檢索增強生成是一種使用從外部來源獲取的事實,來提高生成式 AI 模型準確性和可靠性的技術。

為了理解這一生成式 AI 領域的最新進展,讓我們以法庭為例。

法官通常根據對法律的一般理解來審理和判決案件。但有些案件需要用到特殊的專業知識,如醫療事故訴訟或勞資糾紛等,因此法官會派法庭書記員去圖書館尋找可以引用的先例和具體案例。

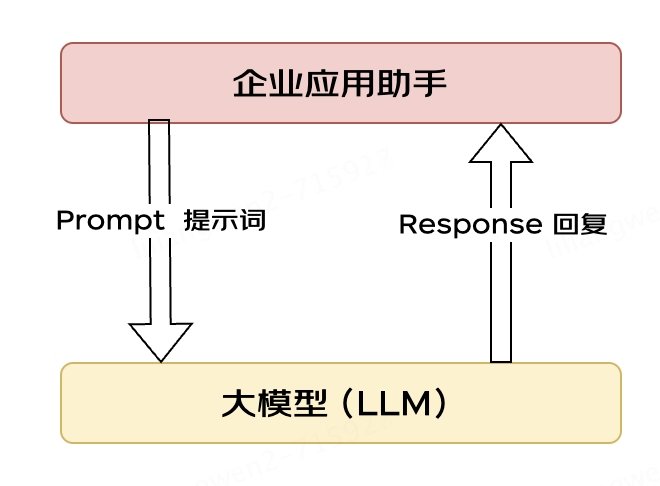

與優秀的法官一樣,大語言模型(LLM)能夠響應人類的各種查詢。但為了能夠提供引經據典的權威答案,模型需要一個助手來做一些研究。

AI 的“法庭書記員”就是一個被稱為檢索增強生成(RAG)的過程。

名稱的由來

這個名稱來自 2020 年的一篇論文(https://arxiv.org/pdf/2005.11401.pdf),論文的第一作者 Patrick Lewis 對 RAG 這個“不討喜”的縮寫詞表示了歉意,如今,這個詞被用來描述在數百篇論文和數十種商業服務中不斷發展壯大的某種方法,而在他看來,這些都代表著生成式 AI 的未來。

在一場于新加坡舉辦的數據庫開發者區域會議中,Lewis 接受了采訪,他提到:“如果我們當時知道研究成果會被如此廣泛地使用,肯定會在起名時多花些心思。”

圖 1:Partick Lewis

Lewis 現在是 AI 初創企業 Cohere 的 RAG 團隊負責人。他表示:“我們當時一直想取一個好聽的名字,但到了寫論文的時候,大家都想不出更好的了。”

什么是檢索增強生成?

檢索增強生成是一種使用從外部來源獲取的事實,來提高生成式 AI 模型準確性和可靠性的技術。

換言之,它填補了 LLM 工作方式的缺口。LLM 其實是一種神經網絡,以其所含參數數量來衡量,參數本質上等同于人類一般的遣詞造句方式。

這種深度理解有時被稱為參數化知識,使 LLM 能夠在瞬間對一般的指令作出響應。但如果用戶希望深入了解當前或更加具體的主題,它就不夠用了。

結合內部與外部資源

Lewis 與其同事所開發的檢索增強生成技術能夠連接生成式 AI 服務與外部資源,尤其是那些具有最新技術細節的資源。

這篇論文的共同作者們來自前 Facebook AI Research(現 Meta AI)、倫敦大學學院和紐約大學。由于 RAG 幾乎可以被任何 LLM 用于連接任意外部資源,因此他們把 RAG 稱為“通用的微調秘方”。

建立用戶信任

檢索增強生成為模型提供了可以引用的來源,就像研究論文中的腳注一樣。這樣用戶就可以對任何說法進行核實,從而建立起信任。

另外,這種技術還能幫助模型消除用戶查詢中的歧義,降低模型做出錯誤猜測的可能性,該現象有時被稱為“幻覺”。

RAG 的另一大優勢就是相對簡單。Lewis 與該論文的其他三位共同作者在博客中表示,開發者只需五行代碼就能實現這一流程。

這使得該方法比使用額外的數據集來重新訓練模型更快、成本更低,而且還能讓用戶隨時更新新的來源。

如何使用檢索增強生成

借助檢索增強生成技術,用戶基本上可以實現與數據存儲庫對話,從而獲得全新的體驗。這意味著用于 RAG 的應用可能是可用數據集數量的數倍。

例如,一個帶有醫療數據索引的生成式 AI 模型可以成為醫生或護士的得力助手;金融分析師將受益于一個與市場數據連接的“助手”。

實際上,幾乎所有企業都可以將其技術或政策手冊、視頻或日志轉化為“知識庫”資源,以此增強 LLM。這些資源可以啟用客戶或現場技術支持、員工培訓、開發者生產力等用例。

AWS、IBM、Glean、谷歌、微軟、NVIDIA、Oracle 和 Pinecone 等公司正是因為這一巨大的潛力而采用 RAG。

開始使用檢索增強生成

為了幫助用戶入門,NVIDIA 開發了檢索增強生成參考架構(https://docs.nvidia.com/ai-enterprise/workflows-generative-ai/0.1.0/technical-brief.html)。該架構包含一個聊天機器人示例和用戶使用這種新方法創建個人應用所需的元素。

該工作流使用了專用于開發和自定義生成式 AI 模型的框架NVIDIA NeMo,以及用于在生產中運行生成式 AI 模型的軟件,例如NVIDIA Triton推理服務器和NVIDIA TensorRT-LLM等。

這些軟件組件均包含在NVIDIA AI Enterprise軟件平臺中,其可加速生產就緒型 AI 的開發和部署,并提供企業所需的安全性、支持和穩定性。

為了讓 RAG 工作流獲得最佳性能,需要大量內存和算力來移動和處理數據。NVIDIA GH200 Grace Hopper 超級芯片配備 288 GB 高速 HBM3e 內存和每秒 8 千萬億次的算力,堪稱最佳的選擇,其速度相比使用 CPU 提升了 150 倍。

一旦企業熟悉了 RAG,就可以將各種現成或自定義的 LLM 與內部或外部知識庫相結合,創造出各種能夠幫助其員工和客戶的助手。

RAG 不需要數據中心。在 Windows PC 上已可直接使用 LLM,其實這都要歸功于 NVIDIA 軟件所提供的支持,使用戶可以在筆記本電腦上輕松訪問各種應用。

圖 2:一個在 PC 上的 RAG 示例應用程序。

配備NVIDIA RTX GPU的 PC 如今可以在本地運行一些 AI 模型。通過在 PC 上使用 RAG,用戶可以連接私人知識來源(無論是電子郵件、筆記還是文章),以改善響應。這樣,用戶可以對其數據來源、指令和回答的私密性和安全性放心。

在最近的一篇博客(https://blogs.nvidia.com/blog/tensorrt-llm-windows-stable-diffusion-rtx/)中,就提供了一個在 Windows 上使用 TensorRT-LLM 加速的 RAG 以快速獲得更好結果的例子。

檢索增強生成的發展史

這項技術的起源至少可以追溯到 20 世紀 70 年代初。當時,信息檢索領域的研究人員推出了所謂的問答系統原型,即使用自然語言處理(NLP)訪問文本的應用程序,最初涵蓋的是棒球等狹隘的主題。

多年以來,這種文本挖掘背后的概念其實一直沒有改變。但驅動它們的機器學習引擎卻有了顯著的發展,從而提高了實用性和受歡迎程度。

20 世紀 90 年代中期,Ask Jeeves 服務(即現在的 Ask.com)以一個穿著考究的男仆作為吉祥物,普及了問答系統。2011 年,IBM 的 Watson 在《危險邊緣》(Jeopardy!)節目中輕松擊敗兩位人類冠軍,成為電視名人。

如今,LLM 正在將問答系統提升至全新的水平。

在一家倫敦實驗室中迸發的靈感

在 2020 年發表這篇開創性的論文時,Lewis 正在倫敦大學學院攻讀自然語言處理(NLP)博士學位,并在倫敦一家新成立的 AI 實驗室中為 Meta 工作。當時,該團隊正在尋找將更多知識加入到 LLM 參數中的方法,并使用模型自己開發的基準來衡量進展。

Lewis 回憶道,團隊在早期方法的基礎上,受谷歌研究人員一篇論文的啟發,“產生了這一絕妙的想法——在一個經過訓練的系統中嵌入檢索索引,這樣它就能學習并生成你想要的任何文本輸出。”

圖 3:IBM Watson 問答系統在電視節目《危險邊緣》(Jeopardy!)中大獲全勝,一舉成名

Lewis 將這項正在開發的工作與另一個 Meta 團隊的優秀檢索系統連接,所產生的第一批結果令人大吃一驚。

“我把結果拿給主管看,他驚嘆道:‘哇,你們做到了。這可不是常有的事情’。因為這些工作流很難在第一次就被設置正確。”

Lewis 還贊揚了團隊成員 Ethan Perez 和 Douwe Kiela 的重要貢獻,兩人分別來自紐約大學和當時的 Facebook AI 研究院。

這項在 NVIDIA GPU 集群上運行并已完成的工作,展示了如何讓生成式 AI 模型更具權威性和可信度。此后,數百篇論文引用了這一研究成果,并在這一活躍的研究領域對相關概念進行了擴展和延伸。

檢索增強生成如何工作

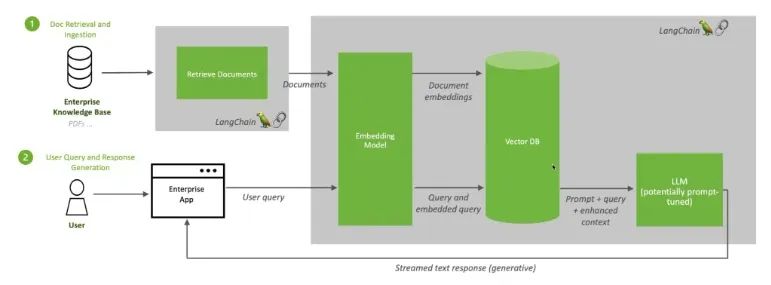

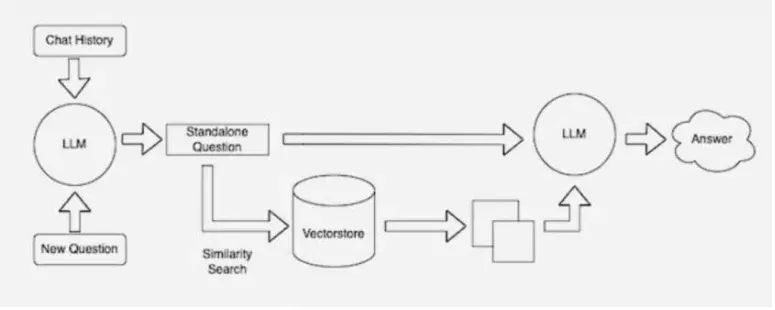

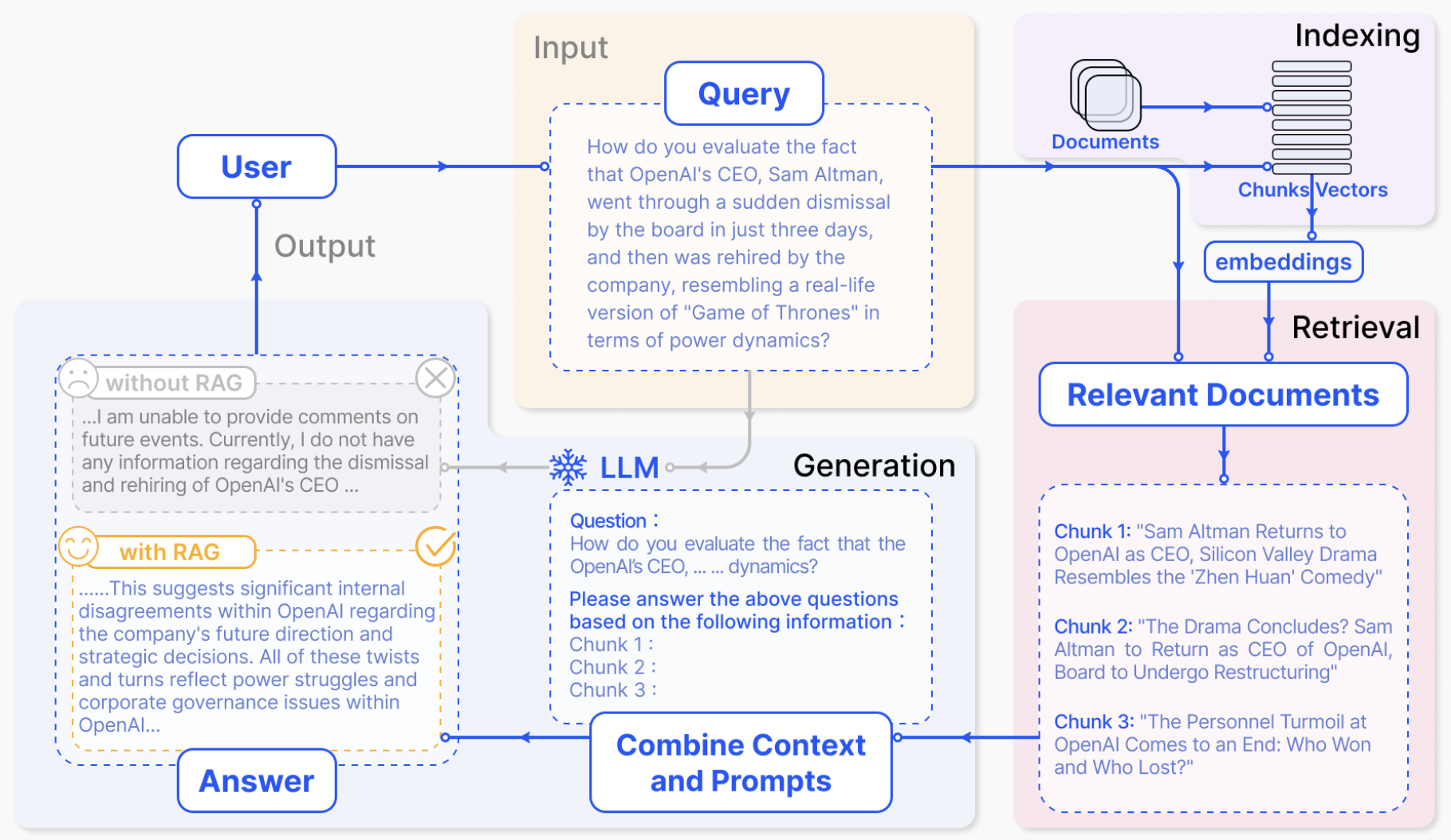

NVIDIA 技術簡介(https://docs.nvidia.com/ai-enterprise/workflows-generative-ai/0.1.0/technical-brief.html)高度概括了 RAG 流程:

當用戶向 LLM 提問時,AI 模型會將查詢發送給另一個模型,后者會將查詢轉換成數字格式以便機器讀取。數字版本的查詢有時被稱為嵌入或向量。

圖 4:檢索增強生成將 LLM 與嵌入模型和向量數據庫相結合。

隨后,嵌入模型會將這些數值與可用知識庫的機器可讀索引中的向量進行比較。當發現存在一個或多個匹配項時,它會檢索相關數據,將其轉換為人類可讀的單詞并發送回 LLM。

最后,LLM 會將檢索到的單詞和它自己對查詢的響應相結合,形成最終的答案并提交給用戶,其中可能會引用嵌入模型找到的來源。

始終使用最新的資源

在后臺,嵌入模型會不斷創建并更新機器可讀索引(有時被稱為向量數據庫),以獲得經過更新的最新知識庫。

圖 5:LangChain 的示意圖從另一個角度描述了使用檢索流程的 LLM。

許多開發者也發現,LangChain 這個開源程序庫特別適合將 LLM、嵌入模型和知識庫串聯到一起。NVIDIA 在其檢索增強生成參考架構中就是使用了 LangChain。

而在 LangChain 社群里,他們也提供了自己的 RAG 流程描述。(https://blog.langchain.dev/tutorial-chatgpt-over-your-data/)

展望未來,生成式 AI 的未來在于其創造性地串聯起各種 LLM 和知識庫,創造出各種新型助手,并將可以驗證的權威結果提供給用戶。

也歡迎您訪問NVIDIA LaunchPad(https://www.nvidia.com/en-us/launchpad/ai/generative-ai-knowledge-base-chatbot/)中的實驗室,您可以通過 AI 聊天機器人親身體驗檢索增強生成。

GTC 2024 將于 2024 年 3 月 18 至 21 日在美國加州圣何塞會議中心舉行,線上大會也將同期開放。點擊“閱讀原文”或掃描下方海報二維碼,立即注冊 GTC 大會。

原文標題:什么是檢索增強生成?

文章出處:【微信公眾號:NVIDIA英偉達企業解決方案】歡迎添加關注!文章轉載請注明出處。

-

英偉達

+關注

關注

22文章

3800瀏覽量

91338

原文標題:什么是檢索增強生成?

文章出處:【微信號:NVIDIA-Enterprise,微信公眾號:NVIDIA英偉達企業解決方案】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

定制本地的ChatFile的AI問答系統

借助浪潮信息元腦企智EPAI高效創建大模型RAG

Cloudera推出RAG Studio,助力企業快速部署聊天機器人

通過阿里云計算巢快速部署NVIDIA NIM

恩智浦eIQ AI和機器學習開發軟件增加兩款新工具

全新 NVIDIA NeMo Retriever微服務大幅提升LLM的準確性和吞吐量

英特爾軟硬件構建模塊如何幫助優化RAG應用

TaD+RAG-緩解大模型“幻覺”的組合新療法

揭秘NVIDIA AI Workbench 如何助力應用開發

英特爾攜手Aible打造創新解決方案,助力企業實現低成本智能化升級

Java開發者LLM實戰——使用LangChain4j構建本地RAG系統

大模型應用之路:從提示詞到通用人工智能(AGI)

什么是檢索增強生成?

什么是檢索增強生成?

評論