大語(yǔ)言模型(LLM)能夠以一種無(wú)需微調(diào)的方式從少量示例中學(xué)習(xí),這種方式被稱為 "上下文學(xué)習(xí)"(In-context Learning)。目前只在大模型上觀察到上下文學(xué)習(xí)現(xiàn)象,那么,常規(guī)大小的模型是否具備類似的能力呢?GPT4、Llama等大模型在非常多的領(lǐng)域中都表現(xiàn)出了杰出的性能,但很多場(chǎng)景受限于資源或者實(shí)時(shí)性要求較高,無(wú)法使用大模型。為了探索小模型的上下文學(xué)習(xí)能力,字節(jié)和華東師大的研究團(tuán)隊(duì)在場(chǎng)景文本識(shí)別任務(wù)上進(jìn)行了研究。

場(chǎng)景文本識(shí)別(Scene Text Recognition)的目標(biāo)是將圖像中的文本內(nèi)容提取出來(lái)。實(shí)際應(yīng)用場(chǎng)景中,場(chǎng)景文本識(shí)別面臨著多種挑戰(zhàn):不同的場(chǎng)景、文字排版、形變、光照變化、字跡模糊、字體多樣性等,因此很難訓(xùn)練一個(gè)能應(yīng)對(duì)所有場(chǎng)景的統(tǒng)一的文本識(shí)別模型。一個(gè)直接的解決辦法是收集相應(yīng)的數(shù)據(jù),然后在特定場(chǎng)景下對(duì)模型進(jìn)行微調(diào)。但是這一過(guò)程需要重新訓(xùn)練模型,當(dāng)場(chǎng)景變多、領(lǐng)域任務(wù)變得復(fù)雜時(shí),實(shí)際的訓(xùn)練、存儲(chǔ)、維護(hù)資源則呈幾何倍增長(zhǎng)。如果文本識(shí)別模型也能具備上下文學(xué)習(xí)能力,面對(duì)新的場(chǎng)景,只需少量標(biāo)注數(shù)據(jù)作為提示,就能提升在新場(chǎng)景上的性能,那么上面的問(wèn)題就迎刃而解。然而,場(chǎng)景文本識(shí)別是一個(gè)資源敏感型任務(wù),將大模型當(dāng)作文本識(shí)別器非常耗費(fèi)資源,并且通過(guò)初步的實(shí)驗(yàn),研究人員發(fā)現(xiàn)傳統(tǒng)的訓(xùn)練大模型的方法在場(chǎng)景文本識(shí)別任務(wù)上并不適用。

為了解決這個(gè)問(wèn)題,來(lái)自字節(jié)和華東師大的研究團(tuán)隊(duì)提出了自進(jìn)化文本識(shí)別器,ESTR(Ego-Evolving Scene Text Recognizer),一個(gè)融合了上下文學(xué)習(xí)能力的常規(guī)大小文本識(shí)別器,無(wú)需微調(diào)即可快速適應(yīng)不同的文本識(shí)別場(chǎng)景。ESTR配備了一種上下文訓(xùn)練和上下文推理模式,不僅在常規(guī)數(shù)據(jù)集上達(dá)到了SOTA的水平,而且可以使用單一模型提升在各個(gè)場(chǎng)景中的識(shí)別性能,實(shí)現(xiàn)對(duì)新場(chǎng)景的快速適應(yīng),甚至超過(guò)了經(jīng)過(guò)微調(diào)后專用模型的識(shí)別性能。ESTR證明,常規(guī)大小的模型足以在文本識(shí)別任務(wù)中實(shí)現(xiàn)有效的上下文學(xué)習(xí)能力。ESTR在各種場(chǎng)景中無(wú)需微調(diào)即可表現(xiàn)出卓越的適應(yīng)性,甚至超過(guò)了經(jīng)過(guò)微調(diào)后的識(shí)別性能。

論文地址:https://arxiv.org/pdf/2311.13120

方法

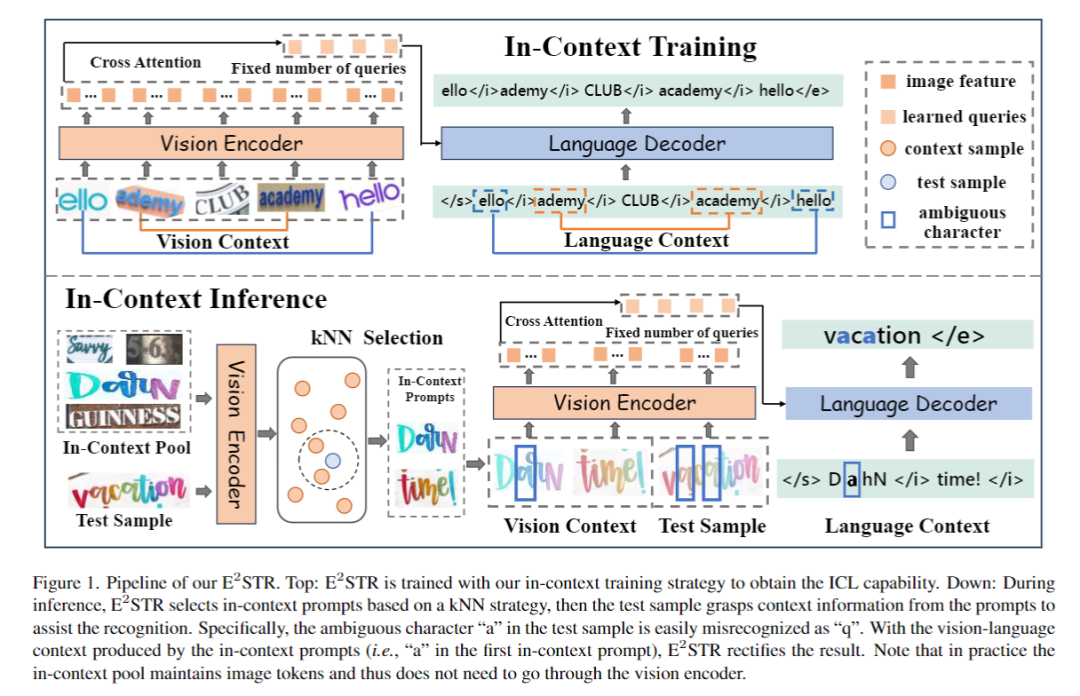

圖1介紹了ESTR的訓(xùn)練和推理流程。

1.基礎(chǔ)文本識(shí)別訓(xùn)練

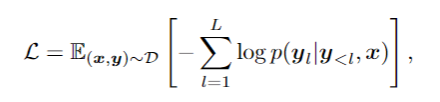

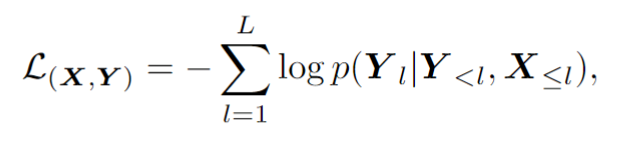

基礎(chǔ)文本識(shí)別訓(xùn)練階段采用自回歸框架訓(xùn)練視覺(jué)編碼器和語(yǔ)言解碼器:

2.上下文訓(xùn)練

上下文訓(xùn)練階段ESTR 將根據(jù)文中提出的上下文訓(xùn)練范式進(jìn)行進(jìn)一步訓(xùn)練。在這一階段,ESTR 會(huì)學(xué)習(xí)理解不同樣本之間的聯(lián)系,從而從上下文提示中獲益。

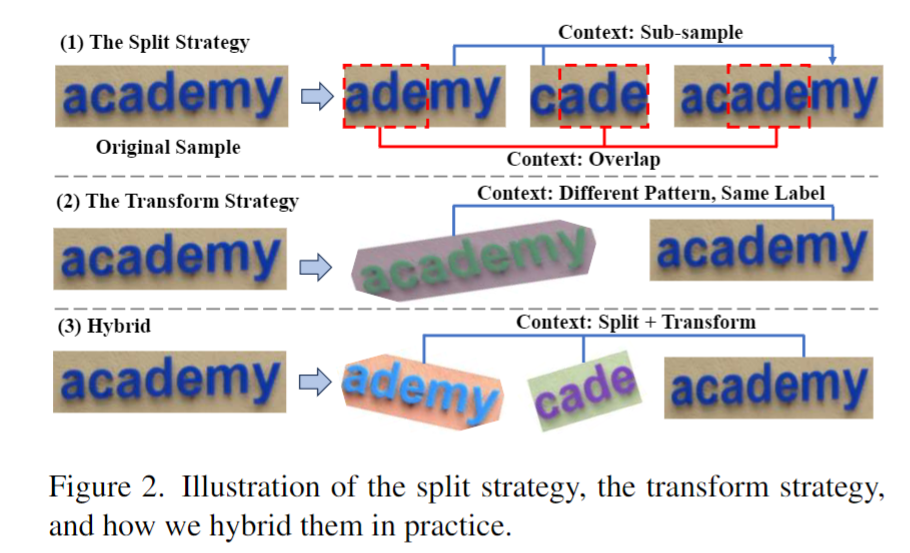

如圖2所示,這篇文章提出 ST 策略,在場(chǎng)景文本數(shù)據(jù)中進(jìn)行隨機(jī)的分割和轉(zhuǎn)換,從而生成一組 "子樣本"。子樣本在視覺(jué)和語(yǔ)言方面都是內(nèi)在聯(lián)系的。這些內(nèi)在聯(lián)系的樣本被拼接成一個(gè)序列,模型從這些語(yǔ)義豐富的序列中學(xué)習(xí)上下文知識(shí),從而獲取上下文學(xué)習(xí)的能力。這一階段同樣采用自回歸框架進(jìn)行訓(xùn)練:

3.上下文推理

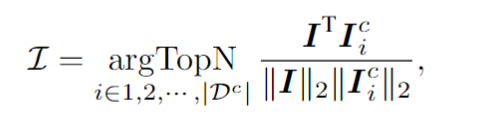

針對(duì)一個(gè)測(cè)試樣本,該框架會(huì)從上下文提示池中選擇 個(gè)樣本,這些樣本在視覺(jué)隱空間與測(cè)試樣本具有最高的相似度。具體來(lái)說(shuō),這篇文章通過(guò)對(duì)視覺(jué)token序列做平均池化,計(jì)算出圖像embedding 。然后,從上下文池中選擇圖像嵌入與 的余弦相似度最高的前 N 個(gè)樣本,從而形成上下文提示。

上下文提示和測(cè)試樣本拼接在一起送入模型,ESTR便會(huì)以一種無(wú)訓(xùn)練的方式從上下文提示中學(xué)得新知識(shí),提升測(cè)試樣本的識(shí)別準(zhǔn)確率。值得注意的是,上下文提示池只保留了視覺(jué)編碼器輸出的token,使得上下文提示的選擇過(guò)程非常高效。此外,由于上下文提示池很小,而且ESTR不需要訓(xùn)練就能直接進(jìn)行推理,因此額外的消耗也降到了最低限度。

實(shí)驗(yàn)

實(shí)驗(yàn)從三個(gè)角度進(jìn)行:

1.傳統(tǒng)數(shù)據(jù)集

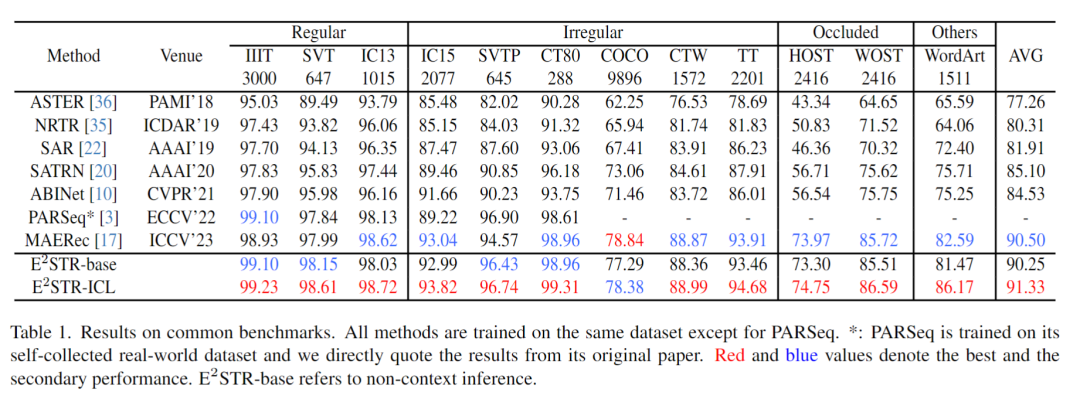

從訓(xùn)練集中隨機(jī)抽取很少的樣本(1000個(gè),訓(xùn)練集 0.025% 的樣本數(shù)量)組成上下文提示池,在12個(gè)常見(jiàn)的場(chǎng)景文本識(shí)別測(cè)試集中進(jìn)行的測(cè)試,結(jié)果如下:

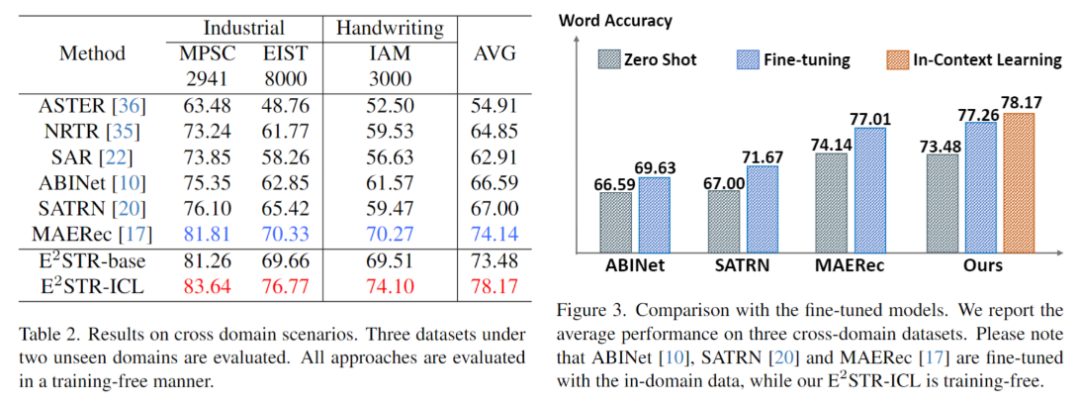

2.跨域場(chǎng)景

跨域場(chǎng)景下每個(gè)測(cè)試集僅提供100個(gè)域內(nèi)訓(xùn)練樣本,無(wú)訓(xùn)練和微調(diào)對(duì)比結(jié)果如下。ESTR甚至超過(guò)了SOTA方法的微調(diào)結(jié)果。

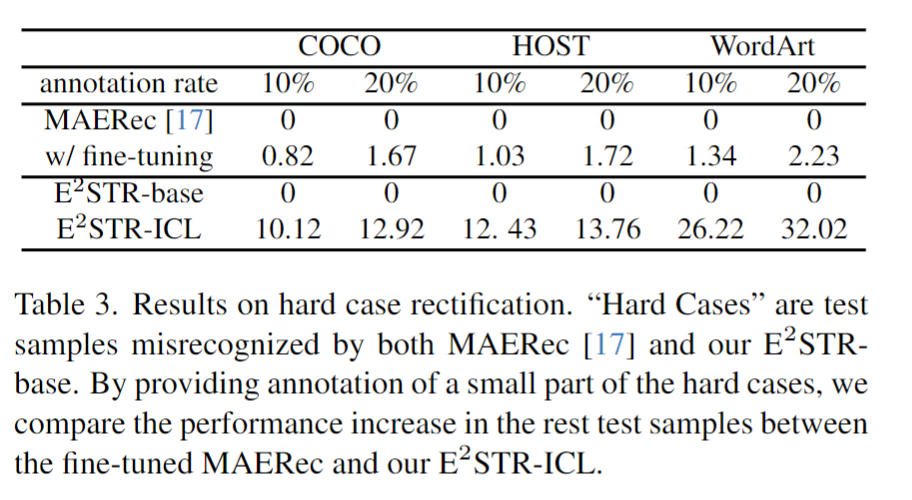

3.困難樣本修正

研究人員收集了一批困難樣本,對(duì)這些樣本提供了10%~20%的標(biāo)注,對(duì)比ESTR的無(wú)訓(xùn)練學(xué)習(xí)方法和SOTA方法的微調(diào)學(xué)習(xí)方法,結(jié)果如下:

可以發(fā)現(xiàn),ESTR-ICL大大降低了困難樣本的錯(cuò)誤率。

未來(lái)展望

ESTR證明了使用合適的訓(xùn)練和推理策略,小模型也可以擁有和LLM類似的In-context Learning的能力。在一些實(shí)時(shí)性要求比較強(qiáng)的任務(wù)中,使用小模型也可以對(duì)新場(chǎng)景進(jìn)行快速的適應(yīng)。更重要的是,這種使用單一模型來(lái)實(shí)現(xiàn)對(duì)新場(chǎng)景快速適應(yīng)的方法使得構(gòu)建統(tǒng)一高效的小模型更近了一步。

-

模型

+關(guān)注

關(guān)注

1文章

3290瀏覽量

49022 -

識(shí)別器

+關(guān)注

關(guān)注

0文章

20瀏覽量

7619 -

大模型

+關(guān)注

關(guān)注

2文章

2523瀏覽量

2984

原文標(biāo)題:小模型也能進(jìn)行上下文學(xué)習(xí)!字節(jié)&華東師大聯(lián)合提出自進(jìn)化文本識(shí)別器

文章出處:【微信號(hào):CVer,微信公眾號(hào):CVer】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

【「基于大模型的RAG應(yīng)用開(kāi)發(fā)與優(yōu)化」閱讀體驗(yàn)】+大模型微調(diào)技術(shù)解讀

《具身智能機(jī)器人系統(tǒng)》第7-9章閱讀心得之具身智能機(jī)器人與大模型

Llama 3 語(yǔ)言模型應(yīng)用

onsemi LV/MV MOSFET 產(chǎn)品介紹 & 行業(yè)應(yīng)用

SystemView上下文統(tǒng)計(jì)窗口識(shí)別阻塞原因

【《大語(yǔ)言模型應(yīng)用指南》閱讀體驗(yàn)】+ 基礎(chǔ)知識(shí)學(xué)習(xí)

鴻蒙Ability Kit(程序框架服務(wù))【應(yīng)用上下文Context】

小模型也能進(jìn)行上下文學(xué)習(xí)!字節(jié)&華東師大聯(lián)合提出自進(jìn)化文本識(shí)別器

小模型也能進(jìn)行上下文學(xué)習(xí)!字節(jié)&華東師大聯(lián)合提出自進(jìn)化文本識(shí)別器

評(píng)論