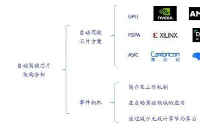

電子發燒友網報道(文/周凱揚)隨著AI計算開始有著風頭蓋過通用計算開始,不少芯片廠商都將其視為下一輪技術革新。CPU、GPU、FPGA和ASIC紛紛投入到這輪AI革命中來,但斬獲的戰果卻是有多有少。由于承載了絕大多數AI計算負載,GPU和ASIC成了市面上最炙手可熱的計算硬件。表面上來看,這是市場提供了兩種不同的靈活選擇,但面對利潤如此高的AI市場,兩者總得爭一個高下。

根據GMInsight的統計,2022年全球AI芯片市場規模超過150億美元,預計將在2032年超過4000億美元,年復合增長率高達35%。而在去年出貨量最大的依然是GPU,占比高達47%左右,第二名為占比34%的CPU,其次才是ASIC與FPGA,但ASIC已經隱隱有迎頭趕超之勢。

選擇通用性還是專用性

從2016年左右,就一直流傳著這樣一個說法,那就是AI計算作為特定負載的高性能計算,其未來肯定是屬于ASIC這樣的“專用芯片”。這個說法似乎也沒錯,畢竟我們轉而看下目前排名前三的云巨頭們,亞馬遜、微軟和谷歌紛紛都選擇了自研ASIC,比如亞馬遜的Trainium和Inferentia、谷歌的TPU、英特爾的Gaudi以及微軟的Maia等。

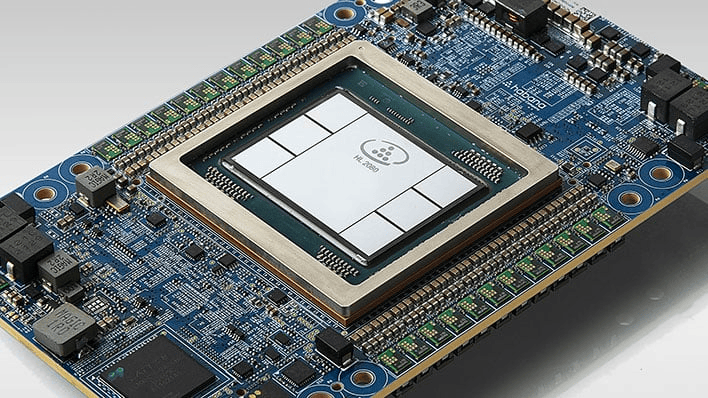

Gaudi 2 /英特爾

要從通用性和專用性的角度來看,ASIC確實是最“專”的那個。即便是在GPU之外,CPU、FPGA的通用性也要遠高于ASIC,但CPU并不適用于純AI負載,更多的是給AI計算起到輔助作用,其提供的算力占比并不算高,哪怕是英偉達的Grace這種宣稱為AI打造的CPU。而FPGA的應用市場則比較固定,比如汽車、工業和金融科技等,難以在大規模的服務器端進行部署。

由此看來,ASIC確實是上佳的硬件之選。尤其是目前LLM占據AI應用的主流,算法逐漸固定,反倒是專用的ASIC在性能、能效上占了上風,不再需要像過去一樣,一代算法一代芯片地不斷迭代。且隨著云服務廠商開始擴大AI服務器規模,ASIC顯然具備更強的擴展性,大量出貨后也能控制好制造成本。

第一代TPU /谷歌

而且從谷歌的TPU設計來看,借助先進的接口IP、Chiplet和EDA工具,在已有架構上進行迭代設計也開始變得簡單,更不用說谷歌在TensorFlow上有著深厚的積累。云服務廠商幾乎評估了市面上所有具備商用可行性的AI芯片,如果他們沒有這個底氣是斷然不會選擇大規模部署的,而他們對ASIC的看好恰好說明了這一點。英特爾這幾年開始分離各種業務,而Habana Labs的ASIC AI芯片業務雖然沒有創造可觀的營收,英特爾卻依然看好這一業務,也證明了ASIC的前景無限。

市場和開發者依然偏愛GPU

但從市場和開發者角度來看,GPU依舊是最吃香的,且牢牢占據主導地位,這又是為什么呢?前英特爾圖形部門負責人Raja Koduri也發表了一些自己的見解。首先,專用芯片的“專用”并不算穩定,與絕大多數人認知中不一樣的是,AI計算并非一成不變,也并不是簡單的一堆矩陣乘法運算。

而反觀GPU這邊,其系統架構已經經過了20多年的演進,比如頁表、內存管理、中斷處理和調試等,這些已經成了支持商用軟件棧落地的必要因素。而ASIC在這方面確實有所欠缺,反而將不少重擔甩給了軟件開發者。而Raja認為,如今并沒有太多年輕的軟件開發者進入行業,所以絕大多數公司都還在爭搶為數不多的老將。

需要注意的是,Raja此處指的軟件開發者并非那些模型/算法開發者,在這類軟件開發者上依然新秀層出不窮,但反觀系統軟件工程師,比如底層驅動開發者,就確實相對較少了。英偉達雖說也常有人員變動,但其在這類軟件的開發上,至少比初創企業領先10多年。

再拿常見的AI基準測試MLPerf為例,這個對訓練和推理性能提供公平評估的榜單,幾乎所有的MLPerf應用都是原生基于CUDA開發。且原本GPU在AI計算效能上的劣勢,也隨著英偉達這幾代不斷添加TensorCore而得到了改善。ASIC的AI加速器雖然理論性能占優,但始終沒法拉開較大差距。

對AI硬件的未來憧憬

即便目前AI硬件生態向好,但要想各類硬件都能活下去創造良性的競爭,我們也可以做一些“愿望清單”。首先,雖然各大AI芯片廠商都在宣揚自己在大模型下的優異表現,然而對于那些沒法全塞進內存里的大模型的訓練和推理來說,英偉達的GPU依然是唯一的可行方案,其他廠商明年還是應該繼續努力。

第二則是軟件生態的兼容性,對于GPU廠商、云服務廠商之外的第三方AI芯片廠商,還是應該加強對各類模型的兼容性,特別是要做到開箱即用。比如英特爾的Gaudi現在已經投入云服務商的服務器中正式使用了,且從性能角度來看著實不賴,但對于PyTorch的支持并不像英偉達的CUDA和AMD的ROCm般順暢。連英特爾都受制于此,可想而知其他的ASIC AI芯片廠商要付出多大的成本和精力了。

另一個做法就是AI芯片廠商自己下場做大模型,如果廠商有這個軟件開發實力的話,自己根據自研芯片開發大模型是最好的,無論模型的架構和芯片的架構怎么演進,都在自己的把控范圍內。畢竟像浪潮這樣的服務器廠商,都已經下場開發大模型了,更為上游的谷歌也已經投身其中。但這種方式也存在一個問題,那就是其模型和硬件往往都會選擇閉源,這也就意味著放棄了龐大的開源開發生態,很難帶動相關AI應用的真正騰飛。

第三是性能優化,在AI芯片廠商與軟件開發社區的不懈努力下,我們看到不同硬件之間的軟件兼容性已經有了可觀的改善,但性能問題仍然擺在臺前,即便是英特爾、AMD和蘋果這樣的大廠也沒法徹底突破。所以在解決完兼容性的問題后,AI芯片廠商還是要持續投入硬件利用率的優化中去。當然了,如果GPU之外的ASIC真的能做到GPU三倍以上的性能,以力大磚飛之勢力壓GPU也不是不可能。

寫在最后

我們現在處于AI硬件的“寒武紀爆發期”,從EDA廠商和晶圓廠的業績就可以看出,AI芯片無論是新的設計還是制造都沒有止步,市面上公開提供的選擇就足以令人眼花繚亂了,還有不少初創企業處于“隱身階段”,或是在等待先進封裝的產能。不管如何,2024年都應該會有更多的產品面市。

AI應用開發者固然沒法一個個買來測試,好在云服務廠商提供了AI服務器的租賃選項,在上面跑一遍自己的AI任務就能對其性能和開發難易度有個大致了解,畢竟AI應用的落地不在于跑矩陣乘法計算有多快,而在于開發者愿不愿意選擇這個開發平臺的硬件與軟件。

-

asic

+關注

關注

34文章

1200瀏覽量

120507 -

gpu

+關注

關注

28文章

4740瀏覽量

128951

發布評論請先 登錄

相關推薦

GPU是如何訓練AI大模型的

《CST Studio Suite 2024 GPU加速計算指南》

《算力芯片 高性能 CPUGPUNPU 微架構分析》第3篇閱讀心得:GPU革命:從圖形引擎到AI加速器的蛻變

FPGA和ASIC在大模型推理加速中的應用

AI芯片的混合精度計算與靈活可擴展

為什么GPU對AI如此重要?

AI訓練,為什么需要GPU?

AI服務器異構計算深度解讀

FPGA在深度學習應用中或將取代GPU

到底什么是ASIC和FPGA?

FPGA、ASIC、GPU誰是最合適的AI芯片?

ASIC和GPU,誰才是AI計算的最優解?

ASIC和GPU,誰才是AI計算的最優解?

評論