隨著人工智能(ai)熱潮的持續,微軟(ms)、meta、谷歌(google)等全球科技大企業正在積極確保高性能ai gpu芯片。據市場調查機構omdia稱,英偉達在2023年第三季度共售出50萬個主力產品h100 gpu。

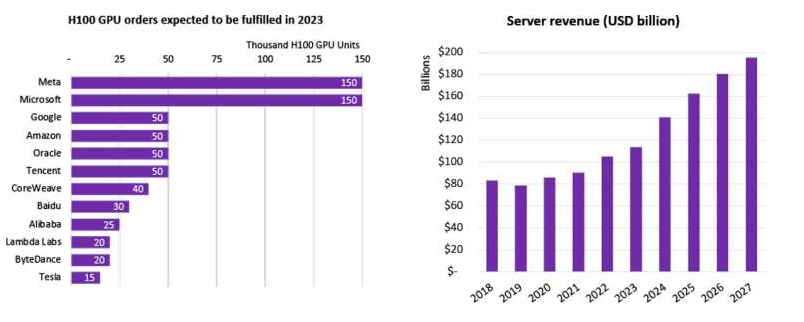

這款產品最大購買客戶是Meta與微軟,各自購買了15萬塊;谷歌、亞馬遜、甲骨文、騰訊各自購買了5萬塊,榜單中還出現了百度、阿里巴巴、字節跳動這幾家中國公司。集微網了解到,目前H100 80GB單卡售價將近4萬美元,約合28萬元人民幣。

《omdia re報告》預測說,英偉達的h100和a100需求第四季度也將保持較高水平,并表示,h100服務器的待機時間達36至52周。

據數據顯示,大部分服務器gpu直接提供給超大型云端服務提供商,但戴爾、聯想、惠普等oem服務器設備制造商尚未確保足夠的ai和hpc gpu。業界預測,服務器市場價值將從目前的約1000億美元,到2027年將增長到約1956億美元,達到2023年的2倍。

聲明:本文內容及配圖由入駐作者撰寫或者入駐合作網站授權轉載。文章觀點僅代表作者本人,不代表電子發燒友網立場。文章及其配圖僅供工程師學習之用,如有內容侵權或者其他違規問題,請聯系本站處理。

舉報投訴

-

微軟

+關注

關注

4文章

6612瀏覽量

104163 -

人工智能

+關注

關注

1792文章

47425瀏覽量

238948 -

GPU芯片

+關注

關注

1文章

303瀏覽量

5850

發布評論請先 登錄

相關推薦

英偉達H100芯片市場降溫

隨著英偉達新一代AI芯片GB200需求的不斷攀升,其上一代明星產品H100芯片卻遭遇了市場的冷落。據業內人士透露,搭載H100的服務器通常以8卡的形式進行出售或出租,而在去年,這類服務

英偉達或取消B100轉用B200A代替

今年3月份,英偉達在美國加利福尼亞州圣何塞會議中心召開的GTC 2024大會上推出了Blackwell架構GPU。原定于今年底出貨的B100

馬斯克自曝訓練Grok 3用了10萬塊NVIDIA H100

在科技界的前沿陣地上,埃隆·馬斯克再次以其前瞻性的視野和大膽的嘗試引領著新的風潮。近日,馬斯克在社交媒體X上的一則回應,不經意間透露了其即將推出的AI聊天機器人Grok 3背后的驚人秘密——這款被馬斯克譽為“非常特別”的AI產品,竟然是通過10萬塊

英偉達去年數據中心GPU出貨量占比約98%

半導體分析公司TechInsights的最新報告揭示了英偉達在數據中心GPU領域的驚人增長。據悉,在2023年,英偉達在數據中心

特斯拉加碼AI布局:xAI將采購30萬塊英偉達B200芯片

特斯拉CEO埃隆·馬斯克近日在社交平臺上公布了一項重要消息,旗下的人工智能初創公司xAI計劃采購30萬塊英偉達B200 AI芯片。這一大規模采購計劃標志著特斯拉在人工智能領域布局的進一步加深。

首批1024塊H100 GPU,正崴集團將建中國臺灣最大AI計算中心

中國臺灣當地正崴集團5月27日宣布,將與日本公司Ubitus共同打造人工智能(AI)計算中心,其中第一期將導入128個機柜,共計1024張英偉達H100旗艦計算卡,旨在構建臺灣最大的AI計算中心。

進一步解讀英偉達 Blackwell 架構、NVlink及GB200 超級芯片

冷卻技術,提高計算密度,減少占地面積,并通過高帶寬、低延遲的GPU通信,有效減少數據中心的碳足跡和能源消耗。相較于傳統的NVIDIA H100風冷基礎設施,GB200在相同功耗下實現25倍的性能提升

發表于 05-13 17:16

特斯拉和xAI籌集H100芯片,以推動L5級自動駕駛和“終極真相人工”的實現?

近期,X平臺用戶“技術兄弟”報導稱,Meta已成為全球最具實力的H100 GPU持有者,總計為35萬塊,但馬斯克對此卻并不認同(特斯拉與xAI的持有量均為1萬顆),并堅持認為“如若計算

英偉達H200帶寬狂飆

英偉達H200帶寬的顯著提升主要得益于其強大的硬件配置和先進的技術創新。H200配備了高達141GB的HBM3e顯存,與前代產品

英偉達H200顯卡價格

英偉達H200顯卡的具體價格尚未公布。根據上一代H100顯卡的價格范圍,預計H200的單片價格將超過40000美元。由于新芯片通常定價較高,

英偉達縮短AI GPU交付周期,持續推進算力產業鏈發展

與此同時,隨著人工智能的迅猛發展及其廣泛應用,對像H100和A100這類專為數據中心設計的高性能GPU的需求也大幅增長。而包括Yotta在內的多家公司因此紛紛加大向英偉

英偉達H100 GPU Q3售出50萬塊,科技巨頭爭搶

英偉達H100 GPU Q3售出50萬塊,科技巨頭爭搶

評論