以下文章來源于谷歌云服務,作者 Google Cloud

Amin Vahdat

ML、系統(tǒng)與 Cloud AI 副總裁/總經理

Mark Lohmeyer

計算與 ML 基礎設施副總裁/總經理

生成式 AI 模型正在迅速發(fā)展,提供了前所未有的精密性和功能。這項技術進展得以讓各行各業(yè)的企業(yè)和開發(fā)人員能夠解決復雜的問題,開啟新的機遇之門。然而,生成式 AI 模型的增長也導致訓練、調整和推理方面的要求變得更加嚴苛。過去五年來,生成式 AI 模型的參數每年增長十倍,如今的大模型具有數千億甚至上萬億項參數,即使在最專業(yè)的系統(tǒng)上仍需要相當長的訓練時間,有時需持續(xù)數月才能完成。此外,高效的 AI 工作負載管理需要一個具備一致性能、優(yōu)化的計算、存儲、網絡、軟件和開發(fā)框架所組成的集成 AI 堆棧。

為了應對這些挑戰(zhàn),我們很高興宣布推出 Cloud TPU v5p,這是 Google 迄今為止功能、可擴展性、靈活性最為強大的 AI 加速器。長期以來,TPU 一直是訓練和服務 AI 支持的產品的基礎,例如 YouTube、Gmail、Google 地圖、Google Play 和 Android。事實上,Google 剛剛發(fā)布的功能最強大的通用 AI 模型 Gemini 就是使用 TPU 進行訓練和服務的。

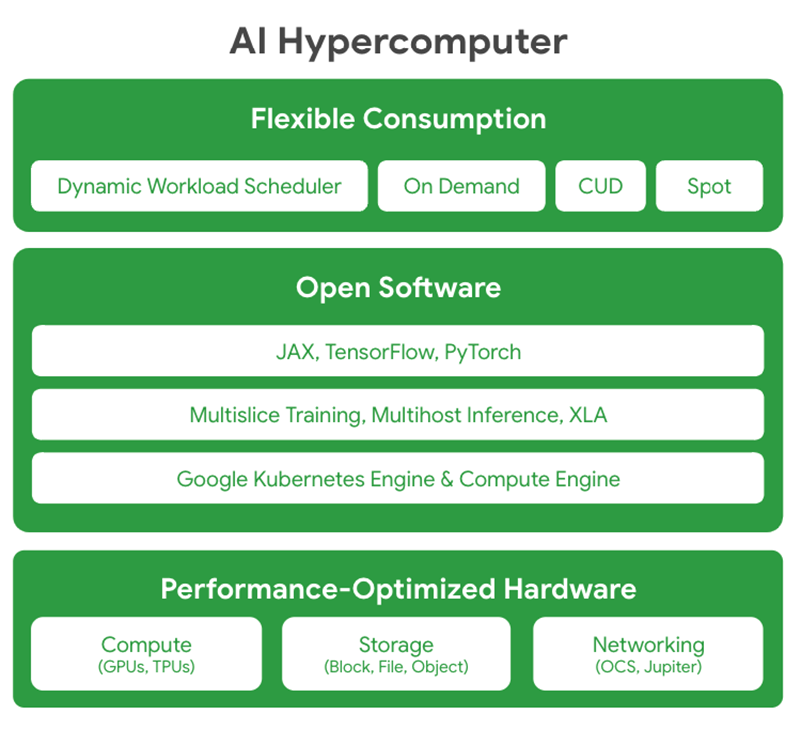

此外,我們也宣布推出 Google Cloud AI Hypercomputer,這是一種突破性的超級計算機架構,采用集成系統(tǒng),并結合了性能優(yōu)化的硬件、開放軟件、領先的 ML 框架和靈活的消費模式。傳統(tǒng)方法通常是以零碎的組件級增強來解決要求嚴苛的 AI 工作負載,這可能會導致效率不佳和性能瓶頸。相比之下,AI Hypercomputer 采用系統(tǒng)級協(xié)同設計來提高 AI 訓練、調整和服務的效率和生產力。

01

探索 Cloud TPU v5p

Google Cloud 目前功能最強大

可擴展能力最佳的 TPU 加速器

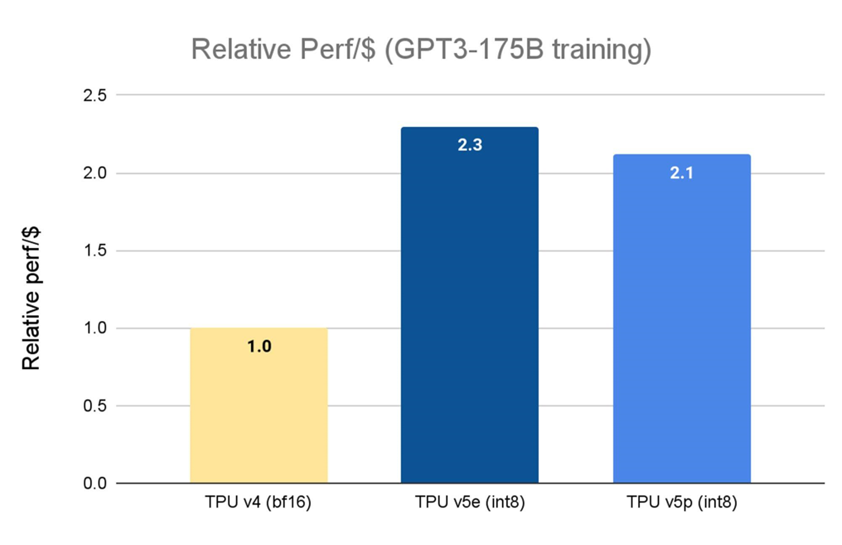

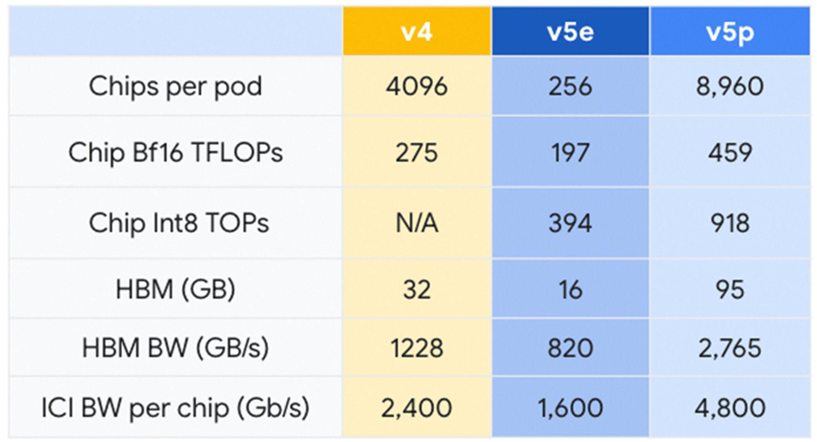

上個月,我們宣布全面推出 Cloud TPU v5e。相較于上一代 TPU v41,TPU v5e 的性價比提高了 2.3 倍,是我們目前最具成本效益的 TPU。而 Cloud TPU v5p 則是我們目前功能最強大的 TPU。每個 TPU v5p pod 由 8,960 個芯片組成,采用了我們帶寬最高的芯片間互連 (Inter-chip Interconnect, ICI) 技術,以 3D 環(huán)形拓撲結構實現每芯片 4,800 Gbps 的速率。與 TPU v4 相比,TPU v5p 的每秒浮點運算次數 (FLOPS) 提高 2 倍以上,高帶寬內存 (High-bandwidth Memory, HBM) 則增加 3 倍。

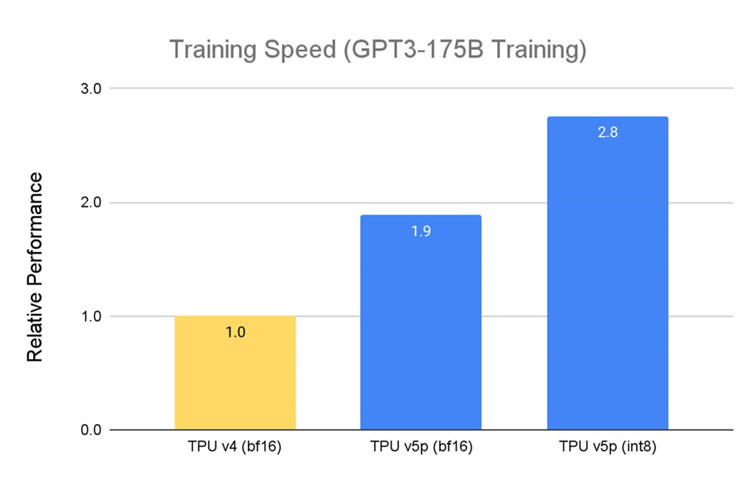

TPU v5p 專為性能、靈活性和可擴展性設計,相較于上一代 TPU v4,TPU v5p 訓練大型 LLM 的速度提升 2.8 倍。此外,若搭配第二代 SparseCores,TPU v5p 訓練嵌入密集模型的速度比 TPU v42 快 1.9 倍。

資料來源: Google 內部數據。截至 2023 年 11 月,GPT-3 1750 億參數模型的所有數據均按每芯片 seq-len=2048 為單位完成標準化。

資料來源: TPU v5e 數據來自 MLPerf 3.1 Training Closed 的 v5e 結果;TPU v5p 和 v4 基于 Google 內部訓練運行。截至 2023 年 11 月,GPT-3 1750 億參數模型的所有數據均按每芯片 seq-len=2048 為單位完成標準化。并以 TPU v4:3.22 美元/芯片/小時、TPU v5e:1.2 美元/芯片/小時和 TPU v5p:4.2 美元/芯片/小時的公開定價顯示每美元相對性能。

TPU v5p 不僅性能更佳,就每 Pod 的總可用 FLOPS 而言,TPU v5p 的可擴展能力比 TPU v4 高 4 倍,且 TPU v5p 的每秒浮點運算次數 (FLOPS) 是 TPU v4 的兩倍,并在單一 Pod 中提供兩倍的芯片,可大幅提升訓練速度相關性能。

02

Google AI Hypercomputer

大規(guī)模提供頂尖性能和效率

實現規(guī)模和速度是必不可少的,但并不足以滿足現代 AI/ML 應用程序和服務的需求。軟硬組件必須組合相輔相成,組成一個易于使用、安全可靠的集成計算系統(tǒng)。Google 已針對此問題投入數十年的時間進行研發(fā),而 AI Hypercomputer 正是我們的心血結晶。此系統(tǒng)集結了多種能協(xié)調運作的技術,能以最佳方式來執(zhí)行現代 AI 工作負載。

?

?

?

?

?

?性能優(yōu)化硬件: AI Hypercomputer 以超大規(guī)模數據中心基礎設施為基礎構建,采用高密度足跡、水冷技術和我們的 Jupiter 數據中心網絡技術,在計算、存儲和網絡功能上均能提供最佳性能。所有這一切都基于以效率為核心的各項技術,利用清潔能源和對水資源管理的堅定承諾,助力我們邁向無碳未來。

開放軟件: AI Hypercomputer 使開發(fā)人員能夠通過使用開放軟件來訪問我們性能優(yōu)化的硬件,利用這些硬件調整、管理和動態(tài)編排 AI 訓練和推理工作負載。

-

廣泛支持主流 ML 框架 (例如 JAX、TensorFlow 和 PyTorch) 且提供開箱即用。如要構建復雜的 LLM,JAX 和 PyTorch 均由 OpenXLA 編譯器提供支持。XLA 作為基礎設施,支持創(chuàng)建復雜的多層模型。XLA 優(yōu)化了各種硬件平臺上的分布式架構,確保針對不同的 AI 場景高效開發(fā)易于使用的模型。

-

提供開放且獨特的 Multislice Training 及 Multihost Inferencing 軟件,分別使擴展、訓練和提供模型的工作負載變得流暢又簡單。若要處理要求嚴苛的 AI 工作負載,開發(fā)人員可將芯片數量擴展至數萬個。

-

與 Google Kubernetes Engine (GKE) 和 Google Compute Engine 深度集成,實現高效的資源管理、一致的操作環(huán)境、自動擴展、自動配置節(jié)點池、自動檢查點、自動恢復和及時的故障恢復。

靈活的消費模式: AI Hypercomputer 提供多種靈活動態(tài)的消費方案。除了承諾使用折扣 (Committed Used Discunts, CUD)、按需定價和現貨定價等經典選項外,AI Hypercomputer 還通過 Dynamic Workload Scheduler 提供針對 AI 工作負載量身定制的消費模式。Dynamic Workload Scheduler 包含兩種消費模式: Flex Start 模式可實現更高的資源獲取能力和優(yōu)化的經濟效益;Calendar 模式則針對作業(yè)啟動時間可預測性更高的工作負載。

03

利用 Google 的豐富經驗

助力 AI 的未來發(fā)展

Salesforce 和 Lightricks 等客戶已在使用 Google Cloud 的 TPU v5p 以及 AI Hypercomputer 來訓練和服務大型 AI 模型——并發(fā)現了其中的差異:

G

C

"我們一直在使用 Google Cloud 的 TPU v5p 對 Salesforce 的基礎模型進行預訓練,這些模型將作為專業(yè)生產用例的核心引擎,我們看到訓練速度獲得了顯著提升。事實上,Cloud TPU v5p 的計算性能比上一代 TPU v4 高出至少 2 倍。我們還非常喜歡使用 JAX 順暢地從 Cloud TPU v4 過渡到 v5p。我們期待能通過 Accurate Quantized Training (AQT) 庫,運用 INT8 精度格式的原生支持來優(yōu)化我們的模型,進一步提升速度。"

——Salesforce 高級研究科學家

Erik Nijkamp

G

C

"憑借 Google Cloud TPU v5p 的卓越性能和充足內存,我們成功地訓練了文本到視頻的生成模型,而無需將其拆分成單獨進程。這種出色的硬件利用率大大縮短了每個訓練周期,使我們能夠迅速開展一系列實驗。能在每次實驗中快速完成模型訓練的能力加快了迭代速度,為我們的研究團隊在生成式 AI 這個競爭激烈的領域帶來寶貴優(yōu)勢。"

——Lightricks 核心生成式 AI 研究團隊主管

Yoav HaCohen 博士

G

C

"在早期使用過程中,Google DeepMind 和 Google Research 團隊發(fā)現,對于 LLM 訓練工作負載,TPU v5p 芯片的性能比 TPU v4 代提高了 2 倍。此外,AI Hypercomputer 能為 ML 框架 (JAX、PyTorch、TensorFlow) 提供強大的支持和自動編排工具,使我們能夠在 v5p 上更高效地擴展。搭配第二代 SparseCores,我們也發(fā)現嵌入密集型工作負載 (embeddings-heavy workloads) 的性能得到顯著提高。TPU 對于我們在 Gemini 等前沿模型上開展最大規(guī)模的研究和工程工作至關重要。"

—— Google DeepMind 和 Google Research

首席科學家 Jeff Dean

在 Google,我們一直堅信 AI 能夠幫助解決棘手問題。截至目前,大規(guī)模訓練與提供大型基礎模型對于許多企業(yè)來說都過于復雜且昂貴。現在,通過 Cloud TPU v5p 和 AI Hypercomputer,我們很高興能將我們在 AI 和系統(tǒng)設計領域數十年的研究成果與我們的用戶分享,以便他們能夠更快、更高效、更具成本效益地運用 AI 加速創(chuàng)新。

?

?1: MLPerf v3.1 Training Closed 的結果多個基準如圖所示。資料日期:2023 年 11 月 8 日。資料來源:mlcommons.org。結果編號:3.1-2004。每美元性能并非 MLPerf 的評估標準。TPU v4 結果尚未經 MLCommons 協(xié)會驗證。MLPerf 名稱和標志是 MLCommons 協(xié)會在美國和其他國家的商標,并保留所有權利,嚴禁未經授權的使用。更多信息,請參閱 www.mlcommons.org。

2: 截至 2023 年 11 月,Google TPU v5p 內部資料:E2E 執(zhí)行時間 (steptime)、搜索廣告預估點擊率 (SearchAds pCTR)、每個 TPU 核心批次大小為 16,384、125 個 vp5 芯片。

?點擊屏末|閱讀原文|即刻查看詳細內容

?點擊屏末|閱讀原文|即刻查看詳細內容

原文標題:Google Cloud 推出 TPU v5p 和 AI Hypercomputer: 支持下一代 AI 工作負載

文章出處:【微信公眾號:谷歌開發(fā)者】歡迎添加關注!文章轉載請注明出處。

-

谷歌

+關注

關注

27文章

6172瀏覽量

105618

原文標題:Google Cloud 推出 TPU v5p 和 AI Hypercomputer: 支持下一代 AI 工作負載

文章出處:【微信號:Google_Developers,微信公眾號:谷歌開發(fā)者】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

相關推薦

Google兩款先進生成式AI模型登陸Vertex AI平臺

OPPO與Google Cloud攜手開創(chuàng)AI手機新未來

雷諾下一代車載語音助手Reno將引入生成式AI技術

下一代高功能新一代AI加速器(DRP-AI3):10x在高級AI系統(tǒng)高級AI中更快的嵌入處理

賽輪思與NVIDIA合作,利用生成式AI打造下一代車內體驗

豐田、日產和本田將合作開發(fā)下一代汽車的AI和芯片

谷歌將推出第六代數據中心AI芯片Trillium TPU

DPU技術賦能下一代AI算力基礎設施

三星電子已開始與Naver合作開發(fā)下一代AI芯片Mach-2

Google Cloud推出基于Arm Neoverse V2定制Google Axion處理器

加入AI軍備賽! Google推出ARM架構處理器Axion和下一代TPU v5p

NVIDIA的專用AI平臺如何推動下一代醫(yī)療健康行業(yè)的發(fā)展

英偉達的下一代AI芯片

Google Cloud 推出 TPU v5p 和 AI Hypercomputer: 支持下一代 AI 工作負載

Google Cloud 推出 TPU v5p 和 AI Hypercomputer: 支持下一代 AI 工作負載

評論