來源|AIGC開放社區

在 Sora 引爆文生視頻賽道之前,國內的字節跳動也推出了一款顛覆性視頻模型——Boximator。

與 Gen-2、Pink1.0 等模型不同的是,Boximator 可以通過文本精準控制生成視頻中人物或物體的動作。

例如,下雨天,大風把一位女生的雨傘吹走了。目前,很少有視頻模型能精準做到這一點。

Boximator 案例賞析

我們先看一下 Boximator 與 Gen-2、Pink1.0,在使用相同的文本提示詞、圖像生成的視頻,所表現出來的不同動作。

為了方便觀察,「AIGC 開放社區」將對比視頻整合在一起,最左邊的是 Boximator 生成的視頻。

一個可愛的 3D 男孩站著,然后走路

在這個案例中,Pika 1.0 生成的視頻男孩只是站著沒有走動,Gen-2 的視頻走動了但不明顯,只有 Boximator 產生了明顯的走動動作。

一位英俊的男人用他的右手從口袋里拿出一朵玫瑰,并且在看著這朵玫瑰

這個案例 Pika 1.0 和 Gen-2 表現的都非常不好,男士沒有掏出玫瑰花的動作。Boximator 再一次完美理解文本語義并做出了相應的動作。

往杯子里加紅酒

這個案例主要展示了控制物體動作的能力,Pika 1.0 和 Gen-2 都做出了倒酒的動作,但是杯子里的酒沒有明顯上升的動作。只有 Boximator 做到了倒酒 + 上升兩個動作。

看了這 3 個案例,能感受到 Boximator 對文本語義精準理解,以及對動作控制的強大功能了吧。

Boximator 模型介紹

為了實現對視頻中物體、人物的動作控制,Boximator 使用了“軟框”和“硬框”兩種約束方法。

硬框:可精確定義目標對象的邊界框。用戶可以在圖片中畫出感興趣的對象,Boximator 會將其視為硬框約束, 在之后的幀中精準定位該對象的位置。

軟框:軟框定義一個對象可能存在的區域, 形成一個寬松的邊界框。對象需要停留在這個區域內, 但位置可以有一定變化,實現適度的隨機性。

兩類框都包含目標對象的 ID, 用于在不同幀中跟蹤同一對象。此外, 框還包含坐標、類型等信息的編碼。

控制模塊和訓練策略

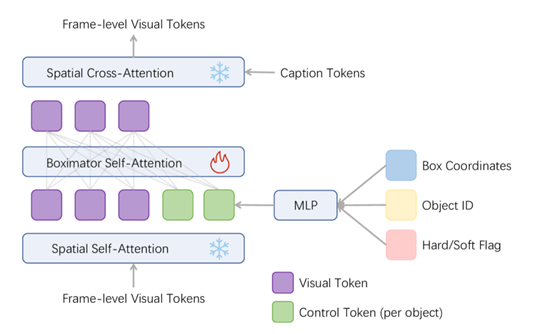

控制模塊可以將框約束的編碼與視頻幀的視覺編碼結合,用來指導視頻的精準動作生成。包含框編碼器和自注意力層兩大塊。

框編碼器:將框的坐標、ID、類型等信息, 通過 Fourier 編碼和 MLP 映射為控制向量。

自注意力層:將框的控制向量與視頻幀的視覺向量通過自注意力建模其關系, 學習將框指導幀生成。

訓練策略方面,Boximator 主要分為兩個階段: 自跟蹤階段,訓練模型的同時生成視頻內容和對應的框,并簡化框與對象的關系學習。

正常訓練,訓練模型只生成視頻內容, 框的內在表達已經學會指導對象生成。此外, 訓練還使用多階段策略,逐步過渡從硬框到軟框的約束, 以及適當融合無框數據。

Boximator 實驗數據

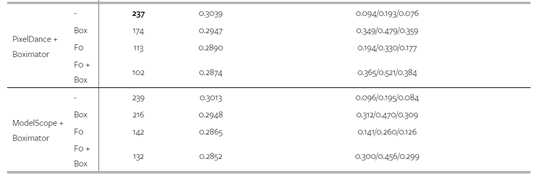

為獲得視頻訓練數據, 研究人員從 WebVid-10M 數據集中,過濾出 110 萬段動態明顯的視頻片段, 并自動為其注釋了 220 萬個對象的邊界框。并在 PixelDance 和 ModelScope 這兩個模型上訓練了 Boximator。

實驗數據顯示,Boximator 在保持原模型視頻質量, 具有非常強大的動作控制能力。同時可以作為一種插件,幫助現有視頻擴散模型提升生成質量。

在 MSR-VTT 數據集上, 無論是視頻質量還是框與對象對齊精度方面,Boximator 都優于原模型。在人類評估中,Boximator 生成的視頻也在質量和運動控制上明顯超過原模型。

字節跳動的研究人員表示,目前該模型處于研發階段,預計 2-3 個月內發布測試網站。讓我們期待一下國內挑戰 Sora 的產品誕生吧!

審核編輯:劉清

-

字節跳動

+關注

關注

0文章

318瀏覽量

8932 -

Sora

+關注

關注

0文章

81瀏覽量

199

原文標題:字節跳動推出顛覆性文生視頻模型,可自由控制動作!

文章出處:【微信號:AI前線,微信公眾號:AI前線】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

字節跳動推出一款顛覆性視頻模型—Boximator

字節跳動推出一款顛覆性視頻模型—Boximator

評論