5 月 26 日消息,微軟近期推出其小語言 AI 模型新成員“Phi-3-vision”,以卓越的“視覺”處理能力著稱,能夠深度解析圖文信息并在移動設備上穩定運行。

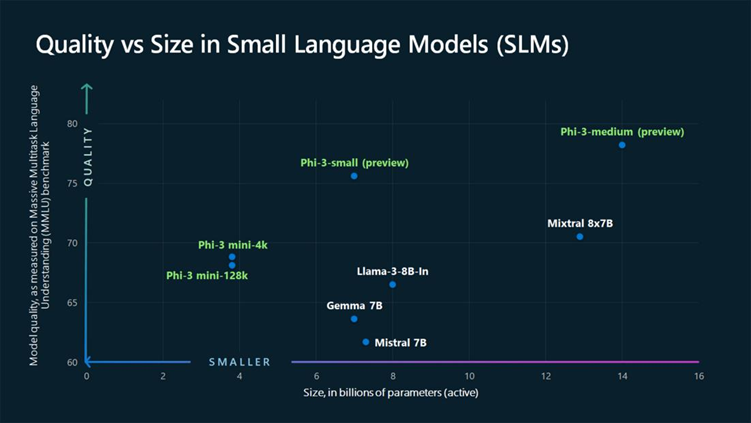

據悉,Phi-3-vision 作為微軟 Phi-3 家族的首款多模態模型,繼承自 Phi-3-mini 的文本理解能力,兼具輕巧便攜特性,適用于移動平臺/嵌入式終端;模型參數規模達 42 億,遠超 Phi-3-mini(3.8B),略遜于 Phi-3-small(7B),上下文長度為 128k token,訓練時間跨度為 2024 年 2 月至 4 月。

值得關注的是,Phi-3-vision 模型的核心優勢在于其強大的“圖文識別”功能,能夠準確理解現實世界圖像的內涵,迅速識別并提取圖片中的文字信息。

微軟強調,Phi-3-vision 尤其適用于辦公場景,開發者針對圖表和方塊圖(Block diagram)識別進行了專門優化,使其能夠根據用戶輸入信息進行推理,并生成一系列決策建議,為企業提供戰略參考,被譽為“媲美大型模型”的效果。

在模型訓練環節,微軟表示 Phi-3-vision 采用了“多元化圖片與文字數據”進行訓練,涵蓋了一系列“精選的公共內容”,如“教科書級”教育素材、代碼、圖文標注數據、現實世界知識、圖表圖片、聊天記錄等,以保證模型輸入內容的豐富性。此外,微軟承諾所用訓練數據“可追溯”且不含任何個人信息,充分保障用戶隱私。

在性能對比方面,微軟提供了 Phi-3-vision 與字節跳動 Llama3-Llava-Next(8B)、微軟研究院與威斯康星大學、哥倫比亞大學聯合研發的 LlaVA-1.6(7B)以及阿里巴巴通義千問 QWEN-VL-Chat 模型等競品的對比圖表,展示了 Phi-3-vision 在多項測試中的優秀表現。

-

微軟

+關注

關注

4文章

6598瀏覽量

104064 -

AI

+關注

關注

87文章

30896瀏覽量

269089 -

模型

+關注

關注

1文章

3243瀏覽量

48840

發布評論請先 登錄

相關推薦

微軟尋求在365 Copilot中引入非OpenAI模型

微軟預覽版Copilot Vision AI功能上線

用Ollama輕松搞定Llama 3.2 Vision模型本地部署

微軟發布Azure AI Foundry,推動云服務增長

在英特爾酷睿Ultra7處理器上優化和部署Phi-3-min模型

聆思CSK6視覺語音大模型AI開發板入門資源合集(硬件資料、大模型語音/多模態交互/英語評測SDK合集)

英特爾機器視覺與AI解決方案助力生產力升級

微軟發布視覺型AI新模型:Phi-3-vision

微軟發布視覺型AI新模型:Phi-3-vision

評論