電子發燒友網報道(文/吳子鵬)近日,斯坦福大學AI團隊主導的Llama3-V開源模型被證實套殼抄襲國內清華與面壁智能的開源模型“小鋼炮”MiniCPM-Llama3-V 2.5。該事件引起了業界的廣泛關注,也讓大家對于開源大模型的規范使用更加擔憂。

斯坦福Llama3V模型被證實抄襲

5月29日,斯坦福大學的一個AI團隊在Github等平臺發布了一款大模型,名為Llama3V,該模型的亮點是據稱只需要500美元就可以訓練出一個 SOTA多模態模型,模型效果可比肩GPT-4V、Gemini Ultra等大模型。

由于模型團隊來自斯坦福,且效果描述非常吸引眼球,因此該模型很快在社交平臺發酵,推特上相關話題的瀏覽量超過了30萬,迅速沖到了Hugging Face首頁。

不過,有用戶很快發現,Llama3-V大模型實際上是套殼面壁智能的MiniCPM-Llama3-V 2.5,但Llama3-V在發布信息中并沒有體現這一點,且稱只是使用了MiniCPM-Llama3-V 2.5的tokenizer。但這一說法讓用戶很難認同,隨后有用戶在Github頁面上指出了套殼的問題,但相關言論很快被斯坦福團隊刪除。

該用戶非常不滿隨后到MiniCPM-Llama3-V 2.5頁面下重述了這一問題,并提醒面壁智能重視此事。面壁團隊通過測試發現,Llama3V與MiniCPM-Llama3-V 2.5在“胎記”般案例上的表現100%雷同,做實了斯坦福團隊的抄襲行為。隨后,這一事件在國外媒體迅速發酵。

隨后不久,斯坦福Llama3-V團隊承認抄襲,斯坦福本科生Siddharth Sharma和Aksh Garg發布了道歉聲明,不過據稱是主要責任人的Mustafa Aljadery并沒有出現在道歉聲明中,這名學生來自南加利福尼亞大學,目前處于失蹤的狀態,是這一事件的主要過錯方。

Aksh Garg在道歉聲明中表示,“首先,我們要向MiniCPM原作者道歉。我、Siddharth Sharma,以及Mustafa一起發布了Llama3-V,Mustafa為這個項目編寫了代碼,但從昨天起就無法聯系他。我與Siddharth Sharma主要負責幫助Mustafa進行模型推廣。我們倆查看了最新的論文,以驗證這項工作的新穎性,但并未被告知或意識到OpenBMB(清華團隊支持發起的大規模預訓練語言模型庫與相關工具)之前的任何工作。我們向作者道歉,并對自己沒有努力驗證這項工作的原創性感到失望。我們對所發生的事情承擔全部責任,并已撤下Llama3-V,再次致歉。”

6月3日,面壁智能CEO李大海與聯合創始人劉知遠先后發文,回應開源模型被斯坦福大學AI團隊抄襲一事。李大海表示:“我們對這件事深表遺憾。一方面感慨這也是一種受到國際團隊認可的方式,另一方面呼吁大家共建開放、合作、有信任的社區環境。”“我們希望團隊的好工作被更多人關注與認可,但不是以這種方式。”

據介紹,MiniCPM-Llama3-V 2.5是MiniCPM-V系列的最新版本模型,基于SigLip-400M和Llama3-8B-Instruct構建,共參數規模為8B,相較于MiniCPM-V 2.0性能取得較大幅度提升。MiniCPM-Llama3-V 2.5在綜合了11個主流多模態大模型評測基準的OpenCompass榜單上平均得分65.1的成績,超越了GPT-4o、GPT-4V、Gemini Pro、Qwen-VL-Max等商用閉源模型。

開源大模型規范使用值得關注

開源大模型是指一種基于開源技術和大規模數據集構建的人工智能模型,具有開放性和可擴展性的特點。開源大模型與傳統的商業人工智能模型不同,其最大的特點在于開放性和可擴展性。這種模型的構建需要利用大量的開源工具和資源,包括開源的深度學習框架、開源的數據集和開源的算法等。

開源大模型是AI大模型發展的重要分支,擁有LLaMA、Grok-1、Stable Code Instruct-3B、Mistral 8x7B和零一萬物的Yi-34B等代表產品,這些大模型的發布和發展,不僅顯著增強了數據的安全性和隱私保護,更為用戶節省了大量成本,減少了對外部依賴的需求。

不過,由于是開源的,因此開源大模型一直以來都面臨著被抄襲的風險。實際上,上述提到的零一萬物的Yi-34B在去年也是深陷抄襲的漩渦里。2023年11月14日,一位國外開發者在Hugging Face開源主頁上評論稱,創新工場董事長兼CEO、零一萬物CEO李開復旗下 AI 公司“零一萬物”開源大模型Yi-34B,完全使用Meta研發的LIama開源模型架構,而只對兩個張量(Tensor)名稱進行修改。

根據零一萬物的說明,零一萬物在訓練模型過程中,沿用了GPT/LLaMA的基本架構,由于LLaMA社區的開源貢獻,讓零一萬物可以快速起步。零一萬物還在聲明中稱,模型結構僅是模型訓練其中一部分。Yi 開源模型在其他方面的精力,比如數據工程、訓練方法、baby sitting(訓練過程監測)的技巧、hyperparameter設置、評估方法以及對評估指標的本質理解深度、對模型泛化能力的原理的研究深度、行業頂尖的AI infra能力等。

實際上,在更早的2022年,智源研究院的大模型研究中心就被爆出了抄襲的問題,一篇擁有100位作者署名的綜述研究《A Roadmap for Big Model》被質疑抄襲了多篇論文內容,引發國內外學者和社區的廣泛關注與討論。另外,商湯、谷歌等公司都曾被指出存在抄襲問題。

目前,AI大模型在防止抄襲、版權歸屬等問題方面還存在很大的漏洞,行業法規明顯不健全,關于大模型使用已有作品進行訓練是否構成侵權,以及大模型生成物是否可以享有版權,這類事件也已經有案件發生。相信隨著行業的進一步發展,杜絕抄襲和版權歸屬將逐漸有法可依,這樣會更有利于大模型的發展。

結語

斯坦福團隊開源大模型抄襲事件暴露了開源大模型的濫用和監管問題,同時AI大模型也還有更深層次的數據和作品版權歸屬問題,因此不難看出AI大模型尚處于野蠻生長的階段,未來還需要逐步健全行業法規。

-

大模型

+關注

關注

2文章

2448瀏覽量

2701

發布評論請先 登錄

相關推薦

斯坦福STANFORD FS725銣鐘

斯坦福研究:電動汽車電池實際壽命比預估長得多

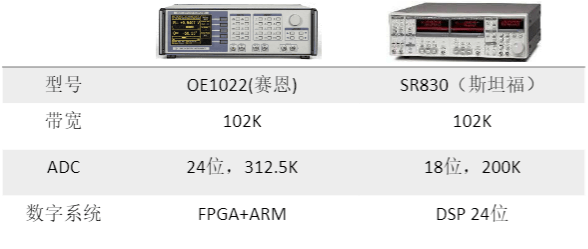

STANFORD斯坦福SR830 鎖相放大器

國產儀器崛起:斯坦福替代方案來了!

斯坦福大學研發全新AI輔助全息成像技術

斯坦福發布《2024 AI指數報告》

斯坦福、伯克利大神教授創業給機器人造大腦,OpenAI紅杉搶著投5億

MCSDK 5.2電機啟動后經常導致串口失聯的原因有哪些?

英偉達CEO黃仁勛建議應屆畢業生降低期望

斯坦福繼Flash Attention V1和V2又推出Flash Decoding

英偉達CEO黃仁勛:競爭對手的芯片免費也難以比肩英偉達GPU

NVIDIA首席科學家Bill Dally:深度學習硬件趨勢

維修斯坦福SR560可編程濾波器燒了overload

斯坦福團隊抄襲國產大模型,主要責任人失聯

斯坦福團隊抄襲國產大模型,主要責任人失聯

評論