神經(jīng)網(wǎng)絡(luò)是一種強(qiáng)大的機(jī)器學(xué)習(xí)模型,廣泛應(yīng)用于各種分類任務(wù)。在本文中,我們將詳細(xì)介紹幾種適合分類任務(wù)的神經(jīng)網(wǎng)絡(luò)模型,包括前饋神經(jīng)網(wǎng)絡(luò)、卷積神經(jīng)網(wǎng)絡(luò)、循環(huán)神經(jīng)網(wǎng)絡(luò)、深度信念網(wǎng)絡(luò)和長(zhǎng)短期記憶網(wǎng)絡(luò)等。

- 前饋神經(jīng)網(wǎng)絡(luò)(Feedforward Neural Networks)

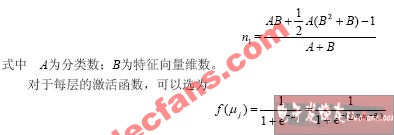

前饋神經(jīng)網(wǎng)絡(luò)是一種最基本的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),由輸入層、隱藏層和輸出層組成。每個(gè)神經(jīng)元接收前一層神經(jīng)元的輸出作為輸入,并通過(guò)激活函數(shù)生成輸出,傳遞給下一層神經(jīng)元。前饋神經(jīng)網(wǎng)絡(luò)的訓(xùn)練過(guò)程通常使用反向傳播算法和梯度下降法。

前饋神經(jīng)網(wǎng)絡(luò)的優(yōu)點(diǎn)是結(jié)構(gòu)簡(jiǎn)單,易于實(shí)現(xiàn)和訓(xùn)練。然而,它在處理復(fù)雜的分類任務(wù)時(shí)可能表現(xiàn)不佳,因?yàn)樗荒芎芎玫夭蹲綌?shù)據(jù)的非線性特征。

1.1 多層感知器(Multilayer Perceptron, MLP)

多層感知器是一種包含多個(gè)隱藏層的前饋神經(jīng)網(wǎng)絡(luò)。通過(guò)增加隱藏層的數(shù)量,多層感知器可以更好地捕捉數(shù)據(jù)的非線性特征,提高分類性能。然而,過(guò)多的隱藏層可能導(dǎo)致過(guò)擬合問(wèn)題。

1.2 徑向基函數(shù)神經(jīng)網(wǎng)絡(luò)(Radial Basis Function Neural Networks, RBFNN)

徑向基函數(shù)神經(jīng)網(wǎng)絡(luò)是一種特殊的前饋神經(jīng)網(wǎng)絡(luò),其隱藏層神經(jīng)元使用徑向基函數(shù)作為激活函數(shù)。徑向基函數(shù)可以捕捉數(shù)據(jù)的局部特征,使得RBFNN在處理高維數(shù)據(jù)時(shí)具有較好的泛化能力。

- 卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Networks, CNN)

卷積神經(jīng)網(wǎng)絡(luò)是一種針對(duì)圖像數(shù)據(jù)設(shè)計(jì)的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),由卷積層、池化層和全連接層組成。卷積層通過(guò)卷積操作提取圖像的局部特征,池化層對(duì)特征進(jìn)行降維處理,全連接層則用于分類任務(wù)。

卷積神經(jīng)網(wǎng)絡(luò)的優(yōu)點(diǎn)是可以自動(dòng)學(xué)習(xí)圖像的局部特征,減少參數(shù)數(shù)量,提高計(jì)算效率。此外,卷積神經(jīng)網(wǎng)絡(luò)在圖像分類任務(wù)中表現(xiàn)出色,已成為圖像識(shí)別領(lǐng)域的主流模型。

2.1 AlexNet

AlexNet是一種深度卷積神經(jīng)網(wǎng)絡(luò),由5個(gè)卷積層和3個(gè)全連接層組成。AlexNet在2012年的ImageNet競(jìng)賽中取得了突破性的成績(jī),開(kāi)啟了深度學(xué)習(xí)在計(jì)算機(jī)視覺(jué)領(lǐng)域的應(yīng)用。

2.2 VGGNet

VGGNet是一種使用更小的卷積核和更深的網(wǎng)絡(luò)結(jié)構(gòu)的卷積神經(jīng)網(wǎng)絡(luò)。VGGNet通過(guò)重復(fù)使用3x3的卷積核和2x2的池化操作,實(shí)現(xiàn)了更深的網(wǎng)絡(luò)結(jié)構(gòu),提高了分類性能。

2.3 ResNet

ResNet是一種引入殘差連接的卷積神經(jīng)網(wǎng)絡(luò),可以解決深度網(wǎng)絡(luò)訓(xùn)練中的梯度消失問(wèn)題。ResNet通過(guò)添加跳躍連接,使得網(wǎng)絡(luò)可以學(xué)習(xí)到更深層次的特征,提高了分類性能。

- 循環(huán)神經(jīng)網(wǎng)絡(luò)(Recurrent Neural Networks, RNN)

循環(huán)神經(jīng)網(wǎng)絡(luò)是一種適合處理序列數(shù)據(jù)的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),由循環(huán)單元組成。循環(huán)單元可以存儲(chǔ)和傳遞前一個(gè)時(shí)間步的信息,使得RNN可以捕捉序列數(shù)據(jù)的時(shí)間依賴性。

循環(huán)神經(jīng)網(wǎng)絡(luò)的優(yōu)點(diǎn)是可以處理序列數(shù)據(jù),適用于自然語(yǔ)言處理、語(yǔ)音識(shí)別等領(lǐng)域。然而,RNN在處理長(zhǎng)序列數(shù)據(jù)時(shí)可能遇到梯度消失或梯度爆炸的問(wèn)題。

3.1 長(zhǎng)短期記憶網(wǎng)絡(luò)(Long Short-Term Memory, LSTM)

長(zhǎng)短期記憶網(wǎng)絡(luò)是一種改進(jìn)的循環(huán)神經(jīng)網(wǎng)絡(luò),通過(guò)引入門(mén)控機(jī)制解決了梯度消失問(wèn)題。LSTM通過(guò)輸入門(mén)、遺忘門(mén)和輸出門(mén)控制信息的流動(dòng),使得網(wǎng)絡(luò)可以學(xué)習(xí)到長(zhǎng)序列數(shù)據(jù)的特征。

3.2 門(mén)控循環(huán)單元(Gated Recurrent Unit, GRU)

門(mén)控循環(huán)單元是一種與LSTM類似的循環(huán)神經(jīng)網(wǎng)絡(luò),通過(guò)引入更新門(mén)和重置門(mén)控制信息的流動(dòng)。GRU的結(jié)構(gòu)相對(duì)簡(jiǎn)單,但在某些任務(wù)中可以與LSTM相媲美。

- 深度信念網(wǎng)絡(luò)(Deep Belief Networks, DBN)

深度信念網(wǎng)絡(luò)是一種由多層受限玻爾茲曼機(jī)(RBM)堆疊而成的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)。DBN可以通過(guò)無(wú)監(jiān)督預(yù)訓(xùn)練的方式學(xué)習(xí)數(shù)據(jù)的層次特征,然后通過(guò)有監(jiān)督微調(diào)的方式進(jìn)行分類任務(wù)。

深度信念網(wǎng)絡(luò)的優(yōu)點(diǎn)是可以通過(guò)無(wú)監(jiān)督預(yù)訓(xùn)練提高模型的泛化能力,適用于數(shù)據(jù)量較小的任務(wù)。然而,DBN的訓(xùn)練過(guò)程較為復(fù)雜,且在某些任務(wù)中可能不如其他神經(jīng)網(wǎng)絡(luò)模型。

- 長(zhǎng)短期記憶網(wǎng)絡(luò)(Long Short-Term Memory, LSTM)

長(zhǎng)短期記憶網(wǎng)絡(luò)是一種特殊的循環(huán)神經(jīng)網(wǎng)絡(luò),通過(guò)引入門(mén)控機(jī)制解決了梯度消失問(wèn)題。LSTM在處理序列數(shù)據(jù)時(shí)具有較好的性能,已被廣泛應(yīng)用于自然語(yǔ)言處理、語(yǔ)音識(shí)別等領(lǐng)域。

-

非線性

+關(guān)注

關(guān)注

1文章

213瀏覽量

23081 -

函數(shù)

+關(guān)注

關(guān)注

3文章

4331瀏覽量

62622 -

神經(jīng)網(wǎng)絡(luò)模型

+關(guān)注

關(guān)注

0文章

24瀏覽量

5610 -

神經(jīng)元

+關(guān)注

關(guān)注

1文章

363瀏覽量

18452

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

神經(jīng)網(wǎng)絡(luò)教程(李亞非)

Keras之ML~P:基于Keras中建立的簡(jiǎn)單的二分類問(wèn)題的神經(jīng)網(wǎng)絡(luò)模型

如何構(gòu)建神經(jīng)網(wǎng)絡(luò)?

輕量化神經(jīng)網(wǎng)絡(luò)的相關(guān)資料下載

卷積神經(jīng)網(wǎng)絡(luò)模型發(fā)展及應(yīng)用

神經(jīng)網(wǎng)絡(luò)分類

什么神經(jīng)網(wǎng)絡(luò)模型適合做分類

什么神經(jīng)網(wǎng)絡(luò)模型適合做分類

評(píng)論