驗證自動駕駛軟件需要數百萬公里的測試。這不僅意味著系統開發周期長,而且系統的復雜度也會不斷增加,同時,大規模的實車測試也會耗費巨量的資源并且可能會面臨未知的安全問題。aiSim這樣的虛擬仿真工具可以減輕真實世界測試的負擔。

AD和ADAS系統依靠閉環驗證來確保安全性和性能。然而,實現閉環評估需要一個能夠準確代表真實世界場景的3D環境。雖然這些3D環境可以由3D設計工程師手工構建,但這種方案很難解決Sim2Real的差距并且在可擴展方面存在一定的局限性。為此,本文為您介紹神經重建如何打破限制,在自動駕駛模擬中的具體應用。

一、神經渲染——彌合差距

神經渲染可以利用深度學習技術來緩解這個問題,它可以從一個新的視角上逼真地渲染靜態(和動態)環境。當然這種方法也存在一定的優劣點:

1、優點:

(1)高保真的仿真質量:神經渲染可以產生幾乎和現實無異的場景,增強現實感。

(2)數據驅動和可擴展:這種方法具有可擴展性,使其適用于實時應用(如3D高斯潑濺)。

2、缺點:

(1)分布外的對象:神經渲染很難將分布外(即以前未見過的)的對象插入 3D 環境中。

(2)偽影對動態物體的影響:偽影可能會影響動態物體的外觀。

(3)幾何不一致:在深度預測中,可能會出現幾何不一致。

二、現有生成模型的挑戰

目前的生成模型能夠創建高度逼真的圖像和視頻,但它們在幾個方面存在不足,例如:

(1)僅 2D 信息:這些模型不提供 3D 信息,僅在 2D 圖像空間中操作。

(2)射影幾何的空白:更多內容請參見https://arxiv.org/abs/2311.17138

(3)有限的傳感器模態:這些模型不能用于生成其他傳感器模態(例如,激光雷達)。

總之,當前的生成模型不適合汽車級驗證。

三、康謀混合解決方案:集成式神經重建

為了解決這些限制,aiSim5提供了一種混合方案。在成熟的基于物理的渲染方案中集成最前沿的神經重建技術,使我們能夠在任意位置虛擬地插入動態對象,調整環境條件,并渲染以前未見過的相機視角。

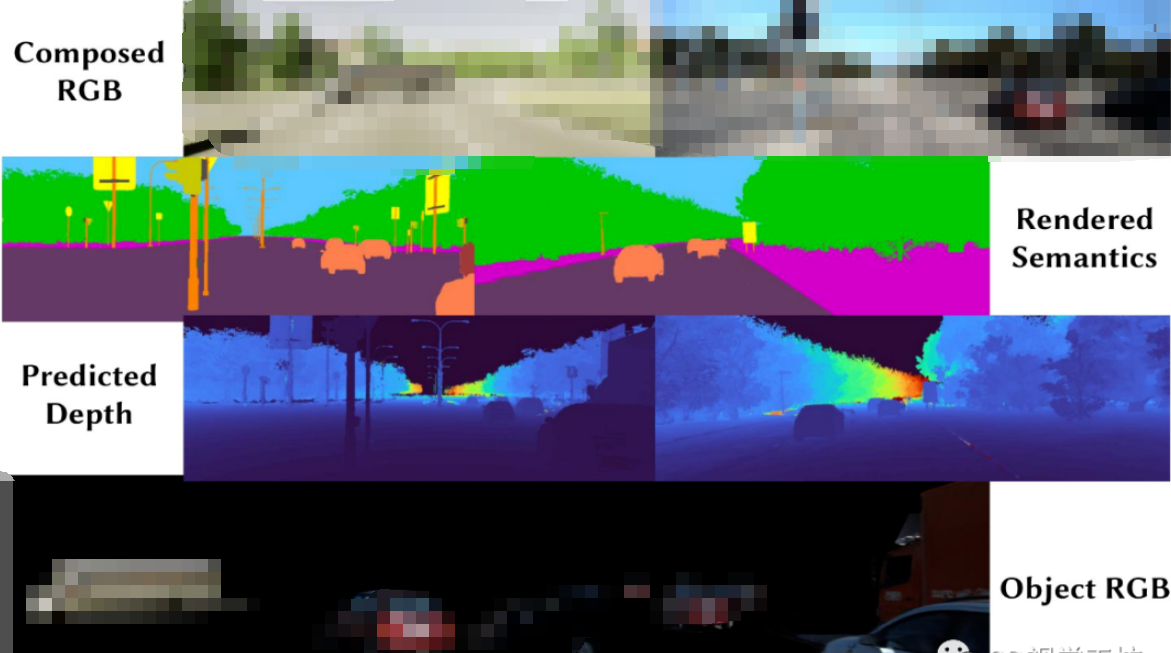

通過這種方式,我們能實現以下的功能:

1、虛擬動態內容插入

(1)添加具有逼真光照和環境光遮蔽的動態對象。

(2)模擬如雨、雪、霧等環境效果,以創建更多樣化的模擬場景。

2、多模態渲染:

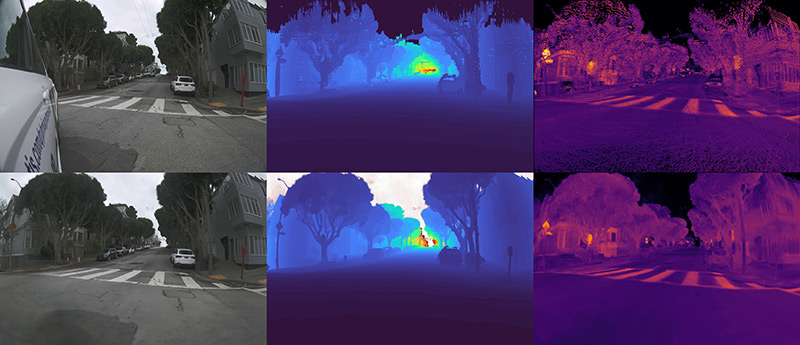

(1)從任意相機視角生成精確的RGB圖像、深度圖和激光雷達強度圖(如下圖所示,第一行為GT)。

(2)未來的工作將包括語義分割掩碼和雷達仿真。

3、相機虛擬化:

(1)模擬各種虛擬相機設置,包括不同的相機的安裝和定向以及模型。

(2)下圖展示了模擬的前置魚眼(左)、前置廣角(中)和前置長距(右)相機的渲染效果,這些圖像是通過一個沒有直接使用前置相機數據訓練的模型生產的,也就是說,這些視角并沒有專門采集數據進行訓練。

-

仿真

+關注

關注

50文章

4082瀏覽量

133613 -

軟件

+關注

關注

69文章

4944瀏覽量

87500 -

渲染

+關注

關注

0文章

69瀏覽量

10920 -

智能汽車

+關注

關注

30文章

2852瀏覽量

107278 -

自動駕駛

+關注

關注

784文章

13812瀏覽量

166461

發布評論請先 登錄

相關推薦

FPGA在自動駕駛領域有哪些應用?

【話題】特斯拉首起自動駕駛致命車禍,自動駕駛的冬天來了?

自動駕駛真的會來嗎?

自動駕駛的到來

AI/自動駕駛領域的巔峰會議—國際AI自動駕駛高峰論壇

神經網絡解決方案讓自動駕駛成為現實

【PYNQ-Z2申請】基于PYNQ的神經網絡自動駕駛小車

【PYNQ-Z2試用體驗】基于PYNQ的神經網絡自動駕駛小車 - 項目規劃

自動駕駛汽車的處理能力怎么樣?

自動駕駛汽車中傳感器的分析

自動駕駛系統要完成哪些計算機視覺任務?

如何保證自動駕駛的安全?

基于神經輻射場(NeRFs)的自動駕駛模擬器

神經重建在自動駕駛模擬中的應用

神經重建在自動駕駛模擬中的應用

評論