OpenAI新模型o1號稱編程能力8倍殺GPT-4o,MMLU媲美人類專家,MMLU是什么?評估大模型的標準是什么?

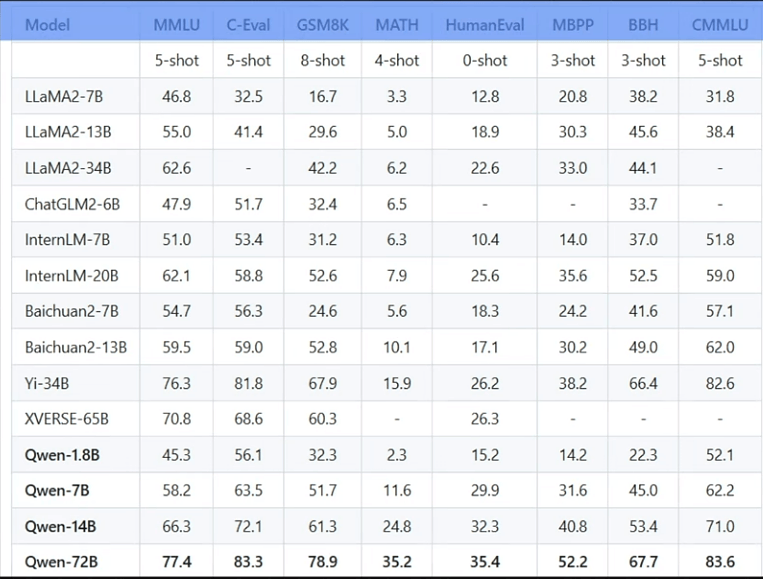

相信大家在閱讀大模型相關文檔的時候經常會看到MMLU,BBH,GSM8K,MATH,HumanEval,MBPP,C-Eval,CMMLU等等這些都是什么?大模型訓練完成后,如何客觀地評估其效果呢?

當然我們不能依靠主觀判斷,于是研究者們制定了一系列標準,用于測評大模型在不同數據集上的表現。而這些數據集( MMLU、C-Eval、GSM8K、MATH、HumanEval、MBPP、BBH 和 CMMLU),正是用于評估大模型性能的重要依據。

當然,它們也也可用于模型訓練。

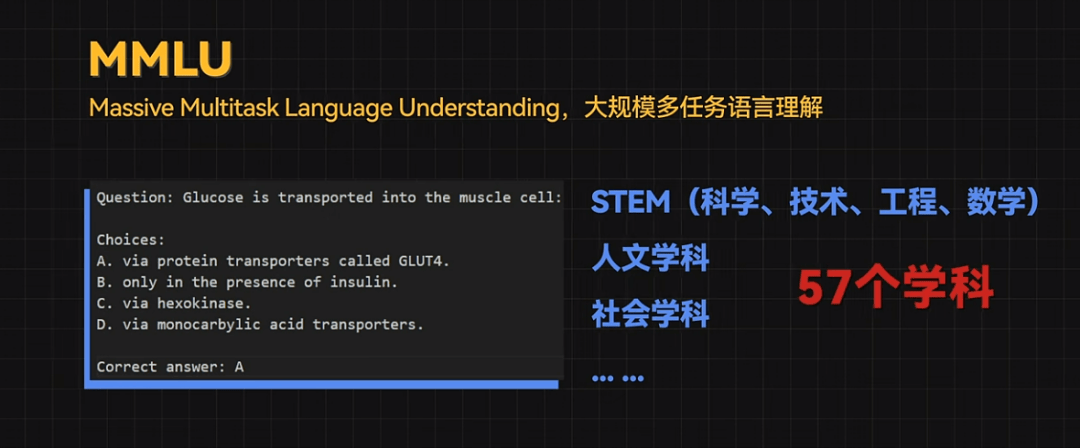

MMLU這個基準包含STEM(科學、技術、工程、數學)、人文學科、社會學科等57個學科領域,難度從初級到高級不等。

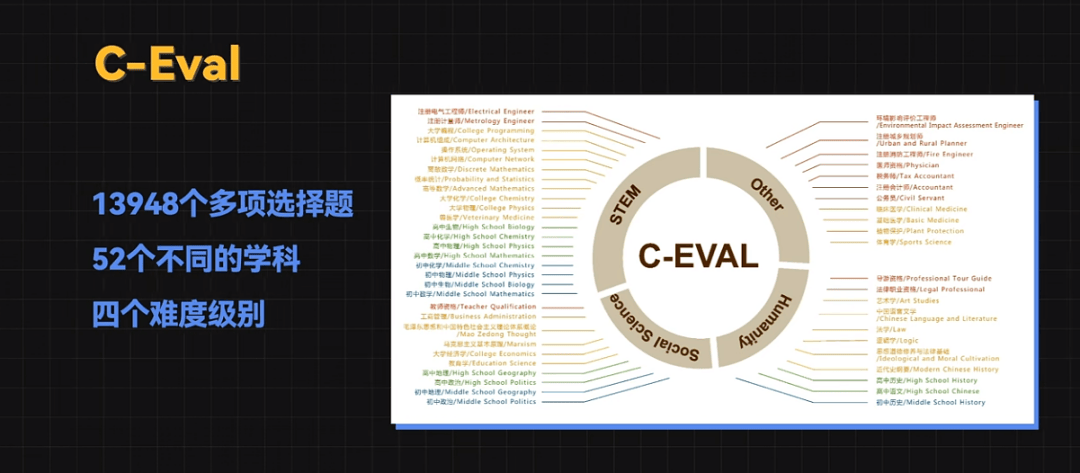

C-Eval 是一個全面的中文基礎模型評估套件,它包含了13948個多項選擇題,涵蓋了52個不同的學科和四個難度級別。

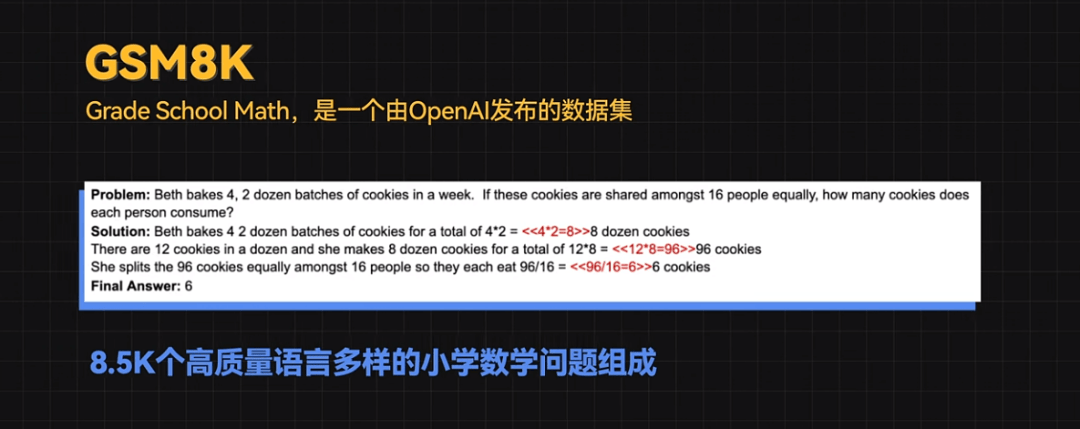

GSM8K(Grade School Math)是一個由OpenAI發布的數據集,有8.5K個高質量語言多樣的小學數學問題組成。這些問題需要 2 到 8 個步驟來解決,解決方法主要是使用基本的算術運算(+ - / *)進行一連串的基本計算,以得出最終答案。

雖然看起來很簡單,但很多大模型的表現都不太好。

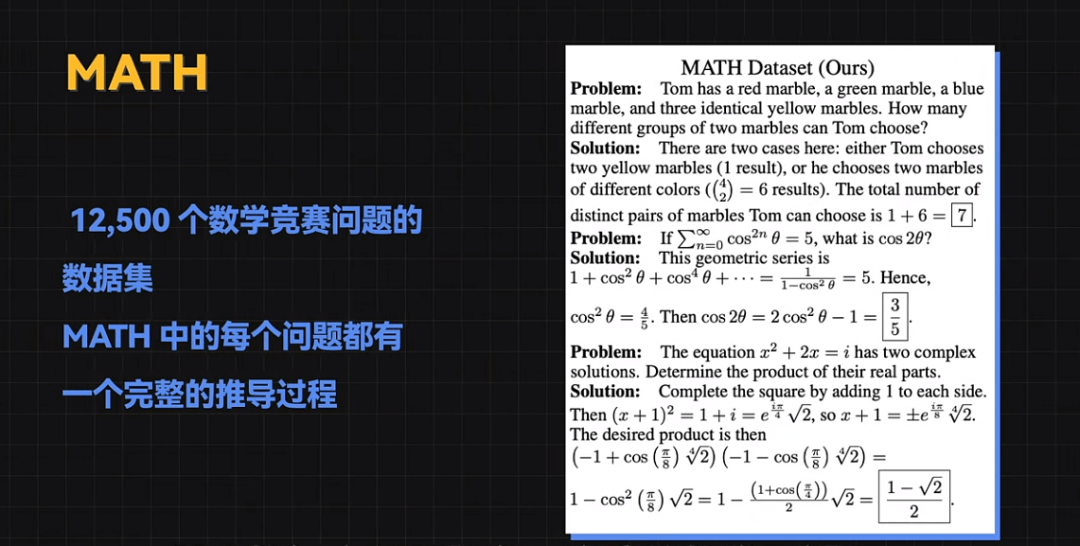

MATH是一個包含 12500 個數學競賽問題的數據集,其中的每個問題都有一個完整的推導過程。

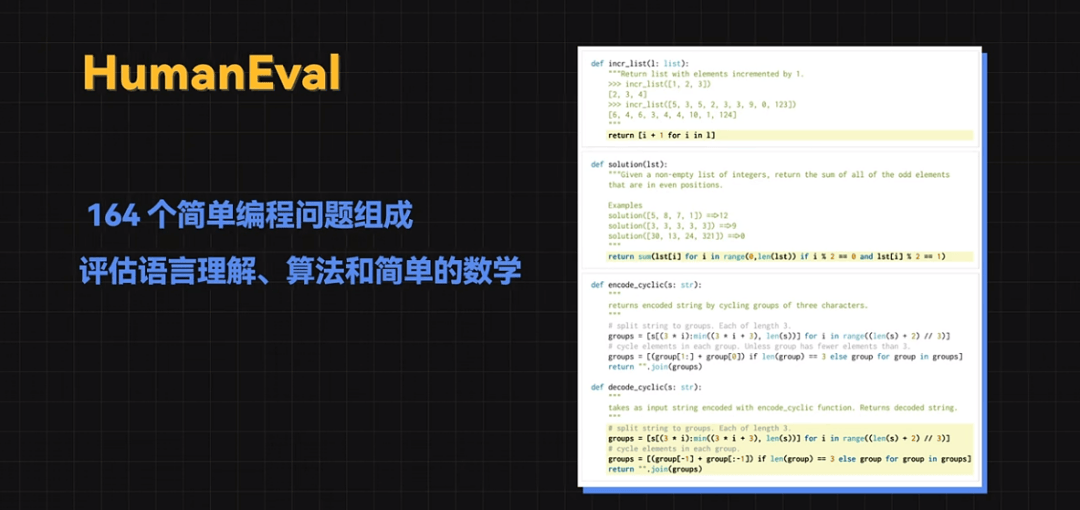

HumanEval是由 164 個簡單編程問題組成,主要用來評估語言理解、算法和簡單的數學。

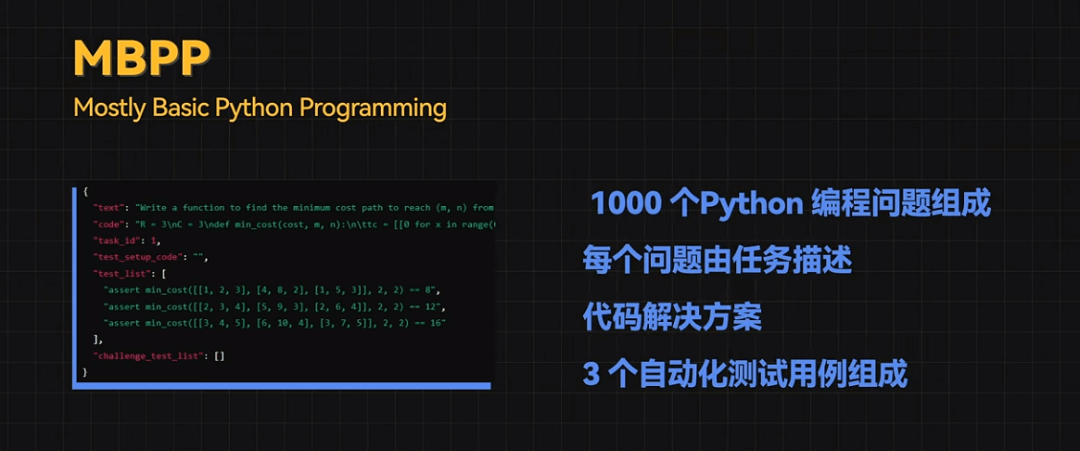

MBPP(Mostly Basic Python Programming)由大約 1000 個Python 編程問題組成,每個問題由任務描述、代碼解決方案和 3 個自動化測試用例組成。

BBH的全稱是BIG-Bench Hard,它是BIG-Bench數據集的一個子集,它專注于23個具有挑戰性的任務,這些任務超出了當前語言模型的能力范圍,BBH中的任務需要進行多步驟推理。

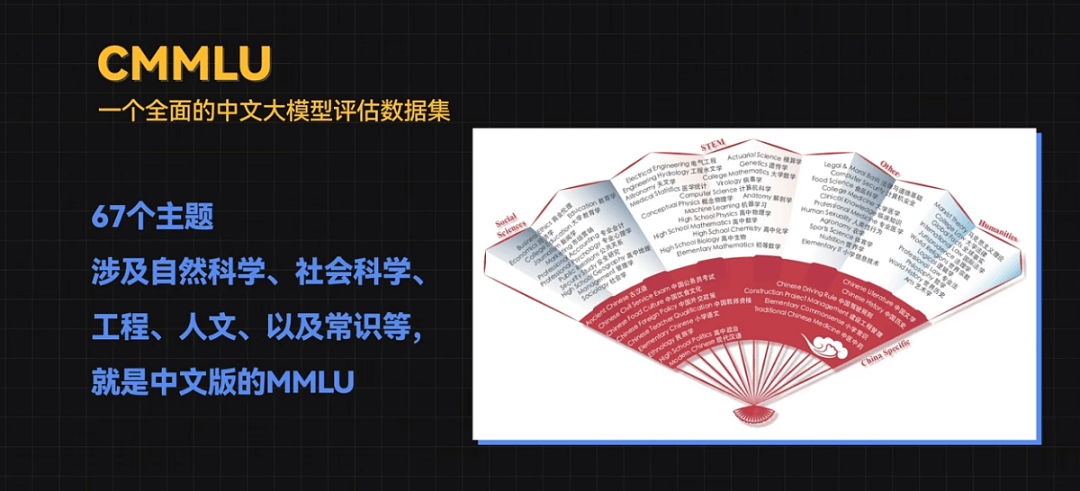

CMMLU,一個全面的中文大模型評估數據集。它涵蓋了67個主題,涉及自然科學、社會科學、工程、人文、以及常識等,就是中文版的MMLU。

通過這些評測數據集和評估標準,我們可以從不同角度系統地評估大模型的性能、泛化能力和魯棒性,為大模型的進一步研究和應用提供科學依據。

AI體系化學習路線

學習資料免費領

? AI全體系學習路線超詳版

? AI體驗卡(AI實驗平臺體驗權限)

? 100余講AI視頻課程

? 項目源碼《從零開始訓練與部署YOLOV8》

? 170余篇AI經典論文

全體系課程詳情介紹

-

AI

+關注

關注

87文章

30887瀏覽量

269069 -

人工智能

+關注

關注

1791文章

47274瀏覽量

238468 -

大模型

+關注

關注

2文章

2448瀏覽量

2702

發布評論請先 登錄

相關推薦

【每天學點AI】實戰圖像增強技術在人工智能圖像處理中的應用

【每天學點AI】人工智能大模型評估標準有哪些?

【每天學點AI】人工智能大模型評估標準有哪些?

評論