編者按:在工業(yè)界大量資源的投入下,大數(shù)據(jù)、大規(guī)模GPU集群帶來(lái)了深度學(xué)習(xí)在計(jì)算機(jī)視覺(jué)領(lǐng)域的全面產(chǎn)業(yè)落地,在很多競(jìng)賽中甚至取得遠(yuǎn)超學(xué)術(shù)界的成績(jī)。在AI領(lǐng)域的各個(gè)頂級(jí)會(huì)議上,越來(lái)越多的優(yōu)秀工作也來(lái)自于Google、Facebook、BAT等巨頭或者一些新銳創(chuàng)業(yè)公司。

值得注意的是,工業(yè)界目前的主要進(jìn)展和應(yīng)用落地,很大程度上依賴于高成本的有監(jiān)督深度學(xué)習(xí)。而在很多實(shí)際場(chǎng)景中,存在數(shù)據(jù)獲取成本過(guò)高、甚至無(wú)法獲取的問(wèn)題。因此,在數(shù)據(jù)不足的情況下,如何使用弱監(jiān)督、乃至無(wú)監(jiān)督的方式進(jìn)行學(xué)習(xí),這既是學(xué)術(shù)界中大家廣泛關(guān)注的問(wèn)題,其實(shí)也是工業(yè)界面臨的新挑戰(zhàn)。

商湯科技研發(fā)總監(jiān)、中山大學(xué)教授林倞,將從產(chǎn)業(yè)落地以及學(xué)術(shù)創(chuàng)新兩種視角出發(fā),帶領(lǐng)大家一起探索“后深度學(xué)習(xí)時(shí)代”的新挑戰(zhàn)。

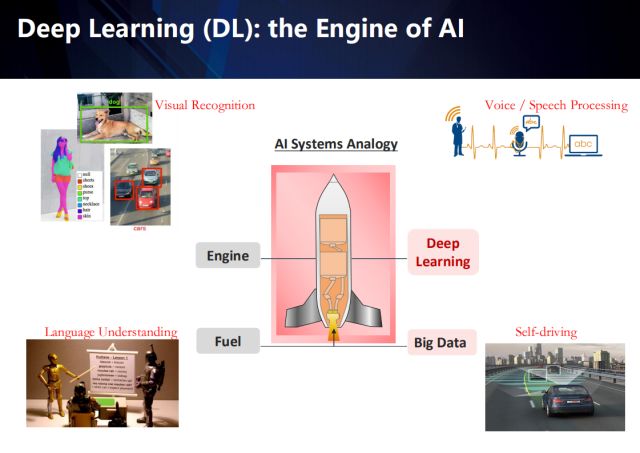

如果把AI系統(tǒng)比作為一架火箭,那么大數(shù)據(jù)就是它的燃料,深度學(xué)習(xí)則是它的引擎。隨著大數(shù)據(jù)以及GPU算力的加持,深度學(xué)習(xí)在很多領(lǐng)域都取得了突破性的進(jìn)展,例如視覺(jué)圖像理解、屬性識(shí)別、物體檢測(cè)、自然語(yǔ)言處理、乃至自動(dòng)駕駛。當(dāng)然了,垂直化應(yīng)用場(chǎng)景才是AI技術(shù)落地不可或缺的因素,這其實(shí)也是在工業(yè)界做研究的最大優(yōu)勢(shì)——從真實(shí)的需求引導(dǎo)技術(shù)的發(fā)展,而學(xué)術(shù)界的科研往往基于一些不太實(shí)際的假設(shè)。

基于視覺(jué)的圖像理解,是從有標(biāo)注的數(shù)據(jù)學(xué)習(xí)出AI算法,以實(shí)現(xiàn)相應(yīng)的視覺(jué)識(shí)別任務(wù),左上角展示了視覺(jué)圖像理解中的物體檢測(cè)以及屬性識(shí)別應(yīng)用。

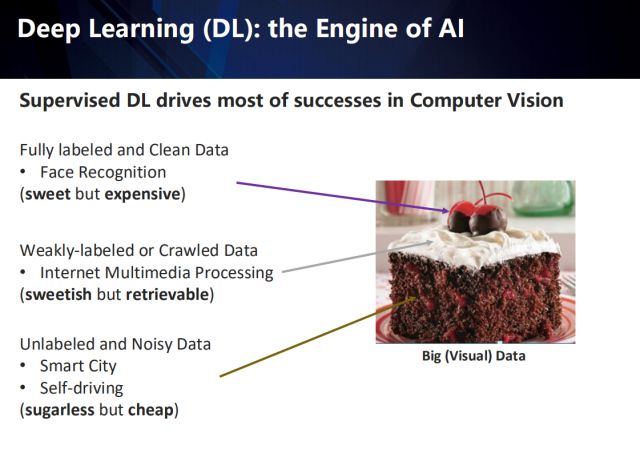

而值得注意的是,深度學(xué)習(xí)在計(jì)算機(jī)視覺(jué)領(lǐng)域的成功應(yīng)用,很大程度上依賴于有監(jiān)督的數(shù)據(jù),這意味著大量的完全標(biāo)注的干凈數(shù)據(jù)(例如人臉識(shí)別領(lǐng)域的數(shù)據(jù))。然而,這樣的數(shù)據(jù)意味著非常高昂的成本。在真實(shí)的場(chǎng)景中,經(jīng)常存在的是弱監(jiān)督或者從互聯(lián)網(wǎng)上獲取的數(shù)據(jù)(例如網(wǎng)絡(luò)社交媒體的數(shù)據(jù)),以及無(wú)標(biāo)注或者標(biāo)注有噪聲的數(shù)據(jù)(例如智慧城市以及自動(dòng)駕駛等應(yīng)用中采集到的數(shù)據(jù))。

LeCun教授曾用右圖的蛋糕,來(lái)形容有監(jiān)督學(xué)習(xí)、無(wú)監(jiān)督學(xué)習(xí)、以及強(qiáng)化學(xué)習(xí)之間的區(qū)別,這里借用來(lái)說(shuō)明這三種數(shù)據(jù)的區(qū)別:完全標(biāo)注的干凈數(shù)據(jù)就像蛋糕上的金箔櫻桃,甜美卻昂貴;而弱標(biāo)注或互聯(lián)網(wǎng)爬取的數(shù)據(jù),就像蛋糕上的奶油,還算甜但也可獲取;而無(wú)標(biāo)注的或者標(biāo)注有噪聲的數(shù)據(jù),不太甜但成本較低。

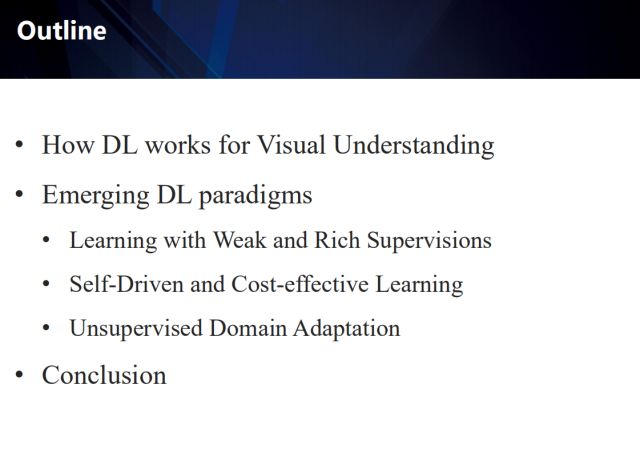

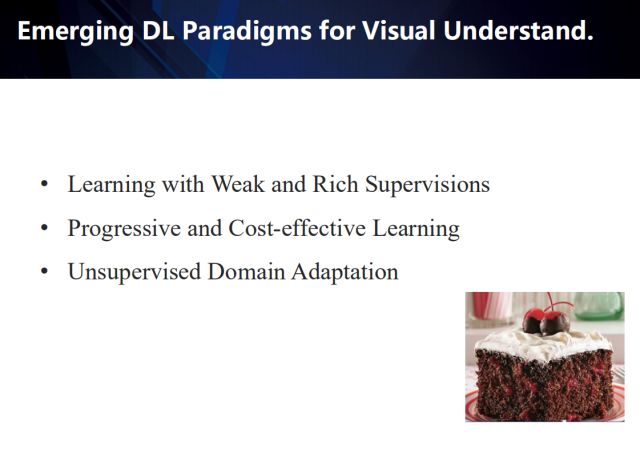

在本次報(bào)告中,我將首先介紹深度學(xué)習(xí)如何應(yīng)用于視覺(jué)理解,接下來(lái)會(huì)從三個(gè)方面介紹最新的深度學(xué)習(xí)范式:

以豐富多源的弱監(jiān)督信息來(lái)輔助學(xué)習(xí)

算法自驅(qū)動(dòng)、具有高性價(jià)比(性能/監(jiān)督信息成本)的自主學(xué)習(xí)

無(wú)監(jiān)督領(lǐng)域自適應(yīng)學(xué)習(xí)

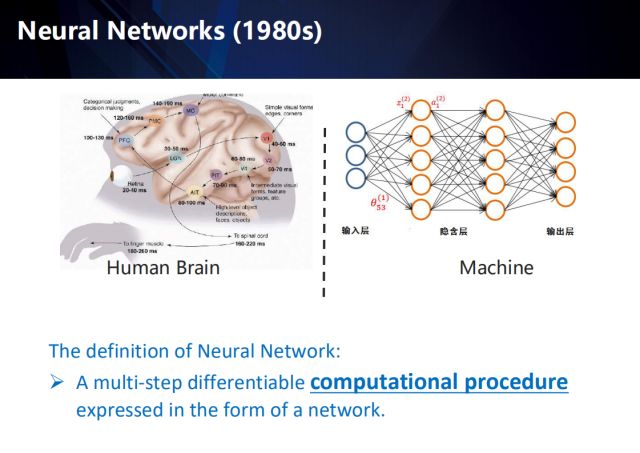

首先介紹一下深度學(xué)習(xí)的基本概念,深度學(xué)習(xí)被定義為最終以網(wǎng)絡(luò)形式呈現(xiàn)的、涵蓋了多個(gè)步驟的、可微分的計(jì)算過(guò)程。而說(shuō)起深度學(xué)習(xí),就要從上世紀(jì)80年代的神經(jīng)網(wǎng)絡(luò)開(kāi)始講起。神經(jīng)網(wǎng)絡(luò)其命名的初衷,是向人腦中的神經(jīng)網(wǎng)絡(luò)致敬。那么人腦中是如何處理視覺(jué)信號(hào)呢?

首先,視網(wǎng)膜輸入視覺(jué)信號(hào),經(jīng)過(guò)LGN外膝體,到達(dá)視覺(jué)皮層V1—V5,其中V1對(duì)邊緣和角點(diǎn)敏感,V2捕捉運(yùn)動(dòng)信息, V4對(duì)part物件敏感,例如人的眼睛、胳膊等,最后到達(dá)AIT,來(lái)處理高層信息:臉、物體等。送到PFC決策層,最后由MC發(fā)出指令。所以人腦處理視覺(jué)信號(hào)是一個(gè)從淺層到深層的過(guò)程,而在此過(guò)程中,并不是一個(gè)單一的處理,它還具備時(shí)序性,也就是說(shuō)它在處理每個(gè)信號(hào)時(shí),都是利用了之前的時(shí)序信息的。

深度神經(jīng)網(wǎng)絡(luò)的形式和計(jì)算過(guò)程與人腦有很大的不同,不過(guò)它的發(fā)明的確是受到了神經(jīng)信號(hào)處理的啟發(fā),例如經(jīng)典的感知機(jī)模型其實(shí)是對(duì)神經(jīng)元最基本概念的模擬。右上展示了1980年發(fā)明的多層感知機(jī)。

從1980年代的多層感知機(jī)到2010年的卷積神經(jīng)網(wǎng)絡(luò),它經(jīng)歷了一個(gè)層數(shù)由少至多、層級(jí)由淺至深的過(guò)程,通過(guò)解決網(wǎng)絡(luò)梯度消失以及泛化不好的問(wèn)題,以及數(shù)據(jù)及GPU的加持,它終于實(shí)現(xiàn)了一個(gè)一站式的端到端的網(wǎng)絡(luò)。

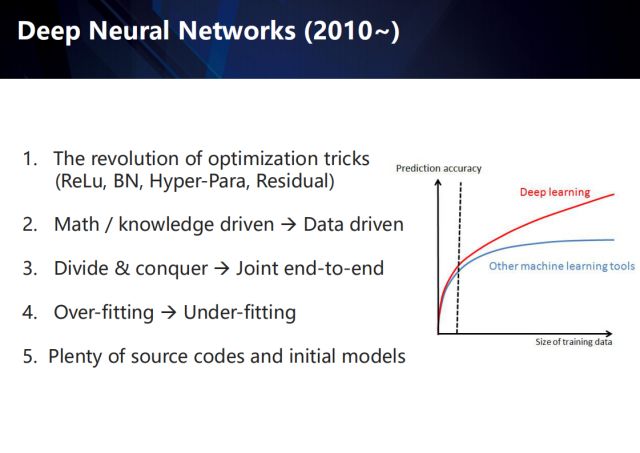

自2010年起,深度學(xué)習(xí)方法取得了遠(yuǎn)超傳統(tǒng)機(jī)器學(xué)習(xí)方法的成績(jī),尤其隨著訓(xùn)練數(shù)據(jù)集的不斷擴(kuò)展,傳統(tǒng)方法迅速觸碰到精度天花板,相比之下,深度方法的預(yù)測(cè)精度則不斷提升。這里總結(jié)了這一波深度學(xué)習(xí)技術(shù)革新的幾個(gè)關(guān)鍵點(diǎn),包括新的網(wǎng)絡(luò)優(yōu)化方法,如ReLu,Batch Normally,Skip Connection等;從數(shù)學(xué)/知識(shí)驅(qū)動(dòng)到數(shù)據(jù)驅(qū)動(dòng)的研究思路的轉(zhuǎn)變;分治優(yōu)化逐漸過(guò)渡到聯(lián)合端到端聯(lián)合優(yōu)化;從避免過(guò)擬合學(xué)習(xí)到避免欠擬合學(xué)習(xí);大量的開(kāi)源代碼和初始化模型的涌現(xiàn)。

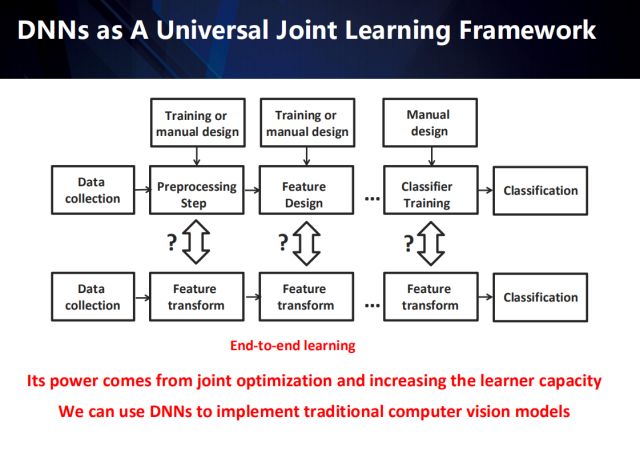

傳統(tǒng)的模式識(shí)別任務(wù),大致可總結(jié)為幾個(gè)獨(dú)立的步驟:包括數(shù)據(jù)采集、數(shù)據(jù)預(yù)處理、特征提取、分類器訓(xùn)練以及最終的分類。其中,數(shù)據(jù)預(yù)處理器和特征提取器的設(shè)計(jì)都是以經(jīng)驗(yàn)為驅(qū)動(dòng)的。而深度學(xué)習(xí)通過(guò)將預(yù)處理、特征提取以及分類訓(xùn)練任務(wù)融合,因此衍生出了一個(gè),具有更強(qiáng)表示能力的端到端的特征轉(zhuǎn)換網(wǎng)絡(luò)。

在傳統(tǒng)模式識(shí)別方法到深度方法的演變過(guò)程中,我們?cè)絹?lái)越體會(huì)到學(xué)習(xí)的重要性,而特征學(xué)習(xí)也已進(jìn)化成一個(gè)端到端的學(xué)習(xí)系統(tǒng),傳統(tǒng)方法中的預(yù)處理已不是必須手段,而被融入端到端的系統(tǒng)中。似乎特征學(xué)習(xí)影響著一切模式識(shí)別任務(wù)的性能,然而,我們卻忽視了數(shù)據(jù)收集和評(píng)估的重要性。

接下來(lái)我們舉例說(shuō)明傳統(tǒng)方法是如何演化為深度方法的。

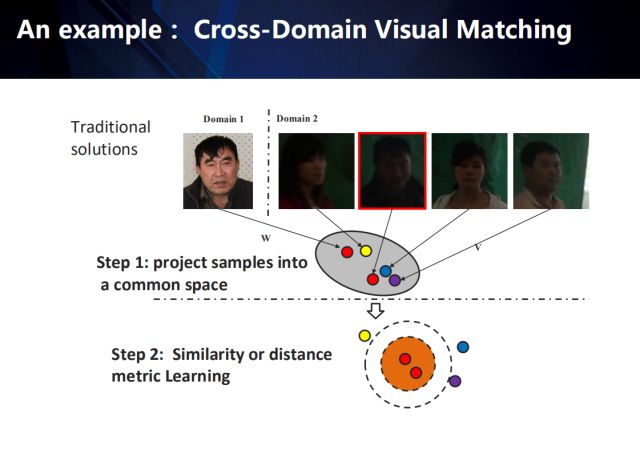

以跨領(lǐng)域視覺(jué)匹配任務(wù)(從領(lǐng)域2的數(shù)據(jù)中匹配到給定的領(lǐng)域1中的目標(biāo))為例,傳統(tǒng)的方法一般會(huì)包含以下兩個(gè)步驟:

首先,將來(lái)自于不同領(lǐng)域的樣本投影到一個(gè)公共的特征空間 (特征學(xué)習(xí));

然后,采用相似性或距離度量學(xué)習(xí)的方式,學(xué)習(xí)到一種距離度量,來(lái)表征這個(gè)公共空間上特征之間的相似性 (相似性度量學(xué)習(xí))。

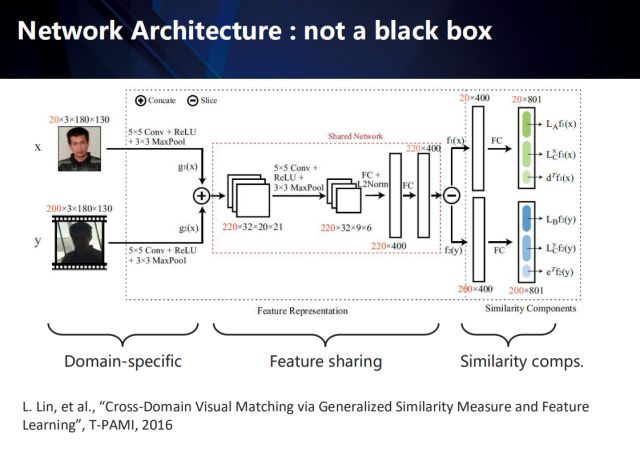

那么如何將這種相似性的度量整合到深度神經(jīng)網(wǎng)絡(luò)中,并進(jìn)行端到端的學(xué)習(xí)呢?

如何把相似性度量融合到特征提取中去?

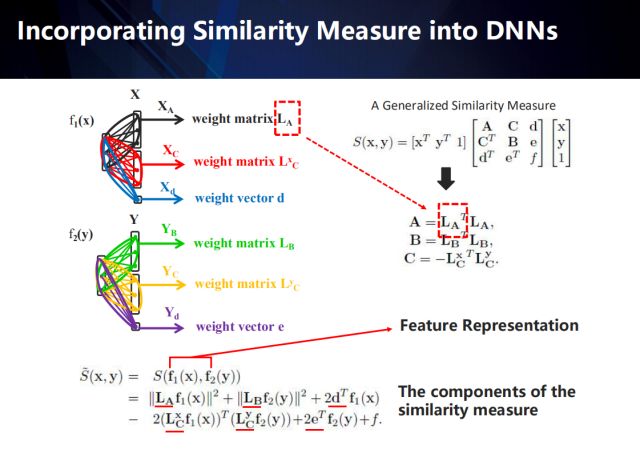

以右上公式表示的相似性度量方法為例 (度量模型的提出和推導(dǎo)請(qǐng)參加相關(guān)論文),我們可以將該度量模型分解后融入到神經(jīng)網(wǎng)絡(luò)中——將原來(lái)的全連接網(wǎng)絡(luò)表示成成若干個(gè)與度量模型相匹配的結(jié)構(gòu)化網(wǎng)絡(luò)。再通過(guò)誤差反向傳導(dǎo),可以將度量模型與卷積特征進(jìn)行聯(lián)合學(xué)習(xí)、統(tǒng)一優(yōu)化。詳細(xì)過(guò)程如下:

右上公式中, A矩陣為x樣本所在領(lǐng)域中樣本間的自相關(guān)矩陣,半正定; B矩陣表示y樣本所在領(lǐng)域中樣本間的自相關(guān)矩陣,半正定;C矩陣則是兩個(gè)領(lǐng)域樣本間的相關(guān)矩陣。

展開(kāi)后我們可以發(fā)現(xiàn),其組成成分除了網(wǎng)絡(luò)從不同域提取到的特征外,還包含6個(gè)不同的表達(dá)距離度量模型的變量(每個(gè)域包含2個(gè)矩陣和1個(gè)向量)。圖中左上部分顯示了我們將分解后的距離度量變量融入到神經(jīng)網(wǎng)絡(luò)中的過(guò)程——結(jié)構(gòu)化的網(wǎng)絡(luò)模型。

由此看來(lái),深度網(wǎng)絡(luò)并不是完全的黑盒子,通過(guò)引入領(lǐng)域知識(shí)和結(jié)構(gòu)化模型,是可以具備一定的宏觀解釋性的。

以跨域視覺(jué)匹配算法為例,其內(nèi)部可歸納為三個(gè)部分:域獨(dú)有層、特征共享層、以及相似度量。

整個(gè)端到端的網(wǎng)絡(luò)如圖所示,其每個(gè)部分都具有可解釋性。

在域獨(dú)有層,該網(wǎng)絡(luò)為不同域的數(shù)據(jù)提取該域的獨(dú)有特征;

在特征共享層,我們首先將不同域的特征融合,再將融合后的特征投影到共有空間下,再反向拆解出各自域在該共有空間下的特征;

最終通過(guò)相似性度量得到不同域樣本間的匹配相似度。

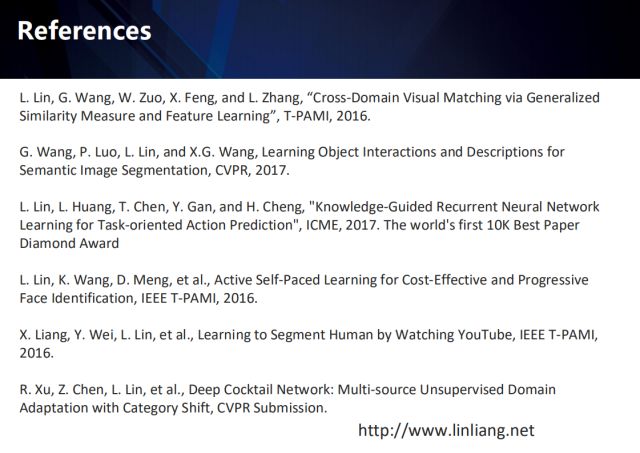

相關(guān)的工作發(fā)表在T-PAMI 2016上,該模型在當(dāng)時(shí)很多領(lǐng)域取得了state-of-the-arts的效果。

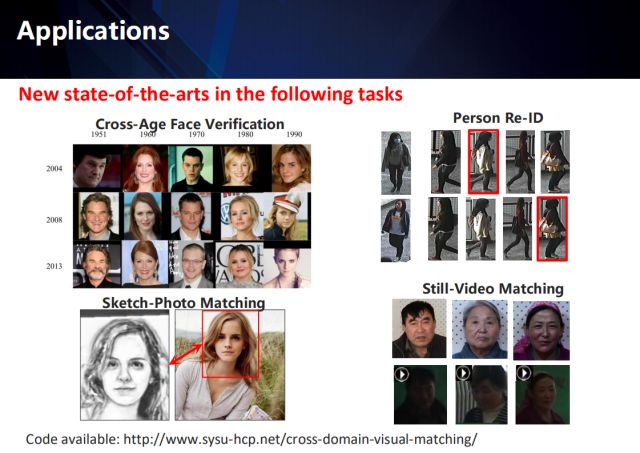

我們的驗(yàn)證基準(zhǔn)包括的幾個(gè)主要任務(wù):年齡人臉驗(yàn)證、跨攝像頭的行人再識(shí)別、素描畫(huà)與照片間的匹配、以及靜態(tài)圖片與靜態(tài)視頻間的匹配。

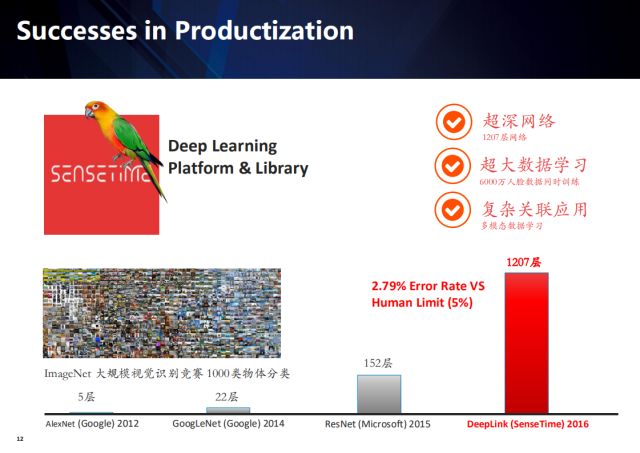

相比較之下,在公司做深度學(xué)習(xí)則充分發(fā)揮了海量計(jì)算資源和充足數(shù)據(jù)量的優(yōu)勢(shì),學(xué)術(shù)界精心設(shè)計(jì)的算法優(yōu)勢(shì)很容易被工程化的能力抵消。

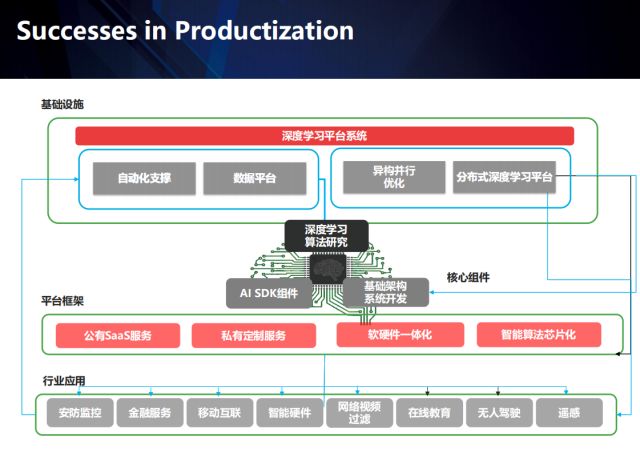

此外,區(qū)別于學(xué)術(shù)界只關(guān)注算法本身的模式,在工業(yè)界做產(chǎn)品,則涉及到大量的環(huán)節(jié),不同的場(chǎng)景會(huì)衍生出不同的問(wèn)題,此時(shí)通過(guò)應(yīng)用場(chǎng)景形成數(shù)據(jù)閉環(huán)成為關(guān)鍵。商湯投入了大量資源建設(shè)基礎(chǔ)平臺(tái)、工程化團(tuán)隊(duì),通過(guò)深入各個(gè)垂直領(lǐng)域、積攢行業(yè)數(shù)據(jù)、建立行業(yè)壁壘,目前正在從AI平臺(tái)公司逐漸向AI產(chǎn)品公司過(guò)渡。

在工業(yè)界大量資源的投入下,大數(shù)據(jù)、大規(guī)模GPU集群帶來(lái)了深度學(xué)習(xí)在計(jì)算機(jī)視覺(jué)領(lǐng)域的全面產(chǎn)業(yè)落地,在很多競(jìng)賽中甚至取得遠(yuǎn)超學(xué)術(shù)界的成績(jī)。值得注意的是,工業(yè)界的這些進(jìn)展的取得,是依賴于大量的全監(jiān)督數(shù)據(jù)的,而在很多實(shí)際場(chǎng)景中,存在數(shù)據(jù)獲取成本過(guò)高、甚至無(wú)法獲取的問(wèn)題。2012年以來(lái),深度學(xué)習(xí)技術(shù)的高速發(fā)展并且在圖像、語(yǔ)音等各個(gè)領(lǐng)域的取得了大量的成功應(yīng)用,如果把這5年看成是一個(gè)新的技術(shù)時(shí)代, 那么在“后深度學(xué)習(xí)”時(shí)代,我們更應(yīng)該關(guān)注哪些方向呢?

我在這個(gè)報(bào)告中給出一些想法——介紹3個(gè)新的深度學(xué)習(xí)范式:

以豐富多源的弱監(jiān)督信息來(lái)輔助學(xué)習(xí)

算法自驅(qū)動(dòng)、成本效益較高的自主學(xué)習(xí)

無(wú)監(jiān)督領(lǐng)域自適應(yīng)學(xué)習(xí)

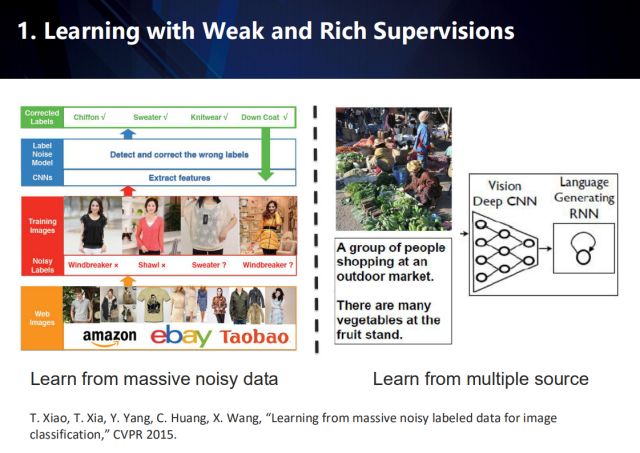

Learning with Weak and Rich Supervisions

首先來(lái)介紹如何以豐富多源的弱監(jiān)督信息來(lái)輔助學(xué)習(xí)。

由于網(wǎng)頁(yè)形式的多樣化,從互聯(lián)網(wǎng)上獲取的數(shù)據(jù)時(shí)常具備多種類型的標(biāo)簽,然而卻不能保證標(biāo)簽的準(zhǔn)確性, 往往存在標(biāo)簽噪聲 。因此,這類數(shù)據(jù)可以看作具備豐富多源的弱監(jiān)督信息。那么,我們考慮通過(guò)學(xué)習(xí)多個(gè)源的弱監(jiān)督信息,來(lái)對(duì)標(biāo)簽進(jìn)行更正。

將大量的數(shù)據(jù)連同帶有小量噪聲的標(biāo)簽,一起送入深度卷積神經(jīng)網(wǎng)絡(luò),檢測(cè)其中的標(biāo)簽噪聲并進(jìn)行更正。例如,右圖展示了,通過(guò)融合圖像數(shù)據(jù)以及對(duì)應(yīng)的文本描述,來(lái)輔助對(duì)標(biāo)簽進(jìn)行更正。

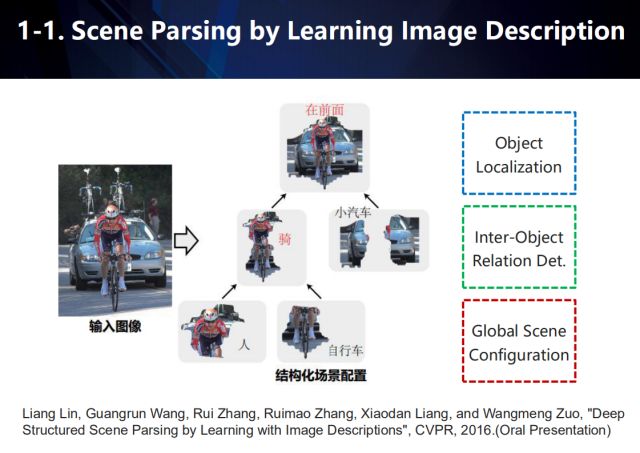

在場(chǎng)景解析任務(wù)中,我們通過(guò)學(xué)習(xí)圖像的描述來(lái)解析場(chǎng)景。如圖所示,利用物體定位來(lái)獲取場(chǎng)景中具有顯著性語(yǔ)義的物體,然后根據(jù)物體間的交互關(guān)系構(gòu)建結(jié)構(gòu)化場(chǎng)景配置。

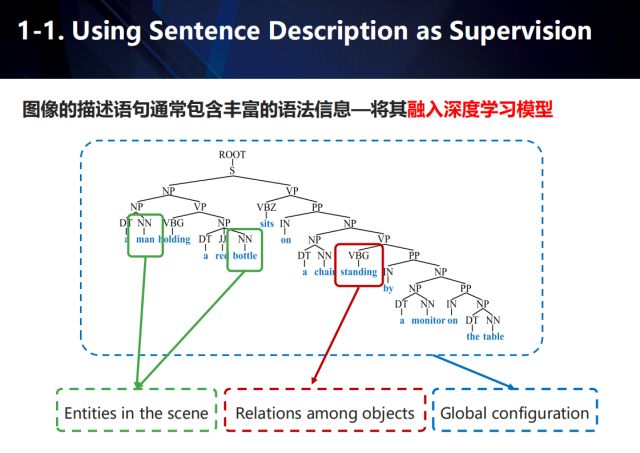

而圖像的描述語(yǔ)句通常包含豐富的語(yǔ)法信息,如果能將這些信息融入深度學(xué)習(xí)模型,那么可以將其看作一種輔助的監(jiān)督手段。以對(duì)圖像描述這一應(yīng)用為例,如圖所示,我們用綠色框表示場(chǎng)景中出現(xiàn)的實(shí)體,紅色框表示實(shí)體之間的關(guān)系,而藍(lán)色框表示場(chǎng)景的全局配置結(jié)構(gòu)。

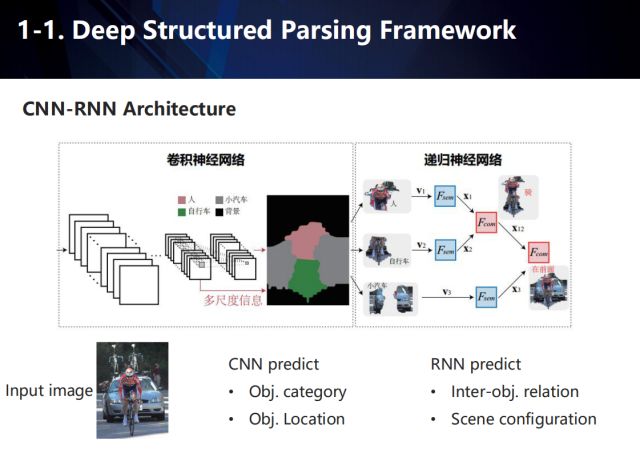

基于上述所說(shuō),我們提出了一個(gè)端到端的,結(jié)合卷積神經(jīng)網(wǎng)絡(luò)和遞歸神經(jīng)網(wǎng)絡(luò)的,深度結(jié)構(gòu)化場(chǎng)景解析框架。輸入的圖片經(jīng)過(guò)卷積神經(jīng)網(wǎng)絡(luò)后,會(huì)為每個(gè)語(yǔ)義類別產(chǎn)生得分圖以及每個(gè)像素的特征表達(dá),然后根據(jù)這些得分圖對(duì)每個(gè)像素進(jìn)行分類,并將同類別的像素聚合到一起,最終獲取場(chǎng)景內(nèi)v個(gè)目標(biāo)的特征表達(dá)。然后將這v個(gè)目標(biāo)的特征送入到遞歸神經(jīng)網(wǎng)絡(luò)中,并映射到某個(gè)語(yǔ)義空間,提取語(yǔ)義以預(yù)測(cè)物體間的交互關(guān)系。其訓(xùn)練過(guò)程如下:

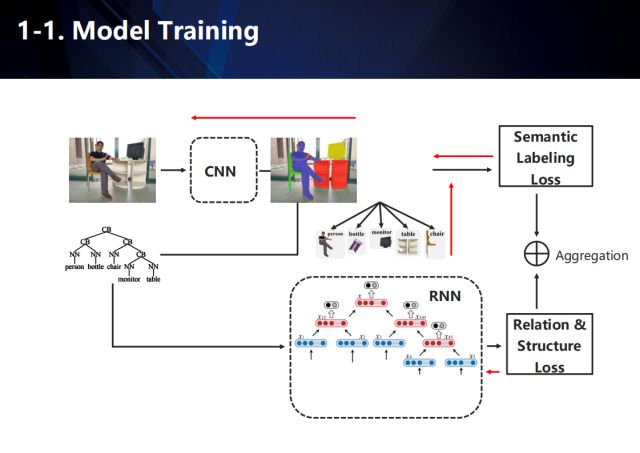

整個(gè)網(wǎng)絡(luò)學(xué)習(xí)的目標(biāo)包含兩個(gè),一個(gè)是卷積神經(jīng)網(wǎng)絡(luò)部分中的場(chǎng)景語(yǔ)義標(biāo)注信息,另一個(gè)則是遞歸神經(jīng)網(wǎng)絡(luò)部分中的結(jié)構(gòu)化解析結(jié)果。在訓(xùn)練的過(guò)程中,由于圖像數(shù)據(jù)缺乏對(duì)應(yīng)的場(chǎng)景結(jié)構(gòu)化信息,我們需要對(duì)其進(jìn)行估計(jì),來(lái)訓(xùn)練卷積神經(jīng)網(wǎng)絡(luò)和遞歸循環(huán)神經(jīng)網(wǎng)絡(luò)。

簡(jiǎn)單來(lái)說(shuō),本工作的重點(diǎn)在于得到以下兩個(gè)目標(biāo):(1)語(yǔ)義標(biāo)注信息,包括定位語(yǔ)義實(shí)體的位置和確定語(yǔ)義實(shí)體之間的互動(dòng)關(guān)系,(2)得到語(yǔ)義實(shí)體中的繼承結(jié)構(gòu)。

在本論文中采用的CNN-RNN聯(lián)合結(jié)構(gòu),與單一RNN方法不同之處在于模型預(yù)測(cè)了子節(jié)點(diǎn)和父節(jié)點(diǎn)之間的關(guān)系。其中,對(duì)于語(yǔ)義標(biāo)注,我們采用CNN模型為每一個(gè)實(shí)體類生成特征表達(dá),并將臨近的像素分組并對(duì)同類別使用同一標(biāo)簽。利用CNN生成的特征,我們?cè)O(shè)計(jì)RNN模型來(lái)生成圖像理解樹(shù)來(lái)預(yù)測(cè)物體之間的關(guān)系和繼承結(jié)構(gòu),其中包括四個(gè)部分,語(yǔ)義映射(單層全連接層),融合(兩個(gè)子節(jié)點(diǎn)結(jié)合生成一個(gè)父節(jié)點(diǎn)),類別器(其中一個(gè)子網(wǎng)絡(luò),用于確定兩個(gè)節(jié)點(diǎn)之間的關(guān)系,并利用父節(jié)點(diǎn)的特征作為輸入),打分器(另外一個(gè)子網(wǎng)絡(luò),衡量?jī)蓚€(gè)節(jié)點(diǎn)的置信度)。

本方法在學(xué)習(xí)過(guò)程中有兩個(gè)輸入,一個(gè)是圖像,另外一個(gè)圖像對(duì)應(yīng)的解析句子,將圖像輸入CNN,得到圖像的實(shí)體類特征表達(dá),同時(shí)利用語(yǔ)義解析生成樹(shù)方法將句子分解成語(yǔ)義樹(shù),并將圖像得到的實(shí)體類與語(yǔ)義生成樹(shù)一同輸入到RNN網(wǎng)絡(luò)中,利用圖像的語(yǔ)義標(biāo)注與關(guān)聯(lián)結(jié)構(gòu)樹(shù)進(jìn)行訓(xùn)練,從而得到預(yù)期的結(jié)果。

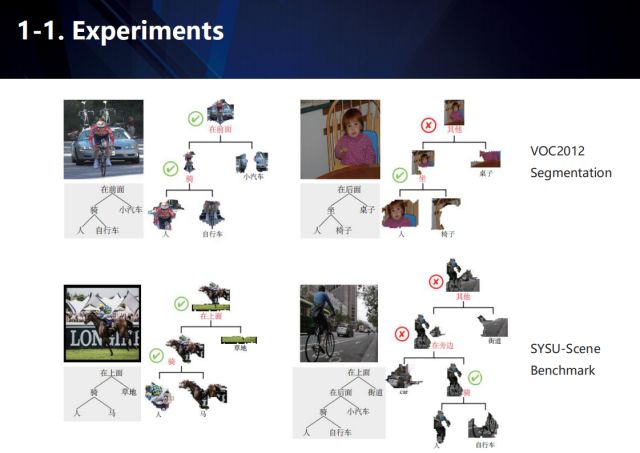

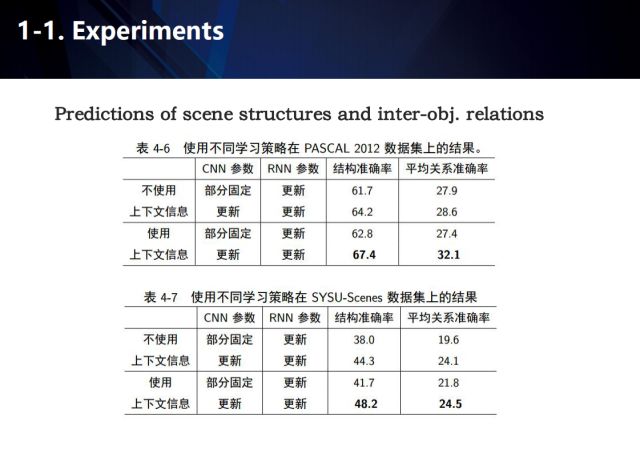

語(yǔ)義分割和場(chǎng)景結(jié)構(gòu)化解析在PSACALVOC 2012 和SYSU-Scene 評(píng)測(cè)集上的實(shí)驗(yàn)結(jié)果展示如圖。

這里給出了使用不同的學(xué)習(xí)策略在PASCAL2012數(shù)據(jù)集上的結(jié)果,可以看出上下文信息被證明是一種有效的輔助手段。

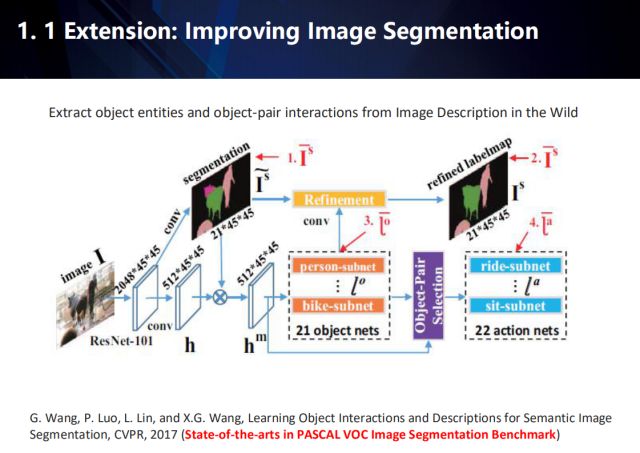

還可以擴(kuò)展到圖像語(yǔ)義分割領(lǐng)域。這一工作發(fā)表在CVPR2017,目前在PASCAL VOC數(shù)據(jù)集上做到了state-of-the-arts。

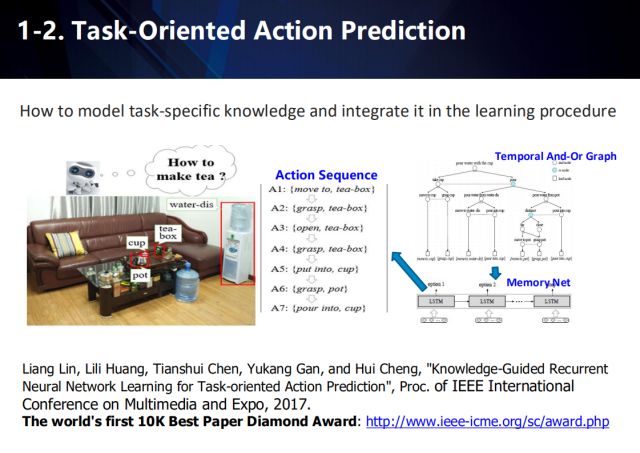

此外,在面向任務(wù)的動(dòng)作預(yù)測(cè)中, 同樣可以采用弱監(jiān)督學(xué)習(xí)的方式來(lái)解決需要大量標(biāo)注信息的問(wèn)題。這一工作獲得了The World’s First 10K Best Paper Diamond Award by ICME 2017.

這項(xiàng)工作首次提出了任務(wù)導(dǎo)向型的動(dòng)作預(yù)測(cè)問(wèn)題,即如何在特定場(chǎng)景下,自動(dòng)地生成能完成指定任務(wù)的動(dòng)作序列,并針對(duì)該問(wèn)題進(jìn)行了數(shù)據(jù)采集。在這篇論文中,作者提出使用長(zhǎng)短期記憶神經(jīng)網(wǎng)絡(luò)(LSTM)進(jìn)行動(dòng)作預(yù)測(cè),并提出了多階段的訓(xùn)練方法。為了解決學(xué)習(xí)過(guò)程中標(biāo)注樣本不足的問(wèn)題,該工作在第一階段采取時(shí)域與或圖模型(And-Or Graph, AOG)自動(dòng)地生成動(dòng)作序列集合進(jìn)行數(shù)據(jù)增強(qiáng),在下一階段利用增強(qiáng)后的數(shù)據(jù)訓(xùn)練動(dòng)作預(yù)測(cè)網(wǎng)絡(luò)。具體步驟如下。

1)為了對(duì)任務(wù)知識(shí)建模,該文引入時(shí)域與或圖(And-Or Graph, AOG)模型表達(dá)任務(wù)。AOG由四部分組成:表示任務(wù)的根節(jié)點(diǎn),非終端節(jié)點(diǎn)集合,終端節(jié)點(diǎn)集合和權(quán)重分布集合。非終端節(jié)點(diǎn)包括與節(jié)點(diǎn)和或節(jié)點(diǎn)。其中,與節(jié)點(diǎn)表示將該節(jié)點(diǎn)的動(dòng)作分解為有時(shí)序關(guān)系的子動(dòng)作,或節(jié)點(diǎn)則表示可以完成該節(jié)點(diǎn)動(dòng)作的不同方式,并根據(jù)概率分布P選擇其中一個(gè)子節(jié)點(diǎn)。終端節(jié)點(diǎn)包括跟該任務(wù)相關(guān)的原子動(dòng)作。

2)由于AOG定義時(shí)存在的時(shí)序依賴關(guān)系,該論文利用深度優(yōu)先遍歷的方法遍歷每個(gè)節(jié)點(diǎn),同時(shí)利用與或圖長(zhǎng)短期記憶模型(AOG-LSTM)預(yù)測(cè)該節(jié)點(diǎn)的支路選擇。

3)由于原子動(dòng)作序列非常強(qiáng)的時(shí)序依賴關(guān)系,該論文同樣設(shè)計(jì)了一個(gè)LSTM(即Action-LSTM)時(shí)序地預(yù)測(cè)每個(gè)時(shí)刻的原子動(dòng)作。具體地,原子動(dòng)作Ai由一個(gè)原生動(dòng)作以及一個(gè)相關(guān)物體組成,可表示為Ai=(ai, oi)。為了降低模型復(fù)雜性和預(yù)測(cè)空間的多變性,該論文假設(shè)原生動(dòng)作和相關(guān)物體的預(yù)測(cè)是獨(dú)立的,并分別進(jìn)行預(yù)測(cè)。

Progressive and Cost-effective Learning

接著介紹一下自驅(qū)動(dòng)、成本效益較高的學(xué)習(xí)方式。

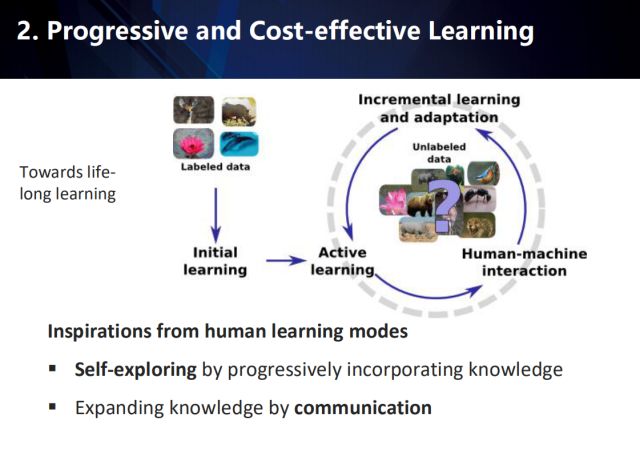

這類方法受到人類學(xué)習(xí)模式的一些啟發(fā):一是在逐步整合學(xué)習(xí)到的知識(shí)中自我探索,二是在交流的過(guò)程中不斷擴(kuò)充知識(shí),以達(dá)到終生學(xué)習(xí)的目的。如上圖所示,在學(xué)習(xí)的初期,利用已有的標(biāo)注數(shù)據(jù)進(jìn)行初始化學(xué)習(xí),然后在大量未標(biāo)注的數(shù)據(jù)中不斷按照人機(jī)協(xié)同方式進(jìn)行樣本挖掘,以增量地學(xué)習(xí)模型和適配未標(biāo)注數(shù)據(jù)。

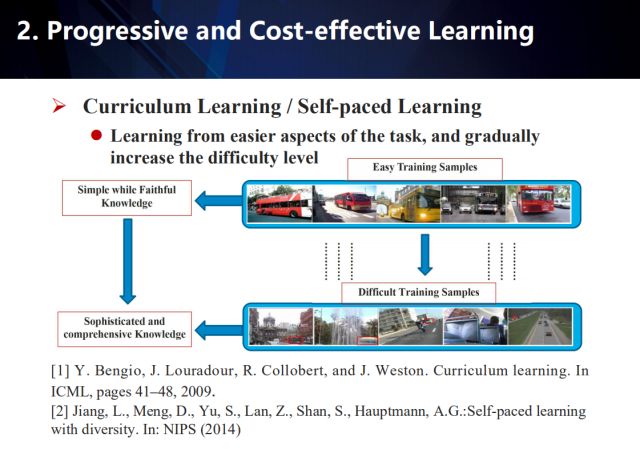

在自我驅(qū)動(dòng)、低成本高效益的學(xué)習(xí)方式中,課程學(xué)習(xí)和自步學(xué)習(xí)是一種有效的思路。

課程學(xué)習(xí)的基本思想,是由深度學(xué)習(xí)的開(kāi)創(chuàng)者之一,YoshuaBengio教授團(tuán)隊(duì)于2009年的ICML會(huì)議上提出;而在2014年,由LuJiang等人提出了自步學(xué)習(xí)的公理化構(gòu)造條件,并說(shuō)明了針對(duì)不同的應(yīng)用,可根據(jù)該公理化準(zhǔn)則延伸出各種實(shí)用的課程學(xué)習(xí)方案。這些方法首先從任務(wù)中的簡(jiǎn)單方面學(xué)習(xí),來(lái)獲取簡(jiǎn)單可靠的知識(shí);然后逐漸地增加難度,來(lái)過(guò)渡到學(xué)習(xí)更復(fù)雜、更專業(yè)的知識(shí),以完成對(duì)復(fù)雜事物的認(rèn)知。

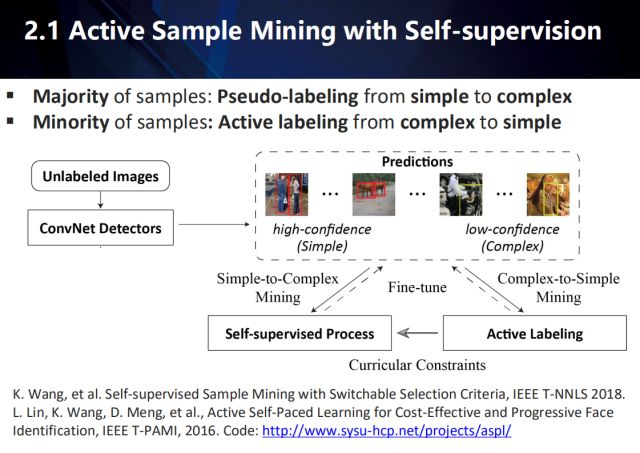

在目標(biāo)檢測(cè)任務(wù)中,采用大量無(wú)標(biāo)注、或者部分標(biāo)注的數(shù)據(jù)進(jìn)行訓(xùn)練,盡管充滿挑戰(zhàn),但仍然是實(shí)際視覺(jué)任務(wù)中成本效益較高的方式。對(duì)于這一挑戰(zhàn),往往采用主動(dòng)學(xué)習(xí)的方式來(lái)解決。而目前提出的主動(dòng)學(xué)習(xí)方法,往往會(huì)利用最新的檢測(cè)器,根據(jù)一個(gè)信度閾值,來(lái)尋找檢測(cè)器難以區(qū)分的復(fù)雜樣例。通過(guò)對(duì)這些樣例進(jìn)行主動(dòng)標(biāo)注,進(jìn)而優(yōu)化檢測(cè)器的性能。然而,這些主動(dòng)學(xué)習(xí)的方法,卻忽視了余下大量的簡(jiǎn)單樣例。

那么,如何既考慮到少量的復(fù)雜樣例,又充分利用到大量的簡(jiǎn)單樣例呢?

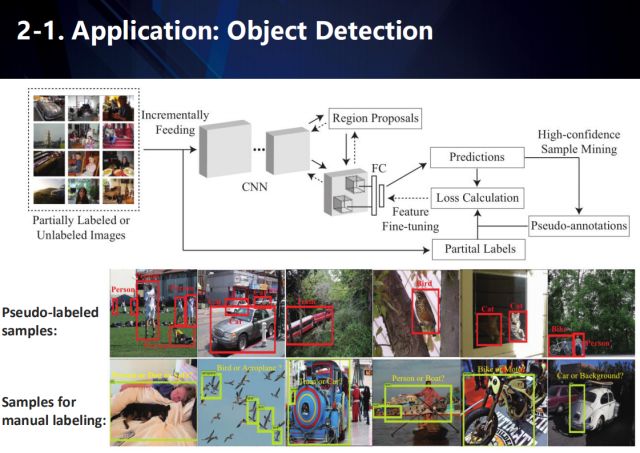

我們提出了一種主動(dòng)樣本挖掘(ASM)框架,如上圖所示。對(duì)于大量未標(biāo)注的檢測(cè)數(shù)據(jù),我們采用最新的檢測(cè)器進(jìn)行檢測(cè),并將檢測(cè)結(jié)果按照信度排序。對(duì)于信度高的檢測(cè)結(jié)果,我們直接將檢測(cè)結(jié)果作為其未標(biāo)注信息;而對(duì)于少量的信度低的檢測(cè)結(jié)果,我們采用主動(dòng)學(xué)習(xí)的方式來(lái)進(jìn)行標(biāo)注。最后,利用這些數(shù)據(jù)來(lái)優(yōu)化檢測(cè)器性能。

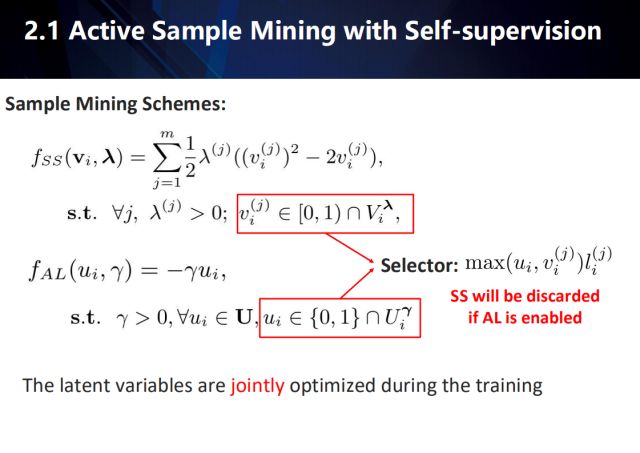

具體來(lái)說(shuō),我們采用兩套不同的樣本挖掘方案策略函數(shù):一個(gè)用于高置信度樣本的自動(dòng)偽標(biāo)注階段,另一組用于低置信度樣本的人工標(biāo)注階段。我們進(jìn)一步地引入了動(dòng)態(tài)選擇函數(shù),以無(wú)縫地確定上述哪個(gè)階段用于更新未標(biāo)注樣本的標(biāo)簽。在這種方式下,我們的自監(jiān)督過(guò)程和主動(dòng)學(xué)習(xí)過(guò)程可以相互協(xié)作和無(wú)縫切換,進(jìn)行樣本挖掘。此外,自監(jiān)督的過(guò)程還考慮了主動(dòng)學(xué)習(xí)過(guò)程的指導(dǎo)和反饋,使其更適合大規(guī)模下物體檢測(cè)的需要。具體來(lái)說(shuō),我們引進(jìn)兩個(gè)課程:自監(jiān)督學(xué)習(xí)課程 (Self-Supervised learning Curriculum, SSC) 和主動(dòng)學(xué)習(xí)課程 (Active Learning Curriculum, ALC)。SSC 用于表示一組具有高預(yù)測(cè)置信度,能控制對(duì)無(wú)標(biāo)簽樣本的自動(dòng)偽標(biāo)注,而 ALC 用于表示很具有代表性,適合約束需要人工標(biāo)注的樣本。值得注意的是,在訓(xùn)練階段,SSC 以逐漸從簡(jiǎn)單到復(fù)雜的方式,選擇偽標(biāo)簽樣本進(jìn)行網(wǎng)絡(luò)再訓(xùn)練。相比之下,ALC 間歇地將人工標(biāo)注的樣本,按照從復(fù)雜到簡(jiǎn)單的方式,添加到訓(xùn)練中。因此,我們認(rèn)為 SSC 和 ALC 是對(duì)偶課程,彼此互補(bǔ)。通過(guò)主動(dòng)學(xué)習(xí)過(guò)程來(lái)更新,這兩個(gè)對(duì)偶課程能夠有效地指導(dǎo)兩種完全不同的學(xué)習(xí)模式,來(lái)挖掘海量無(wú)標(biāo)簽樣本。使得我們的模型在提高了分類器對(duì)噪聲樣本或離群點(diǎn)的魯棒性同時(shí),也提高了檢測(cè)的精度。

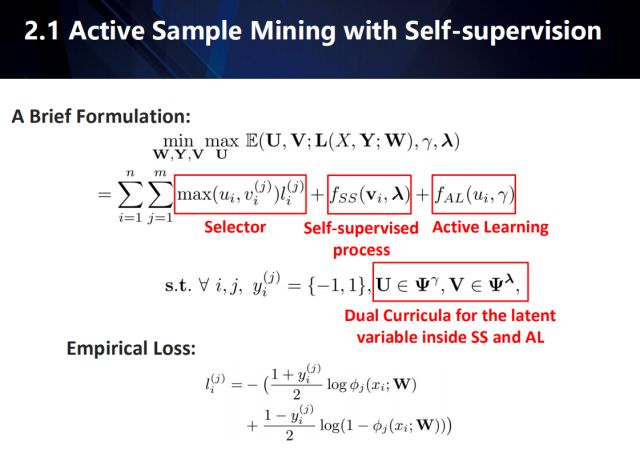

Interpretation:上面優(yōu)化公式由(W,Y,V,U)組成,其中W指代模型參數(shù)(物體檢測(cè)器的參數(shù),我們的文章里面是Faster RCNN或者RFCN)。Y指代在自動(dòng)標(biāo)注下的物體檢測(cè)器產(chǎn)生的proposal的偽標(biāo)注類別。V={v_i}^N_{i=1}指代自步學(xué)習(xí)過(guò)程(self-paced learning,在上式中為self-supervised process)下對(duì)每個(gè)proposal訓(xùn)練實(shí)例的經(jīng)驗(yàn)損失權(quán)重,v_i取值為 [0,1)的一個(gè)連續(xù)值m維向量(m為類別數(shù)目)。U={u_i}^N_{i=1}指代主動(dòng)學(xué)習(xí)下對(duì)每個(gè)訓(xùn)練實(shí)例的經(jīng)驗(yàn)損失權(quán)重,u_i取值為一個(gè){0,1}二值標(biāo)量。

W是我們想要學(xué)習(xí)的參數(shù),其余Y,V,U都可以看成是為了學(xué)習(xí)W而要推斷的隱變量。后兩個(gè)為權(quán)重隱變量,基于選擇函數(shù)(selector)作用于每個(gè)樣本訓(xùn)練損失。具體來(lái)說(shuō),W的優(yōu)化基于經(jīng)驗(yàn)損失的加權(quán)和。因此,在每次優(yōu)化W之前,我們必須要知道Y (由于經(jīng)驗(yàn)損失為判別誤差,沒(méi)有自步學(xué)習(xí)過(guò)程下的給與的偽標(biāo)注(Y),所有數(shù)據(jù)都只能利用AL的人工標(biāo)注,整個(gè)方法退化為全監(jiān)督學(xué)習(xí)) 。同時(shí)在優(yōu)化W和Y之前,我們必須要知道U和V的值(知道每一個(gè)u_i和v_i的取值,才能決定哪些訓(xùn)練實(shí)例的y值需要人工標(biāo)注(自主學(xué)習(xí)AL),那些需要機(jī)器自動(dòng)推斷 (自監(jiān)督過(guò)程SS)。);同時(shí),知道每一個(gè)u_i和v_i,才能基于選擇器(selector)推斷出經(jīng)驗(yàn)誤差的訓(xùn)練權(quán)重)。給定樣本i基于u_i和v_i的值域以及選擇器可以看出,u_i=1>v_i^{j}對(duì)應(yīng)樣本會(huì)被選擇為主動(dòng)學(xué)習(xí)的人工標(biāo)注對(duì)象,u_i=0<=v_i^{j}時(shí)對(duì)應(yīng)樣本會(huì)得到自動(dòng)標(biāo)注。

于是,問(wèn)題落在如何推斷U和V這兩個(gè)權(quán)重隱變量集合身上。容易看出U和V要聯(lián)合推斷,而如何選擇U和V則由每個(gè)訓(xùn)練實(shí)例的經(jīng)驗(yàn)損失以及其對(duì)于各自的控制函數(shù)(f_SS, f_AL)決定。f_SS的具體解釋可以參考自步課程學(xué)習(xí)(self-paced curriculum learning),簡(jiǎn)單的理解就是優(yōu)先選擇訓(xùn)練損失較小的樣本進(jìn)行學(xué)習(xí),這表現(xiàn)為訓(xùn)練損失越小賦予的權(quán)重越大。隨著lambda變大(優(yōu)化過(guò)程中,lambda和gamma都會(huì)逐漸變大),訓(xùn)練會(huì)開(kāi)始接納具有更大訓(xùn)練誤差的樣本。f_AL相反,主動(dòng)學(xué)習(xí)一開(kāi)始會(huì)從訓(xùn)練誤差較大的樣本(樣本誤差比較小的會(huì)被置零,從而被選擇為自監(jiān)督過(guò)程并且得到自動(dòng)標(biāo)注)中選擇并進(jìn)行人工標(biāo)注。隨著gamma增大,主動(dòng)學(xué)習(xí)會(huì)開(kāi)始接納更小的誤差的樣本。

模型函數(shù) f_SS代表了一種貪心的自監(jiān)督的策略。它大大地節(jié)省了人工標(biāo)注量,但是對(duì)于累計(jì)預(yù)測(cè)誤差造成的語(yǔ)義惡化無(wú)能為力。并且,f_SS極大依賴于初始參數(shù) W。由于模型函數(shù) f_AL存在,我們可以有效地克服這些缺點(diǎn)。f_AL選擇樣本給用戶進(jìn)行后處理,通過(guò)f_AL獲得的人工標(biāo)注被認(rèn)為是可靠的,這種過(guò)程應(yīng)該持續(xù)到訓(xùn)練結(jié)束。值得一提的是,通過(guò) f_SS進(jìn)行的偽標(biāo)注只有在訓(xùn)練迭代中是可靠的,并且應(yīng)該被適當(dāng)?shù)恼{(diào)整來(lái)引導(dǎo)每個(gè)階段更魯棒的網(wǎng)絡(luò)參數(shù)的學(xué)習(xí)。實(shí)際上,f_SS和f_AL是同時(shí)作用與每一個(gè)樣本的,這會(huì)等價(jià)于一個(gè)minimax的優(yōu)化問(wèn)題。

另一方面,U和V在推斷時(shí)需要考慮前一階段已經(jīng)由主動(dòng)學(xué)習(xí)中的人手工標(biāo)記好的信息。我們利用之前的人手工標(biāo)記好的信息,定義了兩個(gè)基于U和V的取值約束,稱為“對(duì)偶課程”(Dual Curricula)。該約束項(xiàng)將被自主學(xué)習(xí)選過(guò)的訓(xùn)練樣本,如該樣本屬于m個(gè)類別之中的一類,我們將其為u和v值設(shè)定為1;如該樣本不在m個(gè)類別之中,我們將其u和v值設(shè)定為0。這意味著我們的訓(xùn)練框架可以容納新類別的發(fā)掘,同時(shí)不會(huì)讓新類別影響檢測(cè)器的訓(xùn)練。V^{lambda}_{i}和U^^{lambda}_{i}只基于之前AL選擇后的結(jié)果分別對(duì)u和v值進(jìn)行約束。

形象來(lái)說(shuō),我們采用兩套不同的樣本挖掘方案策略函數(shù):一個(gè)用于高置信度樣本的自動(dòng)偽標(biāo)注模式,另一組用于低置信度樣本的人工標(biāo)注模式。我們進(jìn)一步地引入了動(dòng)態(tài)選擇函數(shù),以無(wú)縫地確定上述哪個(gè)階段用于更新未標(biāo)注樣本的標(biāo)簽。在這種方式下,我們的自監(jiān)督過(guò)程和主動(dòng)學(xué)習(xí)過(guò)程可以相互協(xié)作和無(wú)縫切換,進(jìn)行樣本挖掘。此外,自監(jiān)督的過(guò)程還考慮了主動(dòng)學(xué)習(xí)過(guò)程的指導(dǎo)和反饋,使其更適合大規(guī)模下物體檢測(cè)的需要。具體來(lái)說(shuō),我們引進(jìn)兩個(gè)課程:自監(jiān)督學(xué)習(xí)課程 (Self-Supervised learning Curriculum, SSC) 和主動(dòng)學(xué)習(xí)課程 (Active Learning Curriculum, ALC)。SSC 用于表示一組具有高預(yù)測(cè)置信度,能控制對(duì)無(wú)標(biāo)簽樣本的自動(dòng)偽標(biāo)注,而 ALC 用于表示很具有代表性,適合約束需要人工標(biāo)注的樣本。值得注意的是,在訓(xùn)練階段,SSC 以逐漸從簡(jiǎn)單到復(fù)雜的方式,選擇偽標(biāo)簽樣本進(jìn)行網(wǎng)絡(luò)再訓(xùn)練。相比之下,ALC 間歇地將人工標(biāo)注的樣本,按照從復(fù)雜到簡(jiǎn)單的方式,添加到訓(xùn)練中。因此,我們認(rèn)為 SSC 和 ALC 是對(duì)偶課程,彼此互補(bǔ)。通過(guò)主動(dòng)學(xué)習(xí)過(guò)程來(lái)更新,這兩個(gè)對(duì)偶課程能夠有效地指導(dǎo)兩種完全不同的學(xué)習(xí)模式,來(lái)挖掘海量無(wú)標(biāo)簽樣本。使得我們的模型在提高了分類器對(duì)噪聲樣本或離群點(diǎn)的魯棒性同時(shí),也提高了檢測(cè)的精度。

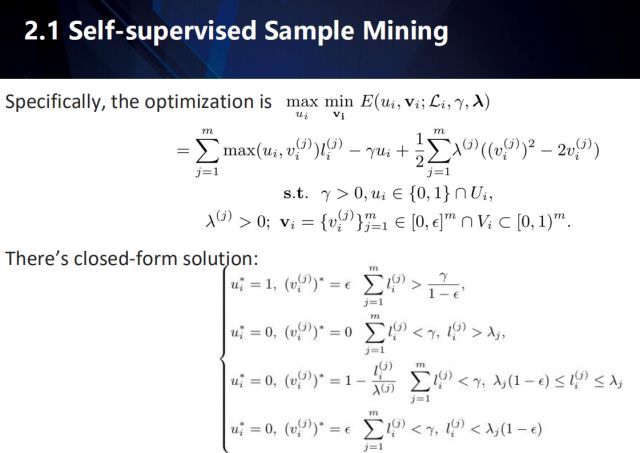

基于u和v的聯(lián)合推斷構(gòu)成了一個(gè)可基于訓(xùn)練實(shí)例分解的minmax優(yōu)化問(wèn)題。對(duì)于每一個(gè)訓(xùn)練實(shí)例u和v,我們證明了在滿足一定條件下,該推斷具有基于上式表達(dá)的閉式解 (具體考究這個(gè)有點(diǎn)復(fù)雜,可以參考我們的文章)。大概意思是,在考慮訓(xùn)練實(shí)例i的類別經(jīng)驗(yàn)誤差和的時(shí)候,大于第一個(gè)閾值會(huì)u_i值會(huì)收斂為1 (大括號(hào)里面第一種情況)。由于v^{j}_i<1,我們知道該實(shí)例會(huì)被選作人工標(biāo)注。另一方面,在類別經(jīng)驗(yàn)誤差和小于另一個(gè)閾值(大括號(hào)第二行第一個(gè)不等式)時(shí),u_i值會(huì)收斂為0。由于v^{j}_i>=0,我們知道該實(shí)例會(huì)被選作機(jī)器自動(dòng)標(biāo)注,同時(shí)根據(jù)誤差大小,相應(yīng)賦予不同的權(quán)重。當(dāng)誤差越大,自動(dòng)標(biāo)注越有可能出錯(cuò),于是自動(dòng)賦予權(quán)重越小。在大于某一值域(大括號(hào)第二行第二個(gè)不等式)下,v和u都會(huì)同時(shí)為零,這意味著該樣本不參與本輪訓(xùn)練。

上圖展示了提出的框架(ASM)在目標(biāo)檢測(cè)中的應(yīng)用。

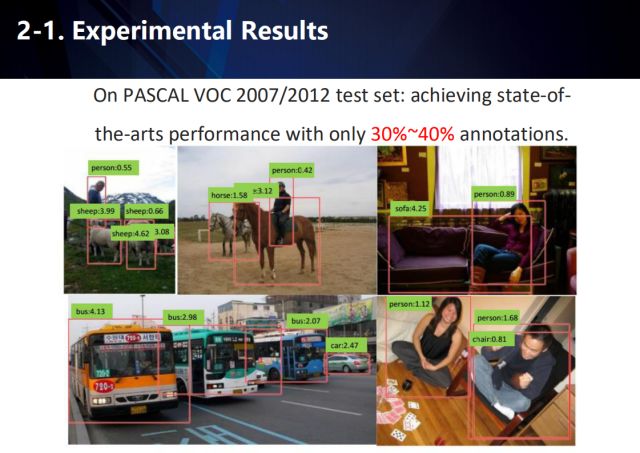

在PASCALVOC2007/2012結(jié)果中,我們的方法僅僅利用大約30~40%左右的標(biāo)注數(shù)據(jù),就能達(dá)到state-of-the-arts的檢測(cè)性能。

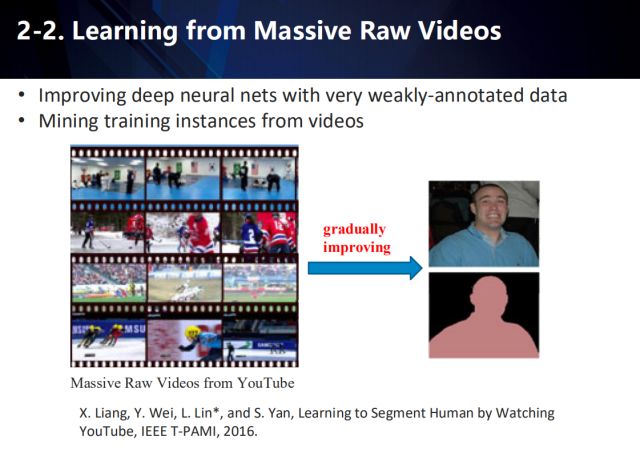

如何利用大量原始視頻學(xué)習(xí)

類似的策略可以應(yīng)用在人體分割任務(wù)中,我們利用人體檢測(cè)器、和無(wú)監(jiān)督的分割方法,從大量的原始視頻(來(lái)自YouTube)中生成人體掩膜。這些掩膜信息可以作為分割網(wǎng)絡(luò)的標(biāo)注信息。同時(shí),結(jié)合分割網(wǎng)絡(luò)輸出的信度圖,對(duì)人體檢測(cè)器提取的候選區(qū)域結(jié)果進(jìn)行修正,以生成更好的人體掩膜。

Unsupervised Domain Adaptation

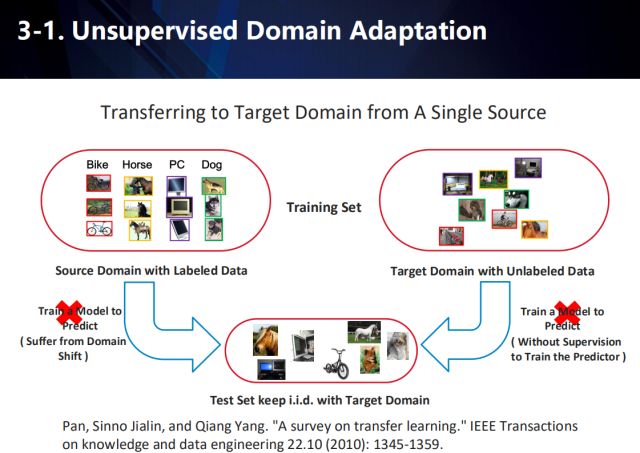

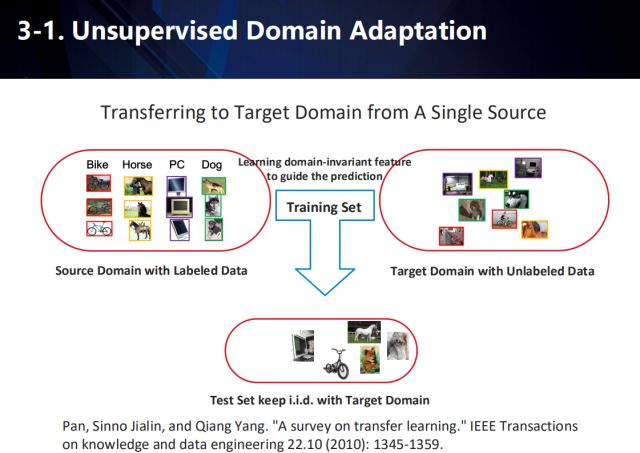

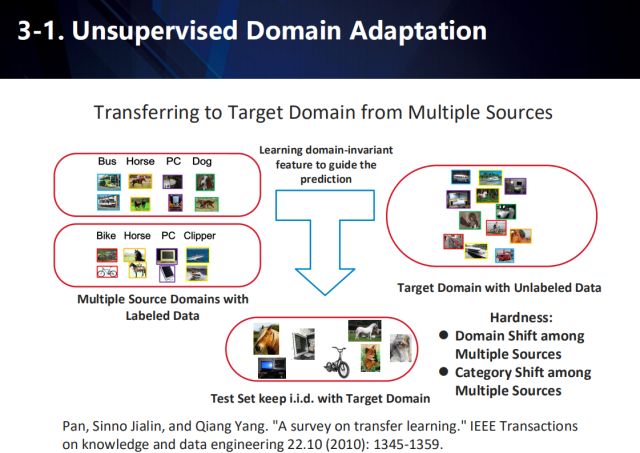

為了適配不同領(lǐng)域數(shù)據(jù)間的分布,解決目標(biāo)任務(wù)缺乏數(shù)據(jù)標(biāo)注的難題,我們將探索無(wú)監(jiān)督領(lǐng)域自適應(yīng)學(xué)習(xí)方法,包括單數(shù)據(jù)源領(lǐng)域自適應(yīng)、以及多數(shù)據(jù)源領(lǐng)域自適應(yīng)。

單數(shù)據(jù)源領(lǐng)域自適應(yīng)

在應(yīng)用場(chǎng)景中,往往存在某一領(lǐng)域的可用數(shù)據(jù)過(guò)少,而其他類似領(lǐng)域的可用數(shù)據(jù)充足,因此,衍生出了一系列遷移學(xué)習(xí)的方式,以做到跨領(lǐng)域的自適應(yīng)。例如,在圖示的任務(wù)中,源域的數(shù)據(jù)一般是帶有標(biāo)注信息的,而目標(biāo)域的數(shù)據(jù)不僅與源域中的數(shù)據(jù)含有不同的分布,往往還沒(méi)有標(biāo)注信息。因此,通過(guò)將學(xué)習(xí)到的知識(shí)從源域遷移到目標(biāo)域,來(lái)提高算法在目標(biāo)域數(shù)據(jù)上的性能。

因此,需要聯(lián)合有標(biāo)注的源域數(shù)據(jù)和無(wú)標(biāo)注的目標(biāo)域數(shù)據(jù),來(lái)學(xué)習(xí)一個(gè)與域無(wú)關(guān)的特征,來(lái)進(jìn)行最終在目標(biāo)域上的預(yù)測(cè)。

多數(shù)據(jù)源領(lǐng)域自適應(yīng)

而對(duì)于從多數(shù)據(jù)源向目標(biāo)域遷移學(xué)習(xí)的情況,將更加復(fù)雜,需要考慮:1.多種源域數(shù)據(jù)本身之間具有偏差 2.多種源域數(shù)據(jù)間類別存在偏差。

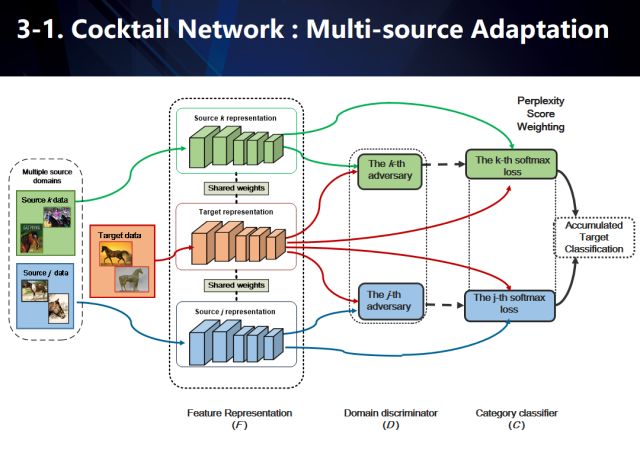

因此我們提出了一種名為“雞尾酒”的網(wǎng)絡(luò),以解決將知識(shí)從多種源域的數(shù)據(jù)向目標(biāo)域的數(shù)據(jù)中遷移的問(wèn)題。

“雞尾酒”網(wǎng)絡(luò)

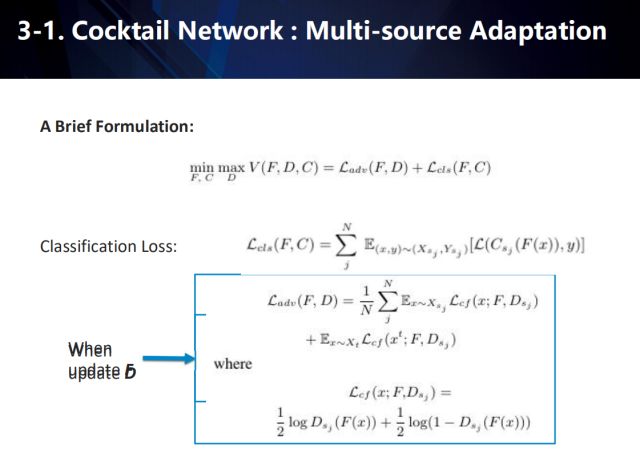

雞尾酒網(wǎng)絡(luò)用于學(xué)習(xí)基于多源域(我們的圖示僅簡(jiǎn)化地展示了j,k兩個(gè)源域)下的域不變特征(domaininvariantfeature)。在具體數(shù)據(jù)流中,我們利用共享特征網(wǎng)絡(luò)對(duì)所有源域以及目標(biāo)域進(jìn)行特征建模,然后利用多路對(duì)抗域適應(yīng)技術(shù)(基于單路對(duì)抗域適應(yīng)(adversarial domainadaptation)下的擴(kuò)展,對(duì)抗域適應(yīng)的共享特征網(wǎng)絡(luò)對(duì)應(yīng)于生成對(duì)抗學(xué)習(xí)(GAN)里面的生成器),每個(gè)源域分別與目標(biāo)域進(jìn)行兩兩組合對(duì)抗學(xué)習(xí)域不變特征。同時(shí)每個(gè)源域也分別進(jìn)行監(jiān)督學(xué)習(xí),訓(xùn)練基于不同源類別下的多個(gè)softmax分類器。注意到,基于對(duì)抗學(xué)習(xí)的建模,我們?cè)诘玫焦蚕硖卣骶W(wǎng)絡(luò)的同時(shí),也可以得到多個(gè)源分別和目標(biāo)域?qū)沟呐袆e器。這些判別器在對(duì)于每一個(gè)目標(biāo)域的數(shù)據(jù),都可以給出該數(shù)據(jù)分別與每一個(gè)源域之間的混淆度(perplexityscore)。因此,對(duì)于每一個(gè)來(lái)自目標(biāo)域的數(shù)據(jù),我們首先利用不同源下的softmax分類器給出其多個(gè)分類結(jié)果。然后,基于每一個(gè)類別,我們找到包含該類別的所有源域softmax分類概率,再基于這些源域與目標(biāo)域的混淆度,對(duì)分類概率取加權(quán)平均得到每個(gè)類別的分?jǐn)?shù)。簡(jiǎn)而言之就是,越跟目標(biāo)域相識(shí)的源域混淆度會(huì)更高,意味著其分類結(jié)果更可信從而具有更高的加權(quán)權(quán)值。

需要注意的是,我們并沒(méi)有直接作用于所有softmax分類器上反而是基于每個(gè)類別分別進(jìn)行加權(quán)平均處理。這是因?yàn)樵谖覀兊募僭O(shè)下,每個(gè)源的類別不一定共享,從而softmax結(jié)果不能簡(jiǎn)單相加。當(dāng)然,我們的方法也適用于所有源共享類別的情況,這樣我們的公式會(huì)等價(jià)于直接將softmax分類結(jié)果進(jìn)行加權(quán)相加。

其中,L_adv 是對(duì)抗損失,當(dāng)訓(xùn)練判別器時(shí)用傳統(tǒng)的GAN loss,當(dāng)訓(xùn)練feature extractor時(shí)用confusion loss。L_cls是多源域(multiple source domains)分類損失,C為多源域softmax分類器。N是source的數(shù)目,s_j 代表第j個(gè)source,C_{s_j}代表第j個(gè)source的softmax 分類器 (用C來(lái)表示全部source的分類輸出),D_{s_j}代表第j個(gè)source跟target對(duì)抗的判別器 (用D來(lái)表示全部的對(duì)抗結(jié)果),F(xiàn)為feature extractor。

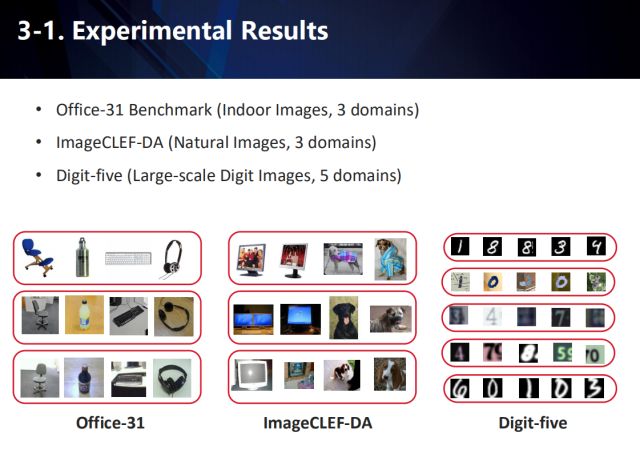

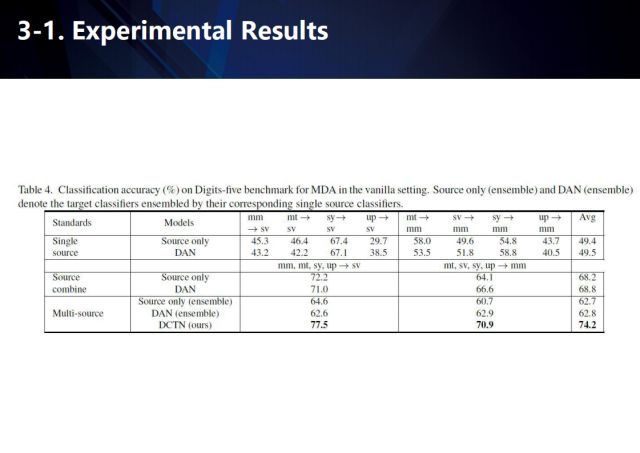

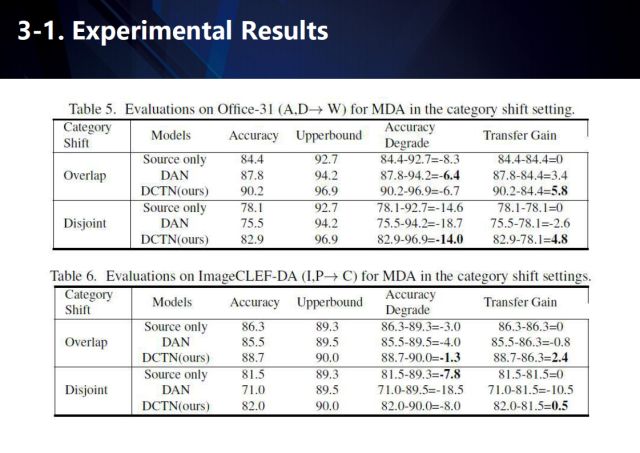

我們分別在Office-31、ImageCLEF-DA、Digit-five數(shù)據(jù)集上進(jìn)行了測(cè)評(píng),我們的方法取得了很好的結(jié)果。

-

AI

+關(guān)注

關(guān)注

87文章

31155瀏覽量

269487 -

大數(shù)據(jù)

+關(guān)注

關(guān)注

64文章

8897瀏覽量

137534 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5507瀏覽量

121298

原文標(biāo)題:后深度學(xué)習(xí)時(shí)代:弱監(jiān)督學(xué)習(xí)、自主學(xué)習(xí)與自適應(yīng)學(xué)習(xí)如何用于視覺(jué)理解

文章出處:【微信號(hào):AI_Thinker,微信公眾號(hào):人工智能頭條】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

國(guó)產(chǎn)深度學(xué)習(xí)框架的挑戰(zhàn)和機(jī)會(huì)

兩種典型的電池供電電路的設(shè)計(jì)方案

《AI for Science:人工智能驅(qū)動(dòng)科學(xué)創(chuàng)新》第一章人工智能驅(qū)動(dòng)的科學(xué)創(chuàng)新學(xué)習(xí)心得

2017全國(guó)深度學(xué)習(xí)技術(shù)應(yīng)用大會(huì)

Nanopi深度學(xué)習(xí)之路(1)深度學(xué)習(xí)框架分析

labview深度學(xué)習(xí)檢測(cè)藥品兩類缺陷

從儲(chǔ)能、阻抗兩種不同視角解析電容去耦原理

深度學(xué)習(xí)的三種基本結(jié)構(gòu)及原理詳解

深度學(xué)習(xí)時(shí)代的新主宰:可微編程

從產(chǎn)業(yè)落地以及學(xué)術(shù)創(chuàng)新兩種視角出發(fā),探索后深度學(xué)習(xí)時(shí)代的新挑戰(zhàn)

從產(chǎn)業(yè)落地以及學(xué)術(shù)創(chuàng)新兩種視角出發(fā),探索后深度學(xué)習(xí)時(shí)代的新挑戰(zhàn)

評(píng)論