隨著人工智能技術的突飛猛進,AI工程師成為了眾多求職者夢寐以求的職業。想要拿下這份工作,面試的時候得展示出你不僅技術過硬,還得能解決問題。所以,提前準備一些面試常問的問題,比如機器學習的那些算法,或者深度學習的框架,還有怎么優化模型,Transformer的一些知識,這些都是加分項,能有效提高面試通過率。

本篇小編整理了一些高頻的Transformer方面的面試題,這些題目都是從實際面試中總結出來的,非常具有代表性和實用性,希望對你有幫助。

01 Encoder-Decoder結構中,Encoder和Decoder的作用分別是什么?

答案:

在Encoder-Decoder結構中:

Encoder:負責將輸入數據(如文本或圖像)轉換為一個固定大小的上下文向量。這一過程通常涉及特征提取和信息壓縮,使得輸入的關鍵信息能夠被有效表示。

Decoder:利用Encoder生成的上下文向量來逐步生成輸出數據(如目標文本或標簽)。Decoder通常是一個遞歸神經網絡(RNN)或Transformer結構,它根據先前生成的輸出和上下文向量來預測下一個輸出。

總的來說,Encoder負責理解和表示輸入,Decoder負責生成輸出。

02 teacher-forcing mode是什么?

答案:

Teacher forcing是一種用于訓練序列到序列模型(如RNN或Transformer)的策略。在這種模式下,模型在生成輸出時,不是使用自己之前生成的輸出作為下一個輸入,而是使用實際的目標輸出。

具體來說:

- 在每一步生成過程中,模型接收到的輸入包括上一個時間步的真實輸出(目標序列中的下一個元素),而不是模型自己預測的結果。

- 這種方法可以加速訓練,提高模型在學習時的收斂速度,因為它始終基于正確的上下文進行學習。

然而,teacher forcing在推理階段會有不同的表現,可能導致模型在使用自己生成的輸出時出現錯誤傳播的問題。為了解決這個問題,常常會結合使用其他策略(如scheduled sampling)。

03 注意力機制如何理解?

答案:

注意力機制是一種模仿人類視覺注意力的機制,用于增強神經網絡處理信息的能力。在序列到序列模型中,它允許模型在生成每個輸出時動態選擇和關注輸入序列中的不同部分。通過計算輸入的不同部分對當前輸出的重要性,模型可以更有效地捕捉長期依賴關系,從而提高生成的準確性和相關性。

04 注意力權重和注意力分數是什么?作用是什么?

答案:

- 注意力分數:指的是輸入序列中每個元素與當前生成輸出的相關性度量。通常通過計算輸入向量和當前輸出向量之間的相似性(如點積或加權求和)來獲得。

-注意力權重:是經過歸一化處理的注意力分數,通常使用softmax函數將其轉換為概率分布。這些權重表示輸入序列中各元素對當前輸出的重要性。

作用:注意力權重用于加權輸入序列中各個元素的貢獻,以生成當前的輸出。這使得模型能夠更加靈活和準確地關注輸入的相關部分,進而提高輸出的質量。

05 加性注意力機制是什么?如何理解?

答案:

加性注意力機制(Additive Attention)是一種計算注意力權重的方法,它通過將查詢(Query)和鍵(Key)結合起來,使用一個可學習的前饋神經網絡來計算注意力分數。

具體過程如下:

- 將查詢向量和鍵向量拼接,傳入一個前饋神經網絡,得到一個注意力分數。

- 對所有注意力分數應用softmax函數,得到注意力權重。

理解加性注意力的關鍵在于它通過一個神經網絡學習如何組合查詢和鍵,從而產生關注的相關性,適用于需要靈活性的場景。

06 縮放點積注意力機制是什么?為什么要縮放?

答案:

縮放點積注意力機制(Scaled Dot-Product Attention)是計算注意力權重的一種方法,首先計算查詢和鍵的點積,然后將其縮放(通常除以 $\sqrt{d_k}$,其中 $d_k$ 是鍵向量的維度),最后通過softmax得到注意力權重。

縮放的原因:

- 在高維空間中,點積的值可能會很大,導致softmax函數的梯度過小,從而使得訓練過程變得不穩定。

- 縮放操作有助于避免這種情況,通過將點積值壓縮到一個更合適的范圍內,使得softmax計算出的權重更加平衡,提升訓練的穩定性和效果。

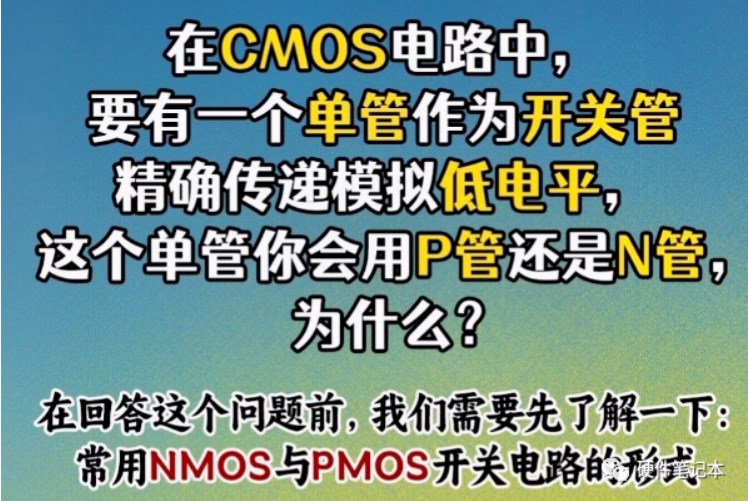

07 soft-attention是什么?有什么優勢?

答案:

Soft Attention(軟注意力)是一種注意力機制,它通過計算加權平均來聚合輸入序列中的信息。與硬注意力(hard attention)不同,軟注意力允許模型在每個時間步關注輸入的不同部分,并為每個部分分配一個連續的權重值。具體而言,軟注意力的實現過程如下:

計算注意力權重:基于查詢(Query)和鍵(Key)之間的相似性(通常通過點積或加性計算),生成一個注意力分數。

應用softmax:將這些分數通過softmax函數歸一化為權重,表示每個輸入元素對當前輸出的重要性。

加權求和:使用這些權重對輸入向量進行加權求和,得到一個上下文向量,作為輸出的輸入。

優勢:

連續性:軟注意力允許模型在訓練和推理階段均使用相同的機制,簡化了實現和理解。

可微性:由于軟注意力是基于加權平均的,因此可以通過反向傳播進行有效的訓練,使得模型更容易優化。

動態聚焦:模型可以根據上下文動態調整注意力權重,靈活地關注輸入的不同部分,從而提高輸出的準確性和相關性。

信息綜合:軟注意力能夠有效整合來自輸入序列的所有信息,避免了丟失關鍵信息的問題。

08 解釋Transformer結構

答案:

Transformer完全基于Attention機制,去除了傳統的CNN和RNN架構。它由Encoder和Decoder組成,每個部分包含多個相同的層,這些層主要包括Multi-HeadAttention(多頭注意力機制)和Feed ForwardNeuralNetworks(前饋神經網絡)。Transformer的核心在于自注意力機制,允許模型在處理輸入的序列時,同時考慮序列中的所有位置,從而捕獲全局依賴。

09 為什么Transformer中要除以根號dk

答案:

在計算注意力得分時,將查詢(Query)和鍵(Key)的點積除以√d(其中dk是鍵的維度),

這樣做是為了防止點積結果過大導致的梯度消失問題。點積隨著維度增加而可能變得非常大,除以√d有助于保持梯度穩定,這樣可以加快模型的收斂速度。

10 Transformer用的LayerNormalize還是BatchNormalize?

答案:

Transformer使用的是LayerNormalization(層歸一化)。LayerNormalization在每個樣本中獨立歸一化輸入,對NLP任務更為有效,因為它允許模型獨立處理每個序列,適應動態序列長度。

11 self-attention機制原理。

答案:

Self-attention機制允許模型在處理序列的每個元素時,考慮到序列中的所有位置。它通過計算每個元素對序列中其他所有元素的注意力分數,并基于這些分數對輸入元素進行加權求和,從而捕獲全局的上下文信息。

12 multi-headattention多頭注意力機制的原理

答案:

Multi-headattention包含多個并行的Self-Attention層(稱為“頭”)。每個頭學習序列中不同子空間的表示。通過這種方式,模型能夠同時捕捉序列中多種不同級別的關聯性,從而增強模型的表示能力。

13 為何使用多頭注意力機制

答案:

使用多頭注意力機制可以使模型同時關注序列中的不同位置和不同表示子空間的信息,增強模型的學習能力和泛化能力。

14 為什么Q和K使用不同的權重矩陣生成?

答案:

通過使用不同的權重矩陣生成Q(查詢)和K(鍵),可以將它們投影到不同的子空間,這樣可以增強模型捕捉不同特征的能力,提高模型的表達能力和泛化性。

15 為什么選擇點乘計算attention而不是加法?

答案:

點乘操作用于計算查詢和鍵之間的相似度,這樣做可以有效地捕獲不同元素之間的關系,而且計算復雜度相對較低。相比之下,加法操作可能不足以表達這種復雜的相互關系,并且可能導致模型學習能力下降。

這些Transformer面試題都是面試過程中經常碰到的,只要準備得充分,就能給面試官留下深刻印象,希望這些題目能幫你順利通過面試,拿到你心儀的offer。

后臺私信雯雯老師,領取更多Transformer面試題

-

AI

+關注

關注

87文章

30887瀏覽量

269065 -

人工智能

+關注

關注

1791文章

47274瀏覽量

238467 -

Transformer

+關注

關注

0文章

143瀏覽量

6005

發布評論請先 登錄

相關推薦

硬件工程師面試題目集合

華為,英飛凌,中興硬件工程師面試題

Java的經典面試題和答案詳細說明

常見的MySQL高頻面試題

人工智能工程師高頻面試題匯總——機器學習篇

【面試題】人工智能工程師高頻面試題匯總:機器學習深化篇(題目+答案)

【面試題】人工智能工程師高頻面試題匯總:Transformer篇(題目+答案)

【面試題】人工智能工程師高頻面試題匯總:Transformer篇(題目+答案)

評論