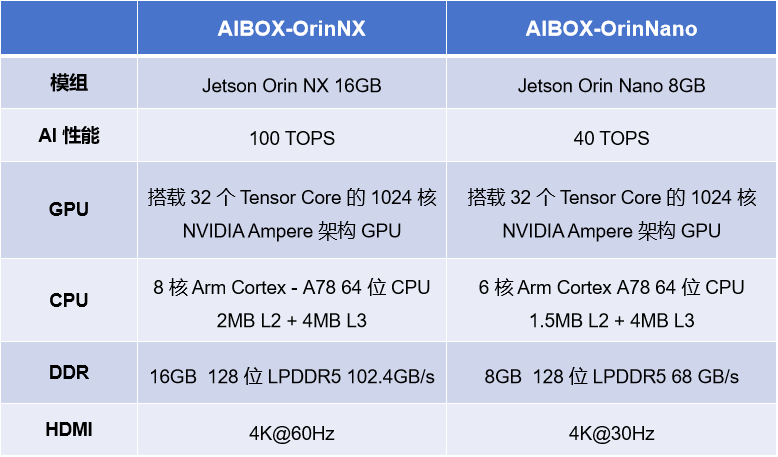

NVIDIA 系列 AIBOX

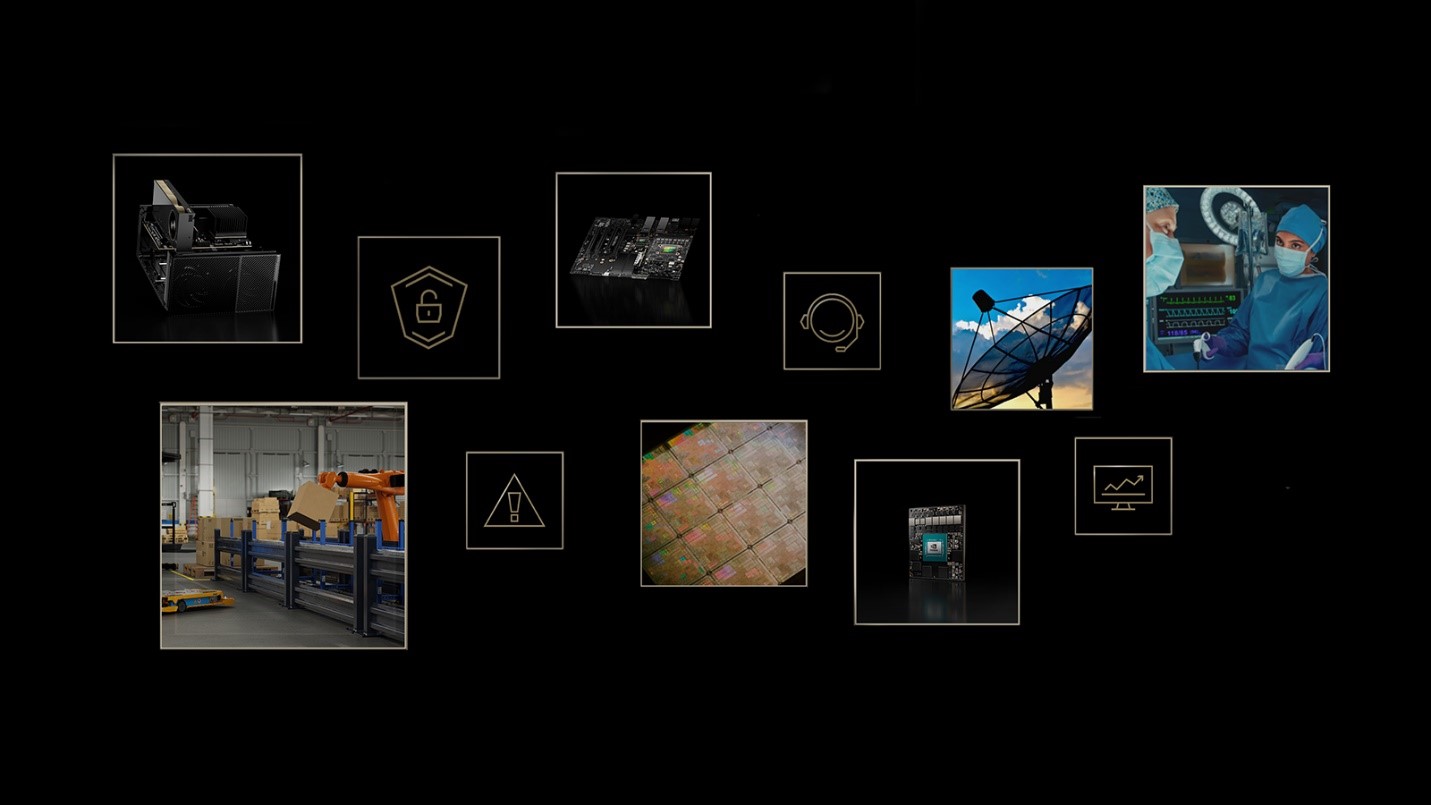

AIBOX-OrinNano 和 AIBOX-OrinNX 均搭載 NVIDIA 原裝 Jetson Orin 核心板模組,標配工業級全金屬外殼,鋁合金結構導熱,頂蓋外殼側面采用條幅格柵設計,高效散熱,保障在高溫運行狀態下的運算性能和穩定性,滿足各種工業級的應用需求。

NVIDIA TensorRT

NVIDIA系列 AIBOX 支持深度學習框架TensorRT,TensorRT是用于高性能深度學習推理的 API 生態系統,其包括推理運行時和模型優化,可為生產應用提供低延遲和高吞吐量。

TensorRT 生態系統包括 TensorRT、TensorRT-LLM、TensorRT 模型優化器和 TensorRT Cloud。

NVIDIA TensorRT 的優勢

推理速度提升 36 倍

優化推理性能

加速各種工作負載

使用 Triton 進行部署、運行和擴展

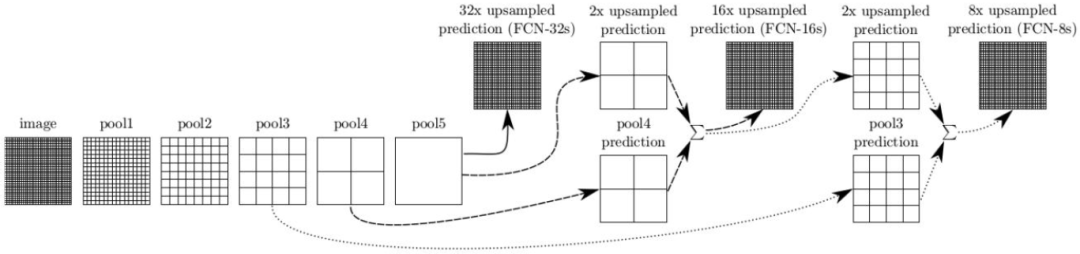

應用案例—語義分割

語義分割基于圖像識別,但分類是在像素級別進行的,而不是在整個圖像上進行。這是通過將預訓練的圖像識別骨干網絡進行卷積化來實現的,將模型轉換為能夠進行逐像素標注的全卷積網絡(FCN)。語義分割對于環境感知特別有用,它能夠對每個場景中的許多不同潛在對象(包括前景和背景)進行密集的逐像素分類。

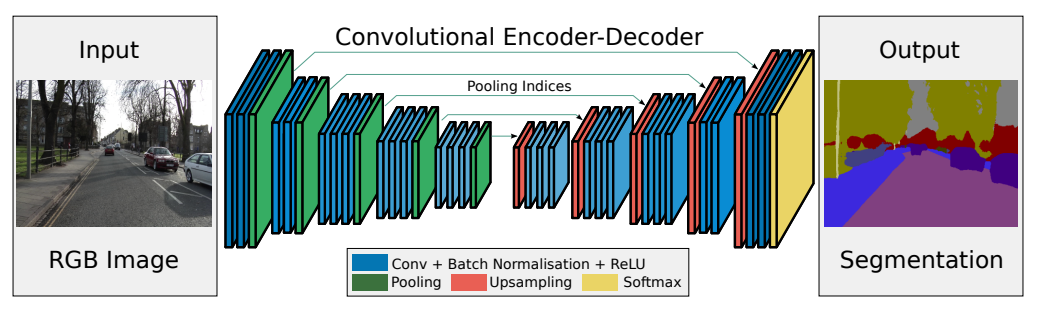

SegNet 模型

SegNet 的新穎之處在于解碼器對其較低分辨率的輸入特征圖進行上采樣的方式。具體地說,解碼器使用了在相應編碼器的最大池化步驟中計算的池化索引來執行非線性上采樣。經上采樣后的特征圖是稀疏的,因此隨后使用可訓練的卷積核進行卷積操作,生成密集的特征圖。SegNet 的架構與廣泛采用的 FCN 以及眾所周知的 DeepLab-LargeFOV,DeconvNet 架構進行比較。比較的結果揭示了在實現良好的分割性能時所涉及的內存與精度之間的權衡。

下載源碼

$ git clone --recursive --depth=1 https://github.com/dusty-nv/jetson-inference

編譯 / 安裝

參考:https://github.com/dusty-nv/jetson-inference/blob/master/docs/building-repo-2.md

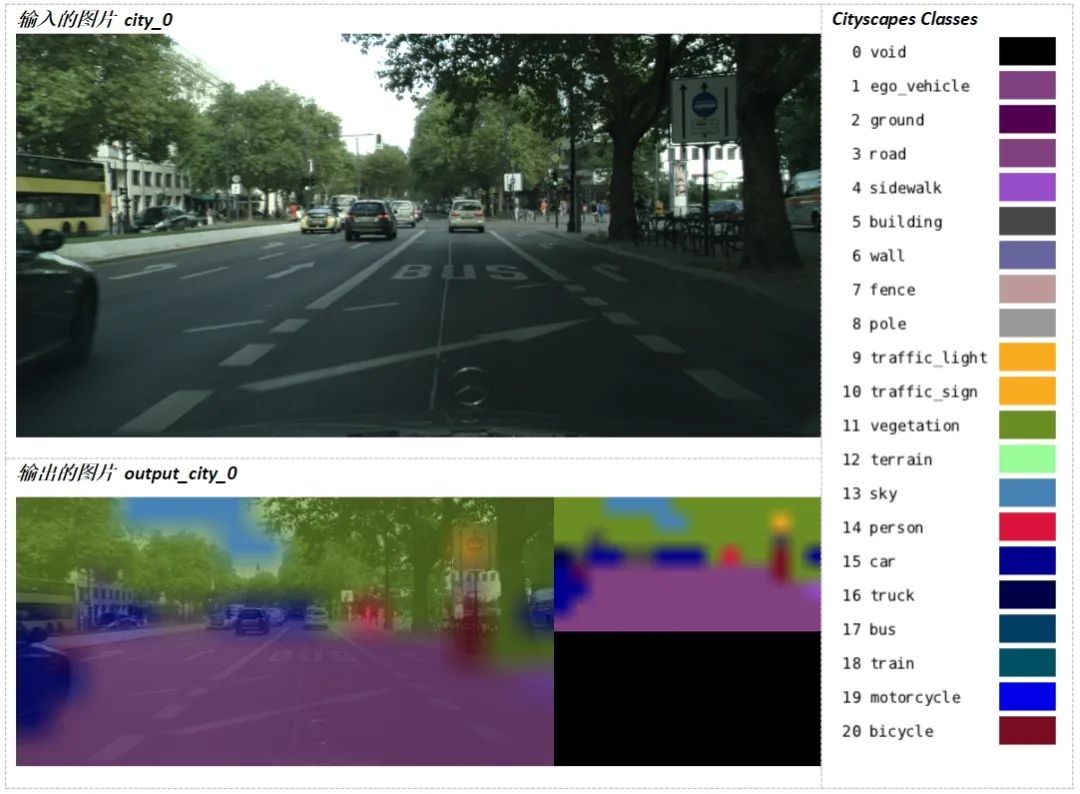

運行示例

$ ./segnet.py --network=fcn-resnet18-cityscapes city_0.jpg output_city_0.jpg

-

解碼器

+關注

關注

9文章

1143瀏覽量

40741 -

NVIDIA

+關注

關注

14文章

4986瀏覽量

103047 -

核心板

+關注

關注

5文章

1014瀏覽量

29768

發布評論請先 登錄

相關推薦

在NVIDIA TensorRT-LLM中啟用ReDrafter的一些變化

解鎖NVIDIA TensorRT-LLM的卓越性能

【NVIDIA生態】具有100 TOPS強勁算力的AIBOX!

NVIDIA TensorRT-LLM Roadmap現已在GitHub上公開發布

TensorRT-LLM低精度推理優化

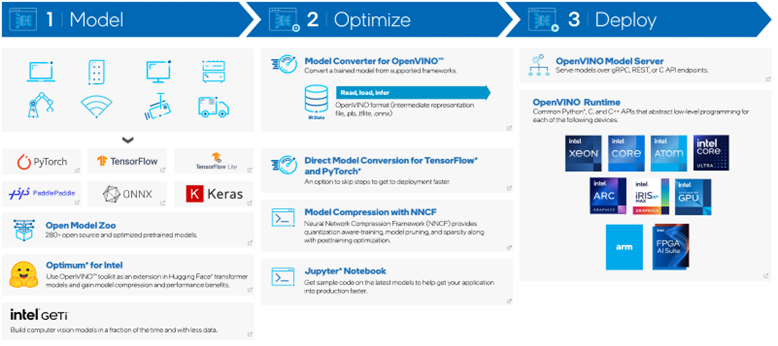

使用OpenVINO C# API部署YOLO-World實現實時開放詞匯對象檢測

AIBOX旗艦版:內置NVIDIA核心模組

魔搭社區借助NVIDIA TensorRT-LLM提升LLM推理效率

圖像語義分割的實用性是什么

圖像分割和語義分割的區別與聯系

圖像分割與語義分割中的CNN模型綜述

NVIDIA 通過 Holoscan 為 NVIDIA IGX 提供企業軟件支持,實現邊緣實時醫療、工業和科學 AI 應用

NVIDIA加速微軟最新的Phi-3 Mini開源語言模型

Torch TensorRT是一個優化PyTorch模型推理性能的工具

【AIBOX應用】通過 NVIDIA TensorRT 實現實時快速的語義分割

【AIBOX應用】通過 NVIDIA TensorRT 實現實時快速的語義分割

評論