大家好,我是雄雄,歡迎關注微信公眾號:雄雄的小課堂

@TOC

寫在前面

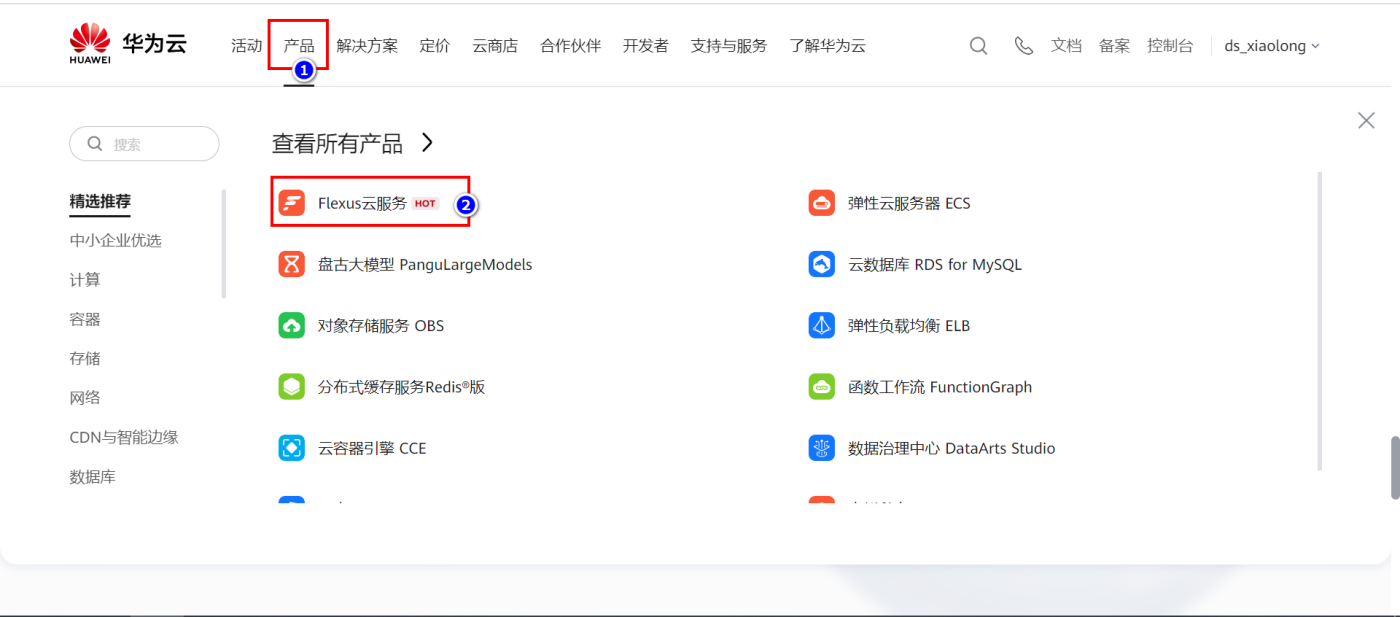

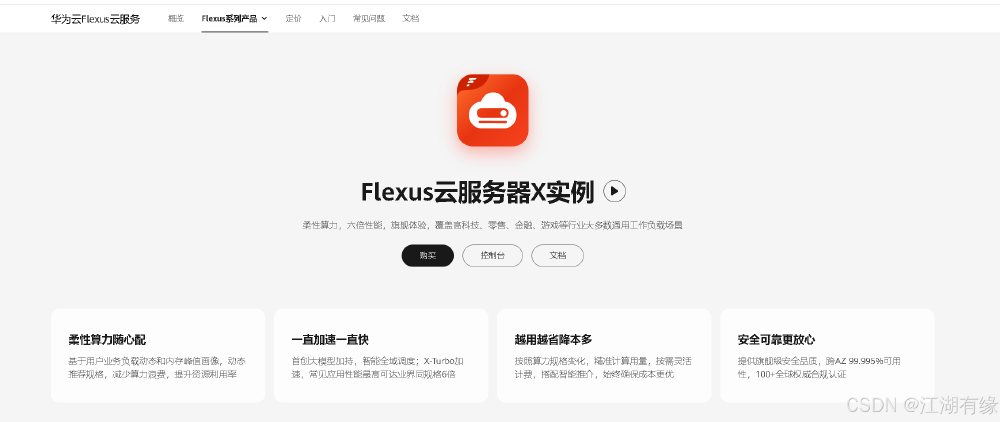

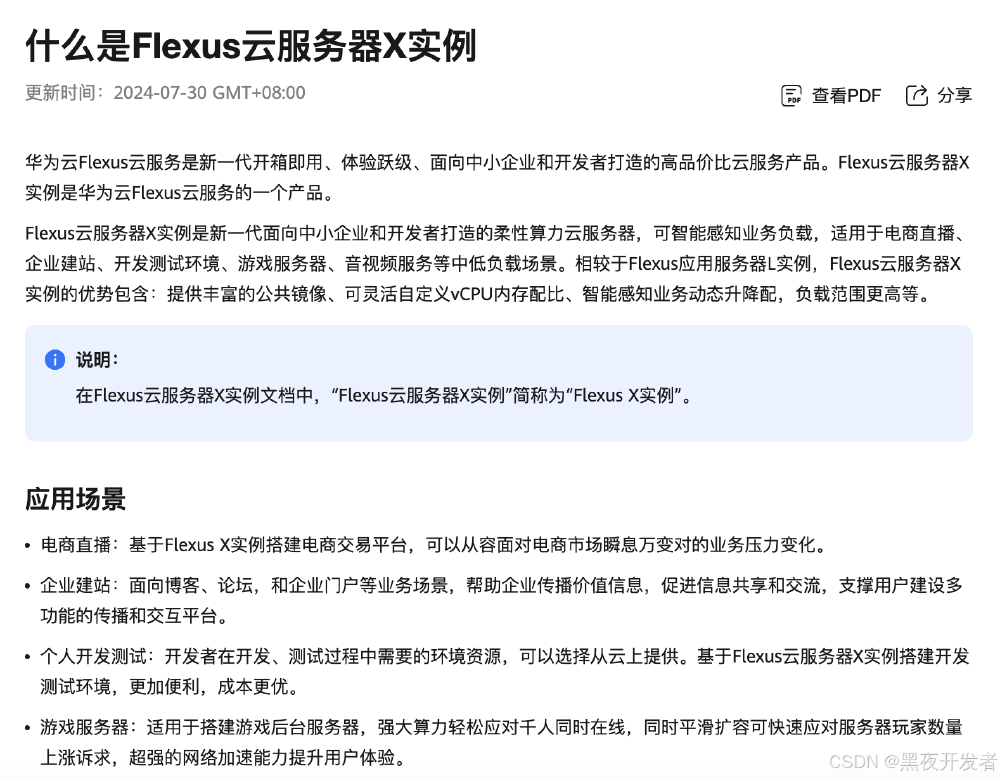

華為云 828,領 8280 元上云禮券,買高性能服務器!!!

這不,手里就拿到了一臺 4 核 12G,10M 的 Flexus X 實例云服務器,拿到后,就想著測測它的性能,看看有沒有官網說的那么神奇!!!

官網的活動地址在這里,領 8280 元券:點我查看

服務器配置情況

下面,簡單的給大家看看我手里的這臺服務器的配置,做個鋪墊,待會兒給大家上大招!!!

cpu 的情況

內存情況

硬盤情況

拿到服務器后,我不想再裝環境上浪費時間,所以就安裝了個寶塔,這個面板在服務器中,占不了多少內存,但是方便了裝環境,不用執行裝環境的命令,只需要在軟件商店中,找到需要安裝的軟件,點擊后面的安裝即可。

評測之前環境準備

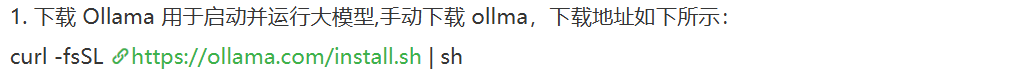

在正式評測之前,我們需要準備以下環境:

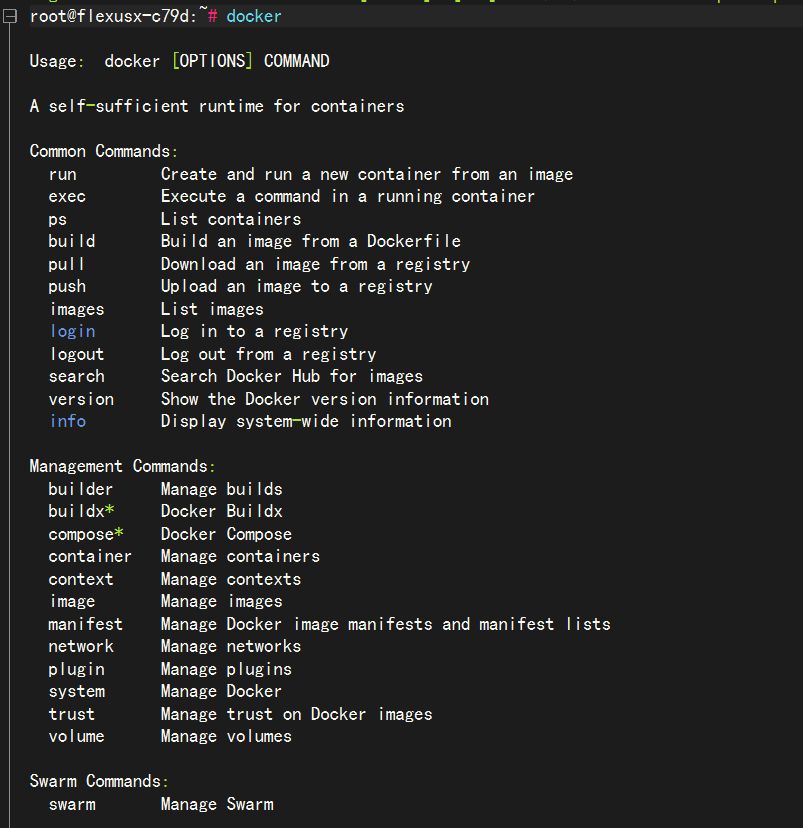

1.docker,不會安裝的可以自行百度

2.ollama,這個也很簡單,執行個命令就完事兒了

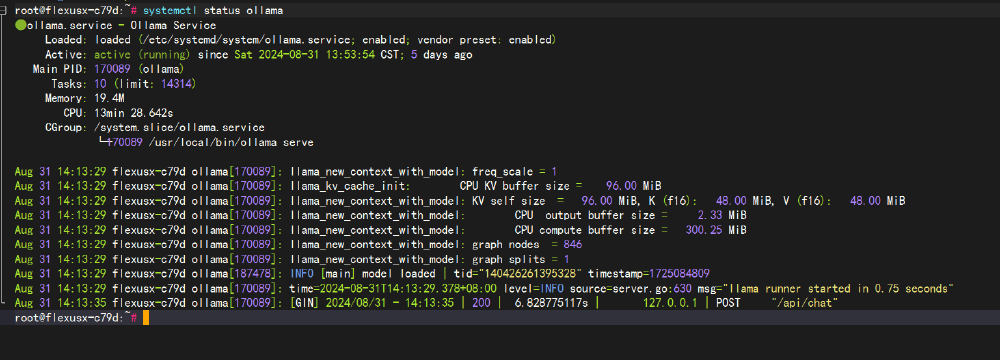

假使我們這兩個環境現在在云服務器上都安裝成功啦。

那么,現在我們開始正式評測!!!

華為云 Flexus X 實例大模型評測

下面,我們開始基于華為云的 Flexus X 實例云服務器評測一下大模型,因為我們現在還不知道這款服務器能跑多大的模型,所以我們就先從小模型開始跑。

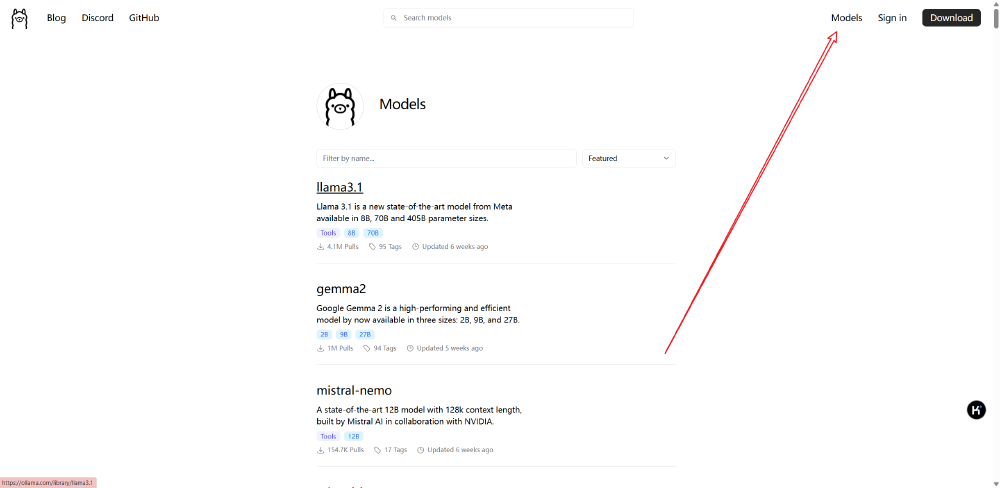

先來個小模型,下面我們可以直接使用 ollama 開始跑模型,大家進入 ollama 的官網,點擊右上角的 model 菜單:

然后就能看到下面所有 ollama 支持的大模型啦。

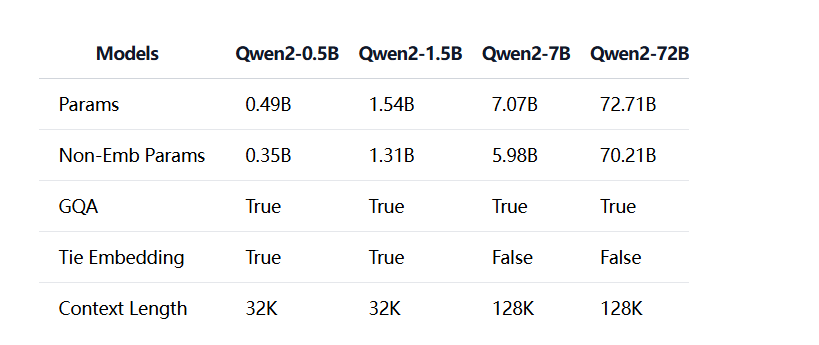

找到 qwen2,我們可以看到下面的 tag 里面分別有:0.5B,1.5B,7B,72B,這幾種。

千問 0.5B 大模型

下面,我們先以最小的為例,試試看看:(注意,模型的質量我們暫且不管,我們只評測響應速度以及 CPU 和內存的占用情況)

占用情況以寶塔面板上的統計圖為例,待會兒給大家截圖。

執行下面的命令,開始跑 0.5B 的大模型:

ollama run qwen2:0.5b

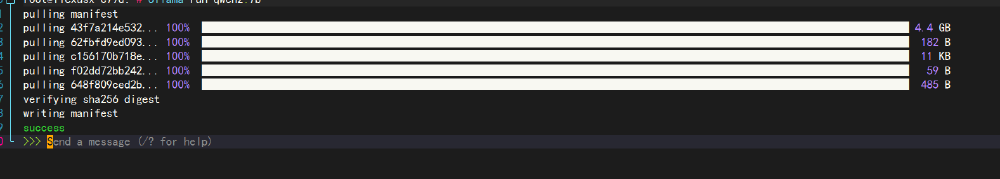

運行情況如下:

占用情況如下:

結論:0.5B 的大模型,可以看到,這個速度快的驚人,沒說的,繼續測下個大模型。

千問 1.5B 大模型

這次我們測 1.5B 的大模型,比 0.5B 的多 1,看看這款 Flexus X 實例云服務器的表現怎么樣。

同樣,執行下面的命令:

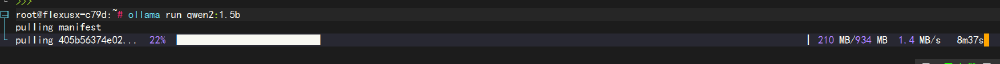

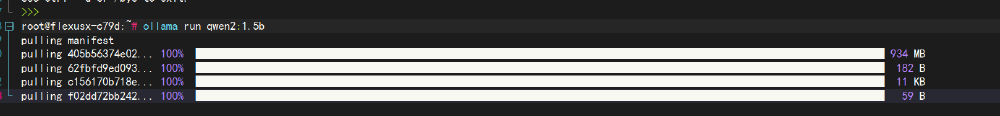

ollama run qwen2:1.5b

這里需要等待半天,讓下載。

下載過程中,我們可以看看寶塔上的內存和 CPU 的占比情況。

基本上毫無壓力,繼續等待!!!

等待的過程有點漫長.....

開測!!!

看看占用情況:

結論:比較完美,感覺和 0.5B 的區別不是很大,就是下載的時候慢了點,整體表現很棒。

gemma2 的 2b 大模型

0.5B 和 1.5B 的我們都測試過了,大家也可以從上圖中看的出來,一點壓力都沒有,響應速度也很快,嗖嗖的就回答完畢了,質量也還行,而且最主要的是服務器的性能完全是過剩的,沒跑滿,所以,我們接著加大力度測試。

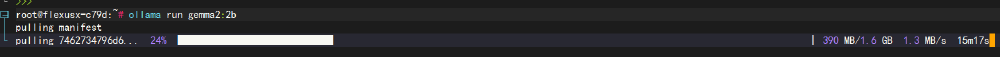

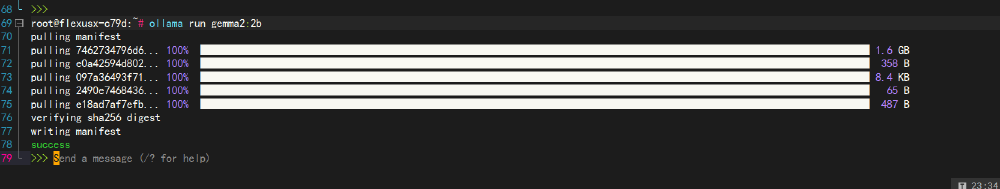

現在我們測測 gemma2 的 2b 大模型,運行如下命令:

ollama run gemma2:2b

又到了等待的過程中了,總是這么漫長~

在下載模型的過程中,我們可以看看占用情況:

一點問題都沒有,幾乎沒有占多少,現在我們繼續等待。

等待完畢,開始問個問題測試一下:

效果展示情況:

資源占用情況:

結論:通過效果圖 gif 中可以看的出來,響應要比 1.5B 的稍微慢了點兒,但是這個速度還是可以接受,不過內存占用稍微偏高了,由原來的 27 增加到了 34,倒是也能接受,畢竟模型的大小由原來的 900 多 M 到現在的 1.4G 了。

千問 7B 大模型

現在,我們繼續增大模型,看看表現效果怎么樣。

這次我們測一下千問的 7B 大模型,這是 2B 的 3 倍多,看看這款 Flexus X 實例云服務器跑 7B 的模型是個什么情況。

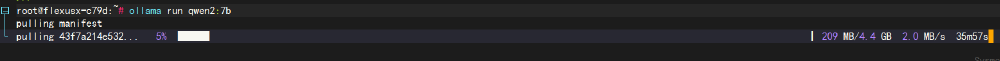

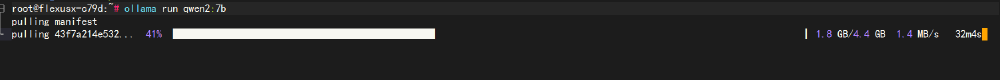

同樣,執行下面的命令:

ollama run qwen2:7b

繼續等待:

7B 的模型,已經到了 4G 多了,期待他能有個很好的表現。

現在是:2024 年 9 月 6 日 00:02:43,我的 7B 大模型還在下載中,已經困的不行了....

再等等....

終于等它下載完啦,一共 4.4G,等的我都快做夢啦。切記,如果有大文件上下傳的場景,買服務器的時候一定要選擇個大帶寬的,我的這個是 10M 的帶寬,感覺遇到大文件了,還是有點不足。

下面我們開始進行評測,首先還是老規矩,先運行看看效果:

資源占用情況:

結論:大家可以看看效果圖中,可以發現,很明顯,相比起 2B 1.5B 的這種小模型來比,7B 的模型,在響應方面確實是稍微慢了點兒,但是也沒有慢到一個字一個字的往出蹦,還是可以接受的。資源占用情況的話,CPU 占用上升到了 50.4% ,內存在原來的 34 增加到了 49。也沒有跑滿服務器。

總結

先放一張各個大小的模型之間的對比吧,從 0.5B,到 1.5B,再到 7B,以及 72B。

大家可以從上圖中看的出來,模型越大,params 就越大,本文我們通過對 0.5b,1.5b,2b,7b 這幾個模型進行評測對比,總體來說,比我預想的要好很多,我以為 7b 的會卡的很,結果表現的很棒,這么看來,跑 8B 以內的模型是沒有問題的。

在往上的大模型,可能會吃力,不過 8B 以內,其實小微企業足矣!!!

審核編輯 黃宇

-

云服務器

+關注

關注

0文章

592瀏覽量

13362 -

大模型

+關注

關注

2文章

2450瀏覽量

2706

發布評論請先 登錄

相關推薦

華為云 Flexus 云服務器 X 實例之 openEuler 系統下部署 Web 應用服務器 OpenResty

華為 Flexus 云服務器 X 實例 使用流程

基于 Flexus X 實例云服務器的評測 - 大模型對比評測

基于 Flexus X 實例云服務器的評測 - 大模型對比評測

評論