?作者:算力魔方創始人/英特爾邊緣計算創新大使 劉力

前面我們分享了《Meta重磅發布Llama 3.3 70B:開源AI模型的新里程碑》,Llama 3.3 70B模型的發布,標志著開源AI模型在智能水平上的一大飛躍。它不僅達到了之前只有Llama 3.1 405B模型才具備的智能水平,而且還超越了11月發布的GPT-4o模型。

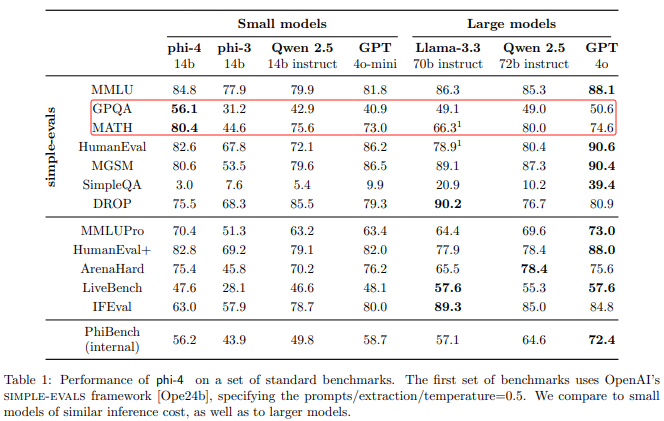

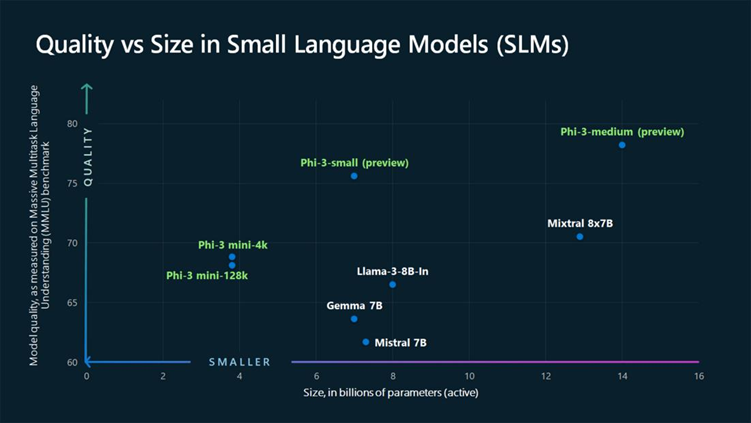

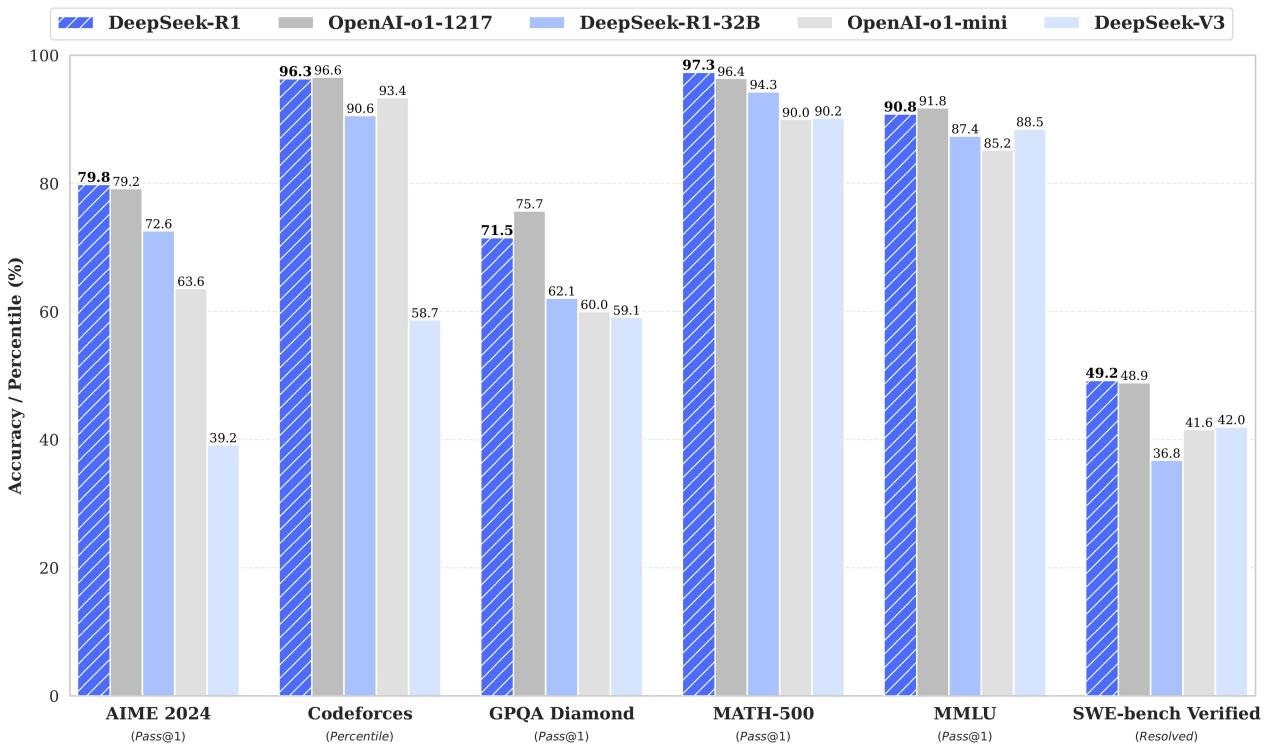

本文我們將分享微軟剛剛發布的Phi-4模型,其模型參數只有14B,是Llama3.3 70B的五分之一,但性能卻跟Llama 3.3 70B模型差不多,甚至在GPQA和MATH兩項上還超越了Llama3.3 70B!

參考鏈接:https://arxiv.org/pdf/2412.08905

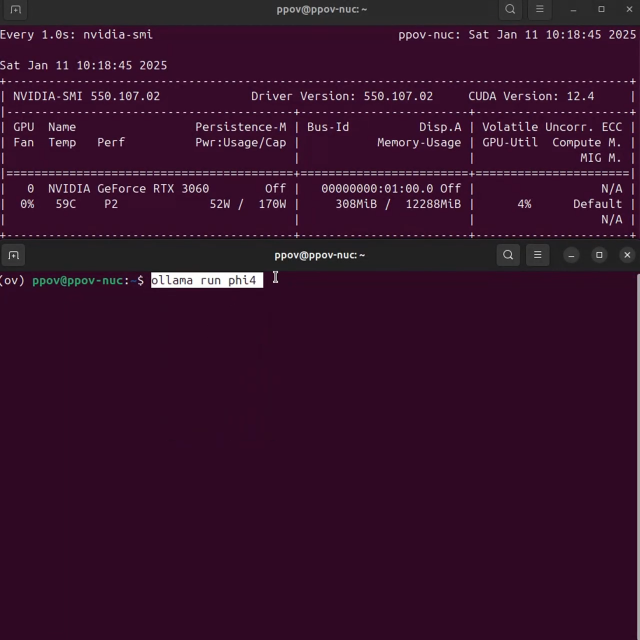

本文將分享Phi-4 14B模型在算力魔方4060版上的部署過程。

一,算力魔方?簡介

算力魔方?是一款可以DIY的迷你主機,采用了抽屜式設計,后續組裝、升級、維護只需要拔插模塊。通過選擇不同算力的計算模塊,再搭配不同的 IO 模塊可以組成豐富的配置,適應不同場景。

性能不夠時,可以升級計算模塊提升算力;IO 接口不匹配時,可以更換 IO 模塊調整功能,而無需重構整個系統。

本文以下所有步驟將在帶有英特爾i7-1265U處理器的算力魔方?上完成驗證。

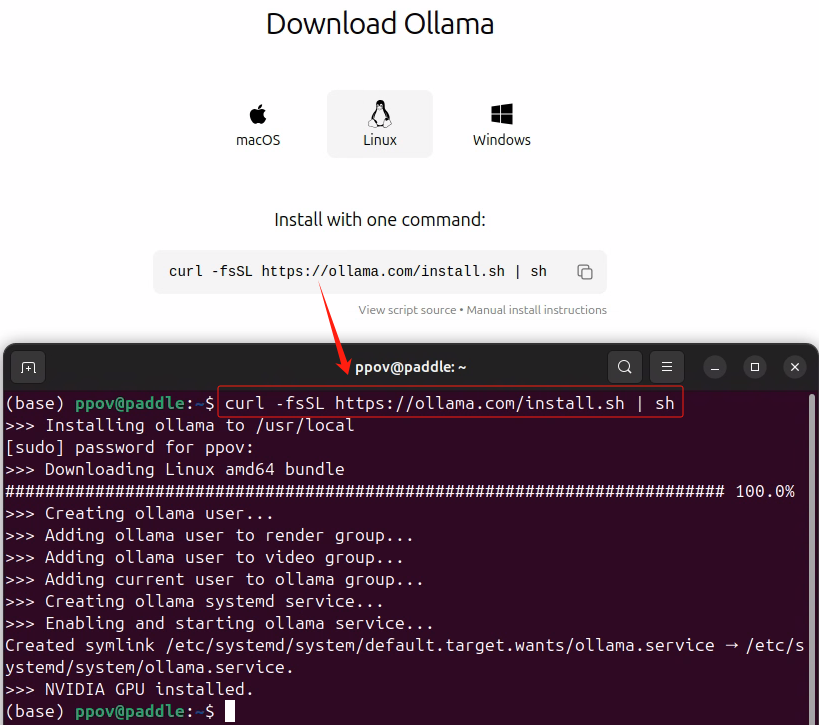

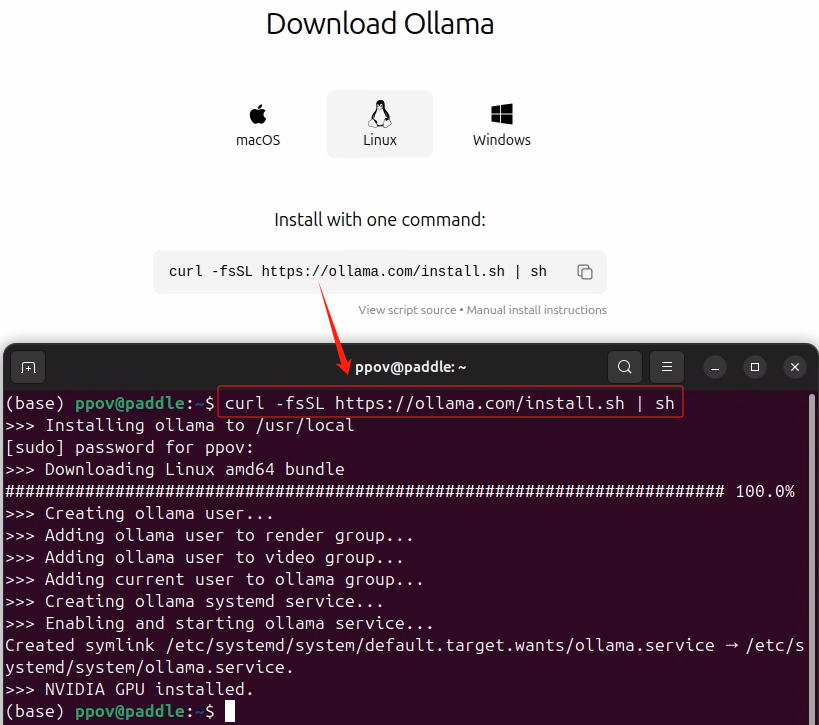

二,安裝Ollama

請按照《Gemma 2+Ollama在算力魔方上幫你在LeetCode解題》安裝Ollama。

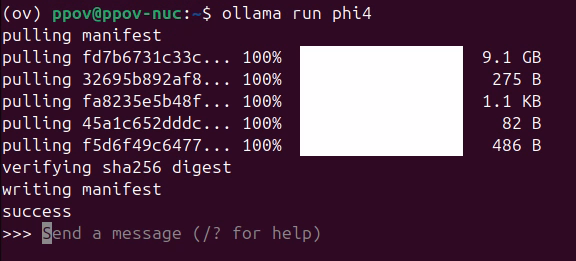

三,運行Phi-4

使用下面的命令完成運行Phi-4:

ollama run phi4

四,測試Phi-4數學能力

輸入下面的數學問題,測試Phi-4的數學能力:

A farmer has a rectangular field with a length of 2x + 5 meters and a width of x - 3 meters.

Part A: Find the area of the field in terms of x.

Part B: If the area of the field is 150 square meters, determine the value of x.

Part C: Calculate the perimeter of the field.

五,總結

使用Ollama可以方便快捷的將Phi-4模型本地化部署在算力魔方?上。

如果你有更好的文章,歡迎投稿!

稿件接收郵箱:nami.liu@pasuntech.com

更多精彩內容請關注“算力魔方?”!

?審核編輯 黃宇

-

模型

+關注

關注

1文章

3291瀏覽量

49028 -

算力

+關注

關注

1文章

1009瀏覽量

14899

發布評論請先 登錄

相關推薦

機器人“大腦+小腦”范式:算力魔方賦能智能自主導航

用Ollama輕松搞定Llama 3.2 Vision模型本地部署

從零開始訓練一個大語言模型需要投資多少錢?

在英特爾酷睿Ultra7處理器上優化和部署Phi-3-min模型

在算力魔方上本地部署Phi-4模型

在算力魔方上本地部署Phi-4模型

評論