OpenAI o1、QwQ-32B-Preview、DeepSeek R1-Lite-Preview的相繼發布,預示著生成式AI研究正從預訓練轉向推理(Inference),以提升AI邏輯推理(reasoning)能力,這一轉變將極大推動上層應用的發展。

紅杉資本近期指出,在可預見的未來,邏輯推理和推理時計算將是一個重要主題,并開啟生成式AI的下一階段。新一輪競賽已然開始。

那么,在推理這一新興市場,哪些企業占據了生態位?他們如何滿足應用層的需求?市場格局又將如何變化?風險投資專家Eric Flaningam在本文中作了深刻分析和可能性預測。其中,有一點是明確的:推理市場的發展取決于AI應用程序的規模和形態。因此,對于專注提供推理服務的企業而言,對應用層變化的感知與需求抽象變得尤為重要。

隨著 OpenAI o1 發布,推理(inference)終于進入了我們過去一年來一直期待的聚光燈下。英偉達CEO黃仁勛曾說:“推理的規模將會比今天大十億倍。”(順便說一句:從查詢數量的角度來看,這可能是真的,但如果推理確實占到了英偉達收入的40%,這個說法在收入上是不可能實現的。)

借助 o1,推理首次構成了模型總計算中有意義的一部分。

來源:

https://www.fabricatedknowledge.com/p/chatgpt-o1-strawberry-and-memory

它指出了一個新的潛在規模定律,即模型“思考”的時間越長,其準確性就越高。Stratechery(https://stratechery.com/2024/enterprise-philosophy-and-the-first-wave-of-ai/)

對這一性能的提升描述得很好:

o1 被明確訓練為如何解決問題,其次,o1 被設計成在推理時生成多個問題解決流,選出最佳方案,并在意識到出錯時迭代每個步驟。這就是為什么它能解開填字游戲——只是花了很長時間。

上個月,Anthropic 宣布了“計算機使用(Computer Use)”功能,使模型能夠像人類一樣與計算機互動。這表明,人工智能應用將變得越來越復雜,進而導致推理量的增加。

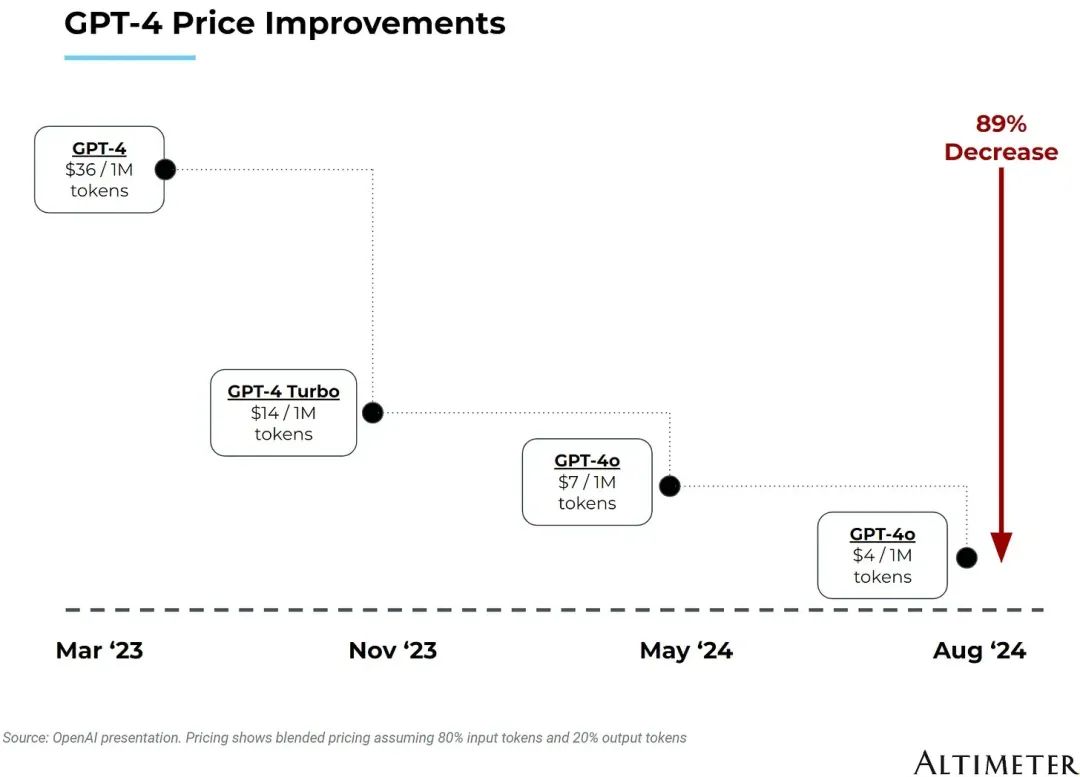

兩個因素使這個市場特別有趣:計算成本的降低和該領域的激烈競爭。

來源:

https://cloudedjudgement.substack.com/p/clouded-judgement-92724-the-foundation

隨著推理成本的降低,市場規模的迅速擴大,以及該領域的競爭加劇,這個市場為人工智能提供了一個非常有趣的案例研究。

本文將深入探討當前的形勢,決定市場走向的變量,以及基于這些變量價值如何在生態系統中流動。

明確地說,推理是一個新興市場,這個領域非常擁擠且變化迅速。我們目前擁有的最佳推理性能指標是第三方基準測試(如果你有更準確的數據,歡迎隨時聯系我們)。

1推理的背景

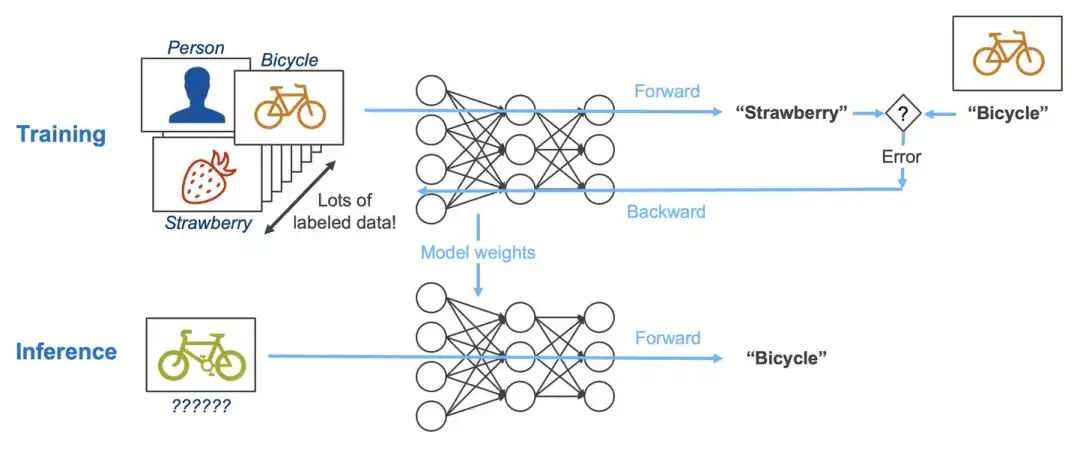

首先,推理提供了一個比訓練更加開放的競爭市場。在訓練過程中,通過大量數據集的迭代來創建一個表示復雜場景的模型,而推理則是將新數據輸入該模型以進行預測的過程。

來源:

https://www.linkedin.com/pulse/difference-between-deep-learning-training-inference-mark-robins-mdq8c

一些關鍵差異在推理中尤為重要:

延遲與位置至關重要:由于推理會為終端用戶運行工作負載,響應速度至關重要,這意味著在邊緣或邊緣云環境中進行推理可能比訓練更有意義。相比之下,訓練可以在任何地方進行。

可靠性的重要程度(稍微)降低:訓練前沿模型可能需要數月時間,并且需要大規模的訓練集群。訓練集群的相互依賴性意味著集群中一個部分的錯誤可能會減緩整個訓練過程。而在推理過程中,工作負載要小得多,且相互依賴性較低;如果發生錯誤,只有單個請求受到影響,并且可以快速重新運行。

硬件可擴展性的重要程度降低:Nvidia 的一個關鍵優勢在于其通過軟件和網絡優勢擴展更大系統的能力。在推理方面,這種可擴展性的重要程度較低。

這些原因共同解釋了為什么許多新的半導體公司專注于推理,因為進入門檻相對較低。

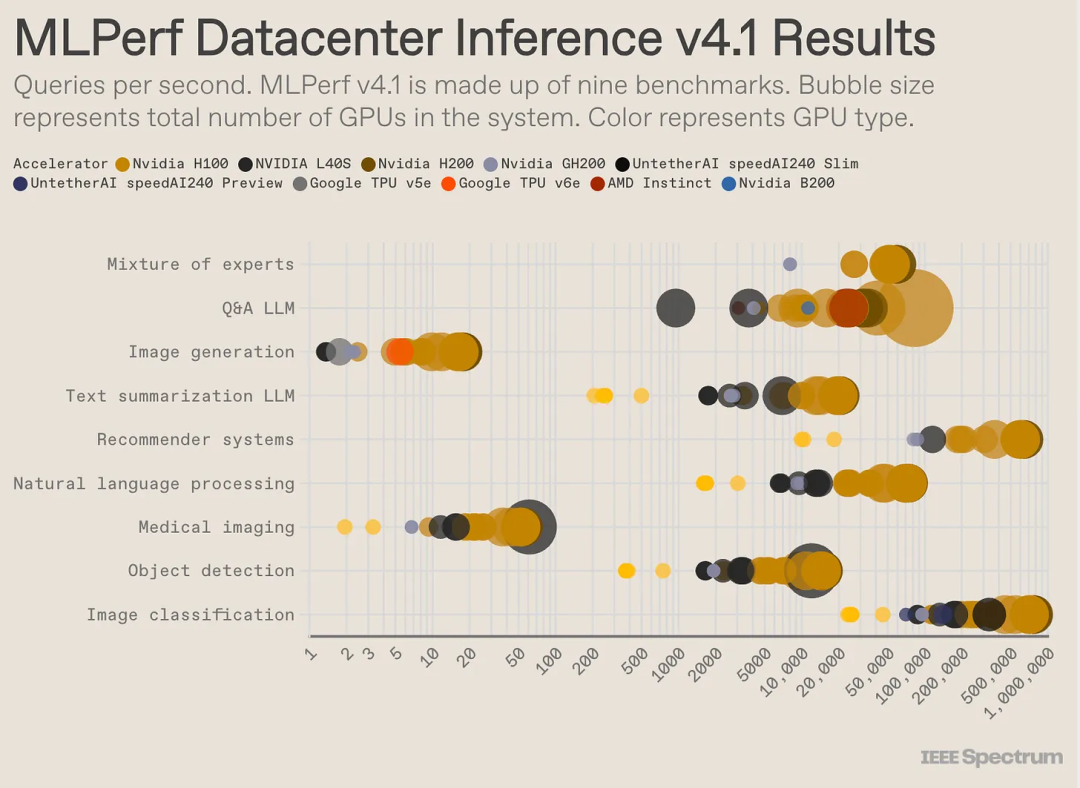

需要指出的是,雖然“推理”是一個廣泛描述模型實際使用情況的術語,但它涵蓋了各種類型的機器學習模型。我的同事在這里寫到了近年來 ML 部署方式的變化。這里展示了不同工作負載的性能差異:

2當前的推理市場概覽

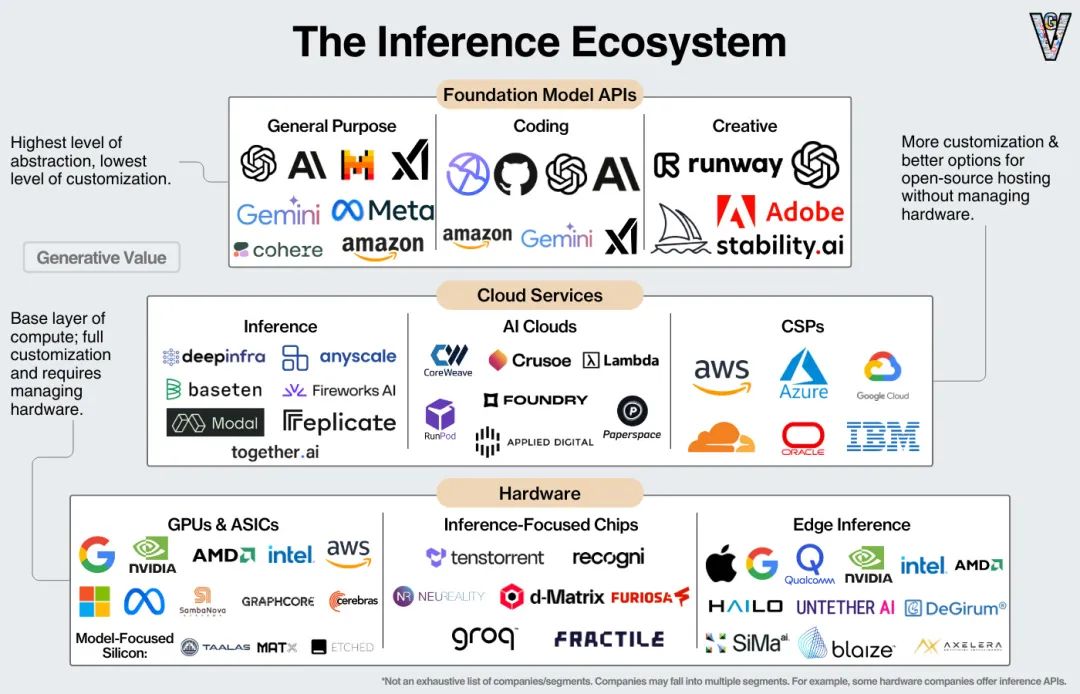

企業運行推理有很多選擇。從最易于管理且定制化程度最低到最難管理但定制化程度最高的選項,企業有以下幾種選擇進行推理:

基礎模型 API:來自 OpenAI 等模型提供商的 API。最簡單且靈活性最低的選項。

推理服務提供商:專門的推理服務提供者,如 Fireworks AI 和 DeepInfra,旨在優化跨各種云和硬件提供商的成本,是運行和定制開源模型的良好選擇。

AI 云:來自 Coreweave 和 Crusoe 等公司的 GPU 或推理即服務,企業可以租用算力并根據需要進行定制。

超大規模云廠商:超大規模云廠商提供計算能力、推理服務和平臺,企業可以在這些平臺上開發專用模型。

AI 硬件提供商:企業用自己的 GPU 并根據特定需求進行優化。

附加信息1:從 API 到 AI 硬件——像 Groq、Cerebras 和 SambaNova 這樣的公司已經開始提供推理云服務,使客戶能夠以推理 API 的形式利用其硬件。Nvidia 收購了推理服務提供商 OctoAI,據推測是為了創建自己的推理服務。

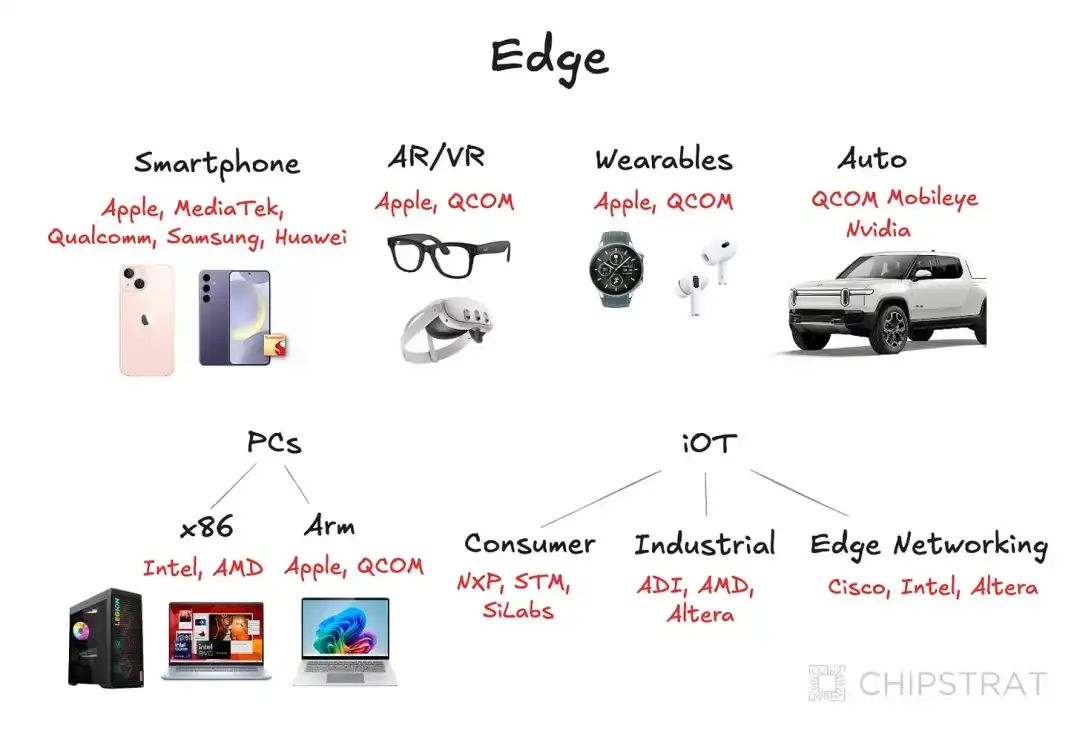

附加信息2:邊緣推理——Apple、Qualcomm 和 Intel 希望提供硬件和軟件,使推理能夠直接在設備上進行。

鑒于基礎模型 API 很簡單(企業從基礎模型提供商調用 API 并按需付費)。我將從推理提供者開始介紹。

3推理提供商

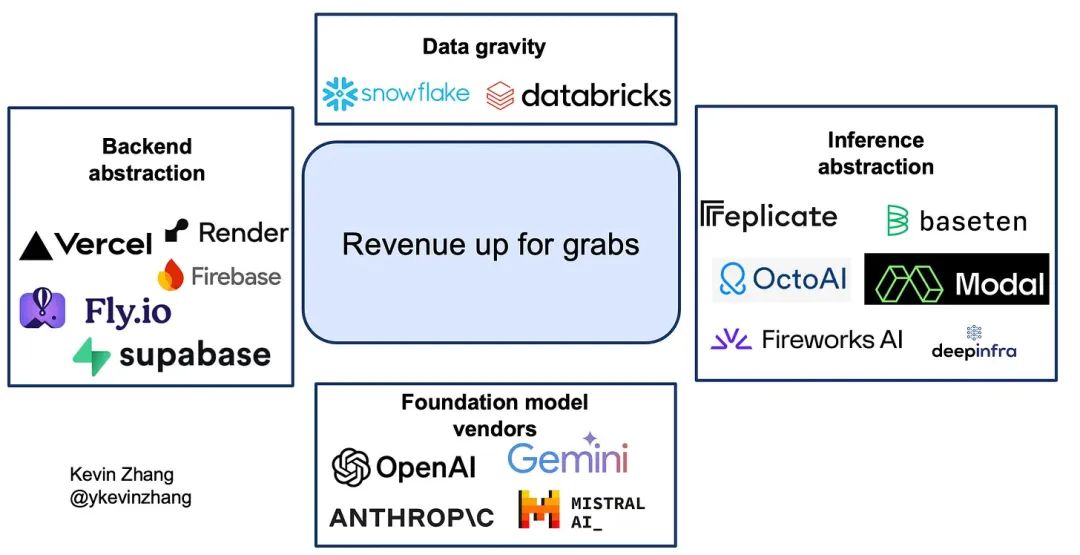

數家公司在提供推理服務方面嶄露頭角,他們抽象化了管理硬件的需求。這些公司中最著名的是像 Fireworks AI、Together、Replicate 和 DeepInfra 這樣的推理初創公司。Kevin Zhang 在這里很好地描述了這些公司:

像 Replicate、Fireworks AI 和 DeepInfra 這樣的 API-only 初創公司已經完全抽象化了所有復雜性,使得模型可以通過 API 調用訪問。這類似于 OpenAI 等基礎模型提供商為開發者提供的使用體驗。因此,這些平臺通常不允許用戶自定義選擇用于特定模型的 GPU 等。不過,Replicate 有 Cog 用于部署自定義模型等任務。

與此同時,Modal 和 Baseten 提供了一種介于兩者之間的體驗,開發者有更多的“調節旋鈕”來控制他們的基礎設施,但仍然比構建自定義基礎設施更容易。這種更細粒度的控制使 Modal 和 Baseten 能夠支持超出簡單文本補全和圖像生成的使用場景。

這些提供商的最明確用例是為開源模型提供推理服務,使企業能夠使用該模型構建應用程序。推理提供商使用各種技術,盡可能地優化成本。

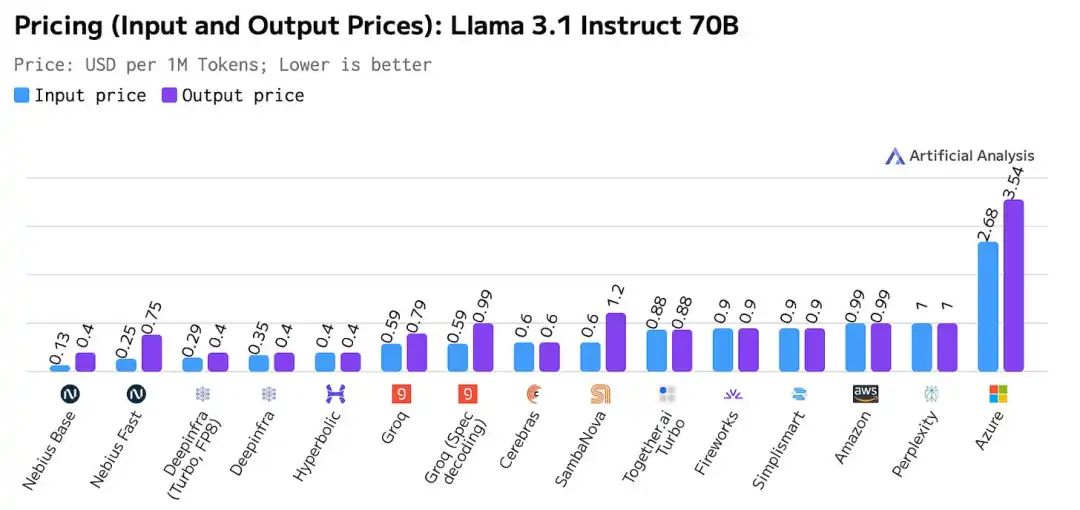

在選擇推理提供商時,最終考慮因素主要是成本/性能的計算,包括推理成本、延遲(首次輸出時間和各輸出之間的時間)和吞吐量(處理需求的能力)。我們對價格有一些了解:

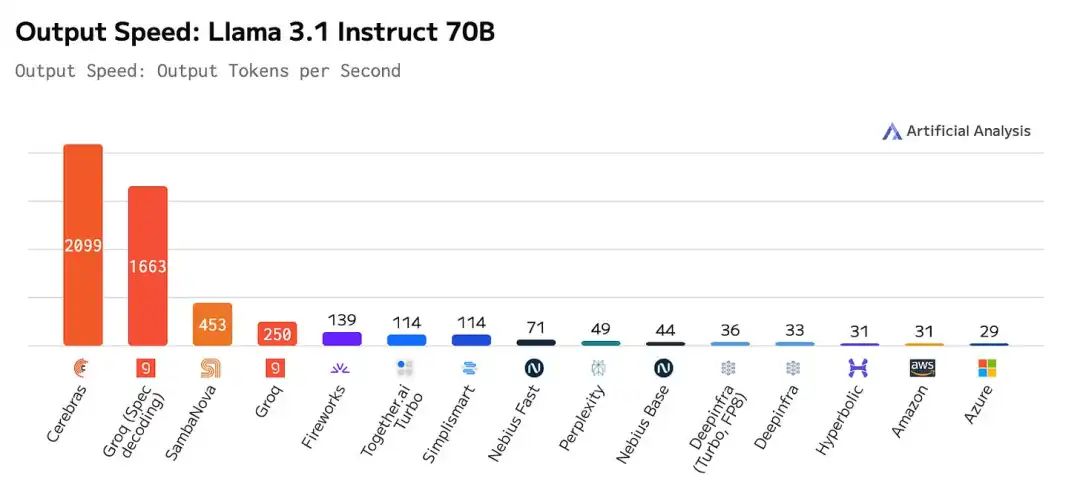

現在,過去幾個月的一個有趣變化是硬件供應商開始進軍推理領域。Nvidia 收購了推理提供商 OctoAI,可能是為了提供類似的服務。我們可以看到有三家硬件供應商提供了市場上最快的推理服務:

一如既往,應對基準測試結果持保留態度。根據Irrational Analysis(https://irrationalanalysis.substack.com/p/cerebras-cbrso-equity-research-report),Cerebras 不提供 Llama 405B,可能是因為其成本不合理。特定的設置可以實現這些結果,但它們可能與其他模型不兼容,或在生產使用場景中不實用。

大多數公司的投資回報率(ROI)計算將是總擁有成本/性能的比值,而這是在行業生命周期的這個階段很難獲得的數據。

我會指出,像 Coreweave、Crusoe 和 Lambda 這樣的 AI 云都提供推理服務。超大規模云廠商也是如此!Kevin Zhang 還推測,數據平臺和應用程序基礎設施提供商也可能擴展到推理領域:

來源:

https://eastwind.substack.com/p/a-deep-dive-on-ai-inference-startups

在這種競爭環境下,公司要么需要提供有意義的架構差異、基于推理解決方案的開發工具或通過垂直整合實現成本優勢,以創造有意義的差異化。

4硬件提供商

上述推理提供者抽象了管理底層硬件的復雜性。對于許多大型 AI 公司來說,管理自己的硬件是有意義的。這包括基礎設施設置(安裝、數據中心建設或機房托管設置)、模型優化、性能監控和持續的硬件維護。

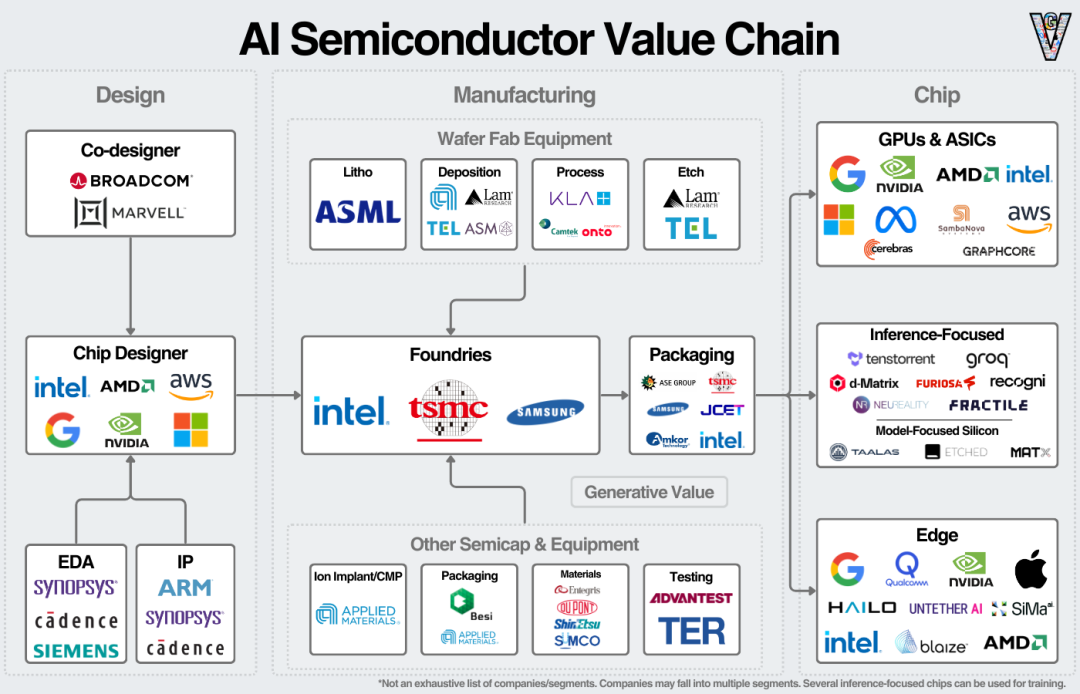

我們可以在價值鏈的芯片部分看到硬件供應商:

如果英偉達 40%的數據中心收入確實來自推理,那么英偉達今天在這個市場上占據主導地位。正如黃仁勛指出的,已經擁有領先訓練硬件的企業可能會在升級設備時將其轉換為推理硬件。

AMD 正在開拓這一市場,預計其 AI 加速器將帶來 50 億美元的年收入。他們最近的財報電話會議上的大部分定性評論都指向了推理工作負載。

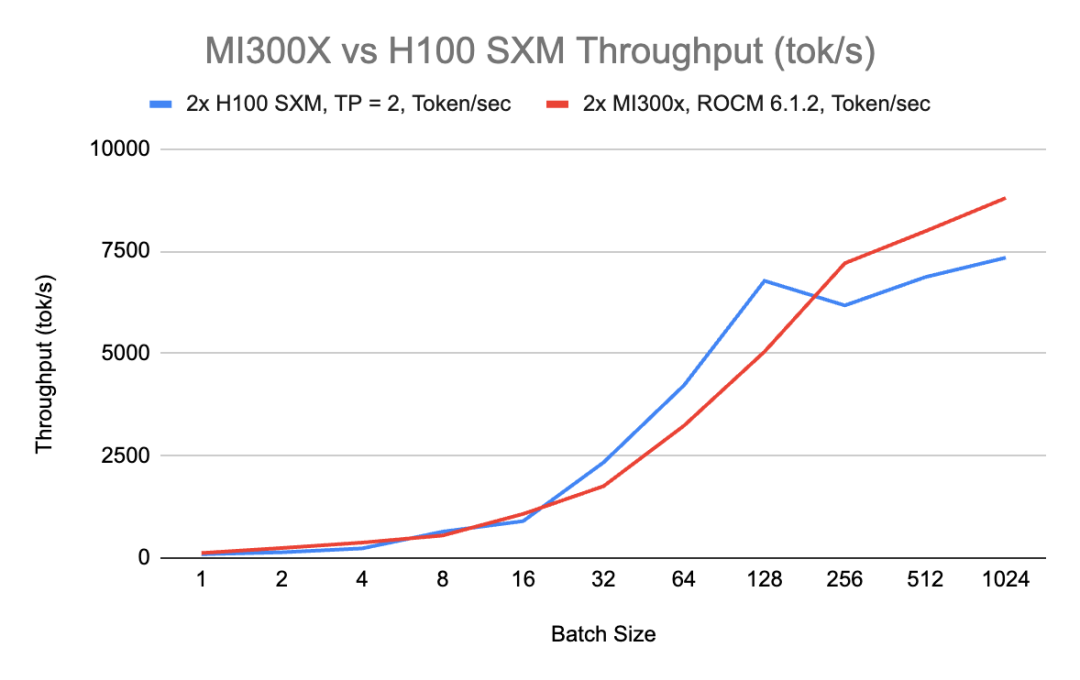

RunPod 對 H100 和 MI300X 在推理方面作了有趣比較,指出 MI300X 由于有更大的 VRAM,在高批處理大小時具有更好的吞吐量。

https://blog.runpod.io/amd-mi30x-vs-nvidia-h100-sxm-performance-comparison-on-mixtral-8x7b-inference/

MI300X 在非常小和非常大的批處理中更具成本優勢。正如博客所指出的,純粹的性能只是評估的一部分。Nvidia 在網絡和軟件方面的領先地位使其在需要系統級設計的實際場景中具有額外的優勢。

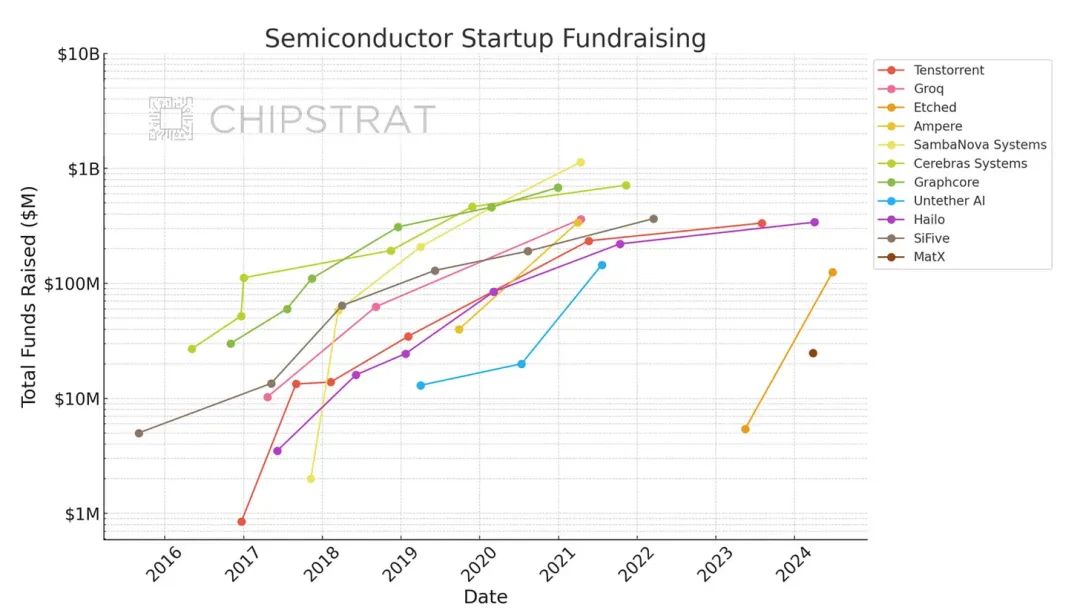

有幾家硬件初創公司也籌集了大量資金以搶占這個市場:

https://www.chipstrat.com/p/etched-silicon-valleys-speedrun

再次需要指出,買家的計算公式將是 TCO/性能。價值將流向硬件層面,問題在于在硬件之上的各層創造了多少價值。

市場上還有一個不確定的變量,但它可以決定推理中價值積累的很大一部分。

5邊緣推理呢?

Chipstrat的Austin(https://www.chipstrat.com/)在這方面做了出色的工作。正如奧斯汀所描述的,邊緣推理對所有相關方都是有利的:

企業將會越來越有動力將這些工作負載盡可能地轉移到消費者的設備上——消費者提供了硬件和電力資源,使企業能夠生成智能。

這是雙贏的局面:企業減少了資本支出和運營支出,而消費者則享受到了本地推理的好處。需要注意的是,采用本地推理需要:

激勵消費者(獎勵本地推理的商業模式、安全優勢等)。

可以在邊緣設備上運行的有用的小模型。

前者似乎很簡單。像 o1-mini 這樣的模型使后一種方法越來越現實。我不需要 Siri 成為整個網絡的壓縮版本——只需要一個能夠處理簡單任務的推理工具。所需要的更像是一個訓練有素的五年級學生,而不是一個博士通才。

問題回歸到開發硬件和軟件以滿足用戶需求。我相信我們可以隨著時間解決這些問題。

https://www.generativevalue.com/p/the-ai-semiconductor-landscape

企業已經在開發硬件,如蘋果的神經網絡引擎、AMD 的 NPU、英特爾的 NPU、高通的 NPU、谷歌的 Tensor 以及初創公司 Hailo。隨著小型模型的改進,它將越來越多地實現在邊緣進行推理。

我對邊緣推理的看法:

如果我們回顧歷史上的顛覆性科技變革事件,它發生在新產品以遠低于現有產品價格提供較少功能時,而現有產品無法與之競爭。大型機讓位給小型機,小型機讓位給個人電腦,個人電腦又讓位給智能手機。

開啟這些顛覆性變化的關鍵變量是性能過剩。高端解決方案解決了對大多數人而言非必需的問題。許多計算領域的顛覆性變化來自于計算的去中心化,因為消費者并不需要額外的性能。

有了AI,我還沒看到性能過剩。ChatGPT 很好,但還不算出色。一旦它變得出色,那么 AI 在邊緣計算的大門就會打開。小型語言模型和神經處理單元將引領這個時代。問題在于 AI 何時會在邊緣計算中實現,而不是是否會實現。

這個市場再次回歸到應用,邊緣推理對于消費者應用來說更有意義。

6推理市場的未來

推理工作負載最終將遵循 AI 應用程序的規模和形態。

人工智能用的規模和強度將是決定推理市場大小的關鍵因素(即有多少應用程序在使用以及它們的復雜程度)。這些應用程序的形態(即誰在構建它們)將有助于確定推理市場的形態。

如果 AI 應用市場最終集中在 OpenAI、Microsoft 和 Google 等少數幾家公司手中,那么推理價值將流向這些垂直整合公司的底層硬件。

如果 AI 應用市場最終變得碎片化,許多公司擁有較小的市場份額,那么推理市場將更加開放。這些較小的、非垂直整合的公司,將為推理提供商的管理服務付費。有些公司可能希望獲得比簡單 API 所能提供的更多的個性化或定制化選項。

如果這些應用程序能夠使用足夠簡單的模型在邊緣運行,那么這將為邊緣的推理硬件打開大門。

最后,所有這些變量都是連續的,而不是二元的。一些推理將在邊緣運行,一些應用程序將成為高度復雜的邏輯推理機器,一些應用程序將由大型模型提供商擁有,而另一部分將由初創公司贏得。

-

AI

+關注

關注

87文章

31360瀏覽量

269762 -

人工智能

+關注

關注

1793文章

47566瀏覽量

239415

原文標題:生成式AI推理技術、市場與未來

文章出處:【微信號:AI智勝未來,微信公眾號:AI智勝未來】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

國內生成式AI備案數量突破300款

三行代碼完成生成式AI部署

STAR AI進軍美股科技星智能領跑生成式AI賽道

生成式AI的基本原理和應用領域

聯發科聯合生態伙伴推出《生成式AI手機產業白皮書》,生成式AI手機發展路線明確了!

生成式AI推理技術、市場與未來

生成式AI推理技術、市場與未來

評論