NVIDIA推理平臺(tái)提高了AI推理性能,為零售、電信等行業(yè)節(jié)省了數(shù)百萬美元。

今年,各行各業(yè)的企業(yè)都在紛紛推出 AI 服務(wù)。對(duì)于微軟、Oracle、Perplexity、Snap 等數(shù)百家領(lǐng)先企業(yè)來說,使用 NVIDIA AI 推理平臺(tái)(由世界領(lǐng)先的芯片、系統(tǒng)和軟件組成的全堆棧)是實(shí)現(xiàn)高吞吐量、低延遲推理的關(guān)鍵,并且還能在降低成本的同時(shí)為用戶帶來卓越體驗(yàn)。

NVIDIA 憑借在推理軟件優(yōu)化和NVIDIA Hopper平臺(tái)方面所取得的進(jìn)步,正在幫助行業(yè)服務(wù)于最新的生成式 AI 模型,在提供出色的用戶體驗(yàn)的同時(shí),優(yōu)化總體擁有成本。與前幾代產(chǎn)品相比,Hopper 平臺(tái)還可幫助推理工作負(fù)載實(shí)現(xiàn)高達(dá) 15 倍的能效提升。

AI 推理的難度眾所周知,因?yàn)樗枰?jīng)過許多步驟,才能在吞吐量和用戶體驗(yàn)之間達(dá)成適當(dāng)?shù)钠胶狻?/p>

但其根本目標(biāo)很簡(jiǎn)單:以更低的成本生成更多的 token。Token 代表大語言模型 (LLM) 系統(tǒng)中的單詞,而 AI 推理服務(wù)通常按生成的每百萬個(gè) token 收費(fèi),這一目標(biāo)能夠給 AI 投資和每項(xiàng)任務(wù)所用能源帶來最顯著的回報(bào)。

全棧軟件優(yōu)化是提高 AI 推理性能和實(shí)現(xiàn)這一目標(biāo)的關(guān)鍵。

以經(jīng)濟(jì)的方式提高用戶吞吐量

企業(yè)經(jīng)常面臨著平衡推理工作負(fù)載性能與成本的挑戰(zhàn)。有些客戶或用例可以使用開箱即用的模型或托管模型,有些則可能需要使用定制模型。NVIDIA 技術(shù)可在簡(jiǎn)化模型部署的同時(shí),優(yōu)化 AI 推理工作負(fù)載的成本和性能。此外,客戶還可以體驗(yàn)到他們選擇部署的模型的靈活性和可定制性。

為了滿足用戶需求,NVIDIA 推出了NVIDIA NIM微服務(wù)、NVIDIA Triton推理服務(wù)器和NVIDIA TensorRT庫等推理解決方案:

NVIDIA NIM是一套用于部署 AI 模型的推理微服務(wù),是一套易于使用的預(yù)構(gòu)建容器工具,專為在一切基礎(chǔ)設(shè)施(云、數(shù)據(jù)中心、邊緣或工作站)上快速部署 AI 基礎(chǔ)模型。

NVIDIA Triton推理服務(wù)器是 NVIDIA 最受歡迎的開源項(xiàng)目之一,允許用戶將基于各類 AI 訓(xùn)練框架的模型封裝并提供服務(wù)。

NVIDIA TensorRT是一個(gè)包含運(yùn)行時(shí)和模型優(yōu)化工具的高性能深度學(xué)習(xí)推理庫,能夠?yàn)樯a(chǎn)級(jí)的應(yīng)用實(shí)現(xiàn)低延遲、高吞吐量的推理。

NVIDIA AI Enterprise軟件平臺(tái)包含以上所有解決方案,并提供企業(yè)級(jí)支持、穩(wěn)定性、易管理性和安全性,可通過各大主要云應(yīng)用市場(chǎng)獲取。

借助與框架無關(guān)的 NVIDIA AI 推理平臺(tái),企業(yè)可節(jié)省生產(chǎn)力、減少開發(fā)工作并降低基礎(chǔ)設(shè)施和設(shè)置成本。使用 NVIDIA 技術(shù)還能幫助企業(yè)避免停機(jī)和欺詐交易、提高電商購(gòu)物轉(zhuǎn)化率并開辟 AI 驅(qū)動(dòng)的新收入渠道,從而增加企業(yè)的收入。

云上 LLM 推理

為了簡(jiǎn)化大語言模型的部署,NVIDIA 與各大云服務(wù)提供商密切合作,以確保只需極少的代碼甚至無需代碼就能在云端無縫部署 NVIDIA 推理平臺(tái)。NVIDIA NIM 已經(jīng)與云原生服務(wù)集成,包括:

Amazon SageMaker AI、Amazon Bedrock Marketplace、Amazon Elastic Kubernetes Service

Google Cloud’s Vertex AI、Google Kubernetes Engine

Microsoft Azure AI Foundry 即將推出、Azure Kubernetes Service

Oracle Cloud Infrastructure 的數(shù)據(jù)科學(xué)工具,Oracle Cloud Infrastructure Kubernetes Engine

此外,為了實(shí)現(xiàn)定制化的推理部署,NVIDIA Triton 推理服務(wù)器已經(jīng)與各大云服務(wù)提供商深度集成。

例如在使用 OCI Data Science 平臺(tái)部署 NVIDIA Triton 時(shí),只需執(zhí)行像在模型部署期間打開命令行參數(shù)中的開關(guān)一樣簡(jiǎn)單的操作,就可以立即啟動(dòng) NVIDIA Triton 推理端點(diǎn)。

同樣,借助 Azure Machine Learning,用戶可以通過 Azure Machine Learning Studio 進(jìn)行 NVIDIA Triton 無代碼部署,也可以通過 Azure Machine Learning CLI 進(jìn)行全代碼部署。AWS 為 SageMaker Marketplace 中的 NVIDIA NIM 提供一鍵部署,Google Cloud 在 Google Kubernetes Engine (GKE) 上提供一鍵部署選項(xiàng)。AWS 在其 AWS 深度學(xué)習(xí)容器上提供 NVIDIA Triton。

NVIDIA AI 推理平臺(tái)還使用流行的通信方法來提供 AI 預(yù)測(cè),并通過自動(dòng)調(diào)整來滿足基于云的基礎(chǔ)架構(gòu)中不斷增長(zhǎng)和變化的用戶需求。

從加速 LLM 到改進(jìn)創(chuàng)意工作流和改變協(xié)議管理,NVIDIA 的 AI 推理平臺(tái)正在各個(gè)行業(yè)產(chǎn)生實(shí)際的影響。以下企業(yè)通過合作與創(chuàng)新將效率和可擴(kuò)展性提升到新的水平。

與 Perplexity AI 的合作:

每月處理 4 億次搜索查詢

Perplexity AI 是一款 AI 搜索引擎,每月處理的查詢超過 4.35 億次,而且每次查詢都包含多個(gè) AI 推理請(qǐng)求。為了滿足這一需求,Perplexity AI 團(tuán)隊(duì)開始使用 NVIDIA Hopper GPU、Triton 推理服務(wù)器和 TensorRT-LLM。

Perplexity 支持 20 多個(gè) AI 模型,包括 8B、70B 等 Llama 3 變體,能夠處理搜索、摘要和問題解答等各種任務(wù)。通過使用較小的分類器模型將任務(wù)分流到 NVIDIA Triton 管理的各個(gè) GPU pod,該公司在嚴(yán)格的服務(wù)水平協(xié)議下提供了經(jīng)濟(jì)高效、響應(yīng)迅速的服務(wù)。

通過模型并行技術(shù)(將 LLM 分配到各個(gè) GPU 上),Perplexity 在保持低延遲和高準(zhǔn)確性的同時(shí),將成本降低至原來的三分之一。這一最佳實(shí)踐框架展示了 IT 團(tuán)隊(duì)如何借助 NVIDIA 加速計(jì)算滿足日益增長(zhǎng)的 AI 需求、降低總體擁有成本并實(shí)現(xiàn)無縫擴(kuò)展。

使用 Recurrent Drafter (ReDrafter)

縮短響應(yīng)時(shí)間

開源研究的進(jìn)步正在幫助實(shí)現(xiàn) AI 推理的民主化。最近,NVIDIA 將 Apple 發(fā)布的推測(cè)解碼開源方法 Redrafter 整合到 NVIDIA TensorRT-LLM 中。

ReDrafter 先使用較小的“draft”模塊并行預(yù)測(cè) token,然后由主模型對(duì) token 進(jìn)行驗(yàn)證。這項(xiàng)技術(shù)大大縮短了 LLM 的響應(yīng)時(shí)間,尤其是在低流量期間。

與 Docusign 的合作:

改變協(xié)議管理

數(shù)字協(xié)議管理領(lǐng)域的領(lǐng)先企業(yè) Docusign 借助 NVIDIA 為其智能協(xié)議管理平臺(tái)提供超強(qiáng)助力。Docusign 在全球擁有超過 150 萬客戶,該公司需要在優(yōu)化吞吐量和管理基礎(chǔ)設(shè)施支出的同時(shí),提供 AI 驅(qū)動(dòng)的洞察。

NVIDIA Triton 提供了一個(gè)適用于所有框架的統(tǒng)一推理平臺(tái),通過將協(xié)議數(shù)據(jù)轉(zhuǎn)換成可操作的洞察,加快產(chǎn)品上市時(shí)間并提高生產(chǎn)力。Docusign 使用 NVIDIA 推理平臺(tái)突顯出可擴(kuò)展的 AI 基礎(chǔ)設(shè)施對(duì)客戶體驗(yàn)和運(yùn)營(yíng)效率所產(chǎn)生的積極影響。

Docusign 高級(jí)產(chǎn)品經(jīng)理 Alex Zakhvatov 表示:“NVIDIA Triton 讓我們的生活變得更加輕松。我們不再需要為 AI 模型部署特定框架的定制推理服務(wù)器,而是可以將 Triton 作為所有 AI 框架的統(tǒng)一推理服務(wù)器,并使用它來確定正確的生產(chǎn)場(chǎng)景,以此優(yōu)化降低成本和節(jié)省性能的工程項(xiàng)目。”

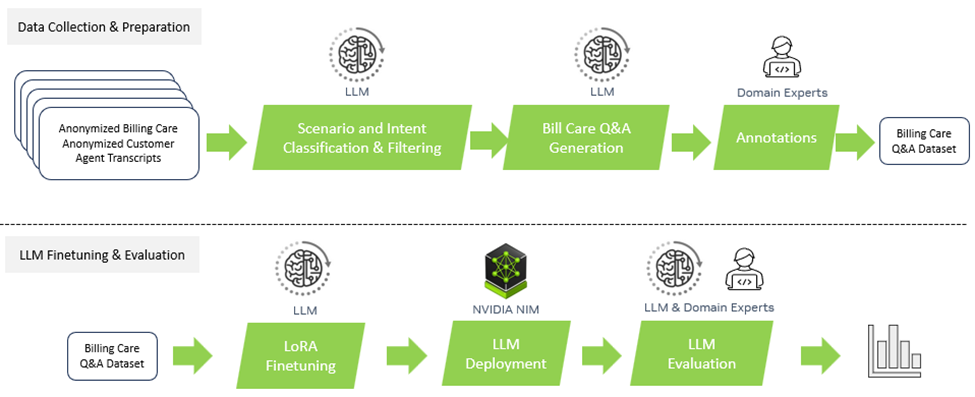

與 Amdocs 的合作:

提升電信行業(yè)的客戶服務(wù)

Amdocs 是一家為通信和媒體服務(wù)商提供軟件和服務(wù)的領(lǐng)先供應(yīng)商,該公司為電信企業(yè)構(gòu)建的特定領(lǐng)域生成式 AI 平臺(tái) amAIz 是一個(gè)開放、安全、經(jīng)濟(jì)且與 LLM 無關(guān)的框架。Amdocs 正在使用NVIDIA DGX Cloud和 NVIDIA AI Enterprise 軟件提供基于商用 LLM 和領(lǐng)域適配模型的解決方案,使服務(wù)提供商能夠構(gòu)建和部署企業(yè)級(jí)生成式 AI 應(yīng)用。

通過使用 NVIDIA NIM,Amdocs 部署的用例在數(shù)據(jù)預(yù)處理和推理中消耗的 token 數(shù)量分別減少了 60% 和 40%,并根據(jù)不同的因素和使用量,在保證準(zhǔn)確性不變的前提下大幅降低了單位 token 的成本。雙方還一同將查詢延遲降低了約 80%,確保終端用戶體驗(yàn)到接近實(shí)時(shí)的響應(yīng)。這一加速提升了用戶在商務(wù)、客服、運(yùn)營(yíng)等方面的體驗(yàn)。

與 Snap 的合作:

利用 AI 革新零售業(yè)態(tài)

Snap 的 Screenshop 功能讓購(gòu)買完美服裝變得空前簡(jiǎn)單。這款由 AI 驅(qū)動(dòng)的工具集成在 Snapchat 中,可幫助用戶找到照片中的時(shí)尚單品。NVIDIA Triton 在實(shí)現(xiàn) Screenshop 的流程方面發(fā)揮著關(guān)鍵作用,該流程使用包括 TensorFlow 和 PyTorch 在內(nèi)的多個(gè)框架來處理圖像。

Snap 的 Screenshop AI 工作流

Snap 將其流程整合到一個(gè)推理服務(wù)平臺(tái)上,大大減少了開發(fā)時(shí)間和成本,同時(shí)還能夠無縫部署更新后的模型,實(shí)現(xiàn)了 AI 驅(qū)動(dòng)的順暢用戶體驗(yàn)。

Snap 的機(jī)器學(xué)習(xí)工程師 Ke Ma 解釋道:“我們不想為我們的 Screenshop 流程部署定制推理服務(wù)平臺(tái),也不想分別為 TensorFlow 和 PyTorch 部署 TF 服務(wù)平臺(tái)和 TorchServe 平臺(tái)。Triton 采用了與框架無關(guān)的設(shè)計(jì)并支持 TensorFlow、PyTorch 和 ONNX 等多種后端,對(duì)我們來說非常具有吸引力。借助它,我們只需要使用一個(gè)推理服務(wù)平臺(tái)就能提供我們的端到端流程。這既降低了我們的推理服務(wù)成本,又減少了開發(fā)者在生產(chǎn)中更新模型所需的天數(shù)。”

在 NVIDIA Triton 上成功推出 Screenshop 服務(wù)之后,Ma 和他的團(tuán)隊(duì)開始使用 NVIDIA TensorRT 來進(jìn)一步提高系統(tǒng)性能。在編譯過程中應(yīng)用 NVIDIA TensorRT 默認(rèn)設(shè)置后,Screenshop 團(tuán)隊(duì)看到吞吐量立刻激增了 3 倍,成本預(yù)計(jì)降低了 66%。

與 Wealthsimple 的合作:

借助 AI 實(shí)現(xiàn)財(cái)務(wù)自由

Wealthsimple是一家資產(chǎn)管理規(guī)模超過300億加元的加拿大投資平臺(tái)。該公司使用 NVIDIA AI 推理平臺(tái)重新定義了其機(jī)器學(xué)習(xí)方法。通過將基礎(chǔ)設(shè)施標(biāo)準(zhǔn)化,Wealthsimple 將模型交付時(shí)間從原來的數(shù)月縮短至 15 分鐘以內(nèi),不僅徹底避免了停機(jī)時(shí)間,還能夠讓團(tuán)隊(duì)以服務(wù)的形式提供機(jī)器學(xué)習(xí)。

通過使用 NVIDIA Triton 并在 AWS 上運(yùn)行其模型,Wealthsimple 的正常運(yùn)行時(shí)間達(dá)到 99.999%,確保了對(duì)每年超過 1.45 億筆交易作出無縫預(yù)測(cè)。該轉(zhuǎn)變充分展現(xiàn)出強(qiáng)大的 AI 基礎(chǔ)設(shè)施為金融服務(wù)帶來變革。

Wealthsimple 高級(jí)軟件開發(fā)經(jīng)理 Mandy Gu 表示:“NVIDIA 的 AI 推理平臺(tái)一直是我們公司在 ML 領(lǐng)域取得成功的關(guān)鍵。它徹底改變了我們的模型部署方式,減少了停機(jī)時(shí)間,使我們能夠?yàn)榭蛻籼峁o與倫比的服務(wù)。”

與 Let's Enhance 的合作:

提升創(chuàng)意工作流

AI 驅(qū)動(dòng)的圖像生成改變了創(chuàng)意工作流并且可以應(yīng)用于企業(yè)用例,例如為營(yíng)銷視覺效果創(chuàng)建個(gè)性化內(nèi)容和富有想象力的背景等。雖然擴(kuò)散模型是改進(jìn)創(chuàng)意工作流的強(qiáng)大工具,但這些模型的計(jì)算成本很高。

為了在生產(chǎn)中使用 Stable Diffusion XL 模型優(yōu)化工作流,領(lǐng)先的 AI 初創(chuàng)公司 Let’s Enhance 選擇了 NVIDIA AI 推理平臺(tái)。

使用 SDXL 驅(qū)動(dòng)的 Let's Enhance 平臺(tái)創(chuàng)建的

帶有背景的產(chǎn)品圖片

Let's Enhance 的最新產(chǎn)品 AI Photoshoot 使用 SDXL 模型將普通產(chǎn)品照片轉(zhuǎn)換成適用于電商網(wǎng)站和營(yíng)銷活動(dòng)的精美視覺資產(chǎn)。

借助 NVIDIA Triton 對(duì)各種框架和后端的強(qiáng)大支持及其動(dòng)態(tài)批處理功能集,Let's Enhance 能夠?qū)?SDXL 模型無縫集成到現(xiàn)有的 AI 管線中并最大程度地減少工程團(tuán)隊(duì)的參與,使他們能夠騰出時(shí)間進(jìn)行研發(fā)工作。

與 OCI 的合作:

加速云端視覺 AI

為驅(qū)動(dòng)其視覺 AI 服務(wù),Oracle Cloud Infrastructure (OCI)集成了 NVIDIA Triton,將預(yù)測(cè)吞吐量提高了 76%,并將延遲降低了 51%。這些優(yōu)化提升了客戶的應(yīng)用體驗(yàn),包括為交通機(jī)構(gòu)實(shí)現(xiàn)收費(fèi)自動(dòng)化、為全球企業(yè)簡(jiǎn)化發(fā)票識(shí)別等。

憑借 Triton 與硬件無關(guān)的功能,OCI 擴(kuò)展了自己的 AI 服務(wù)組合,通過其全球數(shù)據(jù)中心為客戶提供了強(qiáng)大而高效的解決方案。

負(fù)責(zé)為 Oracle 內(nèi)部和外部用戶處理機(jī)器學(xué)習(xí)的 OCI 數(shù)據(jù)科學(xué)服務(wù)產(chǎn)品管理總監(jiān) Tzvi Keisar 表示:“我們的 AI 平臺(tái)具有 Triton 感知能力,能夠?yàn)槲覀兊目蛻魟?chuàng)造效益。”

與微軟的合作:

提高實(shí)時(shí)上下文智能水平和搜索效率

Azure 提供了最廣泛的 NVIDIA AI 驅(qū)動(dòng)和優(yōu)化的虛擬機(jī)。這些虛擬機(jī)涵蓋多代 NVIDIA GPU,包括 NVIDIA Blackwell 和 NVIDIA Hopper 系統(tǒng)。

在這一深厚的工程合作歷史基礎(chǔ)上,NVIDIA GPU 和 NVIDIA Triton 目前幫助加速 Microsoft 365 Copilot 中的 AI 推理。作為 Windows PC 上的專用物理鍵盤鍵,Microsoft 365 Copilot 將大語言模型的強(qiáng)大功能與企業(yè)專有數(shù)據(jù)相結(jié)合,為用戶提供了提高創(chuàng)造力、生產(chǎn)力和技能的實(shí)時(shí)上下文智能。

微軟必應(yīng) (Bing) 還使用 NVIDIA 推理解決方案應(yīng)對(duì)延遲、成本和速度等挑戰(zhàn)。通過集成 NVIDIA TensorRT-LLM 技術(shù),微軟極大提高了其深度搜索功能的推理性能,進(jìn)一步優(yōu)化了網(wǎng)頁搜索結(jié)果。

深度搜索演示由微軟提供

微軟必應(yīng)視覺搜索使世界各地的人們能夠通過照片查找內(nèi)容。該功能的核心是微軟的 TuringMM 視覺嵌入模型,該模型將圖像和文本映射到一個(gè)共享的高維空間。該模型需要處理全網(wǎng)數(shù)十億張圖片,因此性能至關(guān)重要。

微軟必應(yīng)使用NVIDIA TensorRT 和 NVIDIA 加速庫 (包括CV-CUDA和nvImageCodec) 對(duì) TuringMM 流程進(jìn)行了優(yōu)化,使速度提高了 5.13 倍,并且顯著降低了總體擁有成本。

通過硬件創(chuàng)新解鎖 AI 推理的全部潛力

提高 AI 推理工作負(fù)載的效率是一項(xiàng)涉及多個(gè)方面的挑戰(zhàn),需要同時(shí)在軟硬件領(lǐng)域進(jìn)行技術(shù)創(chuàng)新才能實(shí)現(xiàn)。

NVIDIA GPU 處于 AI 賦能的前沿領(lǐng)域,為 AI 模型提供高效率和高性能,而且是節(jié)能的 GPU:基于 NVIDIA Blackwell 架構(gòu)的 NVIDIA 加速計(jì)算將萬億參數(shù) AI 模型推理工作的單位 token 生成能耗降低至過去十年的十萬分之一。

NVIDIA Grace Hopper超級(jí)芯片使用 NVIDIA NVLink-C2C 將 NVIDIA Grace CPU 和 Hopper GPU 架構(gòu)相結(jié)合,為各個(gè)行業(yè)帶來了顯著的推理性能提升。

利用 Meta Andromeda 行業(yè)領(lǐng)先的

機(jī)器學(xué)習(xí)釋放廣告商價(jià)值

Meta Andromeda 正在使用這款超級(jí)芯片實(shí)現(xiàn)高效率、高性能的個(gè)性化廣告檢索。通過創(chuàng)建具有更高計(jì)算復(fù)雜性和并行性的深度神經(jīng)網(wǎng)絡(luò),它在 Facebook 和 Instagram 上實(shí)現(xiàn)了特定細(xì)分市場(chǎng) 8% 的廣告質(zhì)量提升和 6% 的召回率提升。

憑借經(jīng)過優(yōu)化的檢索模型以及具有低延遲、高吞吐量和顯存 IO 感知能力的 GPU 運(yùn)算器,Andromeda 的特征提取速度比之前基于 CPU 的組件提高了 100 倍。Meta 這種在檢索階段集成 AI 的方式在廣告檢索領(lǐng)域處于領(lǐng)先地位,解決了可擴(kuò)展性和延遲等難題,為用戶帶來了更好的體驗(yàn)和更高的廣告投資回報(bào)。

隨著前沿 AI 模型規(guī)模的不斷擴(kuò)大,生成每個(gè) token 所需的計(jì)算量也在增加。為了實(shí)時(shí)運(yùn)行最先進(jìn)的 LLM,企業(yè)需要多個(gè) GPU 協(xié)同工作。NVIDIA 集合通信庫 (NCCL) 等工具能夠讓多 GPU 系統(tǒng)以最短的通信時(shí)間在 GPU 之間快速交換大量數(shù)據(jù)。

未來的 AI 推理創(chuàng)新

未來的 AI 推理有望大幅提高性能并降低成本。

通過結(jié)合 NVIDIA 的軟件、新技術(shù)和先進(jìn)硬件,數(shù)據(jù)中心將能夠處理日益復(fù)雜和多樣化的工作負(fù)載。憑借更準(zhǔn)確的預(yù)測(cè)、更快的決策和更好的用戶體驗(yàn),AI 推理將繼續(xù)推動(dòng)醫(yī)療、金融等行業(yè)的進(jìn)步。

隨著這些趨勢(shì)的不斷發(fā)展,企業(yè)必須與時(shí)俱進(jìn),使用最新推理優(yōu)化來最大程度地發(fā)揮投資的作用,才能在 AI 時(shí)代保持競(jìng)爭(zhēng)力。

-

NVIDIA

+關(guān)注

關(guān)注

14文章

5140瀏覽量

104683 -

AI

+關(guān)注

關(guān)注

87文章

32677瀏覽量

272038 -

微服務(wù)

+關(guān)注

關(guān)注

0文章

143瀏覽量

7526

原文標(biāo)題:AI 盈利的關(guān)鍵:快速、低成本的推理

文章出處:【微信號(hào):NVIDIA-Enterprise,微信公眾號(hào):NVIDIA英偉達(dá)企業(yè)解決方案】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

AI推理的存儲(chǔ),看好SRAM?

英偉達(dá)GTC2025亮點(diǎn):Oracle與NVIDIA合作助力企業(yè)加速代理式AI推理

英偉達(dá)GTC25亮點(diǎn):NVIDIA Blackwell Ultra 開啟 AI 推理新時(shí)代

英偉達(dá)GTC25亮點(diǎn):NVIDIA Dynamo開源庫加速并擴(kuò)展AI推理模型

Oracle 與 NVIDIA 合作助力企業(yè)加速代理式 AI 推理

NVIDIA 推出開放推理 AI 模型系列,助力開發(fā)者和企業(yè)構(gòu)建代理式 AI 平臺(tái)

探討DeepSeek-R1滿血版的推理部署與優(yōu)化策略

解鎖NVIDIA TensorRT-LLM的卓越性能

NVIDIA助力麗蟾科技打造AI訓(xùn)練與推理加速解決方案

開箱即用,AISBench測(cè)試展示英特爾至強(qiáng)處理器的卓越推理性能

魔搭社區(qū)借助NVIDIA TensorRT-LLM提升LLM推理效率

英偉達(dá)推出全新NVIDIA AI Foundry服務(wù)和NVIDIA NIM推理微服務(wù)

英偉達(dá)推出AI模型推理服務(wù)NVIDIA NIM

利用NVIDIA組件提升GPU推理的吞吐

自然語言處理應(yīng)用LLM推理優(yōu)化綜述

評(píng)論