春節期間突然被DeepSeek刷屏了,這熱度是真大,到處都是新聞和本地部署的教程,等熱度過了過,簡單記錄下自己本地部署及相關的內容,就當電子寵物,沒事喂一喂:D,不過有能力的還是閱讀論文和部署完整版的進一步使用。

論文鏈接:https://github.com/deepseek-ai/DeepSeek-R1/blob/main/DeepSeek_R1.pdf

1|0一、什么是 DeepSeek R1

2025.01.20 DeepSeek-R1 發布,DeepSeek R1 是 DeepSeek AI 開發的第一代推理模型,擅長復雜的推理任務,官方對標OpenAI o1正式版。適用于多種復雜任務,如數學推理、代碼生成和邏輯推理等。

DeepSeek-R1 發布的新聞:https://api-docs.deepseek.com/zh-cn/news/news250120

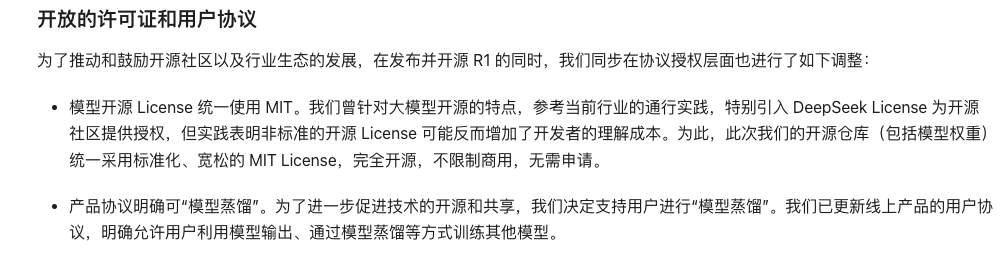

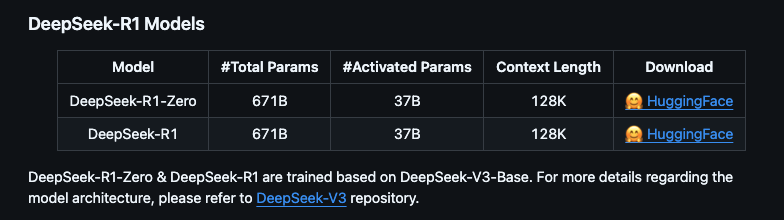

根據官方信息DeepSeek R1 可以看到提供多個版本,包括完整版(671B 參數)和蒸餾版(1.5B 到 70B 參數)。完整版性能強大,但需要極高的硬件配置;蒸餾版則更適合普通用戶,硬件要求較低

DeepSeek-R1官方地址:https://github.com/deepseek-ai/DeepSeek-R1

完整版(671B):需要至少 350GB 顯存/內存,適合專業服務器部署

蒸餾版:基于開源模型(如 QWEN 和 LLAMA)微調,參數量從 1.5B 到 70B 不等,適合本地硬件部署。

蒸餾版與完整版的區別

| 特性 | 蒸餾版 | 完整版 |

|---|---|---|

| 參數量 | 參數量較少(如 1.5B、7B),性能接近完整版但略有下降。 | 參數量較大(如 32B、70B),性能最強。 |

| 硬件需求 | 顯存和內存需求較低,適合低配硬件。 | 顯存和內存需求較高,需高端硬件支持。 |

| 適用場景 | 適合輕量級任務和資源有限的設備。 | 適合高精度任務和專業場景。 |

這里我們詳細看下蒸餾版模型的特點

| 模型版本 | 參數量 | 特點 |

|---|---|---|

| deepseek-r1:1.5b | 1.5B | 輕量級模型,適合低配硬件,性能有限但運行速度快 |

| deepseek-r1:7b | 7B | 平衡型模型,適合大多數任務,性能較好且硬件需求適中。 |

| deepseek-r1:8b | 8B | 略高于 7B 模型,性能稍強,適合需要更高精度的場景。 |

| deepseek-r1:14b | 14B | 高性能模型,適合復雜任務(如數學推理、代碼生成),硬件需求較高。 |

| deepseek-r1:32b | 32B | 專業級模型,性能強大,適合研究和高精度任務,需高端硬件支持。 |

| deepseek-r1:70b | 70B | 頂級模型,性能最強,適合大規模計算和高復雜度任務,需專業級硬件支持。 |

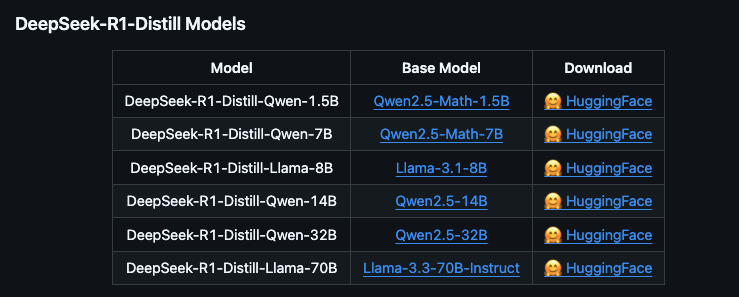

進一步的模型細分還分為量化版

| 模型版本 | 參數量 | 特點 |

|---|---|---|

| deepseek-r1:1.5b-qwen-distill-q4_K_M | 1.5B | 輕量級模型,適合低配硬件,性能有限但運行速度快 |

| deepseek-r1:7b-qwen-distill-q4_K_M | 7B | 平衡型模型,適合大多數任務,性能較好且硬件需求適中。 |

| deepseek-r1:8b-llama-distill-q4_K_M | 8B | 略高于 7B 模型,性能稍強,適合需要更高精度的場景。 |

| deepseek-r1:14b-qwen-distill-q4_K_M | 14B | 高性能模型,適合復雜任務(如數學推理、代碼生成),硬件需求較高。 |

| deepseek-r1:32b-qwen-distill-q4_K_M | 32B | 專業級模型,性能強大,適合研究和高精度任務,需高端硬件支持。 |

| deepseek-r1:70b-llama-distill-q4_K_M | 70B | 頂級模型,性能最強,適合大規模計算和高復雜度任務,需專業級硬件支持。 |

蒸餾版與量化版

| 模型類型 | 特點 |

|---|---|

| 蒸餾版 | 基于大模型(如 QWEN 或 LLAMA)微調,參數量減少但性能接近原版,適合低配硬件。 |

| 量化版 | 通過降低模型精度(如 4-bit 量化)減少顯存占用,適合資源有限的設備。 |

例如:

deepseek-r1:7b-qwen-distill-q4_K_M:7B 模型的蒸餾+量化版本,顯存需求從 5GB 降至 3GB。

deepseek-r1:32b-qwen-distill-q4_K_M:32B 模型的蒸餾+量化版本,顯存需求從 22GB 降至 16GB

我們正常本地部署使用蒸餾版就可以

2|0二、型號和硬件要求

2|12.1硬件配置說明

Windows 配置:

最低要求:NVIDIA GTX 1650 4GB 或 AMD RX 5500 4GB,16GB 內存,50GB 存儲空間

推薦配置:NVIDIA RTX 3060 12GB 或 AMD RX 6700 10GB,32GB 內存,100GB NVMe SSD

高性能配置:NVIDIA RTX 3090 24GB 或 AMD RX 7900 XTX 24GB,64GB 內存,200GB NVMe SSD

Linux 配置:

最低要求:NVIDIA GTX 1660 6GB 或 AMD RX 5500 4GB,16GB 內存,50GB 存儲空間

推薦配置:NVIDIA RTX 3060 12GB 或 AMD RX 6700 10GB,32GB 內存,100GB NVMe SSD

高性能配置:NVIDIA A100 40GB 或 AMD MI250X 128GB,128GB 內存,200GB NVMe SSD

Mac 配置:

最低要求:M2 MacBook Air(8GB 內存)

推薦配置:M2/M3 MacBook Pro(16GB 內存)

高性能配置:M2 Max/Ultra Mac Studio(64GB 內存)

可根據下表配置選擇使用自己的模型

| 模型名稱 | 參數量 | 大小 | VRAM (Approx.) | 推薦 Mac 配置 | 推薦 Windows/Linux 配置 |

|---|---|---|---|---|---|

| deepseek-r1:1.5b | 1.5B | 1.1 GB | ~2 GB | M2/M3 MacBook Air (8GB RAM+) | NVIDIA GTX 1650 4GB / AMD RX 5500 4GB (16GB RAM+) |

| deepseek-r1:7b | 7B | 4.7 GB | ~5 GB | M2/M3/M4 MacBook Pro (16GB RAM+) | NVIDIA RTX 3060 8GB / AMD RX 6600 8GB (16GB RAM+) |

| deepseek-r1:8b | 8B | 4.9 GB | ~6 GB | M2/M3/M4 MacBook Pro (16GB RAM+) | NVIDIA RTX 3060 Ti 8GB / AMD RX 6700 10GB (16GB RAM+) |

| deepseek-r1:14b | 14B | 9.0 GB | ~10 GB | M2/M3/M4 Pro MacBook Pro (32GB RAM+) | NVIDIA RTX 3080 10GB / AMD RX 6800 16GB (32GB RAM+) |

| deepseek-r1:32b | 32B | 20 GB | ~22 GB | M2 Max/Ultra Mac Studio | NVIDIA RTX 3090 24GB / AMD RX 7900 XTX 24GB (64GB RAM+) |

| deepseek-r1:70b | 70B | 43 GB | ~45 GB | M2 Ultra Mac Studio | NVIDIA A100 40GB / AMD MI250X 128GB (128GB RAM+) |

| deepseek-r1:1.5b-qwen-distill-q4_K_M | 1.5B | 1.1 GB | ~2 GB | M2/M3 MacBook Air (8GB RAM+) | NVIDIA GTX 1650 4GB / AMD RX 5500 4GB (16GB RAM+) |

| deepseek-r1:7b-qwen-distill-q4_K_M | 7B | 4.7 GB | ~5 GB | M2/M3/M4 MacBook Pro (16GB RAM+) | NVIDIA RTX 3060 8GB / AMD RX 6600 8GB (16GB RAM+) |

| deepseek-r1:8b-llama-distill-q4_K_M | 8B | 4.9 GB | ~6 GB | M2/M3/M4 MacBook Pro (16GB RAM+) | NVIDIA RTX 3060 Ti 8GB / AMD RX 6700 10GB (16GB RAM+) |

| deepseek-r1:14b-qwen-distill-q4_K_M | 14B | 9.0 GB | ~10 GB | M2/M3/M4 Pro MacBook Pro (32GB RAM+) | NVIDIA RTX 3080 10GB / AMD RX 6800 16GB (32GB RAM+) |

| deepseek-r1:32b-qwen-distill-q4_K_M | 32B | 20 GB | ~22 GB | M2 Max/Ultra Mac Studio | NVIDIA RTX 3090 24GB / AMD RX 7900 XTX 24GB (64GB RAM+) |

| deepseek-r1:70b-llama-distill-q4_K_M | 70B | 43 GB | ~45 GB | M2 Ultra Mac Studio | NVIDIA A100 40GB / AMD MI250X 128GB (128GB RAM+) |

3|0三、本地安裝 DeepSeek R1

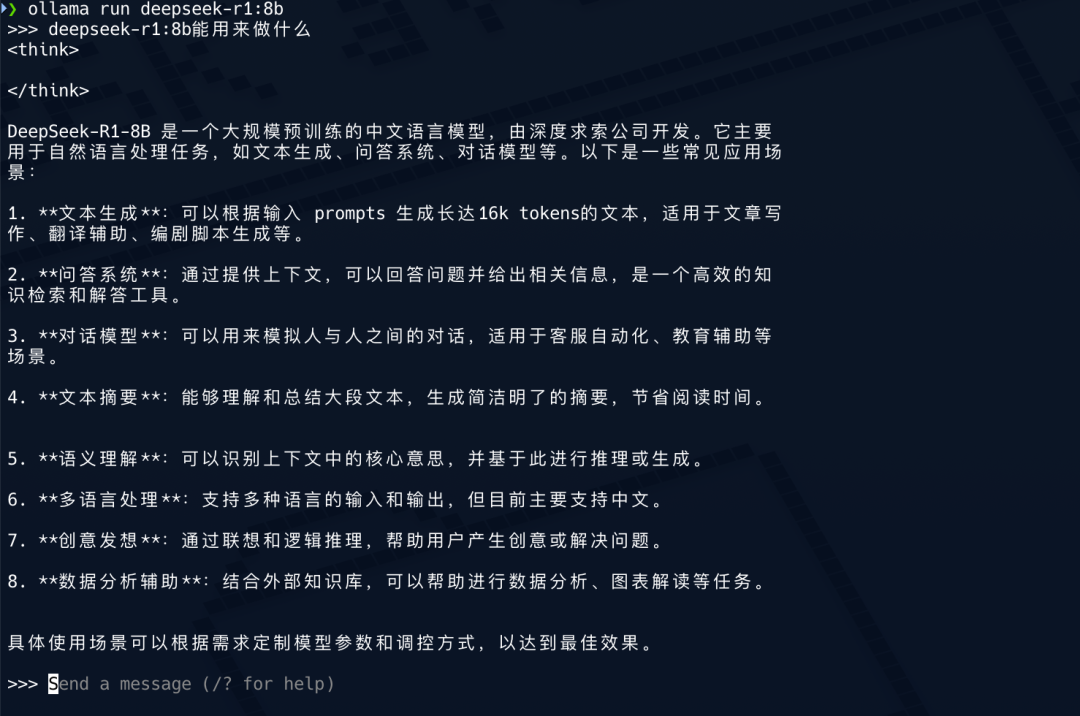

我這里的演示的本地環境:

機器:M2/M3/M4 MacBook Pro (16GB RAM+)

模型:deepseek-r1:8b

簡單說下在本地運行的好處

隱私:您的數據保存在本地的設備上,不會通過外部服務器

離線使用:下載模型后無需互聯網連接

經濟高效:無 API 成本或使用限制

低延遲:直接訪問,無網絡延遲

自定義:完全控制模型參數和設置

之后如果有Windows/Linux的場景需要在后續進行更新。

3|13.1部署工具

部署可以使用Ollama、LM Studio、Docker等進行部署

Ollama:

本地大模型管理框架,Ollama 讓用戶能夠在本地環境中高效地部署和使用語言模型,而無需依賴云服務

支持 Windows、Linux 和 Mac 系統,提供命令行和 Docker 部署方式

使用命令ollama run deepseek-r1:7b下載并運行模型

LM Studio:

LM Studio 是一個桌面應用程序,它提供了一個用戶友好的界面,允許用戶輕松下載、加載和運行各種語言模型(如 LLaMA、GPT 等)

支持 Windows 和 Mac,提供可視化界面,適合新手用戶

Docker:

支持 Linux 和 Windows,適合高級用戶。

使用命令docker run -d --gpus=all -p 11434:11434 --name ollama ollama/ollama啟動容器。

由于需要本地化部署語言模型的場景,對數據隱私和自定義或擴展語言模型功能有較高要求,我們這里使用Ollama來進行本地部署運行

如果只有集顯也想試試玩,可以試試下載LM Studio軟件,更適應新手,如果有需要后續更新

3|23.2 安裝 ollama

官方地址:https://ollama.com/

選擇自己的系統版本進行下載

安裝完成

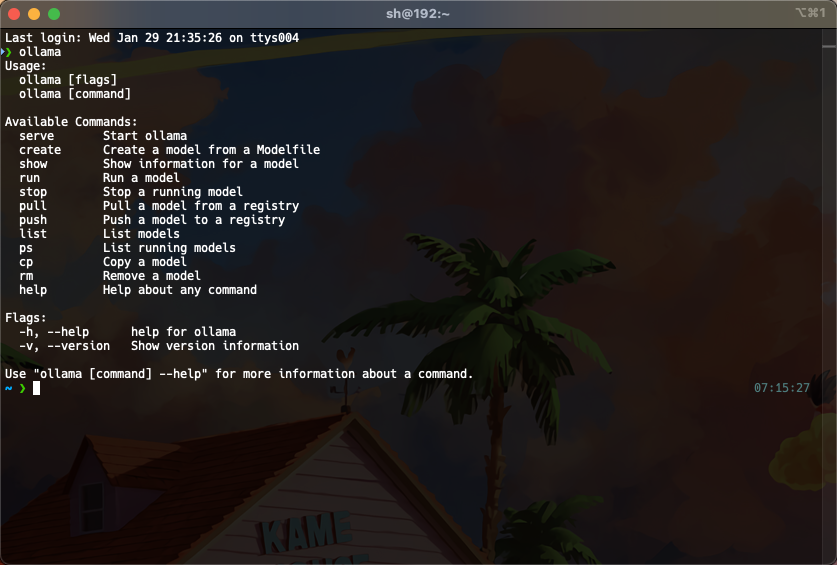

控制臺驗證是否成功安裝

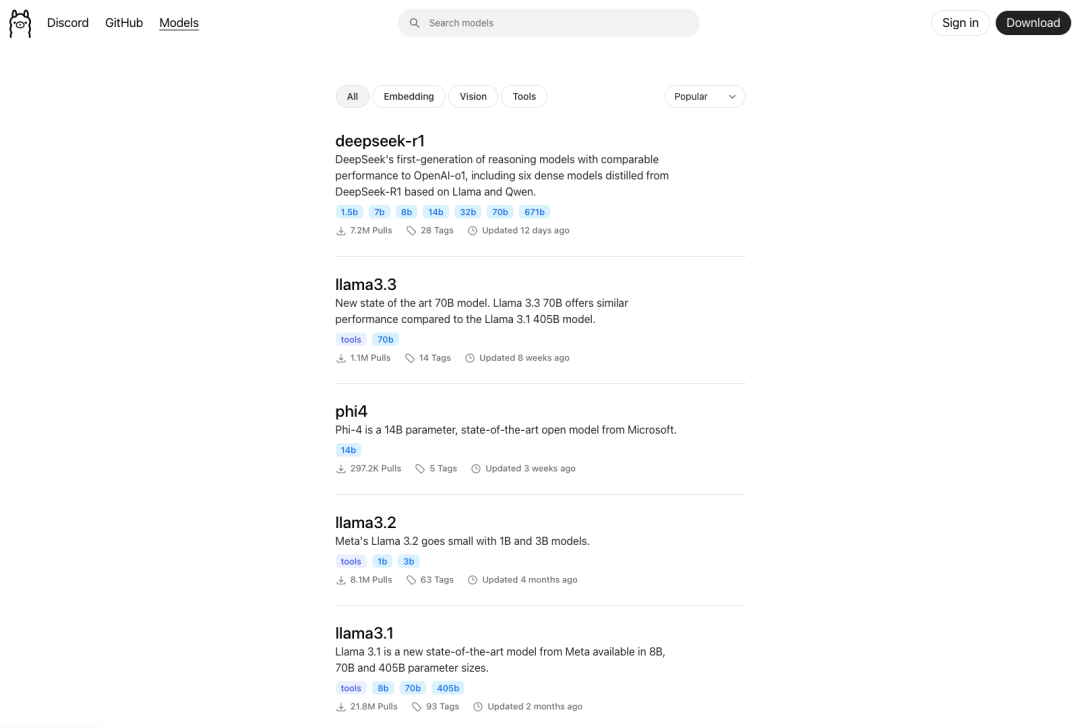

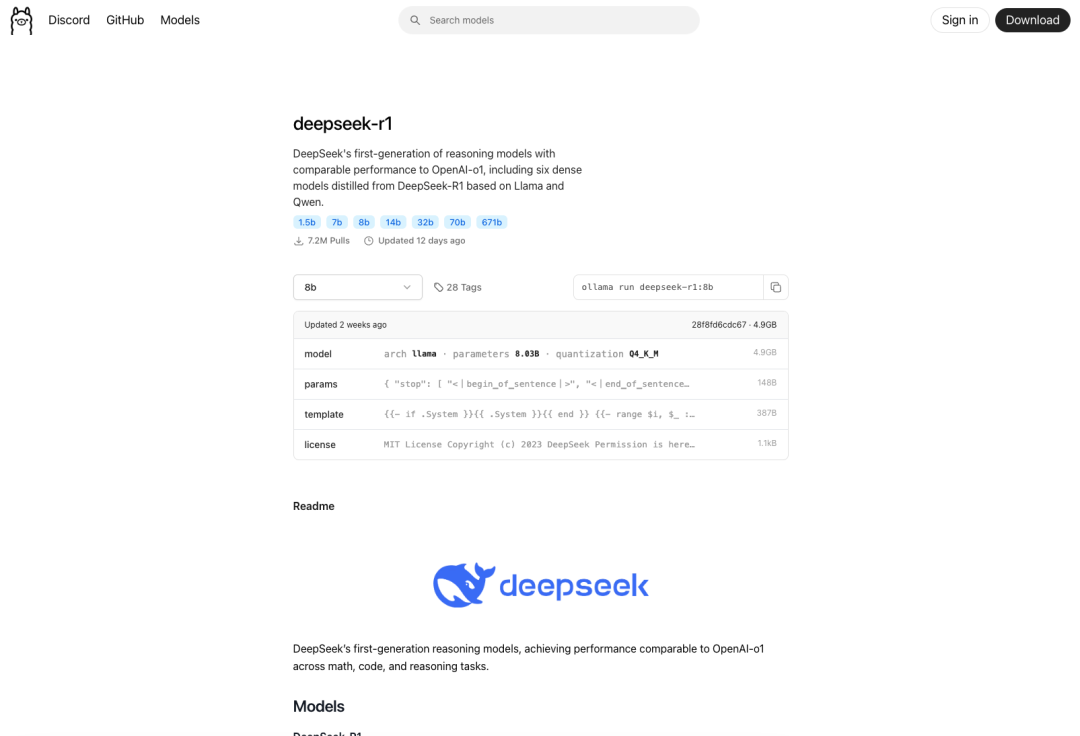

我們再回到ollama官網選擇模型,選擇需要的模型復制命令進行安裝

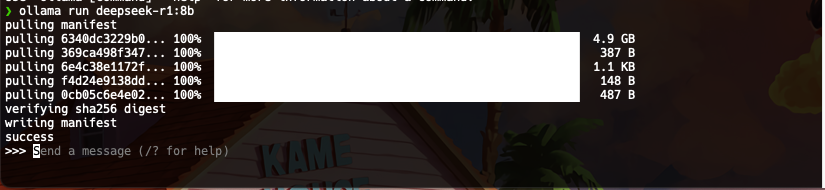

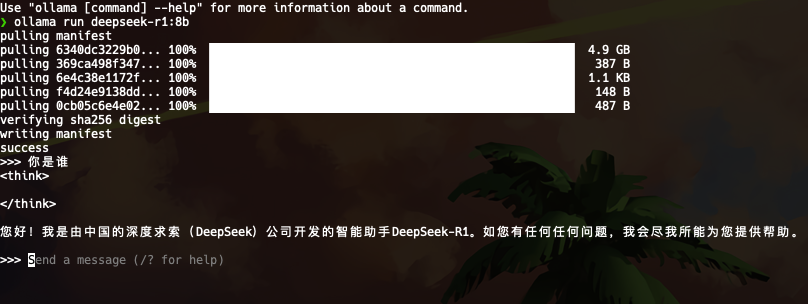

可以看到安裝完成

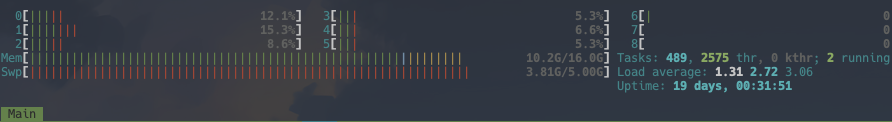

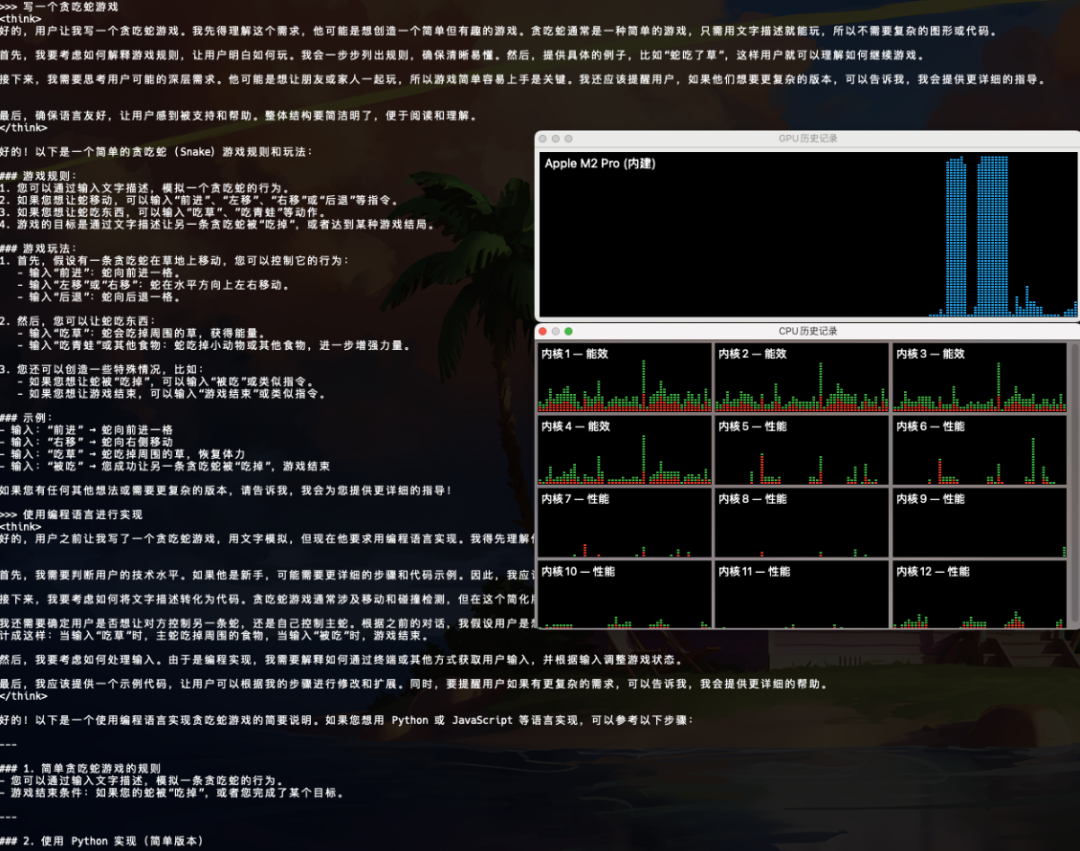

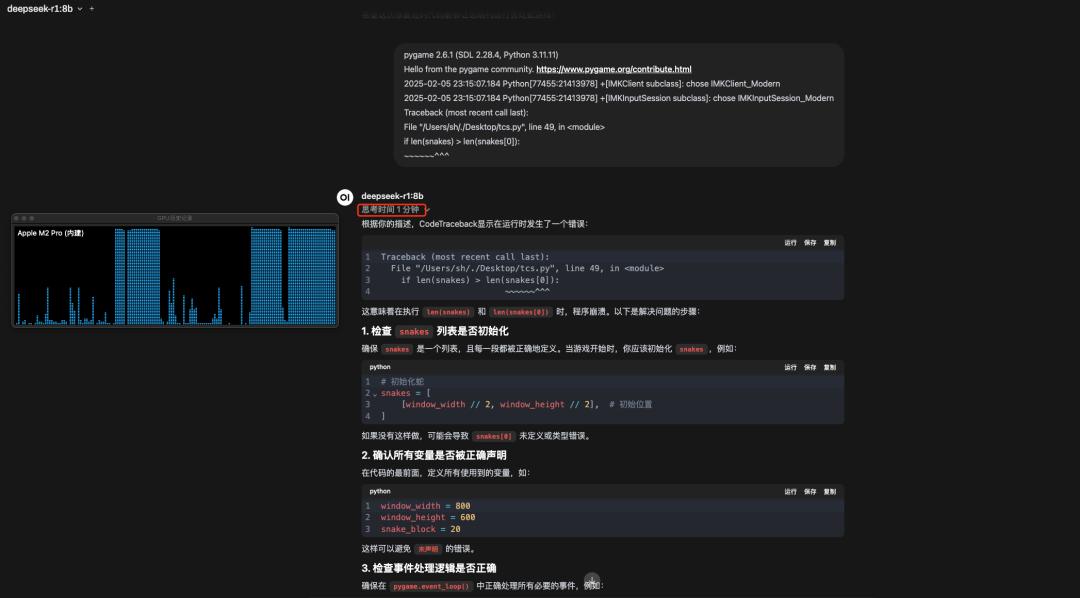

簡單思考下,使用過程中的硬件使用率,GPU飽和,其他使用率不是很高,速度也很快

4|0四、可視化界面

這里介紹下Open-WebUI和Dify

Open-WebUI是一款自托管 LLM Web 界面,提供 Web UI 與大模型交互,僅提供 Web UI,不提供 API,適用于個人使用 LLM以及本地運行大模型

Dify是LLM 應用開發平臺,不完全是可視化界面,可以快速構建 LLM 應用(RAG、AI 代理等),提供 API,可用于應用集成,支持 MongoDB、PostgreSQL 存儲 LLM 相關數據, AI SaaS、應用開發,需要構建智能客服、RAG 應用等

4|14.1 Open-WebUI

Open-WebUI官方地址:https://github.com/open-webui/open-webui

Open-WebUI官方文檔地址:https://docs.openwebui.com/getting-started/

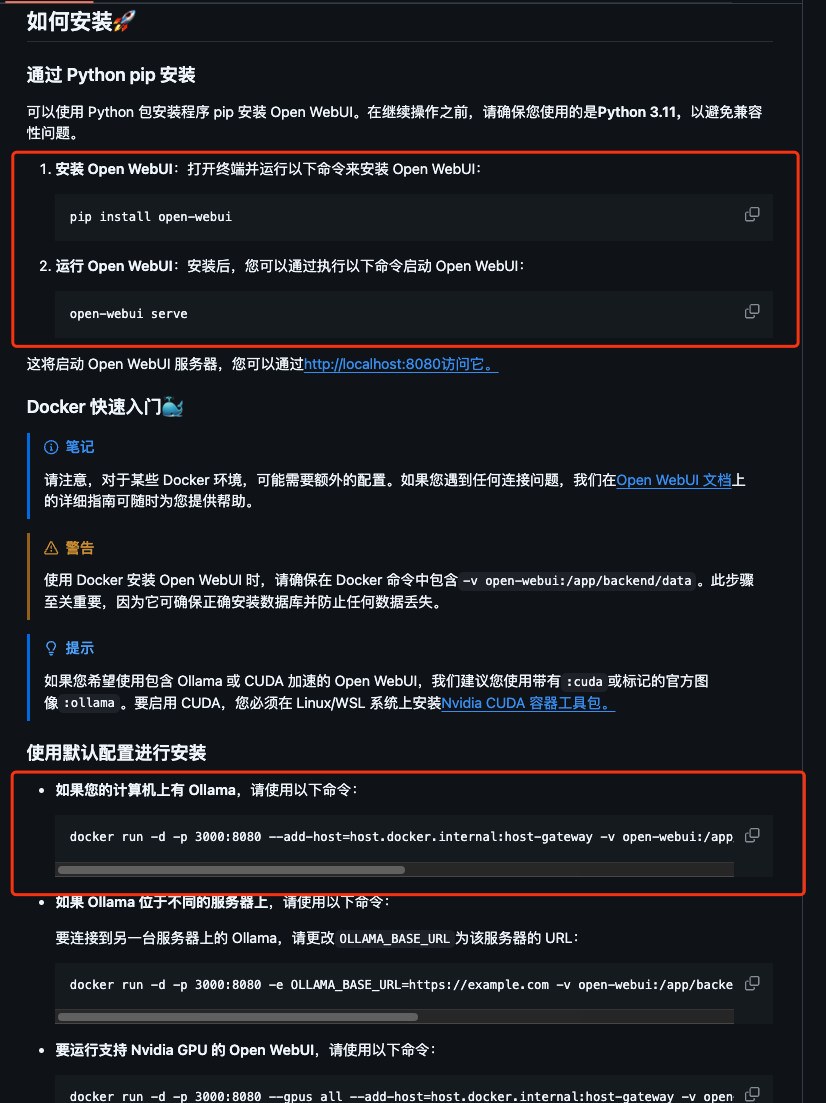

根據官網文檔可使用pip和docker進行安裝,我這里避免影響本地環境使用docker進行安裝

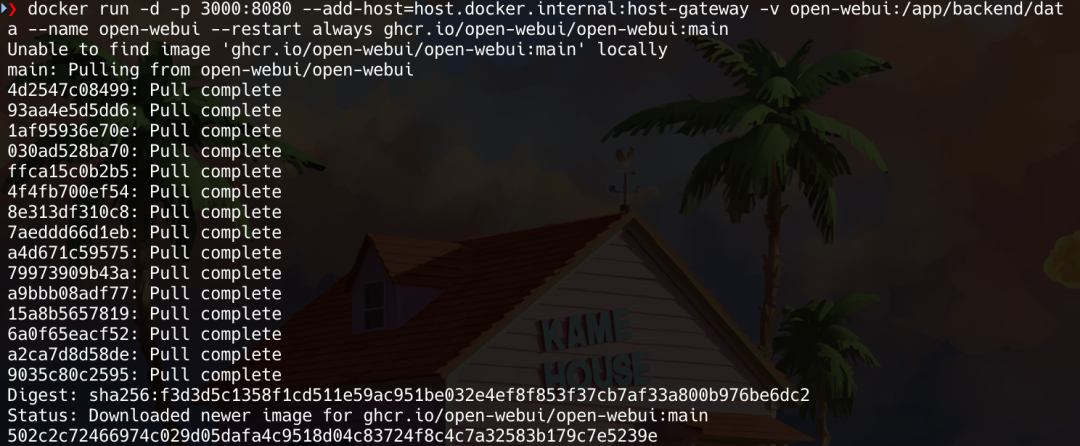

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

訪問http://localhost:3000/

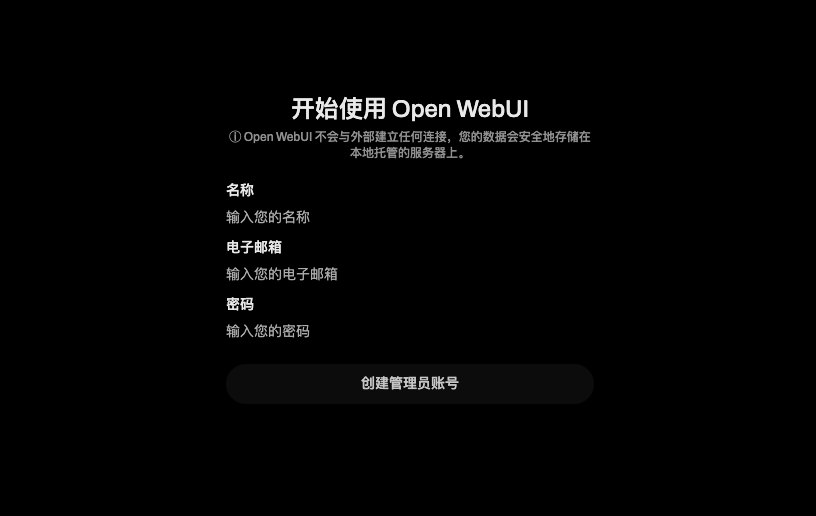

創建賬號

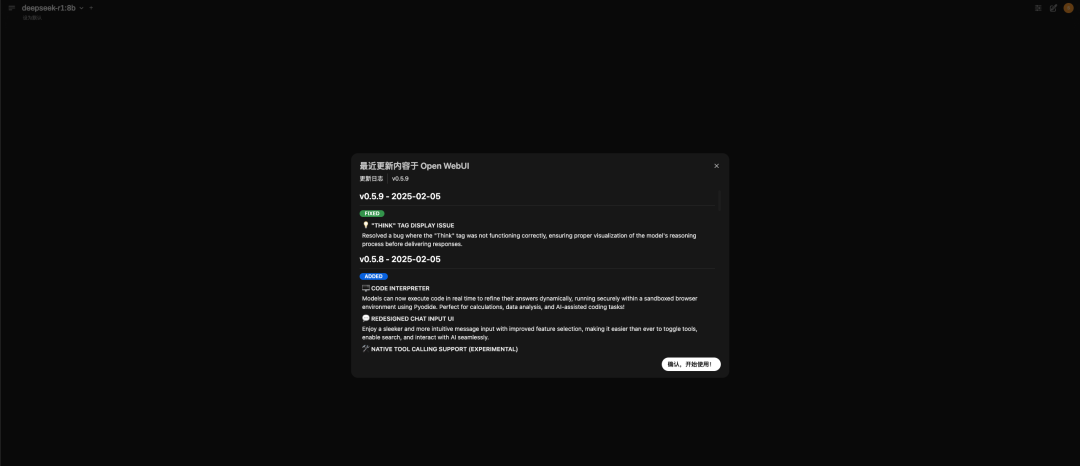

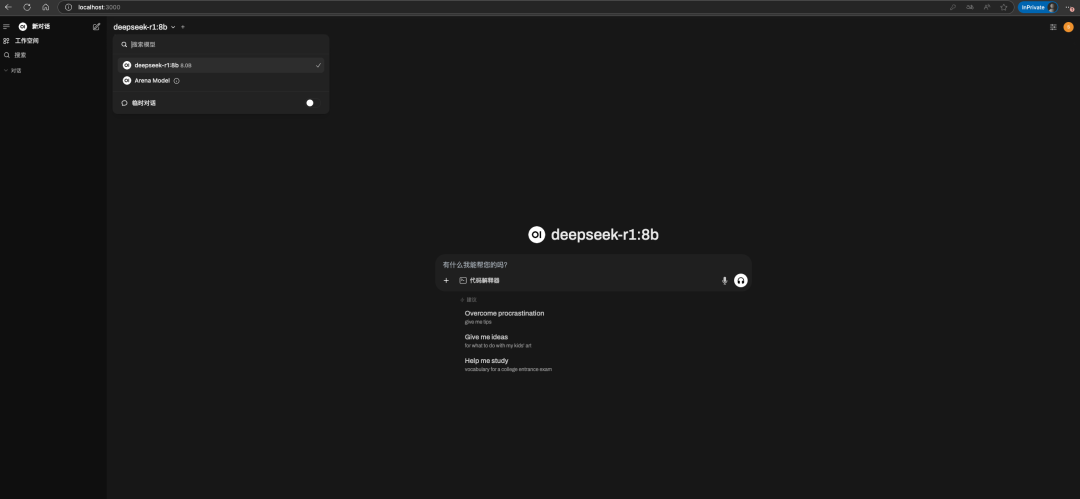

訪問成功

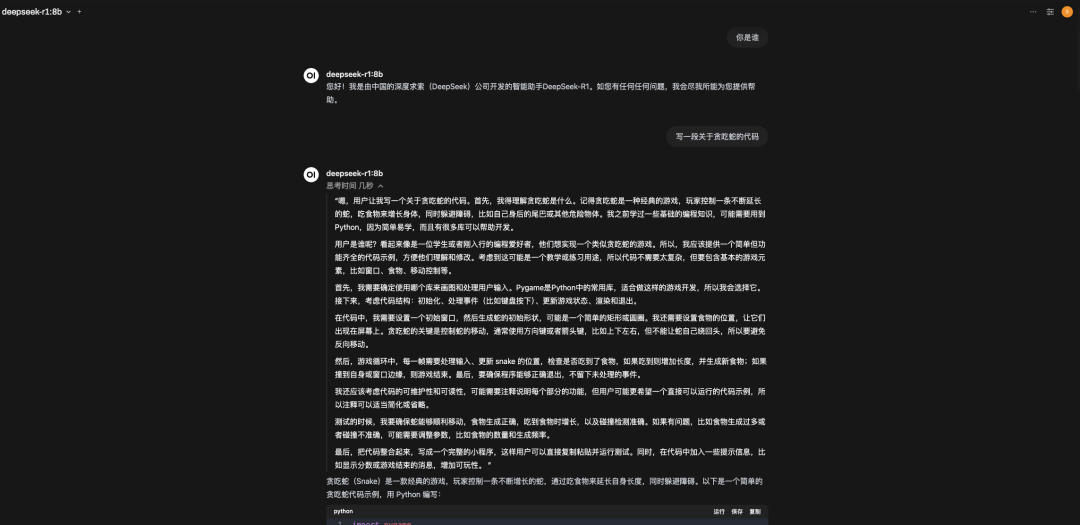

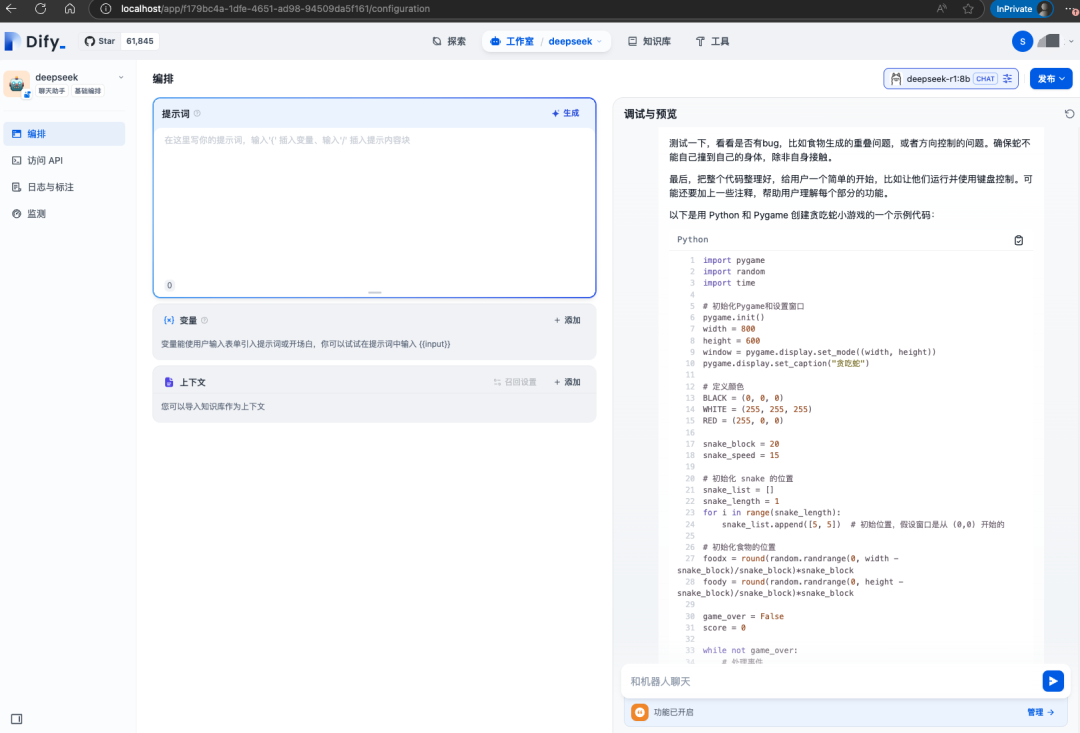

簡單的問下問題,實際運行8b模型給出的代碼是有問題的,根據報錯的問題再次思考時間會變長

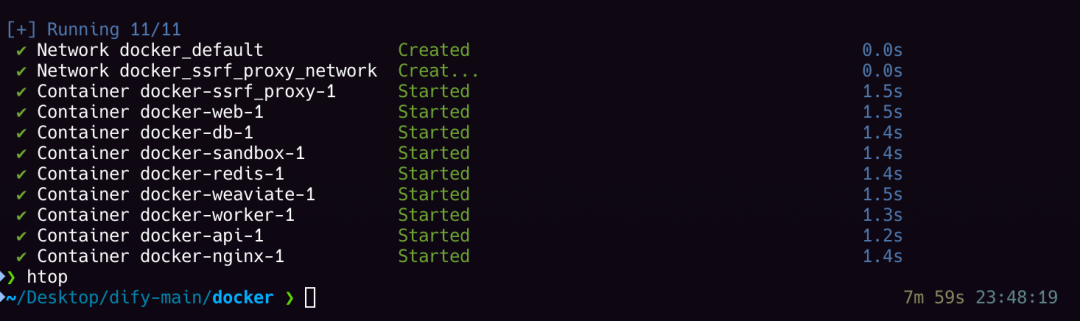

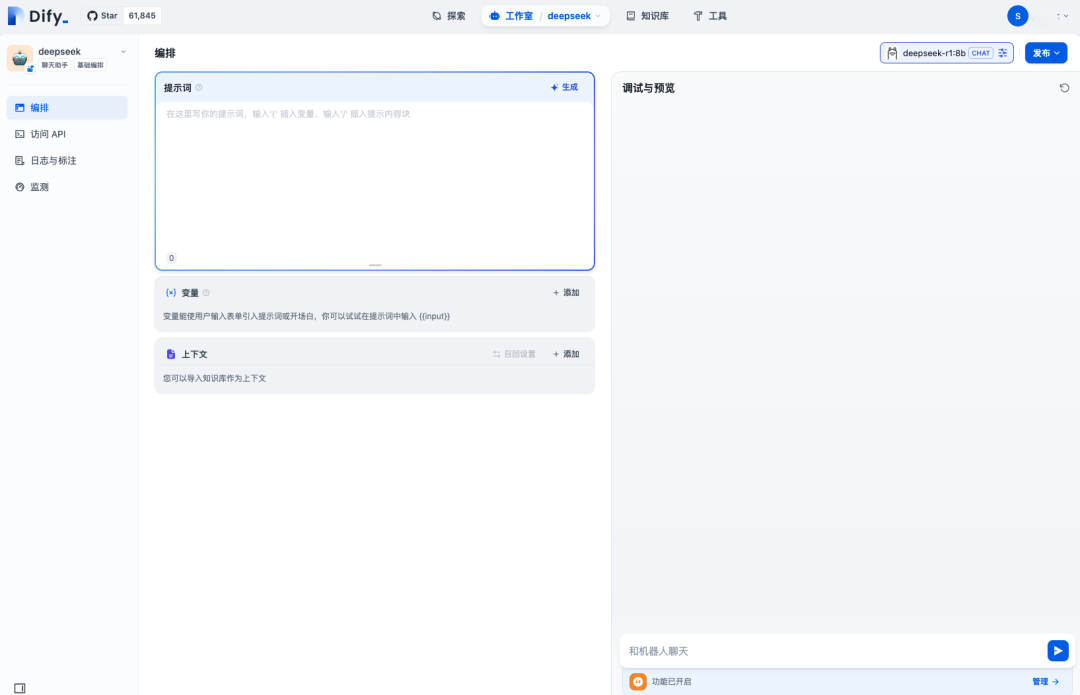

4|24.2 Dify

Dify官方地址:https://github.com/langgenius/dify

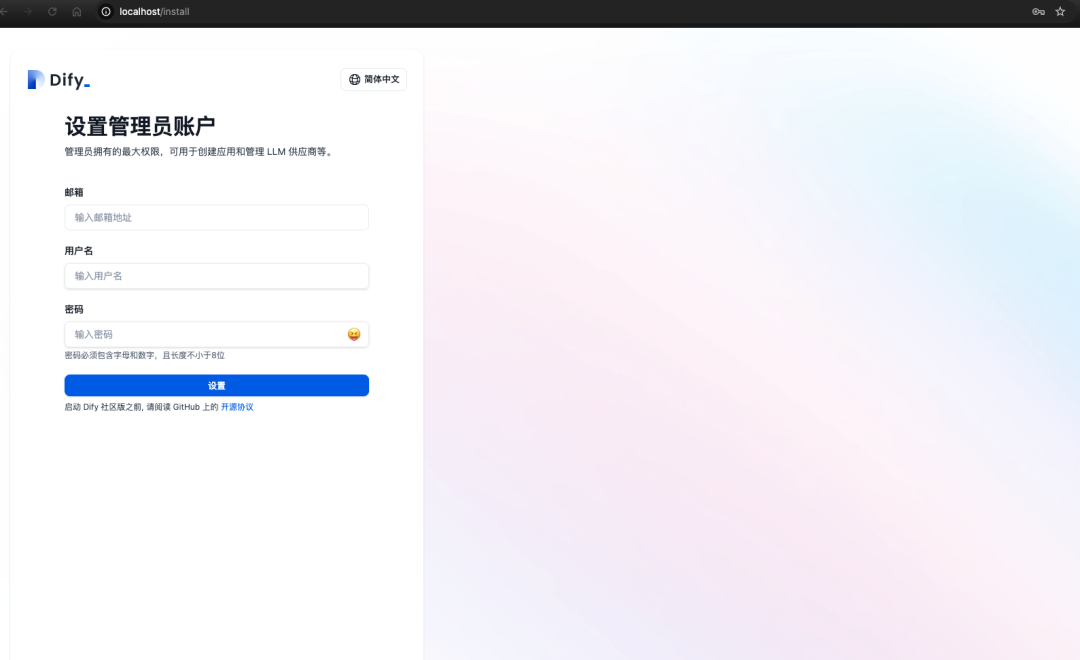

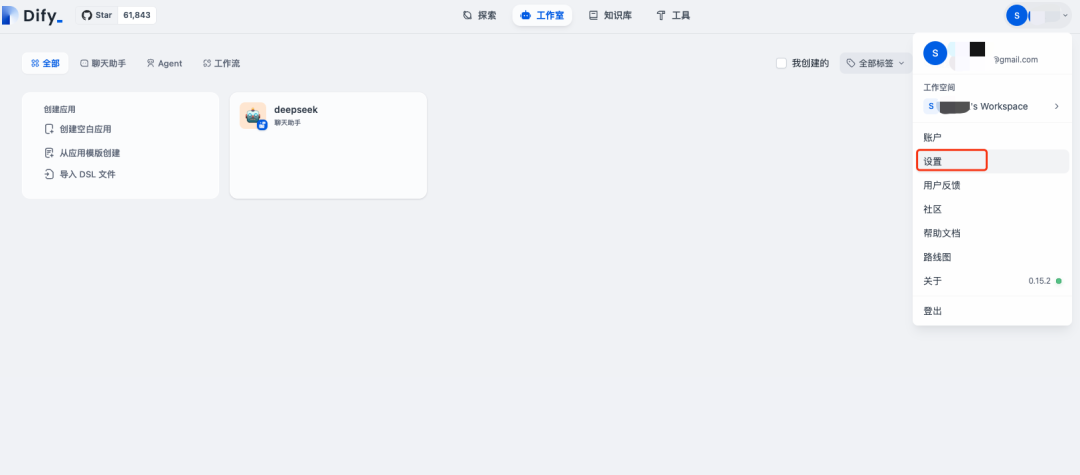

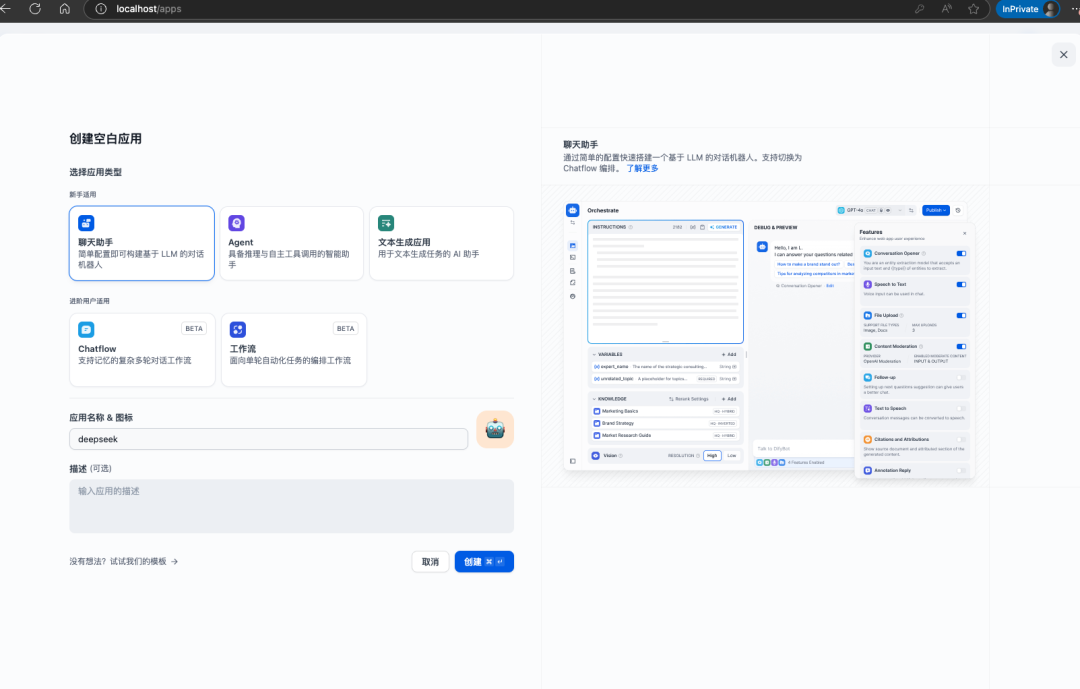

啟動成功,localhost訪問

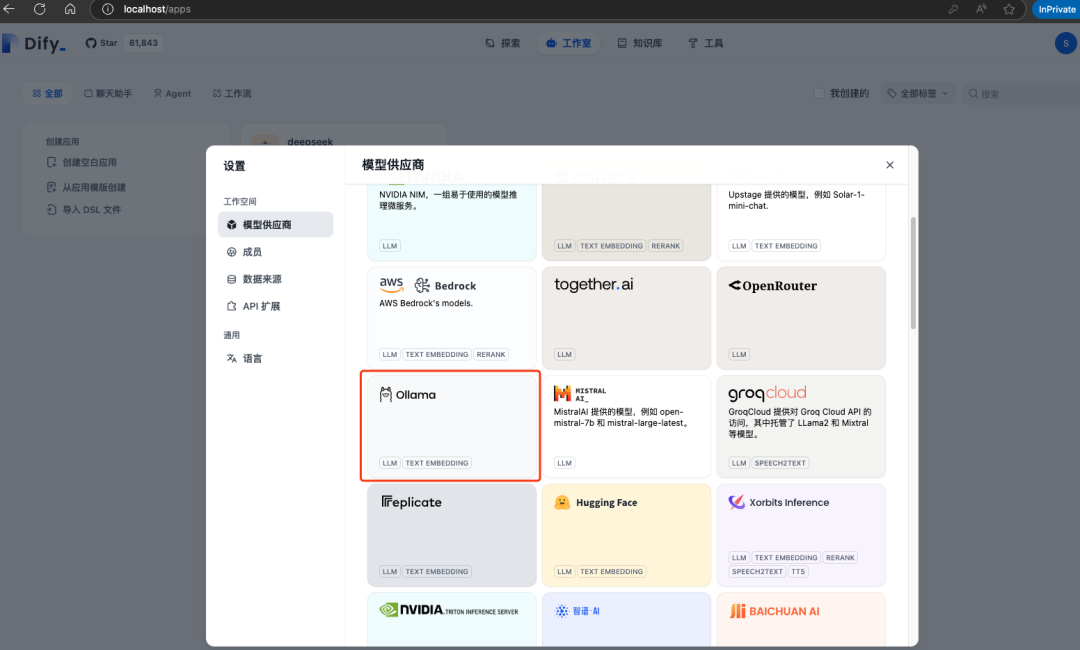

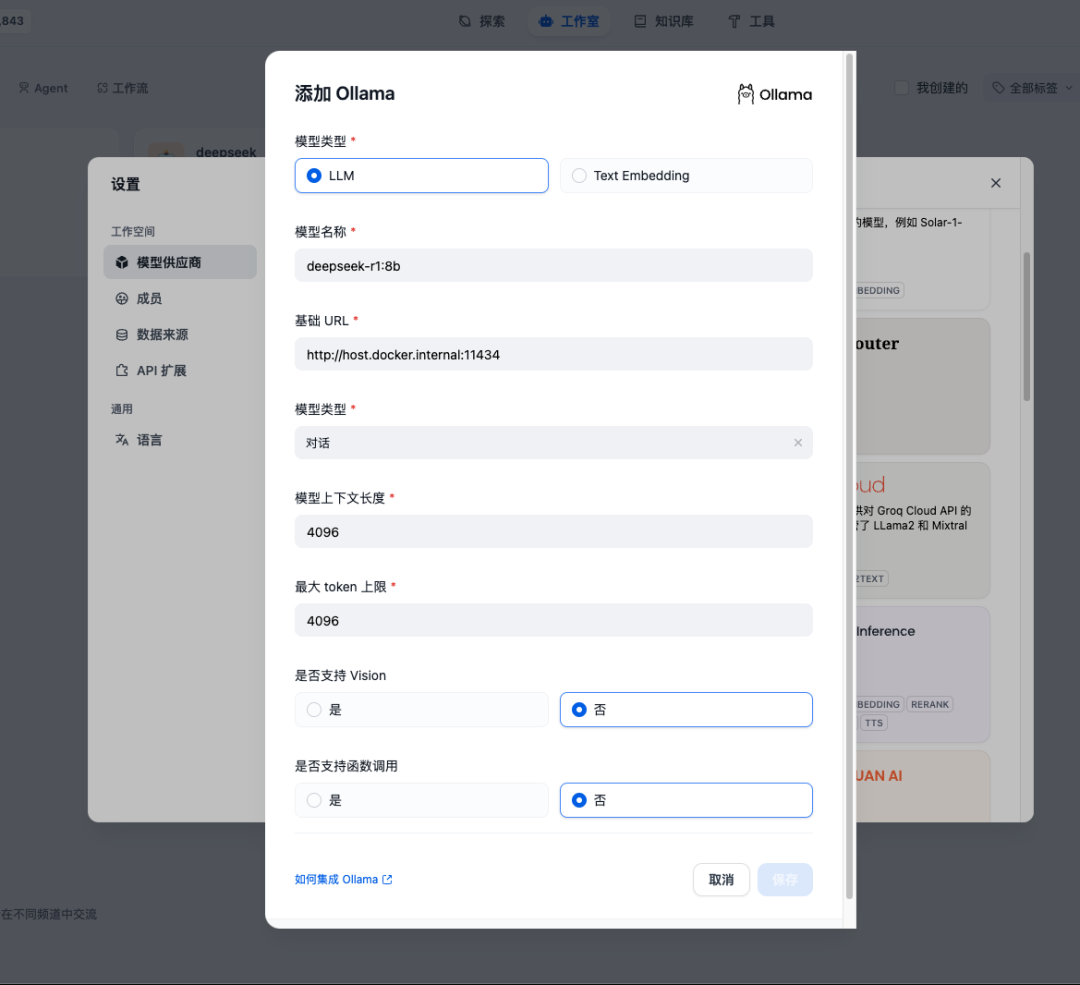

登錄成功選擇Ollama進行添加模型模型供應商,如果Ollama和Dify是同機部署,并且Dify是通過Docker部署,那么填http://host.docker.internal:11434即可

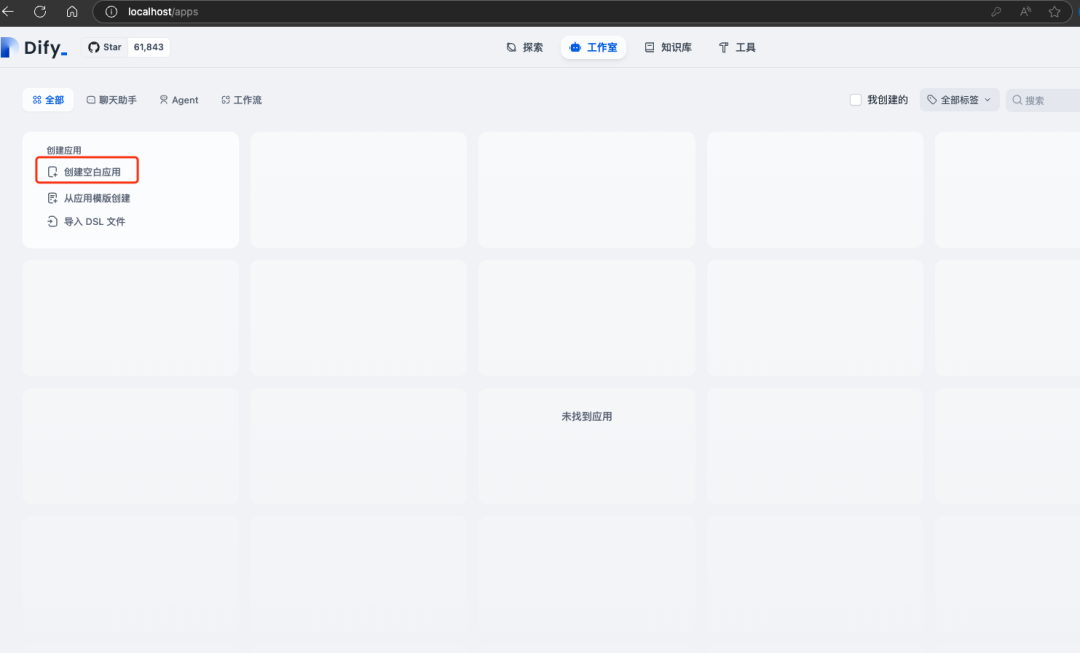

接下來創建應用使用之前安裝好的DeepSeek R1模型

可以看到右上角已經使用deepseek-r1:8b的模型了

簡單的問個問題可以看到已經正常使用

Dify不只是對話,其他功能可以自行探索下,后續有使用我也會更新

以上就是簡單本地部署Deepseek- R1的過程

5|0五、關于Deepseek的使用

最后在本地部署蒸餾版的體驗中對于回答的代碼內容有些不盡人意,不過文字以及思考過程的能力還是可以的

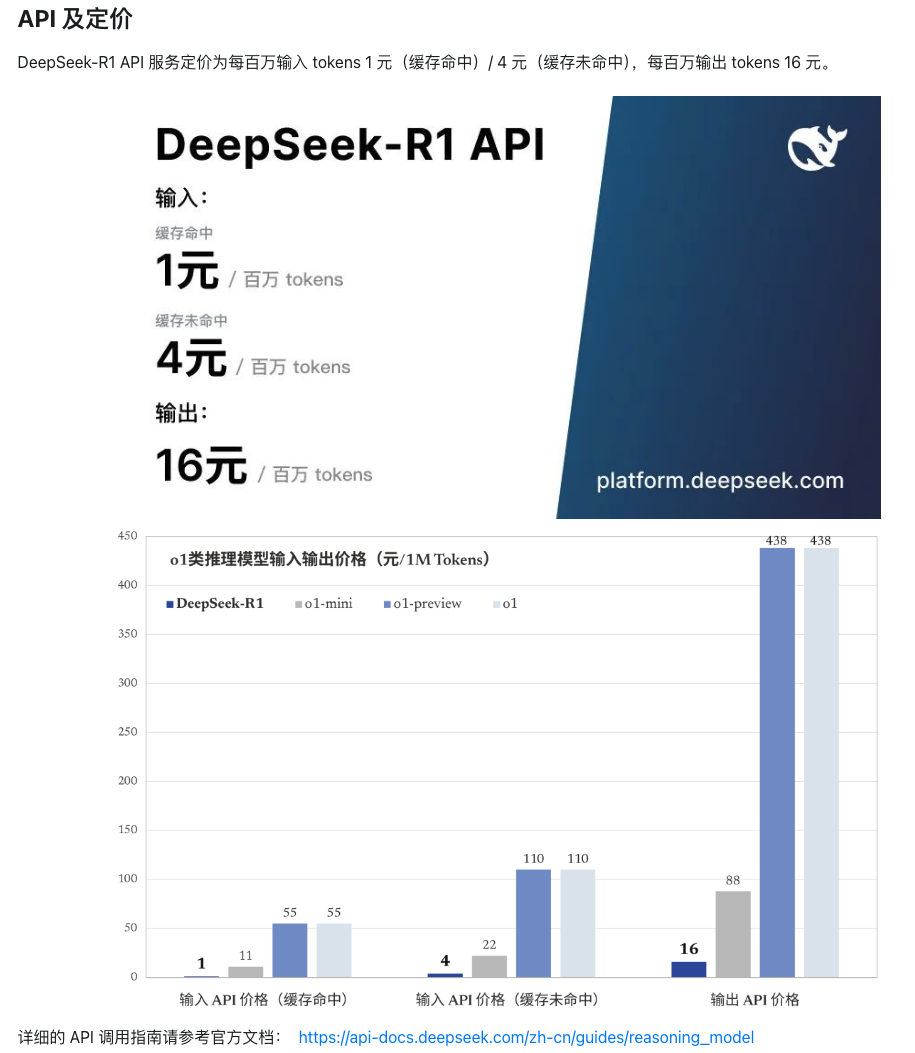

如果想在后續體驗完整版的Deepseek,還沒有高性能的硬件,那么直接使用deepseek官方的服務吧,api是真的便宜

Deepseek剛出現的時候就有在體驗過包括使用API,Deepseek火了之后也總出現了服務器繁忙請稍后再試,API的地址也無法使用,不過之前使用的API卻還可以正常使用,希望盡快修復吧

在vs code中通過Continue插件使用Deepseek的API,也可以在Open-WebUI接入API

在使用過程中感覺到有些上下文聯系不是很緊密,不過思考過程確實很驚艷,在某些方面o1可能還是好些

后來發現chatgpt、kimi這些也推出了推理功能:D,

對于在日常使用中Deepseek和GPT4O的對比各有千秋,可根據使用場景切換使用,但不得不說Deepseek確實很棒。

鏈接:https://www.cnblogs.com/shook/p/18700561

-

AI

+關注

關注

87文章

32677瀏覽量

272027 -

DeepSeek

+關注

關注

1文章

654瀏覽量

470

原文標題:一鍵部署,輕松上手!DeepSeek-R1本地部署指南,開啟你的AI探索之旅!

文章出處:【微信號:magedu-Linux,微信公眾號:馬哥Linux運維】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

如何使用OpenVINO運行DeepSeek-R1蒸餾模型

在英特爾哪吒開發套件上部署DeepSeek-R1的實現方式

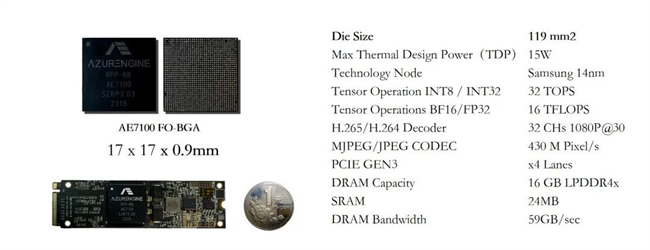

實戰案例 | 299元國產工業級AI核心板部署DeepSeek-R1

RK3588開發板上部署DeepSeek-R1大模型的完整指南

行芯完成DeepSeek-R1大模型本地化部署

Infinix AI接入DeepSeek-R1滿血版

香橙派發布OrangePi 5Plus本地部署Deepseek-R1蒸餾模型指南

添越智創基于 RK3588 開發板部署測試 DeepSeek 模型全攻略

了解DeepSeek-V3 和 DeepSeek-R1兩個大模型的不同定位和應用選擇

Deepseek R1大模型離線部署教程

PerfXCloud上線DeepSeek系列模型

deepin UOS AI接入DeepSeek-R1模型

芯動力神速適配DeepSeek-R1大模型,AI芯片設計邁入“快車道”!

評論