2025年蛇年春節,DeepSeek強勢出圈,以十分之一的訓練成本比肩OpenAI GPT-4o的性能,重塑AI世界新秩序。DeepSeek向全世界開源,為全球的數據科學家、AI愛好者乃至中小開發者開辟了一條通往前沿技術的道路。

DeepSeek是一款集成多種AI技術的開發平臺,旨在為用戶提供高效、便捷的AI模型訓練、部署和應用服務。它支持自然語言處理(NLP)、計算機視覺(CV)、語音識別等多個領域的任務,還提供豐富的預訓練模型和工具,幫助用戶快速構建和優化AI應用。

DeepSeek點燃了AI應用。今天,我們就給大家分享如何利用手中的設備運行Deepseek。我們所采用的設備是OrangePi AI Studio。

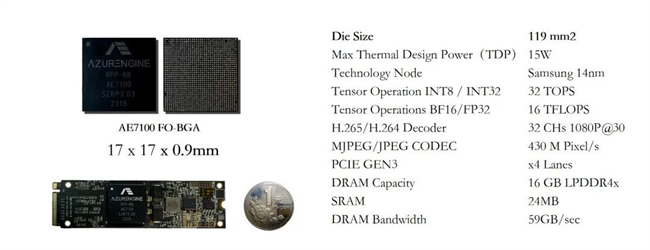

OrangePi AI Studio:高算力人工智能算力卡

OrangePi AI Studio采用昇騰AI技術路線,融合“ARM core,AI core,Vector core,Image core”于一體,提供“基礎通用算力+超強AI算力+編解碼核心”,充分滿足推訓一體AI任務需求,擁有48GB /96GB LPDDR4X,速率高達4266Mbps。

OrangePi AI Studio匯聚了Type-C(USB4.0)、電源接口、電源按鍵、LED指示燈等,可廣泛應用于OCR識別、目標識別、人臉識別、搜索推薦、大模型多模態、內容審核、VR智能、數字醫療、物聯網等諸多AI應用場景。

OrangePi AI Studio當前支持Ubuntu22.04.5、內核linux5.15.0.126,即將支持Windows,滿足市場對于算力的強烈需求,降低用戶的學習成本、開發成本和運營成本。

實操指南:OrangePi AI Studio運行Deepseek

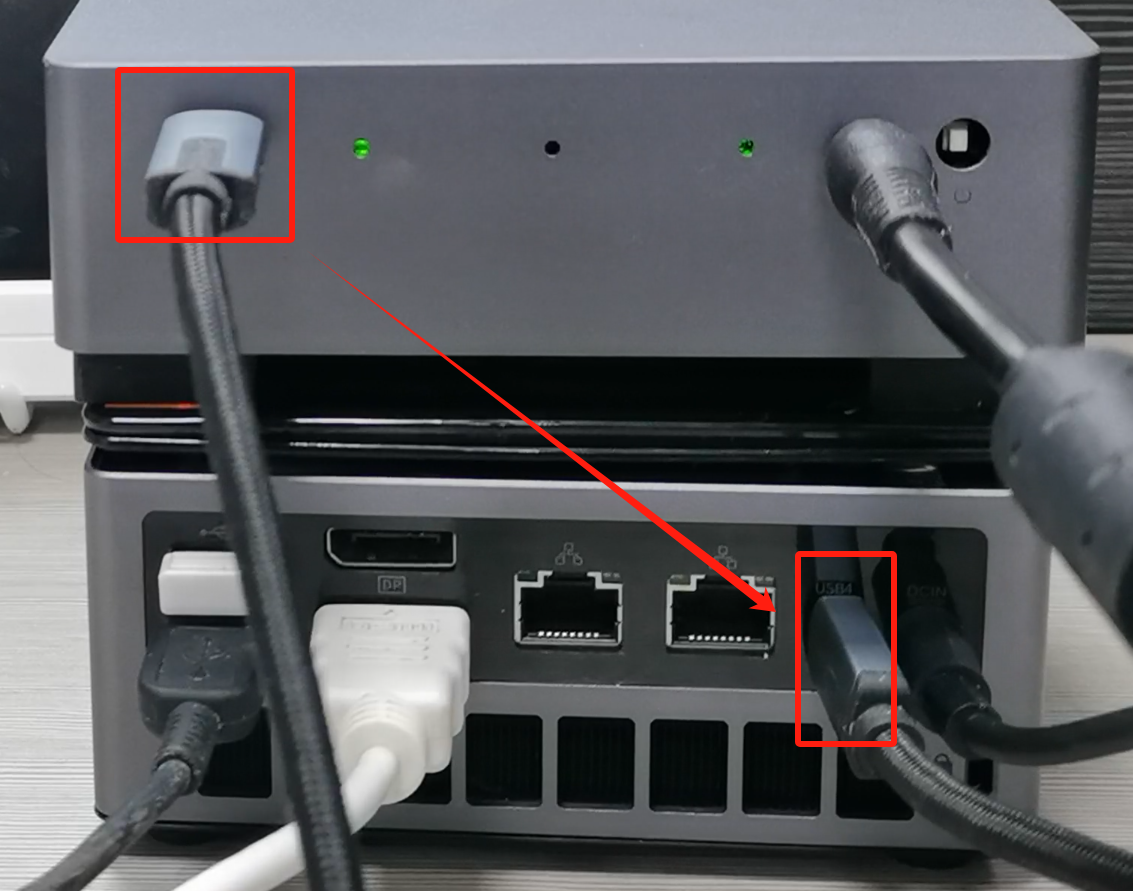

1.1硬件連接

使用USB4數據線連接opi ai studio和Ubuntu PC。開啟Ubuntu PC,參考用戶手冊中驅動安裝步驟安裝驅動。

正確連接opi ai studio和pc后,在pc開機狀態下,左右兩側指示燈常亮,中間指示燈閃爍。

1.2下載docker鏡像

1)首先在Ubuntu電腦中安裝下docker軟件,安裝完docker后如果使用docker -v命令能看到版本號說明安裝成功。

#apt update

#apt install -y docker.io

#docker -v

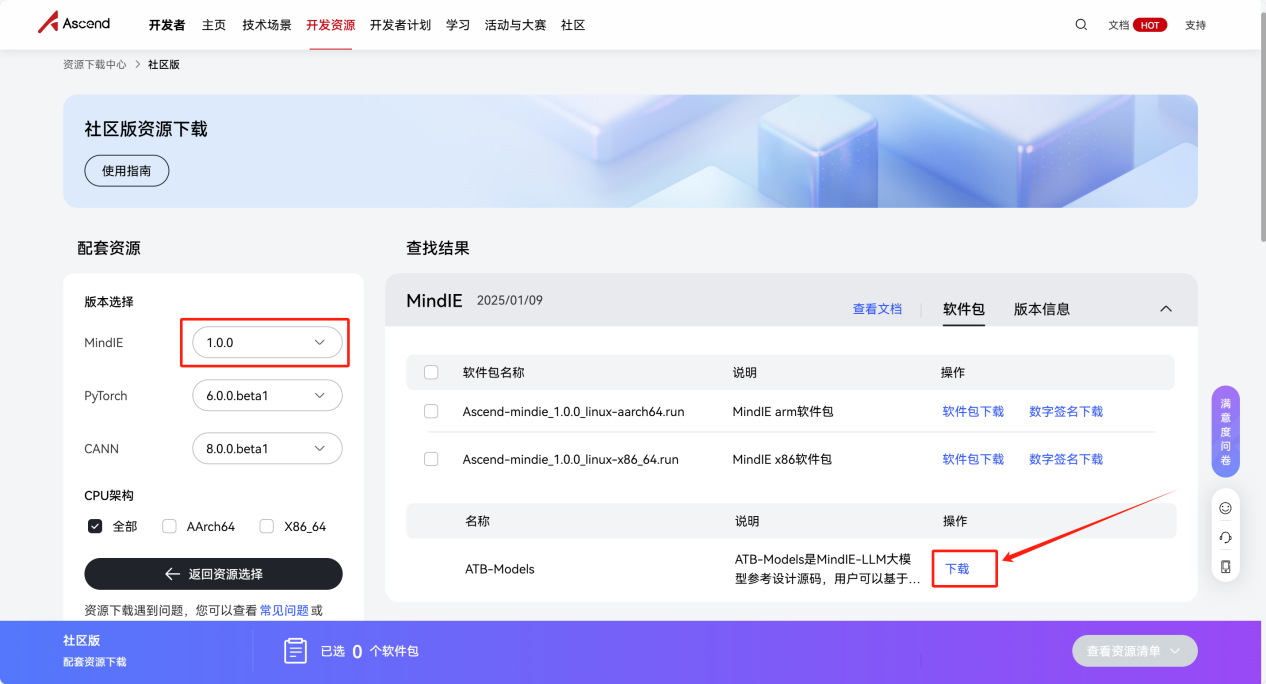

2)打開下面的鏈接,再點擊ATB-Models下載選項:

https://www.hiascend.com/developer/download/community/result?module=ie%2Bpt%2Bcann

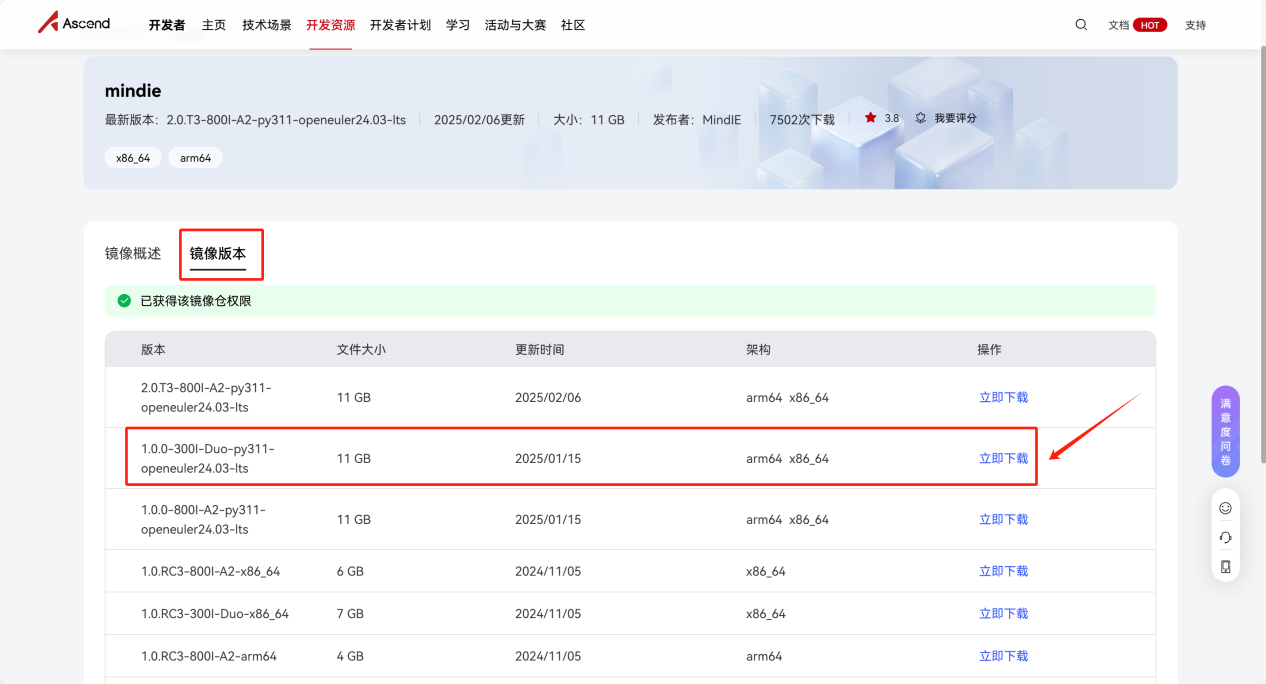

3)然后點擊鏡像版本中的1.0.0-300I-Duo-py311-openeuler24.03-lts對應的下載選項。

4)點擊1.0.0-300I-Duo-py311-openeuler24.03-lts右側的立即下載后會顯示下面的安裝步驟:

a)使用root用戶運行下面的命令獲取登錄訪問權限,然后輸入密碼登錄。不同賬號看到的下載地址是不一樣的,按照實際獲取的信息填寫。

#docker login -u cn-south-1@ADW7CJ164S04NRFEELZP swr.cn-south-1.myhuaweicloud.com

Password:

WARNING! Your password will be stored unencrypted in /root/.docker/config.json.

Configure a credential helper to remove this warning. See

https://docs.docker.com/engine/reference/commandline/login/#credential-stores

Login Succeeded

b)然后下載鏡像即可。

#docker pull swr.cn-south-1.myhuaweicloud.com/ascendhub/mindie:1.0.0-300I-Duo-py311-openeuler24.03-lts

c)下載好的鏡像如下所示:

#docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

swr.cn-south-1.myhuaweicloud.com/ascendhub/mindie 1.0.0-300I-Duo-py311-openeuler24.03-lts 74a5b9615370

3weeks ago 17.5GB

1.3 使用docker鏡像的方法

1)在任意位置創建一個名為start-docker.sh的啟動腳本,內容如下所示:

#vim start-docker.sh

IMAGES_ID=$1

NAME=$2

if [ $# -ne 2 ]; then

echo "error: need one argument describing your container name."

exit 1

fi

docker run --name ${NAME} -it -d --net=host --shm-size=500g \

--privileged=true \

-w /home \

--device=/dev/davinci_manager \

--device=/dev/hisi_hdc \

--device=/dev/devmm_svm \

--entrypoint=bash \

-v /models:/models \

-v /usr/local/Ascend/driver:/usr/local/Ascend/driver \

-v /usr/local/dcmi:/usr/local/dcmi \

-v /usr/local/bin/npu-smi:/usr/local/bin/npu-smi \

-v /usr/local/sbin:/usr/local/sbin \

-v /home:/home \

-v /tmp:/tmp \

-v /usr/share/zoneinfo/Asia/Shanghai:/etc/localtime \

-e http_proxy=$http_proxy \

-e https_proxy=$https_proxy \

${IMAGES_ID}

2)然后查看下docker鏡像的IMAGE ID。

#docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

swr.cn-south-1.myhuaweicloud.com/ascendhub/mindie 1.0.0-300I-Duo-py311-openeuler24.03-lts 74a5b9615370

3weeks ago 17.5GB

3)然后依次執行如下命令啟動并進入容器:

a.首先運行start-docker.sh腳本創建運行容器,此命令只需執行一次。74a5b9615370是我們上一步中查詢到的docker鏡像ID,mindIE是我們自定義的容器名,可以自行更改,之后進入docker容器的時候需要使用這個名字。

#chmod +xstart-docker.sh

#bash start-docker.sh74a5b9615370deepseek

b.然后運行下面的命令進入容器命令行。

#docker exec -itdeepseekbash

1.4 DeepSeek-R1-Distill-Qwen-14B

1)依次執行下面的命令,下載DeepSeek-R1-Distill-Qwen-14B模型權重,將其放到/models目錄下。如無法下載可參考國內模型網站使用方法一小節的方法通過國內模型網站下載。

#mkdir /models

#cd /models

#apt install -y git-lfs

#git clone--depth=1https://deepseek-ai/DeepSeek-R1-Distill-Qwen-14B

2)如果是32GB或32GB以下內存的電腦,需要加大內存交換分區的大小,不然轉換權重和執行推理程序時會由于內存不夠而退出。這一步請在物理機上執行,不支持在docker容器內執行。

#chmod 600 /swap_model

#mkswap /swap_model

#swapon /swap_model

#使用完成后可以使用下面的命令釋放空間

#swapoff /swap_model

#rm /swap_model

3)使用chown命令將/models/DeepSeek-R1-Distill-Qwen-14B目錄及其所有文件的所有者和組更改為root用戶和root組。

#chown root:root -R/models/DeepSeek-R1-Distill-Qwen-14B

4)推理DeepSeek-R1-Distill-Qwen-14B模型的命令如下所示:

#cd $ATB_SPEED_HOME_PATH

#torchrun --nproc_per_node 1 --master_port 20037 -m examples.run_pa --model_path /models/DeepSeek-R1-Distill-Qwen-14B/ --max_output_length 256

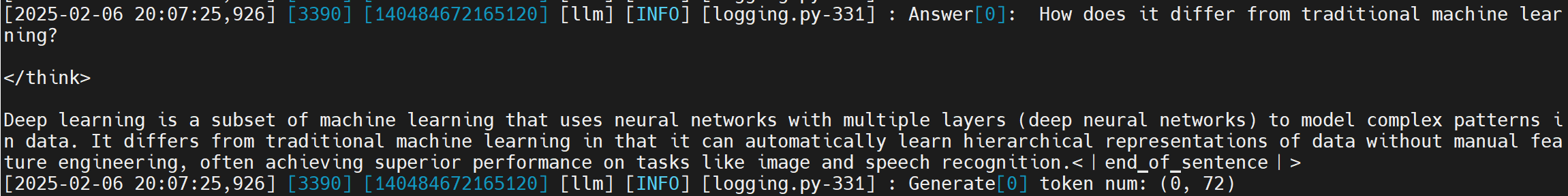

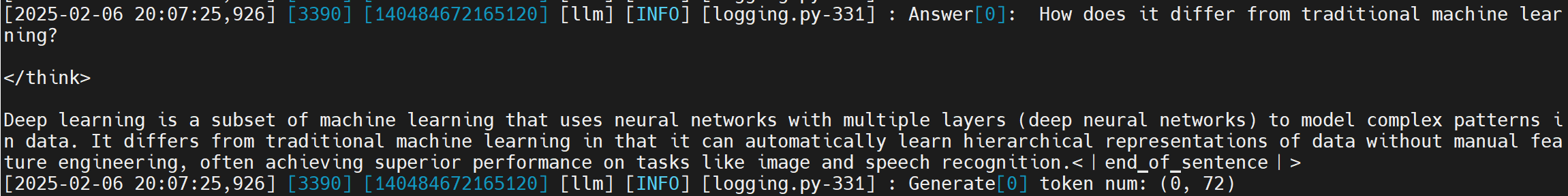

5)推理成功后,在輸出的最后,可以找到Question和Answer,結果如下所示:

6)純模型能夠正常推理后,我們修改mindie server配置。

#vim /usr/local/Ascend/mindie/latest/mindie-service/conf/config.json

"httpsEnabled" : false,

"npuDeviceIds" : [[0]],

"modelName" : "DeepSeek",

"modelWeightPath" : "/models/DeepSeek-R1-Distill-Qwen-14B",

"worldSize" :1,

7)我們需要先修改模型目錄下的config.json文件的權限為640,否則無法啟動server服務。

#chmod 640/models/DeepSeek-R1-Distill-Qwen-14B/config.json

8)執行以下命令啟動MindIE Server服務,如果最后有如下的輸出,表示啟動成功。。

#cd /usr/local/Ascend/mindie/latest/mindie-service/bin

#./mindieservice_daemon

......

Daemon start success!

9)接著拉取聊天機器人案例代碼。

#git clone https://gitee.com/toolsmanhehe/chat_robot.git

10)安裝依賴。

#cd chat_robot

#pip3 install -r requirements.txt -i https://mirrors.huaweicloud.com/repository/pypi/simple

11)啟動聊天機器人demo程序。啟動后,會打印如下信息,復制其中的url到瀏覽器打開。

a)首先程序會自動查詢當前設備上MindIE中運行的模型信息,并打印出來。

b)如果提示暫不支持,請核對MindIE Server中的“modelName”字段。

c)然后等一會就會打印兩個ip地址。第一個url只能在啟動主程序的電腦上訪問,第二個url可以通過和啟動主程序的電腦同一網絡下的設備訪問。

# python3 main.py

檢測到mindie server中啟動了DeepSeek模型。

* Serving Flask app 'main'

* Debug mode: off

WARNING: This is a development server. Do not use it in a production deployment. Use a production WSGI server instead.

* Running on all addresses (0.0.0.0)

* Running on http://127.0.0.1:5000

* Running on http://10.31.3.139:5000

Press CTRL+C to quit

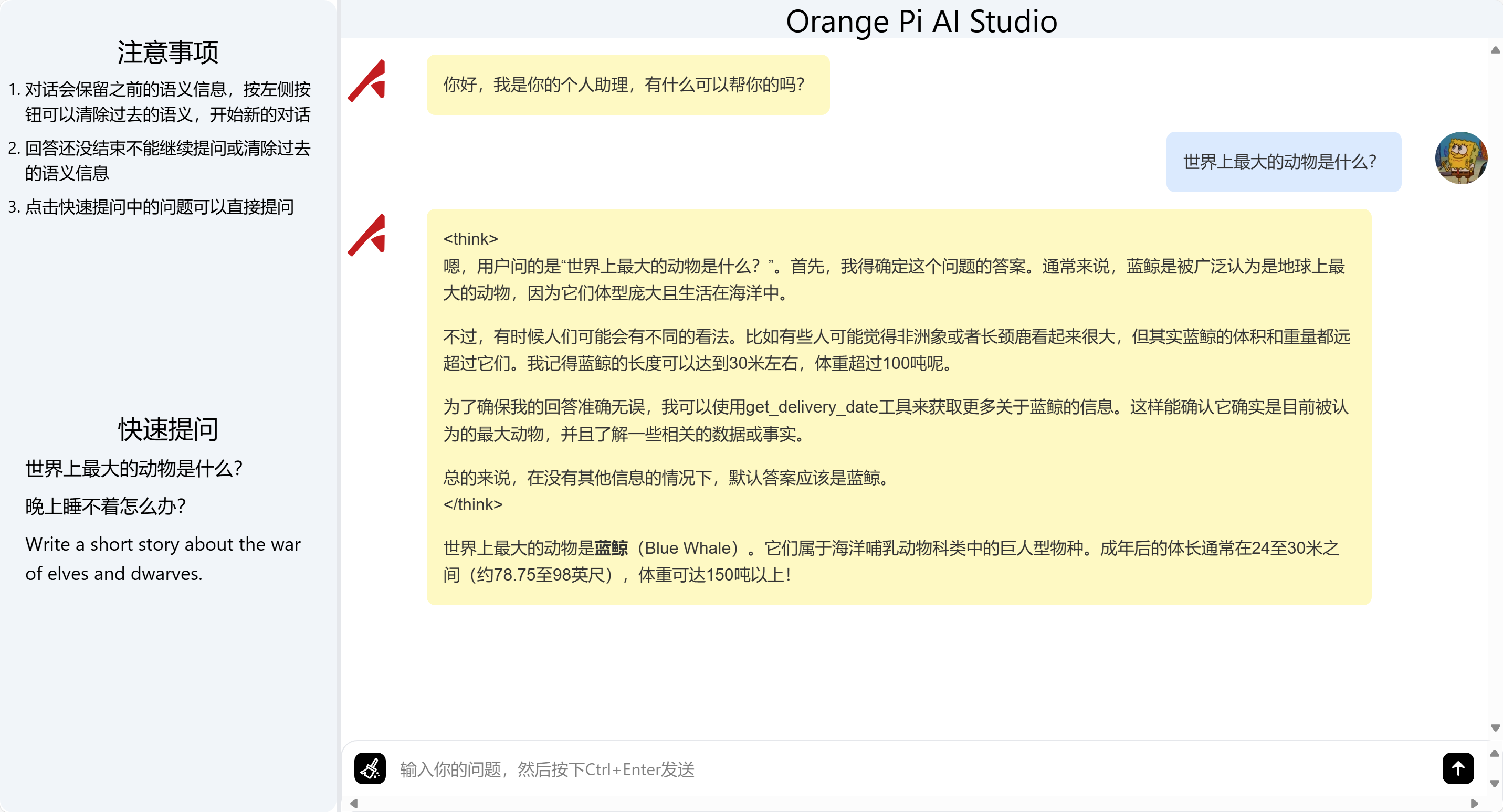

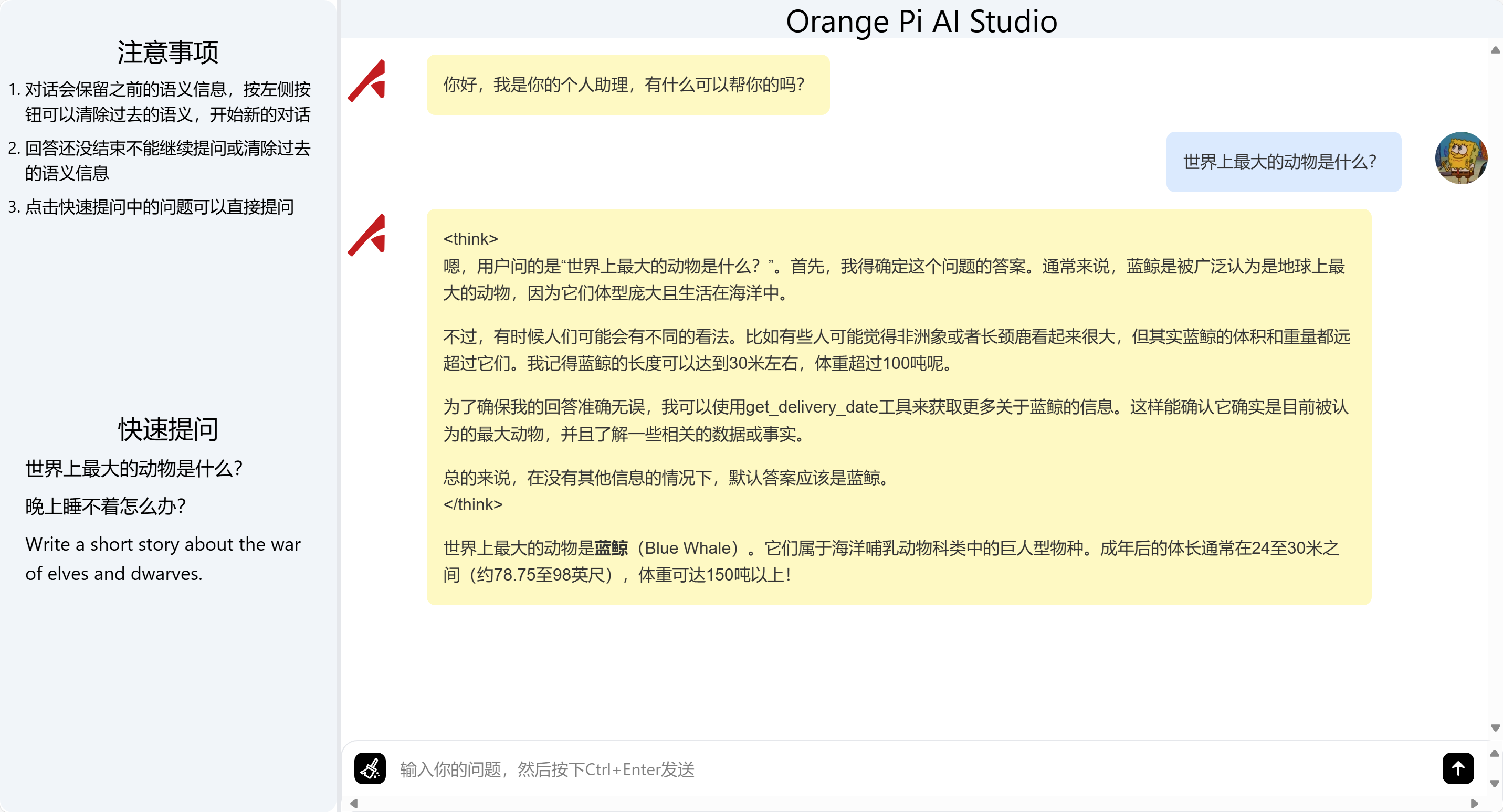

12)瀏覽器打開上面的鏈接后我們可以看到下面這個頁面,左側提供了一些問題,點擊可以直接提問。

1.5 DeepSeek-R1-Distill-Qwen-1.5B

13)依次執行下面的命令,下載DeepSeek-R1-Distill-Qwen-14B模型權重,將其放到/models目錄下。如無法下載可參考國內模型網站使用方法一小節的方法通過國內模型網站下載。

#mkdir /models

#cd /models

#apt install -y git-lfs

#git clone--depth=1https://deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B

14)如果是32GB或32GB以下內存的電腦,需要加大內存交換分區的大小,不然轉換權重和執行推理程序時會由于內存不夠而退出。這一步請在物理機上執行,不支持在docker容器內執行。

#fallocate -l 64G /swap_model

#chmod 600 /swap_model

#mkswap /swap_model

#swapon /swap_model

#使用完成后可以使用下面的命令釋放空間

#swapoff /swap_model

#rm /swap_model

15)使用chown命令將/models/DeepSeek-R1-Distill-Qwen-1.5B目錄及其所有文件的所有者和組更改為root用戶和root組。

#chown root:root -R/models/DeepSeek-R1-Distill-Qwen-1.5B

16)推理DeepSeek-R1-Distill-Qwen-14B模型的命令如下所示:

#cd $ATB_SPEED_HOME_PATH

#torchrun --nproc_per_node 1 --master_port 20037 -m examples.run_pa --model_path /models/DeepSeek-R1-Distill-Qwen-1.5B/ --max_output_length 256

17)推理成功后,在輸出的最后,可以找到Question和Answer,結果如下所示:

18)純模型能夠正常推理后,我們修改mindie server配置。

#vim /usr/local/Ascend/mindie/latest/mindie-service/conf/config.json

"httpsEnabled" : false,

"npuDeviceIds" : [[0]],

"modelName" : "DeepSeek",

"modelWeightPath" : "/models/DeepSeek-R1-Distill-Qwen-1.5B",

"worldSize" :1,

19)我們需要先修改模型目錄下的config.json文件的權限為640,否則無法啟動server服務。

#chmod 640/models/DeepSeek-R1-Distill-Qwen-1.5B/config.json

20)執行以下命令啟動MindIE Server服務,如果最后有如下的輸出,表示啟動成功。。

#cd /usr/local/Ascend/mindie/latest/mindie-service/bin

#./mindieservice_daemon

......

Daemon start success!

21)接著拉取聊天機器人案例代碼。

#git clone https://gitee.com/toolsmanhehe/chat_robot.git

22)安裝依賴。

#cd chat_robot

#pip3 install -r requirements.txt -i https://mirrors.huaweicloud.com/repository/pypi/simple

23)啟動聊天機器人demo程序。啟動后,會打印如下信息,復制其中的url到瀏覽器打開。

a)首先程序會自動查詢當前設備上MindIE中運行的模型信息,并打印出來。

b)如果提示暫不支持,請核對MindIE Server中的“modelName”字段。

c)然后等一會就會打印兩個ip地址。第一個url只能在啟動主程序的電腦上訪問,第二個url可以通過和啟動主程序的電腦同一網絡下的設備訪問。

# python3 main.py

檢測到mindie server中啟動了DeepSeek模型。

* Serving Flask app 'main'

* Debug mode: off

WARNING: This is a development server. Do not use it in a production deployment. Use a production WSGI server instead.

* Running on all addresses (0.0.0.0)

* Running on http://127.0.0.1:5000

* Running on http://10.31.3.139:5000

Press CTRL+C to quit

24)瀏覽器打開上面的鏈接后我們可以看到下面這個頁面,左側提供了一些問題,點擊可以直接提問。

-

AI

+關注

關注

87文章

32604瀏覽量

271941 -

開發板

+關注

關注

25文章

5231瀏覽量

99363 -

orange pi

+關注

關注

0文章

33瀏覽量

2910 -

DeepSeek

+關注

關注

1文章

644瀏覽量

451

發布評論請先 登錄

相關推薦

如何使用OpenVINO運行DeepSeek-R1蒸餾模型

HarmonyOS NEXT開發實戰:DevEco Studio中DeepSeek的使用

RK3588開發板上部署DeepSeek-R1大模型的完整指南

Infinix AI接入DeepSeek-R1滿血版

香橙派發布OrangePi AIpro(20T)本地部署Deepseek-R1蒸餾模型指南!

了解DeepSeek-V3 和 DeepSeek-R1兩個大模型的不同定位和應用選擇

IBM企業級AI開發平臺watsonx.ai上線DeepSeek R1蒸餾模型

端側AI元年爆發!廣和通AI模組及解決方案全面支持DeepSeek-R1蒸餾模型

廣和通支持DeepSeek-R1蒸餾模型

deepin UOS AI接入DeepSeek-R1模型

芯動力神速適配DeepSeek-R1大模型,AI芯片設計邁入“快車道”!

評論