近日,基于開源KTransformers架構的 CPU/GPU 異構推理能力,沐曦在曦云C500單卡GPU上成功實現DeepSeek-R1-671B滿血版單并發解碼吞吐16.5 tokens/s的優異成績,相比社區官方數據提升20%以上。

相比國際高端GPU八卡滿血版部署方案,本項目在單并發性能上具有極高的性價比。

KTransformers項目介紹

KTransformers (https://github.com/kvcache-ai/ktransformers)是由清華大學 KVCache.AI 團隊聯合趨境科技開源的一套輕量化高性能模型推理框架,能夠在計算資源受限的場景下,通過 CPU/GPU 異構推理的方式更快速、更高效地實現大模型的本地推理。KTransformers旨在作為一個開放的平臺,用于試驗創新的大型語言模型(LLM)推理優化方案。同時,KTransformers也計劃演進成本地化中小并發場景下針對稀疏MoE模型最具性價比的開源推理引擎,以及成為一個算子級優化的集成實驗平臺。沐曦正在做的工作非常符合開源社區和KTransformers開源項目的發展。

開源合作內容介紹

沐曦和KVCache.AI團隊合作,通過對KTransformers模型框架進行細致的分析和調整,團隊成功達成了曦云C500與KTransformers的無縫對接,為進一步性能優化奠定了堅實的基礎。

完成基本功能適配后,沐曦研發團隊繼續對整個框架進行了優化。在深入研究了DeepSeek R1滿血版模型的計算特點和性能瓶頸,結合曦云C500的優勢,采用了一系列先進的技術和算法,詳細如下:

1在KTransformers中加入了Multi-Token Prediction (MTP) 功能;

2加入了GPU fused MoE功能,該功能有效利用曦云C500 64GB的高帶寬顯存和高速FP16/BF16運算能力,提升推理性能;

3配合自動/手工算子融合技術,高效的FP16/BF16精度Marlin算子(W4A16),以及經過深度優化的mcBLAS、PyTorch庫、FlashInfer庫。

此次合作不僅為KTransformers帶來了性能上的提升,更體現了開源共創的價值:不同的團隊和開發者通過資源共享、經驗交流,共同推動技術的進步。沐曦和清華大學KVCache.AI團隊的合作就是很好的例子,通過開源倉庫匯聚了各自的優勢,實現了技術上的突破,也為后續持續在開源社區推理優化提供了合作基礎。

通過開源社區的共同努力,KTransformers將不斷提升其性能和功能,為更多的用戶提供優質的服務。同時,這也將促進整個人工智能行業的發展,推動技術的不斷創新。單卡打開DeepSeek R1滿血版并不斷地提升性能只是一個開始,在開源共創的道路上,我們將迎來更多的驚喜和突破,共同開創國產算力生態和人工智能的無限未來。

關于沐曦

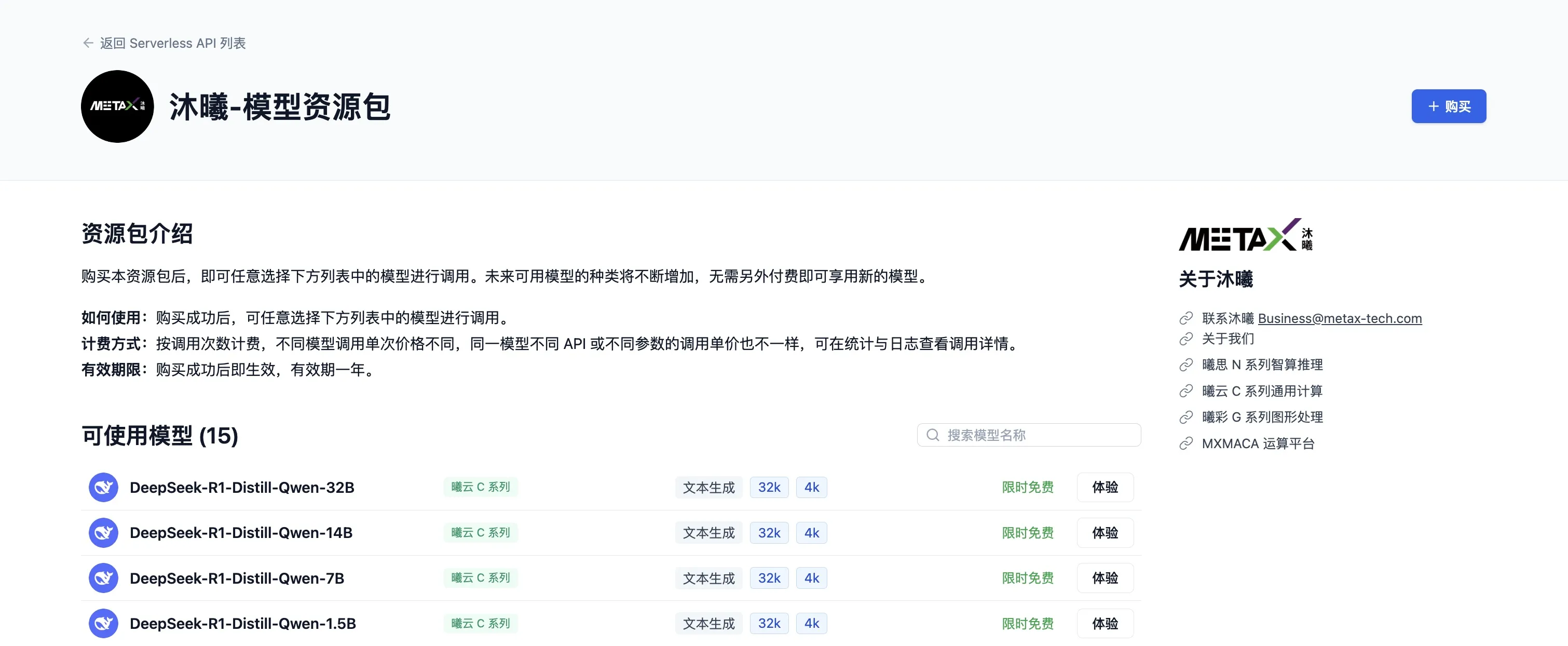

沐曦致力于為異構計算提供安全可靠的GPU芯片及解決方案,打造全棧GPU芯片產品,推出曦思N系列GPU用于智算推理,曦云C系列GPU用于通用計算,以及曦彩G系列GPU用于圖形渲染,滿足“高能效”及“高通用性”的算力需求。沐曦產品均采用完全自主研發的GPU IP,擁有完全自主的指令集和架構,配以兼容主流GPU生態的完整軟件棧(MXMACA),具備高能效和高通用性的天然優勢,能夠為客戶構建軟硬件一體的全面生態解決方案,是“雙碳”背景下推動數字經濟建設和產業數字化、智能化轉型升級的算力基石。

-

gpu

+關注

關注

28文章

4844瀏覽量

129922 -

開源

+關注

關注

3文章

3492瀏覽量

43041 -

沐曦

+關注

關注

0文章

30瀏覽量

1267 -

DeepSeek

+關注

關注

1文章

680瀏覽量

521

原文標題:開源賦能:沐曦聯合清華大學KVCache.AI團隊加速DeepSeek滿血版單卡C500異構推理

文章出處:【微信號:沐曦MetaX,微信公眾號:沐曦MetaX】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

聆思CSK6大模型語音開發板接入DeepSeek資料匯總(包含深度求索/火山引擎/硅基流動華為昇騰滿血版)

壁仞科技支持DeepSeek-V3滿血版訓練推理

RK3588開發板上部署DeepSeek-R1大模型的完整指南

沐曦GPU跑通DeepSeek開源代碼庫FlashMLA

Infinix AI接入DeepSeek-R1滿血版

省內領先!南京率先引入DeepSeek滿血版

黑芝麻智能芯片加速DeepSeek模型推理

探討DeepSeek-R1滿血版的推理部署與優化策略

了解DeepSeek-V3 和 DeepSeek-R1兩個大模型的不同定位和應用選擇

Gitee AI 聯合沐曦首發全套 DeepSeek R1 千問蒸餾模型,全免費體驗!

評論