計算機發(fā)展到今天,已經(jīng)大大改變了我們的生活,我們已經(jīng)進入了智能化的時代。但要是想實現(xiàn)影視作品中那樣充分互動的人工智能與人機互動系統(tǒng),就不得不提到深度學習。

深度學習

深度學習的概念源于人工神經(jīng)網(wǎng)絡(luò)的研究。含多隱層的多層感知器就是一種深度學習結(jié)構(gòu)。深度學習通過組合低層特征形成更加抽象的高層表示屬性類別或特征,以發(fā)現(xiàn)數(shù)據(jù)的分布式特征表示。

深度學習的概念由Hinton等人于2006年提出。基于深信度網(wǎng)(DBN)提出非監(jiān)督貪心逐層訓練算法,為解決深層結(jié)構(gòu)相關(guān)的優(yōu)化難題帶來希望,隨后提出多層自動編碼器深層結(jié)構(gòu)。此外Lecun等人提出的卷積神經(jīng)網(wǎng)絡(luò)是第一個真正多層結(jié)構(gòu)學習算法,它利用空間相對關(guān)系減少參數(shù)數(shù)目以提高訓練性能。

深度學習是機器學習研究中的一個新的領(lǐng)域,其動機在于建立、模擬人腦進行分析學習的神經(jīng)網(wǎng)絡(luò),它模仿人腦的機制來解釋數(shù)據(jù),例如圖像,聲音和文本。

同機器學習方法一樣,深度機器學習方法也有監(jiān)督學習與無監(jiān)督學習之分。不同的學習框架下建立的學習模型很是不同.

例如,卷積神經(jīng)網(wǎng)絡(luò)(Convolutional neural networks,簡稱CNNs)就是一種深度的監(jiān)督學習下的機器學習模型,而深度置信網(wǎng)(Deep Belief Nets,簡稱DBNs)就是一種無監(jiān)督學習下的機器學習模型。

Artificial Intelligence,也就是人工智能,就像長生不老和星際漫游一樣,是人類最美好的夢想之一。雖然計算機技術(shù)已經(jīng)取得了長足的進步,但是到目前為止,還沒有一臺電腦能產(chǎn)生“自我”的意識。是的,在人類和大量現(xiàn)成數(shù)據(jù)的幫助下,電腦可以表現(xiàn)的十分強大,但是離開了這兩者,它甚至都不能分辨一個喵星人和一個汪星人。

圖靈(圖靈,大家都知道吧。計算機和人工智能的鼻祖,分別對應(yīng)于其著名的“圖靈機”和“圖靈測試”)在 1950 年的論文里,提出圖靈試驗的設(shè)想,即,隔墻對話,你將不知道與你談話的,是人還是電腦。這無疑給計算機,尤其是人工智能,預(yù)設(shè)了一個很高的期望值。但是半個世紀過去了,人工智能的進展,遠遠沒有達到圖靈試驗的標準。這不僅讓多年翹首以待的人們,心灰意冷,認為人工智能是忽悠,相關(guān)領(lǐng)域是“偽科學”。

但是自 2006 年以來,機器學習領(lǐng)域,取得了突破性的進展。圖靈試驗,至少不是那么可望而不可及了。至于技術(shù)手段,不僅僅依賴于云計算對大數(shù)據(jù)的并行處理能力,而且依賴于算法。這個算法就是,Deep Learning。借助于 Deep Learning 算法,人類終于找到了如何處理“抽象概念”這個亙古難題的方法。

2012年6月,《紐約時報》披露了Google Brain項目,吸引了公眾的廣泛關(guān)注。這個項目是由著名的斯坦福大學的機器學習教授Andrew Ng和在大規(guī)模計算機系統(tǒng)方面的世界頂尖專家JeffDean共同主導(dǎo),用16000個CPU Core的并行計算平臺訓練一種稱為“深度神經(jīng)網(wǎng)絡(luò)”(DNN,Deep Neural Networks)的機器學習模型(內(nèi)部共有10億個節(jié)點。這一網(wǎng)絡(luò)自然是不能跟人類的神經(jīng)網(wǎng)絡(luò)相提并論的。要知道,人腦中可是有150多億個神經(jīng)元,互相連接的節(jié)點也就是突觸數(shù)更是如銀河沙數(shù)。曾經(jīng)有人估算過,如果將一個人的大腦中所有神經(jīng)細胞的軸突和樹突依次連接起來,并拉成一根直線,可從地球連到月亮,再從月亮返回地球),在語音識別和圖像識別等領(lǐng)域獲得了巨大的成功。

項目負責人之一Andrew稱:“我們沒有像通常做的那樣自己框定邊界,而是直接把海量數(shù)據(jù)投放到算法中,讓數(shù)據(jù)自己說話,系統(tǒng)會自動從數(shù)據(jù)中學習。”另外一名負責人Jeff則說:“我們在訓練的時候從來不會告訴機器說:‘這是一只貓。’系統(tǒng)其實是自己發(fā)明或者領(lǐng)悟了“貓”的概念。”

2012年11月,微軟在中國天津的一次活動上公開演示了一個全自動的同聲傳譯系統(tǒng),講演者用英文演講,后臺的計算機一氣呵成自動完成語音識別、英中機器翻譯和中文語音合成,效果非常流暢。據(jù)報道,后面支撐的關(guān)鍵技術(shù)也是DNN,或者深度學習(DL,DeepLearning)。

用什么加快計算速度?異構(gòu)處理器

在摩爾定律的作用下,單核標量處理器的性能持續(xù)提升,軟件開發(fā)人員只需要寫好軟件,而性能就等待下次硬件的更新,在2003年之前的幾十年里,這種“免費午餐”的模式一直在持續(xù)。2003年后,主要由于功耗的原因,這種“免費的午餐”已經(jīng)不復(fù)存在。為了生存,各硬件生產(chǎn)商不得不采用各種方式以提高硬件的計算能力,以下是目前最流行的幾種方式是。

(1)讓處理器一個周期處理多條指令 ,這多條指令可相同可不同。如Intel Haswell處理器一個周期可執(zhí)行4條整數(shù)加法指令、2條浮點乘加指令,同時訪存和運算指令也可同時執(zhí)行。

(2)使用向量指令 ,主要是SIMD和VLIW技術(shù)。SIMD技術(shù)將處理器一次能夠處理的數(shù)據(jù)位數(shù)從字長擴大到128或256位,也就提升了計算能力。

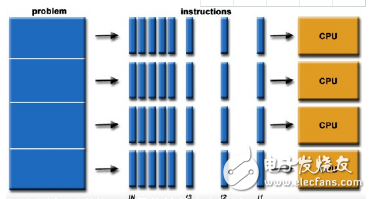

(3)在同一個芯片中集成多個處理單元 ,根據(jù)集成方式的不同,分為多核處理器或多路處理器。多核處理器是如此的重要,以至于現(xiàn)在即使是手機上的嵌入式ARM處理器都已經(jīng)是四核或八核。

(4)使用異構(gòu)處理器,不同的架構(gòu)設(shè)計的處理器具有不同的特點,如X86 處理器為延遲優(yōu)化,以減少指令的執(zhí)行延遲為主要設(shè)計考量(當然今天的X86 處理器設(shè)計中也有許多為吞吐量設(shè)計的影子);如NVIDIA GPU和AMD GPU則為吞吐量設(shè)計,以提高整個硬件的吞吐量為主要設(shè)計目標。

-

人工智能

+關(guān)注

關(guān)注

1792文章

47525瀏覽量

239265 -

異構(gòu)處理器

+關(guān)注

關(guān)注

0文章

9瀏覽量

6458 -

深度學習

+關(guān)注

關(guān)注

73文章

5510瀏覽量

121349

原文標題:如何加速深度學習?GPU、FPGA還是專用芯片

文章出處:【微信號:mcuworld,微信公眾號:嵌入式資訊精選】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

量子計算速度超快,對信息安全構(gòu)成威脅

中國首個異構(gòu)計算處理器IP核實現(xiàn) 可用于機器學習

AMD第七代APU處理器計算速度提升20%

異構(gòu)眾核系統(tǒng)高性能計算架構(gòu)

淺談國產(chǎn)異構(gòu)雙核RISC-V+FPGA處理器AG32VF407的優(yōu)勢和應(yīng)用場景

求助:ucos下和linux下 計算速度的問題

在AM3359 ICE上跑裸機程序,VFP打開后為什么會影響整數(shù)的計算速度呢?

DSP 6748計算速度慢

異構(gòu)計算在人工智能什么作用?

異構(gòu)計算的前世今生

異構(gòu)計算的兩大派別 為什么需要異構(gòu)計算?

新型全光開關(guān)可提高計算機處理器速度

AM625SIP處理器如何透過整合LPDDR4,加快開發(fā)速度

用什么加快計算速度?異構(gòu)處理器來助力

用什么加快計算速度?異構(gòu)處理器來助力

評論