1、什么是FFmpeg

FFmpeg誕生于十幾年前,最初是作為一個MPlayer播放器的一個子項目出現(xiàn)。因為當時的播放器有需要支持各種各樣解碼的需求, 其中有一位Mplayer的開發(fā)者看到了這樣的需求,于是編寫了FFmpeg。

它作為迄今為止最流行的一個開源多媒體框架之一,F(xiàn)Fmpeg有兩種基本使用方式——作為庫或者作為工具,其中后者的使用場景更多,同時它也被稱為多媒體開發(fā)的“瑞士軍刀”。FFmpeg庫中90%的代碼以上使用C,同時也有一些匯編語言上的優(yōu)化,還有一些基于GPU的優(yōu)化。對于匯編優(yōu)化而言,由于YASM對最新的CPU指令支持效果不好,F(xiàn)Fmpeg的匯編現(xiàn)在正在向NASM轉(zhuǎn)變。FFmpeg本身有一些基本的開發(fā)策略,希望所有的Codec集成在內(nèi)部庫中隨時調(diào)用;當然它也在必要時可以依賴一些外部第三方庫,例如像眾所周知的X.264。(X.264作為一個Encoder來說已經(jīng)足夠優(yōu)秀,我們可以看到大部分的商業(yè)產(chǎn)品都以X.264為對標,常會看到某某Codec宣稱比X.264好多少,似乎X.264已經(jīng)成為業(yè)內(nèi)一個基本對標點)。FFmpeg同樣也是一個跨平臺的產(chǎn)品,主要的License是GNU GPLv2,或GNU LGPLv2.1+的,講到這里我想說的是,希望大部分的使用者也能夠在項目通過聲明使用了FFmpeg這一點為開源社區(qū)帶來正面的反饋。

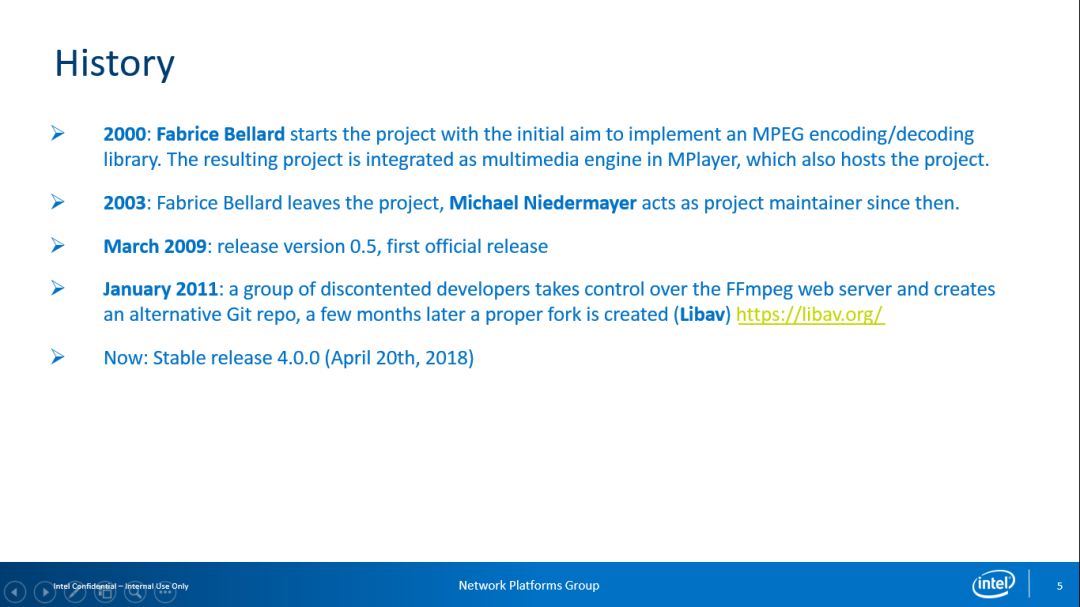

1.1 FFmpeg的發(fā)展歷史

這里需要說明的是FFmpeg與Libav之間的關系, 2011年FFmpeg社區(qū)中的一部分開發(fā)者因為某些原因脫離了FFmpeg社區(qū)并創(chuàng)立了Libav社區(qū),而后來使用Libav的大部分的發(fā)行版本又慢慢遷移回了FFmpeg。但是,直到現(xiàn)在仍有幾位脫離FFmpeg社區(qū)的主要開發(fā)者堅守在Libav,而大部分的開發(fā)者與資源都重新遷回了FFmpeg社區(qū)。現(xiàn)在FFmpeg的最新穩(wěn)定版本為2018年4月更新的v4.0.0,從v3.4.2 到最新的v4.0.0,其中最大的改進之一便是硬件加速。

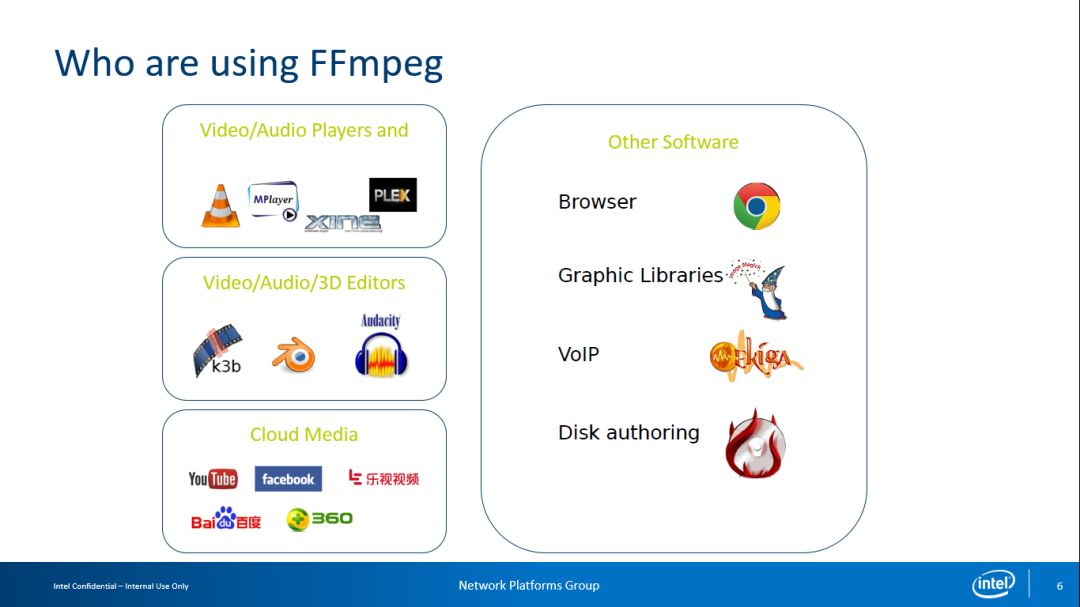

1.2使用場景

FFmpeg有很多使用場景,其中較為典型的有播放器、媒體編輯器、云轉(zhuǎn)碼等等。據(jù)我所知有上圖中左側(cè)的這些公司在以上場景中使用FFmpeg,而右側(cè)的公司則是將FFmpeg作為第三方Codec使用。

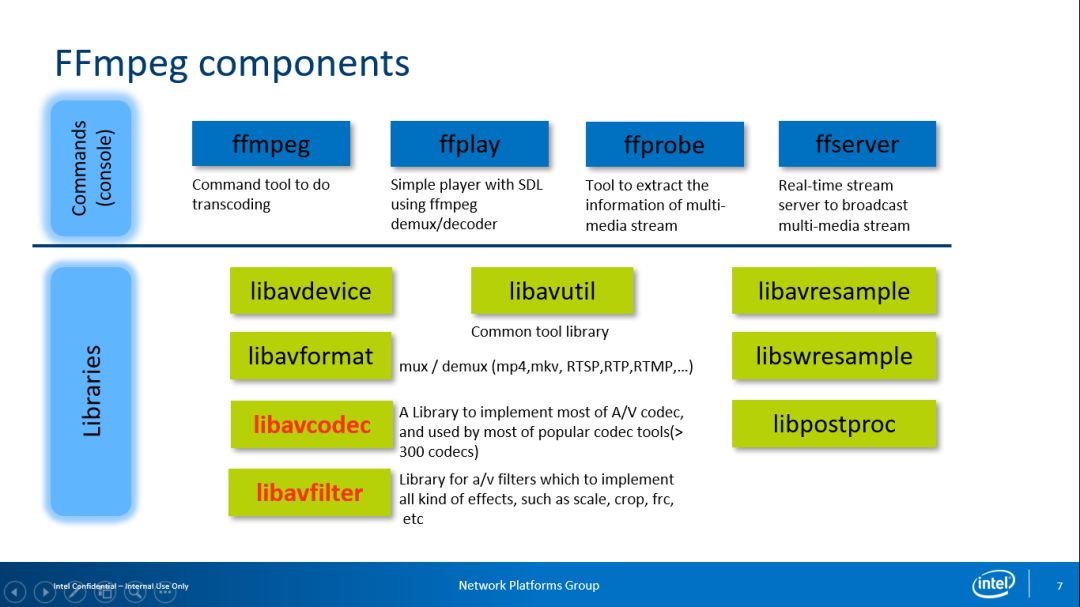

2、FFmpeg組件

關于FFmpeg組件,大家可以在網(wǎng)上查到使用FFmpeg的API編寫播放器的教程文章。FFmpeg組件中應用最多的是FFmpeg,它被用于進行轉(zhuǎn)碼,而FFprobe則被用于進行碼流分析(這些都是基于命令行的工具);而FFserver的代碼庫已經(jīng)被刪除,其最主要的原因是FFmpeg Server的維護狀態(tài)并不好,出現(xiàn)很多問題。最近社區(qū)又有人在重寫FFmpeg Server,估計不久之后代碼庫會得以恢復。但這時的FFserver的實現(xiàn)方式跟之前已經(jīng)基本沒什么關系了。在上圖中我們可以看到其中的Libavdevice主要使用硬件Capture或者進行SDI (流化),Libavformat是一些常見容器格式例如Mux或Demux等。我個人的大部分工作是在Libavcodec與Libavfilter,在Libavcodec上進行一些基于英特爾平臺的優(yōu)化,而Libavfilter主要是針對圖像的后處理。我認為在AI盛行的時代Libavfilter會出現(xiàn)非常大的改動,加入更多新功能而非僅僅基于傳統(tǒng)信號處理方式的圖像處理。最近實際上已經(jīng)有人嘗試在其中集成Super Resolution,但在性能優(yōu)化上仍有待改進,預計還需要持續(xù)一段時間才能真正做到實時與離線。除去作為基礎組件的Libavutil,其他像Libavresample、Libswresample、Libpostproc這幾個庫現(xiàn)在都有逐漸被廢棄的趨勢。

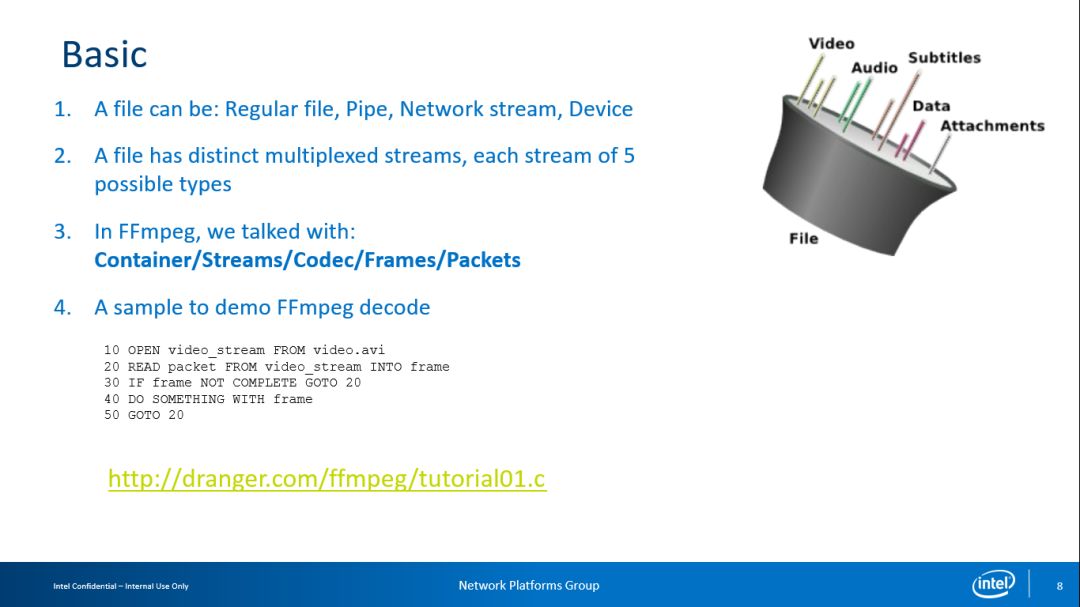

2.1 基本介紹

為什么FFmpeg會有那么高的使用量? FFmpeg和Gstreamer究竟是什么關系?我也在反復思考這些問題,為什么我會用FFmpeg而不用Gstreamer?將這個問題引申來看可能會考慮:FFmpeg適合做哪些?不適合做哪些?我想人們熱衷于使用FFmpeg的原因之一是FFmpeg的API非常簡潔。上圖是一個范例,我們可以看到只需五步就可寫出一個基本的Decoder。這個例子非常容易理解,如果能將這個例子從API到底層逐步研習其細節(jié)便可對FFmpeg有更深層的認識。

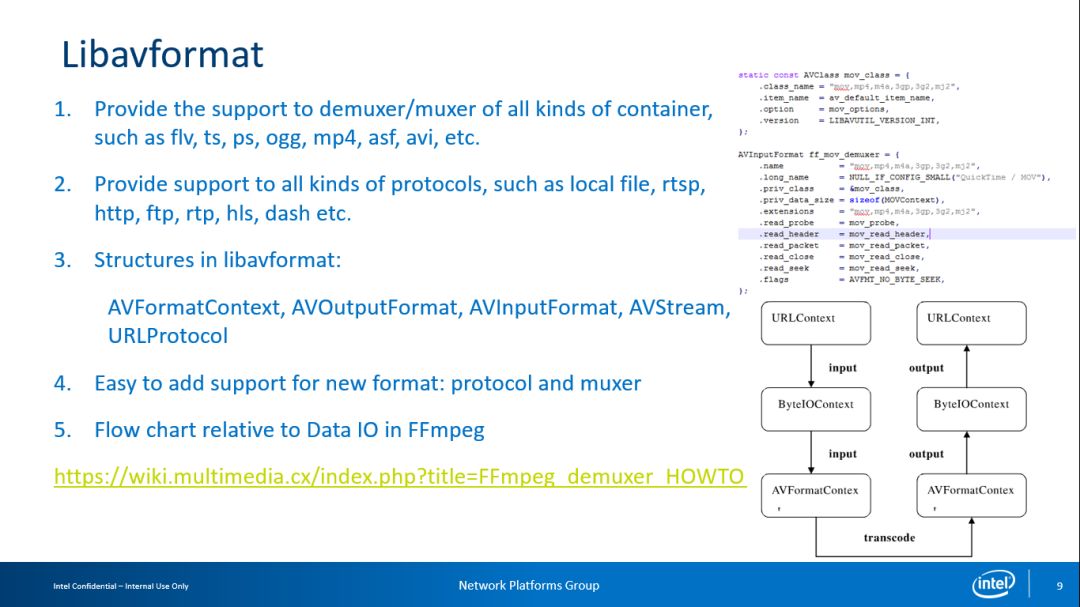

2.1.1 Libavformat

Libavformat的主要任務是Demuxer/Muxer功能。我們可以看到FFmpeg的框架設計得十分精煉,基本上如果需要實現(xiàn)一個AVFormat或AVCodec以對應新的Format/Codec;所以即使一位開發(fā)者不了解FFmpeg框架也可以編寫一個簡單的Format或Codec,需要做的最主要是實現(xiàn)對應的AVFormat/AVCodec。

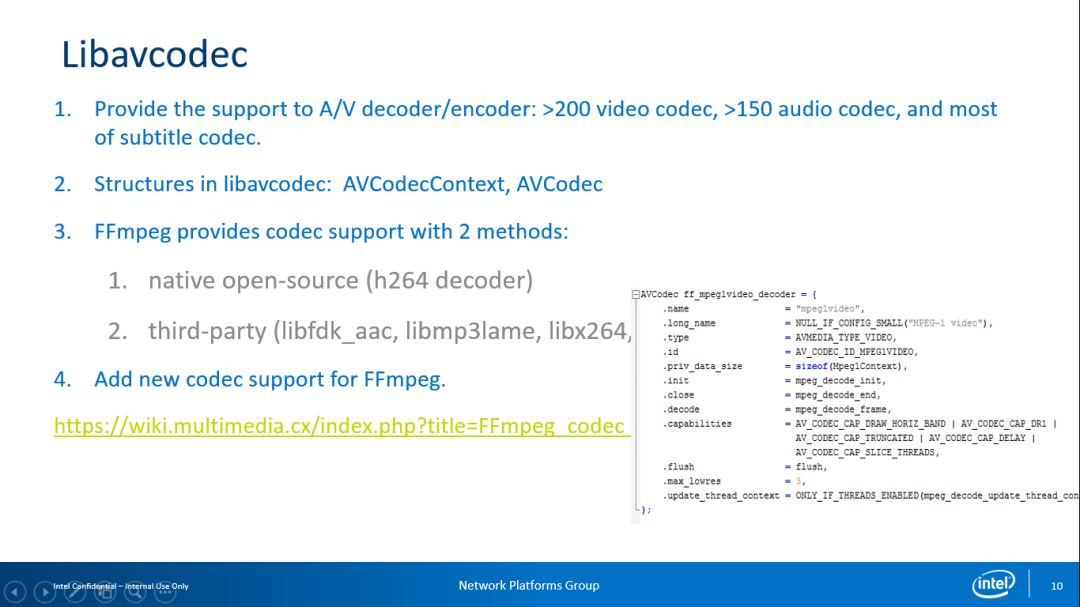

2.1.2 Libavcodec

需要提及一下的,有兩種方案實現(xiàn)對應的Libavcodec,一種是以Native方式實現(xiàn)在FFmpeg內(nèi)部,另一種是利用集成的第三方庫,我們現(xiàn)在看到的一些Encoder相關的是以集成的第三方庫為基礎。而對于Decoder ,F(xiàn)Fmpeg社區(qū)的開發(fā)者做得非常快。耐人尋味的是,據(jù)說FFmpeg內(nèi)部VP9 的Decoder速度比Google Libvpx Decoder還要快,我們知道Google是VP9 Codec的創(chuàng)立者,但是Google的表現(xiàn)還不如FFmpeg自身的VP9 的Decoder 。

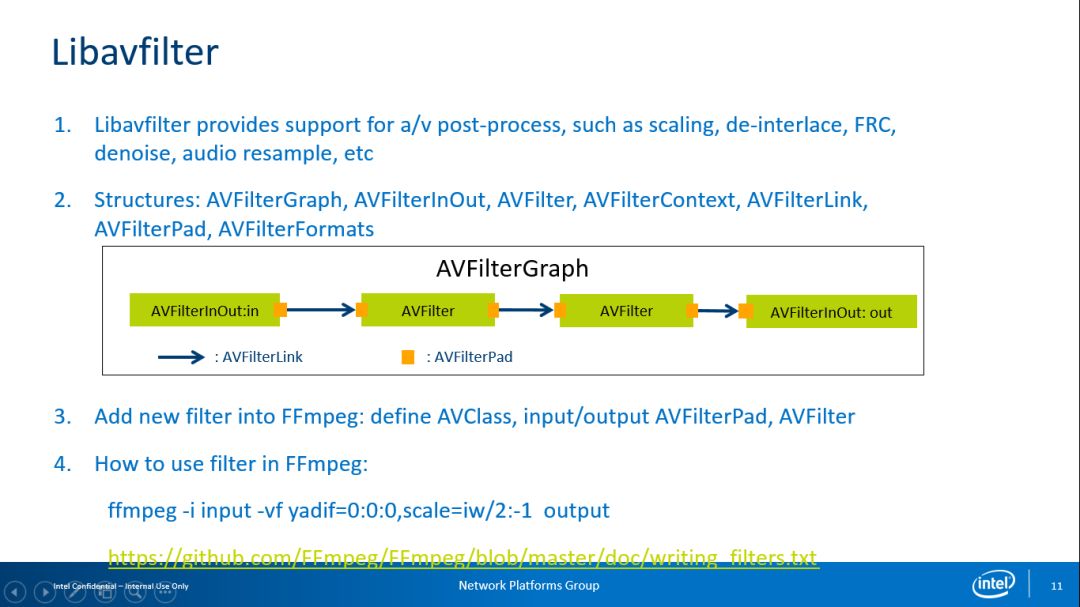

2.1.3 Libavfilter

Libavfilter是FFmpeg內(nèi)部最復雜的部分之一,其代碼一直在反復重構(gòu)。Libavfilter的思想可能借鑒了Windows 的DirectX上一些思想,但代碼卻有些復雜。其構(gòu)成并非像圖片展示的那樣是一個簡單的串行關系,實際上它可以構(gòu)成一個有向無環(huán)圖,這意味著只要能夠構(gòu)成一個DAG這個LibavFilter就能工作。但是Libavfilter的綜合表現(xiàn)并不是特別好,我一直在想嘗試對其進行改進,但因為這一部分的復雜度比較高,總是令我感覺不入其門。

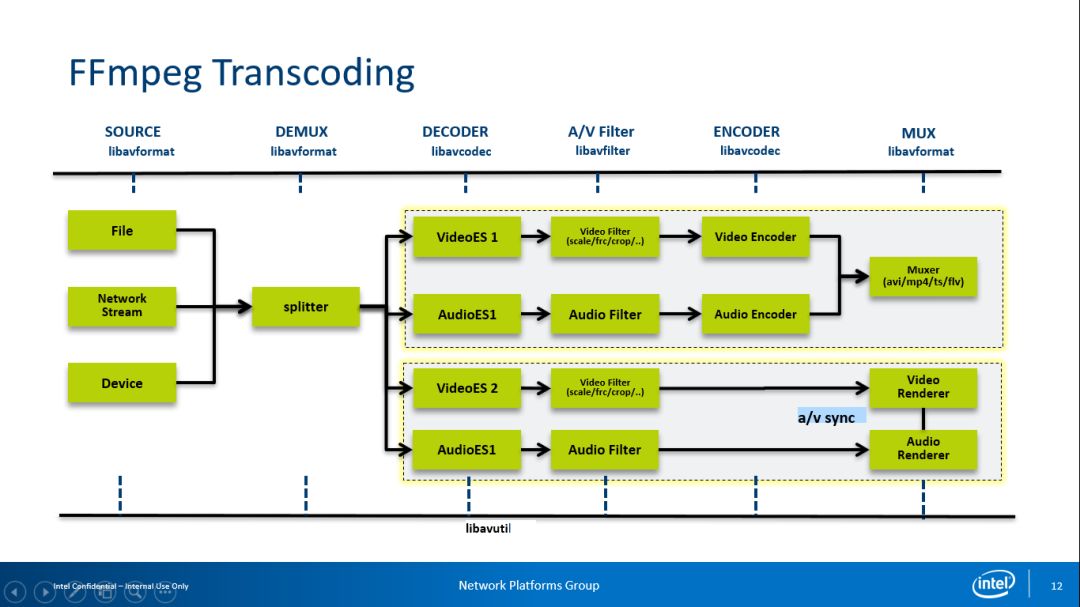

2.1.4 FFmpeg Transcoding

FFmpeg的應用場景之一是Transcoding轉(zhuǎn)碼,涉及Demux/Decoder/Encoder/Muxer,同時我們可以把Demux+Mux的流程看作是它的一個特例。另一應用場景是作為Player播放器,上圖展示了Transcoding與Player兩種應用場景的流程。

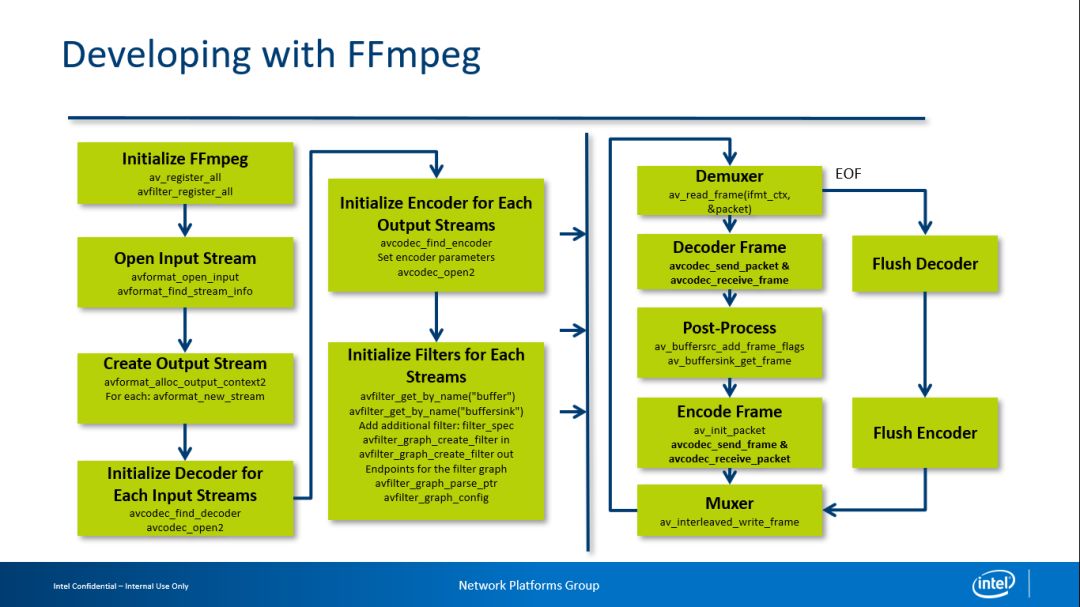

3、FFmpeg開發(fā)

FFmpeg中比較重要的API包括如何進行Decoder、Postprocess、Encoder等。如果你對此感興趣,我認為最好的辦法是去認真看一看FFmpeg里一些很好的例子。最近兩年FFmpeg把過去的API進行了重構(gòu),如果我以原來的FFmpeg API為基礎進行解碼,其做法是輸入一個已經(jīng)壓縮過的Frame數(shù)據(jù)并希望得到一個解碼的Frame,但實際上此過程存在的限制是需要確保輸入的Frame與解碼出的數(shù)據(jù)一一對應。后來隨著開發(fā)的深入,特別是H.264提供的MVC這種模式以后,有時我們輸入一個Frame后需要分左右解碼兩個幀,此時它的API便無法支持這種場景。因此最近FFmpeg的API被從輸入一個Frame輸出一個Packet修改為兩個API,這樣便可解除它們之間的耦合。當然由于輸入與解碼變成了兩個分離的步驟,導致代碼中需要大量的While循環(huán)來判斷此解碼過程是否結(jié)束。

4、硬件加速

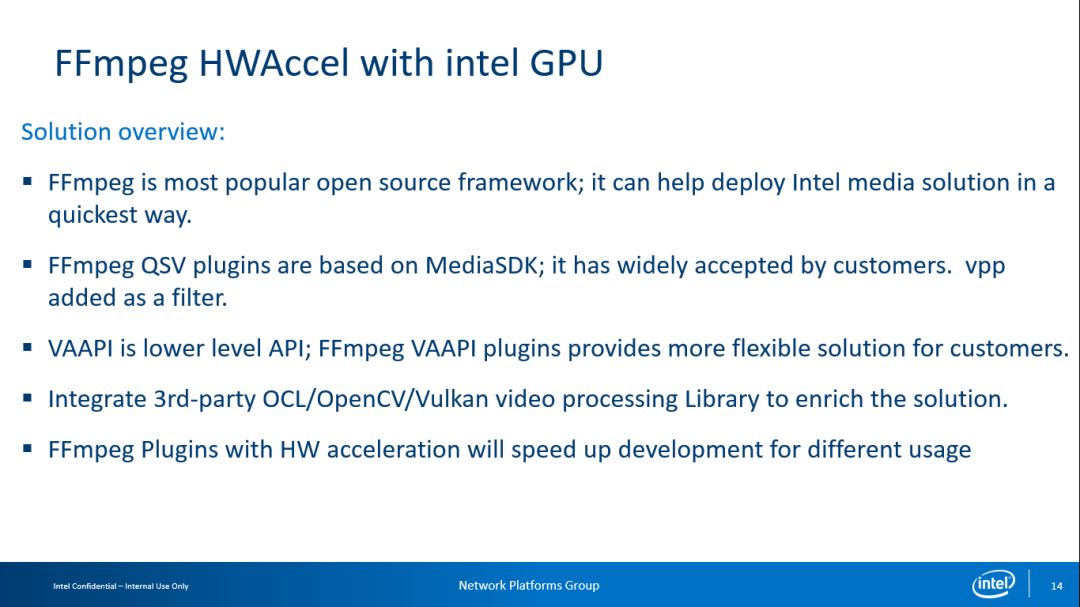

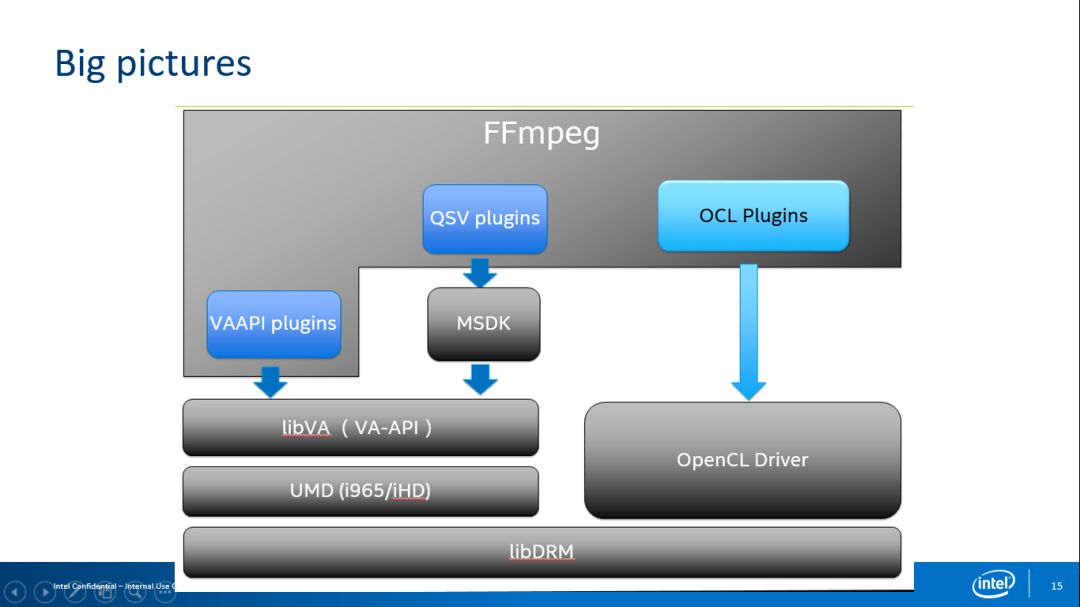

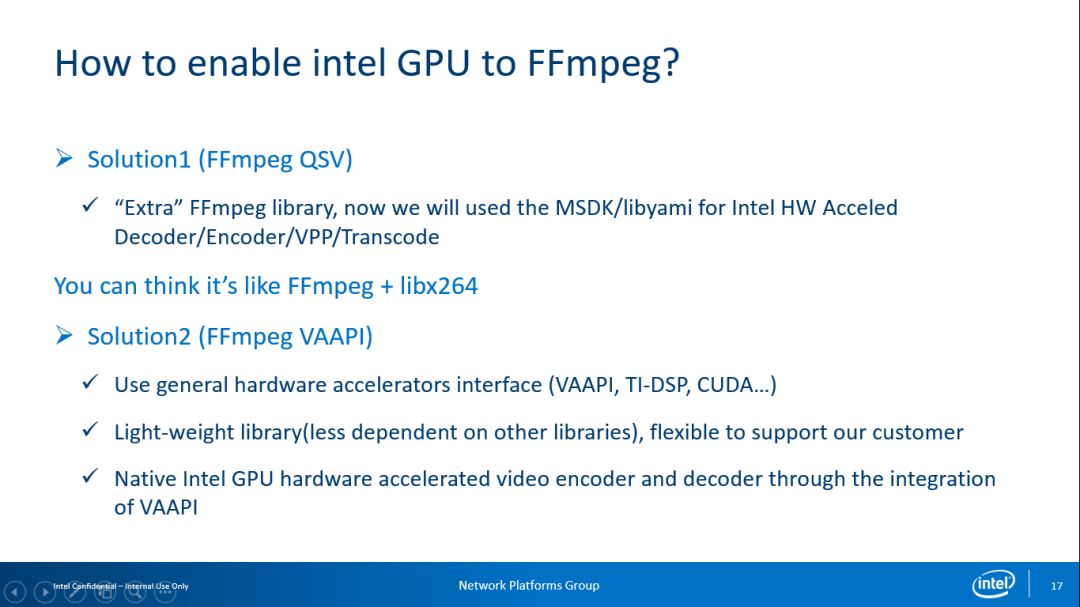

我在英特爾負責FFmpeg硬件加速的工作,因此更關注FFmpeg的硬件加速在英特爾GPU上的表現(xiàn)。我們一直在考慮如何更快地將英特爾的硬件加速方案推薦給客戶使用,讓用戶能夠有機會體驗到硬件加速的強大功能。現(xiàn)在英特爾提出的兩種通過FFmpeg驅(qū)動GPU的硬件加速方案,其中一種方案基于MediaSDK,我想如果你用過英特爾的GPU便應該會對其有所了解,已經(jīng)有很多客戶基于MediaSDk進行了部署,其中,MediaSDK的VPP部分作為AVFilter也在FFmpeg內(nèi)部;另一種更為直接的方案是VA-API,VA-API類似于Windows上提供的DXV2或是MacOS上提供的Video Toolbox等基于OS層面的底層硬件加速API,我現(xiàn)在的大部分的工作專注于此領域。FFmpeg同樣集成了OpenCL的一些加速,它使得你可以借助GPU進行轉(zhuǎn)碼工作并在整套流程中不涉及GPU與CPU的數(shù)據(jù)交換,這個方案方案會帶來明顯的性能提升。我們雖希望從解碼到VPP再到編碼的整條流程都可以在GPU內(nèi)完成,但GPU的一些功能上的缺失需要其他硬件加速功能來彌補,此時就可考慮使用OpenCL優(yōu)化。其次是因為OpenCV已經(jīng)進行了大量的OpenCL加速,所以當面對這種圖像后處理的硬件加速需求時可以考慮把OpenCV集成到FFmpeg中,但在OpenCV發(fā)展到v3.0后其API從C切換到了C++,而FFmpeg自身對C++的API支持并不友好,這也導致了FFmpeg的官方版本中只支持OpenCV到v2.4。如果你對此感興趣,可以嘗試基于在OpenCV v3.0以上的版本做一個新的C Warper,再考慮集成進FFmpeg。但如果你對性能要求足夠高,直接使用VA-API和OpenCL去做優(yōu)化,保證整個流程能夠在GPU內(nèi)部完整運行,達到最好的性能表現(xiàn)。

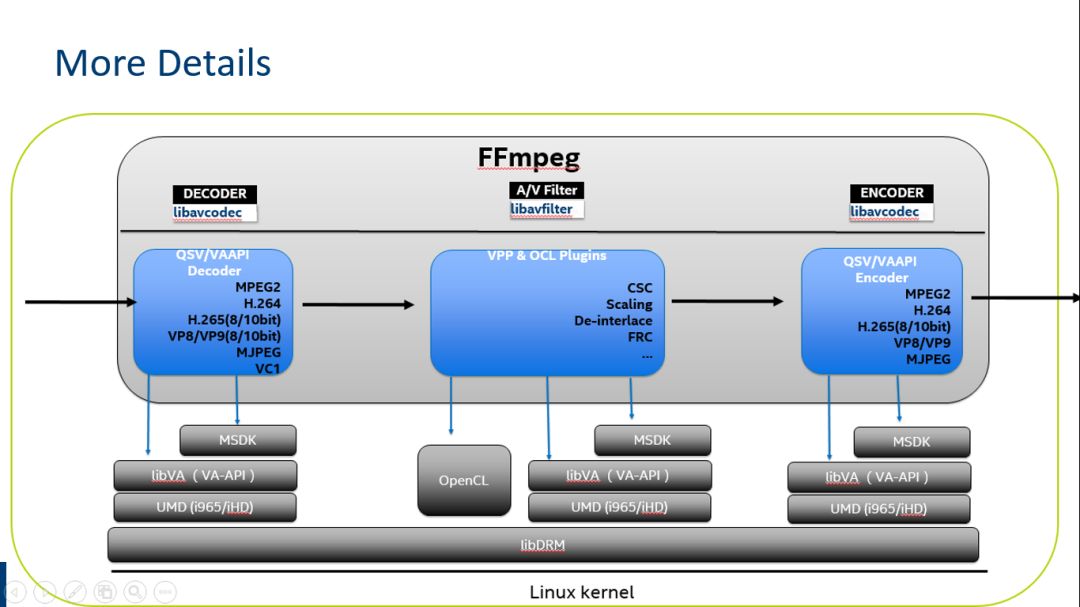

上圖是對GFFmpeg硬件加速的流程概覽圖,大部分人可能對英特爾的兩套方案有比較清晰的認識,最關鍵的點在于QSV方案依賴于MediaSDK,而VA-API則可以理解為將整個MediaSDK做的工作完整的放進了FFmpeg的內(nèi)部,與FFmpeg融為一體,F(xiàn)Fmpeg開發(fā)者與社區(qū)更推薦后者。現(xiàn)在的OCL方案最近也正不停的在有一些Patch進來,這里主要是對AVFilter的處理的過程進行硬件加速。需要說明一下,因為社區(qū)曾經(jīng)有嘗試用OpenCL加速X.264使其成為一個更快的Codec,但結(jié)果并不是特別好。所以用OpenCL去硬件加速Encoder,其整體性能提升并不是特別明顯。

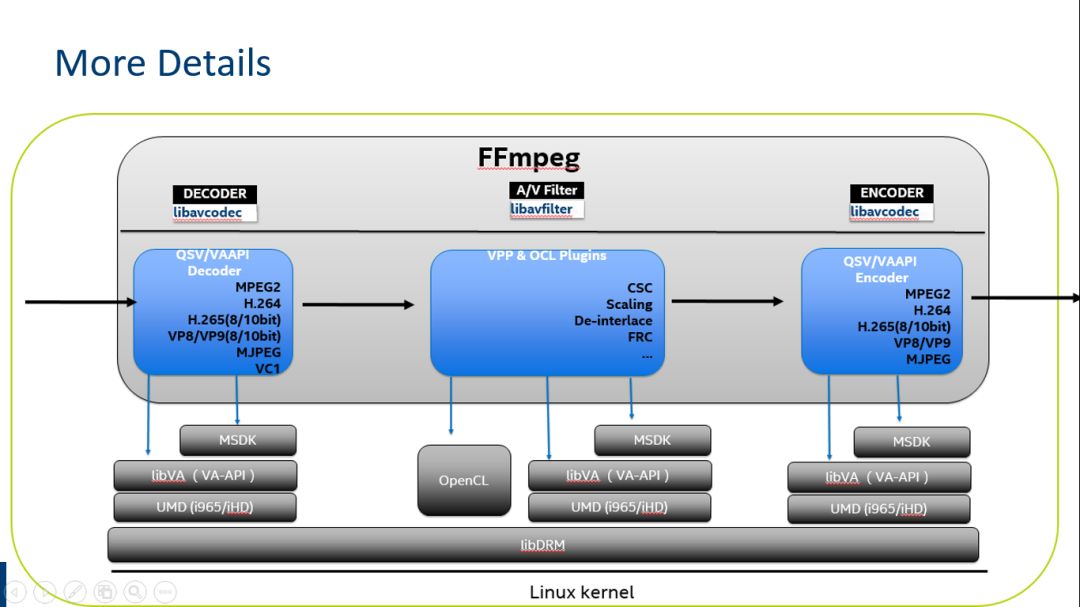

上圖展示了更多細節(jié),我們可以看到每種方案支持的Codec與VPP的功能與對應的Decoder和Encoder。

這兩種方案的差異在于實際上是QSV Call第三方的Library,而VA-API直接基于VA-API 的Interface,使用FFmpeg的Native 實現(xiàn)而并不依賴任何第三方外部庫。

VA-API

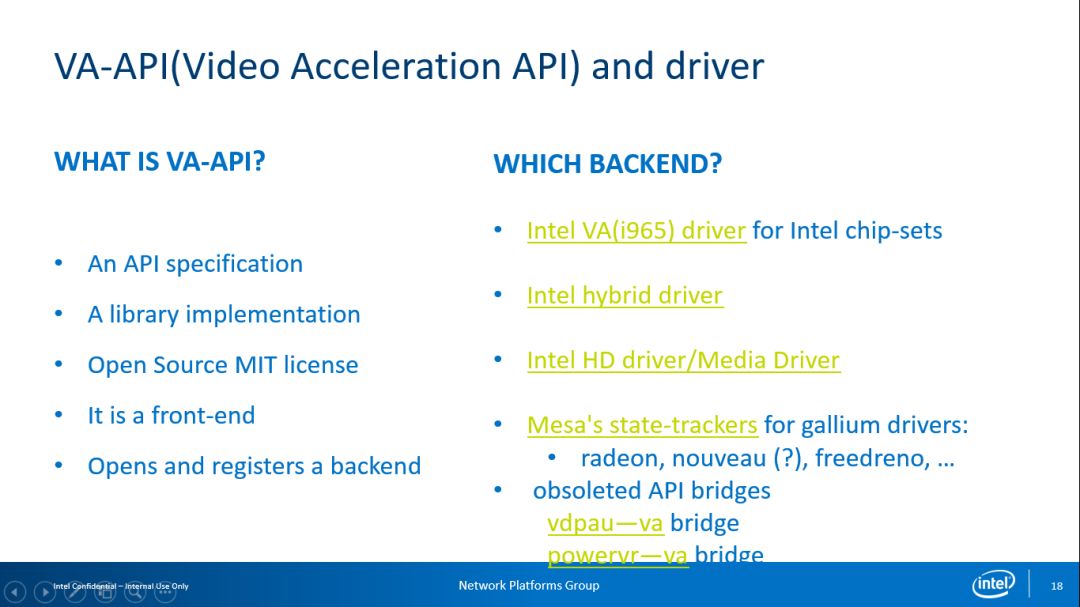

經(jīng)常會有人提出疑問:VA-API是什么?它的本質(zhì)類似于Microsoft在Windows上提出的DXVA2,也就是希望用一套抽象的接口去隱藏底層硬件細節(jié),同時又暴露底層硬件的基本能力。VA-API有多個可用后端驅(qū)動,最常見的是原先英特爾OTC提供的VA (i965)的驅(qū)動,現(xiàn)如今在Linux發(fā)行版本中也存在;而Hybird驅(qū)動則更多被用于當硬件的一些功能還沒有準備好的情景,需要先開發(fā)一個仿真驅(qū)動;等硬件部分準備完成后再使正式驅(qū)動。第三個是iHD/Media driver,這部分驅(qū)動在去年年底時Intel便已經(jīng)開源,這一套驅(qū)動對比i965驅(qū)動其圖像質(zhì)量和性能表現(xiàn)更優(yōu)但穩(wěn)定性較差。現(xiàn)在我一直在此領域工作,希望它能夠更好地支持FFmpeg。Mesa’s State-Trackers主要支持AMD的GPU,但是由于現(xiàn)在只有Decoder而Encoder處在試驗階段一直未開放,所以AMD的GPU在FFmpeg上無法進行Encoder加速。

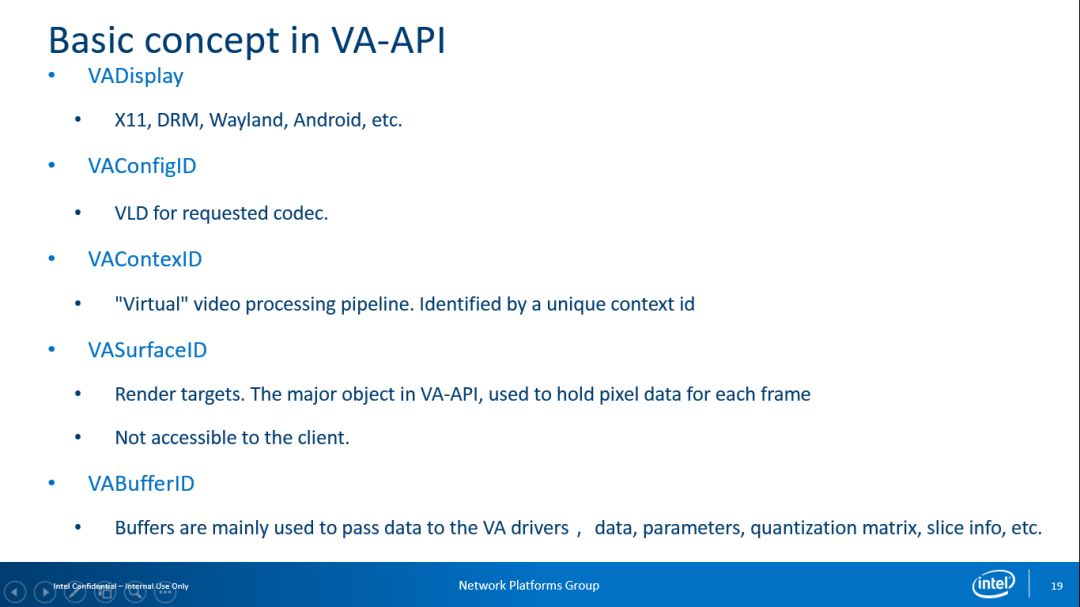

上圖是VA-API的一些基本概念,在這里我就不做過多闡述。

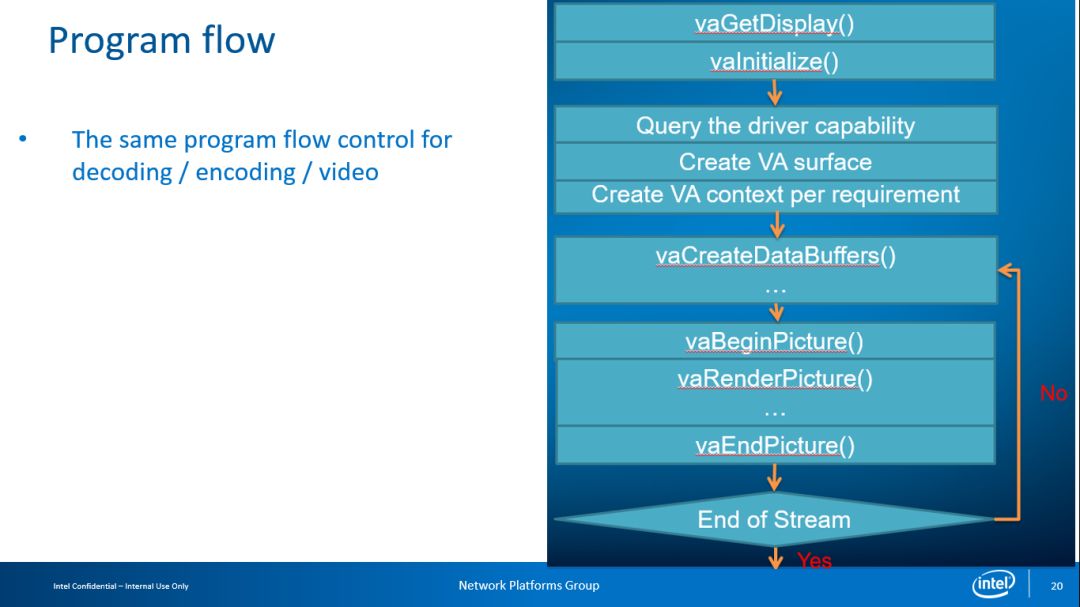

這是基于VA-API 一個基本流程。FFmpeg的VA-API也是基于此流程做的。

開放問題

FFmpeg的QSV硬件加速方案究竟有什么優(yōu)缺點?如果將 FFmpeg與GStreamer比較,什么情況下選擇FFmmpeg什么情況下選擇GStreamer,這是我一直在反反復復考慮的內(nèi)容,還有FFmpeg與OpenMAX的差別這些(Android使用了OpenMAX)。對于未來趨勢,我們期待基于FFmpeg與英特爾的GPU構(gòu)建一個全開源的解決方案,將整個開發(fā)流程透明化;在之后我們也考慮OpenCL的加速 ,順帶說一句,作為OpenCL最初的支持者的Apple,在不久前的WWDC上稱要放棄OpenCL,不過從現(xiàn)實來看,如果想在GPU或異構(gòu)上進行硬件加速開發(fā),OpenCL仍然是最優(yōu)的選擇。其他方案直到現(xiàn)在還沒有OpenCL的廣泛適應度。實際上OpenCL本身的推出并不是特別的成功,在OpenCL過去的十年發(fā)展中并沒有出現(xiàn)殺手級應用;另一個趨勢是,Vulkan作為OpenGL的后繼者開始流行,因此業(yè)界也在考慮直接把OpenCL作為Vulkan部分合并在一起。另外,OpenCV有大量的OpenCL優(yōu)化,如果你不愿意重寫OpenCL的優(yōu)化,可以考慮用FFmpeg與 OpenCV一起加速來構(gòu)建整個流程。

上圖展示了你所見的基于各個OS與硬件廠商的硬件加速狀態(tài)。大部分專注于硬件加速的開發(fā)者更關心播放器的表現(xiàn),在Windows上進行硬件編碼的需求并不強。

Q&A

Q1:FFmpeg Server最近的一些大改動是什么?

A:FFmpeg Server的代碼在最新版本的FFmpeg里已經(jīng)不存在了,主要是由于維護者并不積極。現(xiàn)在又有開發(fā)者正在重寫FFmpeg Server并且已經(jīng)Review到第三輪,我相信最快需要一兩個月它又會回到FFmpeg里面,但和以前的FFmpeg Server完全不一樣。

Q2:FFmpeg 4.0已經(jīng)有VA-API的方案嗎?

A:VA-API的Encoder從3.3.1開始支持,這部分的代碼從2016年到2018年一直在進行重構(gòu),在4.0.0時VA-API的Encoder都可以支持。屆時是一個開箱即用的狀態(tài)。

Q3:安卓平臺現(xiàn)在可以硬件加速嗎?

A:VA-API的方案是英特爾的,由于英特爾的產(chǎn)品生態(tài)緣故,安卓的解決方案是基于MediaCodec而非VA-API,其硬件加速就目前而言只有解碼加速沒有編碼加速。

Q4:后臺的多任務轉(zhuǎn)碼服務器需要用硬件來編碼,那么可以同時進行多少任務?如果根據(jù)硬件的核心數(shù)量來決定,那么超過性能極限是否會導致創(chuàng)建編碼器失敗?

A:如果是基于CPU的編碼方案,那么編碼的性能與CPU的線程數(shù)有關,而FFmpeg性能并未和CPU的核心數(shù)量構(gòu)成一個線性關系;如果是基于GPU的編碼方案,包括1對n的轉(zhuǎn)碼,這需要以官方測試為準。英特爾在官方網(wǎng)站的GPU參數(shù)有相關數(shù)據(jù),這與硬件平臺有非常大的關系,具有強大性能的硬件平臺可以保證良好的編解碼運算處理能力。

Q5:還有一個跟WebRTC相關的問題,他說這個在WebRTC 在Chrome里FFmpeg實現(xiàn)硬件加速有哪些,可以替換其他版本的FFmpeg嗎?

A:據(jù)我所知在ChromeOS中只有當自身API硬件加速不工作的情況下才會使用FFmpeg,Chrome可以說是把FFmpeg作為一個備選方案,并沒有直接用作硬件加速。

Q6:英特爾 Collabration 的客戶端SDK,支持喂數(shù)據(jù)給WebRTC的,這里硬件編碼是用的WebRTC內(nèi)部,還是自己替換的?

A:英特爾 Collabration的客戶端我不知道這個事情,在Server端采用了三套方案,一套方案是MediaSDK進行硬件加速,第二套方案是VPX以支持VP8,VP9 ,其他還有支持另外格式的方案。我無法準確推斷是否會用FFmpeg進行硬件加速與軟件解碼,之前與內(nèi)部有過相關的的交流,但最終沒有決定。

Q7:還有個問題,F(xiàn)Fmpeg有哪些Filter是使用了硬件加速,有沒有這方面的加速計劃?

A:現(xiàn)在是有這個計劃,以下圖片可以說明

現(xiàn)在已經(jīng)有一些基本的硬件加速,主要是一些ColorSpace的轉(zhuǎn)換,有一些Scaling,再就是 Deinterlace,F(xiàn)RC現(xiàn)在考慮OpenCL去做,因為 iHD driver這塊支持應當沒有了。預計更多的OpenCL會進行加速,我們希望Decoder + Filter + Encoder的整個過程都在GPU內(nèi)部運算完成從而減少CPU的性能損耗,同時也希望OpenCL具有一定的靈活度。

Q8:VA-API在Linux下支持哪些型號CPU?

A:這與驅(qū)動有關,總體來說i965支持更多的處理器,iHD支持英特爾Skylake架構(gòu)以后的處理器

Q9:如何提升硬件編解碼的質(zhì)量?

A:這是硬件編解碼方面的老大難問題,每一個做硬件編解碼的人都會提出類似的問題。因特爾曾提出了一個被稱為FEI的解決方案,其原理是僅提供GPU中與硬件加速相關的最基本功能,而像圖像質(zhì)量等方面的提升則基于搜索算法等非硬件加速功能。這就使得可以讓用戶考慮使用自己的算法,而與計算量相關的問題則交給GPU處理,但此方案并未出現(xiàn)一個特別成熟的應用。

Q10:基于CPU、GPU設置FFmpeg線程數(shù),線程數(shù)和核心數(shù)有什么對應關系?

A:其實對GPU而言處理速度已經(jīng)足夠快,運行多進程的轉(zhuǎn)碼對GPU而言基本沒有什么影響。根據(jù)實測來看,例如運行4進程的轉(zhuǎn)碼,對CPU和GPU的消耗沒有特別大的區(qū)別。但在這種情況下如果是用GPU進行,我的建議是用進程會更好管理。其次是FFmpeg自身1對n的特性使得在價格上比較敏感,這也是我們一直致力改進的重點。相信改進之后會為1對n轉(zhuǎn)碼帶來一個比較大的提升,但就目前而言仍處于內(nèi)部設計的初級階段。

-

處理器

+關注

關注

68文章

19286瀏覽量

229842 -

英特爾

+關注

關注

61文章

9964瀏覽量

171775

原文標題:FFmpeg Maintainer趙軍:FFmpeg關鍵組件與硬件加速

文章出處:【微信號:livevideostack,微信公眾號:LiveVideoStack】歡迎添加關注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關推薦

【飛凌嵌入式OK3588J-C開發(fā)板體驗】OK3588J-C開發(fā)板的ffmpeg編解碼、HDMI輸入及編碼

【米爾NXP i.MX 93開發(fā)板試用評測】03.在Debian系統(tǒng)中進行異構(gòu)通信及總結(jié)

如何移植FFmpeg

介紹FFmpeg是什么?與關于FFmpeg的問題回答

介紹FFmpeg是什么?與關于FFmpeg的問題回答

評論