一直以來,Google 就通過自研 AI 芯片以滿足其神經網絡日益增長的計算需求。北京時間昨日晚間,遠在太平洋彼岸的 GoogleCloud Next 2018 大會上,Google正式對外宣布推出 Edge TPU,一款能使傳感器和其他設備更快處理數據的 AI 專用芯片。

據了解,早在 2016 年,Google就發布了張量處理單元(Tensor Processing Unit,簡稱 TPU ),讓大家首次認識到了 AI 專用芯片的能力。

從 TPU 的一路演進上可以發現,在 2015 年 Google 才剛開始內部投入使用,2016年初代TPU版本公布時還只能做些通過數據預測的事情,2017 年第二代版本則可被用來訓練模型,甚至還能與英偉達顯卡相媲美,到今年5月第三代版本推出時,由 TPU 3.0 組成的 TPU Pod 運算陣列,性能相比上一代提升了 8 倍,可提供 100 petaflops(千萬億次) 的機器學習硬件加速.

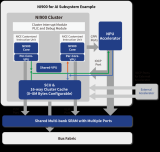

而此次 Edge TPU 的到來讓我們看到,Google 又將目光轉移到了網絡終端的無數個物聯網設備,并順勢推出了配套軟件棧 Cloud IoT Edge。

相比來說,Edge TPU 是專門為在邊緣運行TensorFlow Lite ML模型而設計,用來處理 ML 預測的微型芯片,要比訓練模型的計算強度小很多。Edge TPU 可以自己進行運算,不需要與多臺強大的計算機相連,因此應用程序可以更快、更可靠的工作。

Edge TPU開發套件:SOM和底板

在CNBC等多家外媒報道中透露,

Google 進軍“定制芯片”市場,是其試圖擴大云計算市場份額、與亞馬遜和微軟加強競爭的一種方式。自2015年以來,Google 始終在用 TPU 來加速自家數據中心的某些工作負載,而不是依賴英偉達等供應商提供的商用硬件。

接受CNBC采訪中,三星前首席技術官 Injong Rhee 則表示,Google 并沒有讓Edge TPU 與傳統芯片競爭,“這對所有硅芯片供應商和設備制造商是非常有利的”。

在他看來,Edge TPU 可能會“顛覆云計算競爭”,因為許多計算現在可以在設備上進行,而不是全部發送到數據中心。在成本和能耗方面,Google 芯片在某些類型的計算上比傳統芯片更加高效。

那么回到國內,近段時間諸多AI領域的創業企業正暗暗打造自己的AI芯片,看到Google此舉,是否有些許不安呢?

-

傳感器

+關注

關注

2552文章

51239瀏覽量

754814 -

Google

+關注

關注

5文章

1766瀏覽量

57627 -

AI芯片

+關注

關注

17文章

1894瀏覽量

35105

原文標題:Google把AI芯片裝進IoT設備,與國內造芯勢力何干?

文章出處:【微信號:rgznai100,微信公眾號:rgznai100】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

意法半導體推出面向下一代智能穿戴醫療設備的生物傳感器芯片

ADS1230怎么處理才能使信號在芯片量程范圍內?

求推薦一款處理24V的差分編碼器信號的芯片

Orin芯片與其他芯片對比

在NVIDIA Holoscan SDK中使用OpenCV構建零拷貝AI傳感器處理管線

納芯微推出一款完全集成的高隔離電流傳感器—NSM2311

智能家居、智慧工廠,AI傳感器無處不在!國內外廠商積極布局

英飛凌和盛思銳合作推出一款支持Arduino的傳感器擴展板

鼠害監測設備(傳感器技術)

NanoEdge AI的技術原理、應用場景及優勢

芯來科技正式發布首款專用處理器產品線Nuclei Intelligence系列

一款能使傳感器和其他設備更快處理數據的AI專用芯片

一款能使傳感器和其他設備更快處理數據的AI專用芯片

評論