機器學習發展至今,我們看到很多AI模型經過大量數據能畫畫、能作曲。但是現在一個“神奇”的網站可以通過你的文字生成意想不到的圖像。事情還要從大半年前的一篇論文說起。

在今年一月份發表的一篇論文中,微軟研究院的實習生們訓練了一個機器學習算法,稱為AttnGAN。這是GAN的一種變體,可以根據寫下的文字生成圖像,圖像質量是之前技術生成的圖像質量的三倍。

這項技術可以生成任意圖像,從普通的田園風光到抽象的場景,每幅圖都能將文字描述詳細地表示出來。

論文簡介

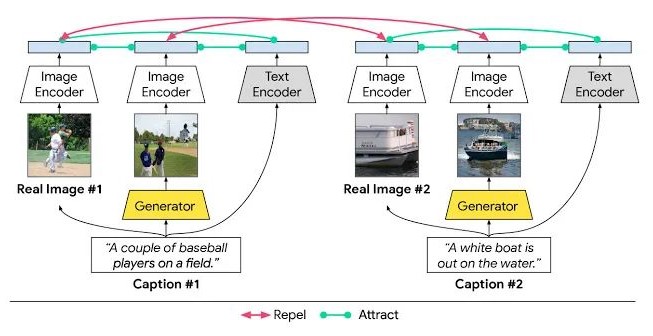

最近很多文本生成圖像的方法都是基于生成對抗網絡(GAN)的,常用方法是將完整的文本描述編寫進整個句子向量中作為圖片生成的條件。雖然已經能生成質量不錯的圖像了,但是由于句子向量缺少在詞語層面上的微調信息,GAN無法生成更高質量的圖像。這一問題在生成復雜場景時更嚴重。

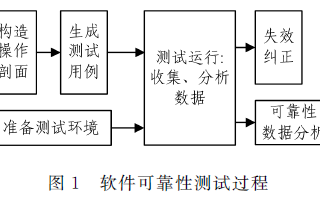

為了解決這一問題,作者提出了注意力生成對抗網絡(AttnGAN),用注意力驅動、多階段的方法對文本生成圖像的問題進行微調。AttnGAN的整體結構如圖:

模型有兩個創新元素。首先是注意力生成網絡,其中的注意力機制是通過觀察與該區域最相關的文字,生成器畫出圖像的不同部分。

更具體地說,除了將自然語言描述編碼到全局句子向量中,句中的每個單詞同樣有對應的向量。在第一階段,生成網絡利用全局句子向量生成一個低分辨率的圖像。接著,它會通過注意力層用每個區域的圖片向量查詢詞向量,從而形成一個詞-語境向量。之后,它會將區域圖像向量和對應的詞-語境向量相結合,形成一個多模態的語境向量。這就能夠在各個階段生成細節更豐富的高分辨率圖像。

該結構中的另一個重要組成部分是深度注意力多模態相似模型(DAMSM)。由于有注意力機制,DAMSM可以計算生成圖像和句子之間的相似性。所以,DAMSM對訓練生成器提供了額外的調整損失函數。

模型試驗

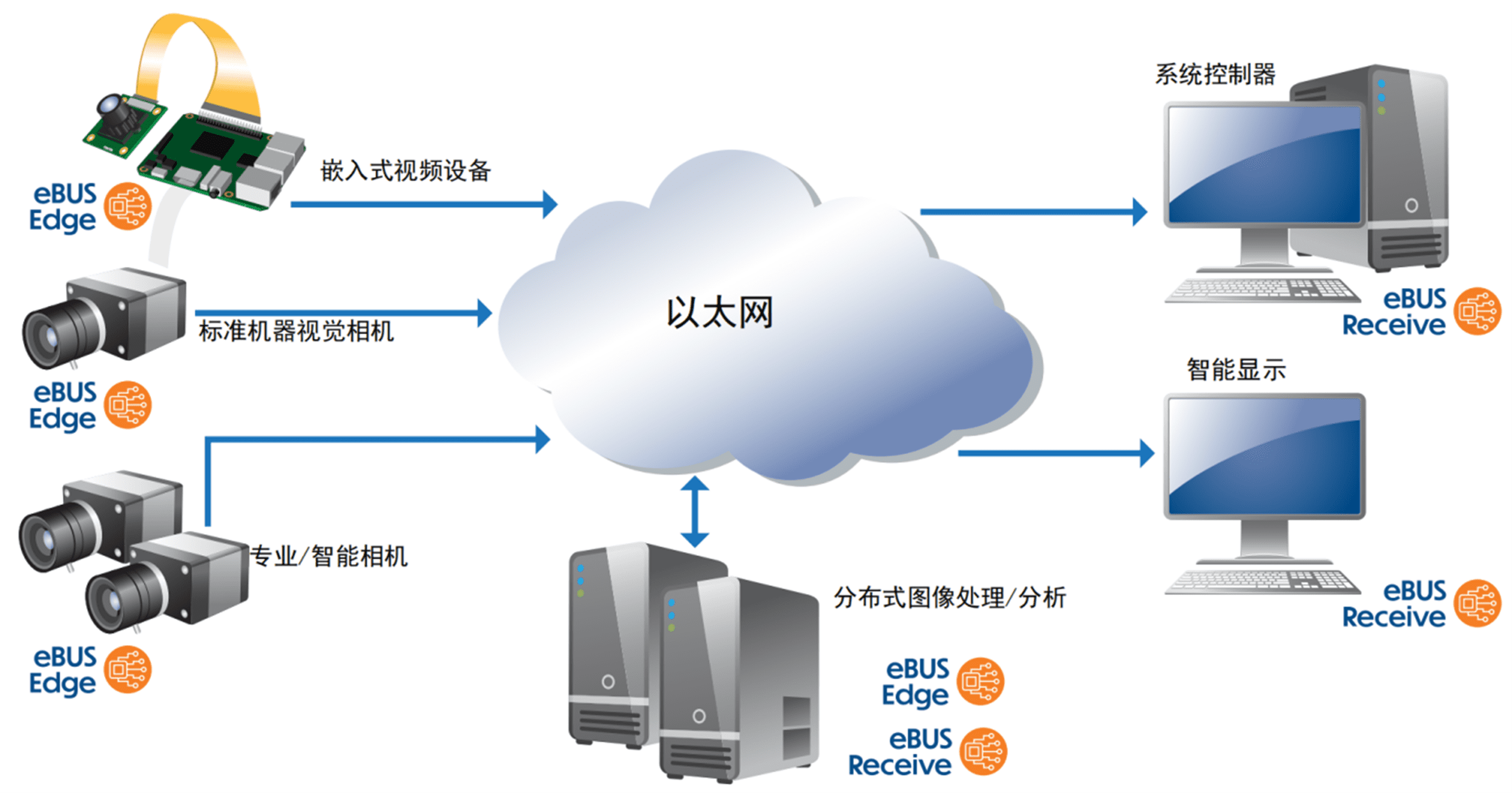

與此前的方法相同,這篇論文提出的方法也在CUB和COCO兩個數據集上測試。最終訓練的結果如下:

每個場景的第一張圖片都是AttnGAN的第一階段(G0),僅僅描繪出了場景的原始輪廓,圖像分辨率很低。基于詞向量,接下來的兩個階段(G1和G2)學習糾正前面的結果。

在CUB數據集上的生成結果

經過COCO數據集訓練的模型生成的結果,圖中的描述幾乎是不可能在現實中出現的

奇怪的方向

總的來說,AttnGAN的表現還是不錯的。但是國外一些研究者逐漸找到了新的玩法。研究者Cristóbal Valenzuela根據論文搭建了一個網站,用戶可以嘗試AttnGAN,但不同的是,訓練數據換成了更大的數據集。機器學習愛好者Janelle Shane在博客中寫道:“當把這個算法在另一個更大的、內容更多樣的數據集上訓練后,生成的圖片難以符合文字描述(并且變得非常奇怪)。”例如下面這個例子,同樣的一句話,用原始模型生成的圖片是這樣的:

然而換了訓練數據集后:

這是……什么?由于在更大的數據集上訓練過,所以當GAN要畫出我要求的內容時,它要搜索的圖像就更多,問題也變得廣泛。不僅僅在小鳥的生成上有限制,在生成人像上也會出現bug,例如下圖:

這個表現得就很糟了,根本分不清哪里是人臉。其他類似的還有很多,完全就是超現實主義作品。

Janelle Shane表示:“這個demo非常有趣,它也體現了目前先進的圖像識別算法是如何理解圖像和文字的。它們如何理解’狗’或’人類’?在2D圖像中,算法看到的人指向前方和側面是完全不同的。”

對于這一結果,AttnGAN論文的作者Tao Xu也給予了回復。Xu目前是美國理海大學一名研究生,她認為這是對論文結果的重要改進:

“隨著深度學習的快速發展,計算機視覺系統非常強大。例如它們可以從醫學影像中診斷疾病、在自動駕駛系統中定位行人和汽車。但是,我們仍然不能認為這些系統完全理解了它們所看到的東西。因為,如果機器真的擁有了智慧,它們不會僅識別圖像,而是可以生成圖像。

我們的AttnGAN將注意力機制和生成對抗網絡結合了起來,大大提高了文本生成圖像的模型性能。由于注意力是人類特有的概念,我們的AttnGAN就能學習這種”智慧“,像人類一樣畫畫,即注意相關詞語以及相關圖像區域。

雖然AttnGAN比之前的文本到圖像的模型表現得更好,但是生成多種“現實畫風”的物體對整個領域還是待解決的問題。我們希望未來在這一方向進行更多研究。”

-

機器學習

+關注

關注

66文章

8421瀏覽量

132703 -

數據集

+關注

關注

4文章

1208瀏覽量

24716 -

自然語言

+關注

關注

1文章

288瀏覽量

13355

原文標題:雖然很驚悚,但這個AI靈魂畫手真的很努力了

文章出處:【微信號:jqr_AI,微信公眾號:論智】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

六月,帶你品味合心鎮的合心瓜,享受田園采摘生活

點陣式液晶任意圖片顯示的實現

MAX4455 任意圖形隨屏顯示視頻發生器

紅外場景仿真在導引頭圖像實時生成中的應用

GAN在圖像生成應用綜述

一種結合回復生成的對話意圖預測模型

一種基于改進的DCGAN生成SAR圖像的方法

AIGC最新綜述:從GAN到ChatGPT的AI生成歷史

基于文本到圖像模型的可控文本到視頻生成

一鍵解鎖:將任意圖像設備秒變GigE Vision設備的終極秘訣

AttnGAN可以生成任意圖像,從普通的田園風光到抽象的場景

AttnGAN可以生成任意圖像,從普通的田園風光到抽象的場景

評論