目前的機(jī)器翻譯模型基于編碼器-解碼器系統(tǒng)結(jié)構(gòu),本文提出了一種名為“普適注意力”的新翻譯模型,用2D卷積網(wǎng)絡(luò)做序列預(yù)測(cè),無論長(zhǎng)句短句翻譯結(jié)果都更好,使用的參數(shù)也更少。實(shí)驗(yàn)表明,新模型的總體表現(xiàn)優(yōu)于目前最出色的解碼器-編碼器模型系統(tǒng)。

目前,最先進(jìn)的機(jī)器翻譯系統(tǒng)基于編碼器-解碼器架構(gòu),首先對(duì)輸入序列進(jìn)行編碼,然后根據(jù)輸入編碼生成輸出序列。兩者都與注意機(jī)制接口有關(guān),該機(jī)制基于解碼器狀態(tài),對(duì)源令牌的固定編碼進(jìn)行重新組合。

本文提出了一種替代方法,該方法于跨兩個(gè)序列的單個(gè)2D卷積神經(jīng)網(wǎng)絡(luò)。網(wǎng)絡(luò)的每一層都根據(jù)當(dāng)前的輸出序列重新編碼源令牌。因此,類似注意力的屬性在整個(gè)網(wǎng)絡(luò)中普遍存在。我們的模型在實(shí)驗(yàn)中表現(xiàn)出色,優(yōu)于目前最先進(jìn)的編碼器-解碼器系統(tǒng),同時(shí)在概念上更簡(jiǎn)單,參數(shù)更少。

“普適注意力”模型及原理

我們的模型中的卷積層使用隱性3×3濾波器,特征僅根據(jù)先前的輸出符號(hào)計(jì)算。圖為經(jīng)過一層(深藍(lán)色)和兩層(淺藍(lán)色)計(jì)算之后的感受野,以及正常3×3濾波器(灰色)的視野的隱藏部分。

上圖為具有兩個(gè)隱藏層的解碼器網(wǎng)絡(luò)拓?fù)涞膱D示,底部和頂部的節(jié)點(diǎn)分別表示輸入和輸出。水平方向連接用于RNN,對(duì)角線方向連接用于卷積網(wǎng)絡(luò)。在兩種情況下都會(huì)使用垂直方向的連接。參數(shù)跨時(shí)間步長(zhǎng)(水平方向)共享,但不跨層(垂直方向)共享。

塊級(jí)(頂部)和每個(gè)塊(底部)內(nèi)的DenseNet體系結(jié)構(gòu)

令牌嵌入大小、層數(shù)(L)和增長(zhǎng)率(g)的影響

無論是長(zhǎng)句、短句,翻譯結(jié)果都更好

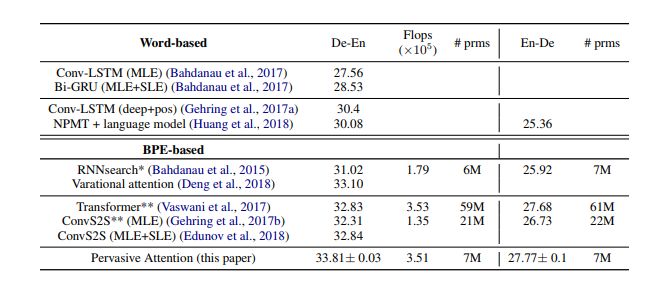

與現(xiàn)有最佳技術(shù)的比較

我們將結(jié)果與表3中的現(xiàn)有技術(shù)進(jìn)行了比較,包括德-英翻譯(De-En)和英-德翻譯(En-De)。我們的模型名為Pervasive Attention。除非另有說明,我們使用最大似然估計(jì)(MLE)訓(xùn)練所有模型的參數(shù)。對(duì)于一些模型,我們會(huì)另外報(bào)告通過序列水平估計(jì)(SLE,如強(qiáng)化學(xué)習(xí)方法)獲得的結(jié)果,我們通常直接針對(duì)優(yōu)化BLEU量度,而不是正確翻譯的概率。

在不同句子序列長(zhǎng)度上的表現(xiàn)

在上圖中,我們將翻譯質(zhì)量視為句子長(zhǎng)度的函數(shù),并將我們的模型與RNNsearch、ConvS2S和Transformer進(jìn)行比較。結(jié)果表明,我們的模型幾乎在所有句子長(zhǎng)度上都得到了最好的結(jié)果,ConvS2S和Transformer只在最長(zhǎng)的句子上表現(xiàn)更好。總的來說,我們的模型兼?zhèn)銻NNsearch在短句中的強(qiáng)大表現(xiàn),同時(shí)也接近ConvS2S和Transformer在較長(zhǎng)句子上的良好表現(xiàn)。

隱性的句子對(duì)齊

上圖所示為最大池化運(yùn)算符在我們的模型中生成的隱式句子對(duì)齊。作為參考,我們還展示了我們的模型使用的“自我注意力”產(chǎn)生的對(duì)齊。可以看到,兩種模型都成功定性地模擬了隱性的句子對(duì)齊。

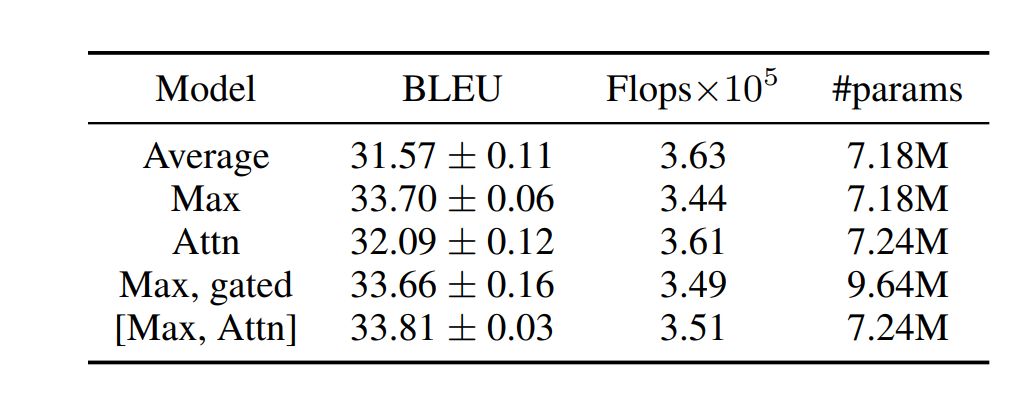

我們的模型(L = 24,g = 32,ds = dt = 128),具有不同的池化操作符,使用門控卷積單元

在不同的濾波器尺寸k和深度L下,我們的模型(g = 32,ds = dt = 128)的表現(xiàn)。

與IWSLT德語(yǔ)-英語(yǔ)翻譯模型的最新結(jié)果的比較。

(*):使用我們的實(shí)現(xiàn)獲得的結(jié)果(**):使用FairSeq獲得的結(jié)果。

脫離編碼器-解碼器范式,用DenseNet作機(jī)器翻譯

我們提出了一種新的神經(jīng)機(jī)器翻譯架構(gòu),該架構(gòu)脫離了編碼器-解碼器范例。我們的模型將源序列和目標(biāo)序列聯(lián)合編碼為深度特征層次結(jié)構(gòu),其中源令牌嵌入到部分目標(biāo)序列的上下文中。沿源維度對(duì)此聯(lián)合編碼進(jìn)行最大池化,將相關(guān)要素映射到下一個(gè)目標(biāo)令牌的預(yù)測(cè)。該模型實(shí)現(xiàn)基于DenseNet的2D CNN。

由于我們的模型會(huì)結(jié)合語(yǔ)境,對(duì)每一層當(dāng)前生成的目標(biāo)序列的輸入令牌重新編碼,因此該模型網(wǎng)絡(luò)構(gòu)造的每層中都具有“類似注意力”(attention-like)的屬性。

因此,添加明確的“自注意模塊”具有非常有限、但十分積極的效果。然而,我們模型中的最大池化運(yùn)算符生成的隱式句子對(duì)齊,在性質(zhì)上與注意力機(jī)制生成的對(duì)齊類似。我們?cè)贗WSLT'14數(shù)據(jù)集上評(píng)估了我們的模型,將德-英雙語(yǔ)互譯。

我們獲得的BLEU分?jǐn)?shù)與現(xiàn)有最佳方法相當(dāng),我們的模型使用的參數(shù)更少,概念上也更簡(jiǎn)單。我們希望這一成果可以引發(fā)對(duì)編碼器-解碼器模型的替代方案的興趣。在未來,我們計(jì)劃研究混合方法,其中聯(lián)合編碼模型的輸入不是由嵌入向量提供的,而是1D源和目標(biāo)嵌入網(wǎng)絡(luò)的輸出。

未來我們還將研究如何該模型來跨多語(yǔ)種進(jìn)行翻譯。

-

濾波器

+關(guān)注

關(guān)注

161文章

7853瀏覽量

178504 -

編碼器

+關(guān)注

關(guān)注

45文章

3655瀏覽量

134874 -

機(jī)器翻譯

+關(guān)注

關(guān)注

0文章

139瀏覽量

14917

原文標(biāo)題:機(jī)器翻譯新突破!“普適注意力”模型:概念簡(jiǎn)單參數(shù)少,性能大增

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

卷積神經(jīng)網(wǎng)絡(luò)模型發(fā)展及應(yīng)用

探索一種降低ViT模型訓(xùn)練成本的方法

北大研究者創(chuàng)建了一種注意力生成對(duì)抗網(wǎng)絡(luò)

一種新的神經(jīng)機(jī)器翻譯架構(gòu),它脫離了編碼器-解碼器的范疇

循環(huán)神經(jīng)網(wǎng)絡(luò)卷積神經(jīng)網(wǎng)絡(luò)注意力文本生成變換器編碼器序列表征

基于注意力機(jī)制的深度學(xué)習(xí)模型AT-DPCNN

一種注意力增強(qiáng)的自然語(yǔ)言推理模型aESIM

融合雙層多頭自注意力與CNN的回歸模型

基于深度圖注意力卷積CNN的三維模型識(shí)別方法

基于多層CNN和注意力機(jī)制的文本摘要模型

基于循環(huán)卷積注意力模型的文本情感分類方法

基于視覺注意力的全卷積網(wǎng)絡(luò)3D內(nèi)容生成方法

基于注意力機(jī)制等的社交網(wǎng)絡(luò)熱度預(yù)測(cè)模型

一種新的深度注意力算法

一種基于因果路徑的層次圖卷積注意力網(wǎng)絡(luò)

一種名為“普適注意力”的新翻譯模型,用2D卷積網(wǎng)絡(luò)做序列預(yù)測(cè)

一種名為“普適注意力”的新翻譯模型,用2D卷積網(wǎng)絡(luò)做序列預(yù)測(cè)

評(píng)論