藝術(shù)風(fēng)格轉(zhuǎn)換算得上是AI最有趣的應(yīng)用之一了,你可以將梵高的名畫風(fēng)格添加到自己的照片中,也可以個(gè)自己的頭像來一幅映像派的油畫。它同時(shí)處理風(fēng)格圖像和內(nèi)容圖像來進(jìn)行合成,使得生成的結(jié)果在保持了內(nèi)容的前提下獲得了風(fēng)格圖像的質(zhì)感與美學(xué)特征。但目前的算法模型實(shí)現(xiàn)比較龐大,同時(shí)會(huì)消耗很大的計(jì)算資源,在一定程度上限制了人工智能對(duì)于美的創(chuàng)造。

近日,來自英偉達(dá)的研究人員與加州大學(xué)默塞德分校的研究人員們共同提出了一種新的風(fēng)格遷移算法,不僅大幅提高了風(fēng)格遷移的效率,同時(shí)實(shí)現(xiàn)了任意圖片的風(fēng)格轉(zhuǎn)換,這使得AI對(duì)于圖像的創(chuàng)造邁向了更廣闊的天地。

對(duì)于提供的隨機(jī)圖片,這一算法可以將參考圖片中的任意風(fēng)格進(jìn)行抽取并基于內(nèi)容圖片進(jìn)行合成輸出。近來的任意風(fēng)格轉(zhuǎn)換算法主要通過內(nèi)容圖片特征與預(yù)先計(jì)算得到的轉(zhuǎn)化矩陣相乘。但這些算法十分消耗計(jì)算,同時(shí)合成的圖像有時(shí)也不盡如人意。為了解決這些問題,研究人員們從理論上得到了遷移矩陣的表達(dá)形式,并給出了一種利用兩個(gè)輕型的卷積神經(jīng)網(wǎng)絡(luò)來學(xué)習(xí)獲取任意遷移矩陣的方法,這種基于學(xué)習(xí)的遷移矩陣可以通過不同層次的風(fēng)格損失來控制,在保持內(nèi)容圖像的情況下靈活地結(jié)合多層次風(fēng)格。同時(shí),算法的實(shí)現(xiàn)具有很高的效率。

這一工作的主要貢獻(xiàn)在于以下三個(gè)方面:

1.提出了一種線性遷移的通用方法,其優(yōu)化過程同時(shí)可以最小化風(fēng)格重建損失;

2.提出了一種速度高達(dá)140fps的遷移矩陣學(xué)習(xí)方法,可靈活的在單一遷移矩陣中結(jié)合多層次風(fēng)格,并在遷移過程中保持內(nèi)容特征;

3.基于上述靈活性,這一方法可以廣泛用于包括美學(xué)風(fēng)格遷移、視頻圖像實(shí)際風(fēng)格遷移以及領(lǐng)域遷移等很多任務(wù)中。

在這一研究中,研究人員提出的模型包括兩個(gè)前向卷積網(wǎng)絡(luò)、一個(gè)對(duì)稱的編碼、解碼圖像重建結(jié)構(gòu)以及遷移學(xué)習(xí)模塊和損失模塊等四個(gè)部分。

其中編碼器和解碼器主要用于重建輸入的圖像,事先訓(xùn)練好后就固定下來作為網(wǎng)絡(luò)的基礎(chǔ)用于后續(xù)的訓(xùn)練過程。(編碼器用于抽取輸入圖像中的特征,分別對(duì)內(nèi)容和風(fēng)格圖像提取特征圖Fc,F(xiàn)s,而解碼器則用于從抽取重建圖像。)

遷移模塊主要包含了兩個(gè)小卷積網(wǎng)絡(luò),用于從前面的編碼器輸出中抽取特征,并輸出遷移矩陣T. 隨后圖像遷移通過內(nèi)容圖像與遷移矩陣的線性乘法來實(shí)現(xiàn),隨后利用解碼其重建合成圖像。在網(wǎng)絡(luò)的最后,一個(gè)與訓(xùn)練并固定的VGG-19網(wǎng)絡(luò)用于計(jì)算多層次的風(fēng)格損失以及內(nèi)容損失。整個(gè)網(wǎng)絡(luò)是純粹的前向傳播卷積神經(jīng)網(wǎng)絡(luò),對(duì)于GPU的運(yùn)算十分友好,可以實(shí)現(xiàn)高達(dá)140fps的高效率風(fēng)格遷移。

在網(wǎng)絡(luò)中,只有藍(lán)色的壓縮和解壓模塊,以及綠色的遷移單元是可以學(xué)習(xí)的,而其他的模塊都是固定的。

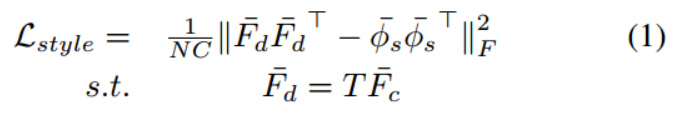

研究人員先從理論上探討了風(fēng)格轉(zhuǎn)換、學(xué)習(xí)轉(zhuǎn)換矩陣的模型、高效計(jì)算的模型以及無損風(fēng)格轉(zhuǎn)換的表達(dá)。對(duì)于風(fēng)格轉(zhuǎn)換來說,其目標(biāo)就是最小化遷移后的特征Fc和期望的虛擬特征phis之間的中心協(xié)方差,所以風(fēng)格損失函數(shù)可以寫為下面的形式:

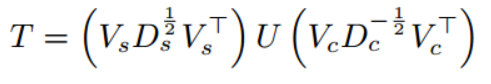

但絕對(duì)值中的兩項(xiàng)差為0時(shí)可以實(shí)現(xiàn)最小化。同時(shí)可以利用線性約束和分解計(jì)算出風(fēng)格遷移矩陣T,

其主要用內(nèi)容和特征圖像的特征的協(xié)方差決定的。為了計(jì)算出T,需要選擇合適的模型來進(jìn)行學(xué)習(xí)。

T矩陣是由內(nèi)容和風(fēng)格圖像共同決定的,研究人員認(rèn)為一種可能的方法便是利用神經(jīng)網(wǎng)絡(luò)同時(shí)將輸入的兩張圖像轉(zhuǎn)換為C*C的T矩陣輸出。在這一工作中,主要利用了兩個(gè)相互隔離的CNNs來實(shí)現(xiàn)。為了獲取這一輸出,其輸入包含了三種不同的形式:內(nèi)容和風(fēng)格圖像、內(nèi)容和風(fēng)格特征圖、內(nèi)容和風(fēng)格特征圖的協(xié)方差。下圖是三種不同輸入的情況下的風(fēng)格轉(zhuǎn)換結(jié)果,可以看到將編碼器特征圖的協(xié)方差作為全連接輸入進(jìn)行風(fēng)格遷移的效果更好:

研究人員選擇了利用協(xié)方差來生成C*C的中間矩陣,隨后得到T矩陣。首先T矩陣與輸入的維數(shù)不相干,并在不同分辨率下保持一致。同時(shí)需要全連接層在卷積的頂部進(jìn)行處理。利用協(xié)方差作為模型的輸出將對(duì)更一般地風(fēng)格遷移得到更好的結(jié)果。

為了實(shí)現(xiàn)高效的模型,研究人員們將以往算法中耗時(shí)的矩陣分解工作用前向網(wǎng)絡(luò)代替,將耗時(shí)的計(jì)算從GPU中移除。研究顯示T可以通過CNNs模塊和一個(gè)全連接層方便的訓(xùn)練得到。同時(shí)利用學(xué)習(xí)的方法得到了包含多層次特征單個(gè)T矩陣。T可以通過與不同風(fēng)格重建損失的結(jié)合來實(shí)現(xiàn)豐富的表達(dá)。

基于線性遷移的風(fēng)格轉(zhuǎn)換還具有較強(qiáng)的內(nèi)容保留特性,通過這種特性和淺層自編碼器,可以實(shí)現(xiàn)較好的無失真圖像遷移。保證了在風(fēng)格遷移的過程中內(nèi)容圖像的內(nèi)容不會(huì)產(chǎn)生畸變。

在深入研究了各個(gè)方面后,研究人員按照前述的架構(gòu)構(gòu)建了神經(jīng)網(wǎng)絡(luò),并在不同任務(wù)上進(jìn)行了驗(yàn)證。其數(shù)據(jù)集來自于MS-COCO和WikiArt進(jìn)80000張圖像。利用Pytorch在TitanXP上訓(xùn)練需要約2小時(shí)。下圖是本文提出算法與不同算法的比較結(jié)果:

其中視頻和照片的實(shí)際場(chǎng)景風(fēng)格遷移,將拍攝到的圖像遷移到期望的場(chǎng)景中區(qū),具有十分廣闊的應(yīng)用,這將會(huì)生成更為有效的濾鏡和產(chǎn)品。

研究人員表示這將給內(nèi)容生產(chǎn)者提供更多的創(chuàng)意,并將在實(shí)際生活中產(chǎn)生更多有趣的應(yīng)用,將周圍的場(chǎng)景實(shí)時(shí)渲染成期望的樣子。

最后,研究人員們還驗(yàn)證了這種方法在不同領(lǐng)域間遷移的有效性。通過將Cityscapes中的圖像作為風(fēng)格圖,GTA游戲場(chǎng)景數(shù)據(jù)中的圖作為內(nèi)容圖,并利用在Cityscapes上訓(xùn)練的PSPNet來進(jìn)行語義風(fēng)格。研究結(jié)果顯示,進(jìn)行風(fēng)格遷移后的圖像具有比原圖更好的語義分割效果。

這也為低成本獲取語義分割數(shù)據(jù)集訓(xùn)練提供了可行的手段。

-

編碼器

+關(guān)注

關(guān)注

45文章

3729瀏覽量

136142 -

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4789瀏覽量

101852 -

英偉達(dá)

+關(guān)注

關(guān)注

22文章

3894瀏覽量

92659

原文標(biāo)題:NVIDIA研究人員提出新的風(fēng)格遷移算法,可大幅提高風(fēng)格遷移的效率,同時(shí)實(shí)現(xiàn)任意圖片的風(fēng)格轉(zhuǎn)換

文章出處:【微信號(hào):thejiangmen,微信公眾號(hào):將門創(chuàng)投】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

非局部神經(jīng)網(wǎng)絡(luò),打造未來神經(jīng)網(wǎng)絡(luò)基本組件

【PYNQ-Z2試用體驗(yàn)】神經(jīng)網(wǎng)絡(luò)基礎(chǔ)知識(shí)

基于賽靈思FPGA的卷積神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)設(shè)計(jì)

卷積神經(jīng)網(wǎng)絡(luò)一維卷積的處理過程

卷積神經(jīng)網(wǎng)絡(luò)模型發(fā)展及應(yīng)用

卷積神經(jīng)網(wǎng)絡(luò)簡(jiǎn)介:什么是機(jī)器學(xué)習(xí)?

一種卷積神經(jīng)網(wǎng)絡(luò)和極限學(xué)習(xí)機(jī)相結(jié)合的人臉識(shí)別方法_余丹

一種改進(jìn)的基于卷積神經(jīng)網(wǎng)絡(luò)的行人檢測(cè)方法

評(píng)論