在基于激光的自動駕駛或者移動機器人的應用中,在移動場景中提取單個對象的能力是十分重要的。因為這樣的系統需要在動態的感知環境中感知到周圍發生變化或者移動的對象,在感知系統中,將圖像或者點云數據預處理成單個物體是進行進一步分析的第一個步驟。

在這篇文章中就提出了一種十分高效的分割方法。首先是將掃描到的點云移除平面處理,然后移除平面后一定范圍內的點云數據分割成不同的對象。該論文的是集中解決了在很小的計算量的條件下,能夠在大多數系統上做到高效的分割。避免了直接對3D點云的計算,并直接在2.5D的深度圖像上進行操作。此方案能夠很好的解決處理稀疏的3D點云數據。作者使用了新型Velodyne VLP-16掃描儀,并且代碼是在C++和ROS中實現了這種方法,并且代碼是開源的,這種方法可以做到使用單核CPU以及高于傳感器的幀運行速率運行,能夠產生高質量的分割結果。

左圖:使用Velodyne VLP-16掃描儀得到的稀疏3D點云數據分割后生成的對象(如人,車和樹)。不同的顏色對應不同的分割結果。 右:用于實驗的Clearpath Husky機器人。

在3D激光點云數據中分離單個對象是移動機器人或自動駕駛車輛自主導航的重要任務。 在未知環境中航行的自動駕駛車輛面臨著對其周圍環境進行推理的復雜任務。,在擁有汽車和行人的繁忙街道上,地圖可能受到環境動態性質導致的錯誤數據關聯的影響。 在掃描配準和映射過程中,能夠更好地推理此類對象并忽略可能的動態對象的關鍵步驟是將3D點云數據分割為不同的對象,以便可以單獨跟蹤它們。

所以本論文很重要的貢獻是將實現快讀高效且穩健的3D稀疏點云的分割。(本人親自測試,真的很快,我的電腦的配置真的很菜,但是運行起來都超快)在移動的CPU上都可以處理超過70HZ(64線)或者250HZ的(16線)的Velodyne傳感器。

地面去除

在進行分割之前,需要從掃描的點云數據中移除地面。這種地面移除的方法,只是把低于車輛高度的3D點移除。這種方法在簡單的場景中起作用,但是如果在車輛的俯仰或者側傾角不等于零或者地面不是完美的平面。則會失敗。但是可以使用RANSAC的平面擬合的方法改善情況。

激光雷達的會提供每個激光束的距離值,時間戳以及光束的方向作為原始數據。這使得我們可以直接將數據轉換為深度圖像。圖像中的行數由垂直方向上的光束的數量定義,比如對于Velodyne掃描儀,有16線,32線以及64線,而圖像的列數有激光每360度旋轉得到的距離值。這種虛像的每個像素存儲了傳感器到物體之間的距離,為了加速計算甚至可以考慮在需要時將水平方向上的多個讀數組合成一個像素。

左上角:深度圖像的一部分。左中:通過顯示α角度生成的圖像。左下:應用Savitsky-Golay平滑后的角度。右上角:α角的圖示。右下圖:左圖中標記的α角度列的平滑圖示。

使用上述生成的和成圖像來處理而不是直接處理計算3D點云,可以有效的加速處理速度,對于其他的不提供距離值的掃描儀也可以將3D點云投影到圓柱圖像上,計算每個像素的歐幾里得距離,仍然可以使用該論文提出的方法。

為了識別地面,這里面有三個假設:

1, 假設傳感器是大致安裝在水平移動基座上。

2, 假設地面的曲率很低。

3, 移動機器人或者車輛至少在深度圖像上最低行的像素觀測地平面

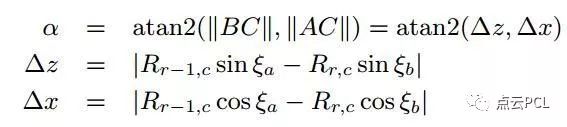

在假設成立的條件下,首先將深度圖像的每一列(c)像素的距離值(R)轉化為角度值

這些角度表示了連接兩點的傾斜角度。

和

分別代表在該行相鄰的深度值。知道連續垂直的兩個單個激光束深度值,可以使用三角規則計算角度α,如下所示:

其中ξa和ξb是對應于行r-1和r的激光束的垂直角,由于每個α計算需要兩個深度值,所以生成的角度圖大小比深度圖范圍的行數小1.這里假設吧這些所有的角度表示為,表示為在r行和c列(行和列)坐標上的角度值。

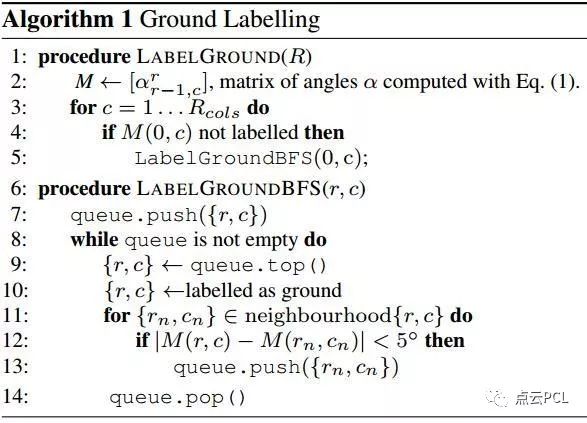

地面識別算法

根據上述算法得出的地面,地面標記為淺藍色。

但是由于激光雷達也是有誤差的,所以這里也是需要處理一些在深度范圍內的離群點,具體可查看論文。為了達到角度平滑的效果使用了Savitsky-Golay濾波算法對每一個列進行處理。在得到濾波后的角度圖后,在這個基礎上開始執行地面識別,使用了廣度優先搜索將相似的點標記在一起,廣度優先搜索(Breadth-first search BFS) 是一種流行的圖搜索遍歷算法,他從圖給定的點開始遍歷,并在移動到下一級令居之前首先開始探索直接相鄰的節點,在該論文中使用了網格上的N4領域值計算角度差值,以確定矩陣M的兩個相鄰元素是否滿足角度上的約束條件Δa,設置為5°。

使用激光深度圖像進行快速有效的分割

傳感器的垂直分辨率對分割問題的難度是有著十分重要的影響的,我們需要判斷對于相鄰點,去判斷該激光束是否是被同一物體反射。為了解決激光是否是同一個物體反射的問題,這里是基于角度測量的方法。這種方法的好處是文中反復提及多次這種方法的優點 :首先,我們可以直接在深度圖像中利用明確定義的鄰域關系,這使得分割問題更容易。 其次,我們避免生成3D點云,這使得整體方法的計算速度更快。

在下圖中展示了分割的效果

這是使用該分割方案的結果,(A)圖是來自Velodynede 點云,(B)根據傳感器的原始值創建的深度圖像,并且已經將地面點去除了。(C)圖是在生成的深度圖的基礎上執行的分割結果。(D)將分割后的深度圖還原為點云,并以不同的顏色顯示。

這里詳細的解釋一下關于如果使用角度約束的方法實現分割的:

如下圖所示的一個示例場景,其中兩個人在騎自行車者前面彼此靠近地行走,騎自行車者在他們和停放的汽車之間經過。 這里使用的Velodyne VLP-16掃描儀記錄了這個場景。 中間的圖像展示出了從位于O處的掃描儀測量的兩個任意點A和B的結果,表示出了激光束OA和OB。 在不失一般性的情況下,我們假設A和B的坐標位于以O為中心的坐標系中,y軸沿著兩個激光束中較長的那一個。 我們將角度β定義為激光束與連接A和B的線之間的角度,該角度一般是遠離掃描儀。 在實踐中,角度β證明是有價值的信息,可以用來確定點A和B是否位于同一物體上。

左:示例場景有兩個行人,一個騎自行車者和一輛汽車。 中間:假設傳感器在O點并且線OA和OB表示兩個激光束,則點A和B產生一條線,該線估計對象的表面,如果它們都屬于同一對象。 我們基于角度β做出是否為同一物體的判斷。 如果β>θ,其中θ是預定閾值,認為這些點代表一個對象。 右圖:示例場景中行人的俯視圖。 綠線表示β>θ的點,而紅線表示低于閾值的角度,因此將對象標記為不同。

那么基于激光的測量值我們是知道第一次測量的距離值OA以及對應的第二次測量值OB,分別將這兩次的測量結果標記為d1和d2,那么利用以上信息既可以用下列公式測量角度:

圖中的右圖示出了從場景的俯視圖中在xy平面中的計算。 注意,我們可以計算在范圍圖像中在行或列方向上相鄰的點A和B對的角度β。 在第一種情況下,角度對應于行方向上的角度增量,而另一種情況下對應于列方向上的增量。

分割算法

基于閾值的β的分割方法在實驗評估中進行實驗,實際情況可以是被掃描物體是平面的情況,例如墻壁,并且幾乎平行于激光束方向。在這種情況下,角度β將很小,因此物體可能被分成多個區段。這基本上意味著如果β小于θ,則難以確定兩個點是否源自兩個不同的物體,或者僅僅位于幾乎平行于波束方向的平面物體上。然而,盡管有這個缺點,我們的實驗表明該方法在實踐中仍然有用。上述行為很少發生,如果是這樣,它通常將會導致特別傾斜的平面物體的過度分割。

以上就是關于去地面后使用的分割算法。可以看得出最重要的一個公式就是β角度值的求解

實驗部分

該算法

(i)所有計算都可以快速執行,即使在大約70 Hz的移動CPU的單核上運行,

(ii)可以 將移動機器人獲得3D原始數據生成深度數據并分段為有意義的個體

(iii)該方法在稀疏數據上表現良好,例如從16光束Velodyne Puck掃描儀獲得的稀疏數據。 在實驗中中,使用點云庫PCL中來實現的歐幾里德聚類。 在所有實驗中,我們使用默認參數θ= 10°。

-

傳感器

+關注

關注

2558文章

52005瀏覽量

760577 -

移動機器人

+關注

關注

2文章

780瀏覽量

33883 -

深度圖像

+關注

關注

0文章

19瀏覽量

3558

原文標題:實時稀疏點云分割

文章出處:【微信號:IV_Technology,微信公眾號:智車科技】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

基于深度學習的方法在處理3D點云進行缺陷分類應用

3D點云技術介紹及其與VR體驗的關系

谷歌AI發布3D物體數據集,附帶標記邊界框、相機位姿、稀疏點云

基于層級圖網絡的圖卷積,用點云完成3D目標檢測

首個無監督3D點云物體實例分割算法

3D點云數據集在3D數字化技術中的應用

自動駕駛3D點云語義分割數據標注

評論