在幾年之前,我踏進(jìn)了數(shù)據(jù)科學(xué)的大門。之前還是軟件工程師的時(shí)候,我是最先開(kāi)始在網(wǎng)上自學(xué)的(在開(kāi)始我的碩士學(xué)位之前)。我記得當(dāng)我搜集網(wǎng)上資源的時(shí)候,我看見(jiàn)的只有玲瑯滿目的算法名稱—線性回歸,支持向量機(jī)(SVM),決策樹(shù)(DT),隨即森林(RF),神經(jīng)網(wǎng)絡(luò)等。對(duì)于剛剛開(kāi)始學(xué)習(xí)的我來(lái)說(shuō),這些算法都是非常有難度的。但是,后來(lái)我才發(fā)現(xiàn):要成為一名數(shù)據(jù)科學(xué)家,最重要的事情就是了解和學(xué)習(xí)整個(gè)的流程,比如,如何獲取和處理數(shù)據(jù),如何理解數(shù)據(jù),如何搭建模型,如何評(píng)估結(jié)果(模型和數(shù)據(jù)處理階段)和優(yōu)化。為了達(dá)到這個(gè)目的,我認(rèn)為從邏輯回歸開(kāi)始入門是非常不錯(cuò)的選擇,這樣不但可以讓我們很快熟悉這個(gè)流程,而且不被那些高大上的算法所嚇倒。

因此,下面將要列出5條原因來(lái)說(shuō)明為什么最開(kāi)始學(xué)習(xí)邏輯回歸是入門最好的選擇。當(dāng)然,這只是我個(gè)人的看法,對(duì)于其他人可能有更快捷的學(xué)習(xí)方式。

1. 因?yàn)槟P退惴ㄖ皇钦麄€(gè)流程的一部分

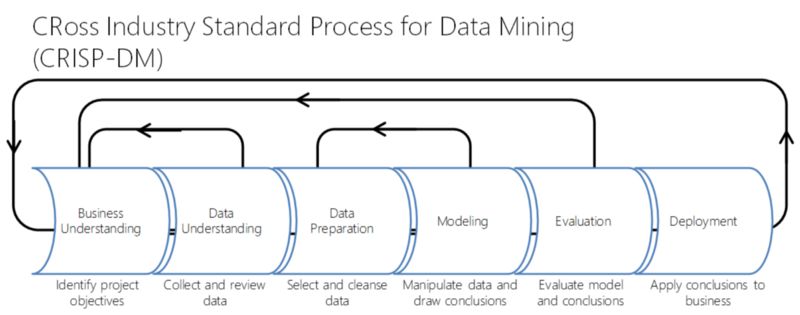

像我之前提到的一樣,數(shù)據(jù)科學(xué)工作不僅僅是建模,它還包括以下的步驟:

可以看到,“建模” 只是這個(gè)重復(fù)過(guò)程的一部分而已。當(dāng)開(kāi)展一個(gè)數(shù)據(jù)產(chǎn)品的時(shí)候,一個(gè)非常好的實(shí)踐就是首先建立你的整個(gè)流程,讓它越簡(jiǎn)單越好,清楚地明白你想要獲得什么,如何進(jìn)行評(píng)估測(cè)試,以及你的baseline是什么。隨后在這基礎(chǔ)上,你就可以加入一些比較炫酷的機(jī)器學(xué)習(xí)算法,并知道你的效果是否變得更好。

順便說(shuō)下,邏輯回歸(或者任何ML算法)可能不只是在建模部分所使用,它們也可能在數(shù)據(jù)理解和數(shù)據(jù)準(zhǔn)備的階段使用,填補(bǔ)缺失值就是一個(gè)例子。

2. 因?yàn)槟銓⒁玫乩斫鈾C(jī)器學(xué)習(xí)

我想當(dāng)大家看到本篇的時(shí)候,第一個(gè)想要問(wèn)的問(wèn)題就是:為什么是邏輯回歸,而不是線性回歸。真相其實(shí)是都無(wú)所謂,理解了機(jī)器學(xué)習(xí)才是最終目的。說(shuō)到這個(gè)問(wèn)題,就要引出監(jiān)督學(xué)習(xí)的兩個(gè)類型了,分類(邏輯回歸)和回歸(線性回歸)。當(dāng)你使用邏輯回歸或者線性回歸建立你整個(gè)流程的時(shí)候(越簡(jiǎn)單越好),你會(huì)慢慢地熟悉機(jī)器學(xué)習(xí)里的一些概念,例如監(jiān)督學(xué)習(xí)v.s非監(jiān)督學(xué)習(xí),分類v.s回歸,線性v.s非線性等,以及更多問(wèn)題。你也會(huì)知道如何準(zhǔn)備你的數(shù)據(jù),以及這過(guò)程中有什么挑戰(zhàn)(比如填補(bǔ)缺失值和特征選擇),如何度量評(píng)估模型,是該使用準(zhǔn)確率,還是精準(zhǔn)率和召回率,RUC AUC?又或者可能是 “均方差”和“皮爾遜相關(guān)”?所有的概念都都是數(shù)據(jù)科學(xué)學(xué)習(xí)過(guò)程中非常重要的知識(shí)點(diǎn)。等慢慢熟悉了這些概念以后,你就可以用更復(fù)雜的模型或者技巧(一旦你掌握了之后)來(lái)替代你之前的簡(jiǎn)單模型了。

3. 因?yàn)檫壿嫽貧w有的時(shí)候,已經(jīng)足夠用了

邏輯回歸是一個(gè)非常強(qiáng)大的算法,甚至對(duì)于一些非常復(fù)雜的問(wèn)題,它都可以做到游刃有余。拿MNIST舉例,你可以使用邏輯回歸獲得95%的準(zhǔn)確率,這個(gè)數(shù)字可能并不是一個(gè)非常出色的結(jié)果,但是它對(duì)于保證你的整個(gè)流程工作來(lái)說(shuō)已經(jīng)足夠好了。實(shí)際上,如果說(shuō)能夠選擇正確且有代表性的特征,邏輯回歸完全可以做的非常好。

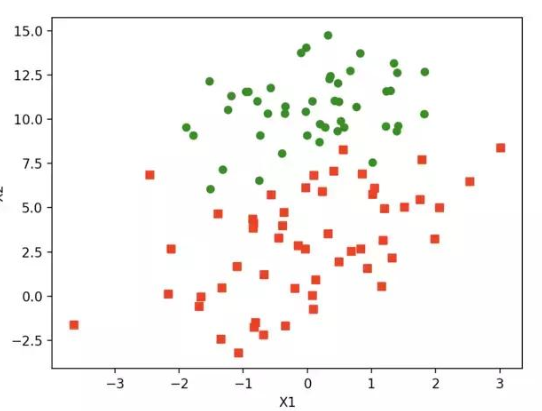

當(dāng)處理非線性的問(wèn)題時(shí),我們有時(shí)候會(huì)用可解釋的線性方式來(lái)處理原始數(shù)據(jù)。可以用一個(gè)簡(jiǎn)單的例子來(lái)說(shuō)明這種思想:現(xiàn)在我們想要基于這種思想來(lái)做一個(gè)簡(jiǎn)單的分類任務(wù)。

X1x2|Y==================-201201-100100

如果我們將數(shù)據(jù)可視化,我們可以看到?jīng)]有一條直線可以將它們分開(kāi)。

在這種情況下,如果不對(duì)數(shù)據(jù)做一些處理的話,邏輯回歸是無(wú)法幫到我們的,但是如果我們不用x2特征,而使用x12來(lái)代替,那么數(shù)據(jù)將會(huì)變成這樣:

X1x1^2|Y==================-241241-110110

現(xiàn)在,就存在一條直線可以將它們分開(kāi)了。當(dāng)然,這個(gè)簡(jiǎn)單的例子只是為了說(shuō)明這種思想,對(duì)于現(xiàn)實(shí)世界來(lái)講,很難發(fā)現(xiàn)或找到如何改變數(shù)據(jù)的方法以可以使用線性分類器來(lái)幫助你。但是,如果你可以在特征工程和特征選擇上多花些時(shí)間,那么很可能你的邏輯回歸是可以很好的勝任的。

4. 因?yàn)檫壿嫽貧w是統(tǒng)計(jì)中的一個(gè)重要工具

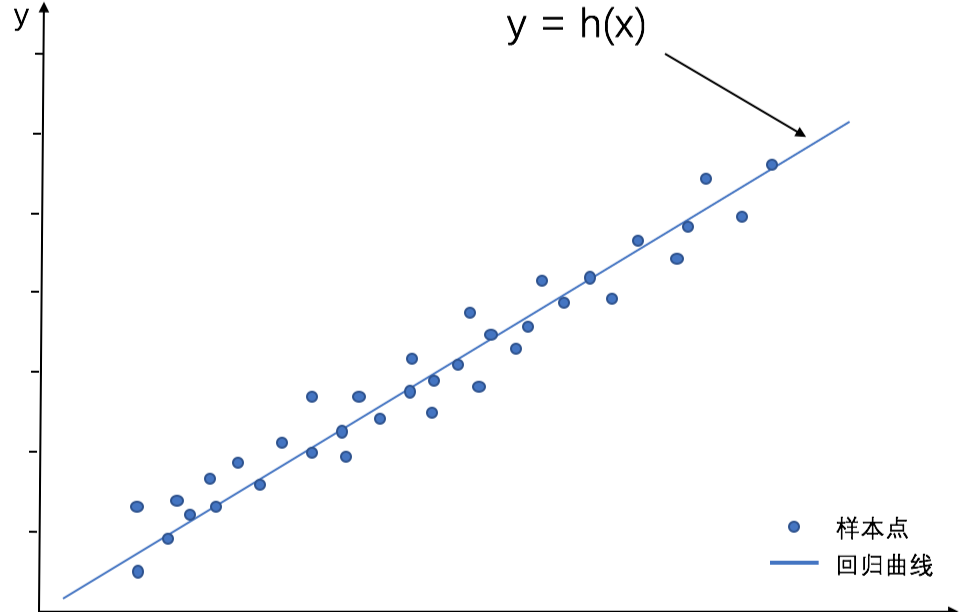

線性回歸不僅僅可以用來(lái)預(yù)測(cè)。如果你有了一個(gè)訓(xùn)練好的線性模型,你可以通過(guò)它學(xué)習(xí)到因變量和自變量之間的關(guān)系,或者用更多的ML語(yǔ)言來(lái)說(shuō),你可以學(xué)習(xí)到特征變量和目標(biāo)變量的關(guān)系。一個(gè)簡(jiǎn)單的例子,房?jī)r(jià)預(yù)測(cè),我們有很多房屋特征,還有實(shí)際的房?jī)r(jià)。我們基于這些數(shù)據(jù)訓(xùn)練一個(gè)線性回歸模型,然后得到了很好的結(jié)果。通過(guò)訓(xùn)練,我們可以發(fā)現(xiàn)模型訓(xùn)練后會(huì)給每個(gè)特征分配相應(yīng)的權(quán)重。如果某個(gè)特征權(quán)重很高,我們就可以說(shuō)這個(gè)特征比其它的特征更重要。比如房屋大小特征,對(duì)于房?jī)r(jià)的變化會(huì)有50%的權(quán)重,因?yàn)榉课荽笮∶吭黾右黄矫追績(jī)r(jià)就會(huì)增加10k。線性回歸是一個(gè)了解數(shù)據(jù)以及統(tǒng)計(jì)規(guī)律的非常強(qiáng)的工具,同理,邏輯回歸也可以給每個(gè)特征分配各自的權(quán)重,通過(guò)這個(gè)權(quán)重,我們就可以了解特征的重要性。

5. 因?yàn)檫壿嫽貧w是學(xué)習(xí)神經(jīng)元網(wǎng)絡(luò)很好的開(kāi)始

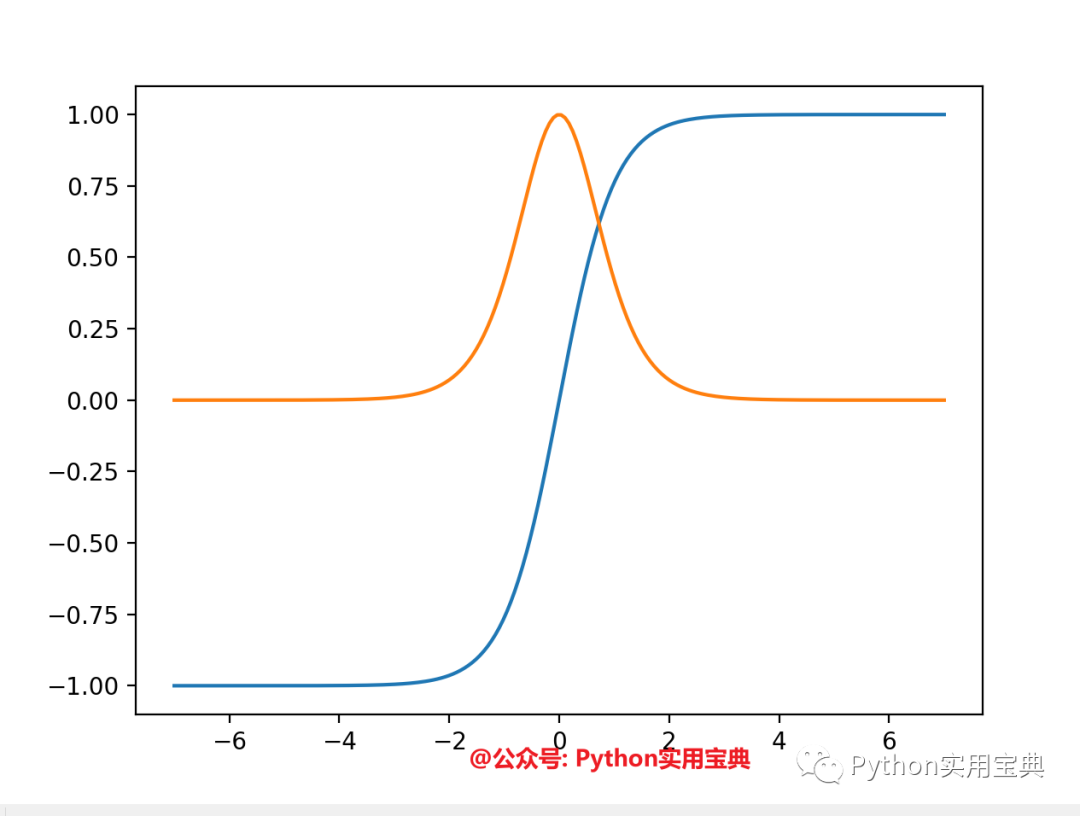

當(dāng)學(xué)習(xí)神經(jīng)元網(wǎng)絡(luò)的時(shí)候,最開(kāi)始學(xué)習(xí)的邏輯回歸對(duì)我?guī)椭艽蟆D憧梢詫⒕W(wǎng)絡(luò)中的每個(gè)神經(jīng)元當(dāng)作一個(gè)邏輯回歸:它有輸入,有權(quán)重,和閾值,并可以通過(guò)點(diǎn)乘,然后再應(yīng)用某個(gè)非線性的函數(shù)得到輸出。更多的是,一個(gè)神經(jīng)元網(wǎng)絡(luò)的最后一層大多數(shù)情況下是一個(gè)簡(jiǎn)單的線性模型,看一下最基本的神經(jīng)元網(wǎng)絡(luò):

如果我們更深入地觀察一下output層,可以看到這是一個(gè)簡(jiǎn)單的線性(或者邏輯)回歸,有hidden layer 2作為輸入,有相應(yīng)的權(quán)重,我們可以做一個(gè)點(diǎn)乘然后加上一個(gè)非線性函數(shù)(根據(jù)任務(wù)而定)。可以說(shuō),對(duì)于神經(jīng)元網(wǎng)絡(luò),一個(gè)非常好的思考方式是:將NN劃分為兩部分,一個(gè)是代表部分,一個(gè)是分類/回歸部分。

第一部分(左側(cè))嘗試從數(shù)據(jù)中學(xué)習(xí)并具有很好的代表性,然后它會(huì)幫助第二個(gè)部分(右側(cè))來(lái)完成一個(gè)線性的分類或者回歸任務(wù)。

總結(jié)

成為一個(gè)數(shù)據(jù)科學(xué)家你可能需要掌握很多知識(shí),第一眼看上去,好像學(xué)習(xí)算法才是最重要的部分。實(shí)際的情況是:學(xué)習(xí)算法確實(shí)是所有情況中最復(fù)雜的部分,需要花費(fèi)大量的時(shí)間和努力來(lái)理解,但它也只是數(shù)據(jù)科學(xué)中的一個(gè)部分,把握整體更為關(guān)鍵。

-

算法

+關(guān)注

關(guān)注

23文章

4615瀏覽量

92962 -

人工智能

+關(guān)注

關(guān)注

1791文章

47336瀏覽量

238696

原文標(biāo)題:5個(gè)原因告訴你:為什么在成為數(shù)據(jù)科學(xué)家之前,“邏輯回歸”是第一個(gè)需要學(xué)習(xí)的

文章出處:【微信號(hào):AI_shequ,微信公眾號(hào):人工智能愛(ài)好者社區(qū)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

機(jī)器學(xué)習(xí)實(shí)戰(zhàn)之logistic回歸

回歸預(yù)測(cè)之入門

回歸算法有哪些,常用回歸算法(3種)詳解

TensorFlow邏輯回歸處理MNIST數(shù)據(jù)集

TensorFlow邏輯回歸處理MNIST數(shù)據(jù)集

Edge Impulse的回歸模型

使用KNN進(jìn)行分類和回歸

Python機(jī)器學(xué)習(xí)回歸部分的應(yīng)用與教程

對(duì)于機(jī)器學(xué)習(xí)/數(shù)據(jù)科學(xué)初學(xué)者 應(yīng)該掌握的七種回歸分析方法

機(jī)器學(xué)習(xí)的回歸分析和回歸方法

機(jī)器學(xué)習(xí):線性回歸與邏輯回歸的理論與實(shí)戰(zhàn)

Python 梯度計(jì)算模塊如何實(shí)現(xiàn)一個(gè)邏輯回歸模型

邏輯回歸的對(duì)于數(shù)據(jù)學(xué)習(xí)的關(guān)鍵

邏輯回歸的對(duì)于數(shù)據(jù)學(xué)習(xí)的關(guān)鍵

評(píng)論