ICLR-17最佳論文《理解深度學習需要重新思考泛化》曾引發(fā)學界熱議。現(xiàn)作者張馳原和Samy Bengio等再出新作,指出神經(jīng)網(wǎng)絡(luò)每個層并非“生而平等”,進一步拓展對神經(jīng)網(wǎng)絡(luò)泛化的理解。

今天新智元要介紹的論文是ICLR 2017最佳論文獎得主、《理解深度學習需要重新思考泛化》的作者張弛原和Samy Bengio等人的新作:

神經(jīng)網(wǎng)絡(luò)的各個層生而平等嗎?(Are All Layers Created Equal?)

張弛原、Samy Bengio等人新作:神經(jīng)網(wǎng)絡(luò)各個層生而平等嗎?

在ICLR 2017那篇“重新思考泛化”的文章中,張馳原等人得出結(jié)論認為,只要參數(shù)的數(shù)量超過實踐中通常的數(shù)據(jù)點的數(shù)量,即便是簡單的層數(shù)為2的神經(jīng)網(wǎng)絡(luò),就已經(jīng)具有完美的有限樣本表現(xiàn)力(finite sample expressivity)。

而在這篇新的論文中,張弛原等人繼續(xù)探討深度神經(jīng)網(wǎng)絡(luò)的泛化能力,深入到“層”的級別,并指出在研究深度模型時,僅關(guān)注參數(shù)或范數(shù)(norm)的數(shù)量是遠遠不夠的。

研究深度模型時,只考慮參數(shù)和范數(shù)的數(shù)量是不夠的

理解深層架構(gòu)的學習和泛化能力是近年來一個重要的研究目標,《理解深度學習需要重新思考泛化》發(fā)表后在學界卷起了一股風暴,有人甚至稱其為“勢必顛覆我們對深度學習理解”。

ICLR 2017最佳論文《理解深度學習需要重新思考泛化》

ICLR 2017那篇文章指出,傳統(tǒng)方法無法解釋大規(guī)模神經(jīng)網(wǎng)絡(luò)在實踐中泛化性能好的原因,并提出了兩個新的定義——“顯示正則化”和“隱示正則化”來討論深度學習。

作者通過在CIFAR10和ImageNet的幾個不同實驗發(fā)現(xiàn):

神經(jīng)網(wǎng)絡(luò)的有效容量對于整個數(shù)據(jù)集的暴力記憶是足夠大的;

對隨機標簽進行優(yōu)化的過程很容易。與對真實標簽的訓練相比,隨機標簽的訓練時間只增加了一個小的恒定因子;

對標簽進行隨機化只是一種數(shù)據(jù)變換,神經(jīng)網(wǎng)絡(luò)要學習的問題的所有其他屬性不變。

更準確地說,當對真實數(shù)據(jù)的完全隨機標記進行訓練時,神經(jīng)網(wǎng)絡(luò)實現(xiàn)了零訓練誤差——當然,測試誤差并不比隨機概率好,因為訓練標簽和測試標簽之間沒有相關(guān)性。

換句話說,通過單獨使標簽隨機化,我們可以迫使模型的泛化能力顯著提升,而不改變模型、大小、超參數(shù)或優(yōu)化器。

這一次,論文又提出了兩個新的概念——(訓練后)“重新初始化”和“重新隨機化魯棒性”,并認為神經(jīng)網(wǎng)絡(luò)的層可以分為“關(guān)鍵層”和“魯棒層”;與關(guān)鍵層相比,將魯棒層重置為其初始值沒有負面影響,而且在許多情況下,魯棒層在整個訓練過程中幾乎沒有變化。

作者根據(jù)經(jīng)驗研究了過度參數(shù)化深度模型的分層功能結(jié)構(gòu),為神經(jīng)網(wǎng)絡(luò)層的異構(gòu)特征提供了證據(jù)。

再次思考神經(jīng)網(wǎng)絡(luò)泛化:各個層并非“生而平等”

深度神經(jīng)網(wǎng)絡(luò)在現(xiàn)實世界的機器學習實例中已經(jīng)得到了非常成功的應用。在將這一系統(tǒng)應用于許多關(guān)鍵領(lǐng)域時,對系統(tǒng)的深層理解至少與其最先進的性能同樣重要。最近,關(guān)于理解為什么深度網(wǎng)絡(luò)在實踐中表現(xiàn)優(yōu)異的研究主要集中在網(wǎng)絡(luò)在漂移下的表現(xiàn),甚至是數(shù)據(jù)分布等問題上。

與此類研究相關(guān)的另一個有趣的研究是,我們?nèi)绾谓忉尣⒗斫馐苓^訓練的網(wǎng)絡(luò)的決策函數(shù)。雖然本文的研究問題與此相關(guān),但采取了不同的角度,我們主要關(guān)注網(wǎng)絡(luò)層在受過訓練的網(wǎng)絡(luò)中的作用,然后將經(jīng)驗結(jié)果與泛化、魯棒性等屬性聯(lián)系起來。

本文對神經(jīng)網(wǎng)絡(luò)表達力的理論進行了深入研究。眾所周知,具有足夠?qū)挼膯蝹€隱藏層的神經(jīng)網(wǎng)絡(luò)是緊湊域上的連續(xù)函數(shù)的通用逼近器。

最近的研究進一步探討了深度網(wǎng)絡(luò)的表達能力,是否真的優(yōu)于具有相同數(shù)量的單元或邊緣的淺層網(wǎng)絡(luò)。同時,也廣泛討論了用有限數(shù)量的樣本表示任意函數(shù)的能力。

然而,在上述用于構(gòu)建近似于特定功能的網(wǎng)絡(luò)的研究中,使用的網(wǎng)絡(luò)結(jié)構(gòu)通常是“人工的”,且不太可能通過基于梯度的學習算法獲得。我們重點關(guān)注的是實證深層網(wǎng)絡(luò)架構(gòu)中不同網(wǎng)絡(luò)層發(fā)揮的作用,網(wǎng)絡(luò)采用基于梯度的訓練。

深度神經(jīng)網(wǎng)絡(luò)的泛化研究引起了很多人的興趣。由于大神經(jīng)網(wǎng)絡(luò)無法在訓練集上實現(xiàn)隨機標記,這使得在假設(shè)空間上基于均勻收斂來應用經(jīng)典學習的理論結(jié)果變得困難。

本文提供了進一步的經(jīng)驗證據(jù),并進行了可能更細致的分析。尤其是,我們憑經(jīng)驗表明,深層網(wǎng)絡(luò)中的層在表示預測函數(shù)時所起的作用并不均等。某些層對于產(chǎn)生良好的預測結(jié)果至關(guān)重要,而其他層對于在訓練中分配其參數(shù)則具備相當高的魯棒性。

此外,取決于網(wǎng)絡(luò)的容量和目標函數(shù)的不同復雜度,基于梯度的訓練網(wǎng)絡(luò)可以不使用過剩容量來保持網(wǎng)絡(luò)的復雜度。本文討論了對“泛化“這一概念的確切定義和涵蓋范圍。

全連接層(FCN)

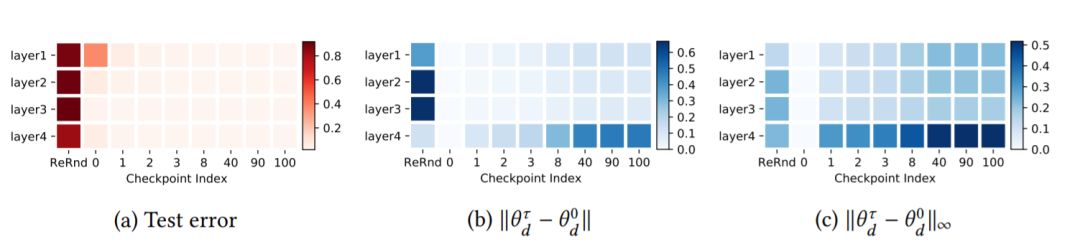

圖1:MNIST數(shù)據(jù)集上FCN 3×256的魯棒性結(jié)果。(a)測試錯誤率:圖中每行對應于網(wǎng)絡(luò)中的每一層。第一列指定每個層的魯棒性w.r.t重新隨機化,其余列指定不同檢查點的重新初始化魯棒性。最后一列為最終性能(在訓練期間設(shè)置的最后一個檢查點)作為參考。(b-c)權(quán)重距離:熱圖中的每個單元表示訓練參數(shù)與其初始權(quán)重的標準化2范數(shù)(b)或∞范數(shù)(c)距離

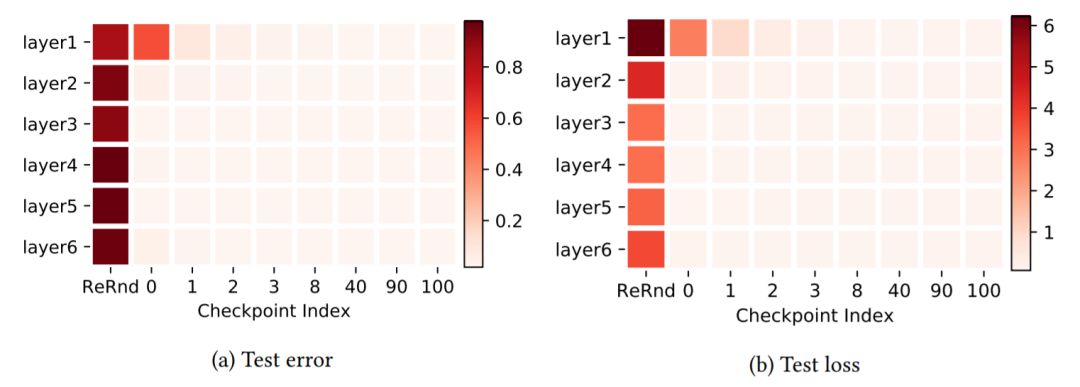

圖2:MNIST數(shù)據(jù)集上FCN 5×256的層魯棒性研究。兩個子圖使用與圖1(a)相同的布局。兩個子圖分別表示在測試錯誤(默認值)和測試損失中評估的魯棒性

大規(guī)模卷積網(wǎng)絡(luò)(CNN)

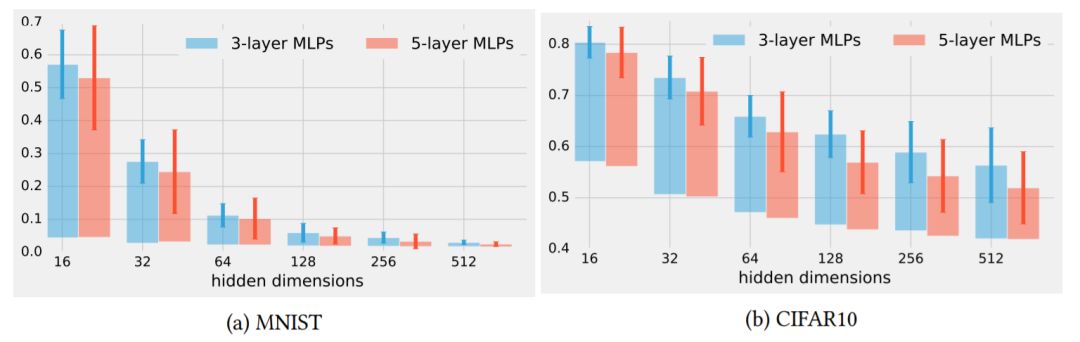

圖3:重新初始化所有層的魯棒性,但第一次使用檢查點0用于不同維度的隱藏層的FCN。每個條形表示完全訓練后的模型有具有一層重新初始化的模型之間的分類誤差的差異。誤差條表示通過使用不同的隨機初始化運行實驗得到的一個標準偏差。

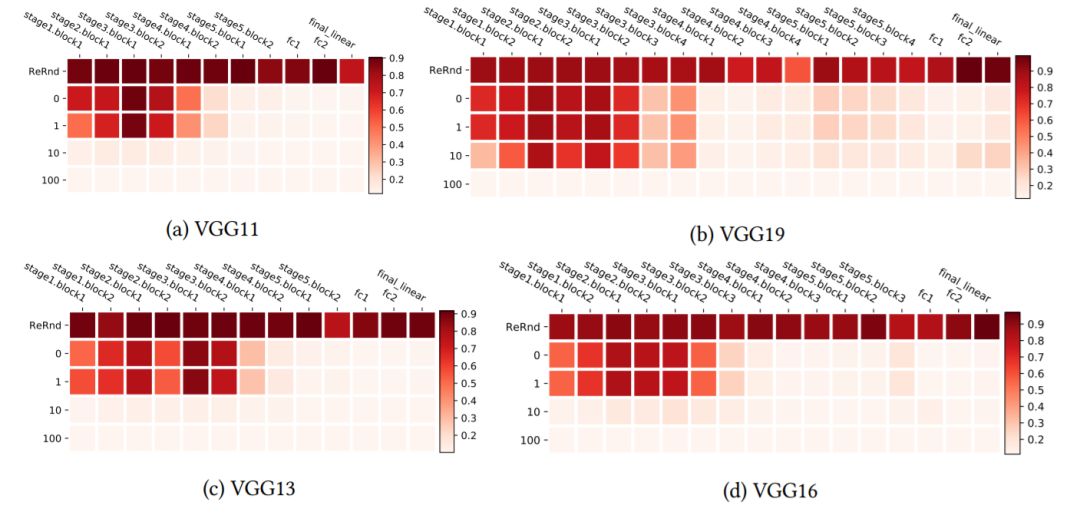

圖4:使用CIFAR10上的VGG網(wǎng)絡(luò)進行分層魯棒性分析。熱圖使用與圖1中相同的布局,但加以轉(zhuǎn)置,以便更有效地對更深層的架構(gòu)進行可視化。

殘差網(wǎng)絡(luò)(ResNets)

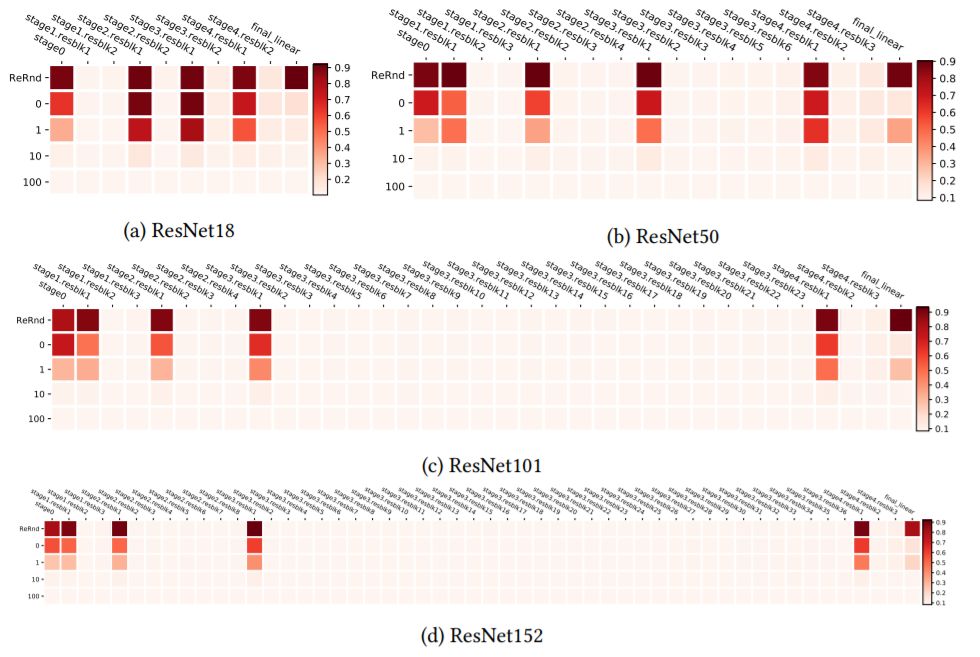

圖5:在CIFAR10上訓練的ResNets殘差塊的分層魯棒性分析。

圖6:在ImageNet上訓練的ResNets殘差塊的分層魯棒性分析

圖7:采用/不采用下采樣跳過分支的殘余塊(來自ResNets V2)。C,N和R分別代表卷積、(批量)歸一化和ReLU激活

網(wǎng)絡(luò)層的聯(lián)合魯棒性

圖8:MNIST上FCN 5×256的聯(lián)合魯棒性分析。布局與圖1中的相同,但是圖層分為兩組(每個圖層中圖層名稱上的*標記表示),對每組中的所有圖層全部應用重新隨機化和重新初始化。

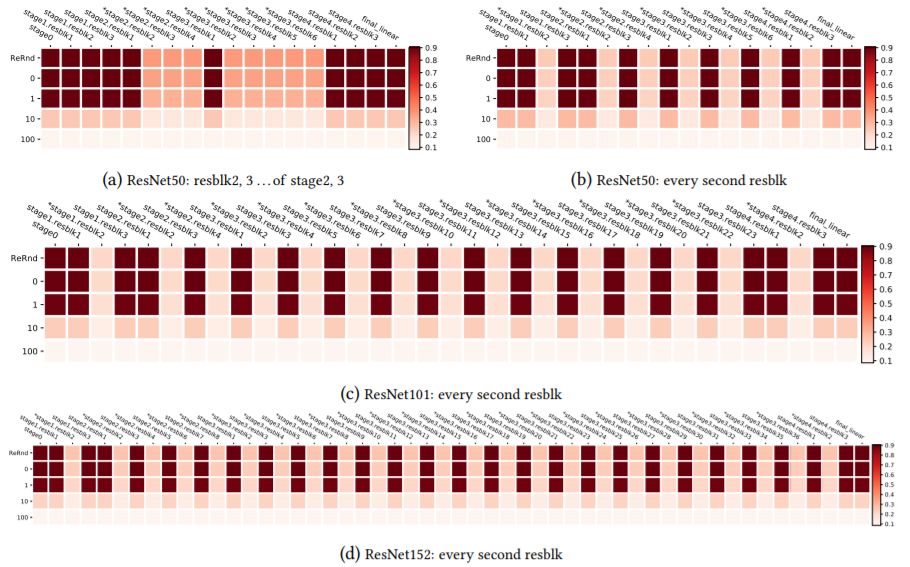

圖9:CIFAR10上ResNets的聯(lián)合魯棒性分析,基于對所有剩余階段中除第一個殘余塊之外的所有剩余塊進行分組的方案。分組由圖層名稱上的*表示。

圖10:CIFAR10上ResNets的聯(lián)合魯棒性分析,以及其他分組方案。分組由圖層名稱上的*表示

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4777瀏覽量

100974 -

網(wǎng)絡(luò)架構(gòu)

+關(guān)注

關(guān)注

1文章

94瀏覽量

12605 -

深度學習

+關(guān)注

關(guān)注

73文章

5511瀏覽量

121356

原文標題:ICLR-17最佳論文一作張弛原新作:神經(jīng)網(wǎng)絡(luò)層并非“生而平等”

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

谷歌工程師機器學習干貨:從表現(xiàn)力、可訓練性和泛化三方面詳解

深度學習如何確定最佳深度?

探索機器“視覺”演進的無限可能性 Qualcomm AI研究人員獲得ICLR殊榮

ICLR 2019在官網(wǎng)公布了最佳論文獎!

ICLR 2019最佳論文日前揭曉 微軟與麻省等獲最佳論文獎項

谷歌發(fā)表論文EfficientNet 重新思考CNN模型縮放

泛在電力物聯(lián)網(wǎng)的發(fā)展真的需要5G嗎

自監(jiān)督學習與Transformer相關(guān)論文

如何理解泛化是深度學習領(lǐng)域尚未解決的基礎(chǔ)問題

基于深度學習的評論文本推薦方法

深度學習頂級學術(shù)會議ICLR 2023錄用結(jié)果已經(jīng)公布!

PyTorch教程5.5之深度學習中的泛化

ICLR-17最佳論文《理解深度學習需要重新思考泛化》

ICLR-17最佳論文《理解深度學習需要重新思考泛化》

評論