谷歌藝術與文化推出新作品,手機上體驗宇宙大爆炸,并可以作為背景進行自拍。而谷歌博客解釋了如何使用ARCore和機器學習,只用一個手機攝像頭就可以實現給自拍加AR特效的工作原理。

谷歌與歐洲研究機構CERN合作創建了一個增強現實應用程序,可以讓用戶通過手機體驗宇宙大爆炸Big Bang,感受上帝創世紀時候的宏偉壯闊。

應用程序將帶給你一場360度的奇幻旅程,從宇宙誕生開始,到第一顆恒星誕生,直到我們的太陽系,以及地球的出現。

更有意思的是,你還可以以大爆炸作為背景,進行自拍!可以說是超炫酷了。各大應用商店搜索Google Arts & Culture下載。

如果你使用的是Android手機,你需要確認一下是否裝了ARCore。

ARCore是谷歌推出的搭建增強現實(Augmented Reality,簡稱 AR)應用程序的軟件平臺,類似蘋果的ARKit,它可以利用云軟件和設備硬件的進步,將數字對象放到現實世界中。

用ARCore實現AR效果

增強現實,是一種實時地計算攝影機影像的位置及角度并加上相應圖像的技術,這種技術的目標是在屏幕上把虛擬世界套在現實世界并進行互動。

這種技術最早于1990年提出。隨著隨身電子產品運算能力的提升,增強現實的用途越來越廣。比如下面這個動圖,通過AR設備你可以看到實際并不存在的藍色光圈。

AR已經被廣泛應用于自拍、短視頻、直播app中,可以實現一些好玩的效果。而其中最關鍵的挑戰在于將虛擬內容適當地錨定到現實世界中。這個過程需要一套獨特的感知技術,能夠跟蹤每個微笑,皺眉或傻笑背后的高動態表面幾何。

所以今天我們就為大家介紹一下,開發者如何借助最新版本ARCore的全新Augmented Faces API,使機器學習(ML)來推斷近似的3D表面幾何形狀,從而只需要一個攝像機輸入,無需專用的深度傳感器就可以實現給自拍添加動畫特效,比如添加眼鏡、3D帽子等物品。

3D網格及其實現的一些效果

這種方法提供了實時速度的AR效果,使用TensorFlow Lite進行移動CPU推理或其可用的新移動GPU功能。

此技術與YouTube Stories的新creator effect效果相同,并且通過最新的ARCore SDK版本和ML Kit Face Contour Detection API,可供更廣泛的開發人員社區使用。

自拍AR的ML pipeline

我們的ML pipeline由兩個一起工作的實時深度神經網絡模型組成。一個探測器,在整個圖像上運行,并計算面部位置;一個通用3D網格模型,在這些位置上運行并通過回歸預測近似表面幾何。

精確地裁剪面部可以大大減少對共同數據增強的需求,例如由旋轉,平移和比例變化組成的仿射變換。

它允許網絡將其大部分容量用于坐標預測準確度,這對于實現虛擬內容的正確錨定至關重要。

一旦需要的位置被裁剪,網格網絡每次僅應用于單個幀,使用窗口平滑以便在面部靜止時減少噪聲,同時避免在快速移動時滯后。

3D網格

對于我們的3D網格,我們采用了傳遞學習并訓練了一個具有多個目標的網絡。

網絡同時預測合成、渲染數據上的3D網格坐標,以及類似于MLKit提供的帶注釋的真實世界數據的2D語義輪廓。

由此產生的網絡不僅在合成上,而且在現實世界數據上為我們提供了合理的3D網格預測。

所有模型都接受來自地理上不同數據集的數據培訓,隨后在平衡,多樣化的測試集上進行測試,以獲得定性和定量性能。

3D網格網絡接收裁剪的視頻幀作為輸入。它不依賴于額外的深度輸入,因此它也可以應用于預先錄制的視頻。

該模型輸出3D點的位置,以及在輸入中存在并合理對齊的面部概率。一種常見的替代方法是預測每個地標的2D熱圖,但它不適合深度預測,并且對于這么多點具有高計算成本。

通過迭代引導和細化預測來進一步提高模型的準確性和魯棒性。這樣我們就可以將我們的數據集增長到越來越具有挑戰性的案例,例如鬼臉,斜角和遮擋。

數據集增強技術還擴展了可用的地面實況數據,開發了模型對相機缺陷或極端光照條件等工件的彈性。

數據集擴展和改進pipeline

我們使用TensorFlow Lite進行設備上的神經網絡推理。新推出的GPU后端加速可在可用的情況下提升性能,并顯著降低功耗。

此外,為了涵蓋廣泛的消費類硬件,我們設計了各種具有不同性能和效率特性的模型架構。

較輕的網絡最重要的區別是殘余塊布局和可接受的輸入分辨率(最輕的模型中為128x128像素,而最復雜的模型中為256x256)。

我們還改變了層數和子采樣率(輸入分辨率隨網絡深度減小的速度)。

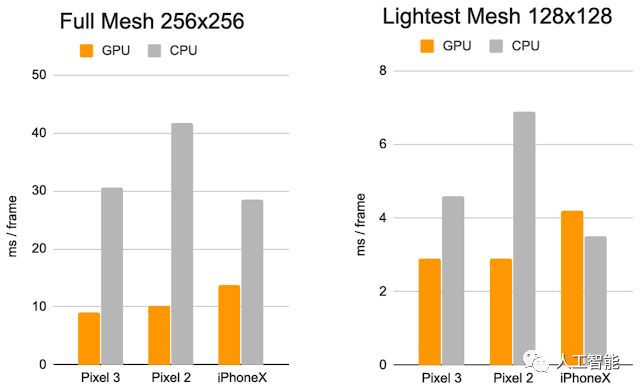

每幀的推理時間:CPU與GPU

這些優化的結果是使用較輕型號的顯著加速,AR效果質量的降低最小。

比較最復雜(左)和最輕的模型(右)。

在輕型模型上,時間一致性以及唇部和眼睛跟蹤略微降低

這些努力的最終結果是通過以下方式為用戶體驗在YouTube,ARCore和其他客戶中提供令人信服的,逼真的自拍AR效果:

通過環境映射模擬光反射,實現眼鏡的逼真渲染

通過將虛擬對象陰影投射到面網格上來實現自然光照

對面部遮擋建模以隱藏面部后面的虛擬對象部分,例如虛擬眼鏡,如下圖所示

YouTube Stories基于3D網格的逼真虛擬眼鏡

此外,我們通過以下方式實現高度逼真的妝效:

建模在嘴唇和嘴唇上應用的鏡面反射

通過使用亮度感知材料進行面部繪畫

案例研究將不同光照條件下5個主題的真實化妝與AR妝容進行比較。

未來,谷歌計劃將此技術擴展到更多谷歌產品中。

-

手機

+關注

關注

35文章

6881瀏覽量

157687 -

谷歌

+關注

關注

27文章

6171瀏覽量

105491 -

Ar

+關注

關注

24文章

5098瀏覽量

169671

原文標題:138億年在手中!谷歌用手機體驗宇宙大爆炸,還教你用機器學習實現AR自拍特效

文章出處:【微信號:worldofai,微信公眾號:worldofai】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

谷歌推出ARCore,手機上體驗宇宙大爆炸,實現AR效果

谷歌推出ARCore,手機上體驗宇宙大爆炸,實現AR效果

評論