生成對(duì)抗網(wǎng)絡(luò) (GAN) 是深度學(xué)習(xí)中最有趣、最受歡迎的應(yīng)用之一。本文列出了 10 篇關(guān)于 GAN 的論文,這些論文將為你提供一個(gè)很好的對(duì) GAN 的介紹,幫助你理解最先進(jìn)技術(shù)的基礎(chǔ)。

本文選擇的10篇GAN論文包括:

DCGANs

Improved Techniques for Training GANs

Conditional GANs

Progressively Growing GANs

BigGAN

StyleGAN

CycleGAN

Pix2Pix

StackGAN

Generative Adversarial Networks

DCGANs?—?Radford et al.(2015)

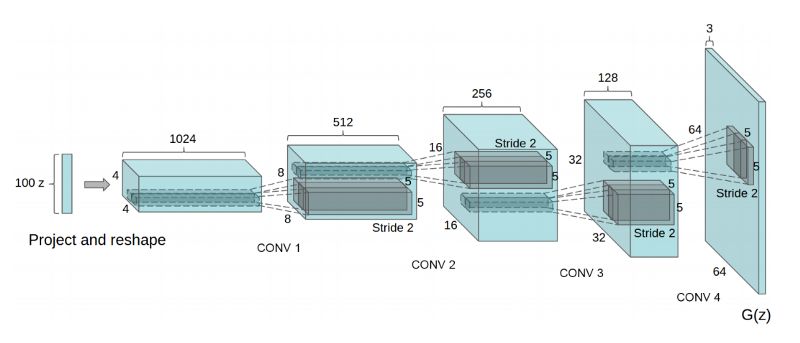

我建議你以DCGAN這篇論文來(lái)開(kāi)啟你的GAN之旅。這篇論文展示了卷積層如何與GAN一起使用,并為此提供了一系列架構(gòu)指南。這篇論文還討論了GAN特征的可視化、潛在空間插值、利用判別器特征來(lái)訓(xùn)練分類器、評(píng)估結(jié)果等問(wèn)題。所有這些問(wèn)題都必然會(huì)出現(xiàn)在你的GAN研究中。

總之,DCGAN論文是一篇必讀的GAN論文,因?yàn)樗砸环N非常清晰的方式定義架構(gòu),因此很容易從一些代碼開(kāi)始,并開(kāi)始形成開(kāi)發(fā)GAN的直覺(jué)。

DCGAN模型:具有上采樣卷積層的生成器架構(gòu)

論文:

Unsupervised Representation Learning with Deep Convolutional Generative Adversarial Networks

Alec Radford, Luke Metz, Soumith Chintala

https://arxiv.org/abs/1511.06434

改進(jìn)GAN訓(xùn)練的技術(shù)——?Salimans et al.(2016)

這篇論文(作者包括Ian Goodfellow)根據(jù)上述DCGAN論文中列出的架構(gòu)指南,提供了一系列建議。這篇論文將幫助你了解GAN不穩(wěn)定性的最佳假設(shè)。此外,本文還提供了許多用于穩(wěn)定DCGAN訓(xùn)練的其他機(jī)器,包括特征匹配、minibatch識(shí)別、歷史平均、單邊標(biāo)簽平滑和虛擬批標(biāo)準(zhǔn)化。使用這些技巧來(lái)構(gòu)建一個(gè)簡(jiǎn)單的DCGAN實(shí)現(xiàn)是一個(gè)很好的練習(xí),有助于更深入地了解GAN。

論文:

Improved Techniques for Training GANs

Tim Salimans, Ian Goodfellow, Wojciech Zaremba, Vicki Cheung, Alec Radford, Xi Chen

https://arxiv.org/abs/1606.03498

Conditional GANs?—?Mirza and Osindero(2014)

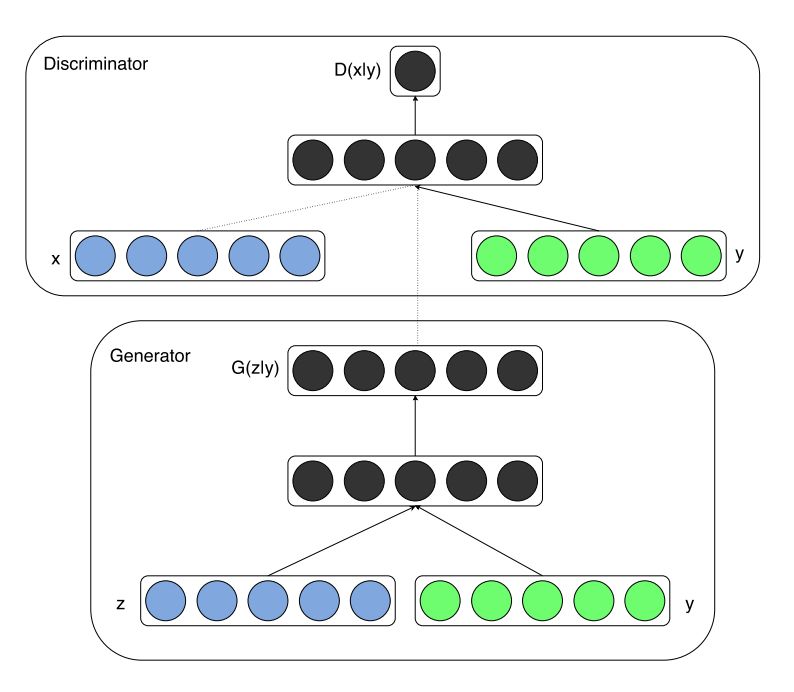

這是一篇很好的論文,讀起來(lái)很順暢。條件GAN(Conditional GAN)是最先進(jìn)的GAN之一。論文展示了如何整合數(shù)據(jù)的類標(biāo)簽,從而使GAN訓(xùn)練更加穩(wěn)定。利用先驗(yàn)信息對(duì)GAN進(jìn)行調(diào)節(jié)這樣的概念,在此后的GAN研究中是一個(gè)反復(fù)出現(xiàn)的主題,對(duì)于側(cè)重于image-to-image或text-to-image的論文尤其重要。

Conditional GAN架構(gòu):除了隨機(jī)噪聲向量z之外,類標(biāo)簽y被連接在一起作為網(wǎng)絡(luò)的輸入

論文:

Conditional Generative Adversarial Nets

Mehdi Mirza, Simon Osindero

https://arxiv.org/abs/1411.1784

Progressively Growing GANs—?Karras et al.(2017)

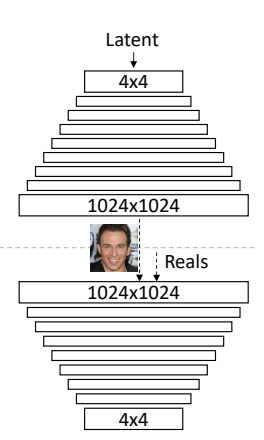

Progressively Growing GAN (PG-GAN)有著驚人的結(jié)果,以及對(duì)GAN問(wèn)題的創(chuàng)造性方法,因此也是一篇必讀論文。

這篇GAN論文來(lái)自NVIDIA Research,提出以一種漸進(jìn)增大(progressive growing)的方式訓(xùn)練GAN,通過(guò)使用逐漸增大的GAN網(wǎng)絡(luò)(稱為PG-GAN)和精心處理的CelebA-HQ數(shù)據(jù)集,實(shí)現(xiàn)了效果令人驚嘆的生成圖像。作者表示,這種方式不僅穩(wěn)定了訓(xùn)練,GAN生成的圖像也是迄今為止質(zhì)量最好的。

它的關(guān)鍵想法是漸進(jìn)地增大生成器和鑒別器:從低分辨率開(kāi)始,隨著訓(xùn)練的進(jìn)展,添加新的層對(duì)越來(lái)越精細(xì)的細(xì)節(jié)進(jìn)行建模。“Progressive Growing”指的是先訓(xùn)練4x4的網(wǎng)絡(luò),然后訓(xùn)練8x8,不斷增大,最終達(dá)到1024x1024。這既加快了訓(xùn)練速度,又大大穩(wěn)定了訓(xùn)練速度,并且生成的圖像質(zhì)量非常高。

Progressively Growing GAN的多尺度架構(gòu),模型從4×4 逐步增大到1024×1024

論文:

Progressive Growing of GANs for Improved Quality, Stability, and Variation

Tero Karras, Timo Aila, Samuli Laine, Jaakko Lehtinen

https://arxiv.org/abs/1710.10196

BigGAN?—?Brock et al.(2019)

BigGAN模型是基于ImageNet生成圖像質(zhì)量最高的模型之一。該模型很難在本地機(jī)器上實(shí)現(xiàn),而且BigGAN有許多組件,如Self-Attention、Spectral Normalization和帶有投影鑒別器的cGAN,這些組件在各自的論文中都有更好的解釋。不過(guò),這篇論文對(duì)構(gòu)成當(dāng)前最先進(jìn)技術(shù)水平的基礎(chǔ)論文的思想提供了很好的概述,因此非常值得閱讀。

BigGAN生成的圖像

論文:

Large Scale GAN Training for High Fidelity Natural Image Synthesis

Andrew Brock, Jeff Donahue, Karen Simonyan

https://arxiv.org/abs/1809.11096

StyleGAN?—?Karras et al.(2019)

StyleGAN模型可以說(shuō)是最先進(jìn)的,特別是利用了潛在空間控制。該模型借鑒了神經(jīng)風(fēng)格遷移中一種稱為自適應(yīng)實(shí)例標(biāo)準(zhǔn)化(AdaIN)的機(jī)制來(lái)控制潛在空間向量z。映射網(wǎng)絡(luò)和AdaIN條件在整個(gè)生成器模型中的分布的結(jié)合使得很難自己實(shí)現(xiàn)一個(gè)StyleGAN,但它仍是一篇很好的論文,包含了許多有趣的想法。

StyleGAN架構(gòu),允許潛在空間控制

論文:

A Style-Based Generator Architecture for Generative Adversarial Networks

Tero Karras, Samuli Laine, Timo Aila

https://arxiv.org/abs/1812.04948

CycleGAN?—?Zhu et al.(2017)

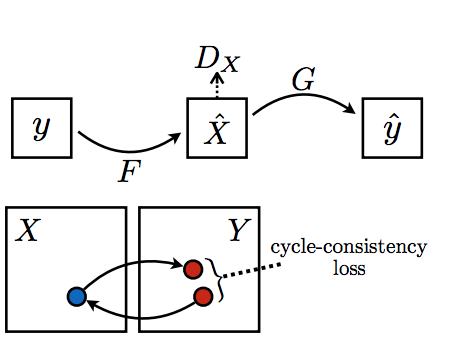

CycleGAN的論文不同于前面列舉的6篇論文,因?yàn)樗懻摰氖莍mage-to-image的轉(zhuǎn)換問(wèn)題,而不是隨機(jī)向量的圖像合成問(wèn)題。CycleGAN更具體地處理了沒(méi)有成對(duì)訓(xùn)練樣本的image-to-image轉(zhuǎn)換的情況。然而,由于Cycle-Consistency loss公式的優(yōu)雅性,以及如何穩(wěn)定GAN訓(xùn)練的啟發(fā)性,這是一篇很好的論文。CycleGAN有很多很酷的應(yīng)用,比如超分辨率,風(fēng)格轉(zhuǎn)換,例如將馬的圖像變成斑馬。

Cycle Consistency Loss背后的主要想法,一個(gè)句子從法語(yǔ)翻譯成英語(yǔ),再翻譯回法語(yǔ),應(yīng)該跟原來(lái)的是同一個(gè)句子

論文:

Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks

Jun-Yan Zhu, Taesung Park, Phillip Isola, Alexei A. Efros

https://arxiv.org/abs/1703.10593

Pix2Pix?—?Isola et al.(2016)

Pix2Pix是另一種圖像到圖像轉(zhuǎn)換的GAN模型。該框架使用成對(duì)的訓(xùn)練樣本,并在GAN模型中使用多種不同的配置。讀這篇論文時(shí),我覺(jué)得最有趣部分是關(guān)于PatchGAN的討論。PatchGAN通過(guò)觀察圖像的70×70的區(qū)域來(lái)判斷它們是真的還是假的,而不是查看整個(gè)圖像。該模型還展示了一個(gè)有趣的U-Net風(fēng)格的生成器架構(gòu),以及在生成器模型中使用ResNet風(fēng)格的skip connections。Pix2Pix有很多很酷的應(yīng)用,比如將草圖轉(zhuǎn)換成逼真的照片。

使用成對(duì)的訓(xùn)練樣本進(jìn)行Image-to-Image轉(zhuǎn)換

論文:

Image-to-Image Translation with Conditional Adversarial Networks

Phillip Isola, Jun-Yan Zhu, Tinghui Zhou, Alexei A. Efros

https://arxiv.org/abs/1611.07004

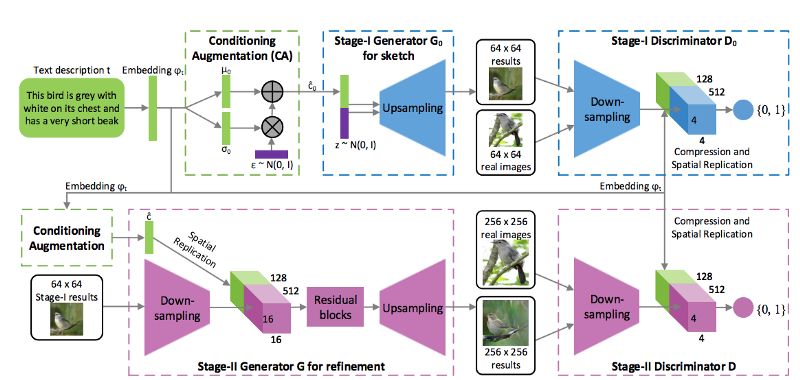

StackGAN?—?Zhang et al.(2017)

StackGAN的論文與本列表中的前幾篇論文相比非常不同。它與Conditional GAN和Progressively Growing GANs最為相似。StackGAN模型的工作原理與Progressively Growing GANs相似,因?yàn)樗梢栽诙鄠€(gè)尺度上工作。StackGAN首先輸出分辨率為64×64的圖像,然后將其作為先驗(yàn)信息生成一個(gè)256×256分辨率的圖像。

StackGAN是從自然語(yǔ)言文本生成圖像。這是通過(guò)改變文本嵌入來(lái)實(shí)現(xiàn)的,以便捕獲視覺(jué)特征。這是一篇非常有趣的文章,如果StyleGAN中顯示的潛在空間控制與StackGAN中定義的自然語(yǔ)言接口相結(jié)合,想必會(huì)非常令人驚訝。

基于文本嵌入的StackGAN多尺度架構(gòu)背后的想法

論文:

StackGAN: Text to Photo-realistic Image Synthesis with Stacked Generative Adversarial Networks

Han Zhang, Tao Xu, Hongsheng Li, Shaoting Zhang, Xiaogang Wang, Xiaolei Huang, Dimitris Metaxas

https://arxiv.org/abs/1612.03242

Generative Adversarial Networks?—?Goodfellow et al.(2014)

Ian Goodfellow的原始GAN論文對(duì)任何研究GAN的人來(lái)說(shuō)都是必讀的。這篇論文定義了GAN框架,并討論了“非飽和”損失函數(shù)。論文還給出了最優(yōu)判別器的推導(dǎo),這是近年來(lái)GAN論文中經(jīng)常出現(xiàn)的一個(gè)證明。論文還在MNIST、TFD和CIFAR-10圖像數(shù)據(jù)集上對(duì)GAN的有效性進(jìn)行了實(shí)驗(yàn)驗(yàn)證。

論文:

Generative Adversarial Networks

Ian J. Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, David Warde-Farley, Sherjil Ozair, Aaron Courville, Yoshua Bengio

https://arxiv.org/abs/1406.2661

-

GaN

+關(guān)注

關(guān)注

19文章

1939瀏覽量

73549 -

生成器

+關(guān)注

關(guān)注

7文章

315瀏覽量

21031 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1208瀏覽量

24716

原文標(biāo)題:必讀!生成對(duì)抗網(wǎng)絡(luò)GAN論文TOP 10

文章出處:【微信號(hào):aicapital,微信公眾號(hào):全球人工智能】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

Google兩款先進(jìn)生成式AI模型登陸Vertex AI平臺(tái)

直流變頻焊接控制器:先進(jìn)技術(shù)在焊接領(lǐng)域的革新應(yīng)用探索

庫(kù)克稱iPhone16是最先進(jìn)的iPhone

NVIDIA Nemotron-4 340B模型幫助開(kāi)發(fā)者生成合成訓(xùn)練數(shù)據(jù)

憶聯(lián)以完善的產(chǎn)品矩陣與先進(jìn)技術(shù)為AI PC助力

首屆人工智能先進(jìn)技術(shù)成果供需對(duì)接大會(huì)硬核又新潮!

生成對(duì)抗網(wǎng)絡(luò)(GANs)的原理與應(yīng)用案例

格芯收購(gòu) Tagore Technology 的 GaN 技術(shù)

神經(jīng)網(wǎng)絡(luò)架構(gòu)有哪些

瑞薩電子完成對(duì)Transphorm的收購(gòu),加速GaN技術(shù)布局

TüV萊茵舉辦光儲(chǔ)充先進(jìn)技術(shù)研討會(huì),攜手行業(yè)伙伴共創(chuàng)綠色未來(lái)

思科完成對(duì)Isovalent的收購(gòu)

深度學(xué)習(xí)生成對(duì)抗網(wǎng)絡(luò)(GAN)全解析

生成式人工智能和感知式人工智能的區(qū)別

AI克隆技術(shù)可用于創(chuàng)建虛擬人物形象!它的技術(shù)原理和發(fā)展趨勢(shì)

生成對(duì)抗網(wǎng)絡(luò)GAN論文TOP 10,幫助你理解最先進(jìn)技術(shù)的基礎(chǔ)

生成對(duì)抗網(wǎng)絡(luò)GAN論文TOP 10,幫助你理解最先進(jìn)技術(shù)的基礎(chǔ)

評(píng)論