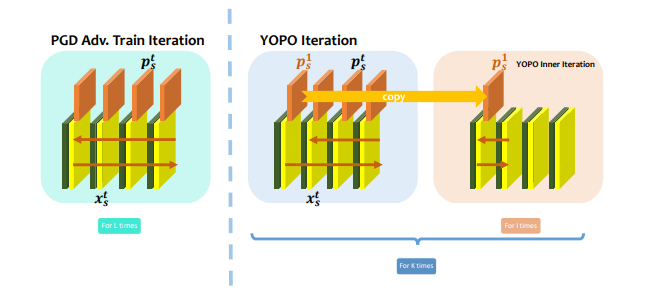

在YouOnly PropagateOnce(YOPO)的算法中,研究人員開發(fā)了出一種加速對抗訓(xùn)練的有效策略。他們將神經(jīng)網(wǎng)絡(luò)的對抗訓(xùn)練重新組織為差異化游戲,并為其開發(fā)了龐特里亞金(Pontryagin)的極大原則。

通過最大原理,他們發(fā)現(xiàn)對抗層只與第一層的權(quán)重相結(jié)合,這有助于將對抗層更新從反向傳播梯度計算中分離出來。

這樣做,YOPO避免了訪問梯度所需的次數(shù),這顯著減少了計算時間。為了證明其有效性,研究人員在MNIST和CIFAR10上進(jìn)行了實(shí)驗(yàn),并發(fā)現(xiàn)使用YOPO訓(xùn)練的模型與PGD對抗訓(xùn)練的模型在清潔數(shù)據(jù)和對抗擾動數(shù)據(jù)上具有相似的表現(xiàn),但YOPO訓(xùn)練的模型具有更優(yōu)秀的性能和較低的計算成本。

YOPO讓人聯(lián)想到Y(jié)OLO,但與YOLO不同的是,YOPO算法是解決龐特里亞金極大原理的一種方法。龐特里亞金的極大原理具有很大的潛力,因?yàn)樗梢詥l(fā)各種算法的設(shè)計,從而分解對抗更新和數(shù)據(jù)反向傳播。

我們希望YOPO能夠?yàn)閺?qiáng)大的ML應(yīng)用程序修復(fù)對抗性示例。

如果你發(fā)現(xiàn)了對抗性示例,恭喜你,從現(xiàn)在開始它們不再是bug

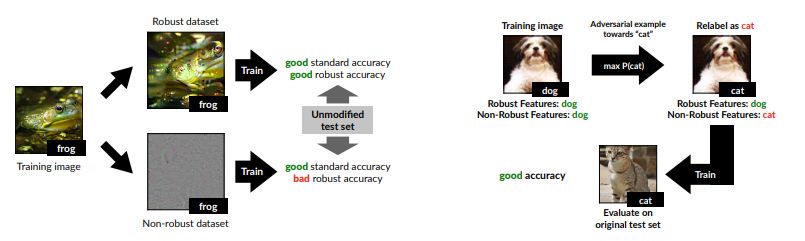

與傳統(tǒng)觀點(diǎn)相反,一群學(xué)者最近發(fā)表了一種關(guān)于對抗性示例現(xiàn)象的新觀點(diǎn)。根據(jù)他們的說法,對抗性的示例自然地來自于標(biāo)準(zhǔn)機(jī)器學(xué)習(xí)數(shù)據(jù)集中的高度預(yù)測但非魯棒的特征。

他們證明了對抗性的示例可以直接歸因于非魯棒特征的存在。非魯棒特征意為從數(shù)據(jù)分布的模式中得到的具有高度預(yù)測性的特征,但這對人類來說是脆弱和難以理解的。

他們將對抗脆弱性作為主導(dǎo)監(jiān)督學(xué)習(xí)范式的主要結(jié)果,這表明:對抗脆弱性是我們模型對數(shù)據(jù)中良好概括特征的敏感性的直接結(jié)果。

他們通過明確地解釋標(biāo)準(zhǔn)數(shù)據(jù)集中魯棒的和非魯棒的特征,為他們的假設(shè)提供了支持。此外,他們表明單獨(dú)的非強(qiáng)大功能對于良好的推廣是令人滿意的。

本研究論文中的研究結(jié)果似乎得出結(jié)論,只有在采用魯棒訓(xùn)練時,分類器才能學(xué)習(xí)完全準(zhǔn)確且完全穩(wěn)健的決策邊界。因此,鑒于這些元素存在于真實(shí)世界的數(shù)據(jù)集中,分類器利用在人類選擇的相似概念下恰好是非魯棒的高度預(yù)測特征應(yīng)該不足為奇。

此外,從可解釋性的角度來看,只要模型依賴于非魯棒特征,就不可能期望模型解釋既對人類有意義又完全依據(jù)模型。為了獲得可解釋和強(qiáng)大的模型,需要人類進(jìn)行先驗(yàn)后,再進(jìn)行模型訓(xùn)練。

下一代MobileNetV3定義

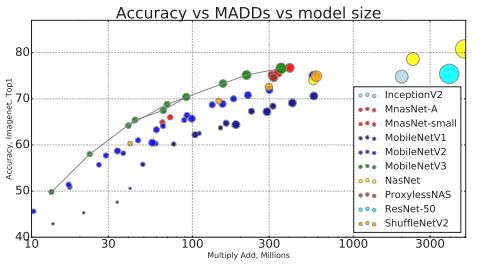

2017年,GoogleAI宣布發(fā)布了MobileNets,這種計算機(jī)視覺模型旨在于考慮設(shè)備或嵌入式應(yīng)用程序資源受限的情況下,有效并最大限度地提高準(zhǔn)確性。現(xiàn)在,研究人員發(fā)布了MobileNetV3,它代表了基于互補(bǔ)搜索技術(shù)和新架構(gòu)設(shè)計相結(jié)合的下一代MobileNets。

MobileNetV3通過結(jié)合使用NetAdapt算法補(bǔ)充的硬件感知網(wǎng)絡(luò)架構(gòu)搜索(NAS)調(diào)整到移動電話CPU,然后通過尖端架構(gòu)改進(jìn)進(jìn)行性能提升。

在此過程之后,研究人員創(chuàng)建了兩個新的MobileNet模型:MobileNetV3-Large和MobileNetV3-Small,分別針對高資源和低資源的使用情況。然后對模型進(jìn)行調(diào)整并應(yīng)用于對象檢測和語義分割任務(wù)。

MobileNetV3的大型和小型模型將使研究人員能夠繼續(xù)進(jìn)步,從而提供下一代高度精確的網(wǎng)絡(luò)模型,這將促進(jìn)設(shè)備端計算機(jī)視覺的進(jìn)步。

半監(jiān)督學(xué)習(xí)的整體性方案

半監(jiān)督式學(xué)習(xí)已經(jīng)證明,它是利用未標(biāo)記的數(shù)據(jù)來減輕機(jī)器學(xué)習(xí)對大型標(biāo)記數(shù)據(jù)集依賴的一種強(qiáng)有力的方法。谷歌的一組研究人員已經(jīng)通過對目前領(lǐng)先的半監(jiān)督學(xué)習(xí)方法的整合而提出了一種新的算法,即MixMatch.新算法的工作原理是通過猜測新增未標(biāo)記數(shù)據(jù)的低熵標(biāo)簽并通過MixUp混合已標(biāo)記和未標(biāo)記數(shù)據(jù).

評估顯示,MixMatch在許多數(shù)據(jù)集和標(biāo)記的數(shù)據(jù)量等方面極大地顯示了其優(yōu)越性.例如,在有250個標(biāo)簽的CIFAR-10,STL-10的系數(shù)為2的情況下上,錯誤率從38%下降到了11%

MixMatch展現(xiàn)出其相對于傳統(tǒng)方法的優(yōu)越性.這一研究更有價值的一點(diǎn)在于對半監(jiān)督學(xué)習(xí)文獻(xiàn)和相關(guān)混合方法研究的進(jìn)一步整合,這講促進(jìn)對大幅提高算法效率因素的探索。

目前,MixMatch可以幫助我們實(shí)現(xiàn)更好的差別隱私交易中的準(zhǔn)確性和私密性。

針對神經(jīng)網(wǎng)絡(luò)的對抗式再編程

在近期的研究中,谷歌研究員嘗試了一個具有挑戰(zhàn)性的目標(biāo):在不提供攻擊者對既定目標(biāo)期望輸出的條件下,重新編程來模擬攻擊者選擇的任務(wù)。

研究人員發(fā)現(xiàn),經(jīng)過訓(xùn)練的神經(jīng)網(wǎng)絡(luò)可以被重新編程來分類排列的圖像,這些圖像不保留任何原始的空間結(jié)構(gòu),這表明跨領(lǐng)域重新編程是可能的。他們還發(fā)現(xiàn),經(jīng)過訓(xùn)練的神經(jīng)網(wǎng)絡(luò)比隨機(jī)系統(tǒng)更容易受到對抗式重新編程的影響,即使在數(shù)據(jù)結(jié)構(gòu)與主要任務(wù)中的數(shù)據(jù)結(jié)構(gòu)差異很大的情況下,重新編程仍然是成功的。

這就是對圖像領(lǐng)域中的分類任務(wù)進(jìn)行對抗式重新編程的演示。類似的攻擊在音頻、視頻、文本或其他方面能成功嗎?以RNNs的對抗式重新編程為例——攻擊者只需要在RNN中找到用于執(zhí)行簡單操作的輸入,就可以重新編程模型來執(zhí)行任何計算任務(wù)。

如果一個特別設(shè)計的輸入可以重構(gòu)整個機(jī)器學(xué)習(xí)系統(tǒng),攻擊者將會達(dá)到難以預(yù)料的可怕效果。例如,攻擊者很容易竊取計算資源或執(zhí)行違反云服務(wù)編程的任務(wù)。所有這一切都表明了對抗式重新編程可能給人工智能系統(tǒng)帶來的潛在威脅。

隨著人工智能的不斷發(fā)展,認(rèn)識到技術(shù)的進(jìn)步可能帶來的潛在挑戰(zhàn),并努力找到減輕或抵御這些挑戰(zhàn)的可能方法,對人工智能的未來十分重要。

-

人工智能

+關(guān)注

關(guān)注

1793文章

47615瀏覽量

239556

原文標(biāo)題:Google AI再定義設(shè)備端機(jī)器學(xué)習(xí),DNNs智能手機(jī)端實(shí)現(xiàn)實(shí)時運(yùn)行 | AI一周學(xué)術(shù)

文章出處:【微信號:BigDataDigest,微信公眾號:大數(shù)據(jù)文摘】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

基于國產(chǎn)化鴻道Intewell操作系統(tǒng)的高性能實(shí)時運(yùn)動控制解決方案

什么是機(jī)器學(xué)習(xí)?通過機(jī)器學(xué)習(xí)方法能解決哪些問題?

使用機(jī)器學(xué)習(xí)和NVIDIA Jetson邊緣AI和機(jī)器人平臺打造機(jī)器人導(dǎo)盲犬

AI干貨補(bǔ)給站 | 深度學(xué)習(xí)與機(jī)器視覺的融合探索

AI大模型與深度學(xué)習(xí)的關(guān)系

AI大模型與傳統(tǒng)機(jī)器學(xué)習(xí)的區(qū)別

RISC-V如何支持不同的AI和機(jī)器學(xué)習(xí)框架和庫?

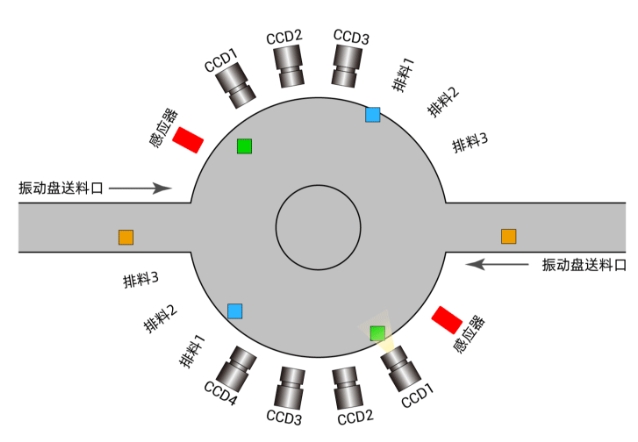

PCIe實(shí)時運(yùn)動控制卡的雙盤視覺篩選機(jī)上位機(jī)開發(fā)應(yīng)用

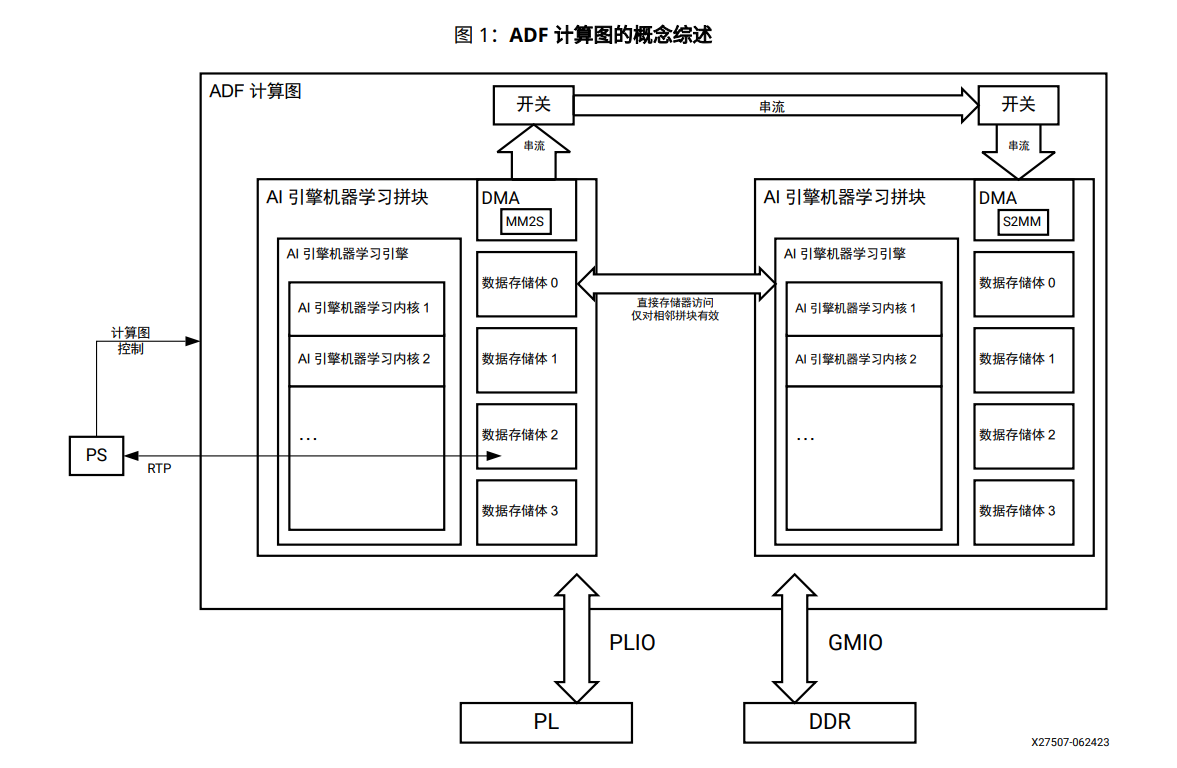

AI引擎機(jī)器學(xué)習(xí)陣列指南

Google AI定義機(jī)器學(xué)習(xí) DNNs實(shí)現(xiàn)實(shí)時運(yùn)行

Google AI定義機(jī)器學(xué)習(xí) DNNs實(shí)現(xiàn)實(shí)時運(yùn)行

評論