DeepMind提出一種全新的“深度壓縮感知”框架,將壓縮感知與深度學(xué)習(xí)相結(jié)合,顯著提高了信號恢復(fù)的性能和速度,并提出一種改進(jìn)GAN的新方法。

壓縮感知(CS)是一種優(yōu)雅的框架,用于從壓縮信號中恢復(fù)稀疏信號。

例如,CS可以利用自然圖像的結(jié)構(gòu),僅從少量的隨機(jī)測量中恢復(fù)圖像。

CS具有靈活性和數(shù)據(jù)效率高的優(yōu)點(diǎn),但由于其稀疏性和昂貴的重建過程,CS的應(yīng)用受到限制。

那么,將CS與深度學(xué)習(xí)的思想相結(jié)合,是否能得到更優(yōu)雅的框架呢?

近日,DeepMind的Yan Wu,Mihaela Rosca,Timothy Lillicrap等研究人員在ICML 2019發(fā)表論文Deep Compressed Sensing,基于前人將CS和神經(jīng)網(wǎng)絡(luò)生成器結(jié)合起來的方法,提出一個(gè)全新的框架。

深度壓縮感知(DCS)框架通過聯(lián)合訓(xùn)練生成器和通過元學(xué)習(xí)優(yōu)化重建過程,顯著提高了信號恢復(fù)的性能和速度。作者探索了針對不同目標(biāo)的測量訓(xùn)練,并給予最小化測量誤差推導(dǎo)出一系列模型。

作者表示:“我們證明了,生成對抗網(wǎng)絡(luò)(GANs)可以被視為這個(gè)模型家族中的一個(gè)特例。借鑒CS的思想,我們開發(fā)了一種使用來自鑒別器的梯度信息來改進(jìn)GAN的新方法。”

壓縮感知,一種優(yōu)雅的框架

壓縮感知是什么呢?

有人這樣評價(jià)道:

壓縮感知是信號處理領(lǐng)域進(jìn)入 21 世紀(jì)以來取得的最耀眼的成果之一,并在磁共振成像、圖像處理等領(lǐng)域取得了有效應(yīng)用。壓縮感知理論在其復(fù)雜的數(shù)學(xué)表述背后蘊(yùn)含著非常精妙的思想。基于一個(gè)有想象力的思路,輔以嚴(yán)格的數(shù)學(xué)證明,壓縮感知實(shí)現(xiàn)了神奇的效果,突破了信號處理領(lǐng)域的金科玉律 —— 奈奎斯特采樣定律。即,在信號采樣的過程中,用很少的采樣點(diǎn),實(shí)現(xiàn)了和全采樣一樣的效果。[1]

編碼和解碼是通信中的核心問題。壓縮感知(CS)提供了將編碼和解碼分離為獨(dú)立的測量和重建過程的框架。與常用的自動(dòng)編碼模型(具有端到端訓(xùn)練的編碼器和解碼器對)不同,CS通過在線優(yōu)化從低維測量重建信號。

該模型架構(gòu)具有高度的靈活性和采樣效率:高維信號可以從少量隨機(jī)測量數(shù)據(jù)中重建,幾乎不需要或根本不需要任何訓(xùn)練。

CS已經(jīng)成功地應(yīng)用于測量噪聲大、成本高的場景,如MRI。它的采樣效率使得諸如“單像素相機(jī)”的開發(fā)成為可能,可以從單個(gè)光傳感器重全分辨率的圖像。

然而,尤其是在現(xiàn)代深度學(xué)習(xí)方法蓬勃發(fā)展的大規(guī)模數(shù)據(jù)處理中,CS的廣泛應(yīng)用受到了它的稀疏信號假設(shè)和重建優(yōu)化過程緩慢的阻礙。

最近,Bora et al. (2017)將CS與單獨(dú)訓(xùn)練的神經(jīng)網(wǎng)絡(luò)生成器相結(jié)合。雖然這些預(yù)訓(xùn)練的神經(jīng)網(wǎng)絡(luò)沒有針對CS進(jìn)行優(yōu)化,但它們表現(xiàn)出的重建性能優(yōu)于現(xiàn)有的方法,如Lasso (Tibshirani, 1996)。

在本文中,我們提出一種深度壓縮感知框架(deep compressed sensing,DCS),在此框架中,神經(jīng)網(wǎng)絡(luò)可以從頭開始訓(xùn)練,用于測量和在線重建。

我們證明,深度壓縮感知框架可以自然地生成一系列模型,包括GANs,可以通過訓(xùn)練具有不同目標(biāo)的測量函數(shù)推導(dǎo)得出。

這項(xiàng)工作的貢獻(xiàn)如下:

我們展示了如何在CS框架下訓(xùn)練深度神經(jīng)網(wǎng)絡(luò)。

結(jié)果表明,與以往的模型相比,元學(xué)習(xí)重建方法具有更高的精度和快幾個(gè)數(shù)量級的速度。

我們開發(fā)了一種新的基于潛在優(yōu)化的GAN訓(xùn)練算法,提高了GAN的性能。

我們將這個(gè)新框架擴(kuò)展到訓(xùn)練半監(jiān)督GAN,并表明潛在優(yōu)化會(huì)產(chǎn)生具有語義意義的潛在空間。

深度壓縮感知:結(jié)合深度神經(jīng)網(wǎng)絡(luò)

我們首先展示了將元學(xué)習(xí)與Bora et al. (2017)的模型相結(jié)合的好處。然后將測量矩陣推廣到參數(shù)化的測量函數(shù),包括深度神經(jīng)網(wǎng)絡(luò)。

之前的工作依賴于 random projection作為測量函數(shù),而我們的方法通過將RIP作為訓(xùn)練目標(biāo)來學(xué)習(xí)測量函數(shù)。然后,我們通過在測量上添加RIP之外的其他特性,得到了兩個(gè)新的模型,包括一個(gè)帶有鑒別器引導(dǎo)的潛在優(yōu)化的GAN模型,這導(dǎo)致了更穩(wěn)定的訓(xùn)練動(dòng)態(tài)和更好的結(jié)果。

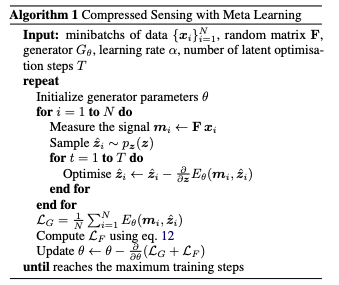

壓縮感知與元學(xué)習(xí)

我們假設(shè)CSGM(Bora et al. 2017)的運(yùn)行時(shí)效率和性能可以通過使用元學(xué)習(xí)訓(xùn)練潛在的優(yōu)化過程、通過梯度下降步驟的反向傳播來提高。

CS模型的潛在優(yōu)化過程可能需要數(shù)百個(gè)或數(shù)千個(gè)梯度下降步驟。通過使用元學(xué)習(xí)來優(yōu)化這個(gè)優(yōu)化過程,我們的目標(biāo)是用更少的更新來實(shí)現(xiàn)類似的結(jié)果。

為此,我們訓(xùn)練模型參數(shù),以及潛在的優(yōu)化程序,以盡量減低預(yù)期的測量誤差:

我們的算法如下:

算法1:元學(xué)習(xí)壓縮感知

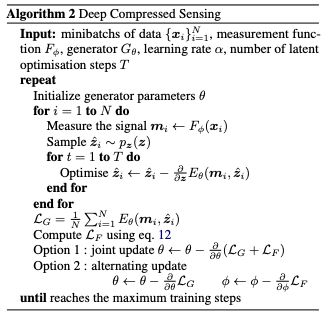

具有學(xué)習(xí)測量函數(shù)的深度壓縮感知

在算法1中,我們使用RIP屬性來訓(xùn)練生成器。我們可以使用相同的方法,并加強(qiáng)RIP屬性來學(xué)習(xí)測量函數(shù)F本身,而不是使用random projection。

下面的算法2總結(jié)了這個(gè)擴(kuò)展算法。我們稱之為深度壓縮感知(DCS) ,以強(qiáng)調(diào)測量和重建可以是深度神經(jīng)網(wǎng)絡(luò)。

算法2:深度壓縮感知

實(shí)驗(yàn)和結(jié)果

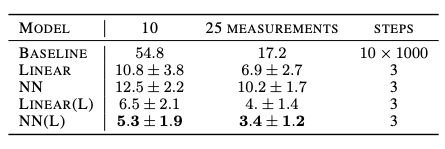

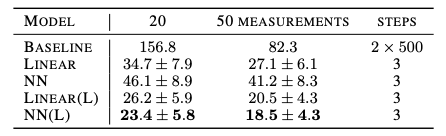

表2和表3總結(jié)了我們的模型以及Bora等人的基準(zhǔn)模型的結(jié)果。

表2:使用不同測量函數(shù)的MNIST測試數(shù)據(jù)的重建損失。除了第一行之外,所有行都來自我們的模型。“±”表示測試樣本間的標(biāo)準(zhǔn)差。(L)表示習(xí)得的測量函數(shù),越低越好。

表3:使用不同測量函數(shù)的CelebA測試數(shù)據(jù)的重建損失。除了第一行之外,所有行都來自我們的模型。“±”表示測試樣本間的標(biāo)準(zhǔn)差。(L)表示習(xí)得的測量函數(shù),越低越好。

可以看到,DCS的性能明顯優(yōu)于基準(zhǔn)。此外,雖然基線模型使用了數(shù)千個(gè)梯度下降步驟,并且多次重啟,但是我們只使用了3個(gè)步驟,沒有重啟,大幅提高了效率。

有趣的是,對于固定的函數(shù)F,隨機(jī)線性投影的表現(xiàn)優(yōu)于神經(jīng)網(wǎng)絡(luò)。這個(gè)實(shí)證結(jié)果符合壓縮感知文獻(xiàn)中描述的隨機(jī)投影的最優(yōu)性,以及更通用的Johnson-Lindenstrauss定理。

更多結(jié)果如下:

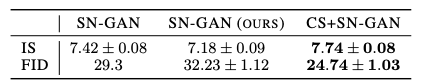

表4:與 Spectral Normalised GANs的比較。

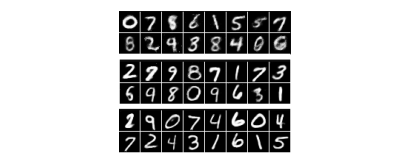

圖2:利用隨機(jī)線性投影(上)、訓(xùn)練線性投影(中)和訓(xùn)練神經(jīng)網(wǎng)絡(luò)(下)的10個(gè)測量的重建。

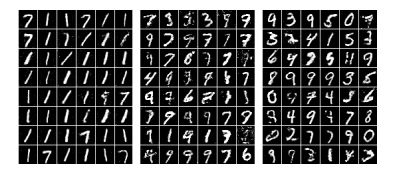

圖3:使用0(左)、3(中)和5(右)個(gè)梯度下降步驟進(jìn)行潛在優(yōu)化的CS-GAN樣本。采用0步驟的CS-GAN相當(dāng)于原始GAN。

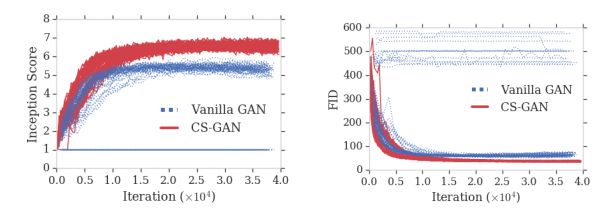

圖4:在CIFAR訓(xùn)練期間的Inception Score(越高越好)和FID分?jǐn)?shù)(越低越好)。

-

GaN

+關(guān)注

關(guān)注

19文章

1935瀏覽量

73426 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5503瀏覽量

121162 -

DeepMind

+關(guān)注

關(guān)注

0文章

130瀏覽量

10863

原文標(biāo)題:DeepMind論文:深度壓縮感知,新框架提升GAN性能

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

一種基于AliOS Things的uData感知設(shè)備軟件框架

一種基于圖像平移的目標(biāo)檢測框架

在RK3399開發(fā)板上如何去實(shí)現(xiàn)一種人工智能深度學(xué)習(xí)框架呢

壓縮感知的重構(gòu)算法講解

一種高光譜圖像分布式壓縮感知重構(gòu)方法

一種基于混合壓縮感知的WSN能耗優(yōu)化方法

基于模糊控制和壓縮感知的無線傳感網(wǎng)絡(luò)擁塞算法

壓縮感知的理論框架和應(yīng)用的系統(tǒng)概述和信號重構(gòu)算法研究

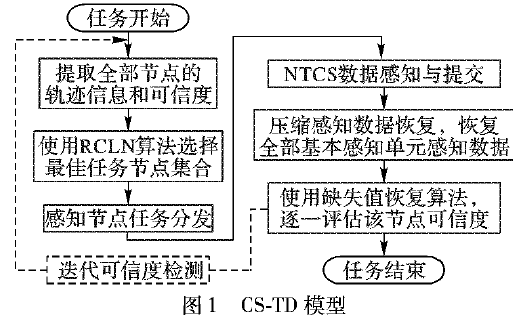

如何使用壓縮感知實(shí)現(xiàn)移動(dòng)群智感知任務(wù)分發(fā)機(jī)制的資料說明

一個(gè)全新的深度學(xué)習(xí)框架——計(jì)圖

如何使用壓縮感知實(shí)現(xiàn)移動(dòng)群智感知任務(wù)分發(fā)機(jī)制

一種用于交通流預(yù)測的深度學(xué)習(xí)框架

一種端到端的立體深度感知系統(tǒng)的設(shè)計(jì)

DeepMind提出一種全新的“深度壓縮感知”框架

DeepMind提出一種全新的“深度壓縮感知”框架

評論