為了探索AutoML在序列域中的應用是否能夠取得的成功,谷歌的研究團隊在進行基于進化的神經架構搜索(NAS)之后,使用了翻譯作為一般的序列任務的代理,并找到了Evolved Transformer這一新的Transformer架構。Evolved Transformer不僅實現了最先進的翻譯結果,與原始的Transformer相比,它還展示了語言建模的改進性能。

自幾年前推出以來,Google的Transformer架構已經應用于從制作奇幻小說到編寫音樂和聲的各種挑戰。重要的是,Transformer的高性能已經證明,當應用于序列任務(例如語言建模和翻譯)時,前饋神經網絡可以與遞歸神經網絡一樣有效。雖然用于序列問題的Transformer和其他前饋模型越來越受歡迎,但它們的架構幾乎完全是手動設計的,與計算機視覺領域形成鮮明對比。AutoML方法已經找到了最先進的模型,其性能優于手工設計的模型。當然,我們想知道AutoML在序列域中的應用是否同樣成功。

在進行基于進化的神經架構搜索(NAS)之后,我們使用翻譯作為一般的序列任務的代理,我們找到了Evolved Transformer,這是一種新的Transformer架構,它展示了對各種自然語言處理(NLP)任務的有希望的改進。Evolved Transformer不僅實現了最先進的翻譯結果,而且與原始的Transformer相比,它還展示了語言建模的改進性能。我們是將此新模型作為Tensor2Tensor的部分發布,它可用于任何序列問題。

開發技術

要開始進化NAS,我們有必要開發新技術,因為用于評估每個架構的“適應性”的任務——WMT'14英語-德語翻譯——計算量很大。這使得搜索比在視覺領域中執行的類似搜索更加昂貴,這可以利用較小的數據集,如CIFAR-10。

這些技術中的第一種是溫啟動——在初始進化種群中播種Transformer架構而不是隨機模型。這有助于在我們熟悉的搜索空間區域中進行搜索,從而使其能夠更快地找到更好的模型。

第二種技術是我們開發的一種稱為漸進動態障礙(PDH)(Progressive Dynamic Hurdles)的新方法,這種算法增強了進化搜索,以便為最強的候選者分配更多的資源,這與先前的工作相反,其中NAS的每個候選模型被分配相同的評估時的資源量。如果模型明顯不好,PDH允許我們提前終止對模型的評估,從而使有前途的架構獲得更多資源。

Evolved Transformer簡介

使用這些方法,我們在翻譯任務上進行了大規模的NAS,并發現了Evolved Transformer(ET)。與大多數序列到序列(seq2seq)神經網絡體系結構一樣,它有一個編碼器,將輸入序列編碼為嵌入,解碼器使用這些嵌入構造輸出序列;在翻譯的情況下,輸入序列是要翻譯的句子,輸出序列是翻譯。

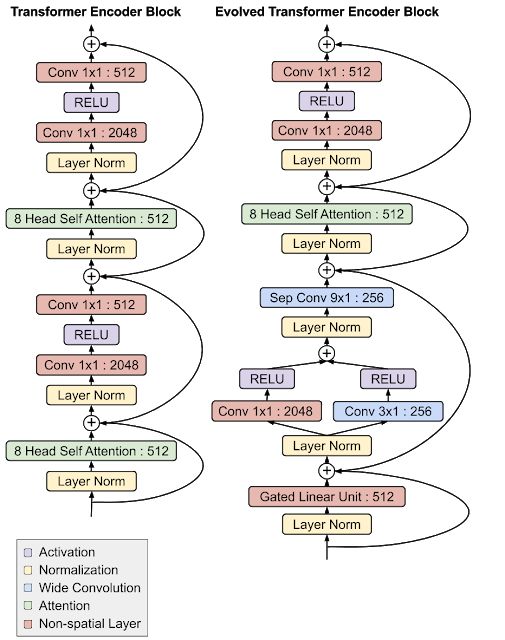

演化變壓器最有趣的特征是其編碼器和解碼器模塊底部的卷積層,在兩個地方都以類似的分支模式添加(即輸入在加到一起之前通過兩個單獨的卷積層)。

Evolved Transformer與原始Transformer編碼器架構的比較。注意模塊底部的分支卷積結構,它獨立地在編碼器和解碼器中形成。

這一點特別有趣,因為在NAS期間編碼器和解碼器架構不共享,因此獨立發現該架構對編碼器和解碼器都很有用,這說明了該設計的優勢。雖然最初的Transformer完全依賴于自我關注,但Evolved Transformer是一種混合體,利用了自我關注和廣泛卷積的優勢。

對Evolved Transformer的評估

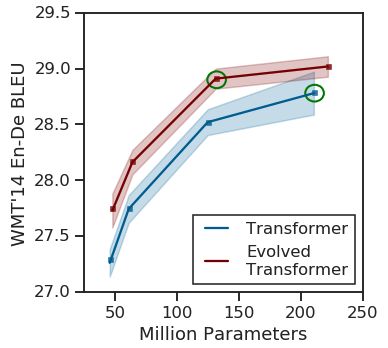

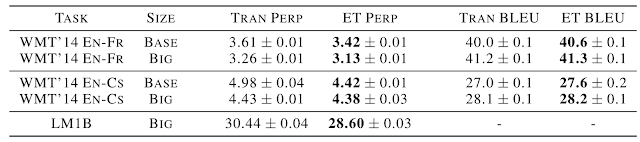

為了測試這種新架構的有效性,我們首先將它與我們在搜索期間使用的英語-德語翻譯任務的原始Transformer進行了比較。我們發現在所有參數尺寸下,Evolved Transformer具有更好的BLEU和 perplexity performance,擁有最大增益與移動設備兼容(約700萬個參數),證明了參數的有效使用。在更大的尺寸上,Evolved Transformer在WMT'14 En-De上達到了最先進的性能,BLEU得分為29.8,SacreBLEU得分為29.2。

不同尺寸的WMT'14 En-DeEvolved Transformer與原Transformer的比較。性能的最大提高發生在較小的尺寸上,而ET在較大的尺寸上也顯示出強度,優于最大的Transformer,參數減少37.6%(要比較的模型用綠色圈出)。

為了測試普遍性,我們還在其他NLP任務上將ET與Transformer進行了比較。首先,我們研究了使用不同語言對的翻譯,發現ET表現提升,其邊緣與英語-德語相似;再次,由于其有效使用參數,對于中型模型觀察到了最大的提升。我們還比較了使用LM1B進行語言建模的兩種模型的解碼器,并且看到性能提升近2個perplexity。

未來工作

這些結果是探索體系結構搜索在前饋序列模型中應用的第一步。Evolved Transformer作為Tensor2Tensor的一部分已開源,在那里它可以用于任何序列問題。為了提高可重復性,我們還開源了我們用于搜索的搜索空間,以及實施漸進動態障礙的Colab。我們期待著看到研究團體用新模型做了什么,并希望其他人能夠利用這些新的搜索技術!

-

谷歌

+關注

關注

27文章

6173瀏覽量

105633 -

開源

+關注

關注

3文章

3371瀏覽量

42578

原文標題:谷歌將AutoML應用于Transformer架構,翻譯結果飆升,已開源!

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

transformer專用ASIC芯片Sohu說明

SensiML開源了Analytics Studio AutoML引擎

英偉達推出歸一化Transformer,革命性提升LLM訓練速度

SensiML開源AutoML解決方案-Piccolo AI發布

Transformer語言模型簡介與實現過程

Transformer架構在自然語言處理中的應用

使用PyTorch搭建Transformer模型

Transformer 能代替圖神經網絡嗎?

【大語言模型:原理與工程實踐】大語言模型的基礎技術

一文詳解Transformer神經網絡模型

基于Transformer的多模態BEV融合方案

谷歌將AutoML應用于Transformer架構,翻譯結果飆升!

谷歌將AutoML應用于Transformer架構,翻譯結果飆升!

評論