隨著深度學(xué)習(xí)的大熱,許多研究都致力于如何從單張圖片生成3D模型。但近期一項(xiàng)研究表明,幾乎所有基于深度神經(jīng)網(wǎng)絡(luò)的3D中重建工作,實(shí)際上并不是重建,而是圖像分類。深度學(xué)習(xí)并不是萬(wàn)能的!

深度學(xué)習(xí)并不是萬(wàn)靈藥。

近幾年,隨著深度學(xué)習(xí)的大熱,許多研究攻克了如何從單張圖片生成3D模型。從某些方面似乎再次驗(yàn)證了深度學(xué)習(xí)的神奇——doing almost the impossible。

但是,最近一篇文章卻對(duì)此提出了質(zhì)疑:幾乎所有這些基于深度神經(jīng)網(wǎng)絡(luò)的3D重建的工作,實(shí)際上并不是進(jìn)行重建,而是進(jìn)行圖像分類。

arXiv地址:

https://arxiv.org/pdf/1905.03678.pdf

在這項(xiàng)工作中,研究人員建立了兩種不同的方法分別執(zhí)行圖像分類和檢索。這些簡(jiǎn)單的基線方法在定性和定量上都比最先進(jìn)的方法產(chǎn)生的結(jié)果要更好。

正如伯克利馬毅教授評(píng)價(jià):

幾乎所有這些基于深度神經(jīng)網(wǎng)絡(luò)的3D重建的工作(層出不窮令人眼花繚亂的State of the Art top conferences 論文),其實(shí)還比不上稍微認(rèn)真一點(diǎn)的nearest neighbor baselines。沒有任何工具或算法是萬(wàn)靈藥。

至少在三維重建問(wèn)題上,沒有把幾何關(guān)系條件嚴(yán)格用到位的算法,都是不科學(xué)的——根本談不上可靠和準(zhǔn)確。

并非3D重建,而只是圖像分類?

基于對(duì)象(object-based)的單視圖3D重建任務(wù)是指,在給定單個(gè)圖像的情況下生成對(duì)象的3D模型。

如上圖所示,推斷一輛摩托車的3D結(jié)構(gòu)需要一個(gè)復(fù)雜的過(guò)程,它結(jié)合了低層次的圖像線索、有關(guān)部件結(jié)構(gòu)排列的知識(shí)和高層次的語(yǔ)義信息。

研究人員將這種情況稱為重建和識(shí)別:

重構(gòu)意味著使用紋理、陰影和透視效果等線索對(duì)輸入圖像的3D結(jié)構(gòu)進(jìn)行推理。

識(shí)別相當(dāng)于對(duì)輸入圖像進(jìn)行分類,并從數(shù)據(jù)庫(kù)中檢索最合適的3D模型。

雖然在其它文獻(xiàn)中已經(jīng)提出了各種體系結(jié)構(gòu)和3D表示,但是用于單視圖3D理解的現(xiàn)有方法都使用編碼器——解碼器結(jié)構(gòu),其中編碼器將輸入圖像映射到潛在表示,而解碼器執(zhí)行關(guān)于3D的非平凡(nontrivial)推理,并輸出空間的結(jié)構(gòu)。

為了解決這一任務(wù),整個(gè)網(wǎng)絡(luò)既要包含高級(jí)信息,也要包含低級(jí)信息。

而在這項(xiàng)工作中,研究人員對(duì)目前最先進(jìn)的編解碼器方法的結(jié)果進(jìn)行了分析,發(fā)現(xiàn)它們主要依靠識(shí)別來(lái)解決單視圖3D重建任務(wù),同時(shí)僅顯示有限的重建能力。

為了支持這一觀點(diǎn),研究人員設(shè)計(jì)了兩個(gè)純識(shí)別基線:一個(gè)結(jié)合了3D形狀聚類和圖像分類,另一個(gè)執(zhí)行基于圖像的3D形狀檢索。

在此基礎(chǔ)上,研究人員還證明了即使不需要明確地推斷出物體的3D結(jié)構(gòu),現(xiàn)代卷積網(wǎng)絡(luò)在單視圖3D重建中的性能是可以超越的。

在許多情況下,識(shí)別基線的預(yù)測(cè)不僅在數(shù)量上更好,而且在視覺上看起來(lái)更有吸引力。

研究人員認(rèn)為,卷積網(wǎng)絡(luò)在單視圖3D重建任務(wù)中是主流實(shí)驗(yàn)程序的某些方面的結(jié)果,包括數(shù)據(jù)集的組成和評(píng)估協(xié)議。它們?cè)试S網(wǎng)絡(luò)找到一個(gè)快捷的解決方案,這恰好是圖像識(shí)別。

純粹的識(shí)別方法,性能優(yōu)于先進(jìn)的神經(jīng)網(wǎng)絡(luò)

實(shí)驗(yàn)基于現(xiàn)代卷積網(wǎng)絡(luò),它可以從一張圖像預(yù)測(cè)出高分辨率的3D模型。

方法的分類是根據(jù)它們的輸出表示對(duì)它們進(jìn)行分類:體素網(wǎng)格(voxel grids)、網(wǎng)格(meshes)、點(diǎn)云和深度圖。為此,研究人員選擇了最先進(jìn)的方法來(lái)覆蓋主要的輸出表示,或者在評(píng)估中已經(jīng)清楚地顯示出優(yōu)于其他相關(guān)表示。

研究人員使用八叉樹生成網(wǎng)絡(luò)(Octree Generating Networks,OGN)作為直接在體素網(wǎng)格上預(yù)測(cè)輸出的代表性方法。

與早期使用這種輸出表示的方法相比,OGN通過(guò)使用八叉樹有效地表示所占用的空間,可以預(yù)測(cè)更高分辨率的形狀。

還評(píng)估了AtlasNet作為基于表面的方法的代表性方法。AtlasNet預(yù)測(cè)了一組參數(shù)曲面,并在操作這種輸出表示的方法中構(gòu)成了最先進(jìn)的方法。它被證明優(yōu)于直接生成點(diǎn)云作為輸出的唯一方法,以及另一種基于八叉樹的方法。

最后,研究人員評(píng)估了該領(lǐng)域目前最先進(jìn)的Matryoshka Networks。該網(wǎng)絡(luò)使用由多個(gè)嵌套深度圖組成的形狀表示,,這些深度圖以體積方式融合到單個(gè)輸出對(duì)象中。

對(duì)于來(lái)自AtlasNet的基于IoU的表面預(yù)測(cè)評(píng)估,研究人員將它們投影到深度圖,并進(jìn)一步融合到體積表示。 對(duì)于基于表面的評(píng)估指標(biāo),使用移動(dòng)立方體算法從體積表示中提取網(wǎng)格。

研究人員實(shí)現(xiàn)了兩個(gè)簡(jiǎn)單的基線,僅從識(shí)別的角度來(lái)處理問(wèn)題。

第一種方法是結(jié)合圖像分類器對(duì)訓(xùn)練形狀進(jìn)行聚類;第二個(gè)是執(zhí)行數(shù)據(jù)庫(kù)檢索。

在聚類方面的基線中,使用K-means算法將訓(xùn)練形狀聚類為K個(gè)子類別。

在檢索基線方面,嵌入空間由訓(xùn)練集中所有3D形狀的兩兩相似矩陣構(gòu)造,通過(guò)多維尺度將矩陣的每一行壓縮為一個(gè)低維描述符。

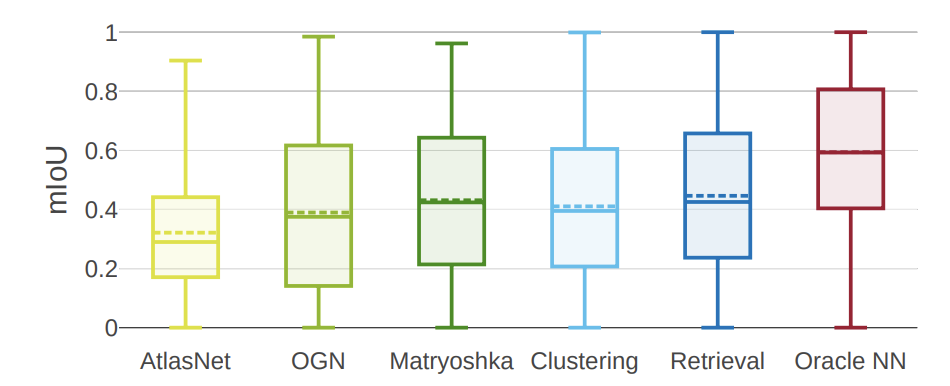

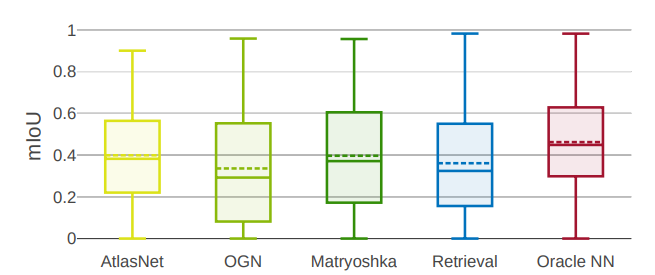

研究人員根據(jù)平均IoU分?jǐn)?shù)對(duì)所有方法進(jìn)行標(biāo)準(zhǔn)比較。

研究人員發(fā)現(xiàn),雖然最先進(jìn)的方法有不同體系結(jié)構(gòu)的支持,但在執(zhí)行的時(shí)候卻非常相似。

有趣的是,檢索基線是一種純粹的識(shí)別方法,在均值和中位數(shù)IoU方面都優(yōu)于所有其他方法。簡(jiǎn)單的聚類基線具有競(jìng)爭(zhēng)力,性能優(yōu)于AtlasNet和OGN。

但研究人員進(jìn)一步觀察到,一個(gè)完美的檢索方法(Oracle NN)的性能明顯優(yōu)于所有其他方法。值得注意的是,所有方法的結(jié)果差異都非常大(在35%到50%之間)。

這意味著僅依賴于平均IoU的定量比較不能提供這種性能水平的全貌。 為了更清楚地了解這些方法的行為,研究人員進(jìn)行了更詳細(xì)的分析。

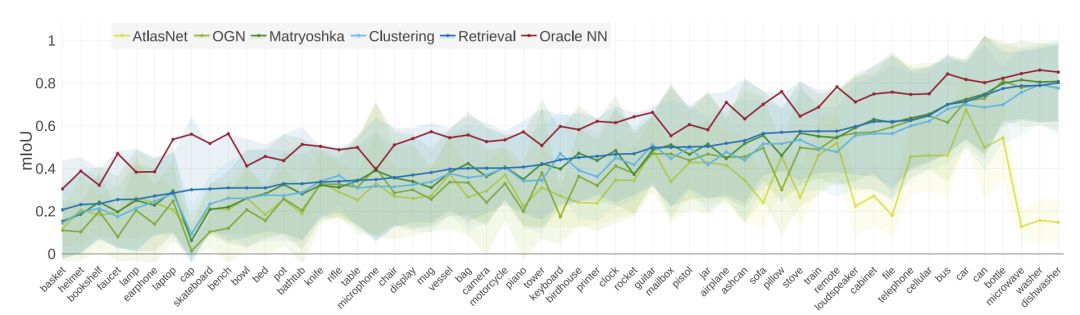

每類mIoU比較。

總的來(lái)說(shuō),這些方法在不同的類之間表現(xiàn)出一致的相對(duì)性能。檢索基線為大多數(shù)類生成最佳重構(gòu)。所有類和方法的方差都很大。

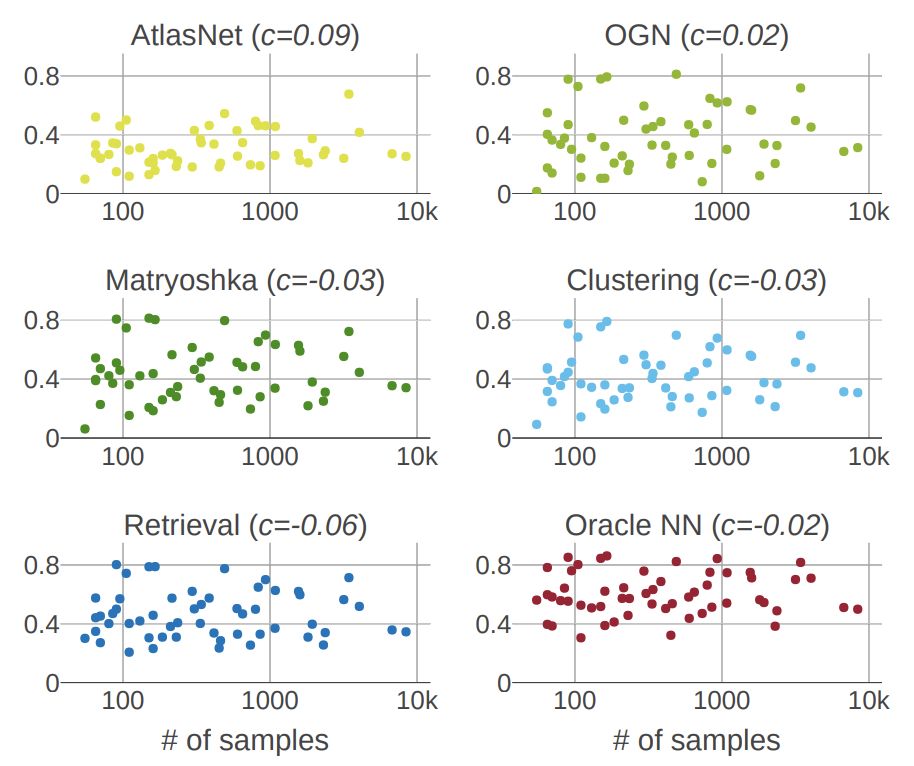

mIoU與每個(gè)類的訓(xùn)練樣本數(shù)量。

研究人員發(fā)現(xiàn)一個(gè)類的樣本數(shù)量和這個(gè)類的mIoU分?jǐn)?shù)之間沒有相關(guān)性。所有方法的相關(guān)系數(shù)c均接近于零。

定性的結(jié)果

聚類基線產(chǎn)生的形狀質(zhì)量與最先進(jìn)的方法相當(dāng)。 檢索基線通過(guò)設(shè)計(jì)返回高保真形狀,但細(xì)節(jié)可能不正確。 每個(gè)樣本右下角的數(shù)字表示IoU。

左:為所選類分配IoU。 基于解碼器的方法和顯式識(shí)別基線的類內(nèi)分布是類似的。 Oracle NN的發(fā)行版在大多數(shù)類中都有所不同。 右圖:成對(duì)Kolmogorov-Smirnov檢驗(yàn)未能拒絕兩個(gè)分布的無(wú)效假設(shè)的類數(shù)的熱圖。

研究中的一些問(wèn)題

參照系的選擇

我們嘗試使用視角預(yù)測(cè)網(wǎng)絡(luò)對(duì)聚類基線方法進(jìn)行擴(kuò)展,該方法將重點(diǎn)回歸攝像頭的方位角和仰角等規(guī)范框架,結(jié)果失敗了,因?yàn)橐?guī)范框架對(duì)每個(gè)對(duì)象類都有不同的含義,即視角網(wǎng)絡(luò)需要使用類信息來(lái)解決任務(wù)。我們對(duì)檢索基線方法進(jìn)行了重新訓(xùn)練,將每個(gè)訓(xùn)練視圖作為單獨(dú)樣本來(lái)處理,從而為每個(gè)單獨(dú)的對(duì)象提供空間。

量度標(biāo)準(zhǔn)

平均IoU通常在基準(zhǔn)測(cè)試中被用作衡量單視圖圖像重建方法的主要量化指標(biāo)。如果將其作為最優(yōu)解的唯一衡量指標(biāo),就可能會(huì)出現(xiàn)問(wèn)題,因?yàn)樗趯?duì)象形狀的質(zhì)量值足夠高時(shí)才能有效預(yù)測(cè)。如果該值處于中低水平,表明兩個(gè)對(duì)象的形狀存在顯著差異。

如上圖所示,將一個(gè)汽車模型與數(shù)據(jù)集中的不同形狀的對(duì)象進(jìn)行了比較,只有 IoU分?jǐn)?shù)比較高(最右兩張圖)時(shí)才有意義,即使IoU=0.59,兩個(gè)目標(biāo)可能都是完全不同的物體,比較相似度失去了意義。

倒角距離(Chamfer distance)

如上圖所示,兩者目標(biāo)椅子與下方的椅子的下半部分完美匹配,但上半部分完全不同。但是根據(jù)得分,第二個(gè)目標(biāo)要好于第一個(gè)。由此來(lái)看,倒角距離這個(gè)量度會(huì)被空間幾何布局顯著干擾。為了可靠地反映真正的模型重建性能,好的量度應(yīng)該具備對(duì)幾何結(jié)構(gòu)變化的高魯棒性。

F-score

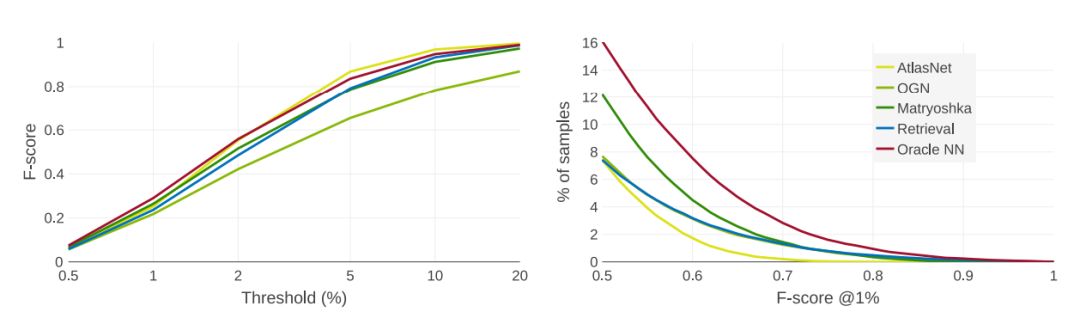

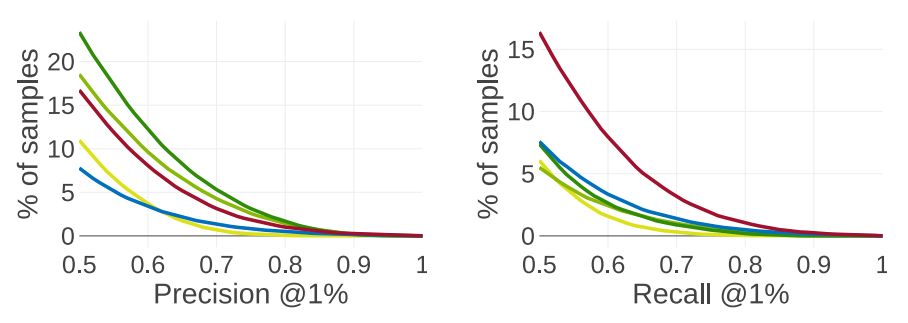

我們繪制了以觀察者為中心的重建方式的F分?jǐn)?shù)的不同距離閾值d(左)。在 d =重建體積邊長(zhǎng)的2%的條件下,F(xiàn)分?jǐn)?shù)絕對(duì)值與當(dāng)前范圍的 mIoU分?jǐn)?shù)相同,這并不能有效反映模型的預(yù)測(cè)質(zhì)量。

因此,我們建議將距離閾值設(shè)為重建模型體積邊長(zhǎng)的1%以下來(lái)考察F值。如上圖(右)中所示,在閾值d = 1%時(shí),F(xiàn)分?jǐn)?shù)為0.5以上。只有一小部分模型的形狀被精確構(gòu)建出來(lái),預(yù)設(shè)任務(wù)仍然遠(yuǎn)未解決。我們的檢索基線方法不再具有明顯的優(yōu)勢(shì),進(jìn)一步表明使用純粹的識(shí)別方法很難解決這個(gè)問(wèn)題。

現(xiàn)有的基于CNN的方法在精度上表現(xiàn)良好,但丟失了目標(biāo)的部分結(jié)構(gòu)

未來(lái)展望

在這項(xiàng)研究中,研究人員通過(guò)重建和識(shí)別來(lái)推斷單視圖3D重建方法的范圍。

工作展示了簡(jiǎn)單的檢索基線優(yōu)于最新、最先進(jìn)的方法。分析表明,目前最先進(jìn)的單視圖3D重建方法主要用于識(shí)別,而不是重建。

研究人員確定了引起這種問(wèn)題的一些因素,并提出了一些建議,包括使用以視圖為中心的坐標(biāo)系和魯棒且信息量大的評(píng)估度量(F-score)。

另一個(gè)關(guān)鍵問(wèn)題是數(shù)據(jù)集組合,雖然問(wèn)題已經(jīng)確定,但沒有處理。研究人員正努力在以后的工作中糾正這一點(diǎn)。

-

圖像識(shí)別

+關(guān)注

關(guān)注

9文章

520瀏覽量

38279 -

3D建模

+關(guān)注

關(guān)注

0文章

35瀏覽量

9768 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5504瀏覽量

121213

原文標(biāo)題:深度學(xué)習(xí)不是萬(wàn)靈藥!神經(jīng)網(wǎng)絡(luò)3D建模其實(shí)只是圖像識(shí)別?

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

深度學(xué)習(xí)中的卷積神經(jīng)網(wǎng)絡(luò)模型

卷積神經(jīng)網(wǎng)絡(luò)有何用途 卷積神經(jīng)網(wǎng)絡(luò)通常運(yùn)用在哪里

pytorch中有神經(jīng)網(wǎng)絡(luò)模型嗎

如何利用CNN實(shí)現(xiàn)圖像識(shí)別

bp神經(jīng)網(wǎng)絡(luò)是深度神經(jīng)網(wǎng)絡(luò)嗎

卷積神經(jīng)網(wǎng)絡(luò)的基本結(jié)構(gòu)和工作原理

深度學(xué)習(xí)與卷積神經(jīng)網(wǎng)絡(luò)的應(yīng)用

卷積神經(jīng)網(wǎng)絡(luò)的基本結(jié)構(gòu)及其功能

卷積神經(jīng)網(wǎng)絡(luò)在圖像識(shí)別中的應(yīng)用

神經(jīng)網(wǎng)絡(luò)建模的適用范圍有哪些

數(shù)學(xué)建模神經(jīng)網(wǎng)絡(luò)模型的優(yōu)缺點(diǎn)有哪些

深度神經(jīng)網(wǎng)絡(luò)模型cnn的基本概念、結(jié)構(gòu)及原理

神經(jīng)網(wǎng)絡(luò)在圖像識(shí)別中的應(yīng)用

神經(jīng)網(wǎng)絡(luò)架構(gòu)有哪些

詳解深度學(xué)習(xí)、神經(jīng)網(wǎng)絡(luò)與卷積神經(jīng)網(wǎng)絡(luò)的應(yīng)用

深度學(xué)習(xí)不是萬(wàn)靈藥 神經(jīng)網(wǎng)絡(luò)3D建模其實(shí)只是圖像識(shí)別

深度學(xué)習(xí)不是萬(wàn)靈藥 神經(jīng)網(wǎng)絡(luò)3D建模其實(shí)只是圖像識(shí)別

評(píng)論