要不要用準確性換可解釋性?這可能是許多資源有限的創業公司,在技術研發中面臨的重要問題,同時也是機器學習可解釋性研究中的重要議題。

把場景具體化,讓我們先來看這樣一道選擇題。

如果你是一個投資公司老板,針對電話詐騙檢測,現在有一個可信度85%,但無法解釋的“黑盒”模型,和一個可信度75%,但可解釋的機器學習模型擺在你面前,你會選擇哪一個?

但最初的最初,讓我們先來理清這兩個概念:自動機器學習與可解釋機器學習。

理清概念

機器學習自動化(AutoML):讓機器自己煉丹

王立威教授首先解釋了什么是機器學習自動化。機器學習的應用需要大量的人工干預,比如特征提取、模型選擇、參數調節等,深度學習也被戲稱為煉丹術。

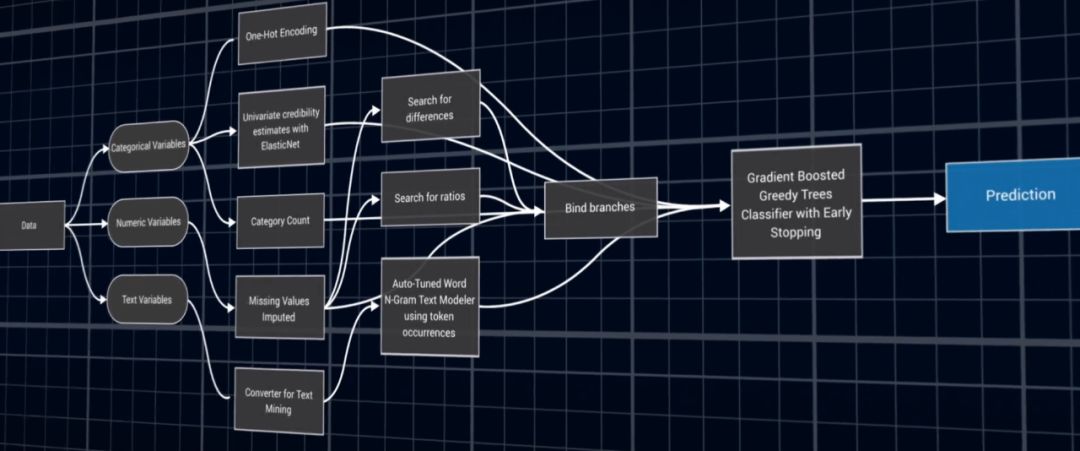

而AutoML 是試圖將這些與特征、模型、優化、評價有關的重要步驟進行自動化地學習,實現從end to end 到learning to learn,使得機器學習模型無需人工干預即可被應用。讓機器自己煉丹,讓深度學習自動尋找最優框架。

使用AutoML,就像是在使用一個工具,我們只需要將訓練數據集傳入AutoML,那么這個工具就會自動幫我們生成參數和模型,形成訓練模型,這樣即使不具備機器學習方面深入的專業知識也可以進行機器學習方面的工作。

可解釋機器學習(Explainable ML):信任之后人與機器才能更好地互動

隨著AutoML學習模型的發展,機器學習的黑箱似乎在越來越大。這種缺乏解釋的情況既是一個現實問題,也是一個倫理問題。所以近年,很多研究者呼吁我們需要可解釋機器學習。

梅俏竹教授在解釋XML的時候強調,辯題的核心還是在于AI和人的關系。我們大多同意未來的世界是AI與人共同合作,AI目前肯定還是做不到取代人。AutoML與XML其實并不矛盾,問題在于合作中如何人要如何達成對于AI的信任。

基于人工智能的結果越重要,對可解釋人工智能的需求就越大。高風險的情況下,比如自動駕駛和醫療領域,人們可能需要明確地解釋是如何得出特定結果的。而相對低風險的人工智能系統可能就更適合黑盒模型,人們很難理解其結果。

為什么說,機器學習中的可解釋性很重要

追逐解釋是人類的天性

場景問題是大家公認的導致可解釋問題重要的一個原因。我們可以容忍機器沒有理由地給我們錯誤推薦了一首不喜歡的歌,但是把重大的投資問題或者醫療建議交由機器決定的時候,我們希望可以得到充分的解釋說明。

解釋是跨多個行業和科學學科的負責任的、開放的數據科學的核心。

俞士綸教授提到對可解釋人工智能的需求與人類的影響會同步上升,比如醫生應用機器評估數據并得出決策數據,但是機器無法回答病人的疑問。以及在過濾假新聞的時候,機器在作出粗略判斷和初步篩選之后,還是需要人類解釋其中細微差別。

Clever Hans問題

Hans是一匹聰明的馬,人們以為它會計算加法,因為有人說2+3的時候,它就會敲5下蹄子。但后來人們發現,它只是單純地在敲蹄子,直到人們的表情發生改變就停下來。如果沒有可解釋性,任何人都無法保證高正確率模型其實只是另一匹Hans。

李興建工程師說道,可解釋也是企業實際應用非常關心的問題。如果人工智能系統出錯,構建者需要理解為什么會這樣做,這樣才能改進和修復。如果他們的人工智能服務在黑盒中存在并運行,他們就無法了解如何調試和改進它。

可解釋也許是一個偽命題

有些事情是無法解釋,也不需要解釋

但很有意思的事,解釋可能無法窮盡。

王立威教授提出一個有趣的例子。機器作出判斷,這是一只貓。如果我們要尋求解釋,問為什么這是一只貓,機器可能回答,因為它有皮毛,有四只貓爪……我們再問,那為什么這是皮毛?

當然機器還可以繼續解釋,但是解釋的結果可能會更加復雜,比直接告訴你這是皮毛要曲折得多。

人類大腦是非常有限的,而現在的數據太多了。我們沒有那么多腦容量去研究所有東西的可解釋性。世界上有那么多應用、網站,我們每天用 Facebook、Google 的時候,也不會想著去尋求它們背后的可解釋性。

對于醫療行業的可解釋機器學習的應用王立威教授也提出完全不同的想法,他認為只有在開始階段,醫生不夠信任系統的時候可解釋才重要。而當系統性能足夠優化,可解釋就不再重要。在不可解釋上做的能超過人類,這就是未來機器學習的可為之處。

來自Geoffrey Hinton 的駁斥

Geoffrey Hinton 曾經大膽宣稱,糾結深度學習(可與不可)解釋性問題根本是一個偽命題。為什么一定要存在識別數字的理論才能證明我們擅長識別數字?難道非要通透騎車每一個細節的物理力學,才能證明自己會騎車?其實不是神經網絡需要理論解釋,而是人類克制不住自己講故事的沖動,理論再合理也只是主觀判斷,并不能幫助我們理解為什么。

王立威教授表示贊同,以歷史做類比。歷史書上簡單歸納出的勝敗輸贏難道就是真實的歷史嗎,不過是人類編造出的故事。真實的歷史復雜,現實生活復雜,只言片語的解釋和理論不過是管窺蠡測。

通過神經網絡反思人的思維,同一個網絡框架,初始點不同結果可能完全不同。解釋可能會有兩套截然不同的解釋,就像對同一件事不同的人可能會有不同的解釋。

一個人都無法完全理解另一個人,更何況與人的思維完全不同的機器?即使把alpha go下圍棋中的所有數據告訴人也沒有用,因為機器每一步的判斷所用的數據是百萬量級,而人最多處理到百的程度。就算打開黑匣,一千個人可能會看到一千種解釋。

俞士綸教授認為Hinton的說法還是有些激進,解釋不僅是為了說服,解釋的形式和含義都非常之廣,就算是autoML我們還是要朝著可解釋的方向不斷推進。

梅俏竹教授則認為單純討論autoML還是XML是沒有意義的,就像我們判斷autoML好不好,怎么算是一個好的推薦算法?如果機器中午十二點推薦你去吃午飯,的確它的準確率是百分之百,但是對于用戶來說這是完全沒有意義的一個推薦。評判需要加入人的因素進行考量,還是要看人機配合得怎么樣,加入用戶體驗。

autoML的能耗問題:ACL論文痛批其撿芝麻丟西瓜

最近一份提交到自然語言處理頂會ACL 2019的論文引起熱議,研究人員對幾種常見的NLP模型進行碳排放評估后發現,像Transformer、GPT-2等流行的深度神經網絡的訓練過程可以排放超過62.6萬磅的二氧化碳當量,幾乎是美國汽車平均壽命期內排放量(包括制造過程)的五倍。

某些模型可能經過了千百次的訓練之后取得最優成果,但是實際進展非常微小,而背后的代價是不成比例的計算量和碳排放。

李文鈺提出業界現在的解決辦法有比如共享參數、熱啟動,利用之前訓練好的參數,避免再從頭訓練一個模型。

真正的autoML應該是在大型數據集上搜索,操作類型,拓撲結構,加上人的先驗知識,未來希望找到又小又高效的好的模型。我們希望用機器代替節約人力,但是人也要去限制一些盲目搜索,節約成本的約束。

未來之路:煉金,觀星,算命都不可取

幾位教授最后都同意autoML和XML在未來是可以結合的。不管是autoML還是XML,現在還是在底層信號的層面運作,比如識別圖像、文本,關鍵還是在知識層面,我們需要的是對整個網絡結構更高層、更進一步的理解。

梅教授提出過猶不及,有三條走得太過的路是煉金、觀星和算命。

煉金就是走極端的autoML之路。不要為了全自動就拋開所有代價去追求自動化,最后你也無法保證煉出來的是金子還是破鐵;

觀星,擴大范圍,如果非要在一大堆的變量中拼命找聯系,總能找尋到一二;

而算命的原理是找一些你愿意聽的說,講你愛聽的故事,觀星和算命都是在可解釋的道路上走得太遠。

最后的最后,梅教授也提醒大家,解釋性可以解釋部分問題,關于倫理,關于道德,但是它不是萬能藥。不要糾結于理解,為了理解而理解。

-

機器學習

+關注

關注

66文章

8430瀏覽量

132859 -

深度學習

+關注

關注

73文章

5511瀏覽量

121362

原文標題:要強大的“黑匣子”,還是“可解釋”的機器學習?| 清華AI Time激辯

文章出處:【微信號:BigDataDigest,微信公眾號:大數據文摘】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

羅克韋爾自動化推出DataReady智能機器

愛普生SG-8101CA可編程晶振應用在工業自動化機器人

下一代機器人技術:工業自動化的五大趨勢

工業自動化時代,如何理解“機器換人”和“人機協作”

自動化焊接機器人:引領制造業未來的高效工具

機器學習自動化(AutoML):讓機器自己煉丹

機器學習自動化(AutoML):讓機器自己煉丹

評論