來(lái)自北京郵電大學(xué)的研究人員開(kāi)發(fā)了一種AI模型壓縮算法,可以讓深度學(xué)習(xí)的運(yùn)算不再依賴高昂的計(jì)算和存儲(chǔ)設(shè)備,保持模型的識(shí)別精度無(wú)損的前提下,顯著降低模型的計(jì)算復(fù)雜度,本文帶來(lái)技術(shù)解讀。

人工智能在眾多計(jì)算機(jī)視覺(jué)領(lǐng)域都取得了很大的成功,然而深度學(xué)習(xí)(Deep Learning)因其計(jì)算復(fù)雜度或參數(shù)冗余,在一些場(chǎng)景和設(shè)備上限制了相應(yīng)的模型部署,需要借助模型壓縮、優(yōu)化加速、異構(gòu)計(jì)算等方法突破瓶頸。

研究人員稱,模型壓縮算法能夠有效降低參數(shù)冗余,從而減少存儲(chǔ)占用、通信帶寬和計(jì)算復(fù)雜度,有助于深度學(xué)習(xí)的應(yīng)用部署。通道剪枝(Channel Pruning)通過(guò)移除神經(jīng)網(wǎng)絡(luò)中冗余通道,達(dá)到加速神經(jīng)網(wǎng)絡(luò)推理過(guò)程和壓縮模型體積的效果,還可以獲得實(shí)際的加速效果,然而當(dāng)前基于結(jié)構(gòu)正則化的通道剪枝方法忽略了神經(jīng)網(wǎng)絡(luò)中連續(xù)層之間的關(guān)聯(lián)關(guān)系。

人工智能領(lǐng)域頂會(huì)CVPR于2019年6月在美國(guó)加利福利亞州召開(kāi),在這篇由北京郵電大學(xué)網(wǎng)絡(luò)智能研究中心、東信北郵EB Lab合作完成的論文中,作者考慮了網(wǎng)絡(luò)中連續(xù)層之間的關(guān)聯(lián)關(guān)系,提出了OICSR方法,將結(jié)構(gòu)正則化同時(shí)運(yùn)用于連續(xù)網(wǎng)絡(luò)層中相互對(duì)應(yīng)的out-channels和in-channels,從而可以在更小的精度損失下,移除更多的冗余通道。在對(duì)指標(biāo)影響較小的情況下,極大地提升深度學(xué)習(xí)模型的運(yùn)行效率。以下為論文詳細(xì)解讀。

基于Out-In-Channel結(jié)構(gòu)稀疏正則化的神經(jīng)網(wǎng)絡(luò)通道剪枝

李家仕,戚琦,王敬宇+,戈策,李鈺劍,岳章章,孫海峰

1,網(wǎng)絡(luò)與交換國(guó)家重點(diǎn)實(shí)驗(yàn)室,北京郵電大學(xué)

一種新的結(jié)構(gòu)正則化形式

人工智能在眾多計(jì)算機(jī)視覺(jué)領(lǐng)域都取得了很大的成功,然而深度學(xué)習(xí)高昂的計(jì)算和存儲(chǔ)需求嚴(yán)重阻礙了其被大規(guī)模地部署于移動(dòng)設(shè)備和嵌入式裝置。通道剪枝(Channel Pruning)是一類很經(jīng)典的網(wǎng)絡(luò)輕量化方法,通過(guò)移除神經(jīng)網(wǎng)絡(luò)中冗余通道的全部可訓(xùn)練參數(shù)和激活值,可以同時(shí)達(dá)到加速神經(jīng)網(wǎng)絡(luò)推理過(guò)程和壓縮模型體積的效果。由于對(duì)神經(jīng)網(wǎng)絡(luò)進(jìn)行通道剪枝后獲得的是結(jié)構(gòu)化稀疏的網(wǎng)絡(luò),因此不需要特殊的硬件支持就可以獲得實(shí)際的加速效果。

目前很多網(wǎng)絡(luò)輕量化的工作[1,2,3]利用結(jié)構(gòu)稀疏正則化(下文簡(jiǎn)稱為結(jié)構(gòu)正則化)來(lái)對(duì)神經(jīng)網(wǎng)絡(luò)進(jìn)行通道剪枝。如公式1所示,這類方法通過(guò)在訓(xùn)練過(guò)程中加入結(jié)構(gòu)正則化來(lái)對(duì)網(wǎng)絡(luò)權(quán)重進(jìn)行結(jié)構(gòu)化約束,使得訓(xùn)練過(guò)程中神經(jīng)網(wǎng)絡(luò)不同通道的重要性分離開(kāi)來(lái)。在剪枝過(guò)程中,網(wǎng)絡(luò)中重要的通道得以繼續(xù)保存,而更多冗余的通道可以在不損失網(wǎng)絡(luò)精度的情況下被安全的移除。

然而當(dāng)前基于結(jié)構(gòu)正則化的通道剪枝方法將結(jié)構(gòu)正則化分離地應(yīng)用于神經(jīng)網(wǎng)絡(luò)中的各個(gè)層的out-channels,忽略了神經(jīng)網(wǎng)絡(luò)中連續(xù)層之間的關(guān)聯(lián)關(guān)系,本研究稱之為分離式的結(jié)構(gòu)正則化。

本研究提出了一種新的結(jié)構(gòu)正則化形式Out-In-Channel Sparsity Regularization (OICSR)來(lái)克服分離式結(jié)構(gòu)正則化的缺陷。OICSR充分考慮了網(wǎng)絡(luò)中連續(xù)層之間的關(guān)聯(lián)關(guān)系,將結(jié)構(gòu)正則化同時(shí)運(yùn)用于連續(xù)網(wǎng)絡(luò)層中相互對(duì)應(yīng)的out-channels和in-channels,從而可以在更小的精度損失下移除更多的冗余通道。

Out-In-Channel結(jié)構(gòu)稀疏正則化

連續(xù)兩層網(wǎng)絡(luò)的關(guān)聯(lián)關(guān)系如圖1所示,本研究用相同的顏色來(lái)標(biāo)識(shí)連續(xù)層之間相互對(duì)應(yīng)的out-channel和in-channel。

連續(xù)兩層網(wǎng)絡(luò)中相互對(duì)應(yīng)的輸入輸出通道在網(wǎng)絡(luò)運(yùn)行過(guò)程中是相互合作相互依賴的,第l層的輸入與第l層中第i個(gè)out-channel的權(quán)重向量共同生成第l層的第i個(gè)輸出特征圖,緊接著第l層的第i個(gè)輸出特征圖和第l+1層中第i個(gè)in-channel的權(quán)重向量共同生成第l+1層的輸出。

除此之外,在網(wǎng)絡(luò)通道剪枝過(guò)程中連續(xù)層之間對(duì)應(yīng)的out-channel和in-channel會(huì)被共同保留或者移除。所以,有理由認(rèn)為在剪枝工作中,連續(xù)層之間對(duì)應(yīng)的out-channels和in-channels應(yīng)該被共同且平等地考慮。

圖1 連續(xù)層網(wǎng)絡(luò)的關(guān)聯(lián)關(guān)系及Out-In-Channel的定義

分離式結(jié)構(gòu)正則化的缺陷在于僅僅使得第l層網(wǎng)絡(luò)的out-channels維度的重要程度分離開(kāi)來(lái),然而第l+1層中對(duì)應(yīng)的in-channels卻被忽略了。存在這樣的情況,第l層網(wǎng)絡(luò)的第i個(gè)out-channel因?yàn)榉蛛x式結(jié)構(gòu)正則化,在訓(xùn)練過(guò)程變得冗余,因此在通道剪枝過(guò)程中被移除。然而被同時(shí)移除的l+1層網(wǎng)絡(luò)中對(duì)應(yīng)的第i個(gè)in-channel可能還是相對(duì)重要的,這時(shí)網(wǎng)絡(luò)的能力和精度就被嚴(yán)重的破壞了。

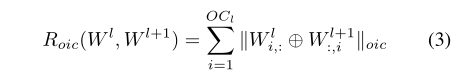

本研究因此提出在應(yīng)用結(jié)構(gòu)正則化進(jìn)行剪枝時(shí),應(yīng)將連續(xù)層之間對(duì)應(yīng)的out-channel和in-channel當(dāng)成一個(gè)正則化組out-in-channel來(lái)進(jìn)行結(jié)構(gòu)化約束。在網(wǎng)絡(luò)訓(xùn)練過(guò)程中,帶有OICSR的優(yōu)化目標(biāo)如公式2和公式3所示:

其中的符號(hào)‘+’表示對(duì)第l層和第l+1層中對(duì)應(yīng)輸入輸出通道的權(quán)重向量進(jìn)行拼接,從而可以對(duì)同一個(gè)out-in-channel正則化組內(nèi)的權(quán)重向量進(jìn)行結(jié)構(gòu)化約束。不同于分離式結(jié)構(gòu)正則化,OICSR可以使得神經(jīng)網(wǎng)絡(luò)中out-in-channels的重要性分離開(kāi)來(lái),也就是說(shuō),對(duì)于連續(xù)網(wǎng)絡(luò)層中共同作用相互對(duì)應(yīng)的out-channels和in-channels,它們將會(huì)同時(shí)變得重要或者同時(shí)變得冗余。因此在對(duì)網(wǎng)絡(luò)進(jìn)行剪枝時(shí),可以在更小的精度損失下,移除更多冗余的out-in-channels.

OICSR是一種通用的結(jié)構(gòu)正則化形式,很多結(jié)構(gòu)正則化項(xiàng)GroupLasso [4], GrOWL regularization [5]等都可以拓展OICSR的形式。例如Group Lasso拓展成OICSR的形式如公式4所示:

通道剪枝框架

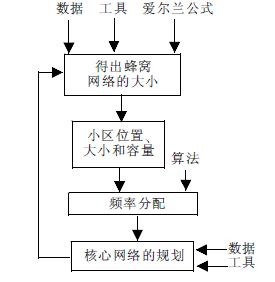

圖2 迭代剪枝流程

本研究的迭代剪枝流程如圖2所示。在通道剪枝過(guò)程中,涉及到冗余通道選取的問(wèn)題。當(dāng)前的很多工作僅僅使用第l層的統(tǒng)計(jì)信息來(lái)選擇第l層和第l+1層之間的冗余通道,然而第l+1層中的統(tǒng)計(jì)信息又被忽略了。沿用out-in-channel的思想,認(rèn)為應(yīng)當(dāng)同時(shí)利用連續(xù)兩層網(wǎng)絡(luò)的統(tǒng)計(jì)信息來(lái)選取兩層網(wǎng)絡(luò)間冗余的out-in-channels。為了簡(jiǎn)潔性表示,本研究使用了通道能量(當(dāng)然也很有效果)作為通道重要性的評(píng)判標(biāo)準(zhǔn),通道重要性準(zhǔn)則如公式5所示:

實(shí)際上神經(jīng)網(wǎng)絡(luò)中每一層的冗余程度都不同,當(dāng)前的很多工作為每一層網(wǎng)絡(luò)設(shè)定均等的剪枝比例或者根據(jù)經(jīng)驗(yàn)人為地設(shè)定剪枝比例是不夠合理的。因此本研究提出一個(gè)全局貪婪剪枝算法(Algorithm 1),來(lái)全局地決定每一層網(wǎng)絡(luò)的剪枝比例。首先根據(jù)公式8計(jì)算出網(wǎng)絡(luò)中全部out-in-channels的通道能量,接著對(duì)這些通道能量進(jìn)行全局排序,最后根據(jù)預(yù)先設(shè)定的全局目標(biāo)剪枝比例,來(lái)貪婪地選取網(wǎng)絡(luò)中的冗余通道,最后每層的剪枝比例因此也被確定下來(lái)。

全局貪婪剪枝算法

實(shí)驗(yàn)結(jié)果

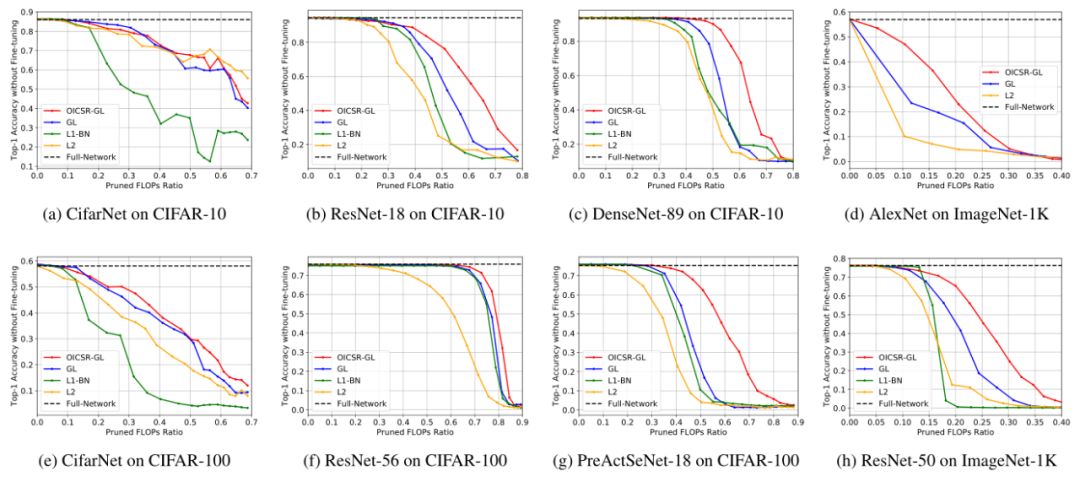

在實(shí)驗(yàn)階段將Group Lasso拓展為OICSR的形式(OICSR-GL),并使用AlexNet, ResNet, DenseNet 與 SeNet等網(wǎng)絡(luò)架構(gòu)在CIFAR-10/100和ImageNet-1K數(shù)據(jù)集上驗(yàn)證OICSR的有效性。OICSR-GL將和一下的baseline作對(duì)比:

(1)L2. 在網(wǎng)絡(luò)訓(xùn)練過(guò)程中只使用L2正則項(xiàng),而不適用結(jié)構(gòu)正則項(xiàng)

(2)GL. Group Lasso的原始形式,分離地被應(yīng)用于網(wǎng)絡(luò)各層的out-channels.

(3)L1-BN [3]. L1-BN使用L1 regularization對(duì)BN層的scale因子進(jìn)行約束,是另一種形式的結(jié)構(gòu)正則化。

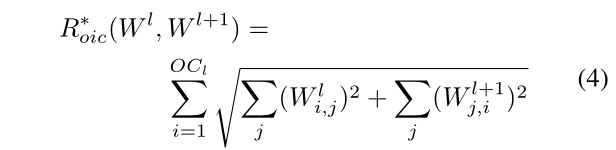

圖3 使用不同正則化約束進(jìn)行網(wǎng)絡(luò)訓(xùn)練后的通道能量分布圖

首先可視化了使用不同正則化約束進(jìn)行訓(xùn)練后神經(jīng)網(wǎng)絡(luò)內(nèi)通道能量 (通道能量定義為公式5) 的分布圖。ResNet-56網(wǎng)絡(luò) (on CIFAR-100 dataset) 內(nèi)layer4.2.conv1和layer4.2.conv2之間的通道能量分布如圖3所示,縱軸表示通道能量的高低,橫軸表示通道的坐標(biāo)。相比于非結(jié)構(gòu)正則化L2和分離式結(jié)構(gòu)正則化GL, OICSR-GL顯然能更大程度的分離通道間的重要程度,故更多的冗余通道能被安全的移除。

圖4 通道剪枝后,重訓(xùn)練前的網(wǎng)絡(luò)精度對(duì)比

接著論文展示了使用OICSR-GL及其baselines對(duì)網(wǎng)絡(luò)進(jìn)行通道剪枝后,進(jìn)行重訓(xùn)練之前的網(wǎng)絡(luò)精度。剪枝后剩余的網(wǎng)絡(luò)參數(shù)/精度可以看成網(wǎng)絡(luò)重訓(xùn)練的初始點(diǎn),好的網(wǎng)絡(luò)初始點(diǎn)可以使得網(wǎng)絡(luò)重訓(xùn)練后的精度更高。如圖3所示,在相同的FLOPs剪枝比例下,OICSR-GL在不同的網(wǎng)絡(luò)架構(gòu)上下均能保存更多的網(wǎng)絡(luò)精度。

最后和其他的state-of-the-art通道剪枝方法在ResNet-50 ImageNet-1K上做了對(duì)比,如表1所示,在不同的FLOPs剪枝比例下,本研究的方法均優(yōu)于目前最好的工作。

表1 在ResNet-50(ImageNet-1K dataset)和當(dāng)前state-of-the-art

通道剪枝方法的對(duì)比結(jié)果

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4773瀏覽量

100882 -

算法

+關(guān)注

關(guān)注

23文章

4619瀏覽量

93039 -

AI

+關(guān)注

關(guān)注

87文章

31077瀏覽量

269412

原文標(biāo)題:CVPR 2019:北郵提出新AI模型壓縮算法,顯著降低計(jì)算復(fù)雜度

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

[原創(chuàng)]《快學(xué)易用 Protel 99》經(jīng)典書(shū)籍--北京郵電大學(xué)出版社

2015年西安郵電大學(xué)電子設(shè)計(jì)競(jìng)賽試題

聚焦開(kāi)源人才培養(yǎng),“開(kāi)放原子校源行”走進(jìn)北京郵電大學(xué)活動(dòng)順利

TD-SCDMA網(wǎng)絡(luò)規(guī)劃(北京郵電大學(xué))

信號(hào)與系統(tǒng)電子教案 (北京郵電大學(xué))

北京郵電大學(xué)與NI合作建立聯(lián)合創(chuàng)新實(shí)驗(yàn)基地

嵌人式實(shí)時(shí)操作系統(tǒng)及其應(yīng)用開(kāi)發(fā)(北京郵電大學(xué)出版社+2006)

嵌入式系統(tǒng)原理及應(yīng)用(北京郵電大學(xué)出版社+2006)

計(jì)算機(jī)與通信專業(yè)英語(yǔ)(第四版) 徐秀蘭 北京郵電大學(xué)出版社

北京郵電大學(xué)5G+VR全景直播云畢業(yè)典禮在線上舉行

第16屆“中國(guó)芯”之雁飛萬(wàn)里,郵苑有“芯”——北京郵電大學(xué)校友論壇成功舉辦

聚焦開(kāi)源人才培養(yǎng),“開(kāi)放原子校源行”走進(jìn)北京郵電大學(xué)活動(dòng)順利舉行

資訊速遞 | 北京郵電大學(xué) OpenHarmony 技術(shù)俱樂(lè)部正式揭牌成立

北京郵電大學(xué)的研究人員開(kāi)發(fā)了一種AI模型壓縮算法

北京郵電大學(xué)的研究人員開(kāi)發(fā)了一種AI模型壓縮算法

評(píng)論