Hadoop是一個能夠對大量數據進行分布式處理的軟件框架。 Hadoop 以一種可靠、高效、可伸縮的方式進行數據處理。Hadoop 是可靠的,因為它假設計算元素和存儲會失敗,因此它維護多個工作數據副本,確保能夠針對失敗的節點重新分布處理。Hadoop 是高效的,因為它以并行的方式工作,通過并行處理加快處理速度。Hadoop 還是可伸縮的,能夠處理 PB 級數據。此外,Hadoop 依賴于社區服務,因此它的成本比較低,任何人都可以使用。

hadoop開發環境

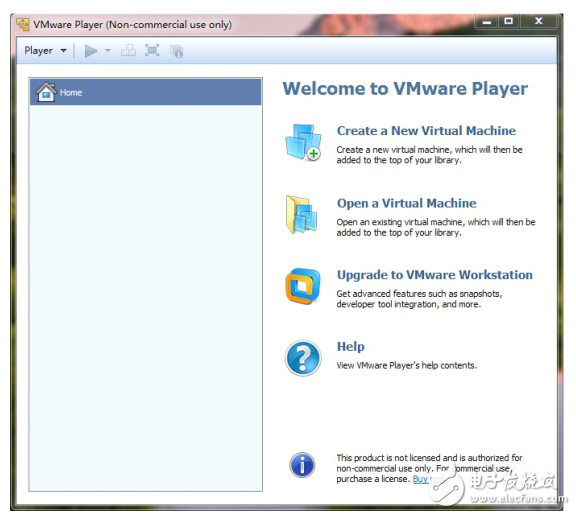

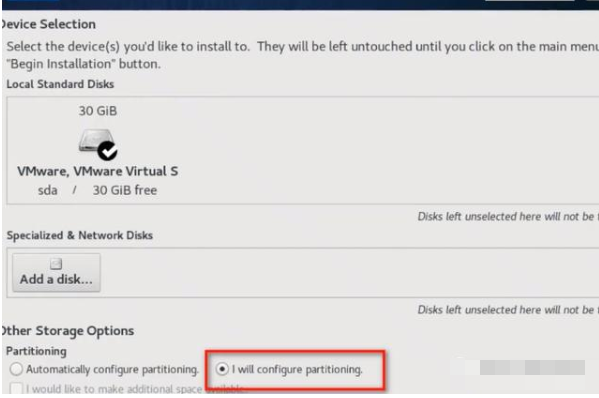

一、在windows上安裝linux雙系統

hadoop是運行在linux下的并行計算框架,在windows上搭建也是通過cygwin模擬linux的環境來運行,所以個人覺得直接在windows下搭建hadoop幾乎沒有任何好處,還不如在windows上安裝linux的虛擬機,通過虛擬機中的linux系統來運行hadoop。所以安裝linux雙系統還是很有必要的。

二、在linux上安裝jdk,并配置java環境

0.下載jdk8

登錄網址:http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html

選擇對應jdk版本下載。(可在Windows下下載完成后,通過文件夾共享到Linux上)

1.登錄Linux,切換到root用戶

su 獲取root用戶權限,當前工作目錄不變(需要root密碼)

2.在usr目錄下建立java安裝目錄

mkdir usr/java

3.將jdk-8u60-linux-x64.tar.gz拷貝到java目錄下并解壓

cp /mnt/hgfs/linux/jdk-8u60-linux-x64.tar.gz /usr/java/

tar -zxvf jdk-8u60-linux-x64.tar.gz得到文件夾jdk1.8.0_60

4.編輯配置文件,配置環境變量

vi /etc/profile

添加如下內容:

JAVA_HOME=/usr/java/jdk1.8.0_60

CLASSPATH=$JAVA_HOME/lib/

PATH=$PATH:$JAVA_HOME/bin

exportPATH JAVA_HOME CLASSPATH

5.重啟機器或執行命令:source/etc/profile

查看安裝情況:

java-version

javaversion “1.8.0_60”

Java(TM)SE Runtime Environment (build 1.8.0_60-b27)

JavaHotSpot(TM) Client VM (build 25.60-b23, mixed mode)

三、配置SSH免密碼登錄

1.確認已經連上互聯網,輸入命令

sudo apt-get install ssh

2.配置為可以無密碼登錄本機

首先查看在hewei(對應自己用戶)用戶下是否存在.ssh文件夾(注意ssh前面有“。”,表示這

是一個隱藏文件夾),輸入命令:

ls -a /home/hewei

一般來說,安裝SSH時會自動在當前用戶下創建這個隱藏文件夾,如果沒有,可以手動創建

一個。接下來,輸入命令:

ssh-keygen -t dsa -P ‘’ -f ~/.ssh/id_dsa

這個命令會在.ssh文件夾下創建兩個文件id_dsa及id_dsa.pub,這是SSH的一對私鑰和公鑰,

類似于鑰匙及鎖,把id_dsa.pub(公鑰)追加到授權的key里面去。

輸入命令:

cat ~/.ssh/id_dsa.pub 》》 ~/.ssh/authorized_keys

這條命令是把公鑰加到用于認證的公鑰文件中,這里的authorized_keys是用于認證的公鑰文件。

3.驗證SSH是否已安裝成功,以及是否可以無密碼登錄本機

輸入命令:

ssh -version

顯示結果:

1

顯示SSH已經安裝成功了。

輸入命令:

ssh localhost

顯示結果:

2

說明安裝成功。

四、安裝并運行hadoop ——偽分布式配置

1.進入conf文件夾,修改配置文件:

a.指定JDK的安裝位置:

在Hadoop-env.sh中:

exportJAVA_HOME=”你的JDK安裝位置”

b.配置HDFS的地址和端口號:

在conf/core-site.xml中:

《configuration》

《property》

《name》fs.default.name《/name》

《value》hdfs://localhost:9000《/value》

《/property》

《/configuration》

c.配置HDFS的備份方式:

在conf/hdfs-site.xml中:

《configuration》

《property》

《name》dfs.replication《/name》

《value》1《/value》

《/property》

《property》

《name》dfs.permissions《/name》

《value》false《/value》

《/property》

《/configuration》

d.配置MapReduce中JobTracker的地址和端口:

在conf/mapred-site.xml中:

《configuration》

《property》

《name》mapred.job.tracker《/name》

《value》localhost:9001《/value》

《/property》

《/configuration》

f.格式化Hadoop并啟動驗證:

格式化Hadoop:

。/bin/hadoop namenode-format

啟動Hadoop:

。/bin/start-all.sh(全部啟動)

驗證Hadoop是否安裝成功,打開瀏覽器,分別輸入網址:

http://localhost:50030(MapReduce的web頁面)

http://localhost:50070(HDFS的web頁面)

若都能查看,說明Hadoop已經安裝成功。

五、在linux上安裝Eclipse

1.安裝eclipse:

(1)到http://www.eclipse.org/downloads/,下載eclipsefor linux版本,我下載后文件的完整名稱為:

eclipse-java-galileo-SR1-linux-gtk.tar.gz

解壓縮后,可以查看根目錄下的

(2)將eclipse-SDK-3.2.1-linux-gtk.tar.gz這一個文件放到/opt目錄下面(用root執行mv_ _語句才能移進opt文件夾)

(3)在shell中進入/opt/,執行:tar -zxvf eclipse-SDK-4.2.1-linux-gtk.tar.gz語句,解壓縮下載文件

(4)在shell中,進入到eclipse目錄,cd/opt/eclipse設置文件eclipse執行權:chown-R root:你的用戶名eclipse

(5)創建桌面連接

sudogedit /usr/share/applications/eclipse.desktop

加入以下內容:

[DesktopEntry]Encoding=UTF-8Name=EclipseComment=EclipseSDKExec=/home/hewei/App/Eclipse/eclipseIcon=/home/hewei/App/Eclipse/icon.xpmTerminal=falseType=ApplicationCategories=Application;Development;2.在eclipse中添加hadoop插件

(1)找eclipse安裝目錄

安裝目錄:/home/App/Eclipse/eclipse/plugins

把/home/hewei/下載/eclipse-plugin/hadoop-1.0.1-eclipse-plugin.jar

復制到plugins中,就有加載hadoop插件

(2)配置hadoop安裝目錄

window -》preference -》 hadoop Map/Reduce -》 Hadoopinstallation

directory:/home/grid/hadoop-1.0.1 -》點擊“OK”

(3)配置Map/Reduce視圖

window -》Open Perspective -》 Map/Reduce -》 點擊“OK”

window -》Show View -》 搜索“map/reduceLocations”視圖選上-》點擊“OK”

在eclipse下方就出現了一個“Map/ReduceLocations選項卡”-》空白地方右鍵選“New

Hadoop Location”

Location name:Mymapred

Map/Reduce Master : host -》 localhost

DFSMaster : host -》 localhost

(4)在左邊projectexplorer列表框中找到“DFSLocations”右鍵refresh,就會看到

一個目錄樹,eclipse提供了一個目錄樹來管理HDFS系統,右鍵可以創建/刪除目錄,上傳/

查看文件,操作起來很簡單,內容與命令hadoopdfs -ls 結果一致

load加載

unload 卸載

upload 上傳

download 下載

電子發燒友App

電子發燒友App

評論