智能時代就要到來,芯片市場格局一變再變。兩個典型例子:引領處理器市場 40 多年的英特爾 2015 年底收購完 Altera,今年 4 月就宣布計劃裁員 1.2 萬;另一方面,GPU 巨頭英偉達今年 3 月推出加速人工智能和深度學習的芯片 Tesla P100,投入研發經費超過 20 億美元,據《華爾街日報》報道,今年 5 月英偉達售出的 GPU 比去年同月增長 62%,公司當前市值 240 億美元。

深度學習應用大量涌現使超級計算機的架構逐漸向深度學習應用優化,從傳統 CPU 為主 GPU 為輔的英特爾處理器變為 GPU 為主 CPU 為輔的結構。不過,未來相當長一段時間內,計算系統仍將保持 CPU + 協處理器的混合架構。但是,在協處理市場,隨著人工智能尤其是機器學習應用大量涌現,芯片廠商紛紛完善產品、推出新品,都想成為智能時代協處理器的領跑者——但問題是,誰會擔當這個角色呢?

TPU:始于谷歌,終于谷歌

要說新的芯片,首先不得不提谷歌在剛剛結束的 I/O 大會上披露的 TPU。

有輿論稱,谷歌自己打造芯片,勢必對芯片制造商產生巨大影響。確實,面向機器學習專用的處理器是芯片行業的發展趨勢,而且未來其他大公司也很有可能組建芯片團隊,設計自己專用的芯片。

谷歌TPU芯片

TPU 團隊主要負責人、計算機體系結構領域大牛 Norm Jouppi 介紹,TPU 專為谷歌 TensorFlow 等機器學習應用打造,能夠降低運算精度,在相同時間內處理更復雜、更強大的機器學習模型并將其更快投入使用。 Jouppi 表示,谷歌早在 2013 年就開始秘密研發 TPU,并且在一年前將其應用于谷歌的數據中心。TPU 從測試到量產只用了 22 天,其性能把人工智能技術往前推進了差不多 7 年,相當于摩爾定律 3 代的時間。

有媒體評論稱 TPU 不僅為谷歌帶來了巨大的人工智能優勢,也對市面上已有的芯片產品構成了威脅。

這后半句話值得商榷。GPU 巨頭、英偉達 CEO 黃仁勛日前告訴《華爾街日報》,兩年前谷歌就意識到 GPU 更適合訓練,而不善于做訓練后的分析決策。由此可知,谷歌打造 TPU 的動機只是想要一款更適合做分析決策的芯片。這一點在谷歌的官方聲明里也得到了印證:TPU 只在特定機器學習應用中作輔助使用,公司將繼續使用其他廠商制造的 CPU 和 GPU。

谷歌云服務副總裁 Diane Greene 也表示,谷歌并沒有對外銷售 TPU 的打算——拋開 TPU 本來就是為了谷歌自己設計的這個事實以外,谷歌對外銷售芯片的可能性很低,就像 Facebook 主張全球提供免費互聯網,也并不是自己要做運營商。

因此,TPU 再好,也僅適用于谷歌,而且還是用于輔助 CPU 和 GPU。

TrueNorth 坐山觀虎斗?

第二個要說的是 IBM TrueNorth。IBM 在 2014 年研發出脈沖神經網絡芯片 TrueNorth,走的是“類腦計算”的路線。類腦計算的假設是,相似的結構可能會實現相似的功能,所以類腦計算研究者使用神經形態器件制造與人腦神經網絡相似的電子神經網絡,希望后者具有與人腦類似的功能,并進一步反過來理解人類智能。

帶有IBM TrueNorth的DRAPA SyNAPSE

TrueNorth 一張郵票大小,有 54 億個晶體管,構成的神經元陣列包含 100 萬個數字神經元,這些神經元之間又通過 2.56 億個電突觸彼此通信。由于采用了異步架構,TrueNorth 的能耗很低,54 億個晶體管僅用 70 毫瓦;而且,只有在特定神經元被開啟并和其他神經元通信時才會產生能耗。TrueNorth 設計師 Filipp Akopyan 表示,TrueNorth 的目標是 Edge-of-the-Net 和大數據解決方案,所以必須要能夠用超低功耗實時處理大量數據。

在此基礎上,2016年 4 月 IBM 推出了用于深度學習的類腦超級計算平臺 IBM TrueNorth,含 16 個 TrueNorth 芯片,處理能力相當于 1600 萬個神經元和 40 億個神經鍵,消耗的能量只需 2.5 瓦。

將低能耗芯片用于深度學習無疑是一大重舉,美國 LLNL 數據科學副主任 Jim Brase 表示,類腦計算與未來高性能計算和模擬發展趨勢一致。但是,新智元芯片群的幾位專家討論后一致認為,TrueNorth 雖然與人腦某些結構和機理較為接近,但智能算法的精度或效果有待進一步提高,離大規模商業應用還有一段距離。

因此,未來 10 年芯片市場群雄逐鹿,TrueNorth 大概不會有亮相的機會。

寒武紀:中國的智能芯片

寒武紀是國際首個深度學習專用處理器芯片。2012 年,中科院計算所和法國 Inria 等機構共同提出了國際上首個人工神經網絡硬件的基準測試集 benchNN。這項工作提升了人工神經網絡處理速度,有效加速了通用計算,大大推動了國際體系結構學術圈對神經網絡的接納度。此后,中科院計算所和法國 Inria 的研究人員共同推出了一系列不同結構的 DianNao 神經網絡硬件加速器結構。

寒武紀芯片板卡

2016 年 3 月,中科院計算所陳云霽、陳天石課題組、寒武紀公司提出的寒武紀深度學習處理器指令集 Cambricon 被計算機體系結構領域頂級國際會議 ISCA 2016 接收,在所有近 300 篇投稿中排名第一,在深度學習處理器指令集方面取得了開創性進展。指令集是計算機軟硬件生態體系的核心,英特爾和 ARM 正是通過其指令集控制了 PC 和嵌入式生態體系。

2016 年 4 月,寒武紀進入產業化運營,陳天石也從中科院計算所的副研究員變成了北京中科寒武紀科技有限公司的 CEO。陳天石表示,寒武紀產業化運營的主要方向將是高性能服務器芯片、高能效終端芯片和服務機器人芯片。

寒武紀芯片預計 2018 年左右上市,其表現如何,值得期待。

后起之秀概率芯片

2016 年 4月16 日,MIT Techonolgy Review 報道,DARPA 投資了一款叫做“S1”的概率芯片。模擬測試中,使用 S1 追蹤視頻里的移動物體,每幀處理速度比傳統處理器快了近 100 倍,而能耗還不到傳統處理器的 2%。MIT 媒體實驗室教授、Twitter 首席媒體科學家 Deb Roy 評論稱,近似計算的潮流正在興起。

美國 Singular Computing 公司開發的“S1”概率芯片(來源:MIT Techonolgy Review)

紐約州立大學石溪分校終身教授顧險峰從最基礎的數學層面分析了概率芯片的優點,專用概率芯片可以發揮概率算法簡單并行的特點,極大提高系統性能。概率芯片所使用的隨機行走概率方法有很多優點:算法邏輯異常簡單,不需要復雜的數據結構,不需要數值代數計算;計算精度可以通過模擬不同數目的隨機行走自如控制;不同的隨機行走相互獨立,可以大規模并行模擬;模擬過程中,不需要全局信息,只需要網絡的局部信息。

顧險峰最后總結,隨著英特爾重組,傳統 CPU 體系機構獨霸江山的時代將一去不復返,概率芯片和其他更多采用全新架構的專用處理器分庭抗禮的時代即將來臨。

早在 2008 年 MIT Techonolgy Review “十大科技突破”預測中,概率芯片就榜上有名。通過犧牲微小的計算精度換取能耗明顯降低,概率芯片在歷來追求精準的芯片領域獨樹一幟,但正因如此,再考慮到 DARPA 已經投資 S1,概率芯片很可能后來居上。

實力股 FPGA

2012年,百度決定自主設計深度學習專有的體系結構和芯片,經過深入研究和論證,為了讓項目快速落地及迭代,工程師最后決定使用 FPGA 實現百度第一版自主設計的深度學習專有芯片。

作為 GPU 在算法加速上強有力的競爭者,FPGA 硬件配置最靈活,單位能耗也通常比 GPU 低。更重要的是,FPGA 相比 GPU 價格便宜(雖然性價比不一定是最好的)。使用 FPGA 需要具體硬件的知識,對許多開發者有一定難度,因此 FPGA 也常被視為一種行家專屬的架構。不過,現在也出現了用軟件平臺編程 FPGA,弱化了軟硬件語言間的障礙,讓更多開發者使用 FPGA 成為可能。

加州大學計算機博士劉少山認為,FPGA 具有低能耗、高性能以及可編程等特性,十分適合感知計算。在能源受限的情況下,FPGA 相對于 CPU 與 GPU 有明顯的性能與能耗優勢。FPGA 低能耗的特點很適合用于傳感器的數據預處理工作。此外,感知算法不斷發展意味著感知處理器需要不斷更新,FPGA 具有硬件可升級、可迭代的優勢。劉少山預計,FPGA 與傳感器的緊密結合將會很快普及,而后隨著視覺、語音、深度學習的算法在 FPGA 上的不斷優化,FPGA 將逐漸取代 GPU 與 CPU 成為機器人上的主要芯片。

目前還沒有任何深度學習工具明確支持 FPGA,但顯然它是一支實力股。

GPU:未來市場霸主?

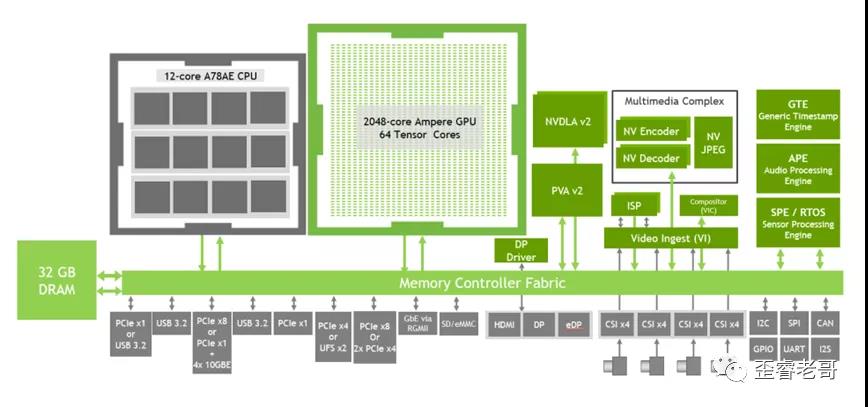

憑借強大的并行計算能力,在機器學習快速發展的推動下,GPU 目前在深度學習芯片市場非常受歡迎,大有成為主流的趨勢。互聯網巨頭,比如谷歌、Facebook、微軟、Twitter 和百度等公司都在使用 GPU 分析圖片、視頻和音頻文件,改進搜索和圖像標簽等應用功能。GPU 也被應用于 VR/AR 相關的產業。此外,很多汽車生產商也在使用 GPU 作為傳感器芯片發展無人車。可以說,GPU 是眼下智能產品市場用戶覆蓋率最廣泛的芯片。

研究公司 Tractica LLC 預計,到 2024 年深度學習項目在 GPU 上的花費將從 2015 年的 4360 萬增長到 41 億美元,在相關軟件上的花費將從 1.09 億增長到 104 億。

但是,也有人認為通用芯片 GPU 相比深度學習專用芯片并不具有優勢。

這有一定道理。然而,設計新的芯片需要很多年,研發成本可能高達幾千萬甚至幾十億美元。而且,專用芯片比通用芯片更難編程。最重要的是,專用芯片——根據定義——只提升特定任務的性能表現,這也是為什么谷歌要制作 TPU 輔助 GPU 和 CPU。

英偉達工程架構副總裁 Marc Hamilton 表示,谷歌的 TPU 是一個非常有意思的技術,但其發布進一步印證了他們的觀點,那就是人工智能處理器將繼續從通用的 CPU 轉向 GPU 和 TPU 等其他芯片。此外,GPU 技術也在不斷發展,從算法層面加速智能感知計算速度。

Hamilton 還提到了百度人工智能科學家 Bryan Catanzaro 的話:深度學習并不是一個那么窄的領域,從計算角度看,深度學習是多樣化的而且演化迅速;要是制造一款適用于所有深度學習應用的專用芯片,本質上也就成了 GPU 或 DSP。

當然,GPU 也有缺陷,比如不如 FPGA 靈活。同時,GPU 也不乏競爭者:除了同樣具備并行計算能力的 AMD,Nervana、Movidius 等公司都在制作與 GPU 類似的芯片,但側重于把數據更快轉移和分攤給圖像所需要的功能。

小結

除了采用其他架構,研究人員很早就開始探索使用新材料制作芯片。2015 年,三星、Gobal Foundries、IBM 和紐約州立大學等機構組成的研究聯盟推出了一個 7 納米的微芯片,其晶體管大約一半都由硅鍺(SiGe)合金制成。石墨烯也是芯片研發一個重點。機器學習加速新材料發現,也意味著使用新材料制作的芯片出現幾率大大提高。

總之,谷歌自己打造 TPU 預示著未來更多非半導體公司或許也將開始生產硬件;硬件制造商必須不斷改進自己的產品,與 CPU 進行更好的配合,并且貼近用戶越來越多樣化的需求。

電子發燒友App

電子發燒友App

評論