人們最初確實天真地以為,算法能比人類更能避免偏見。人工智能學習人類知識,同時也吸收人類偏見。這種擔憂由來已久。但谷歌的一項新發明極大推進了人工智能從文本材料中學習的速度,也使解決機器偏見問題迫在眉睫。

10 月 25 日,谷歌宣布利用 BERT 來優化搜索引擎,已經使英語搜索結果的匹配度提高了 10% 左右。未來,谷歌還會推出學習其他語言和國家的算法。

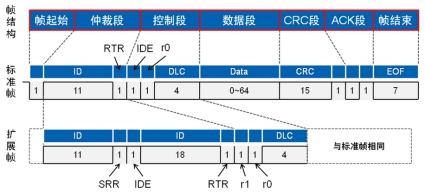

BERT 是谷歌在 2018 年開發的一種基于神經網絡的 NLP 技術,它能一次接收整句話,而非從左至右(或相反)逐字接收。這使得如果有人要搜“在沒有路緣的山坡停車”,BERT 能認出“不要”,從而給出正確的搜索結果。而傳統搜索引起只會關注“路緣”和“山坡”,給出與搜索意圖相反的結果。

圖 | BERT 能更好識別“在沒有路緣的山坡停車”句子里的“沒有”一詞,從而理解人類意圖

讓人們擔憂的是,BERT 的學習材料正來自數字化書籍和新聞文章。在 BERT 學會一切之前,人們沒有時間來清理其中根深蒂固的偏見。而這些偏見一旦被算法吸收,將更難辨認,也更難清除。

“形象一下在 AI 世界長大的孩子。他們在谷歌搜索 CEO 照片,冒出的大部分是男性。他們又搜索個人助手,大部分是女性。”Kriti Sharma 在一次 TED 相關演講中說。卡耐基梅隆大學的計算機科學家已研究證實,BERT 傾向于將程序員與男性聯系起來。

另一位計算機科學家 Robert Munro 發現,展示給 BERT 100 個單詞,包含馬、嬰兒、房子、珠寶等。BERT 會認為大部分與男性有關,僅媽媽是個例外。

“BERT 改變了一切,你可以教它所有技巧。”NLP 初創公司 Primer 的科學主管 John Bohannon 說。Munro 則認為,不平等現象一直存在,但有了 BERT,偏見就能夠繼續存在下去。

“是時候把算法當作人類設計的造物了。”人工智能批評人士 Kate Crawford 說,算法經常被看作是不帶偏見、不可理解、勿需質疑的對象,但實際它會繼承我們的偏見,它只可能跟我們一樣好。

決策黑盒為偏見“藏污納垢”

人們最初確實天真地以為,算法能比人類更能避免偏見。1970 年代,倫敦圣喬治醫學院的 Geoffrey Franglen 博士著手編寫一個算法來篩選學生的入學申請。他認為,如果所有學生的申請都要遵循完全一樣的評估流程,結果就是公平的。

算法完成后與人類判斷有 90% 到 95% 的一致率,因此被投入使用。但直到 4 年后,調查者才發現:算法會僅僅因為一個候選人沒有歐洲名字(可能不是白人),就扣除 15 分。如果申請者是女性,又要被扣掉 3 分。

“從深層次看,算法只是在維持招生系統早已存在的偏見而已。”IEEE 的文章評論說,“圣喬治醫學院之所以被逮住,是因為他們把偏見供奉到一個計算機程序里面,歧視是調查者可以驗證的。”

但對于人工智能的黑箱式決策,情況變得更加復雜。性別或出生地在算法中并不對應單一可辨的參數,你很難給機器“定罪”。“在大工業時代,機器以暴露齒輪來展示強大。但如今,齒輪被隱藏起來,融入生活,無處不在,AI 就是這個齒輪。”一篇《福布斯》文章精辟地說。

在這種黑箱決策面前,反歧視法案可能也無能為力。Kriti Sharma 認為,如果 AI 幫人事主管尋找一位技術領袖,它會發現主管雇傭的大多是男性,從而以為男人比女人更容易編程。如果人類主管這樣做,我們會憤怒,也能夠阻止。“人工智能實際已凌駕于法律之上,因為是機器做的決定。”

更值得擔憂的是,AI 決策可能放大了科技企業和數據標注者的權力,因為無人能監督。一個名為 ImageNet Roulette 的流行應用,曾故意向人們展示這種風險:它曾傾向于將非洲裔美國人標記為“不法分子”“罪犯”,此外還有“失敗者”“初學者”“蕩婦”這樣的標簽。

它的訓練數據來自 ImageNet 數據集,包含了 1400 張被標記的照片,而每張標記費用為幾美分。因此標簽標注者的偏見便被帶入數據集,訓練出各種算法,應用在形形色色的領域。“如果標注女性照片的人不選非二元人群或短發女性,那最終得到的人工智能就只認長發的女性模特。”

在被發現算法存在機器偏見時,谷歌和亞馬遜都會承諾迅速解決。“我們發現的明顯的偏見,但里面如果還有幾個呢?”Bohannon 博士說。如果要依賴這種決策,“正如生物學家努力理解細胞工作原理一樣,軟件工程師也必須找到理解 BERT 系統的方法。”

責任編輯:ct

電子發燒友App

電子發燒友App

評論