近期,ChatGPT以百科全書般的功能引發了業界關注,作為下一個探索熱點,AIGC也激發了大量的行業需求。AIGC將如何重塑內容生態?算力作為AIGC應用背后的關鍵,AIGC對算力有哪些需求?2月10日,摩爾學院院長李豐做客網易科技《邁向AIGC大淘金時代》直播連線,并帶來《全功能GPU是AIGC的算力底座》為主題的分享。

以下是經過整理的訪談實錄:

主持人:大家在接觸ChatGPT之后,會有一種被震撼的感覺。其實AIGC對于目前的內容創作,更多是一種輔助,之后是和人類合作,最后它到達自主的原創階段。其中每一個階段,需要在算法或者數據訓練方面做出哪些突破,距離AIGC真正高度取代人類又有多遠的距離?

李豐:首先,現在ChatGPT也好,AIGC也好,已經可以在某種程度上替代一些人的工作了。以ChatGPT來說,目前它天然的模型是有一些缺陷的。比如,如果你去使用真的ChatGPT,它經常會一本正經的“胡說八道”,這個現象是很普遍的。

我們都知道作為人類,一個人對信息的判別和過濾,很多人連網絡上各種虛假信息都不具備真假的辨別能力,我們跟AI對話當中得到的信息,我們怎么知道它是真是假,這是目前的一個很大的問題。而這個問題至少在目前的ChatGPT技術架構上是無法解決的。同時,因為它現在整個模型的知識,官方說截至2021年。假設實時的新產生的知識它不知道的時候,必然有一些時效性的知識它是有可能“胡說八道”的。所以,當AIGC產生的大量內容和人類產生大量的內容,融合在一起的時候,在很大程度上,你是很難很快去區分的,不管是文字還是圖片。

第二,我們可以在產品上,把一些實時的結果跟ChatGPT的對話結果融合在一起。就像谷歌前幾天的發布會,雖然它的Bard在發布的時候回答錯了一些問題。但是實際上,如果說我們真的去用ChatGPT就知道,ChatGPT回答錯的問題更是多了去了,所以我不認為谷歌的技術就比不上OpenAI,做不出類似的東西。反而是因為它的搜索覆蓋的用戶群過于巨大,它在產品上做一個小的修改,很有可能會引起數以億計的用戶習慣的改變,以及影響到它數十億美金的收入。所以它和OpenAI的地位是不太一樣的,它必然就會束手束腳,這是一個很重要的原因。

總的來說,AIGC實際上已經進入生產,已經可以滿足我們低階的需求,但是要看你怎么用。實際上我知道的一些團隊,包括我所在的團隊,都已經把AIGC的內容導入了工作流,做某個方面的優化。我相信很多的AIGC的產品,它現在在輔助人類的工作,以及替代人類的局部工作,這個現象已經在產生,而歷史的車輪是不可阻擋的。

但也正如前面我提到,ChatGPT現在產生的很多內容,對于精準性、正確性來說,是有很大的缺陷的,這個影響如果說貫穿到很多的行業里,也可能帶來對社會的一些負面影響,所以很多技術,在使用過程當中,我們既要擁抱它的變化,既要善于使用工具,同時也要能夠控制工具,這是我的觀點。

主持人:像AIGC應用,包括ChatGPT,目前需要的算力并不低,如何平衡算力成本和商業變現之間的關系?對于AIGC而言,如何打造一個長期的商業模式或價值?

李豐:首先算力這個問題,在某種程度上,隨著時間的推移,成本肯定會下降。因為我們都知道,GPU一直是號稱超越摩爾定律算力的發展,因此,我覺得某種程度上,算力的成本會隨著時間的推移、半導體技術的發展,這是一個降低的維度。另外一個維度是說算法的改進,效率的提升,包括一些壓縮模型的提出和使用,也會使得成本有一個降低的維度。

商業模式這一點,我認為芯片廠商,可能是吃到AIGC這一波大紅利的廠商。因為他們是基礎設施的提供者,幾乎所有的AIGC算力,現在都是GPU在提供,尤其是在訓練方面。另外一類,比如說云廠商,同樣作為基礎設施提供者,會推出大量的GPU云,以降低GPU部署的門檻。我認為這兩類廠商,相對來說,商業模式比較清楚,它的盈利的點,包括商業模式的建立比較清晰,可以得到保障。?

同時,現在產生出一種新的模式,有的把它叫做MaaS,也就是說模型即服務。有很多的廠商把自己預訓練好的大模型開源出來,這些大模型如果你本機用還可以,但是要把它作為一個服務提供出去的時候,就需要算力托管。所以如果說把大模型加上算力托管做成中間件,提供很多標準的、可調度、可管理的API對外提供,我相信這又是另外一種商業模式,會有不少廠商在這一層上做。?

但是因為算力的產生,算力由中間件到應用開發商,最后到用戶付費這個管道,因為不同用戶付費的意愿和付費的能力是不一樣的,假設你開發的只是一個玩具,寫寫古詩詞,你可能用戶量很大,但是大部分人不會付費,最多有的人會愿意付你幾塊錢的訂閱費,這要覆蓋算力成本幾乎不可能。但如果把AIGC很多成果和生產力對接,能夠解決很多具體的問題,很多行業里的垂直用戶是愿意為這些具體的問題付出高昂費用的。所以目前看起來,我看應用級別,已經產生了比較大收入的,因此這也是一類商業模式。

還有一類是用AIGC文本生成,去做產品評測的文檔,大規模的發出去引流,然后把流量拿來變現,這一類廠商有一些收入也不錯。從另外一個角度來說,一大堆AI產生的內容,在互聯網上作為引流信息,可能人也不怎么看,實際上在互聯網上本身也是一個商業模式,所以這個商業模式也是一類。

總而言之,我認為基礎設施、中間件、算力托管、云服務廠商,這些相對來說隨著時間的推移,盈利模式會比較容易,但是應用開發商還有很長的路要走,至少目前世界上最火的ChatGPT,現階段肯定是嚴重虧損的,所以什么時候能夠達到真正的盈利這一點,有待觀察。

主持人:AIGC如果要大規模應用,它成功的必備因素有哪些?目前國內AIGC的發展現狀如何?與ChatGPT的差距在哪里?

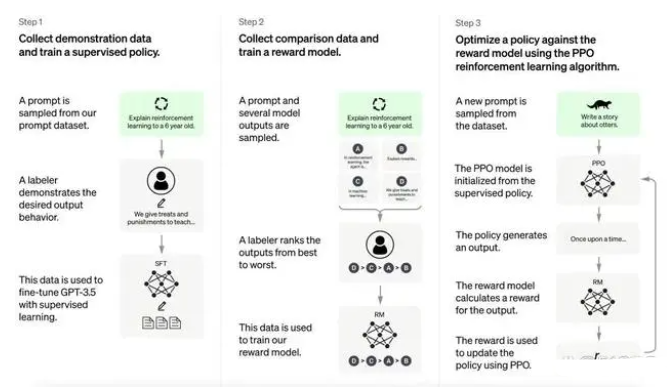

李豐:任何技術從誕生到成熟,到真正的得到應用,它是有一個很長的時間周期的。ChatGPT今天有這樣的成果,并不是突然冒出來的,因為OpenAI經歷了很長一個過程,它作為一個非營利性組織,到相對商業化運作,這個時間是非常長的。而且ChatGPT本身也是經過了GPT1、GPT2、GPT3,包括它是在GPT3.5上加入了很多人類反饋的微調才產生的,它的整個誕生過程是相當漫長的。所以,任何在這個領域里想深耕的企業,它是需要有很長的技術積淀的。

目前,從我個人觀察來看,國內網絡上,以ChatGPT為名的,各種各樣的微信機器人、網絡的應用,相當大一部分和ChatGPT沒有什么關系。很多行業做的事情只要能沾點邊,就拼命往ChatGPT上去靠。在我看來,并不是說今天有一家公司說,ChatGPT很熱,馬上要做就可以成功。

第一個因素是資金。雖然說ChatGPT沒有公布GPT3.5的參數,但是GPT3的參數量高達1750億,數據量也達到了45TB,從一些數據來看,它動用的GPU訓練算力是世界上最高端的GPU芯片,而且是成千上萬張來進行訓練,所以訓練一次的成本相當昂貴。所以很多小型團隊如果說沒有足夠的資金,這件事情至少目前無法實現。

第二因素是原創性。我們必須得承認,在人工智能方面很多的原創模型和原創算法,目前很多還是來自于硅谷的團隊,其實ChatGPT也不是從零開始的,它的很多模型也是來自于其他,比如說它使用了谷歌的Transformer,所以說ChatGPT也是站在全世界很多個科學家以及很多企業,包括很多的開源貢獻者的肩膀上才出現的。目前,國內很多企業也運用了開源,比如GPT2是開源的,BERT是開源的,在一些開源模型上,做一些調整,產生出一些應用,不是說這個方法不好,但是實際上,我們還是在前人很多的技術基礎上來進行修改,我們并沒有誕生出在AIGC方面原創性的成果,我們必須要承認這個差距是在的。

當然,國內近期有一些大的企業,比如說百度、阿里等廠商,已宣布將發布類似于ChatGPT的產品戰略或者是產品的體驗。我相信這些國內的大廠,因為有很長時間的技術積淀,也有大量的數據積淀,也有足夠雄厚的資金和足夠多的工程師,所以,我很期待國內AIGC在接下來的時間里陸續亮相。

主持人:算力是AIGC應用背后的關鍵,AIGC對算力有哪些需求?企業若想大力發展AIGC,在算力方面方面應該做哪些部署?

李豐:我們今天做一個AI應用的部署,實際上就像造車一樣,我們不是從種一棵橡膠樹開始的,而是基于很多前人的技術成果上來搭建我們自己的應用。我們必須基于很多開源生態當中的成果來做,所以就不得不使用同樣算力平臺來做這件事情。

我們也看見有一些AI專用芯片在某些專門算法上優于GPU,但是AI模型和算法迭代的速度非常快,而針對專用算法優化的特定芯片,如果說現在部署,很可能到用上那一天,這個算法已經落后了,所以為了兼顧靈活度和應用開發的算力,目前來看全功能GPU更適合。或許將來,在推理尤其是邊緣端的推理上,可能會有一些專用的SoC可以用于在推理方面的很多應用。事實上,包括現在,在邊緣推理上,其實已經有一些專門的SoC在圖像識別等領域得到了應用。

因此,我個人認為,將來的生態,基本上會以GPU為主,輔以其他種類芯片的生態。所以,假設今天要部署算力集群,首先要有一個明確的目標,我到底要做什么?我需要跟OpenAI去PK大語言嗎?這時候就要先評估自己的資金有多少億打底,如果有看OpenAI發表的一些文章和訪談就知道,有很大一筆費用,他們用于購買GPU。而且買來了GPU,還要有運維、管理、算力部署,需要一個團隊來運營,所以要做什么,決定了你要投入多少在算力部署上。

同時,我認為現在,尤其對于很多小型團隊,肯定要想清楚自己要做什么,因為AIGC是一個工具,最終要解決人類的某些問題,所以我更認為,為你要解決的某些問題來做算力的部署規劃,然后同時有一部分自己本地的小型算力部署,結合一些GPU算力云的算力調用,有可能隨著用戶的多少或者是計算任務種類的變化,你需要一個彈性可變的算力,所以需要一種混合部署的方法,包括很多企業在做AIGC時,基本上也是采用這樣的方式。此外,對于個人而言,也有一些模型是可以在本地計算機上部署的,當然這些模型部署下來,需要的也是本地GPU。因此,在算力部署這個話題上,無論你從哪一個角度去看,都繞不開GPU。

主持人:ChatGPT可以說是AIGC當中的一個爆款,摩爾線程也有自己的AIGC平臺,咱們在開發的過程中遇到最大的困難和挑戰是什么?從ChatGPT的發展上是否得到什么啟示?未來希望怎么落地?

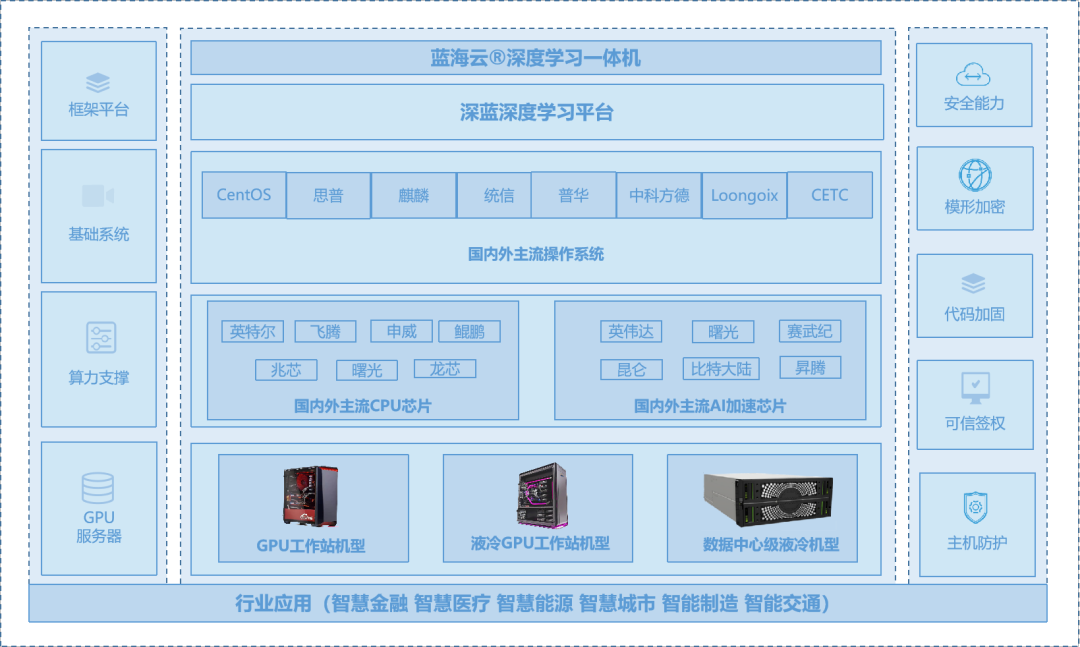

李豐:首先,摩爾線程部署自己的AIGC平臺,這件事情很久以前就在做了。我們跟很多其他廠商不同,我們在推出服務的時候,要必須讓所有的應用都部署在自己的GPU上,要把現在豐富多樣的模型以及生態,在我們GPU上運行起來,這背后還涉及了很多技術問題。總的來說,摩爾線程作為一個算力提供者,我們希望能夠幫助應用開發商擁有一個從端到端的硬件到軟件棧的一套整體解決方案,包括我們也推出了算力底座MCCX元計算一體機,專為元宇宙應用構建的MTVERSE元宇宙平臺,可以把上層SDK工具提供給開發者,實現AIGC內容生成等一系列功能,進一步簡化應用和解決方案的開發周期和難度。

所以,我們做AIGC平臺,不是簡單做一個應用開發,把應用開放出來給消費者使用就可以了,我們要兼顧要做的事情,遠比單純的應用開發商更復雜,而且做GPU最難的是生態的建立,我們要兼顧很多的生態兼容性,比如全功能GPU做多模態生成,對于各種視頻格式的編解碼,作為科學計算的使用,包括AI訓練和推理,包括要展現出圖形的三維的、二維的各種渲染。實際上,我們希望自己的AIGC平臺,運行在自己的GPU上,能夠展示出摩爾線程研發了一個真正的全功能GPU,能夠在AIGC領域對很多類型的內容生成都進行良好的支持。

除此之外,我們開發的AIGC平臺,也在去年11月發布會首次亮相,它叫摩爾線程“馬良”,我們內部已經內測了很長一段時間,現在還在不斷迭代和增加功能過程當中。今年之內,我們陸續會有一些AIGC的成果給大家展現。

此外,摩爾學院院長李豐還帶來《全功能GPU是AIGC的算力底座》的主題分享,以下是經過整理的現場實錄:

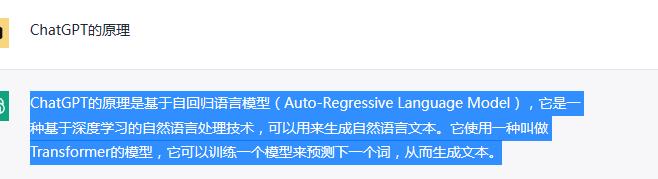

最近大熱的話題ChatGPT在AIGC(AI Generated Content)的C當中,屬于自然語言的本文生成,包括前一段時間流行的文本生成圖像,這些類別我們都統稱為AIGC,實際上就是用人工智能來生成各種類型的內容,包括文本、圖像、音樂、視頻、三維模型等,而且還會涵蓋面越來越廣。

其實不管是ChatGPT,還是基于文本的圖像生成,它們都有一個底層邏輯,所有這一切都是計算能力產生的內容,而這個算力是現在幾乎AIGC都采用的算力——GPU。那么,為什么最終的內容生成都依賴GPU?

首先,GPU為現代科技當中需要算力的地方提供了重要支撐,比如大家熟悉的圖像識別、自動駕駛的訓練、包括推薦算法等領域,以及科學計算、高清視頻編解碼,這些很多需要算力的領域。今天,全世界和中國主要增長算力的來源都是來自于GPU,而AIGC是通過人工智能的模型,通過一些算法來產生出內容,這些內容的種類多種多樣,其產生的機理,大多數先要歷經一個訓練過程,這個過程中需要大量的數據,這些數據需要在非常龐大的GPU集群上進行訓練,訓練完成之后,又部署到GPU的集群上,然后大家在使用當中,它是一個推理的過程。

所以,今天所有的AIGC都繞不開的一個話題,它們的算力底座都來自于全功能GPU,而且我們都知道,ChatGPT主要是文本生成,還有很多人用ChatGPT生成的文本也去生成圖像。這個過程不管是生成圖像、視頻還是三維模型,又需要另外一種計算方法,比如生成高清視頻,需要視頻編解碼;生成音樂,需要音頻的編解碼;三維模型需要三維的渲染,所以所有的這一切,就使得GPU成了這個浪潮當中基礎設施的提供者。

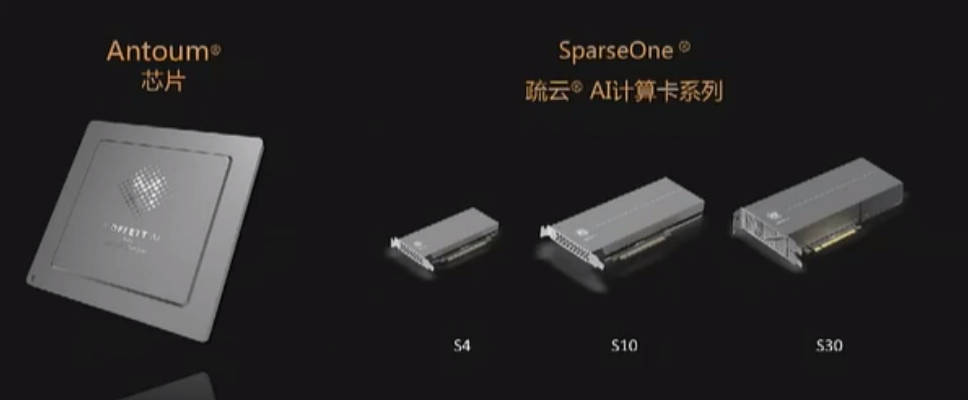

我們都知道,所有的人工智能算法是在不斷進步和迭代的,GPU兼顧了靈活度以及計算能力,它是屬于芯片行業的“圣杯”。摩爾線程作為一家以全功能GPU芯片設計為主的創新型企業,我們也有在AIGC方面的布局。實際上,我們已經在內部測試,一個完全部署在摩爾線程全功能GPU上的AIGC平臺,不久就會跟大家見面,它包括了圖像生成、自然語言生成等一系列的多模態內容生成平臺。?

當然,我們也希望隨著技術的進步,GPU可以為接下來的AIGC帶來很大的助力。所以總的來看,GPU作為AIGC的核心發動機,以及算力的提供者和算力服務的支撐者,摩爾線程可能跟目前市場上做AIGC的一些企業定位不同,我們相當于屬于整個產業的基礎設施的提供商,也希望為中國AIGC發展及相關算力應用提供強大且易用、堅實的算力底座。?

? 編輯:黃飛

?

電子發燒友App

電子發燒友App

評論