半個月以來,ChatGPT 這把火越燒越旺。國內(nèi)很多大廠相繼聲稱要做中文版 ChatGPT,還公布了上線時間表,不少科技圈已功成名就的大佬也按捺不住,攜巨資下場,要創(chuàng)建 “中國版 OpenAI“。

不過,看看過去半個月在群眾眼里稍顯窘迫的 Meta 的 Galactica,以及 Google 緊急發(fā)布的 Bard,就知道在短期內(nèi)打造一個比肩甚至超越 ChatGPT 效果的模型沒那么簡單。

讓很多人不免感到詫異的是,ChatGPT 的核心算法 Transformer 最初是由 Google 提出的,并且在大模型技術(shù)上的積累可以說不弱于 OpenAI,當(dāng)然他們也不缺算力和數(shù)據(jù),但為什么依然會被 ChatGPT 打的措手不及?

Meta 首席 AI 科學(xué)家 Yann LeCun 最近抨擊 ChatGPT 的名言實際上解釋了背后的門道。他說,ChatGPT “只是巧妙的組合而已”,這句話恰恰道出了一種無形的技術(shù)壁壘。

簡單來說,即使其他團(tuán)隊的算法、數(shù)據(jù)、算力都準(zhǔn)備的與 OpenAI 相差無幾,但就是沒想到以一種精巧的方式把這些元素組裝起來,沒有 OpenAI,全行業(yè)不知道還需要去趟多少坑。

即使 OpenAI 給出了算法上的一條路徑,后來者想復(fù)現(xiàn) ChatGPT,算力、工程、數(shù)據(jù),每一個要素都需要非常深的積累。七龍珠之中,算力是自由流通的商品,花錢可以買到,工程上有 OneFlow 這樣的開源項目和團(tuán)隊,因此,對互聯(lián)網(wǎng)大廠之外的團(tuán)隊來說,剩下最大的挑戰(zhàn)在于高質(zhì)量訓(xùn)練數(shù)據(jù)集。

至今,OpenAI 并沒有公開訓(xùn)練 ChatGPT 的相關(guān)數(shù)據(jù)集來源和具體細(xì)節(jié),一定程度上也暫時卡了追趕者的脖子,更何況,業(yè)界公認(rèn)中文互聯(lián)網(wǎng)數(shù)據(jù)質(zhì)量堪憂。

好在,互聯(lián)網(wǎng)上總有熱心的牛人分析技術(shù)的細(xì)枝末節(jié),從雜亂的資料中串聯(lián)起蛛絲馬跡,從而歸納出非常有價值的信息。

此前,發(fā)布的《ChatGPT 背后的經(jīng)濟(jì)賬》,其作者從經(jīng)濟(jì)學(xué)視角推導(dǎo)了訓(xùn)練大型語言模型的成本。本文作者則整理分析了 2018 年到 2022 年初從 GPT-1 到 Gopher 的相關(guān)大型語言模型的所有數(shù)據(jù)集相關(guān)信息,希望幫助有志于開發(fā) “類 ChatGPT” 模型的團(tuán)隊少走一步彎路。

作者|Alan D. Thompson

翻譯|楊婷、徐佳渝、賈川

一些研究人員的報告稱,通用人工智能(AGI)可能是從我們當(dāng)前的語言模型技術(shù)進(jìn)行演進(jìn) [1],預(yù)訓(xùn)練 Transformer 語言模型為 AGI 的發(fā)展鋪平了道路。雖然模型訓(xùn)練數(shù)據(jù)集日漸增大,但缺乏基本指標(biāo)文檔,包括數(shù)據(jù)集大小、數(shù)據(jù)集 token 數(shù)量和具體的內(nèi)容細(xì)節(jié)。

盡管業(yè)內(nèi)提出了數(shù)據(jù)集組成和整理文檔的標(biāo)準(zhǔn) [2],但幾乎所有重點研究實驗室在揭示模型訓(xùn)練數(shù)據(jù)集細(xì)節(jié)這方面都做得不夠。這里整合的研究涵蓋了 2018 年到 2022 年初從 GPT-1 到 Gopher 的精選語言模型的所有數(shù)據(jù)集(包括主要數(shù)據(jù)集:Wikipedia 和 Common Crawl)的綜合視圖。

1、概述

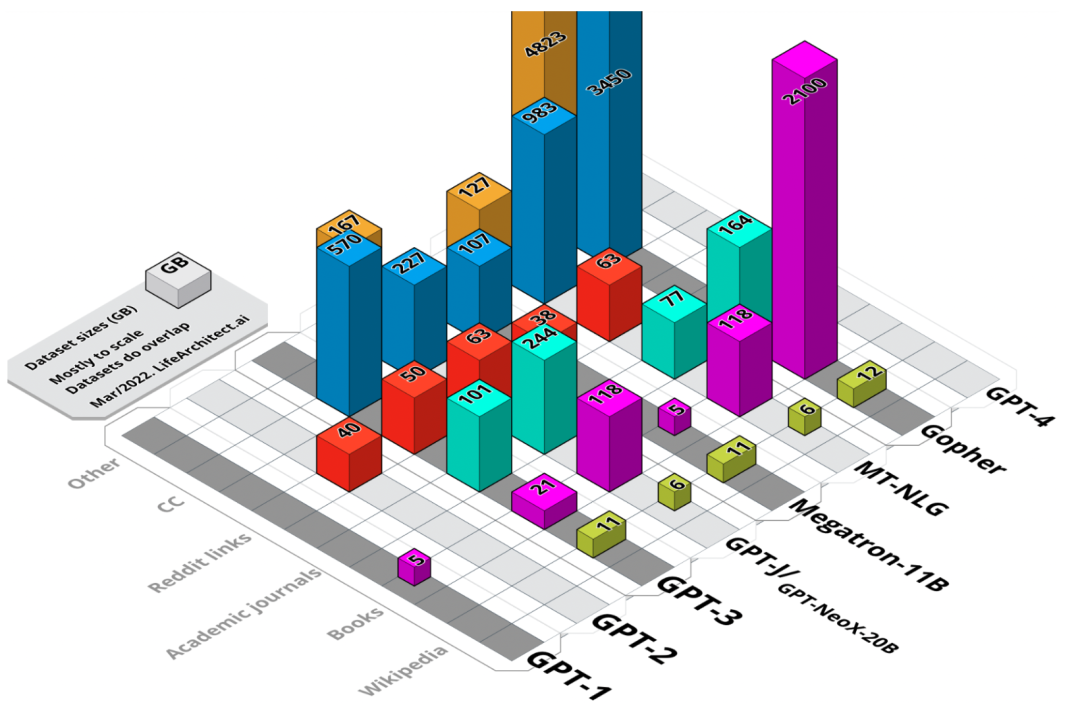

圖 1. 主要數(shù)據(jù)集大小的可視化匯總。未加權(quán)大小,以 GB 為單位。?

2018 年以來,大語言模型的開發(fā)和生產(chǎn)使用呈現(xiàn)出爆炸式增長。一些重點研究實驗室報告稱,公眾對大語言模型的使用率達(dá)到了驚人高度。2021 年 3 月,OpenAI 宣布 [3] 其 GPT-3 語言模型被 “超過 300 個應(yīng)用程序使用,平均每天能夠生成 45 億個詞”,也就是說僅單個模型每分鐘就能生成 310 萬詞的新內(nèi)容。

值得注意的是,這些語言模型甚至還沒有被完全理解,斯坦福大學(xué)的研究人員 [4] 最近坦言,“目前我們對這些模型還缺乏認(rèn)知,還不太了解這些模型的運轉(zhuǎn)模式、不知道模型何時會失效,更不知道這些模型的突現(xiàn)性(emergent properties)能產(chǎn)生什么效果”。

隨著新型 AI 技術(shù)的快速發(fā)展,模型訓(xùn)練數(shù)據(jù)集的相關(guān)文檔質(zhì)量有所下降。模型內(nèi)部到底有什么秘密?它們又是如何組建的?本文綜合整理并分析了現(xiàn)代大型語言模型的訓(xùn)練數(shù)據(jù)集。

因為這方面的原始文獻(xiàn)并不對外公開,所以本文搜集整合了二、三級研究資料,在必要的時候本文會采用假設(shè)的方式來推算最終結(jié)果。

在本文中,我們會將原始論文中已經(jīng)明確的特定細(xì)節(jié)(例如 token 數(shù)量或數(shù)據(jù)集大小)歸類為 “公開的(disclosed)” 數(shù)據(jù),并作加粗處理。

多數(shù)情況下,適當(dāng)?shù)貐⒖级⑷壩墨I(xiàn),并采用假設(shè)的方式來確定最終結(jié)果是很有必要的。在這些情況下,token 數(shù)量和數(shù)據(jù)集大小等細(xì)節(jié)是 “確定的(determined)”,并以斜體標(biāo)記。

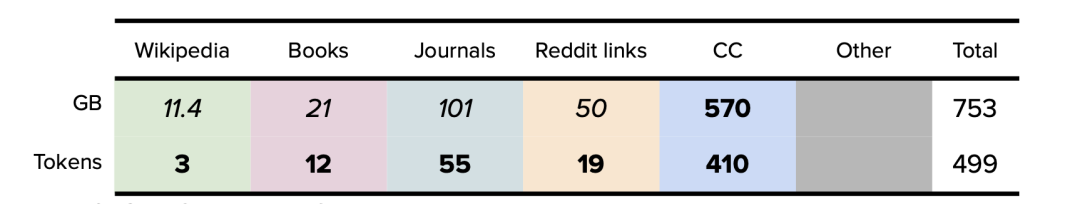

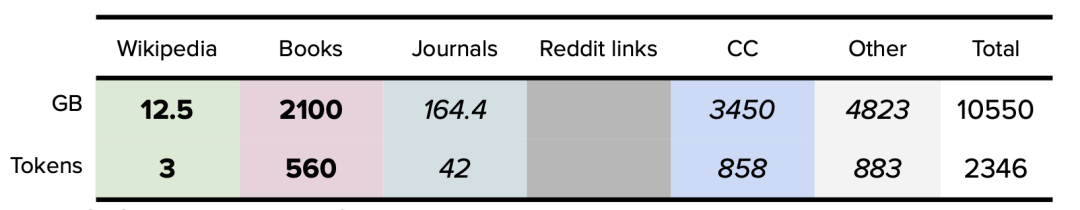

模型數(shù)據(jù)集可分為六類,分別是:維基百科、書籍、期刊、Reddit 鏈接、Common Crawl 和其他數(shù)據(jù)集。

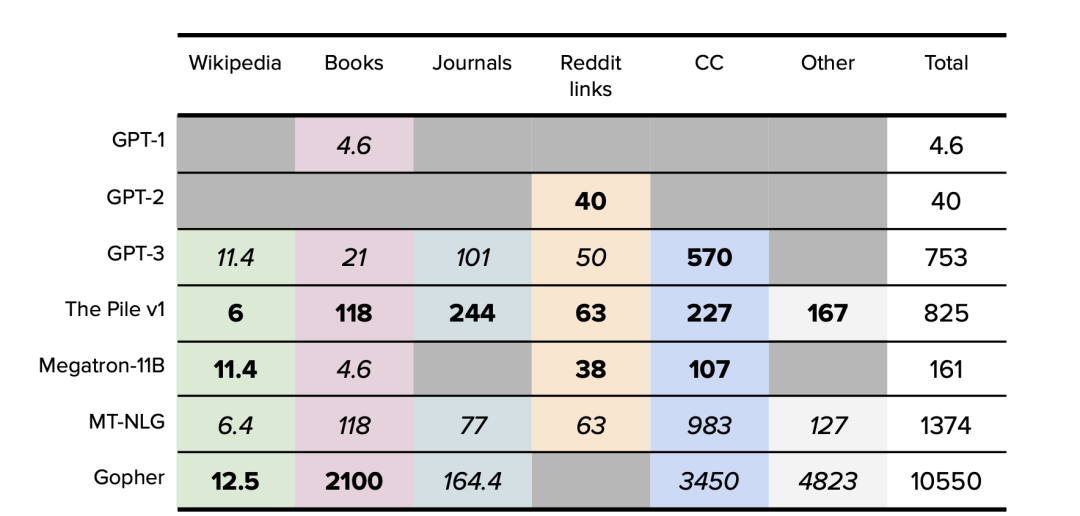

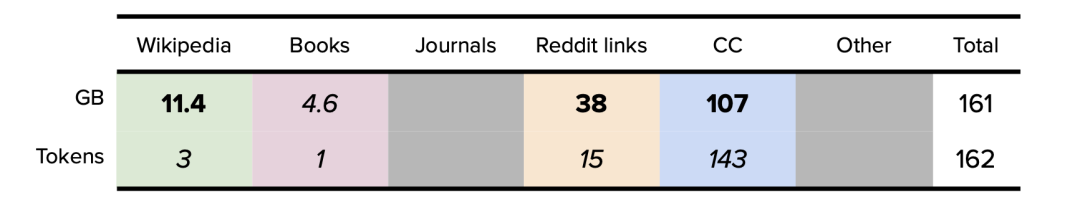

表 1. 主要數(shù)據(jù)集大小匯總。以 GB 為單位。公開的數(shù)據(jù)以粗體表示。確定的數(shù)據(jù)以斜體表示。僅原始訓(xùn)練數(shù)據(jù)集大小。

1.1. 維基百科

維基百科是一個免費的多語言協(xié)作在線百科全書,由超過 300,000 名志愿者組成的社區(qū)編寫和維護(hù)。截至 2022 年 4 月,英文版維基百科中有超過 640 萬篇文章,包含超 40 億個詞 [5]。維基百科中的文本很有價值,因為它被嚴(yán)格引用,以說明性文字形式寫成,并且跨越多種語言和領(lǐng)域。一般來說,重點研究實驗室會首先選取它的純英文過濾版作為數(shù)據(jù)集。

1.2.?書籍

故事型書籍由小說和非小說兩大類組成,主要用于訓(xùn)練模型的故事講述能力和反應(yīng)能力,數(shù)據(jù)集包括 Project Gutenberg 和 Smashwords (Toronto BookCorpus/BookCorpus) 等。

1.3.?雜志期刊

預(yù)印本和已發(fā)表期刊中的論文為數(shù)據(jù)集提供了堅實而嚴(yán)謹(jǐn)?shù)幕A(chǔ),因為學(xué)術(shù)寫作通常來說更有條理、理性和細(xì)致。這類數(shù)據(jù)集包括 ArXiv 和美國國家衛(wèi)生研究院等。

1.4.?Reddit 鏈接

WebText 是一個大型數(shù)據(jù)集,它的數(shù)據(jù)是從社交媒體平臺 Reddit 所有出站鏈接網(wǎng)絡(luò)中爬取的,每個鏈接至少有三個贊,代表了流行內(nèi)容的風(fēng)向標(biāo),對輸出優(yōu)質(zhì)鏈接和后續(xù)文本數(shù)據(jù)具有指導(dǎo)作用。

1.5.?Common Crawl

Common Crawl 是 2008 年至今的一個網(wǎng)站抓取的大型數(shù)據(jù)集,數(shù)據(jù)包含原始網(wǎng)頁、元數(shù)據(jù)和文本提取,它的文本來自不同語言、不同領(lǐng)域。重點研究實驗室一般會首先選取它的純英文過濾版(C4)作為數(shù)據(jù)集。

1.6. 其他數(shù)據(jù)集

不同于上述類別,這類數(shù)據(jù)集由 GitHub 等代碼數(shù)據(jù)集、StackExchange 等對話論壇和視頻字幕數(shù)據(jù)集組成。

2、常用數(shù)據(jù)集

2019 年以來,大多數(shù)基于 Transformer 的大型語言模型 (LLM) 都依賴于英文維基百科和 Common Crawl 的大型數(shù)據(jù)集。在本節(jié)中,我們參考了 Jesse Dodge 和 AllenAI(AI2)[8] 團(tuán)隊的綜合分析,按類別對英文維基百科作了高級概述,并在 Common Crawl 數(shù)據(jù)集 [7] 的基礎(chǔ)上,用谷歌 C4 [6] (Colossal Clean Crawled Corpus) 在 Common Crawl 中提供了頂級域(domains)。

2.1. 維基百科(英文版)分析

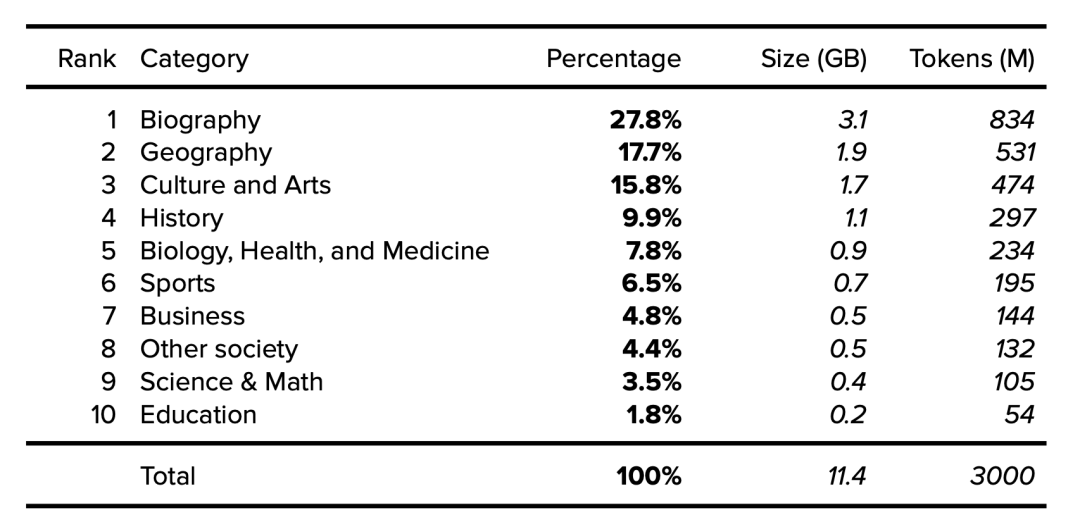

下面按類別 [9] 列出了維基百科的詳細(xì)信息,涵蓋了 2015 年抽樣的 1001 篇隨機(jī)文章,研究人員注意到隨時間推移文章傳播的穩(wěn)定性。假設(shè)一個 11.4GB、經(jīng)過清理和過濾的維基百科英文版有 30 億 token,我們就可以確定類別大小和 token。

表 2. 英文維基百科數(shù)據(jù)集類別。公開的數(shù)據(jù)以粗體表示。確定的數(shù)據(jù)以斜體表示。

2.2 Common Crawl 分析

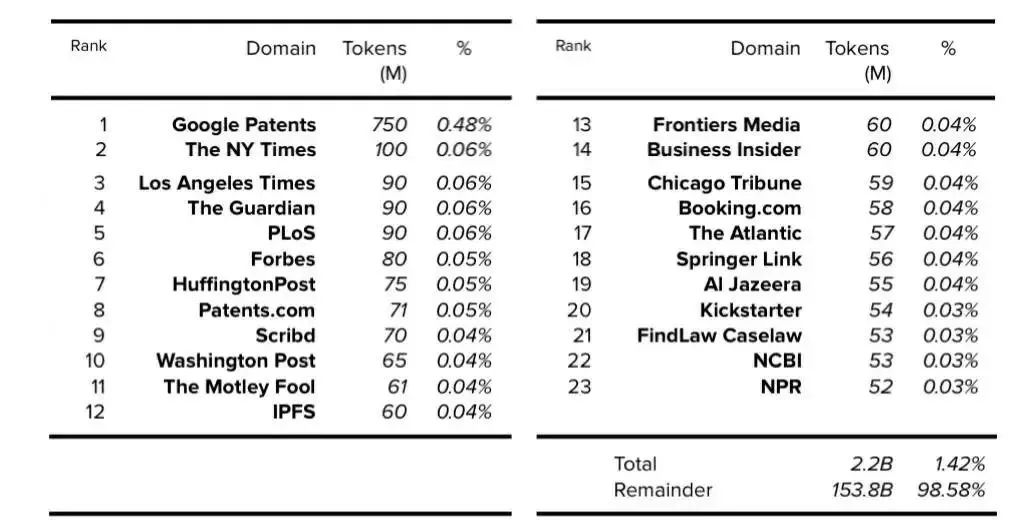

基于 AllenAI (AI2) 的 C4 論文,我們可以確定,過濾后的英文 C4 數(shù)據(jù)集的每個域的 token 數(shù)和總體百分比,該數(shù)據(jù)集為 305GB,其中 token 數(shù)為 1560 億。

表 3. C4:前 23 個域(不包括維基百科)。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

3、GPT-1 數(shù)據(jù)集

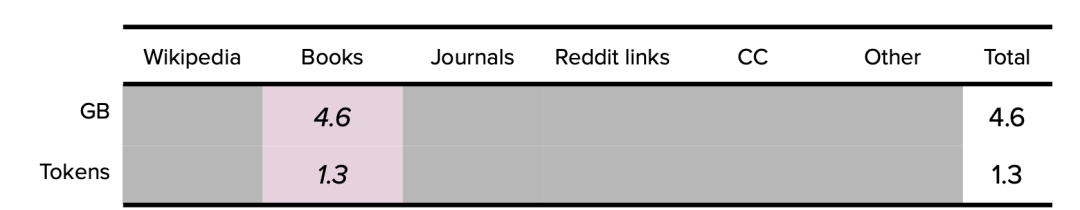

2018 年,OpenAI 發(fā)布了 1.17 億參數(shù)的 GPT-1。在論文中,OpenAI 并沒有公布模型訓(xùn)練數(shù)據(jù)集的來源和內(nèi)容 [10],另外,論文誤將‘BookCorpus’拼寫成了‘BooksCorpus’。BookCorpus 以作家未出版的免費書籍為基礎(chǔ),這些書籍來自于 Smashwords,這是一個自稱為 “世界上最大的獨立電子書分銷商” 的電子書網(wǎng)站。這個數(shù)據(jù)集也被稱為 Toronto BookCorpus。經(jīng)過幾次重構(gòu)之后,BookCorpus 數(shù)據(jù)集的最終大小確定為 4.6GB [11]。

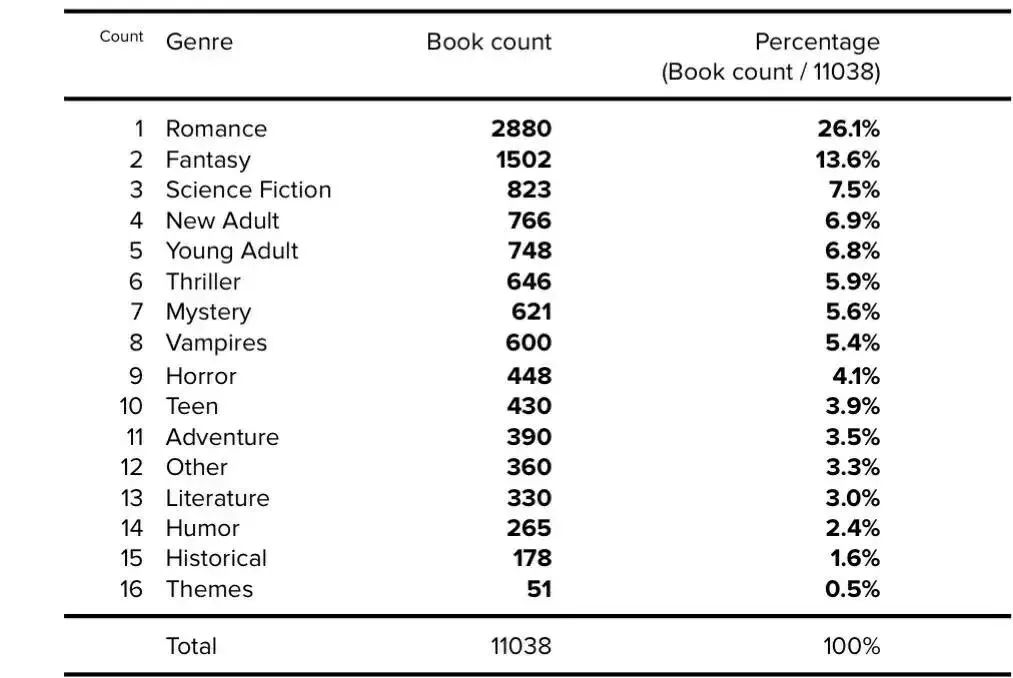

2021 年,經(jīng)過全面的回顧性分析,BookCorpus 數(shù)據(jù)集對按流派分組的書籍?dāng)?shù)量和各類書籍百分比進(jìn)行了更正 [12]。數(shù)據(jù)集中有關(guān)書籍類型的更多詳細(xì)信息如下:

表 4. BookCorpus 書籍類型。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

在隨后的數(shù)據(jù)集重構(gòu)中,BookCorpus 數(shù)據(jù)集進(jìn)一步過濾掉了書籍中的 “吸血鬼” 類別、降低了言情類書籍的百分比、增加了 “歷史” 類書籍,增加了收集的書籍?dāng)?shù)量。

3.1. GPT-1 數(shù)據(jù)集總結(jié)

GPT-1 最終的數(shù)據(jù)集總結(jié)分析如下:

表 5.GPT-1 數(shù)據(jù)集總結(jié)。以 GB 為單位。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

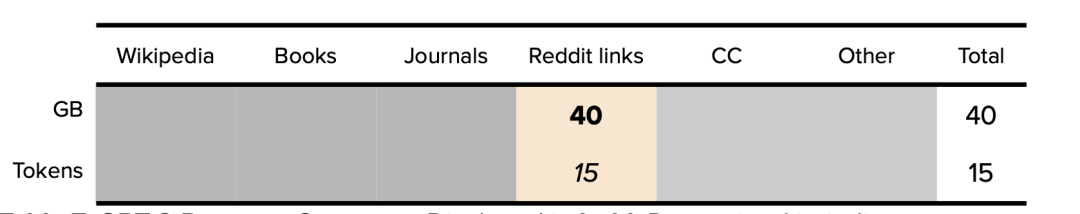

?4、GPT-2 數(shù)據(jù)集

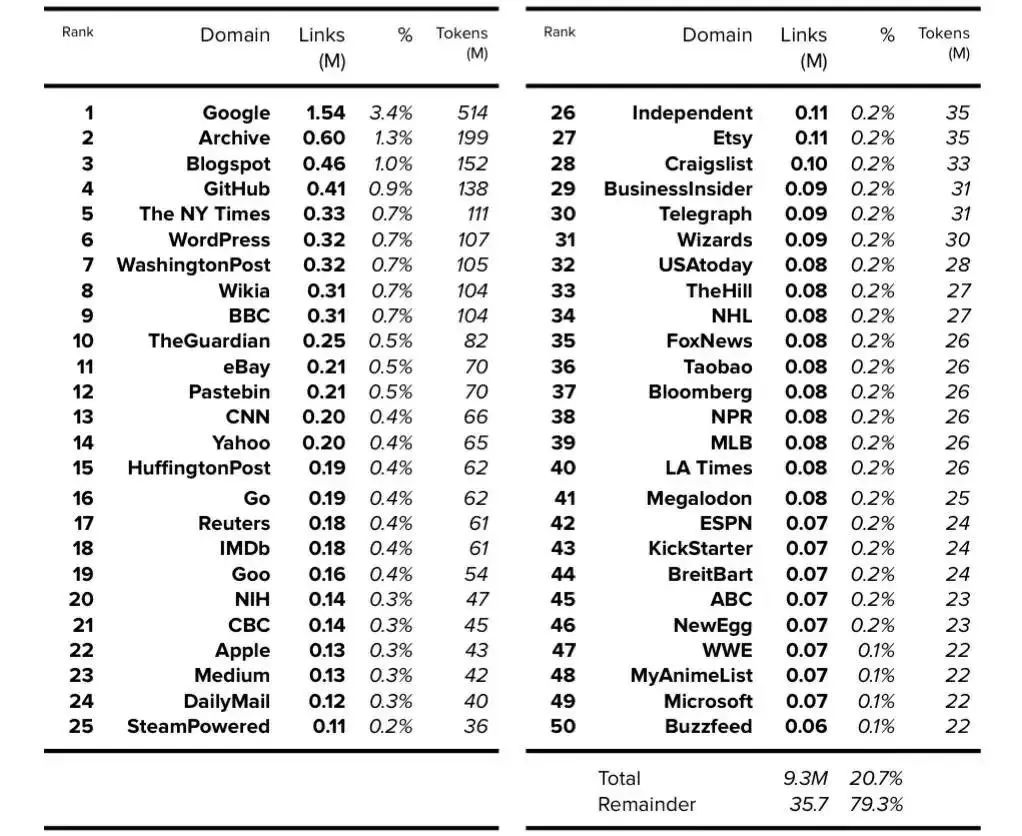

2019 年,OpenAI 發(fā)布了擁有 15 億參數(shù)的語言模型 GPT-2。GPT-2 論文闡明了所用訓(xùn)練數(shù)據(jù)集的大小 [13],不過并未說明其內(nèi)容。而 GPT-2 模型卡(model card)(在 GPT-2 GitHub 倉庫中)說明了模型內(nèi)容 [14]。

我們可以從 GPT-3 論文中得到 token 數(shù)量,該論文使用了 WebText 擴(kuò)展版本來表示 190 億 token。據(jù)推測,2020 年推出的 WebText 擴(kuò)展版本擁有 12 個月的額外數(shù)據(jù)(additional data),因此它可能比 2019 年推出的 GPT-2 版本大 25% 左右 [15]。GPT-2 最終的 token 數(shù)量確定為 150 億左右。

如 GPT-2 論文所述,假設(shè)模型卡顯示鏈接數(shù)時,每個鏈接都可以被 4500 萬鏈接總數(shù)所除,那 WebText 的內(nèi)容在數(shù)據(jù)集中所占的百分比的詳細(xì)信息就可以確定。

然后可以使用確定的 150 億 token 數(shù)量來查找每個域的 token 數(shù)量。請注意,在可用的前 1,000 個域中,此處僅顯示前 50 個域。

表 6. WebText: 前 50 個域。?公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

4.1. GPT-2 數(shù)據(jù)集總結(jié)

GPT-2 模型最終的數(shù)據(jù)集總結(jié)分析如下:

表 7. GPT-2 數(shù)據(jù)集總結(jié)。?公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

5、GPT-3 數(shù)據(jù)集

GPT-3 模型由 OpenAI 于 2020 年發(fā)布。論文闡明了所用訓(xùn)練數(shù)據(jù)集的 token 數(shù)量 [16],但訓(xùn)練數(shù)據(jù)集的內(nèi)容和大小尚不清楚(Common Crawl 的數(shù)據(jù)集大小除外 [17])

表 8. GPT-3 數(shù)據(jù)集。?公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

5.1. GPT-3:關(guān)于 Books1 和 Books2 數(shù)據(jù)集的分析

特別值得關(guān)注的是,在 OpenAI 的 GPT-3 論文中,并未公開 Books1 數(shù)據(jù)集(120 億 token)和 Books2 數(shù)據(jù)集(550 億 token)的大小和來源。關(guān)于這兩個數(shù)據(jù)集的來源人們提出了幾個假設(shè),包括來自 LibGen18 和 Sci-Hub 的類似數(shù)據(jù)集,不過這兩個數(shù)據(jù)集常以 TB 為計,大到無法匹配。

5.2. GPT-3:Books1

GPT-3 使用的 Books1 數(shù)據(jù)集不可能與 GPT-1 使用的 BookCorpus 數(shù)據(jù)集相同,原因在于 Books1 的數(shù)據(jù)集更大,達(dá) 120 億 token。在一篇引用的論文 [19] 中就提及 GPT-1 使用的 BookCorpus 數(shù)據(jù)集擁有 9.848 億個詞,但這可能只相當(dāng)于 13 億 token(984.8 字 x 1.3 字的 token 乘數(shù))。

通過標(biāo)準(zhǔn)化項目古騰堡語料庫(SPGC),Books1 有可能與古騰堡項目保持一致性。SPGC 是一種開放式科學(xué)方法,被用于古騰堡項目完整的 PG 數(shù)據(jù)的精選(curated)版本。SPGC 包含 120 億個 token [20],大約為 21GB [21]。

5.3. GPT-3:Books2

Books2(550 億 token)可能與 Bibliotik 保持一致,并由 EleutherA 收集該來源的數(shù)據(jù),組成數(shù)據(jù)集,使其成為 The Pile v1 的一部分。Bibliotik 版本為 100.96GB [22],其確定的 token 數(shù)僅為 250 億,低于 Books2 公開的 550 億。然而,使用 SPGC 的‘每字節(jié) token 數(shù)’比率(大約為 1:1.75),Bibliotik 的 token 數(shù)和大小將更接近于 Books2。

5.4. GPT-3 數(shù)據(jù)集總結(jié)

附錄 A 概述了使用 Wikipedia + CommonCrawl + WebText 數(shù)據(jù)集的頂級資源列表。GPT-3 模型的最終數(shù)據(jù)集總結(jié)分析如下:

表 9.GPT-3 數(shù)據(jù)集總結(jié)。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

?6、The Pile v1(GPT-J 和 GPT-NeoX-20B)數(shù)據(jù)集

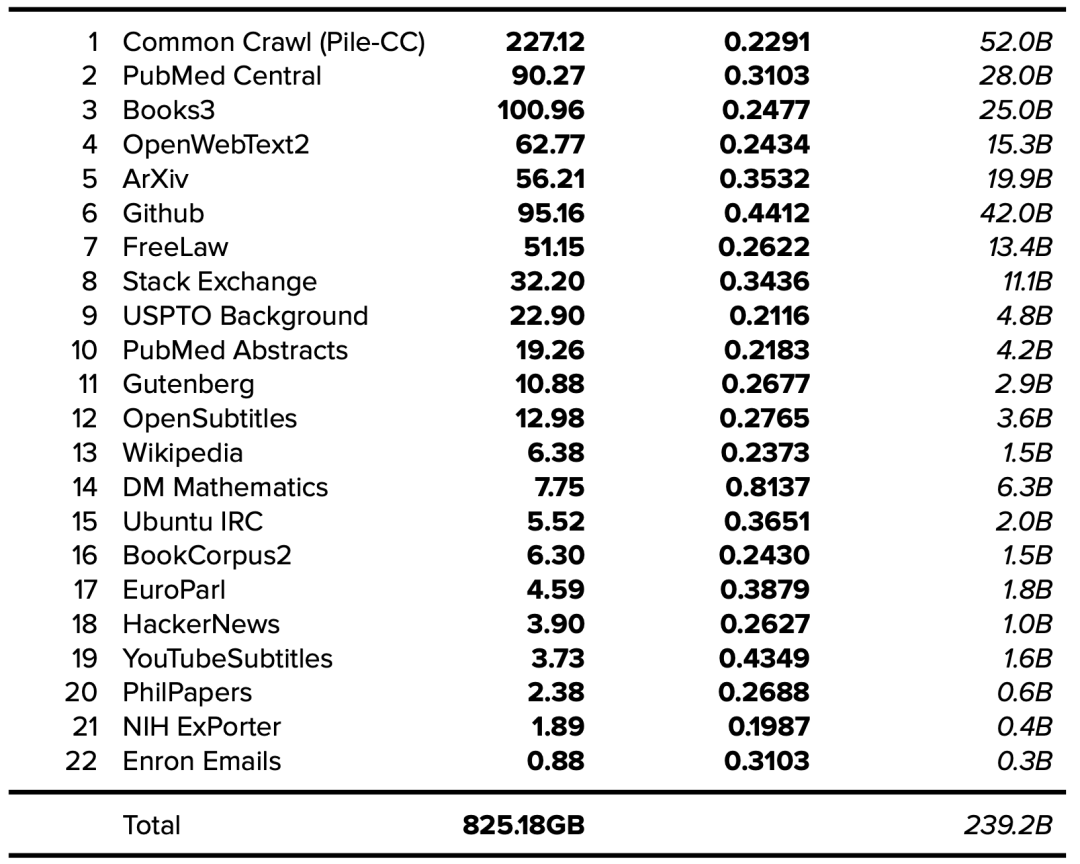

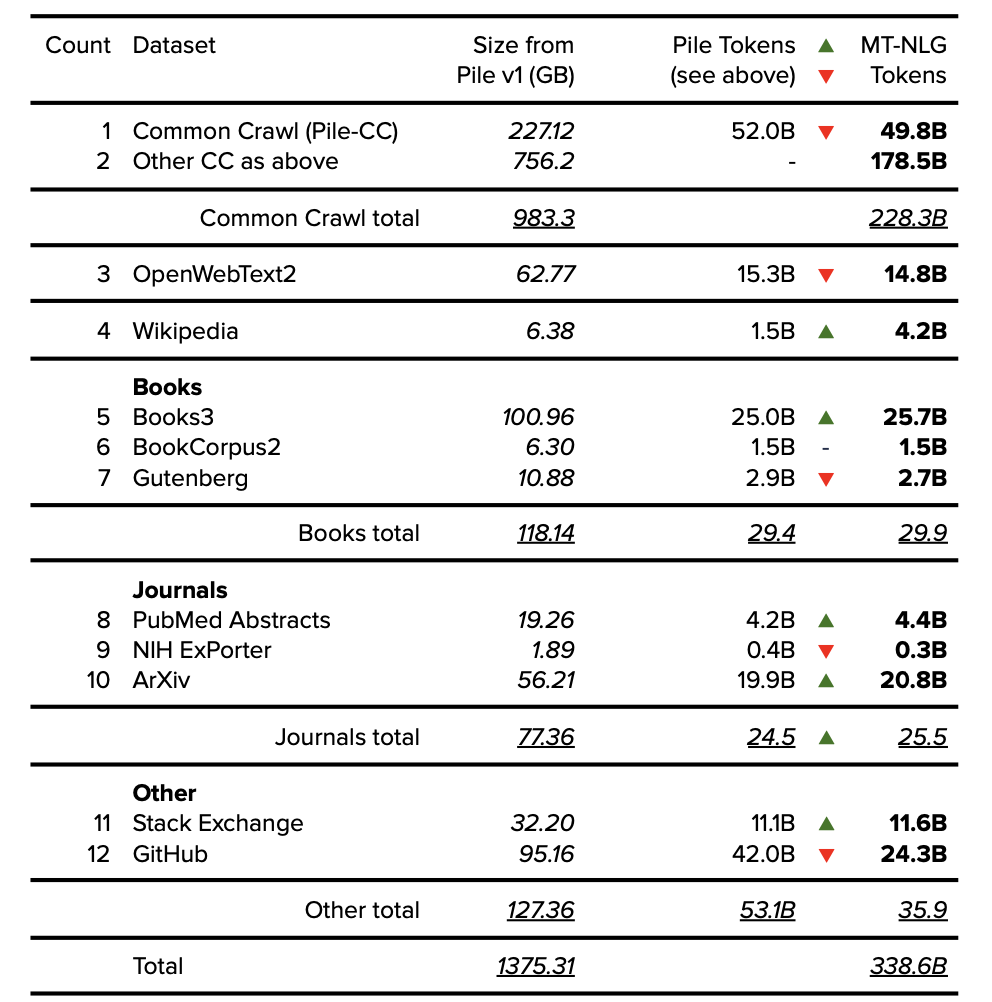

The Pile v1 數(shù)據(jù)集由 EleutherAI 于 2021 年發(fā)布,該數(shù)據(jù)集已被用于訓(xùn)練包括 GPT-J、GPT-NeoX-20B 在內(nèi)的多種模型,并作為包括 MT-NLG 在內(nèi)的其他模型的部分?jǐn)?shù)據(jù)集。The Pile v1 論文闡明了所用訓(xùn)練數(shù)據(jù)集的來源和大小。隨著 token 數(shù)量的增加,The Pile v1 論文應(yīng)被用作未來數(shù)據(jù)集文檔的黃金標(biāo)準(zhǔn)。

有關(guān) token 數(shù)量的更多詳情,可以使用本文提供的信息來確定,參見表 1(大小以 GB 為單位)和表 7(token / 每字節(jié))[23]。

表 10. The Pile v1 數(shù)據(jù)集。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

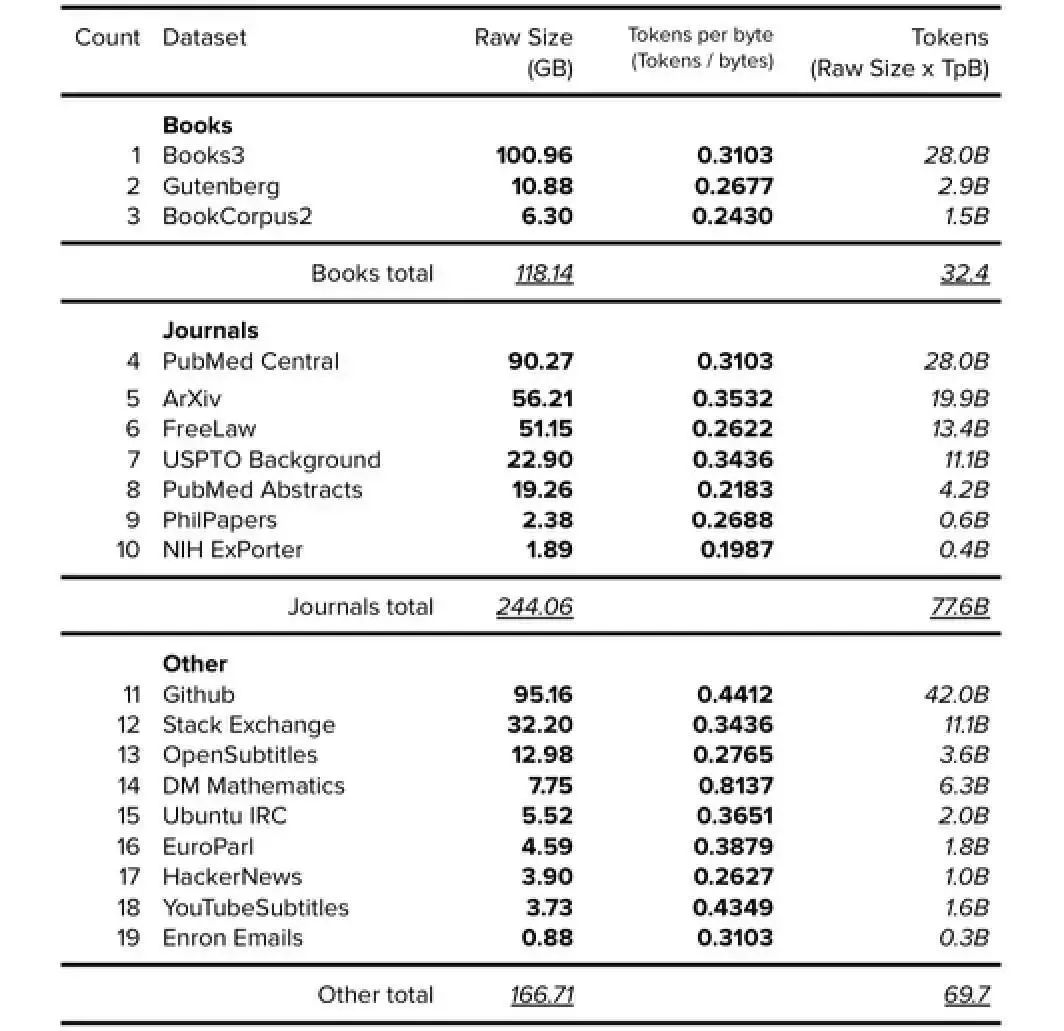

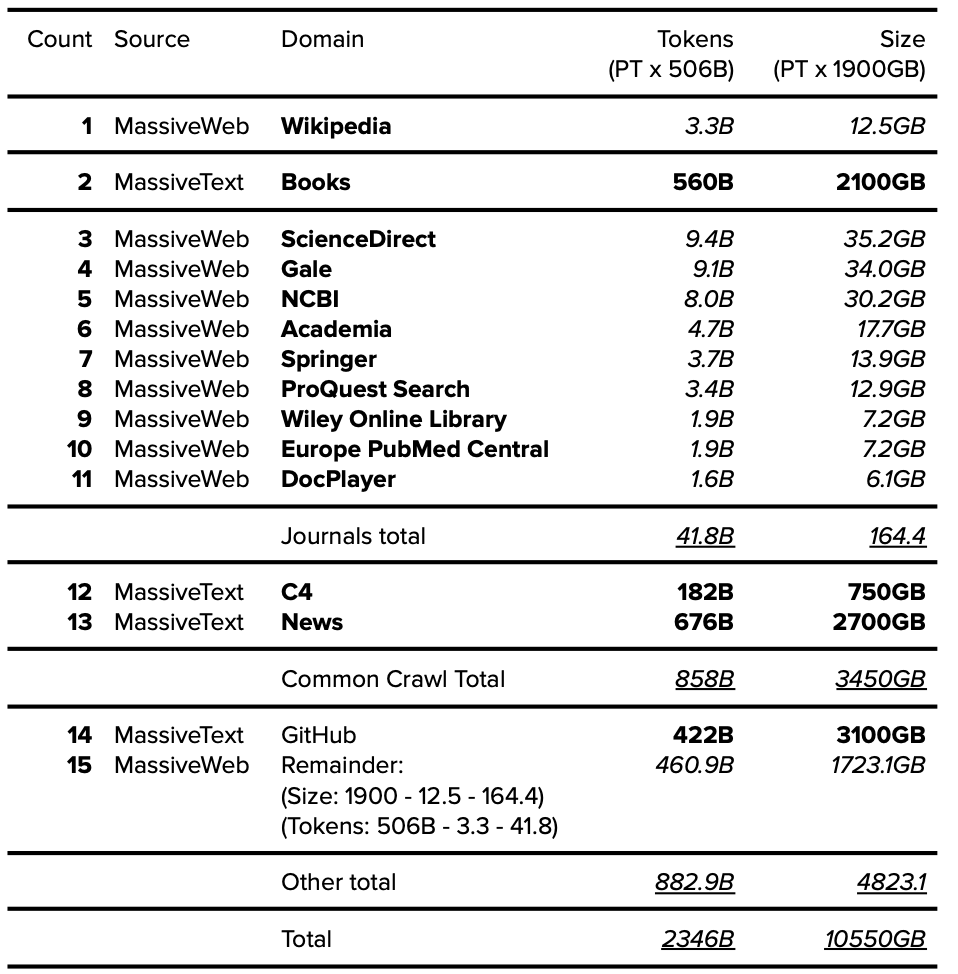

6.1. The Pile v1 分組數(shù)據(jù)集(Grouped Datasets)

為了確定如‘Books’、‘Journals’和‘CC’這類數(shù)據(jù)集的大小,筆者對數(shù)據(jù)集進(jìn)行了分組,如下表所示。

表 11. The Pile v1 分組數(shù)據(jù)集(不包括 Wikipedia、CC 和 WebText)。公開的數(shù)據(jù)以粗體表示,確定的以斜體表示。

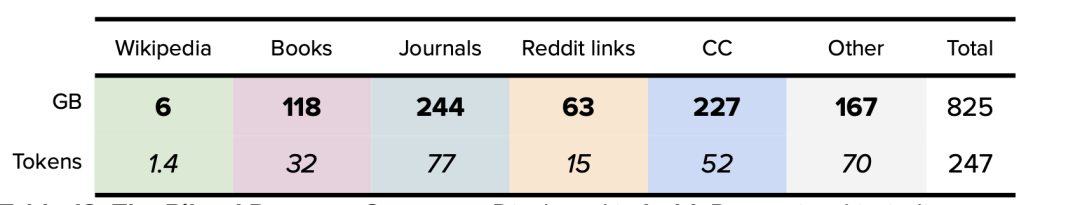

6.2. The Pile v1 數(shù)據(jù)集總結(jié)

The Pile v1 數(shù)據(jù)集與 GPT-J 和 GPT-NeoX-20B 模型的最終數(shù)據(jù)集總結(jié)分析如下:

表 12. Pile v1 數(shù)據(jù)集總結(jié)。?公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

7、Megatron-11B 和 RoBERTa 數(shù)據(jù)集

2019 年,Meta AI (當(dāng)時稱之為 Facebook AI) 和華盛頓大學(xué)聯(lián)合發(fā)布了擁有 1.25 億參數(shù)的 RoBERTa 模型。次年,Meta AI 發(fā)布了擁有 110 億參數(shù)的 Megatron-11B 模型。Megatron-11B 使用的訓(xùn)練數(shù)據(jù)集與 RoBERTa 相同。RoBERTa [24] 論文闡明了所用訓(xùn)練數(shù)據(jù)集的內(nèi)容,不過必須參考引用的論文 (BERT [25] 和 toryes [26]) 來確定最終的數(shù)據(jù)集大小。

BookCorpus?:?確定的數(shù)據(jù)集為 4.6GB,如上面的 GPT-1 部分所示。

維基百科:公開的數(shù)據(jù)集為 “16GB(BookCorpus 加上英文維基百科)”。在減去 BookCorpus 數(shù)據(jù)集(4.6GB,如上面的 GPT-1 部分所述)后,維基百科數(shù)據(jù)集確定為 11.4GB。

CC-News?:(經(jīng)過濾后)公開的數(shù)據(jù)集為 76GB。

OpenWebText?:?公開的數(shù)據(jù)集為 38GB。

Stories?:?公開的數(shù)據(jù)集為 31GB。請注意,此數(shù)據(jù)集是 “基于常識推理任務(wù)問題” 的 Common Crawl 內(nèi)容,不屬于本文的‘Books’類別。相反,將 Stories 與 CC-News 數(shù)據(jù)集(76GB)相結(jié)合,Common Crawl 的總數(shù)據(jù)集則為 107GB。

7.1. Megatron-11B 和 RoBERTa 的數(shù)據(jù)集總結(jié)

Megatron-11B 和 RoBERTa 最終的數(shù)據(jù)集總結(jié)分析如下:

表 13. Megatron-11B 和 RoBERTa 的數(shù)據(jù)集總結(jié)。?公示的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

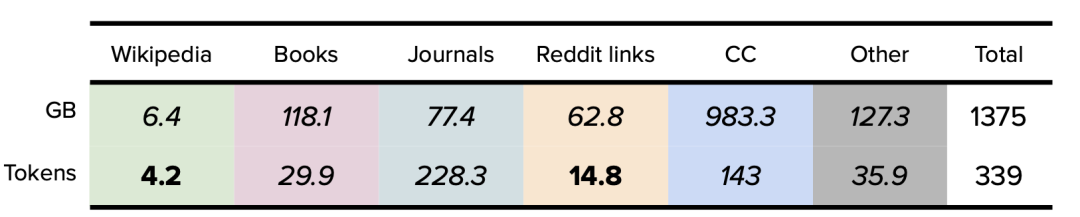

8、MT-NLG 數(shù)據(jù)集

2021 年,英偉達(dá)和微軟發(fā)布了擁有 5300 億參數(shù)的語言模型 MT-NLG。MT-NLG 是微軟 Turing NLG(擁有 170 億參數(shù))和英偉達(dá) Megatron-LM(擁有 83 億參數(shù))的 “繼任者”。MT-NLG 論文闡明了所用訓(xùn)練數(shù)據(jù)集的來源和 token 數(shù)量,不過沒有明確指出數(shù)據(jù)集的大小。

如前所述,有關(guān)數(shù)據(jù)集大小的更多詳情,可以使用 The Pile v1 論文中提供的信息來確定。雖然使用的組件相同,但注意的是,MT-NLG 和 The Pile v1 中報告的組件大小卻各不相同,這是由于來自 Eleuther AI (The Pile v1 數(shù)據(jù)集) 和 Microsoft/NVIDIA (MT-NLG 模型) 的研究人員采用了不同的數(shù)據(jù)過濾和去重方法。

8.1. MT-NLG 中的 Common Crawl 數(shù)據(jù)集

Pile-CC:公開的數(shù)據(jù)集為 498 億 token,確定的數(shù)據(jù)為 227.12GB 左右,參見上述 Pile v1 部分。

CC-2020-50:?公開的數(shù)據(jù)集為 687 億 token,假設(shè) token 的每字節(jié)率(per byte rate)為 0.25 TpB=274.8GB。

CC-2021-04:公開的數(shù)據(jù)集為 826 億 token,假設(shè) token 的每字節(jié)率為 0.25 TpB=330.4GB

RealNews(來自 RoBERTa/Megatron-11B):顯示為 219 億 token。根據(jù) RealNews 論文 [27],數(shù)據(jù)集確定為 120GB。

CC-Stories (來自 RoBERTa/Megatron-11B):公開的數(shù)據(jù)集為 53 億 token,如上述 RoBERTa 部分所示,數(shù)據(jù)集確定為 31GB。

根據(jù)以上來源,可確認(rèn) Common Crawl 的總數(shù)據(jù)量為 983.32GB,共計 2283 億 token。

8.2. MT-NLG 分組數(shù)據(jù)集(Grouped Datasets)

表 14. MT-NLG 分組數(shù)據(jù)集。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

8.3. MT-NLG 數(shù)據(jù)集總結(jié)

MT-NLG 模型最終的數(shù)據(jù)集總結(jié)分析如下:

表 15. MT-NLG 數(shù)據(jù)集總結(jié)。?公示的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

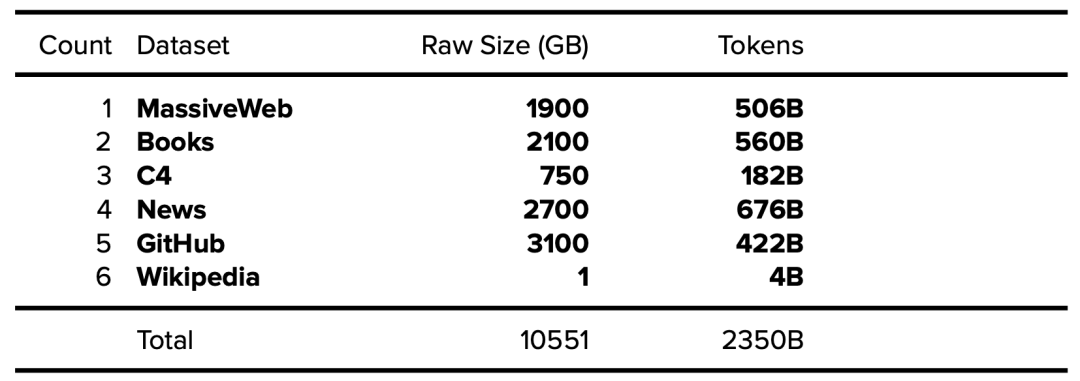

9、MT-NLG 數(shù)據(jù)集?Gopher?數(shù)據(jù)集

Gopher 模型由 DeepMind 于 2021 年發(fā)布,有 2800 億參數(shù)。該論文清楚地說明了所使用訓(xùn)練數(shù)據(jù)集所包含的高級 token 數(shù)量和大小 [28],但沒有說明詳細(xì)內(nèi)容。

表 16. 公開的 Gopher 數(shù)據(jù)集 (MassiveText)。公開的數(shù)據(jù)以粗體表述,確定的數(shù)據(jù)以斜體表示。

有趣的是,據(jù) Gopher 論文披露:其 Books 數(shù)據(jù)集中包含一些超過 500 年歷史(1500-2008)的書籍。

9.1. MassiveWeb 數(shù)據(jù)集分析

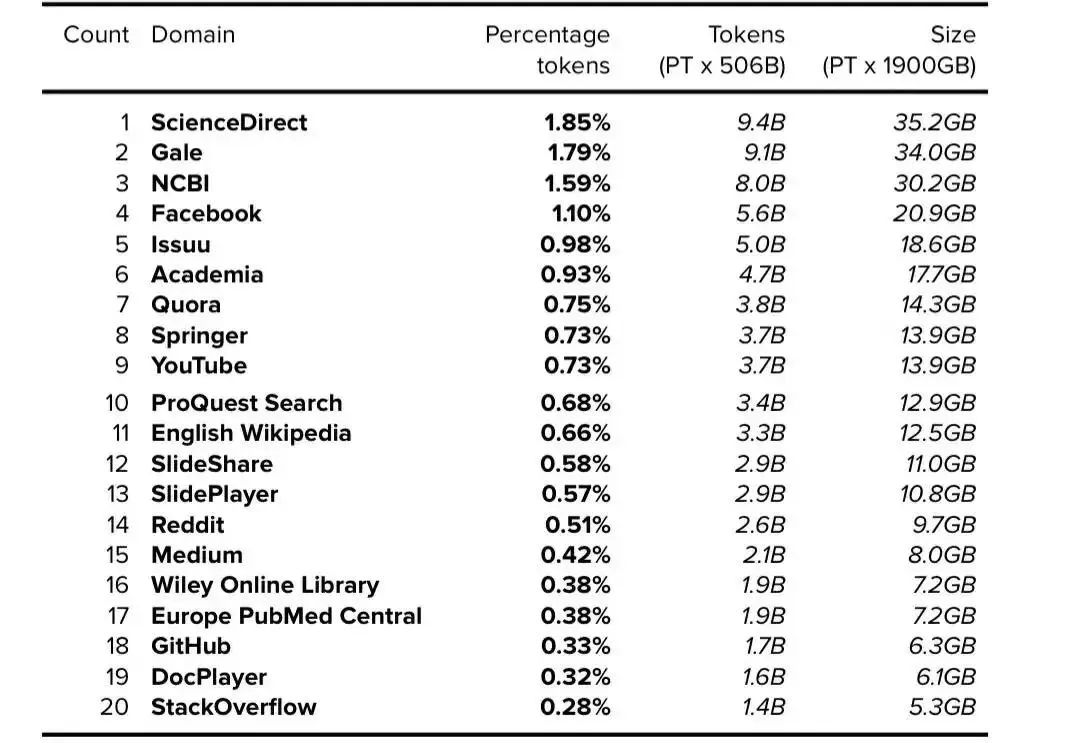

DeepMind 于 2014 年被谷歌收購,并在創(chuàng)建 MassiveText 時獲得了海量數(shù)據(jù)。雖然 Gopher 論文中沒有進(jìn)一步詳細(xì)描述 MassiveWeb,但第 44 頁附錄中的表 A3b 注明了 MassiveWeb 中出現(xiàn)的前 20 個域 [29]。根據(jù)披露的每個域所占的百分比,我們可以使用 MassiveWeb 的總 token 數(shù)(5060 億 token)和總原始大小(1900GB)來確定每個域的 token 數(shù)量和大小。

表 17. MassiveWeb:前 20 個域。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

9.2. Gopher:關(guān)于維基百科數(shù)據(jù)集的分析

維基百科數(shù)據(jù)集的總規(guī)模很難確定。在 Gopher 論文中,研究人員指出維基百科沒有進(jìn)行數(shù)據(jù)去重 [30]。然而,論文中列出的不同大小數(shù)據(jù)集(12.5GB MassiveWeb Wikipedia 與 1GB MassiveText Wikipedia)可能是由于失誤而造成的,誤將 “10GB” 寫成了 “1GB”。無論如何,本文僅使用 MassiveWeb 數(shù)據(jù)集版本 (12.5GB)。

9.3. Gopher: 不包括 WebText

Gopher 數(shù)據(jù)集的組成部分不包括 Reddit 外鏈的 WebText 數(shù)據(jù)集。為了清楚起見,盡管 Reddit 是 MassiveWeb 中的頂級域,但該數(shù)據(jù)集僅抓取 Reddit 域內(nèi)的 Reddit 鏈接。根據(jù)定義,WebText [31] 由 “所有 Reddit 的外鏈” 組成(即指向 Reddit 域外的鏈接)。

9.4. Gopher 分組數(shù)據(jù)集

MassiveWeb 被認(rèn)為是 MassiveText 的子組件,并被集成到 Gopher 的數(shù)據(jù)集匯總中,其分組基于以下列出的可用信息:

表 18. Gopher 分組數(shù)據(jù)集。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

9.5. Gopher 數(shù)據(jù)集總結(jié)

Gopher 是本文中最大的數(shù)據(jù)集,大小為 10.5TB。Gopher 模型的最終數(shù)據(jù)集總結(jié)分析為:

表 19. Gopher 數(shù)據(jù)集總結(jié)。公開的數(shù)據(jù)以粗體表示,確定的數(shù)據(jù)以斜體表示。

10、結(jié)論

對于訓(xùn)練當(dāng)代 Transformer 大型語言模型的數(shù)據(jù)集而言,這可能是最全面的整合分析內(nèi)容(截止 2022 年初)。在主要數(shù)據(jù)源不透明的情況下,本次研究主要從二級和三級來源收集數(shù)據(jù),并經(jīng)常需要假定來確定最終估計值。隨著研究人員要處理千萬億個 token(1,000 萬億)和數(shù)千 TB 的數(shù)據(jù)(1,000TB),確保詳細(xì)披露數(shù)據(jù)集組成的文檔變得越來越重要。

特別值得關(guān)注的是,基于大型語言模型的強(qiáng)大 AI 系統(tǒng)產(chǎn)生的冗長而匿名的輸出正在迅速發(fā)展,其中許多數(shù)據(jù)集的細(xì)節(jié)內(nèi)容幾乎沒有文檔說明。

強(qiáng)烈建議研究人員使用突出顯示的 “數(shù)據(jù)集的數(shù)據(jù)表(Datasheet for Datasets)” 論文中提供的模板,并在記錄數(shù)據(jù)集時使用最佳實踐論文(即 Pile v1 論文,包括 token 數(shù)量)。數(shù)據(jù)集大小(GB)、token 數(shù)量(B)、來源、分組和其他詳細(xì)信息指標(biāo)均應(yīng)完整記錄和發(fā)布。

隨著語言模型不斷發(fā)展并更廣泛地滲透到人們的生活中,確保數(shù)據(jù)集的詳細(xì)信息公開透明、所有人都可訪問且易于理解是有用、緊迫和必要的。

擴(kuò)展閱讀及腳注

考慮到簡潔和可讀性,本文使用了腳注而非文本 / 括弧式引文。主要參考文獻(xiàn)如下,或者參見?http://lifearchitect.ai/papers/,獲取大語言模型領(lǐng)域的主要基礎(chǔ)論文。以下論文按本文順序顯示。

Datasheets for Datasets?Gebru, T., Morgenstern, J., Vecchione, B., Vaughan, J., Wallach, H., Daumé III, H., & Crawford, K. (2018). Datasheets for Datasets.??https://arxiv.org/abs/1803.09010

GPT-1 paper?Radford, A., & Narasimhan, K. (2018). Improving Language Understanding by Generative Pre-Training. OpenAI.??https://cdn.openai.com/research-covers/language-unsupervised/language_understan??ding_paper.pdf

GPT-2 paper?Radford, A., Wu, J., Child, R., Luan, D., Amodei, D. & Sutskever, I. (2019). Language Models are Unsupervised Multitask Learners. OpenAI.??https://cdn.openai.com/better-language-models/language_models_are_unsupervised??_multitask_learners.pdf

GPT-3 paper?Brown, T., Mann, B., Ryder, N., Subbiah, M., Kaplan, J., & Dhariwal, P. et al. (2020). OpenAI. Language Models are Few-Shot Learners.??https://arxiv.org/abs/2005.14165

The Pile v1 paper?Gao, L., Biderman, S., Black, S., Golding, L., Hoppe, T., & Foster, C. et al. (2021). The Pile: An 800GB Dataset of Diverse Text for Language Modeling.

EleutherAI.??https://arxiv.org/abs/2101.00027

GPT-J announcement?Komatsuzak, A., Wang, B. (2021). GPT-J-6B: 6B JAX-Based Transformer.??https://arankomatsuzaki.wordpress.com/2021/06/04/gpt-j/

GPT-NeoX-20B paper?Black, S., Biderman, S., Hallahan, E. et al. (2022). EleutherAI. GPT-NeoX-20B: An Open-Source Autoregressive Language Model.??http://eaidata.bmk.sh/data/GPT_NeoX_20B.pdf

RoBERTa paper?Liu, Y., Ott, M., Goyal, N., Du, J., Joshi, M., & Chen, D. et al. (2019). RoBERTa: A Robustly Optimized BERT Pretraining Approach. Meta AI.??https://arxiv.org/abs/1907.11692

MT-NLG paper?Smith, S., Patwary, M., Norick, B., LeGresley, P., Rajbhandari, S., & Casper, J. et al. (2021). Using DeepSpeed and Megatron to Train Megatron-Turing NLG 530B, A Large-Scale Generative Language Model. Microsoft/NVIDIA.??https://arxiv.org/abs/2201.11990

Gopher paper?Rae, J., Borgeaud, S., Cai, T., Millican, K., Hoffmann, J., & Song, F. et al. (2021). Scaling Language Models: Methods, Analysis & Insights from Training Gopher. DeepMind.??https://arxiv.org/abs/2112.11446

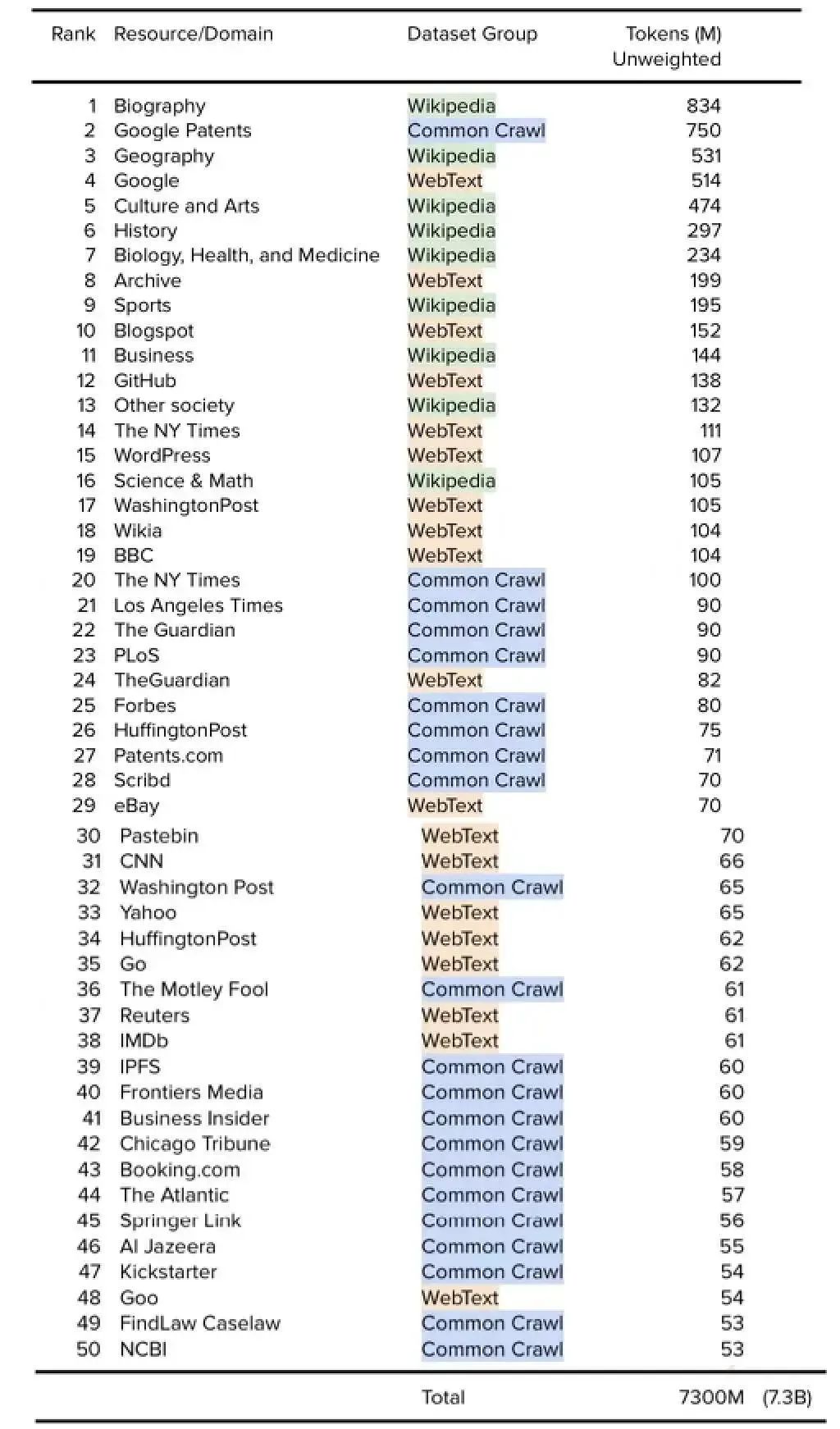

Appendix A: Top 50 Resources: Wikipedia + CC + WebText (i.e. GPT-3)

附錄 A:前 50 個資源:Wikipedia + CC + WebText(即 GPT-3)

基于本文內(nèi)容,尤其是每個數(shù)據(jù)集中每個資源的 token 數(shù)量,我們可以對將 Wikipedia + Common Crawl + WebText 數(shù)據(jù)集的組合,作為其整體訓(xùn)練數(shù)據(jù)集的一部分模型進(jìn)行資源或域的排序。為清楚起見,這包括以下模型:OpenAI GPT-3、EleutherAI GPT-J、EleutherAI GPT-NeoX-20B、Meta AI Megatron-11B 和 RoBERTA,以及 Microsoft/NVIDIA MT-NLG 等。

請注意,展示的排名基于數(shù)據(jù)集中可用的未加權(quán)總 token,每個數(shù)據(jù)集的主觀權(quán)重由研究人員在模型預(yù)訓(xùn)練之前計算得出。其中有一些重復(fù)(例如,《紐約時報》既出現(xiàn)在有 1.11 億 token 的 WebText 中,也出現(xiàn)在過濾后有 1 億 token 的 Common Crawl 中)。

腳注

1.?GPT-NeoX-20B paper: pp11, section 6??http://eaidata.bmk.sh/data/GPT_NeoX_20B.pdf

2.?Datasheet for Datasets paper:??https://arxiv.org/abs/1803.09010

3.?OpenAI blog:??https://openai.com/blog/gpt-3-apps/

4.?On the Opportunities and Risks of Foundation Models:??https://arxiv.org/abs/2108.07258

5.?Size of Wikipedia:??https://en.wikipedia.org/wiki/Wikipedia:Size_of_Wikipedia

6.?C4 dataset:??https://www.tensorflow.org/datasets/catalog/c4

7.?Common Crawl website:??https://commoncrawl.org/

8.?C4 paper:??https://arxiv.org/abs/2104.08758??pp2, Figure 1 right

9.?Wikipedia categories:??https://en.wikipedia.org/wiki/User:Smallbones/1000_random_results?: “維基百科涵蓋哪些主題?覆蓋范圍是否隨時間變化?使用 2015 年 12 月抽取的 1001 篇隨機(jī)文章對這些問題和類似問題進(jìn)行了查驗... 隨著時間推移,這些比例相當(dāng)穩(wěn)定... 傳記(27.8%),地理(17.7%),文化和藝術(shù)(15.8%),歷史(9.9%),生物學(xué)、健康和醫(yī)學(xué)(7.8%),體育(6.5%),商業(yè)(4.8%),其他社會(4.4%),科學(xué)與數(shù)學(xué)(3.5%),教育(1.8%)。”

10.?GPT-1 paper: pp4 “We use the BooksCorpus dataset for training the language model.”

11.??https://huggingface.co/datasets/bookcorpus?: “Size of the generated dataset: 4629.00 MB”

12.?BookCorpus Retrospective Datasheet paper: pp9??https://arxiv.org/abs/2105.05241

13. GPT-2 paper: pp3 “我們從社交媒體平臺 Reddit 中抓取了至少有 3 個 karma 的所有出站鏈接。這可以被認(rèn)為是一個啟發(fā)式指標(biāo),用于判斷其他用戶是否覺得該鏈接有趣、有教育意義或只是有趣……WebText 包含這 4500 萬個鏈接的文本子集…… 其中不包括 2017 年 12 月之后創(chuàng)建的鏈接。經(jīng)過去重和一些基于啟發(fā)式的清理后,其中包含大約超過 800 萬個文檔,總共 40GB 文本。我們從 WebText 中移除了所有維基百科文檔...”

14.?GPT-2 model card:??https://github.com/openai/gpt-2/blob/master/model_card.md?: “我們已經(jīng)發(fā)布了 WebText 中出現(xiàn)的前 1,000 個域及其頻率的列表。WebText 中排名前 15 位的域是:Google、Archive、Blogspot、GitHub、紐約時報、Wordpress、華盛頓郵報、維基亞、BBC、衛(wèi)報、eBay、Pastebin、CNN、雅虎和赫芬頓郵報。”

15. GPT-3 paper: “WebText2:190 億 token。[Alan:WebText2 是從 WebText 稍微擴(kuò)展而來,所以我們可以減去 20%,得到 150 億 token]”

16.?GPT-2 paper: pp3 “GPT-3: pp9, Table 2.2 “CC: 4100 億 token. WebText2: 190 億 token. Books1: 120 億 token. Books2: 550 億 token. Wiki: 30 億 token”

17.?GPT-3 paper: pp8

18.?BookCorpus repo:??soskek/bookcorpus#27?: “books3.tar.gz 似乎類似于 OpenAI 在他們的論文中引用的神秘 “books2” 數(shù)據(jù)集。不幸的是,OpenAI 不會提供細(xì)節(jié),所以我們對其差異知之甚少。人們懷疑它是 “l(fā)ibgen 的全部”,但這純粹是猜測。盡管如此,books3 仍是 “所有的 bibliotik”......”

19.?BookCorpus paper:??https://arxiv.org/abs/1506.06724?: “# of words: 984,846,357 [Alan: BookCorpus 有 13 億 token。我們想要有 120-550 億 token]”

20.?Gutenberg paper:??https://arxiv.org/abs/1812.08092?: “我們介紹了標(biāo)準(zhǔn)化項目古騰堡語料庫(SPGC),這是一種開放的科學(xué)方法,用于處理完整 PG 數(shù)據(jù)的精選版本,其中包含超過 50,000 本書和 3×109word-token [Alan:相當(dāng)于大約 120 億 BPE token,見下文]”

21.?Gutenberg repo:??https://zenodo.org/record/2422561??“未壓縮大小:3GB(count)+ 18GB(token)[總計 21GB]”

22. The Pile v1 paper: “Books3(Bibliotik tracker):100.96GB” [Alan:乘以每字節(jié) token 數(shù) 0.2477 = 250 億 token]

23.?The Pile v1 paper: pp3, Table 1 for datasets. pp28, Table 7 for Tokens per byte.

24.?RoBERTa paper:??https://arxiv.org/abs/1907.11692??“BOOKCORPUS 加上英文 WIKIPEDIA。這是用來訓(xùn)練 BERT 的原始數(shù)據(jù)。(16GB)。”

25.?BERT paper:??https://arxiv.org/abs/1810.04805??“BERT 在 BooksCorpus(8 億字)和維基百科(25 億字)上進(jìn)行訓(xùn)練。”

26.?Stories paper:??https://arxiv.org/abs/1806.02847??pp5-6

27.?RealNews paper:??https://arxiv.org/abs/1905.12616v3??“去重后,RealNews 在沒有壓縮的情況下為 120GB。”

28.?Gopher paper:??https://arxiv.org/abs/2112.11446??pp 7: list of sizes and tokens.

29.?Gopher paper:??https://arxiv.org/abs/2112.11446??pp 44, Figure A3b.

30.?Gopher paper: pp41n14 “請注意,我們將文檔去重應(yīng)用于除 Wikipedia 和 GitHub 之外的所有 MassiveText 子集 “

31.?GPT-2 paper, pp3.

關(guān)于作者

Alan D. Thompson 博士是人工智能專家、顧問。在 2021 年 8 月的世界人才大會(World Gifted Conference)上,Alan 與 Leta(由 GPT-3 提供支持的 AI)共同舉辦了一場名為 “The new irrelevance of intelligence” 的研討會。他的應(yīng)用型人工智能研究和可視化成果受到了國際主要媒體的報道,同時還在 2021 年 12 月牛津大學(xué)有關(guān) AI 倫理的辯論中被引用。他曾擔(dān)任門薩國際(Mensa International)主席、通用電氣(GE)和華納兄弟(Warner Bros)顧問,也曾是電氣與電子工程師協(xié)會(IEEE)和英國工程技術(shù)學(xué)會(IET)會員。

?

編輯:黃飛

?

電子發(fā)燒友App

電子發(fā)燒友App

評論