ChatGPT火熱的背后。

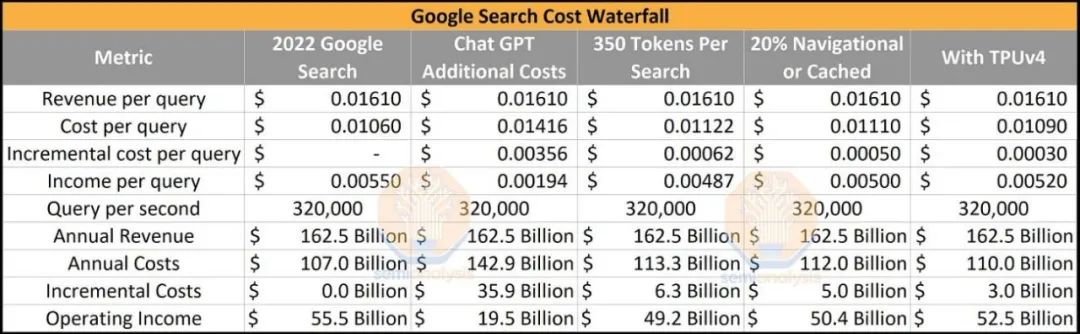

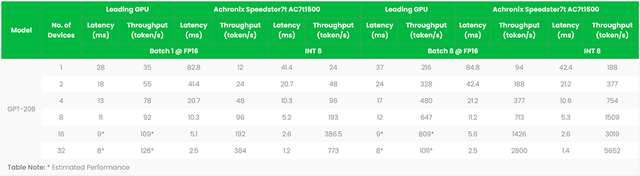

ChatGPT目前每天花費約 700,000 美元來運行硬件推理成本。如果ChatGPT的當前實施和運營被投入到每一個谷歌搜索中,這將意味著成本結構的巨大增加,達到360億美元。谷歌服務業務部門的年凈收入將從 2022 年的 555 億美元下降至 195 億美元。

當然,這永遠不會發生,但是如果我們假設沒有進行任何軟件或硬件改進,那就是有趣的思想實驗。

第一輪優化很簡單。Bing GPT 的 84 個不同真實示例的令牌輸出計數明顯較低,約為 350,而 ChatGPT 則為 2,000。在大多數情況下,人們希望在與搜索交互時避免閱讀大量信息。此估算考慮了未向用戶顯示的令牌。后續的優化是前2000個關鍵詞占搜索量的12.2%,更多的也是純導航搜索。假設 20% 的搜索不需要 LLM。最后,與使用基于英偉達的 HGX A100 的 Microsoft/OpenAI 相比,谷歌使用內部 TPUv4 pod 具有顯著的基礎設施優勢。

這些簡單的優化使 Google 在搜索中實施 LLM 的額外成本僅為 30 億美元。如果一切從一開始就完美設置,Google 僅在硬件上的資本支出成本就約為200億美元,包括數據中心基礎設施。這是在Nvidia H100 和 Google 的 TPUv5 等新硬件或MoE、稀疏性、修剪、模型蒸餾、kv 緩存和提前退出等各種技術提高成本之前。

人們不會接受連接到互聯網的 ChatGPT 的接口,速度太慢,容易編造信息,無法有效變現。上面的分析仍然過于簡單,僅在搜索堆棧的一部分(實時查詢處理)中說明了LLM?。

今天,我們將深入探討 LLM 在整個搜索堆棧中的未來實現。由于用戶體驗的變化,單位收入經濟和成本結構將完全重新設計,這將在未來 2 到 3 年內迅速改變。

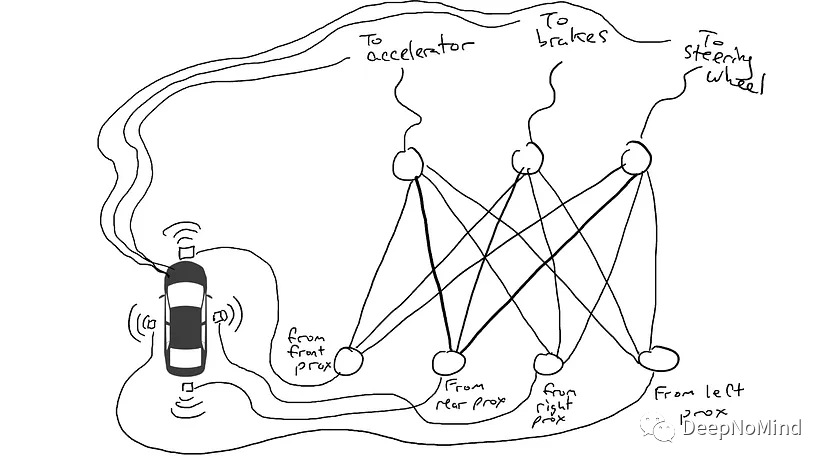

要從收入和成本的角度更深入地了解變化,我們首先必須解釋當前的搜索架構,因為它為未來的變化提供了背景。從較高的層面來看,搜索的目標是盡快提供相關信息。輸入關鍵字時,你希望將最佳信息提升到頂部。搜索管道有四個主要進程:爬蟲、索引、查詢處理器和廣告引擎。機器學習模型已經在這四個領域得到廣泛應用。

履帶式

爬蟲自動定位互聯網上的新內容,包括網頁、圖像和視頻,并將其添加到搜索引擎的數據庫(索引)中。通過利用機器學習,爬蟲確定要索引的頁面的價值并識別重復內容。它還分析頁面之間的鏈接,評估哪些頁面可能相關且重要。此信息用于優化抓取過程,確定抓取哪些頁面、頻率和程度。

爬蟲在內容提取中也起著重要作用。目標是全面文本化網頁包含的內容,同時最小化該數據的總大小以支持快速準確的搜索。延遲就是搜索的重中之重的問題,即使是幾百毫秒也會顯著影響用戶的搜索量。

谷歌和必應利用圖像和小型語言模型來生成頁面/圖像/視頻本身不存在的元數據。大型語言和多模式模型的明顯插入點是大規模擴展這些功能。在任何簡單的搜索成本模型中都沒有考慮到這一點。

索引

索引是一個數據庫,用于存儲爬蟲發現的信息。在索引層中進行了大量預處理,以最大限度地減少必須搜索的數據量。這最大限度地減少了延遲并最大限度地提高了搜索相關性。

相關性排名:模型可用于根據相關性對索引中的頁面進行排名,以便首先返回最相關的頁面以響應用戶的搜索查詢。

聚類:模型可用于將索引中相似的頁面分組為聚類,使用戶更容易找到相關信息。

異常檢測:模型可以檢測并從索引中刪除異常或垃圾頁面,從而提高搜索結果的質量。

文本分類:模型可用于根據內容和上下文對索引中的頁面進行分類。

主題建模:模型可以識別索引頁面涵蓋的主題,并將每一頁映射到一個或多個主題。

雖然目前這是通過較小的模型和 DLRM 完成的,但如果插入 LLM,效率將顯著提高。在任何簡單的搜索成本模型中都沒有考慮到這一點。我們將在本報告稍后部分討論用例并估算成本。

查詢處理器

這是搜索堆棧中最受關注的層。它接收用戶的查詢并生成最相關的結果。它通過解析用戶的查詢,將其分解為關鍵字和短語,從索引中獲取最相關的項目,然后針對該用戶的特定查詢重新排序和過濾來實現這一點。查詢處理器還負責將這些結果呈現給用戶。

目前有多種模型部署在這個管道中,從簡單的拼寫檢查到查詢擴展,自動將相關術語添加到用戶的查詢中以提高搜索結果的準確性。基于用戶的搜索歷史、位置、設備、偏好和興趣的相關性排名和個性化結果。這目前需要在多個小模型上運行推理。

當用戶實時提交查詢時,必須快速有效地執行查詢處理。相比之下,抓取和索引是持續發生的過程,不與用戶交互。

順便說一句,谷歌和必應在這里使用非常不同的硬件來實現他們的經典方法。谷歌使用了大量標準 CPU 和內部 TPU。另一方面,必應目前使用許多標準 CPU 和FPGA 。

廣告引擎

雖然搜索堆棧的最后三個部分對于滿足和留住用戶至關重要,但許多人認為廣告引擎最重要,因為所有盈利都源于其質量。查詢處理器與廣告引擎實時交互。廣告引擎必須對用戶查詢、用戶配置文件、位置和廣告效果之間的關系進行建模,以便為每個用戶生成個性化推薦,從而最大限度地提高點擊率和收入。

廣告市場是一個實時競價的比賽,廣告商通常為關鍵字、詞組或某些用戶類型付費。廣告模型松散地使用這些作為指導,因為支付的金額不是服務的唯一指標。該模型需要優化轉換以賺取收入并提高利率,因此相關性是超優化參數。

平均而言,在過去四年中,80% 的 Google 搜索都沒有在搜索結果頂部顯示任何廣告。此外,目前只有一小部分搜索(不到 5%)有四個最熱門的文字廣告。

使用 LLM,消費者閱讀的部分不是廣告可以轉化為廣告商銷售的前幾個結果。相反,它是 LLM 的輸出。因此,這是隨著對話式 LLM 的出現而發生最大變化的搜索堆棧的一部分。我們將在本報告后面部分討論貨幣化的方式和情況,因為這是廣告服務運作方式的根本轉變。

激進的轉變

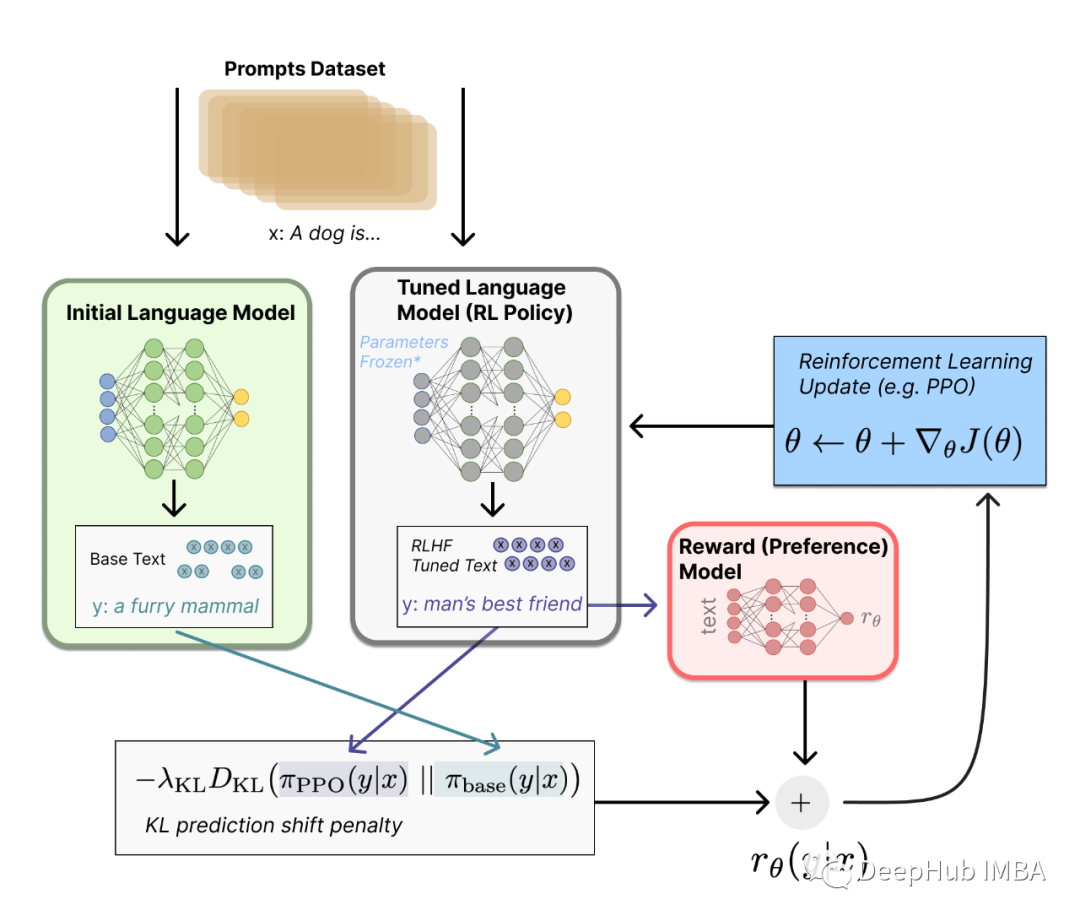

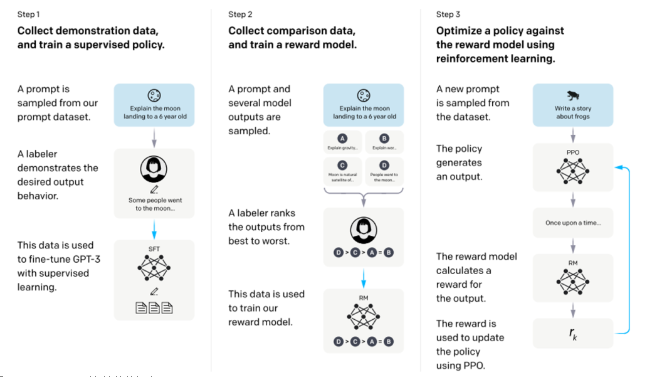

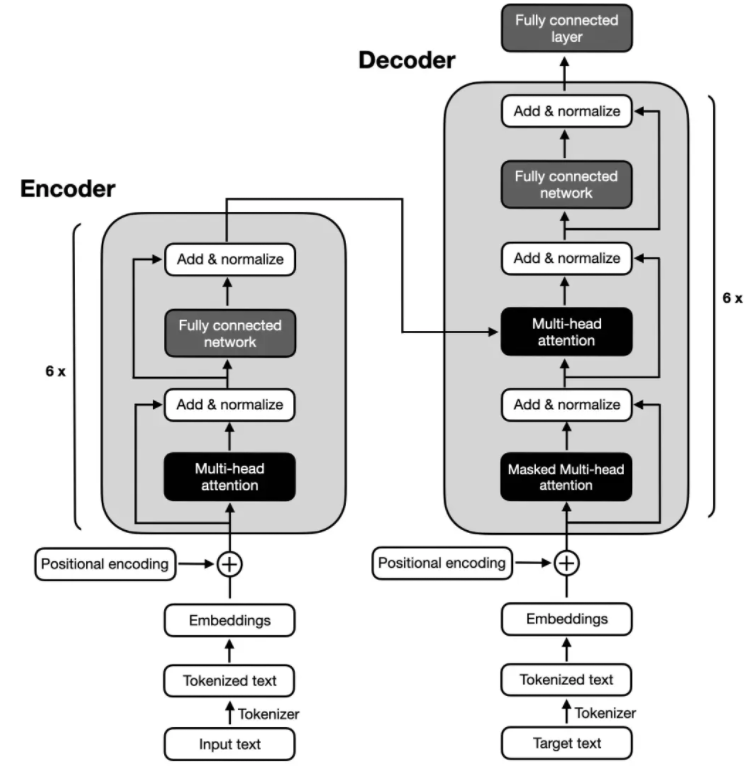

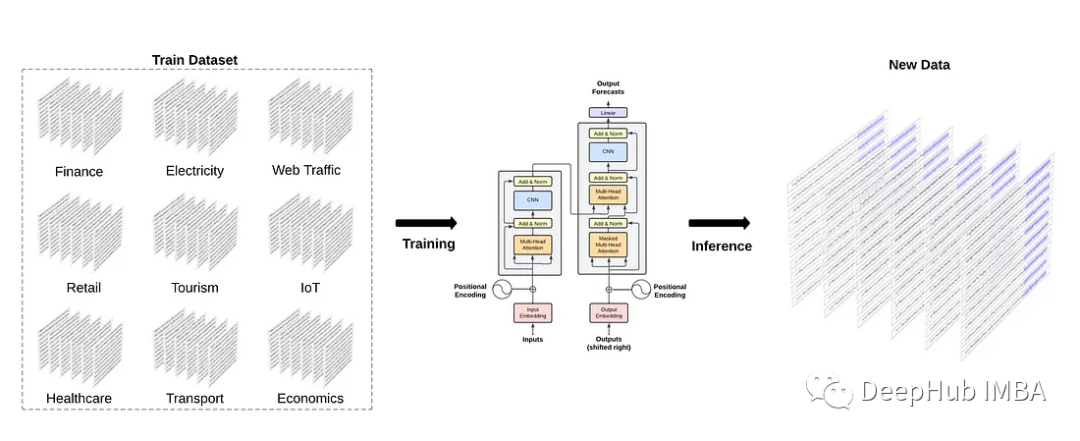

搜索中的LLM不僅僅是加入搜索引擎界面的一個大模型。相反,它是許多模型交織在一起的。每個模型的工作是為鏈中的下一個模型提供最密集和最相關的信息。這些模型必須不斷地在活躍用戶身上重新訓練、調整和測試。谷歌歷來率先在搜索堆棧的所有四個層中使用人工智能,但現在,搜索正在用戶體驗、使用模型和貨幣化結構方面發生根本性轉變,這可能會使軟件堆棧的許多現有部分失效。

最大的問題是谷歌是否準備好完成這項任務。他們能否調整整個搜索堆棧?

在弄清楚使用模型之前,谷歌是否有要求來超級優化其搜索堆棧?假設谷歌將太多資源投入到以最低成本運營并達到搜索相關性的局部最大值。在那種情況下,谷歌可能會限制其本應致力于擴展和測試新使用模型的模型開發和創新。如果是微軟和 OpenAI 團隊的話,更有可能將謹慎拋在一邊,并對搜索堆棧的所有四個元素進行徹底重組。

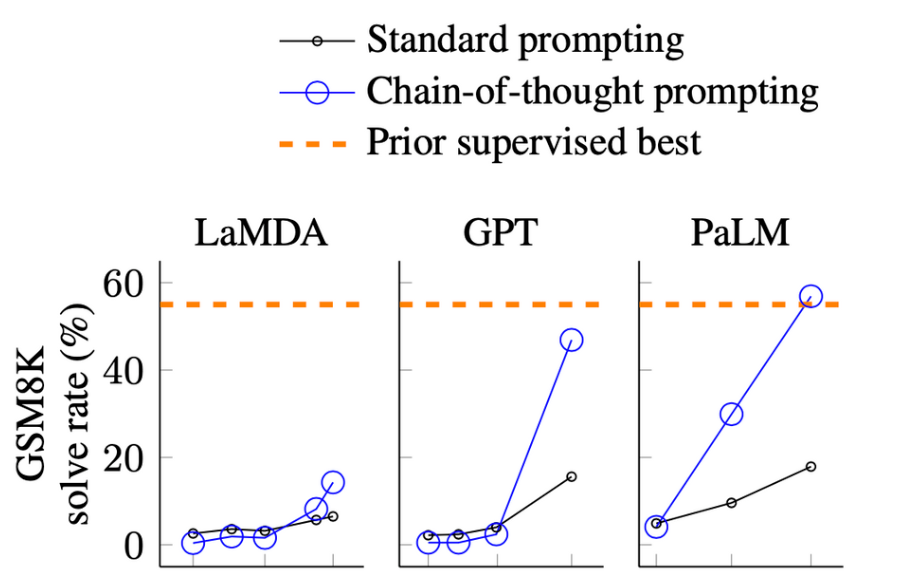

我們最初將與 LaMDA 的輕量級模型版本一起發布。這個小得多的模型需要更少的計算能力,使我們能夠擴展到更多的用戶,從而獲得更多的反饋。

他們正在削減一個模型,其架構最初是在 2021 年初開發的。當然,此后它有所改進,但 OpenAI 和微軟正在使用一個更大的模型和更新的架構,這些模型是在 2022 年底和 2023 年初開發的,并得到了 ChatGPT 的持續反饋。這是有正當理由的,但也正是這個原因可能會讓谷歌在用戶體驗和迭代速度方面受到重創。

更令人擔憂的是,在過去的幾個月里,一些有遠見的人才最近開始涌向初創公司,包括但不限于 OpenAI。這包括 BERT 的教父、PaLM 推理的首席工程師和 Jax 的首席工程師。這可能是文化弱化的跡象。

想象一下,如果這場搜索競爭導致谷歌的股票繼續下跌,而 RSU 的價值遠低于預期。這對員工的士氣和保留有什么影響?

或者,由于必應爭奪市場份額并競標 Google 目前擁有的 Apple 獨家交易,搜索不再是無窮無盡的搖錢樹怎么樣?谷歌是否必須對虧損的業務(包括谷歌云)勒緊褲腰帶?

延遲

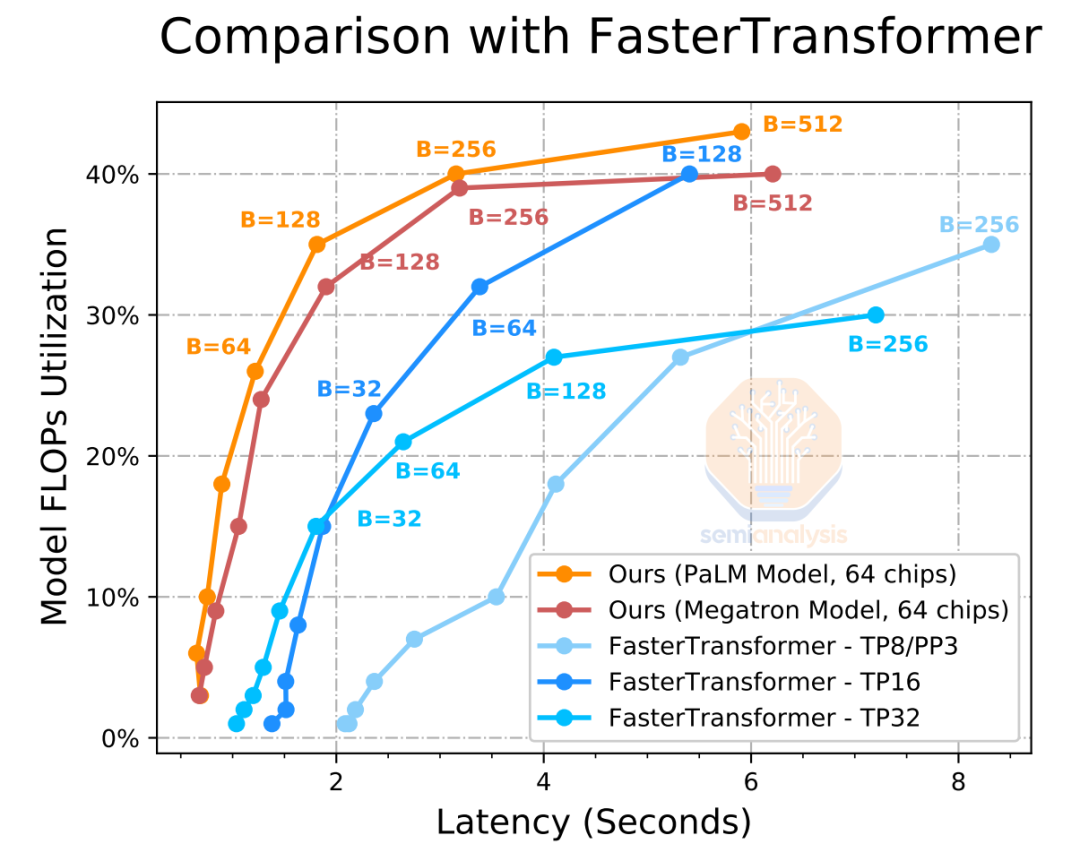

Google 的 Bard 是一個較小的模型,具有較低的延遲響應時間。谷歌內部有一個非常優越的 PaLM 模型,但無力部署它。

即使延遲為 2,000 毫秒,是常規搜索的 4 倍,PaLM 也只能采用 60 個輸入令牌(約 240 個字符)并輸出 20 個令牌(80 個字符),這就是在 64 個 TPUv4 上并行時,始終只能實現大約35% 的利用率。

重要的是,大型 LLM 需要在搜索堆棧的非時間敏感部分使用。此外,更大的批量大小可以在堆棧的這些部分實現更高的利用率,盡管延遲更高。

語境為王

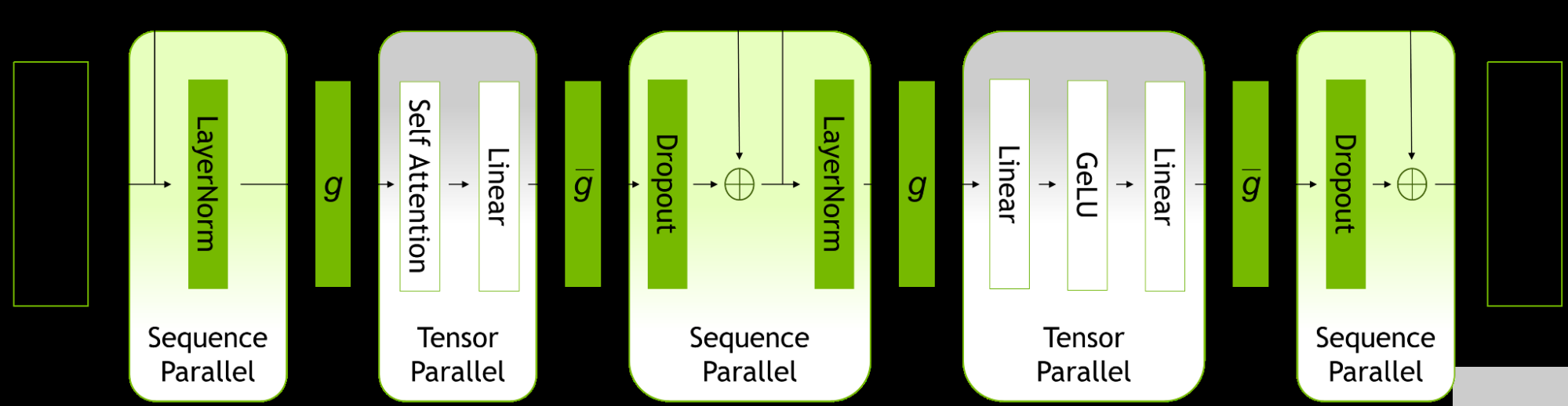

面向用戶的模型和未來 AI 芯片的關鍵是增加它們的上下文窗口,以便可以通過層向前饋送更多先前的模型或源材料。就推理成本而言,縮放序列長度的成本也非常高,這將使你的成本結構膨脹。

因此,在實時方面將圍繞此進行許多優化。在爬行和索引階段,你可以最大化上下文窗口,以盡可能多地將源材料密集化到盡可能高的質量標準。

這樣就可以在堆棧的實時查詢部分啟用更小的模型,以最大限度地減少搜索和上下文窗口的數量,從而減少延遲并縮短響應時間。

整個搜索堆棧中的 LLM 實現

看看微軟如何以相同的方式應用這些技術作為某些高級企業搜索和對話式 AI 助手的一部分,掃描過去 30 年中的每個文檔、電子郵件、Excel 工作表、PDF 和即時消息,這也將很有趣。當然,谷歌仍然擁有其 Android、YouTube、地圖、購物、航班和照片等模塊,在這些領域微軟幾乎無法與之競爭,因此無論發生什么情況,這些模塊都可以讓谷歌在搜索領域保持領先地位。

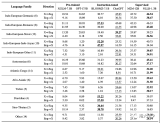

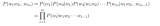

現在,我們將描述我們如何在運營和基礎設施層面設想新的搜索堆棧。我們將通過堆棧逐個類別地描述五種不同類型的 LLM 的用途及其跨搜索堆棧、爬蟲、索引、查詢處理器和廣告引擎的四個不同層的推理成本結構。這些成本結構將仿照 OpenAI 和微軟將使用的 Nvidia HGX A100 / H100,以及谷歌內部的 TPUv4 / TPUv5。從使用模型的角度來看,廣告引擎的變化可能是最有意義的。

編輯:黃飛

?

電子發燒友App

電子發燒友App

評論