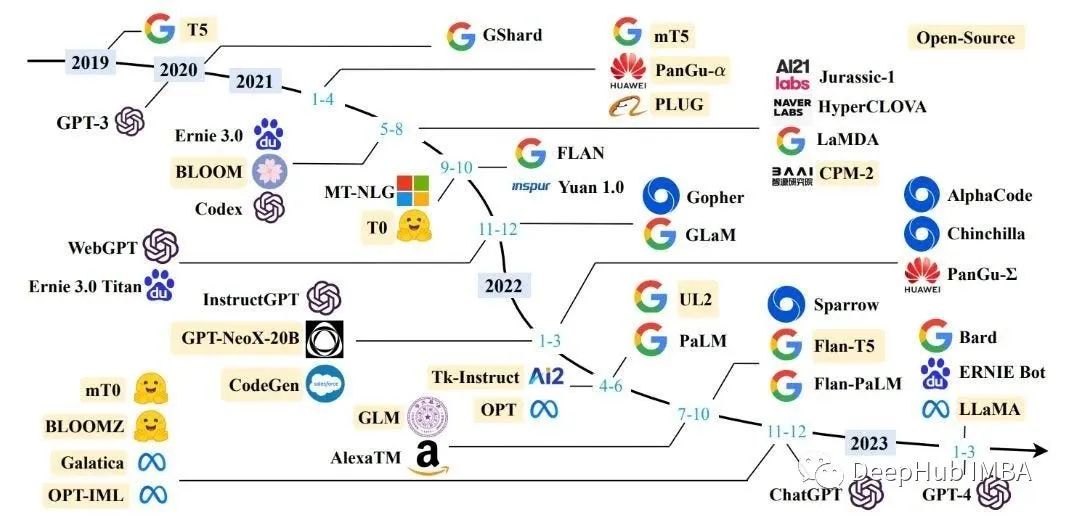

近年來,像 GPT-4 這樣的大型語言模型 (LLM) 因其在自然語言理解和生成方面的驚人能力而受到廣泛關注。但是,要根據特定任務或領域定制LLM,定制培訓是必要的。本文提供了有關自定義訓練 LLM 的詳細分步指南,其中包含代碼示例和示例。

先決條件

在深入研究之前,請確保您已:

訪問預先訓練的 GPT-4 模型。

足夠的計算資源(GPU 或 TPU)。

用于微調的特定域或任務中的數據集。

步驟 1:準備數據集

要微調LLM,您需要一個與目標域或任務一致的數據集。數據準備涉及:

1.1 收集或創建數據集

確保您的數據集足夠大,以涵蓋域或任務中的變體。數據集可以是原始文本或結構化數據的形式,具體取決于您的需求。

1.2 預處理和標記化

清理數據集,刪除不相關的信息并規范化文本。使用 GPT-4 分詞器對文本進行標記化,以將其轉換為輸入標記。

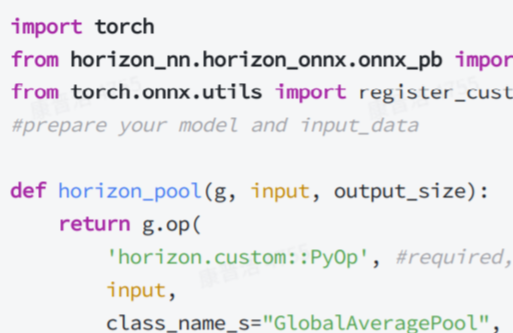

Python

from transformers import GPT4Tokenizer?

tokenizer = GPT4Tokenizer.from_pretrained("gpt-4")

data_tokens = tokenizer(data_text, truncation=True, padding=True, return_tensors="pt")

步驟二:配置訓練參數

微調涉及根據自定義數據集調整LLM的權重。設置訓練參數以控制訓練過程:

Python

from transformers import GPT4Config, GPT4ForSequenceClassification config = GPT4Config.from_pretrained("gpt-4", num_labels=) model = GPT4ForSequenceClassification.from_pretrained("gpt-4", config=config) training_args = { "output_dir": "output", "num_train_epochs": 4, "per_device_train_batch_size": 8, "gradient_accumulation_steps": 1, "learning_rate": 5e-5, "weight_decay": 0.01, }

替換為數據集中唯一標簽的數量。

步驟 3:設置培訓環境

使用庫中的 and 類初始化訓練環境:TrainingArgumentsTrainertransformers

Python

from transformers import TrainingArguments, Trainer

training_args = TrainingArguments(**training_args)

trainer = Trainer(

model=model,

args=training_args,

train_dataset=data_tokens

)

步驟 4:微調模型

通過在實例上調用方法啟動訓練過程:trainTrainer

Python

trainer.train()

此步驟可能需要一段時間,具體取決于數據集大小、模型體系結構和可用的計算資源。

步驟 5:評估微調模型

訓練后,使用實例上的方法評估微調模型的性能:evaluateTrainer

Python

trainer.evaluate()

trainer.evaluate()

步驟 6:保存并使用微調模型

保存微調后的模型并將其用于推理任務:

Python

model.save_pretrained("fine_tuned_gpt4")

tokenizer.save_pretrained("fine_tuned_gpt4")

model.save_pretrained("fine_tuned_gpt4")

? ? ? tokenizer.save_pretrained("fine_tuned_gpt4")

要使用微調的模型,請將其與分詞器一起加載:

Python

model = GPT4ForSequenceClassification.from_pretrained("fine_tuned_gpt4")

tokenizer = GPT4Tokenizer.from_pretrained("fine_tuned_gpt4")

model = GPT4ForSequenceClassification.from_pretrained("fine_tuned_gpt4")

? ? ? tokenizer = GPT4Tokenizer.from_pretrained("fine_tuned_gpt4")

示例輸入文本:

Python

input_text = "Sample text to be processed by the fine-tuned model."

標記輸入文本并生成模型輸入:

inputs = tokenizer(input_text, return_tensors="pt")

運行微調的模型:

inputs = tokenizer(input_text, return_tensors="pt")

數據提取預測:

predictions = outputs.logits.argmax(dim=-1).item()

將預測映射到相應的標簽:

model = GPT4ForSequenceClassification.from_pretrained("fine_tuned_gpt4")

tokenizer = GPT4Tokenizer.from_pretrained("fine_tuned_gpt4")

?

# Example input text

input_text = "Sample text to be processed by the fine-tuned model."

?

# Tokenize input text and generate model inputs

inputs = tokenizer(input_text, return_tensors="pt")

?

# Run the fine-tuned model

outputs = model(**inputs)

?

# Extract predictions

predictions = outputs.logits.argmax(dim=-1).item()

?

# Map predictions to corresponding labels

label = label_mapping[predictions]

?

print(f"Predicted label: {label}")

替換為從預測指數到其相應標簽的特定映射。此代碼片段演示如何使用微調的模型對新的輸入文本進行預測。label_mapping

雖然本指南為自定義培訓 LLM 提供了堅實的基礎,但您可以探索其他方面來增強該過程,例如:

試驗不同的訓練參數,如學習率計劃或優化器,以提高模型性能

在訓練期間實現早期停止或模型檢查點,以防止過度擬合并在訓練的不同階段保存最佳模型

探索先進的微調技術,如逐層學習率計劃,這可以通過調整特定層的學習率來幫助提高性能

使用與您的任務或域相關的指標執行廣泛的評估,并使用交叉驗證等技術來確保模型泛化

調查特定于領域的預訓練模型的使用情況,或者如果可用的LLM不能很好地覆蓋您的特定領域,則從頭開始預訓練您的模型

審核編輯:郭婷

?

電子發燒友App

電子發燒友App

評論