隨著預(yù)

訓(xùn)練語(yǔ)言

模型(PLMs)的不斷發(fā)展,各種NLP任務(wù)設(shè)置上都取得了不俗的性能。盡管PLMs可以從大量語(yǔ)料庫(kù)中學(xué)習(xí)一定的

知識(shí),但仍舊存在很多問(wèn)題,如

知識(shí)量有限、受

訓(xùn)練數(shù)據(jù)長(zhǎng)尾分布影響?hù)敯粜圆缓?/div>

2022-04-02 17:21:43 8765

8765 NLP領(lǐng)域的研究目前由像RoBERTa等經(jīng)過(guò)數(shù)十億個(gè)字符的語(yǔ)料經(jīng)過(guò)預(yù)訓(xùn)練的模型匯主導(dǎo)。那么對(duì)于一個(gè)預(yù)訓(xùn)練模型,對(duì)于不同量級(jí)下的預(yù)訓(xùn)練數(shù)據(jù)能夠提取到的知識(shí)和能力有何不同?

2023-03-03 11:21:51 1339

1339 本章記錄了如何使用TensorFlow2 進(jìn)行目標(biāo)檢測(cè)模型訓(xùn)練的過(guò)程。

2023-12-15 06:40:05 912

912

在這篇文章中,我將逐步講解如何使用 TensorFlow 創(chuàng)建一個(gè)簡(jiǎn)單的機(jī)器學(xué)習(xí)模型。

2024-01-08 09:25:34 272

272

《HarmonyOS ArkUI入門(mén)訓(xùn)練營(yíng)之健康飲食應(yīng)用》是面向入門(mén)開(kāi)發(fā)者打造的實(shí)戰(zhàn)課程系列。特邀華為終端BG高級(jí)開(kāi)發(fā)工程師作為本次訓(xùn)練營(yíng)講師,以健康飲食為例,開(kāi)展技術(shù)教學(xué)及實(shí)戰(zhàn)案例分享,助力入門(mén)

2023-01-05 11:49:46

TensorFlow筆記(5)——優(yōu)化手寫(xiě)數(shù)字識(shí)別模型之優(yōu)化器

2020-03-11 11:19:55

中的 tf.train.exponential_decay 方法來(lái)實(shí)現(xiàn)這一點(diǎn)。根據(jù) TensorFlow 文檔,在訓(xùn)練模型時(shí),通常建議在訓(xùn)練過(guò)程中降低學(xué)習(xí)率。該函數(shù)利用指數(shù)衰減函數(shù)初始化學(xué)習(xí)率。需要

2020-07-28 14:39:34

TensorFlow 入門(mén)(四)

2020-05-27 17:40:06

選擇在這里對(duì)數(shù)據(jù)進(jìn)行歸一化處理,也可以添加偏置并對(duì)網(wǎng)絡(luò)數(shù)據(jù)重構(gòu): 為訓(xùn)練數(shù)據(jù)聲明 TensorFlow 占位符。觀(guān)測(cè)占位符 X 的形狀變化: 為權(quán)重和偏置創(chuàng)建 TensorFlow 變量。通過(guò)隨機(jī)數(shù)

2020-08-11 19:35:23

。可以對(duì)數(shù)據(jù)進(jìn)行歸一化處理: 為訓(xùn)練數(shù)據(jù)聲明 TensorFlow 占位符: 創(chuàng)建 TensorFlow 的權(quán)重和偏置變量且初始值為零: 定義用于預(yù)測(cè)的線(xiàn)性回歸模型: 定義損失函數(shù): 選擇梯度下降優(yōu)化

2020-08-11 19:34:38

、Caffe 和 MxNet,那 TensorFlow 與其他深度學(xué)習(xí)庫(kù)的區(qū)別在哪里呢?包括 TensorFlow 在內(nèi)的大多數(shù)深度學(xué)習(xí)庫(kù)能夠自動(dòng)求導(dǎo)、開(kāi)源、支持多種 CPU/GPU、擁有預(yù)訓(xùn)練模型,并支持常用

2020-07-22 10:14:37

。mnist.train.images 的每項(xiàng)都是一個(gè)范圍介于 0 到 1 的像素強(qiáng)度: 在 TensorFlow 圖中為訓(xùn)練數(shù)據(jù)集的輸入 x 和標(biāo)簽 y 創(chuàng)建占位符: 創(chuàng)建學(xué)習(xí)變量、權(quán)重和偏置: 創(chuàng)建邏輯回歸模型

2020-08-11 19:36:01

。mnist.train.images 的每項(xiàng)都是一個(gè)范圍介于 0 到 1 的像素強(qiáng)度: 在 TensorFlow 圖中為訓(xùn)練數(shù)據(jù)集的輸入 x 和標(biāo)簽 y 創(chuàng)建占位符: 創(chuàng)建學(xué)習(xí)變量、權(quán)重和偏置: 創(chuàng)建邏輯回歸模型

2020-08-11 19:36:31

TF之Tensorboard:Tensorflow之Tensorboard可視化使用之詳細(xì)攻略

2018-12-27 10:05:13

Tensorflow+Keras入門(mén)——保存和恢復(fù)模型的方法學(xué)習(xí)

2020-06-03 16:30:12

tensorflow入門(mén)(五)

2020-05-28 13:05:23

在本文中,我們將討論目標(biāo)檢測(cè)模型和Objectness的基礎(chǔ)知識(shí)。

2021-02-04 07:05:54

訓(xùn)練好的ai模型導(dǎo)入cubemx不成功咋辦,試了好幾個(gè)模型壓縮了也不行,ram占用過(guò)大,有無(wú)解決方案?

2023-08-04 09:16:28

Anaconda之tensorflow:深度學(xué)習(xí)之Anaconda下安裝tensorflow正確運(yùn)行之史上最強(qiáng)攻略

2018-12-21 10:40:30

特性說(shuō)明這個(gè)例子使用了一個(gè)預(yù)先訓(xùn)練過(guò)的模型——SSD_MobilenetV1,它是在TensorFlow中訓(xùn)練的。使用模型導(dǎo)入器VI加載該模型,以檢測(cè)圖像中的缺陷。該示例有兩個(gè)控件:選擇“圖像控制”可

2020-07-29 17:41:31

本帖最后由 wcl86 于 2021-6-3 16:23 編輯

應(yīng)廣大學(xué)員要求,現(xiàn)開(kāi)通Labview深度學(xué)習(xí)tensorflow人工智能目標(biāo)檢測(cè)-教學(xué)貼,有需要的學(xué)員,可以收藏本貼,接下來(lái)會(huì)

2021-05-28 11:58:52

TensorFlow筆記(4)——優(yōu)化手寫(xiě)數(shù)字識(shí)別模型之代價(jià)函數(shù)和擬合

2019-10-21 10:39:55

個(gè)教程的目標(biāo)讀者是對(duì)機(jī)器學(xué)習(xí)和TensorFlow都不太了解的新手。如果你已經(jīng)了解MNIST和softmax回歸(softmax regression)的相關(guān)知識(shí),你可以閱讀這個(gè)快速上手教程。當(dāng)我

2018-03-30 20:05:33

Mali GPU 支持tensorflow或者caffe等深度學(xué)習(xí)模型嗎? 好像caffe2go和tensorflow lit可以部署到ARM,但不知道是否支持在GPU運(yùn)行?我希望把訓(xùn)練

2022-09-16 14:13:01

本教程以實(shí)際應(yīng)用、工程開(kāi)發(fā)為目的,著重介紹模型訓(xùn)練過(guò)程中遇到的實(shí)際問(wèn)題和方法。在機(jī)器學(xué)習(xí)模型開(kāi)發(fā)中,主要涉及三大部分,分別是數(shù)據(jù)、模型和損失函數(shù)及優(yōu)化器。本文也按順序的依次介紹數(shù)據(jù)、模型和損失函數(shù)

2018-12-21 09:18:02

tensorflow還一直保留著他們自己的pb模型格式文件(配置+權(quán)重)。我們直接從Tensorflow官網(wǎng)首頁(yè)的教程Mnist入手,大概簡(jiǎn)單說(shuō)明下如何從Tensorflow.Keras搭建訓(xùn)練模型,然后

2022-03-31 16:23:44

TF之NN:Tensorflow之一次函數(shù)應(yīng)用,隨機(jī)生成100個(gè)數(shù),利用Tensorflow訓(xùn)練使其逼近已知一次函數(shù)的斜率和截距

2018-12-20 10:35:48

簡(jiǎn)單來(lái)說(shuō):所謂模型就是一個(gè)濾波器,訓(xùn)練的權(quán)重就是濾波系數(shù),輸入經(jīng)過(guò)濾波器后得到一個(gè)輸出。所以嵌入式AI部署一般就是解析模型得到“濾波系數(shù)”,輸入信號(hào)進(jìn)行一系列類(lèi)似"濾波&

2023-08-18 07:01:53

1、目標(biāo)檢測(cè)模型精確度評(píng)估 指標(biāo)評(píng)估(重要的一些定義) 指標(biāo)的一些基本概念: TP(True Postives):分類(lèi)器把正例正確的分類(lèi)-預(yù)測(cè)為正例。(IOU 》= 閾值) FN(False

2022-11-21 16:40:45

缺陷檢測(cè)主要知識(shí)點(diǎn):1Tensorflow-GPU環(huán)境的搭建Tensorflow object環(huán)境搭建學(xué)會(huì)如何標(biāo)注圖片如何labview快速通過(guò)遷移學(xué)習(xí)訓(xùn)練自己的模型如何利用labview生成優(yōu)化后的OPENVINO模型IR如何利用labview調(diào)用訓(xùn)練后的PB模型和IR模型進(jìn)行目標(biāo)檢測(cè)

2021-05-10 22:33:46

安裝labview2019 vision,自帶深度學(xué)習(xí)推理工具,支持tensorflow模型。配置好python下tensorflow環(huán)境配置好object_detection API下載SSD模型

2020-08-16 17:21:38

本帖最后由 wcl86 于 2021-9-9 10:39 編輯

`labview調(diào)用深度學(xué)習(xí)tensorflow模型非常簡(jiǎn)單,效果如下,附上源碼和訓(xùn)練過(guò)的模型:[hide][/hide

2021-06-03 16:38:25

yolov5 訓(xùn)練的 tflite 模型進(jìn)行對(duì)象檢測(cè)不適用于 NNStreamer 2.2.0-r0。在之前的 NNStreamer 2.1.1 版本中,我曾經(jīng)獲取檢測(cè)框,而當(dāng)前版本顯示框架的標(biāo)簽

2023-05-17 12:44:23

不良數(shù)據(jù),經(jīng)過(guò)gpu訓(xùn)練后將訓(xùn)練后的模型部署在Horizon x3開(kāi)發(fā)板上(Sunrise3芯片),實(shí)現(xiàn)全國(guó)產(chǎn)邊緣目標(biāo)檢測(cè)的demo,同時(shí)可以通過(guò)b站或51cto網(wǎng)站上韋東山老師的教學(xué)視頻學(xué)習(xí)harmony os所以想嘗試申請(qǐng)此款高性能的開(kāi)發(fā)板,十分希望能通過(guò),謝謝~~~

2020-11-19 20:49:15

框起來(lái)了。

三、YOLOX視頻目標(biāo)檢測(cè)原理解析

YOLOX視頻目標(biāo)檢測(cè)示例程序源碼非常簡(jiǎn)短(test_video_yolovx.cpp文件):

這段代碼中,

model是模型名稱(chēng);

vitis::ai

2023-10-06 23:32:47

,如果使用這些模型,只能實(shí)現(xiàn)對(duì)應(yīng)的識(shí)別功能。如果想要制作自己需要的識(shí)別效果,就需要按照機(jī)器視覺(jué)訓(xùn)練的方式一步一步來(lái)進(jìn)行。

TF-YOLOv3.5是一個(gè)基于TensorFlow的實(shí)時(shí)目標(biāo)檢測(cè)模型

2023-09-18 14:15:48

準(zhǔn)備開(kāi)始為家貓做模型訓(xùn)練檢測(cè),要去官網(wǎng)https://maix.sipeed.com/home 注冊(cè)帳號(hào),文章尾部的視頻是官方的,與目前網(wǎng)站略有出路,說(shuō)明訓(xùn)練網(wǎng)站的功能更新得很快。其實(shí)整個(gè)的過(guò)程

2022-06-26 21:19:40

OpenVINO安裝完成后,需要提供項(xiàng)目的模型文件,才能進(jìn)行參數(shù)調(diào)優(yōu)和深度學(xué)習(xí)推理。所以需要進(jìn)行數(shù)據(jù)收集,數(shù)據(jù)標(biāo)注,進(jìn)行模型訓(xùn)練。訓(xùn)練的模型很多,有Tensorflow、Caffee等,我選用

2020-07-15 23:29:12

、目標(biāo)追蹤等結(jié)果的可視化,都離不開(kāi)OpenCV。 深度學(xué)習(xí)的應(yīng)用開(kāi)發(fā)的典型流程1、收集數(shù)據(jù)2、標(biāo)注數(shù)據(jù)3、訓(xùn)練數(shù)據(jù)4、部署模型 對(duì)于如何訓(xùn)練數(shù)據(jù),圖片的角度各不相同,不能保證對(duì)齊處理。特意請(qǐng)教了一下

2020-08-12 16:28:26

抓取圖像,手動(dòng)標(biāo)注并完成自定義目標(biāo)檢測(cè)模型訓(xùn)練和測(cè)試

在第二章中,我介紹了模型訓(xùn)練的一般過(guò)程,其中關(guān)鍵的過(guò)程是帶有標(biāo)注信息的數(shù)據(jù)集獲取。訓(xùn)練過(guò)程中可以已有的數(shù)據(jù)集合不能滿(mǎn)足自己的要求,這時(shí)候就需要

2023-12-16 10:05:19

使用 TensorFlow2 訓(xùn)練目標(biāo)檢測(cè)模型

因?yàn)槲业捻?xiàng)目是計(jì)劃在飛騰派上實(shí)現(xiàn)一個(gè)目標(biāo)檢測(cè)跟蹤算法,通過(guò)算法輸出控制信號(hào)控制電機(jī)跟隨目標(biāo)運(yùn)行。在第一章完成了Ubuntu系統(tǒng)的構(gòu)建和燒寫(xiě),這幾天就在

2023-12-15 06:44:37

介紹:人工智能AI到來(lái),工業(yè)上很多學(xué)員不了解C#中l(wèi)abview中如何調(diào)用tensorflow進(jìn)行深度學(xué)習(xí)模型的訓(xùn)練和調(diào)用,推出一整套完整的簡(jiǎn)易學(xué)的視頻課程,使學(xué)員能在沒(méi)有任何深度學(xué)習(xí)理論基礎(chǔ),不懂

2020-11-27 11:19:37

, 通常在構(gòu)建階段創(chuàng)建一個(gè)圖來(lái)表示和訓(xùn)練神經(jīng)網(wǎng)絡(luò), 然后在執(zhí)行階段反復(fù)執(zhí)行圖中的訓(xùn)練 op.TensorFlow 支持 C, C++, Python 編程語(yǔ)言. 目前, TensorFlow

2018-03-30 20:03:30

開(kāi)發(fā)人員可以輕松構(gòu)建和部署學(xué)習(xí)驅(qū)動(dòng)的應(yīng)用程序。TensorFlow Lite而管理微控制器的 TensorFlow Lite (TFL) 專(zhuān)注于機(jī)器電腦數(shù)據(jù)記憶的微控制器和其他設(shè)備上運(yùn)行學(xué)習(xí)模型。核心

2021-06-21 15:48:31

,使用labview訓(xùn)練和部署深度學(xué)習(xí)模型,并配備相關(guān)案例視頻。課程目錄:Tensorflow環(huán)境搭建Object_detection api安裝相關(guān)py文件編譯測(cè)試測(cè)試tensorflow目標(biāo)檢測(cè)學(xué)習(xí)

2020-08-10 10:38:12

在沒(méi)有特殊硬件的前提下,在你的筆記本上跑一下機(jī)器學(xué)習(xí)的新想法?Tensorflow可以辦到這點(diǎn)。準(zhǔn)備將你的訓(xùn)練模型在多個(gè)CPU上規(guī)模化運(yùn)算,又不想修改代碼?Tensorflow可以辦到這點(diǎn)。想要

2018-03-30 19:57:24

的定義和訓(xùn)練的收斂趨勢(shì)。總結(jié)我們可以利用阿里云Kubernetes容器服務(wù),輕松的搭建在云端搭建TensorFlow的環(huán)境,運(yùn)行深度學(xué)習(xí)的實(shí)驗(yàn)室,并且利用TensorBoard追蹤訓(xùn)練效果。歡迎大家使用阿里云上的GPU容器服務(wù),在使用GPU高效計(jì)算的能力同時(shí),比較簡(jiǎn)單和快速的開(kāi)始模型開(kāi)發(fā)工作。原文鏈接

2018-05-10 10:24:11

CV:基于Keras利用訓(xùn)練好的hdf5模型進(jìn)行目標(biāo)檢測(cè)實(shí)現(xiàn)輸出模型中的臉部表情或性別的gradcam(可視化)

2018-12-27 16:48:28

:支持 Android NN API、提供 RKNN 跨平臺(tái) API、Linux 支持 TensorFlow 開(kāi)發(fā)。1.3. 開(kāi)發(fā)流程N(yùn)PU開(kāi)發(fā)完整的流程如下圖所示:1.3.1. 1. 模型訓(xùn)練在模型

2022-05-31 11:10:20

并應(yīng)用于邊界框回歸損失中,提高了 YOLOX 在 KITTI 數(shù)據(jù)集上的檢測(cè)精度,檢測(cè)出更多的遮擋目標(biāo);采用動(dòng)態(tài)錨框來(lái)優(yōu)化置信度標(biāo)簽分配,生成更準(zhǔn)確的標(biāo)簽值以?xún)?yōu)化模型訓(xùn)練,最終得到檢測(cè)性能更好的模型

2023-03-06 13:55:27

基于光學(xué)芯片的神經(jīng)網(wǎng)絡(luò)訓(xùn)練解析,不看肯定后悔

2021-06-21 06:33:55

有很多方法可以將經(jīng)過(guò)訓(xùn)練的神經(jīng)網(wǎng)絡(luò)模型部署到移動(dòng)或嵌入式設(shè)備上。不同的框架在各種平臺(tái)上支持Arm,包括TensorFlow、PyTorch、Caffe2、MxNet和CNTK,如Android

2023-08-02 06:43:57

我正在嘗試使用 eIQ 門(mén)戶(hù)訓(xùn)練人臉檢測(cè)模型。我正在嘗試從 tensorflow 數(shù)據(jù)集 (tfds) 導(dǎo)入數(shù)據(jù)集,特別是 coco/2017 數(shù)據(jù)集。但是,我只想導(dǎo)入 wider_face。但是,當(dāng)我嘗試這樣做時(shí),會(huì)出現(xiàn)導(dǎo)入程序錯(cuò)誤,如下圖所示。任何幫助都可以。

2023-04-06 08:45:14

的MCU的功能,該應(yīng)用程序可以檢測(cè)和分類(lèi)用戶(hù)的手寫(xiě)輸入。為此,本文重點(diǎn)介紹流行的MNIST eIQ示例,該示例由幾個(gè)部分組成-數(shù)字識(shí)別由TensorFlow Lite模型執(zhí)行,并且GUI用于提高i.MX

2020-09-29 09:40:16

在EVM1684上如何用BMlang搭建一個(gè)Tensorflow模型,求助官方一個(gè)demo。

2023-09-18 07:00:46

系統(tǒng)學(xué)習(xí)LabVIEW圖像處理相關(guān)知識(shí),并完成相關(guān)實(shí)踐練習(xí)。編者準(zhǔn)備了入門(mén)機(jī)器視覺(jué)最經(jīng)典的視覺(jué)圖像處理書(shū)籍《LabVIEW Vision圖像處理開(kāi)發(fā)寶典》,并且提供分享一則LabVIEW視覺(jué)檢測(cè)的范例,這個(gè)簡(jiǎn)單

2020-12-09 14:53:37

TensorFlow 提供了簡(jiǎn)化的接口的庫(kù)。里面有很多示例和預(yù)構(gòu)建的運(yùn)算和層。使用教程:TFLearn 快速入門(mén)。通過(guò)一個(gè)具體的機(jī)器學(xué)習(xí)任務(wù)學(xué)習(xí) TFLearn 基礎(chǔ)。開(kāi)發(fā)和訓(xùn)練一個(gè)深度神經(jīng)網(wǎng)絡(luò)分類(lèi)器

2018-10-09 11:28:37

和GPU上運(yùn)行,比如說(shuō)可以運(yùn)行在臺(tái)式機(jī)、服務(wù)器、手機(jī)移動(dòng)設(shè)備等等。想要在沒(méi)有特殊硬件的前提下,在你的筆記本上跑一下機(jī)器學(xué)習(xí)的新想法?Tensorflow可以辦到這點(diǎn)。準(zhǔn)備將你的訓(xùn)練模型在多個(gè)CPU上規(guī)模

2020-07-22 10:13:20

神經(jīng)網(wǎng)絡(luò)和深度學(xué)習(xí)的概念,但為了完整起見(jiàn),我們將在這里介紹基礎(chǔ)知識(shí),并探討 TensorFlow 的哪些特性使其成為深度學(xué)習(xí)的熱門(mén)選擇。神經(jīng)網(wǎng)絡(luò)是一個(gè)生物啟發(fā)式的計(jì)算和學(xué)習(xí)模型。像生物神經(jīng)元一樣,它們從其他

2020-07-28 14:34:04

隨著TensorFlow Lite的推出,TensorFlow已經(jīng)更新了量化技術(shù)和工具,您可以使用這些技術(shù)和工具來(lái)提高網(wǎng)絡(luò)性能。

本指南向您展示如何量化網(wǎng)絡(luò),使其在訓(xùn)練過(guò)程中使用8位數(shù)

2023-08-10 06:01:27

tensorflow模型部署系列的一部分,用于tflite實(shí)現(xiàn)通用模型的部署。本文主要使用pb格式的模型文件,其它格式的模型文件請(qǐng)先進(jìn)行格式轉(zhuǎn)換,參考tensorflow模型部署系列————預(yù)訓(xùn)練模型導(dǎo)出。從...

2021-12-22 06:51:18

電子技術(shù)入門(mén)之維修基礎(chǔ)知識(shí)

2012-08-17 20:03:51

一、前言前面結(jié)合神經(jīng)網(wǎng)絡(luò)簡(jiǎn)要介紹TensorFlow相關(guān)概念,并給出了MNIST手寫(xiě)數(shù)字識(shí)別的簡(jiǎn)單示例,可以得出結(jié)論是,構(gòu)建的神經(jīng)網(wǎng)絡(luò)目的就是利用已有的樣本數(shù)據(jù)訓(xùn)練網(wǎng)絡(luò)的權(quán)重和偏置,使神經(jīng)網(wǎng)絡(luò)最終

2020-11-04 07:49:09

利用labview部署yolov5導(dǎo)出的模型,能利用攝像頭動(dòng)態(tài)檢測(cè)輸出目標(biāo)檢測(cè)結(jié)果。根據(jù)工業(yè)視覺(jué)外觀(guān)檢測(cè)的速度和準(zhǔn)確性要求,龍哥視覺(jué)結(jié)合labview編程平臺(tái)推出了labview+yolov5訓(xùn)練和模型

2021-09-03 09:39:28

本內(nèi)容提供了基于碼本模型的運(yùn)動(dòng)目標(biāo)檢測(cè)算法

2011-05-19 10:54:01 32

32 多旋翼模型入門(mén),制作多軸飛行器的可以參考下

2016-02-15 15:07:46 0

0 在神經(jīng)網(wǎng)絡(luò)模型可以構(gòu)建之前進(jìn)行預(yù)處理),或者非常適合簡(jiǎn)單的關(guān)鍵字檢測(cè)。 為了解決這個(gè)問(wèn)題,TensorFlow和AIY團(tuán)隊(duì)創(chuàng)建了語(yǔ)音命令數(shù)據(jù)集,并用于將訓(xùn)練*和推理示例代碼在TensorFlow中運(yùn)行。(https://aiyprojects.withgoogle.com/) 該數(shù)據(jù)集在AIY網(wǎng)站,由成千

2017-09-22 16:47:37 2

2 你知道你可以使用 TensorFlow 來(lái)描述圖像、理解文本和生成藝術(shù)作品嗎?來(lái)這個(gè)演講,你體驗(yàn)到 TensorFlow 在計(jì)算機(jī)視覺(jué)、自然語(yǔ)言處理和計(jì)算機(jī)藝術(shù)生成上的最新項(xiàng)目。我將分享每個(gè)領(lǐng)域內(nèi)

2017-09-29 19:18:45 0

0 針對(duì)遙感圖像中由于背景復(fù)雜、目標(biāo)外觀(guān)多樣和方向任意而導(dǎo)致的檢測(cè)精度不高的問(wèn)題,提出一種基于強(qiáng)監(jiān)督的部件模型方法。該方法針對(duì)目標(biāo)的每個(gè)方向范圍訓(xùn)練子模型,同時(shí)訓(xùn)練集除了標(biāo)注出目標(biāo)的外接矩形,還標(biāo)注

2017-12-18 15:35:01 1

1 與TensorFlow框架,并通過(guò)在Linux系統(tǒng)下搭建環(huán)境,仿真手寫(xiě)字符識(shí)別的TensorFlow模型,實(shí)現(xiàn)手寫(xiě)字符的識(shí)別,從而實(shí)現(xiàn)TensorFlow機(jī)器學(xué)習(xí)框架的學(xué)習(xí)與應(yīng)用。

2018-04-04 14:39:00 6874

6874

使用Tensorflow的目標(biāo)檢測(cè)API,可以快速搭建目標(biāo)檢測(cè)模型。如果你不熟悉這套API,可以看下我之前寫(xiě)的介紹Tensorflow目標(biāo)檢測(cè)API,以及如何使用該API搭建定制模型的博客文章。

2018-07-08 09:38:39 6038

6038

你也許會(huì)好奇:為什么要在瀏覽器里基于tensorflow.js訓(xùn)練我的模型,而不是直接在自己的機(jī)器上基于tensorflow訓(xùn)練模型?你當(dāng)然可以在自己的機(jī)器上訓(xùn)練,特別是如果你的機(jī)器配備

2018-10-18 09:43:12 3837

3837 近年來(lái),隨著深度學(xué)習(xí)在圖像視覺(jué)領(lǐng)域的發(fā)展,一類(lèi)基于單純的深度學(xué)習(xí)模型的點(diǎn)云目標(biāo)檢測(cè)方法被提出和應(yīng)用,本文將詳細(xì)介紹其中一種模型——SqueezeSeg,并且使用ROS實(shí)現(xiàn)該模型的實(shí)時(shí)目標(biāo)檢測(cè)。

2018-11-05 16:47:29 17181

17181 目標(biāo)識(shí)別部分是在快速檢測(cè)的結(jié)果上進(jìn)行,快速檢測(cè)部分提供了目標(biāo)的疑似區(qū)域,在疑似區(qū)域?qū)?yīng)的原始圖像上,形成目標(biāo)切片、提取特征、分類(lèi)器判定,形成目標(biāo)候選區(qū)域。目標(biāo)識(shí)別部分的主要工作體現(xiàn)在分類(lèi)器的訓(xùn)練,因?yàn)樽R(shí)別部分只是使用與訓(xùn)練部分相同的特征提取方式,以及分類(lèi)模型的導(dǎo)入等。

2019-08-26 09:48:03 8100

8100 本文展示了如何使用 Docker 容器中的 TensorFlow 目標(biāo)檢測(cè) API,通過(guò)網(wǎng)絡(luò)攝像頭執(zhí)行實(shí)時(shí)目標(biāo)檢測(cè),同時(shí)進(jìn)行視頻后處理。作者使用的是 OpenCV 和 Python3 多進(jìn)程和多線(xiàn)程

2020-11-27 09:08:53 1784

1784 當(dāng)我們沒(méi)有大量不同的訓(xùn)練數(shù)據(jù)時(shí),我們?cè)撛趺崔k?這是在TensorFlow中使用數(shù)據(jù)增強(qiáng)在模型訓(xùn)練期間執(zhí)行內(nèi)存中圖像轉(zhuǎn)換以幫助克服此數(shù)據(jù)障...

2020-12-14 22:37:08 242

242 在Fynd的研究團(tuán)隊(duì)一直在訓(xùn)練一個(gè)行人檢測(cè)模型來(lái)支持我們的目標(biāo)跟蹤模型。在本文中,我們將介紹如何選擇一個(gè)模型架構(gòu),創(chuàng)建一個(gè)數(shù)據(jù)集,并為我們的特定用例進(jìn)行行人檢測(cè)模型的訓(xùn)練。 什么是目標(biāo)檢測(cè) 目標(biāo)檢測(cè)是一種計(jì)算機(jī)視覺(jué)技

2021-01-07 14:04:53 3120

3120 在本文中,我們將討論目標(biāo)檢測(cè)模型和Objectness的基礎(chǔ)知識(shí)。

2022-02-12 17:00:26 889

889 本次將分享ICLR2021中的三篇投遞文章,涉及知識(shí)圖譜與訓(xùn)練模型相結(jié)合和命名實(shí)體識(shí)別(NER)的研究工作。 文章概覽 知識(shí)圖譜和語(yǔ)言理解的聯(lián)合預(yù)訓(xùn)練(JAKET: Joint

2021-03-29 17:06:10 3778

3778

針對(duì)遙感圖像飛機(jī)檢測(cè)中存在的背景復(fù)雜和目標(biāo)尺度變化大等問(wèn)題,提出基于深度神經(jīng)網(wǎng)絡(luò)的遙感圖像飛機(jī)目標(biāo)檢測(cè)模型DC-DNN。利用圖像底層特征制作像素級(jí)標(biāo)簽完成全卷積神經(jīng)網(wǎng)絡(luò)(FCN)模型訓(xùn)練,將FCN

2021-03-30 09:24:40 17

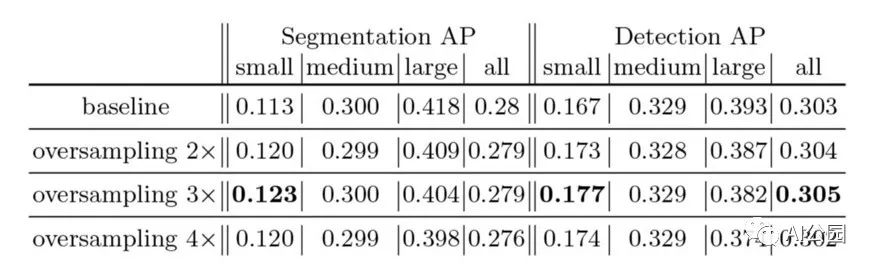

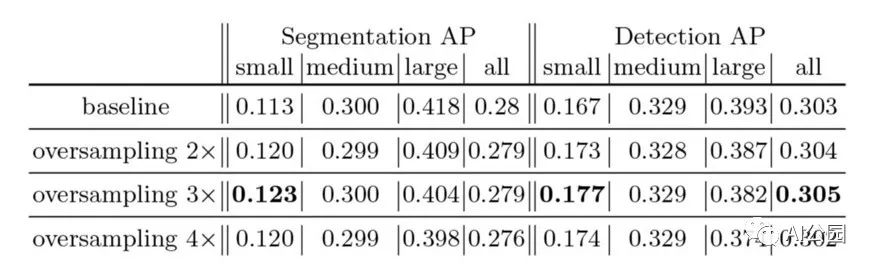

17 實(shí)驗(yàn)中采用的圖像均來(lái)自 MS-COCO 數(shù)據(jù)集 2017 版的驗(yàn)證集。除非另有說(shuō)明,我們采用的所有模型均來(lái)自 Tensorflow 目標(biāo)檢測(cè) API [5]。因此,我們的實(shí)驗(yàn)易于復(fù)現(xiàn),并且可以訪(fǎng)問(wèn)一組不同的當(dāng)前最優(yōu)目標(biāo)檢測(cè)架構(gòu)。

2021-04-01 14:24:41 1243

1243 為提高卷積神經(jīng)網(wǎng)絡(luò)目標(biāo)檢測(cè)模型精度并增強(qiáng)檢測(cè)器對(duì)小目標(biāo)的檢測(cè)能力,提出一種脫離預(yù)訓(xùn)練的多尺度目標(biāo)檢測(cè)網(wǎng)絡(luò)模型。采用脫離預(yù)訓(xùn)練檢測(cè)網(wǎng)絡(luò)使其達(dá)到甚至超過(guò)預(yù)訓(xùn)練模型的精度,針對(duì)小目標(biāo)特點(diǎn)

2021-04-02 11:35:50 26

26 導(dǎo)讀 本文介紹了一些小目標(biāo)物體檢測(cè)的方法和思路。 在深度學(xué)習(xí)目標(biāo)檢測(cè)中,特別是人臉檢測(cè)中,由于分辨率低、圖像模糊、信息少、噪聲多,小目標(biāo)和小人臉的檢測(cè)一直是一個(gè)實(shí)用和常見(jiàn)的難點(diǎn)問(wèn)題。然而,在過(guò)去幾年

2021-04-26 14:13:58 5926

5926

提取的方法以提高對(duì)小目標(biāo)的檢測(cè)能力,再對(duì)高層特征層進(jìn)行特征提取以改善中目標(biāo)的檢測(cè)效果。最后,利用SSD模型中原有的多度卷積檢測(cè)方法,將改進(jìn)的多層特征檢測(cè)結(jié)果選行融合,并通過(guò)參數(shù)再訓(xùn)練以獲得最終改進(jìn)的SSD模型。實(shí)驗(yàn)結(jié)果表明,該方法在 MS COCO數(shù)據(jù)集上對(duì)中目標(biāo)和小目標(biāo)

2021-06-11 16:21:48 11

11 本文關(guān)注于向大規(guī)模預(yù)訓(xùn)練語(yǔ)言模型(如RoBERTa、BERT等)中融入知識(shí)。

2021-06-23 15:07:31 3468

3468

上,目標(biāo)檢測(cè)模型的訓(xùn)練和部署的過(guò)程: 設(shè)備端 ML 學(xué)習(xí)路徑:關(guān)于如何在移動(dòng)設(shè)備上,訓(xùn)練和部署自定義目標(biāo)檢測(cè)模型的分步教程,無(wú)需機(jī)器學(xué)習(xí)專(zhuān)業(yè)知識(shí)。 設(shè)備端 ML 學(xué)習(xí)路徑 https

2021-08-16 17:09:58 2877

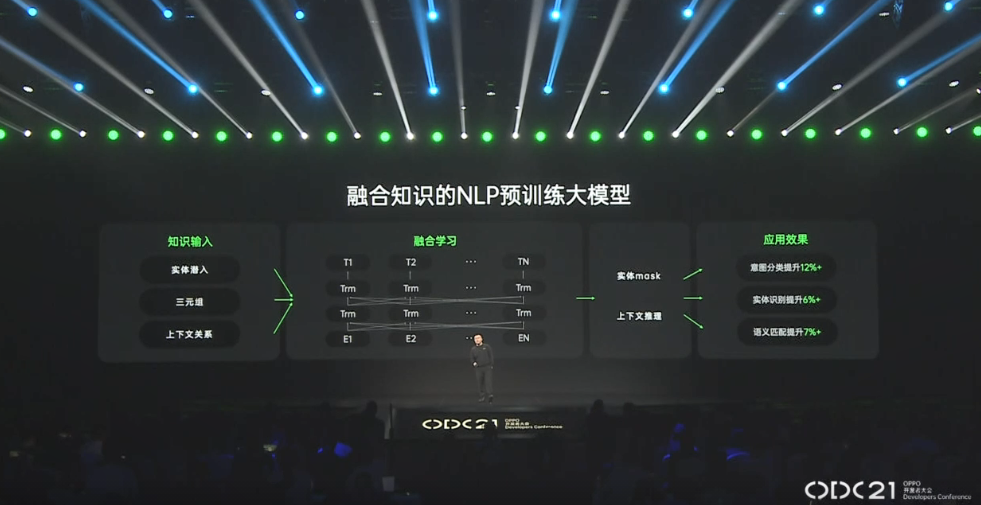

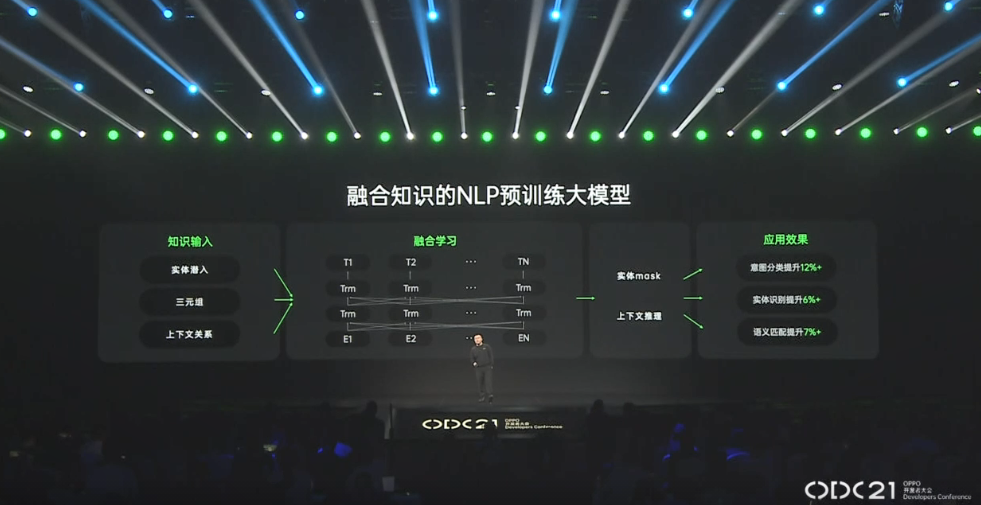

2877 2021 OPPO開(kāi)發(fā)者大會(huì):NLP預(yù)訓(xùn)練大模型 2021 OPPO開(kāi)發(fā)者大會(huì)上介紹了融合知識(shí)的NLP預(yù)訓(xùn)練大模型。 責(zé)任編輯:haq

2021-10-27 14:18:41 1492

1492

2021年OPPO開(kāi)發(fā)者大會(huì)劉海鋒:融合知識(shí)的NLP預(yù)訓(xùn)練大模型,知識(shí)融合學(xué)習(xí)運(yùn)用在小布助手里面。

2021-10-27 14:48:16 2251

2251

曠視科技開(kāi)源了內(nèi)部目標(biāo)檢測(cè)模型-YOLOX,性能與速度全面超越Y(jié)OLOv5早期版本!

2022-04-16 23:00:27 2573

2573 當(dāng)前面已經(jīng)訓(xùn)練好修剪過(guò)的模型之后,接下來(lái)就可以在訓(xùn)練設(shè)備上先執(zhí)行推理計(jì)算,看看檢測(cè)的效果如何?如果實(shí)際推理結(jié)果并不理想的話(huà),就得回到前面第 6 步驟重新再執(zhí)行一次。

2022-05-20 17:43:43 808

808 你是否想入門(mén)機(jī)器學(xué)習(xí),卻苦于找不到最新版官方課程,學(xué)習(xí)資源零散? 你是否也想快速掌握機(jī)器學(xué)習(xí)部署技巧,靈活運(yùn)行機(jī)器學(xué)習(xí)模型,無(wú)論在移動(dòng)端、網(wǎng)頁(yè)端還是云端部署都能得心應(yīng)手? 想多方面入門(mén)機(jī)器學(xué)習(xí)知識(shí)

2022-11-10 11:35:07 566

566 現(xiàn)在目標(biāo)檢測(cè)算法總結(jié)

1. 目標(biāo)檢測(cè)算法在機(jī)動(dòng)車(chē)和行人檢測(cè)識(shí)別上應(yīng)用較多,在非機(jī)動(dòng)車(chē)上應(yīng)用較少

2. 對(duì)于目標(biāo)檢測(cè)模型增強(qiáng)特征表示和引入上下文信息的改進(jìn)方法幾乎對(duì)任何場(chǎng)景和任何任務(wù)都是有利

2023-06-06 09:40:12 0

0 前面已經(jīng)講過(guò)了Yolov5模型目標(biāo)檢測(cè)和分類(lèi)模型訓(xùn)練流程,這一篇講解一下yolov5模型結(jié)構(gòu),數(shù)據(jù)增強(qiáng),以及訓(xùn)練策略。

2023-09-11 11:15:21 844

844

Hello大家好,今天給大家分享一下如何基于深度學(xué)習(xí)模型訓(xùn)練實(shí)現(xiàn)圓檢測(cè)與圓心位置預(yù)測(cè),主要是通過(guò)對(duì)YOLOv8姿態(tài)評(píng)估模型在自定義的數(shù)據(jù)集上訓(xùn)練,生成一個(gè)自定義的圓檢測(cè)與圓心定位預(yù)測(cè)模型

2023-12-21 10:50:05 525

525

谷歌在模型訓(xùn)練方面提供了一些強(qiáng)大的軟件工具和平臺(tái)。以下是幾個(gè)常用的谷歌模型訓(xùn)練軟件及其特點(diǎn)。

2024-03-01 16:24:01 184

184

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論